Материалы по тегу: 800gbe

|

16.12.2024 [11:19], Сергей Карасёв

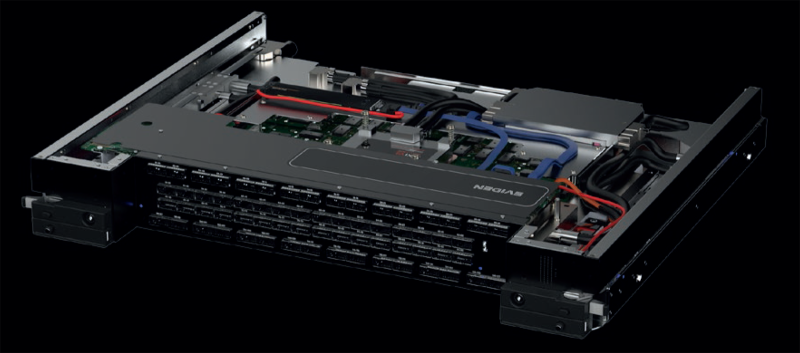

Раскрыты характеристики сетевых устройств Eviden с технологией BXI v3В ноябре текущего года компания Eviden (дочерняя структура Atos) представила интерконнект третьего поколения BullSequana eXascale Interconnect (BXI v3) для рабочих нагрузок ИИ и HPC. Теперь, как сообщает ресурс Next Platform, раскрыты некоторые характеристики устройств с поддержкой данной технологии. BXI v3 в качестве базового протокола связи использует Ethernet. Технология BXI v3 ляжет в основу интеллектуального сетевого адаптера (Smart NIC) и соответствующего коммутатора. Говорится, что для изготовления чипов ASIC с поддержкой BXI v3 компания Eviden рассматривает возможность применения 3-нм или 4-нм методики TSMC. Коммутатор BXI v3 располагает 64 портами, работающими на скорости 800 Гбит/с. Их можно переконфигурировать в 128 портов с пропускной способностью 400 Гбит/с. В свою очередь, адаптер Smart NIC функционирует на скорости 400 Гбит/с. Он будет предлагаться в виде двухслотовой карты расширения PCIe или OCP-3 (с интерфейсом PCIe 5.0). Возможны варианты адаптеров с двумя портами 400 Гбит/с. Карта BXI v3 способна управлять пакетами объёмом до 9 Мбайт, что полезно в нагруженных инфраструктурах ИИ. Платформа BXI v3 поддерживает топологии fat tree и dragonfly+, а также fat tree с оптимизацией маршрутов (используется при обучении больших языковых моделей). Для BXI v3 заявлена поддержка до 64 тыс. конечных точек, а задержка составляет менее 200 нс от порта к порту. Изделия с поддержкой BXI v3 поступит в продажу в 2025 году. Осенью 2027 года ожидается появление интерконнекта BXI v4, который предусматривает повышение пропускной способности портов на сетевых картах и коммутаторах до 1,6 Тбит/с. При этом сетевые адаптеры получат поддержку интерфейса PCIe 6.0. В 2029-м планируется переход на интерконнект BXI v5: он обеспечит скорость портов на коммутаторах до 3,2 Тбит/с, тогда как сетевые адаптеры продолжат работать на скоростях до 1,6 Тбит/с, но получат поддержку PCIe 7.0.

23.11.2024 [12:38], Сергей Карасёв

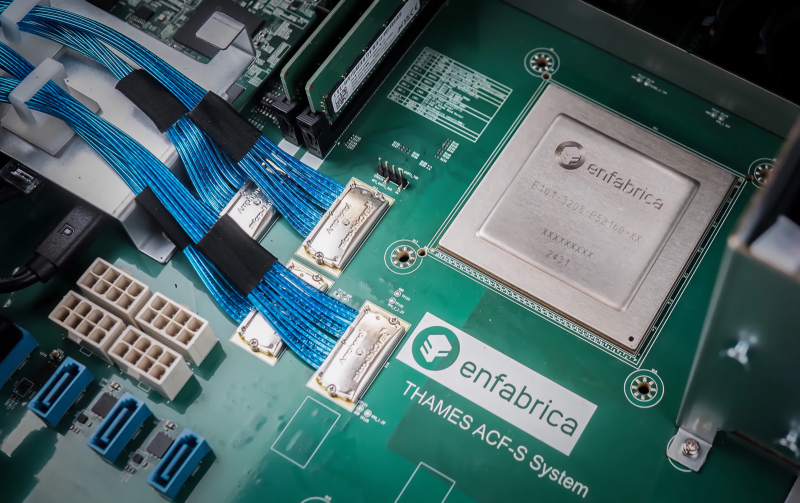

Стартап Enfabrica выпустил чип ACF SuperNIC для ИИ-кластеров на базе GPUКомпания Enfabrica, занимающаяся разработкой инфраструктурных решений в сфере ИИ, объявила о доступности чипа Accelerated Compute Fabric (ACF) SuperNIC, предназначенного для построения высокоскоростных сетей в рамках кластеров ИИ на основе GPU. Кроме того, стартап провёл очередной раунд финансирования. Напомним, Enfabrica предлагает CXL-платформу ACF на базе ASIC собственной разработки, которая позволяет напрямую подключать друг к другу любую комбинацию GPU, CPU, DDR5 CXL и SSD, а также предоставляет 800GbE-интерконнект. Утверждается, что ACF SuperNIC может обеспечить улучшенную масштабируемость и производительность с более низкой совокупной стоимостью владения для распределённых рабочих нагрузок ИИ по сравнению с другими решениями, доступными на рынке. Изделие ACF SuperNIC (ACF-S) позволяет использовать от четырёх до восьми самых современных ускорителей в расчёте на серверную систему. Чип обеспечивает поддержку 800GbE, 400GbE и 100GbE, 32 сетевых портов и 160 линий PCIe. Благодаря этому становится возможным формирование ИИ-кластеров, насчитывающих более 500 тыс. GPU. Программный стек ACF-S поддерживает стандартные коммуникационные и сетевые операции RDMA через набор библиотек, совместимых с существующими интерфейсами. Фирменная технология Resilient Message Multipathing (RMM) повышает отказоустойчивость кластера ИИ и удобство обслуживания. RMM устраняет простои из-за сбоев и отказов сетевых соединений, повышая эффективность. Функция Collective Memory Zoning обеспечивает снижение задержек. Поставки чипов ACF SuperNIC начнутся в I квартале 2025 года. Что касается нового раунда финансирования, то по программе Series C привлечено $115 млн. Раунд возглавила фирма Spark Capital с участием новых инвесторов — Maverick Silicon и VentureTech Alliance. Кроме того, средства предоставили существующие инвесторы в лице Atreides Management, Sutter Hill Ventures, Alumni Ventures, IAG Capital и Liberty Global Ventures.

26.08.2024 [17:10], Руслан Авдеев

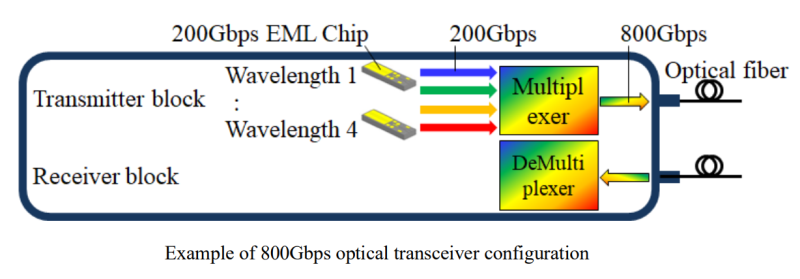

Новый дефицит: Mitsubishi Electric безуспешно пытается справиться со спросом на оптические компоненты для ИИ ЦОДЯпонская Mitsubishi Electric Corp. пытается справиться с нарастающим в мире спросом на оптические компоненты, используемые в ИИ ЦОД, передаёт Bloomberg. Компания контролирует почти половину мирового рынка устройств оптической передачи данных для ЦОД, выпуская высокоэффективные лазерные диоды, модуляторы и сборки, которые используются в трансиверах. При этом в выручке самой компании данное направление занимает очень небольшую долю. В Bloomberg сообщают, что, например, в США, без преувеличения все гиперскейлеры так или иначе являются клиентами Mitsubishi Electric. По словам представителя компании, уже в следующем месяце Mitsubishi Electric сможет нарастить выпуск оптических компонентов на 50 % в сравнении с прошлым годом, но этого всё равно будет недостаточно, чтобы удовлетворить все получаемые запросы. Понадобится вдвое нарастить производство в сравнении с тем, на что оно будет способно в сентябре. Высказывания официального представителя компании стали последним из признаков дефицита компонентов для ИИ-инфраструктур. По оценкам Mitsubishi Electric, спрос со стороны пятёрки первых ведущих провайдеров США «очень силён» и продолжает расти. Буквально на днях компания пообещала начать поставки образцов решения для сетей 800 Гбит/с и 1,6 Тбит/с. На оптические компоненты приходится лишь малая часть бизнеса Mitsubishi Electric, выпускающей самую разную продукцию, от промышленных роботов до спутникового оборудования. Подразделение, занимающееся соответствующими полупроводниками и устройствами, принесло в прошлом финансовом году 4 % от выручки компании. В июне эксперты уже предупреждали о росте спроса на оптическое оборудование для дата-центров.

09.06.2024 [12:46], Сергей Карасёв

Arista представила сетевые ИИ-решения Etherlink с прицелом на крупные кластерыКомпания Arista Networks анонсировала сетевые платформы Etherlink AI, созданные, как утверждается, для обеспечения оптимальной производительности при выполнении наиболее требовательных рабочих нагрузок ИИ, включая обучение больших языковых моделей (LLM) и их инференс. Решения Arista Etherlink AI поддерживают кластеры ИИ, насчитывающие от тысяч до сотен тысяч xPU. Используются эффективные одно- и двухуровневые сетевые топологии для обеспечения оптимальной производительности. Все коммутаторы Etherlink поддерживают новые стандарты Ultra Ethernet Consortium (UEC), которые, как ожидается, в перспективе дадут дополнительные преимущества в плане производительности. В семейство Arista Etherlink AI входят коммутаторы 7060X6 AI Leaf, построенные на базе ASIC Tomahawk 5 разработки Broadcom. Это изделие способно осуществлять коммутацию на скоростях до 51,2 Тбит/с. Новые устройства поддерживают до 60 портов 800GbE или до 128 портов 400GbE. В семействе сетевых платформ также представлены модульные системы Arista 7800R4 AI Spine 4-го поколения. В них применяются чипы-коммутаторы Broadcom Jericho3-AI, ориентированные специально на ИИ-задачи. Устройства Arista 7800R4 AI Spine поддерживают пропускную способность до 460 Тбит/с в одном шасси: 576 портов 800GbE или 1152 портов 400GbE. Наконец, дебютировали коммутаторы 7700R4 AI Distributed Etherlink Switch (DES), рассчитанные на наиболее крупные кластеры ИИ. Используя архитектуру Jericho3-AI, они обеспечивают распределение трафика без перегрузок. Это первые решения в новой серии сверхмасштабируемых интеллектуальных распределенных систем, которые способны поддерживать высочайшую пропускную способность для самых ресурсоёмких ИИ-задач, говорит компания.

15.04.2024 [22:28], Руслан Авдеев

Обновлённому коллайдеру — обновлённая сеть: Nokia и SURF «разогнали» до 800 Гбит/с имеющуюся оптическую сеть БАКФинская Nokia и научно-образовательное IT-объединение SURF из Нидерландов успешно добились скорости передачи данных 800 Гбит/с на существующей трансграничной оптоволоконной сетевой инфраструктуре SURF. По информации Nokia, новых скоростей удалось добиться благодаря применению платформы Photonic Service Engine (PSE-6s). Ожидается, что внедрение нового решения поможет обмениваться большими массивами данных между Большим адронным коллайдером (БАК), исследовательскими мощностями NL Tier-1 (NL T1) группы SURF и нидерландским институтом NIKHEF, занимающимся атомной энергетикой и смежными проектами. Отмечается, что повысить скорость удалось на старых ВОЛС. Испытание провели на линии протяжённостью 1648 км между Амстердамом и Женевой, которая пересекает Бельгию и Францию. Это часть сети SURF, связывающая научно-образовательные институты в Нидерландах и других странах мира, включая собственную оптическую сеть БАК (LHC Optical Private Network, LHCOPN). Последняя обеспечивает доступ к данным БАК в CERN. CERN, NIKHEF, SURF и эксперимент ATLAS объединили усилия для испытаний высокоскоростных соединений, которые понадобятся обновлённому варианту БАК HL-LHC. SERF уже готовит свои сети к росту нагрузок, поскольку обновлённый коллайдер HL-LHC должен заработать в 2029 году. Ожидается, что такая модернизация позволит сделать ещё больше открытий — но данных придётся обрабатывать намного больше, чем это делается сегодня. В Nokia подчёркивают, что эксперимент демонстрирует важнейшую роль сетей передачи данных в инициативах, способных раскрыть секреты вселенной.

22.03.2024 [09:09], Алексей Степин

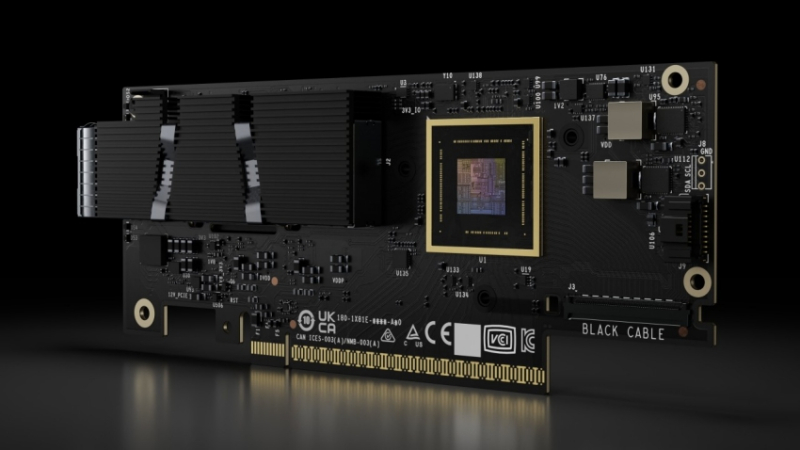

NVIDIA представила 800G-платформы Quantum-X800 и Spectrum-X800 для InfiniBand- и Ethernet-фабрик нового поколенияДополнением к только что представленным ИИ-ускорителям NVIDIA Blackwell станут новые сетевые 800G-платформы Quantum-X800 и Spectrum-X800, а также сетевые адаптеры ConnectX-8. Именно они позволят вывести масштабирование ИИ-кластеров на новый уровень и позволят «прокормить» гигантские массивы ускорителей в дата-центрах гиперскейлеров. Платформа NVIDIA Quantum-X800 ориентирована на наиболее производительные ИИ- и HPC-кластеры. Она использует новое поколение технологии InfiniBand, всё ещё обладающей рядом преимуществ в сравнении с Ethernet, и включает в себя обновлённые SHARP-движки. Технология SHARPv4 реализует «вычисления в сети» (In-Network Computing), что позволяет не только существенно разгрузить вычислительные узлы и серверы, но и обеспечить более высокую пропускную способность интерконнекта вкупе с более серьёзными возможностями его масштабирования. Основой платформы Quantum-X800 стал 4U-коммутатор Q3400-RA, впервые в индустрии, как говорит компания, использующий 200G-блоки SerDes для каждой линии InfiniBand. Коммутатор располагает 144 портами 800G в 72 OSFP-модулях и выделенным портом для Unified Fabric Manager. Новинка имеет стандартное 19″ исполнение с воздушным охлаждением, но есть и вариант Q3400-LD с жидкостным охлаждением, предназначенный для 21″ OCP-стоек. В двухуровневом варианте fat tree коммутаторы позволят объединить 10 368 NIC. Основным адаптером для новой платформы InfiniBand является ConnectX-8 SuperNIC с интерфейсом PCIe 6.0. Он является частью SHARPv4 и предлагается в однопортовом (OSFP224) и двухпортовом (QSFP112) вариантах и в нескольких форм-факторах, включая OCP 3.0. На платах также имеется разъём SocketDirect на 16 линий PCIe. Также компания представила компоненты NVIDIA LinkX: оптические трансиверы 2xDR4/2xFR4 и активные медные кабели (LACC). Не забыла NVIDIA и про Ethernet: здесь вывести производительность сети на новый уровень должна платформа Spectrum-X800. Её основой служит новейший коммутатор SN5600 — это, по словам NVIDIA, первый в мире Ethernet-коммутатор класса 800GbE, специально разработанный для применения гиперскейлерами в крупных облачных ИИ-комплексах. Применяемая архитектура позволяет гарантировать каждому клиенту оптимальный и постоянный уровень производительности, а потоковая телеметрия позволит находить и ликвидировать возможные «бутылочные горлышки» в сети буквально на лету. Общая пропускная способность SN5600 составляет 51,2 Тбит/с. Коммутатор располагает 64 портами 800GbE в формате OSFP. В нём используется ASIC пятого поколения на базе архитектуры Spectrum-4. В качестве основного адаптера предлагается SuperNIC на базе DPU BlueField-3 с двумя 400GbE-портами. Spectrum-X800 сопровождает полноценный спектр инфраструктурных компонентов, включая кабели DAC и LACC. С оптическими трансиверами длина соединения 800GbE может достигать двух километров. Начиная со следующего года, решения на базе новых сетевых платформ NVIDIA будут доступны от широкого круга поставщиков оборудования, включая Aivres, DDN, Dell Technologies, Eviden, Hitachi Vantara, HPE, Lenovo, Supermicro и VAST Data.

19.04.2023 [22:00], Алексей Степин

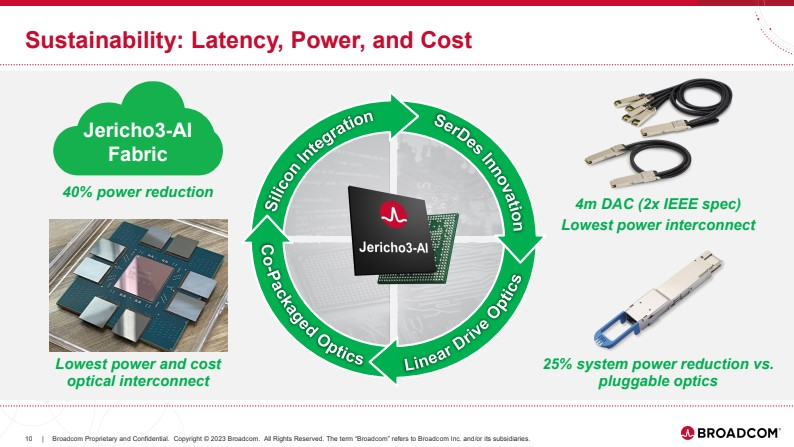

Broadcom представила чип-коммутатор Jericho3-AI для ИИ-платформ, попутно раскритиковав NVIDIAКомпания Broadcom, один из ведущих поставщиков «кремния» для сетевых решений, анонсировала новый сетевой процессор Jerico3-AI, который ориентирован на ИИ-системы. Более того, Broadcom считает подход NVIDIA к «интеллектуальным сетевым решениям» с использованием InfiniBand неверным и даже вредным для кластерных ИИ-систем. Ethernet-коммутаторы компании можно разделить три ветви: наиболее высокопроизводительные чипы Tomahawk, ориентированная на дополнительные возможности ветвь Trident и, наконец, серия Jericho, отличающаяся наибольшей гибкостью в программировании и располагающая более ёмкими буферами. Чип Jericho3-AI BCM88890 — новинка в последней категории, относящаяся к классу 28,8 Тбит/с. Новый коммутатор имеет 144 линка SerDes (106Gbps, PAM4) и может работать в конфигурации 18×800GbE, 36×400GbE или 72×200GbE.

Источник здесь и далее: Broadcom (via ServeTheHome) В своей презентации Broadcom раскритиковала традиционный подход NVIDIA и других крупных игроков на сетевом рынке, заявив о том, что прямое наращивание пропускной способности и снижение латентности кластерной сети якобы является тупиковой ветвью развития. Вместо этого фабрика на базе Jericho3-AI, по словам компании, позволяет сделать так, чтобы процесс обучения нейросети как можно меньше времени тратил не сетевые операции.  Новый коммутатор обеспечивает идеальную балансировку загрузки, гарантирующую отсутствие заторов, и автоматическое переключение отказавшего соединения на резервное менее, чем за 10-нс, а также позволяет создавать большие «плоские» сети (до 32 тыс. портов 800GbE), характерные для ИИ-кластеров. Каждый ускоритель может получить 800G-подключение, а суммарная производительность фабрики на базе новых коммутаторов может достигать 26 Пбит/с.  Broadcom утверждает, что сеть Ethernet на базе Jericho3-AI превосходит аналогичную по классу сеть NVIDIA InfiniBand в тестах с использованием NCCL. При этом новый коммутатор не содержит никаких вычислительных мощностей общего назначения — он проще, а за счёт использования стандарта Ethernet сети на его основе универсальны, что также снижает стоимость владения инфраструктурой.  Высокая степень интегрированности обеспечит и большую экономичность, а значит, решения на базе нового коммутатора Broadcom окажутся и более дружелюбны к экологии. Новые чипы уже доступны избранным клиентам Broadcom. |

|