Материалы по тегу: tpu

|

05.01.2026 [18:25], Владимир Мироненко

Anthropic купит сотни тысяч ИИ-ускорителей Google TPU напрямую у BroadcomAnthropic приобретёт около 1 млн Google TPU v7 (Ironwood) с тем, чтобы запустить их на контролируемых ею объектах, сообщил в соцсети Х ресурс SemiAnalysis. Ранее сообщалось, что примерно 400 тыс. компания купит напрямую у Broadcom в стойках за примерно $10 млрд, а остальные 600 тыс. единиц TPU v7 будут доступны посредством Google Cloud Platform (GCP) в рамках сделки на сумму около $42 млрд, что составляет большую часть увеличения портфеля заказов GCP на $49 млрд или на 46 %, о котором сообщалось в отчёте за III квартал 2025 года. В случае с закупаемыми напрямую ускорителями TeraWulf и Cipher Mining будут ответственны за инфраструктуру ЦОД, а европейское неооблако Fluidstack будет заниматься настройкой оборудования на месте, прокладкой кабелей, первичным тестированием, испытаниями при приёмке и удалённым обслуживанием, освободив Anthropic от бремени управления физическими серверами. По слухам, эти системы получат упрощённую топологию интерконнекта. Сделки Fluidstack с обоими операторами ЦОД, ранее ориентированными на криптомайнинг, финансово застрахованы Google, которая к тому же является совладельцем TeraWulf и может получить долю в Cipher Mining. Любопытно, что оба оператора частично связаны и с AWS. Хотя Google закупает TPU через Broadcom, которая тоже хочет свою маржу, это всё равно лучше, чем та маржа, что требует NVIDIA не только за продаваемые ускорители, но и за всю систему целиком, включая процессоры, коммутаторы, сетевые карты, системную память, кабели, разъёмы и т.п. По оценкам, SemiAnalysis, совокупная стоимость владения (TCO) на один чип Ironwood для полной конфигурации с топологией 3D-тор примерно на 44 % ниже, чем у серверов GB200, что с лихвой компенсирует примерно 10-% отставание TPU от GB200 по пиковым производительности и пропускной способности памяти. При этом реальная, а не теоретическая производительность (Model FLOP Utilization, MFU) у TPU, по мнению SemiAnalysis, может быть выше, чем у конкурентов. Основная причина заключается в том, что заявляемые NVIDIA и AMD показатели производительности (Флопс) значительно завышены. Даже в синтетических тестах, значительно отличающиеся от реальных рабочих нагрузок, Hopper достиг лишь около 80 % пиковой производительности, Blackwell — около 70 %, а серия MI300 от AMD — 50–60 %. Как полагают в SemiAnalysis, даже сдача ускорителей на сторону выгодна Google за счёт того, что TCO в пересчёте на час аренды может быть примерно на 30 % ниже, чем у GB200, и примерно на 41 % ниже, чем у GB300. Несмотря на высокий спрос, Google не может поставлять TPU в желаемом темпе, отметил SemiAnalysis, полагая, что основная проблема заключается в бюрократии Google — от первоначальных обсуждений до подписания генерального соглашения об оказании услуг (Master Services Agreement) проходит до трёх лет. Неооблака, включая Fluidstack, отличаются гибкостью и оперативностью, что облегчает им взаимодействие с новыми поставщиками услуг дата-центров, например, с реорганизованными криптомайнерами. Однако у неооблаков, среди инвесторов которых числится NVIDIA, таких как CoreWeave, Nebius, Crusoe, Together, Lambda, Firmus и Nscale, есть существенный стимул не внедрять конкурирующие технологии в своих дата-центрах: TPU, ускорители AMD и даже коммутаторы Arista — всё это под запретом. Это оставляет огромную нишу на рынке хостинга TPU, которая в настоящее время заполняется комбинацией майнеров криптовалют и Fluidstack, сообщил SemiAnalysis. По мнению SemiAnalysis, в ближайшие месяцы всё большему числу компаний-неооблаков предстоит принимать непростое решение между развитием возможностей хостинга TPU и получением квот на новейшие и лучшие системы NVIDIA Rubin.

03.12.2025 [09:33], Владимир Мироненко

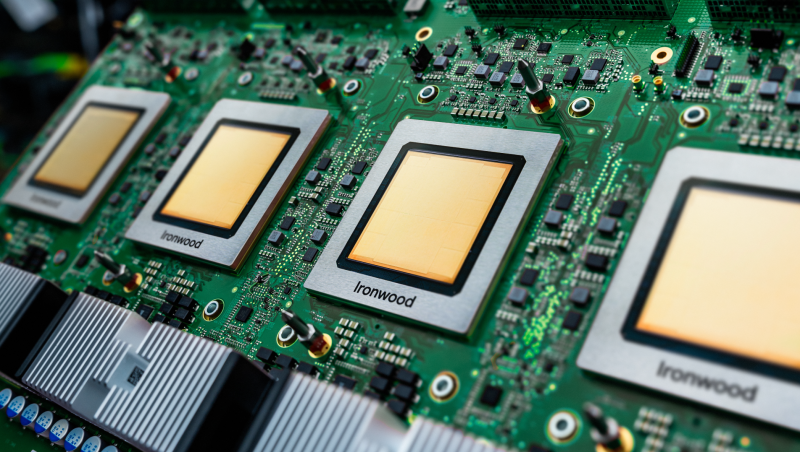

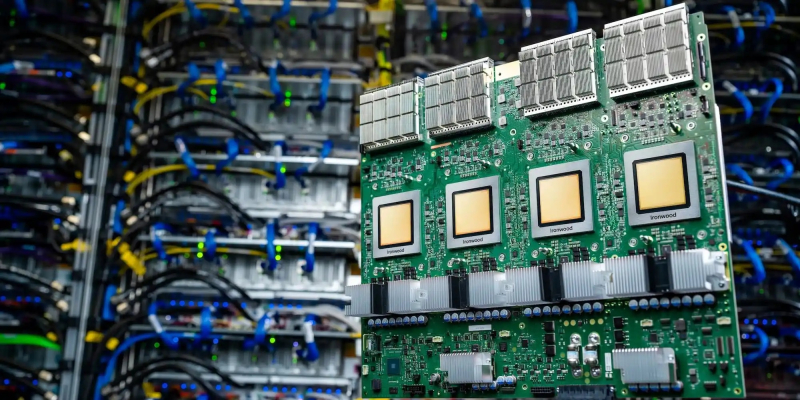

Foxconn поможет Google c TPU-серверами, а Google поможет Foxconn с «умными» роботамиFoxconn получила крупный заказ Google на поставку TPU-узлов, сообщил ресурс Taiwan Economic Daily со ссылкой на информированные источники. С учётом того, что Meta✴ планирует использовать ИИ-ускорители TPU в своих ИИ ЦОД в 2027 году, у Foxconn появилась возможность укрепить партнёрство с обоими гиперскейлерами. Да и самой Google уже сейчас катастрофически не хватает TPU для собственного облака. Foxconn уже является ключевым поставщиком платформ NVIDIA, хотя последняя всё больше ужесточает контроль над производством. По данным источников, ИИ-серверы для Google в основном поставляются в виде стоек с TPU. В этом году Google анонсировала тензорный ускоритель седьмого поколения TPU v7 Ironwood, первый чип компании, специально созданный для инференса, хотя область его применения также включает обучение крупномасштабных моделей и сложное обучение с подкреплением (RL). На его базе можно создавать кластеры (Pod) с объединением в единый вычислительный комплекс до 9216 чипов. По собственным данным Foxconn, он уже способна выпускать более 1000 ИИ-стоек в неделю. К концу 2026 года компания планирует увеличить этот показатель до более 2000 ед./нед. Также планы Foxconn включают расширение присутствия в США, где компания намерена не только осуществлять сборку серверов, но и наладить производство ключевых компонентов, таких как кабели, сетевое оборудование, системы теплоотвода и электропитания. Помимо выпуска ASIC-серверов, сотрудничество Foxconn и Google включает создание роботов, управляемых ИИ. Foxconn заключила партнерство с Intrinsic, робототехнической компанией, входящей в состав Alphabet, материнской компании Google, с целью создания совместного предприятия в США для строительства завода по выпуску роботов с поддержкой ИИ. Партнёры планируют интегрировать ИИ-платформу Intrinsic и интеллектуальную производственную платформу Foxconn для создания адаптивных интеллектуальных робототехнических решений, что ещё больше повысит эффективность производственных объектов Foxconn и всей её экосистемы. В прошлом месяце Google выпустила большую языковую модель Gemini 3, которая, как утверждается, превзошла OpenAI GPT-5 по нескольким ключевым показателям и ИИ-модели других конкурентов, что также способствовало росту популярности TPU. Согласно данным инсайдеров, Google призвала цепочку поставок ускориться в связи с предстоящим поступлением новых крупных заказов на TPU.

26.11.2025 [00:54], Владимир Мироненко

Планы Meta✴ использовать ИИ-ускорители Google TPU ударили по акциям NVIDIAВо вторник рынок ценных бумаг компаний в сфере ИИ пришёл в движение после появления в понедельник публикации ресурса The Information о том, что Meta✴ ведёт переговоры с Google об использовании ИИ-ускорителей TPU в её ЦОД в 2027 году. По данным источника ресурса, стороны также обсуждают возможность аренды этих чипов в Google Cloud уже в следующем году, что являются частью более масштабной стратегии Google по привлечению клиентов к использованию TPU в её облаке. Этот шаг ознаменует собой отход от текущей стратегии Google, нацеленной на использование TPU только в собственных ЦОД, что приведёт к обострению конкуренции на многомиллиардном рынке ИИ-ускорителей, отметило агентство Reuters. В Google Cloud предположили, что эта стратегия может помочь компании получить до 10 % годовой выручки NVIDIA, т.е. миллиарды долларов, говорится в публикации The Information. Заключение сделки станет сигналом о растущем спросе на чипы Google и потенциальной возможности бросить в будущем вызов доминированию NVIDIA на рынке, тем более что Google ранее договорилась о поставке Anthropic до 1 млн чипов TPU, пишет Bloomberg. О таком развитии событий аналитики говорили ещё в прошлом году, а уже в этом году появились слухи, что Google готова предложить свои чипы другим провайдерам. Впрочем, Anthropic получила и полмиллиона фирменных ускорителей AWS Trainium. Новость о переговорах вызвала падение во вторник акций NVIDIA на 4,3 %. Акции Alphabet, материнской компании Google, выросли на 4,2 % после более чем 6 % роста в понедельник. Акции Broadcom, участвующей в разработке TPU, выросли более чем на 2 % на премаркете во вторник после роста на 11 % накануне, сообщил CNBC. «Google Cloud испытывает растущий спрос как на наши собственные TPU, так и на GPU NVIDIA; мы намерены поддерживать обе платформы, как и делали это много лет», — заявил представитель Google телеканалу CNBC. Акции AMD, ранее считавшейся наиболее реальным конкурентом NVIDIA на рынке GPU, во вторник упали на 7,5 %. Акции разработчика чипов Arm упали на 4,2 %. Акции компаний в Азии, связанных с Alphabet, выросли в начале торгов во вторник. В Южной Корее акции IsuPetasys Co., которая поставляет многослойные платы для Alphabet, подскочили на 18 %, установив новый рекорд роста в течение дня. На Тайване акции MediaTek выросли почти на 5 %. В последние месяцы Google набрала обороты, сумев привлечь Berkshire Hathaway, принадлежащую Уоррену Баффету (Warren Buffett), в качестве инвестора, превратив облачное подразделение в двигатель роста и получив высокие первые отзывы о своей новейшей модели Gemini 3. Предоставление чипов NVIDIA в аренду клиентам является крупным источником дохода для ее облачного подразделения, пишет Reuters. Чтобы справиться с доминированием NVIDIA, компании потребуется преодолеть почти двадцатилетнюю историю NVIDIA CUDA, которая затрудняет вытеснение её экосистемы. Более 4 млн разработчиков по всему миру используют CUDA для создания ИИ-приложений и других программ. Кроме того, Google должно хватать TPU на всех клиентов. Следует учесть и то, что Meta✴ разрабатывает собственные ИИ-ускорители MTIA. UPD 01.12.2025: Сайнин Се (Saining Xie), бывший сотрудник ИИ-лаборатории Meta✴ FAIR (Fundamental AI Research), сообщил, что Meta✴ использовала Google TPU как минимум с 2020 года, однако из-за малого интереса среди других разработчиков внутри компании в начале 2023 года она отказалась от контракта с Google Cloud. Примерно за год до этого Meta✴ анонсировала создание самого мощного на тот ИИ-суперкомпьютера в мире — RSC (Research SuperCluster).

07.11.2025 [14:16], Владимир Мироненко

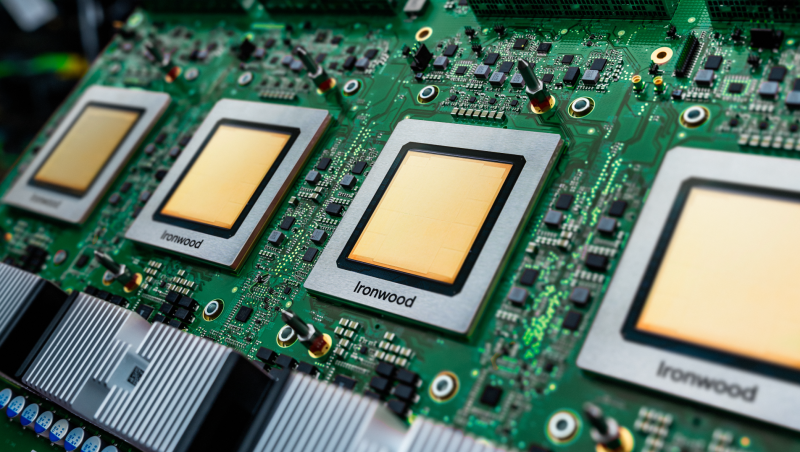

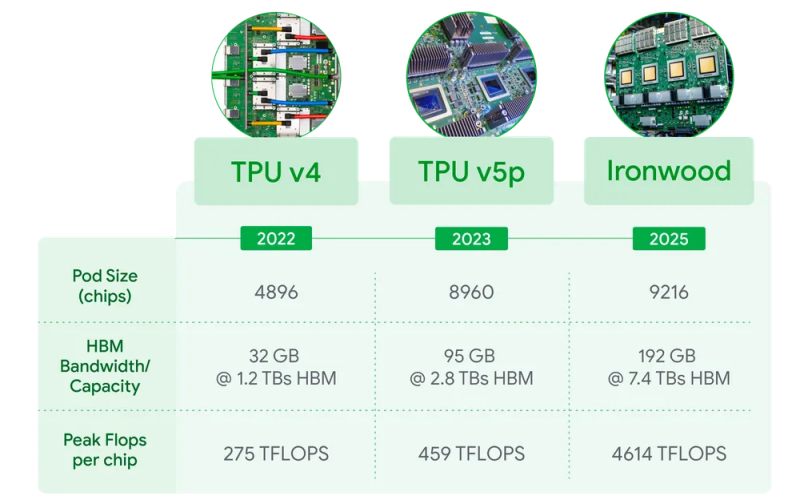

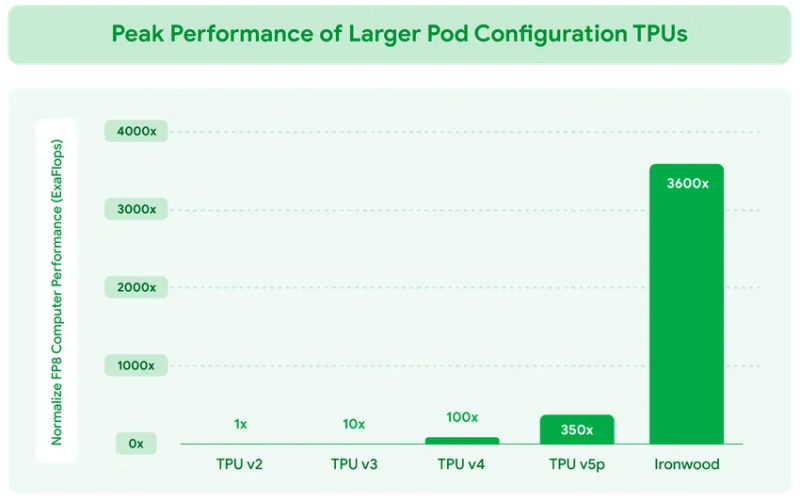

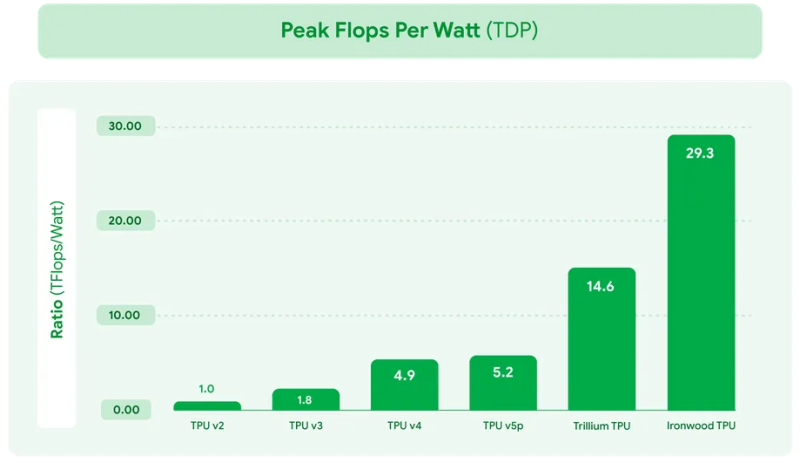

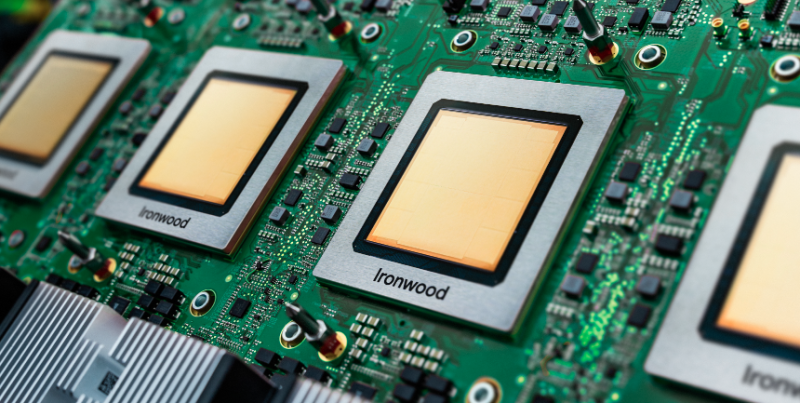

Google объявила о доступности фирменных ИИ-ускорителей TPU Ironwood и кластеров на их основеGoogle объявила о доступности в ближайшие недели ИИ-ускорителя седьмого поколения TPU v7 Ironwood, специально разработанного для самых требовательных рабочих нагрузок: от обучения крупномасштабных моделей и сложного обучения с подкреплением (RL) до высокопроизводительного ИИ-инференса и обслуживания моделей с малой задержкой. Google отметила, что современные передовые ИИ-модели, включая Gemini, Veo, Imagen от Google и Claude от Anthropic, обучаются и работают на TPU. Многие компании смещают акцент с обучения этих моделей на обеспечение эффективного и отзывчивого взаимодействия с ними. Постоянно меняющаяся архитектура моделей, рост агентных рабочих процессов и практически экспоненциальный рост спроса на вычисления определяют новую эру инференса. В частности, ИИ-агенты, требующие оркестрации и тесной координации между универсальными вычислениями и ускорением машинного обучения, создают новые возможности для разработки специализированных кремниевых процессоров и вертикально оптимизированных системных архитектур. TPU Ironwood призван обеспечить новые возможности для инференса и агентных рабочих нагрузок. TPU Ironwood был представлен в апреле этого года. По данным Google, он обеспечивает десятикратное увеличение пиковой производительности по сравнению с TPU v5p и более чем четырёхкратное увеличение производительности на чип как для обучения, так и для инференса по сравнению с TPU v6e (Trillium), что делает Ironwood самым мощным и энергоэффективным специализированным кристаллом компании на сегодняшний день. Ускорители объединяются в «кубы» — 64 шт. TPU в 3D-торе, объединённых интерконнектом Inter-Chip Interconnect (ICI) со скоростью 9,6 Тбит/с на подключение. Google сообщила, что на базе Ironwood можно создавать кластеры, включающие до 9216 чипов (42,5 Эфлопс в FP8), объединённых ICI с агрегированной скоростью 88,5 Пбит/с с доступом к 1,77 Пбайт общей памяти HBM, преодолевая узкие места для данных даже самых требовательных моделей. Компания отметила, что в таком масштабе сервисы требуют бесперебойной доступности. Её гарантирует технология оптической коммутации (OCS), которая реализуется как динамическая реконфигурируемая инфраструктура. А если клиенту требуется больше мощности, Ironwood масштабируется в кластеры из сотен тысяч TPU. Своим клиентам, пользующимся решениями на TPU, компания предлагает возможности Cluster Director в Google Kubernetes Engine. Это включает в себя расширенные возможности обслуживания и понимания топологии для интеллектуального планирования и создания высокоустойчивых кластеров. Для предобучения и постобучения компания предлагает новые улучшения MaxText, высокопроизводительного фреймворка LLM с открытым исходным кодом, которые упрощают внедрение новейших методов оптимизации обучения и обучения с подкреплением, таких как контролируемая тонкая настройка (SFT) и оптимизация политики генеративного подкрепления (GRPO) — алгоритм обучения с подкреплением (RL). Также улучшена поддержка vLLM, что позволит с минимальными усилиями перенести инференс с GPU на TPU. А GKE Inference Gateway позволит снизить задержку выдачи первого токена (TTFT). Никуда не делась и поддержка JAX с PyTorch.

05.11.2025 [14:55], Руслан Авдеев

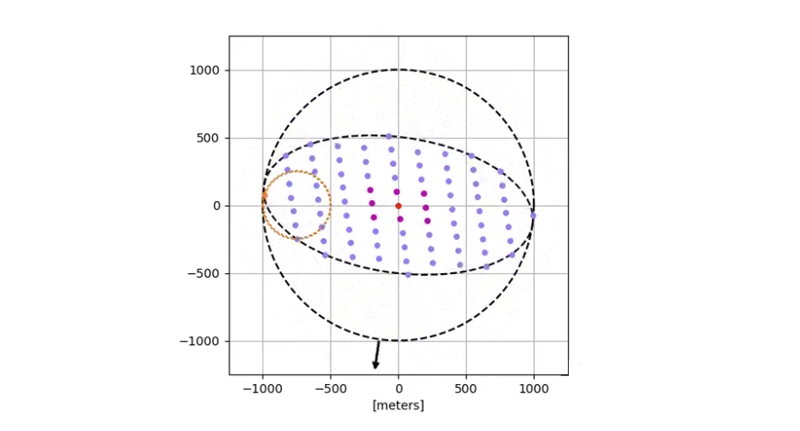

Project Suncatcher: Google рассказала о проекте масштабируемой ИИ-инфраструктуры в космосеGoogle рассказала об инициативе Project Suncatcher, предусматривающей использование группировок спутников-ЦОД на основе фирменных ИИ-ускорителей TPU. Предполагается, что спутники будут работать на солнечной энергии, в изобилии поступающей в околоземное пространство, сообщает пресс-служба техногиганта. Спутники будут связаны оптическими каналами. Размещать спутники в космосе компания намерена не случайно. При выборе подходящей орбиты солнечная панель может быть в восемь раз производительнее, чем на Земле и генерировать электричество практически непрерывно, не завися от погодных условий, что сведёт к минимуму потребность в использовании аккумуляторов. В будущем космос может стать оптимальным местом для масштабных ИИ-вычислений. Project Suncatcher предполагает создание относительно небольших спутниковых группировок с питанием от солнечных элементов, оснащённых TPU-ускорителями. Возможность использования оптических соединений друг с другом обеспечивает огромный потенциал масштабирования. Кроме того, к минимуму сводится воздействие на земные ресурсы. Компания опубликовала документ Towards a future space-based, highly scalable AI infrastructure system design, в котором описала прогресс в решении фундаментальных задач, связанных с реализацией проекта, включая высокоскоростную связь между спутниками. Учитываются орбитальная динамика и влияние радиации на вычислительные компоненты. Модульная структура обеспечит создание высокомасштабируемой ИИ-инфраструктуры в космосе в будущем.

Источник изображения: Javier Miranda/unsplash.com Предлагаемая система представляет собой сеть спутников на солнечно-синхронной низкой околоземной орбите, которые будут практически постоянно находиться под солнечными лучами. Выбор орбиты позволяет максимально эффективно использовать солнечную энергию и снизить потребность в использовании тяжёлых бортовых аккумуляторов. Тем не менее, предстоит решить ряд задач на пути к цели. Сначала необходимо обеспечить высокоскоростные оптические соединения с низкой задержкой в рамках распределённого космического ЦОД. Для того, чтобы производительность была сопоставима с земными аналогами, необходимо обеспечить связь в десятки терабит в секунду. Этого, возможно, удастся добиться с помощью спектрального уплотнения (DWDM) и пространственного мультиплексирования. Впрочем, для обеспечения необходимой пропускной способности необходима мощность сигнала в тысячи раз выше, чем в традиционных системах дальнего радиуса действия. Ожидается, что частично решить проблему можно будет, разместив спутники очень близко друг к другу (километры или даже меньше). Компания уже начала стендовые испытания подходящих технологий и добилась с парой приёмопередатчиков скорости передачи 800 Гбит/с в каждом направлении (всего 1,6 Тбит/с). Также пришлось разработать модели орбитальной динамики близко расположенных спутников, поскольку те должны летать гораздо более «компактно», чем любая существующая система. На динамику орбит, например, влияют несферичность гравитационного поля Земли и потенциальное сопротивление разреженной атмосферы при их движении. Модели показывают, что при размещении спутников на расстоянии в сотни метров друг от друга, скорее всего, потребуются лишь незначительные манёвры по поддержанию стабильности группировок в пределах нужной орбиты. Стоит отметить и необходимость обеспечения устойчивости TPU к условиям низкой околоземной орбиты. TPU v6e Trillium прошёл испытания в пучке протонов с энергией 67 МэВ для проверки их устойчивости к радиации. Наиболее чувствительными компонентами оказались HBM-модули, но в целом результаты оказались многообещающими для компонентов «из коробки» — TPU Trillium удивительно устойчивы к радиации для применения в космосе.

Источник изображения: Google Ключевую роль в успехе сыграет экономическая целесообразность проекта и стоимость запуска. Исторически именно высокие затраты на запуск были одним из основных препятствий для создания крупномасштабных космических систем. Тем не менее в Google прогнозируют, что к середине 2030-х гг. цены могут снизиться до менее $200/кг. В компании сообщают, что при таком уровне затрат стоимость запуска и эксплуатации космического ЦОД может стать приблизительно сопоставимой с заявленными затратами на питание эквивалентного наземного дата-центра в расчёте на кВт·ч/год. Предварительный анализ показывает, что непреодолимых физических и экономических препятствий для вычислений в космосе не имеется, но ещё предстоит решить ряд инженерных задач вроде проблем управления температурным режимом, обеспечения высокоскоростной наземной связи и надёжности орбитальных систем. Для решения этих задач следующим этапом станет учебная миссия при участии компании Planet, в рамках которой планируется запустить два прототипа спутников уже к началу 2027 года. Будет на практике проверена работа TPU и оптических межспутниковых каналов связи. В конечном итоге группировки гигаваттного масштаба возможно, выиграют от применения новых вычислительных архитектур, более подходящих для космической среды. Космических проектов в последние годы реализуется немало. Так, буквально в конце октября появилась новость, что Crusoe развернёт облачную платформу на спутнике Starcloud.

31.10.2025 [00:24], Владимир Мироненко

Google вынуждена отказывать клиентам из-за нехватки ИИ-ускорителей — разобраны даже TPU прошлых поколенийХолдинг Alphabet, включающий компанию Google, объявил финансовые результаты III квартала 2025 года, которые превзошли прогнозы аналитиков, в том числе благодаря успешной работе облачного подразделения на фоне высокого спроса на ИИ-сервисы. Спрос настолько велик, что у компании нет свободных TPU-ускорителей, а ожидаемые капзатраты до конца года вырастут ещё на $6–$8 млрд. Акционеры должны радоваться — согласно данным Bloomberg, с начала года ценные бумаги Google выросли на 45 %. Выручка Alphabet в минувшем квартале, закончившемся 30 сентября, выросла год к году на 16 %, впервые превысив рубеж в $100 млрд и составив $102,3 млрд. Это выше консенсус-прогноза аналитиков, опрошенных LSEG, равного $99,89 млрд. Холдинг отметил, что рост выручки Google Cloud, поискового бизнеса Google, YouTube от рекламы исчисляется двузначными числами в процентах. Скорректированная прибыль на разводнённую акцию составила $3,10 при прогнозе от LSEG в размере $2,33. Чистая прибыль холдинга выросла на 33 % до $34,98 млрд, прибыль на акцию — на 35 % до $2,87. В сентябре Google была оштрафована антимонопольными органами Европейского союза на $3,45 млрд из-за антиконкурентной практики в рекламном бизнесе, что отразилось на величине чистой прибыли. Выручка облачного подразделения Google Cloud увеличилась год к году на 34 % до $15,16 млрд, превысив прогноз StreetAccount в размере $14,74 млрд, в основном за счёт роста доходов Google Cloud Platform (GCP) по основным продуктам GCP, ИИ-инфраструктуре и решениям для генеративного ИИ. Операционная прибыль от облачных технологий выросла на 85 % до $3,6 млрд, а маржа увеличилась с 17,1 % в III квартале 2024 года до 23,7 % в III квартале 2025 года. Объём невыполненных работ по контрактам Google Cloud увеличился на 46 % по сравнению с предыдущим кварталом до $155 млрд, что, по словам финансового директора Alphabet Анат Ашкенази (Anat Ashkenazi), вызвано высоким спросом на корпоративную ИИ-инфраструктуру, включая чипы, и спросом на ИИ-чат-бот Gemini 2.5. Число ежемесячных пользователей Gemini превысило 650 млн. Генеральный директор Сундар Пичаи (Sundar Pichai) сообщил, что число клиентов облачных сервисов увеличилось почти на 34 % в годовом исчислении, причём более 70 % использует ИИ-продукты. Пичаи отметил, что компания в минувшем квартале заключила больше сделок стоимостью более $1 млрд каждая, чем за предыдущие два года вместе взятые. В том числе речь идёт о крупном контракте с Anthropic, подписанном ранее в этом месяце, и шестилетнем контракте с Meta✴ на сумму более $10 млрд, заключённом в августе. Ашкенази сообщила, что Google снова повышает прогноз капитальных затрат на 2025 год до $91–$93 млрд с предыдущего в размере $85 млрд. Капзатртаты компании в отчётном квартале составили $24 млрд, что больше, чем $22,4 млрд во II квартале и $17,2 млрд в I квартале. По словам Ашкенази, «подавляющее большинство» капитальных затрат ушло на техническую инфраструктуру: около 60 % — на серверы и 40 % — на ЦОД сетевое оборудование, пишет Data Center Dynamics. Ресурс уточнил, что крупные инвестиции в ЦОД, объявленные в этом квартале, включают $15 млрд инвестиций в штате Андхра-Прадеш (Индия), $5,8 млрд в Бельгии и по $9 млрд в Южной Каролине, Оклахоме и Вирджинии (США). Согласно прогнозу Ашкенази, напряжённая ситуация с удовлетворением высокого спроса на ИИ-инфраструктуру сохранится в четвёртом квартале и в 2026 году. Пичаи отметил запуск инстансов A4X Max на базе NVIDIA GB300, а также то, что TPU седьмого поколения — Ironwood — скоро станет общедоступным. Ранее, выступая на мероприятии венчурного фонда Andreessen Horowitz (a16z) вице-президент и генеральный директор Google по ИИ и инфраструктуре Амин Вахдат (Amin Vahdat) заявил, что спрос на TPU настолько велик, что компании приходится отказывать клиентам. Даже TPU прошлых поколений, вышедшие семь-восемь лет назад, загружены на 100 %. При этом компания, с одной стороны, готова арендовать у CoreWeave, своего прямого конкурента в области ИИ-облаков, ускорители NVIDIA Blackwell, которые фактически достанутся OpenAI, а с другой — готова, по слухам, предоставить малым облачным провайдерам свои TPU. Говоря о проблемах, с которыми сталкиваются гиперскейлеры, особенно при строительстве ЦОД, Вахдат сообщил, что отрасль в настоящее время ограничена такими факторами, как ограниченные ресурсы электроэнергии, доступность земли, получение разрешений и проблемы с цепочкой поставок. В качестве одной из ответных мер компания пошла на перезапуск АЭС Duane Arnold Energy Center (DAEC).

24.10.2025 [13:15], Руслан Авдеев

1 млн TPU и 1 ГВт: Anthropic расширит использование ИИ-ускорителей и сервисов Google CloudКомпания Anthropic объявила о знаковом расширении использования чипов TPU Google Cloud. Это обеспечит компании доступ к вычислительным ресурсам, необходимым для обучения и обслуживания ИИ-моделей Claude новых поколений. В 2026 году Anthropic рассчитывает получить доступ к мощностям, превышающим 1 ГВт, сообщает пресс-служба Google Cloud. Речь идёт о крупнейшем увеличении использования TPU компанией Anthropic за всё время использования ей тензорных ускорителей Google. Она получит доступ к 1 млн чипов, а также дополнительным сервисам Google Cloud. По оценкам некоторых экспертов, это примерная пятая часть всех TPU Google, но в 2026 году компания намерена развернуть ещё 2,5 млн TPU. Предполагается, что сделка обеспечит R&D-группы Anthropic передовой инфраструктурой, оптимизированной для ИИ-проектов, на годы вперёд. Как сообщают в Google, Anthropic выбрала TPU из-за привлекательного соотношения цены и производительности, а также благодаря имеющемуся опыту обучения и эксплуатации ИИ-моделей именно с помощью TPU. О стратегическом партнёрстве Anthropic и Google Cloud объявили в 2023 году. На сегодняшний день моделями семейства Claude компании Anthropic в Google Cloud активно пользуются тысячи компаний, включая Figma, Palo Alto Networks, Cursor и др. В Anthropic подчеркнули, что с Google компания давно сотрудничает, а последнее расширение поможет и дальше наращивать вычислительные мощности, необходимые для наращивания возможностей ИИ-систем. В числе клиентов — как компании из списка Fortune 500, так и ИИ-стартапы, которые полагаются на Claude. Расширение вычислительных возможностей гарантирует, что компания сможет удовлетворить стремительно растущий спрос, сохраняя актуальность ИИ-продуктов. В Google Cloud отметили, что Anthropic использует TPU уже несколько лет с оптимальным для неё соотношением цены и производительности, в Google продолжают инновации, опираясь на «зрелое» портфолио ИИ-ускорителей, включая TPU седьмого поколения — Ironwood.

04.09.2025 [14:47], Руслан Авдеев

Google бросила вызов NVIDIA, предложив малым облачным провайдерам собственные ИИ-ускорители TPUПо последним данным, Google обратилась к небольшим облачным провайдерам, обычно сдающим в аренду чипы NVIDIA, с необычным предложением — сдавать в аренду её собственные ИИ-ускорители TPU, ранее доступные только в облаке самой Google, сообщает Trendforce со ссылкой на The Information. Это может привести к прямой конкуренции с NVIDIA. Сообщается, что Google уже заключила соглашение как минимум с одним поставщиком облачных сервисов — лондонской Fluidstack. Предполагается разместить TPU в нью-йоркском дата-центре последней. Fluidstack предложены льготы для расширения бизнеса за счёт TPU. Если компания не сможет покрыть расходы на аренду ЦОД в Нью-Йорке, Google обещает предоставить поддержку в объёме до $3,2 млрд. Как утверждается в отчёте, Google ориентируется на молодые компании, в основном на поставщиков облачных услуг, активных пользователей ускорителей NVIDIA. Сообщается, что она уже пыталась заключить аналогичные договоры с другими поставщиками, в настоящее время отдающими предпочтение NVIDIA — включая такие перспективные компании как Crusoe, которая строит ЦОД для OpenAI. Также возможно сотрудничество с CoreWeave, сдающей оборудование NVIDIA в аренду Microsoft (в основном для OpenAI) и также имеющей прямой контракт с OpenAI.

Источник изображения: Google Google довольно давно работает над созданием ИИ-ускорителей. По данным источников The Information, компания рассматривала возможности расширения связанного с TPU бизнеса, чтобы увеличить выручку и снизить зависимость от чипов NVIDIA. По оценкам Morningstar, совокупную стоимость бизнеса TPU и подразделения DeepMind составляет приблизительно $900 млрд. Отмечается, что вышедшие в декабре 2024 года TPU Trillium шестого поколения, весьма востребованы, ожидается и рост спроса на седьмое поколение ускорителей — TPU Ironwood. Это первая модель, разработанная для масштабного инференса. Ранее Google в основном применяла TPU для собственных проектов. Однако некоторое время назад доступность TPU для внешних заказчиков в рамках Google Cloud стала намного выше. Эти чипы использует, например, Apple. Впрочем, и она теперь хочет получить ускорители NVIDIA.

27.08.2025 [09:25], Руслан Авдеев

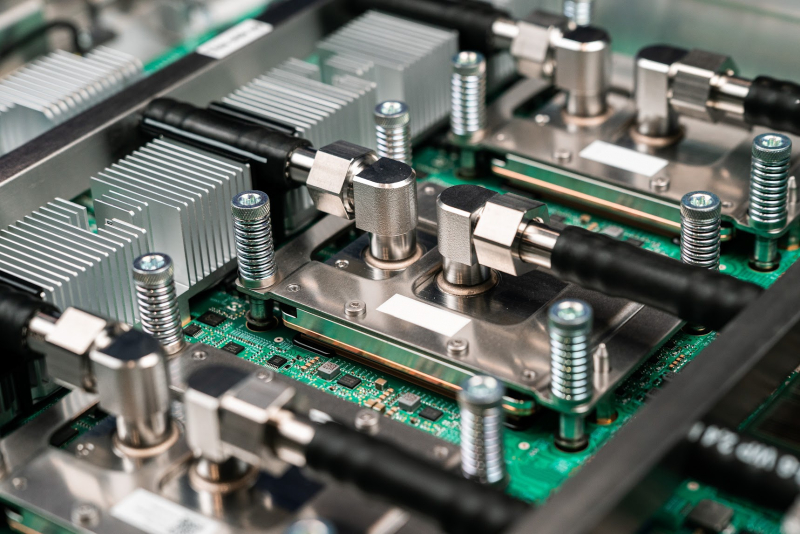

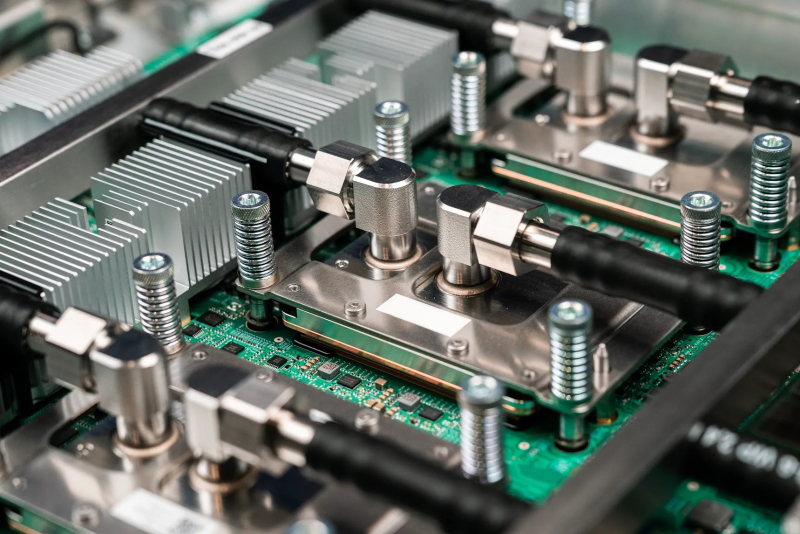

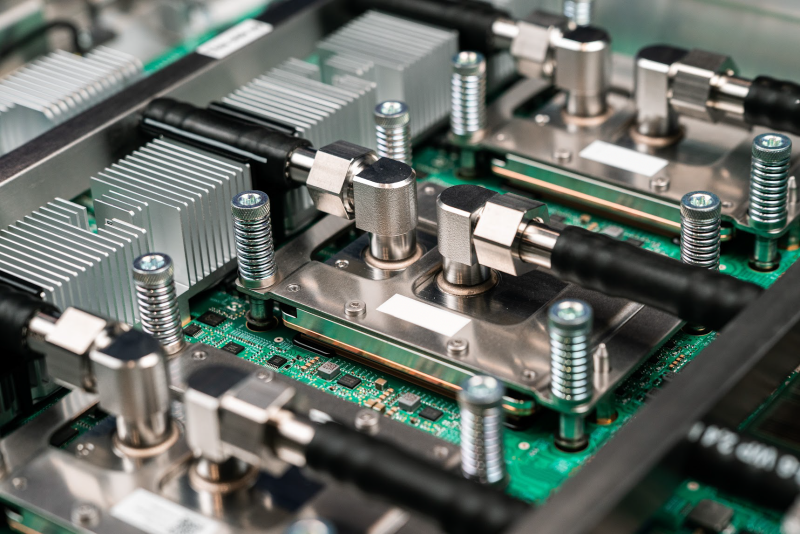

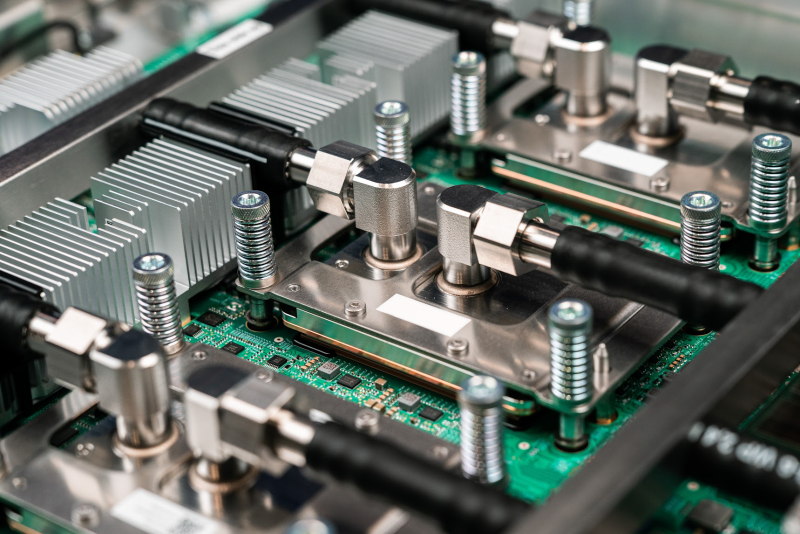

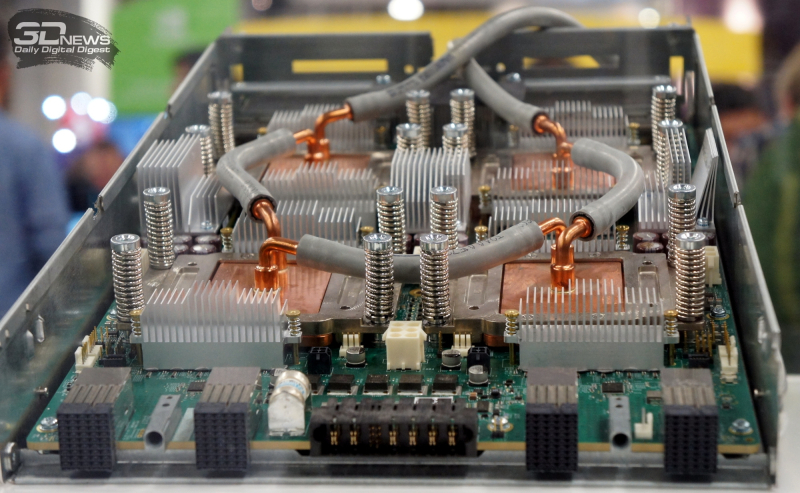

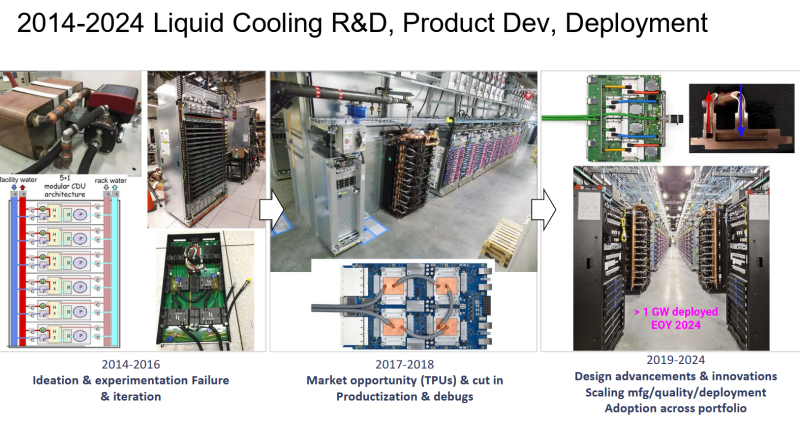

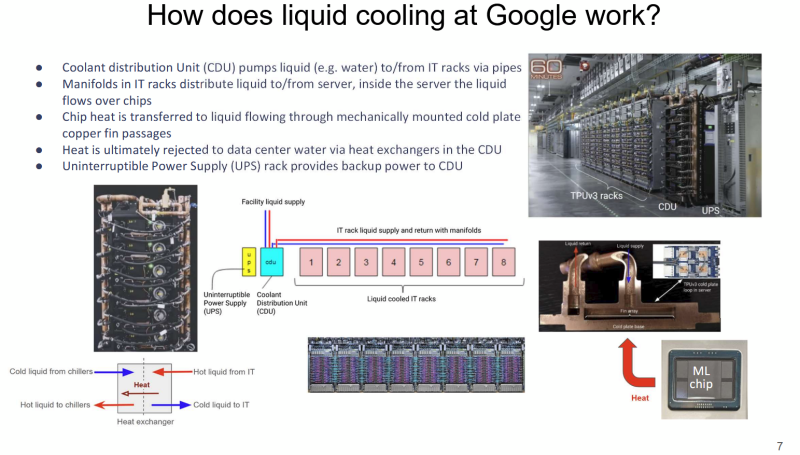

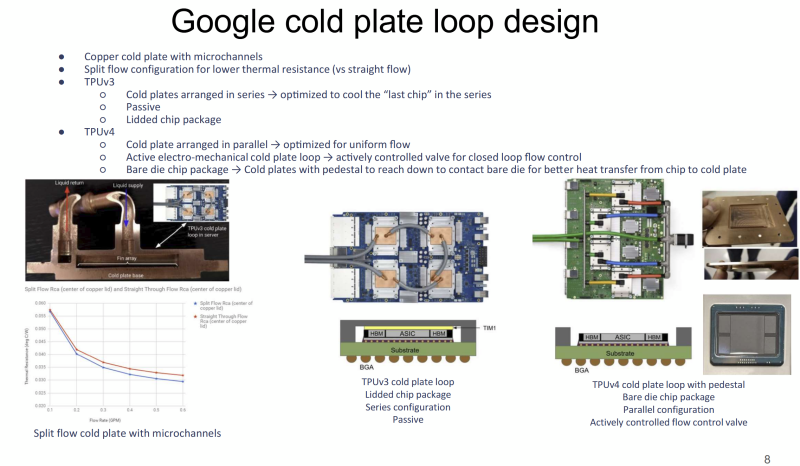

Большому ИИ — большую СЖО: Google рассказала о системе охлаждения TPUЖидкостное охлаждение (СЖО) в ЦОД применяется давно, хотя и не повсеместно. В последнее время оно играет всё более важную роль на фоне роста энергопотребления и тепловыделения ИИ-оборудования. Google рассказала об эволюции охлаждении на уровне дата-центров для своих ИИ-ускорителей TPU, сообщает Chips and Cheese. Google впервые оснастила свои TPU жидкостным охлаждением ещё в 2018 году после ряда экспериментов, и с тех пор совершенствует СЖО. Текущие решения предназначены именно для масштабов ЦОД. Так, стойки с шестью (5+1) блоками распределения жидкости (CDU) обслуживают до восьми стоек с TPU. Применяются гибкие шланги и быстроразъёмные соединения для удобства обслуживания. Во внутреннем контуре чипы в контуре соединены последовательно, что приводит к прогреву теплоносителя, поэтому расчёт охлаждающей мощности ведётся по самому горячему чипу в конце каждого контура. От CDU через теплообменники тепло передаётся в общую систему водоснабжения объекта без смешения жидкостей (в обоих контурах вода). По данным Google, энергопотребление насосов СЖО составляет менее 5 % от мощности вентиляторов, необходимых для воздушного охлаждения. Google применяет водоблок с разделённым потоком жидкости. Для охлаждения TPUv4 применялась система охлаждения открытого кристалла (bare-die). Способ не вполне безопасен, но с случае с TPUv4 такой подход необходим, поскольку такие ускорители потребляют в 1,6 раз больше энергии, чем TPUv3. Кроме того, компании пришлось поработать над проблемами протечек и появления микроорганизмов. Google тщательно проверяет компоненты на герметичность, использует специальные системы оповещения об утечках и проводит плановое обслуживание и фильтрацию. Дополнительно у компании есть набор протоколов реагирования на проблемы и оповещения, что позволяет оперативно устранять угрозы, которые в масштабах ЦОД могут быть весьма существенными. В мае сообщалось, что Google готовит мегаваттные стойки. Строго говоря, компания уже начала использовать 416 В AC на входе в стойки и DC-конвертеры, а также оснащать их встроенными ИБП. Кроме того, она динамически управляет энергопотреблением и производительностью как отдельных TPU, так и стоек в целом.

09.04.2025 [21:55], Владимир Мироненко

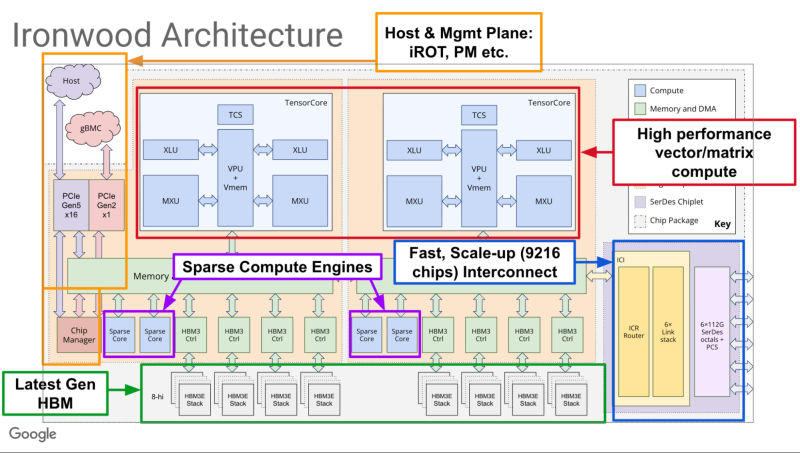

Google представила ИИ-ускоритель TPU v7 Ironwood, созданный специально для инференса «размышляющих» моделейКомпания Google Cloud представила тензорный ускоритель TPU седьмого поколения Ironwood, который охарактеризовала как свой самый производительный и масштабируемый настраиваемый ИИ-ускоритель на сегодняшний день и первый среди её чипов, разработанный специально для инференса. Новый чип представляет собой важный поворот в десятилетней стратегии Google по разработке ИИ-чипов, отметил ресурс VentureBeat. В то время как предыдущие поколения TPU были созданы в первую очередь для рабочих нагрузок обучения и инференса, Ironwood — первый чип, специально созданный для инференса. Как пояснила Google, Ironwood знаменует значительный сдвиг в развитии ИИ и инфраструктуры — переход от простых ИИ-моделей, которые просто предоставляют информацию в режиме реального времени, к моделям, которые обеспечивают проактивную генерацию идей и интерпретацию данных. Компания назвала этот период «эпохой инференса», когда ИИ-агенты будут активно извлекать и генерировать данные, чтобы совместно предоставлять информацию и ответы, а не просто «голые» сведения. Ironwood разработан в соответствии со сложными вычислительными и коммуникационными требованиями «моделей мышления», которые охватывают большие языковые модели (LLM), смешанные экспертные модели (MoE) и сложные задачи для рассуждения. Эти модели требуют массивной параллельной обработки и эффективного доступа к памяти. В частности, Ironwood разработан для минимизации перемещения данных и задержек на чипе при выполнении массивных тензорных манипуляций. Требования размышляющих моделей к вычислительным мощностям выходят далеко за рамки возможностей любого отдельного чипа. Google Cloud Ironwood будет поставляться в двух конфигурациях: с 256 или с 9216 чипами. Один чип может похвастаться пиковой вычислительной мощностью 4614 Тфлопс (FP8), а кластер из 9216 чипов мощностью порядка 10 МВт выдаёт в общей сложности 42,5 Эфлопс. Ironwood оснащён усовершенствованным блоком SparseCore, предназначенным для ускорения работы с ИИ-моделями, которые используются в системах ранжирования и рекомендаций. Расширенная реализация SparseCore в Ironwood позволяет ускорить более широкий спектр рабочих нагрузок, выйдя за рамки традиционной области ИИ в финансовые и научные сферы. Каждый чип оснащен 192 Гбайт памяти HBM, что в шесть раз больше, чем у TPU v6 Trillium. Пропускная способность памяти достигает 7,2 Тбайт/с на чип, что в 4,5 раза больше, чем у Trillium. Также используется межчиповый интерконнект Inter-Chip Interconnect (ICI) с пропускной способностью 1,2 Тбайт/с в дуплексе, что в 1,5 раза больше, чем у Trillium. Наконец, самое важное в эпоху ограниченных по мощности ЦОД — Ironwood обеспечивает вдвое большую производительность на Вт по сравнению с Trillium, а в сравнении с самым первым TPU от 2018 года он почти в 30 энергоэффективнее. Для Ironwood используется СЖО. С Ironwood разработчики также могут задействовать программный стек Pathways от Google DeepMind, чтобы использовать объединённую вычислительную мощность десятков тысяч TPU Ironwood. Как сообщается, Ironwood будет доступен клиентам Google и её собственным разработчикам в конце 2025 года. Google зафиксировала 10-кратный рост спроса на ИИ-вычисления за последние восемь лет. Как отметил ресурс VentureBeat, перенос Google фокуса на оптимизацию инференса имеет смысл. Обучение производится редко, а операции инференса — миллиарды раз в день. Экономика ИИ всё больше связана с затратами на инференс, особенно по мере того, как модели становятся всё более сложными и требующими больших вычислительных ресурсов. |

|