Материалы по тегу: google

|

09.02.2026 [23:25], Владимир Мироненко

Alphabet возьмёт в долг $20 млрд на 100 лет, чтобы вложиться в ИИХолдинг Alphabet (включает Google), объявивший на прошлой неделе о планах удвоить капзатраты в 2026 году до ≈$180 млрд, планирует привлечь $20 млрд за счёт выпуска долларовых облигаций, сообщил Bloomberg со ссылкой на информированные источники. Поначалу источники сообщали о планах Alphabet привлечь таким образом $15 млрд. По словам источников, помимо США холдинг предлагает инвесторам свои первые в истории размещения облигации в Швейцарии и Великобритании. Последнее будет включать редкую продажу 100-летних облигаций — первый случай, когда технологическая компания пытается осуществить подобное размещение со времён бума доткомов в конце 1990-х годов, отметил Bloomberg. В последний раз такой возможностью воспользовалась Motorola в 1997 году. Источники утверждают, что объявление Alphabet о выпуске долларовых облигаций в понедельник привлекло заявки на более чем $100 млрд. Собеседники Bloomberg сообщили, что холдинг разместит семь выпусков, самый «длинный» из которых со сроком погашения в 2066 году и доходностью на 0,95 п.п. выше, чем у казначейских облигаций США (ранее сообщалось о 1,2 п.п.). Согласно прогнозу Morgan Stanley, в 2026 году крупные инвестиционные компании займут $400 млрд, что намного больше $165 млрд в 2025 году. Массовое размещение облигаций, вероятно, приведёт к рекордному объему выпуска высококачественных долговых обязательств в этом году в размере $2,25 трлн, указал в своей аналитической записке Вишвас Паткар (Vishwas Patkar), глава отдела кредитной стратегии в США Morgan Stanley. Некоторые кредитные стратеги ожидают, что масштабный выпуск облигаций приведёт к расширению спредов (увеличению разницы между ценами покупки и продажи) по корпоративным облигациям, что означает увеличение рисков при операциях с такими активами. «Мы считаем, что сценарий похож на 1997/98 или 2005 год: кредиты показывают худшие результаты, но не “конец цикла”», — написал Паткар, имея в виду период, когда растёт число дефолтов и сокращается доступность кредитов. Последний раз Alphabet выходил на американский рынок облигаций в ноябре 2025 года, когда привлёк $17,5 млрд в рамках сделки с продажей 50-летних облигаций. Это было самое долгосрочное предложение корпоративных технологических облигаций в долларах США в прошлом году, согласно данным Bloomberg. Alphabet также продал в то время облигации на €6,5 млрд в Европе. Другие технологические компании тоже наращивают капзатраты в борьбе за доминирование на ИИ-рынке. Amazon объявила о планах направить на капзатраты в 2026 году $200 млрд, а Meta✴ Platforms планирует потратить от $115 до $135 млрд. Ожидаемые затраты Microsoft составят $145 млрд, а Oracle — $55 млрд.

05.02.2026 [22:55], Владимир Мироненко

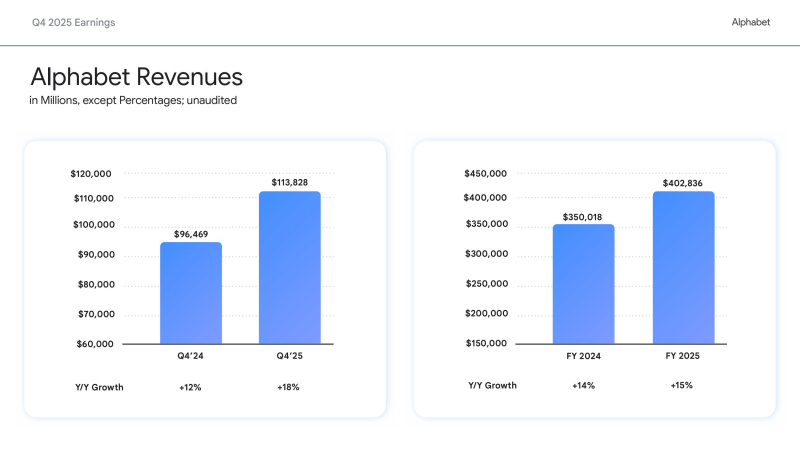

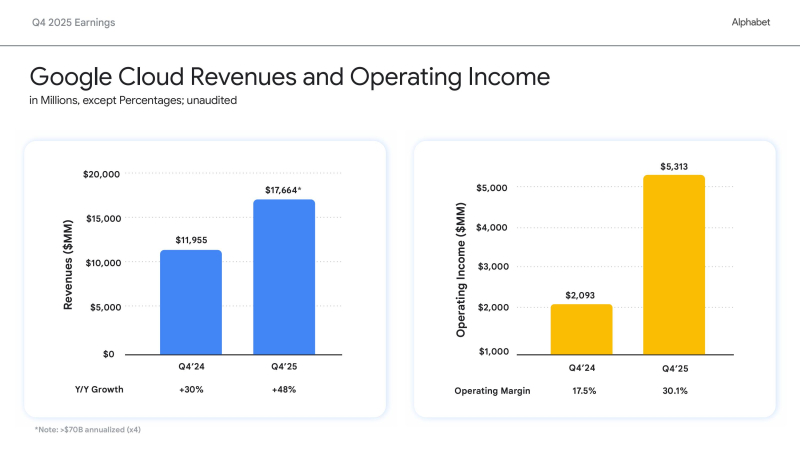

Вложимся в ИИ, а там посмотрим: Alphabet удвоит капзатраты в 2026 году на фоне полуторакратного роста выручки Google CloudХолдинг Alphabet, включающий компанию Google, объявил финансовые результаты IV квартала и всего 2025 финансового года, закончившегося 31 декабря 2025 года. Финансовые результаты компании за IV квартал превзошли прогнозы Уолл-стрит как по выручке, так и по прибыли. Как сообщил Alphabet, это отражает сильную динамику развития бизнеса и ускорение роста как в сервисах Google, так и в Google Cloud. Видимо, поэтому холдинг готов нарастить инвестиции в ИИ-инфраструктуру. Выручка за квартал выросла год к году на 18 % до $113,83 млрд, превысив консенсус-прогноз аналитиков, опрошенных LSEG, в размере $111,43 млрд (по данным CNBC). Разводнённая прибыль на акцию холдинга за квартал выросла до $2,82 с $2,15 в предыдущем году, что также выше прогнозируемых Уолл-стрит $2,63 (по данным Reuters). Годовая выручка достигла $402,8 млрд, а разводнённая прибыль на акцию — $10,81. Финансовый директор Alphabet Анат Ашкенази (Anat Ashkenazi) заявила, что Alphabet будет осуществлять свои инвестиции в 2026 году «таким образом, чтобы сохранить очень здоровое финансовое положение организации». Облачный бизнес компании — Google Cloud — продемонстрировал впечатляющий рост в IV квартале, главным образом за счёт роста доходов Google Cloud Platform (GCP) по основным продуктам, ИИ-инфраструктуре и решениям для генеративного ИИ, увеличившись на 48 % до $17,66 млрд, что превзошло ожидания аналитиков StreetAccount в размере $16,18 млрд. Это был самый высокий темп роста за более чем четыре года. Операционная прибыль сегмента составила $5,31 млрд против $2,09 млрд годом ранее. Рост облачного подразделения «впервые за несколько лет оказался значительно выше, чем у Microsoft Azure», что помогло материнской компании оправдать увеличение капитальных затрат, сказал Гил Лурия (Gil Luria), аналитик D.A. Davidson. Сообщается, что акции Alphabet поначалу упали после отчёта на 6 %, поскольку объявление, что капитальные затраты в 2026 году составят от $175 до $185 млрд, что примерно вдвое больше, чем $91,4 млрд, инвестированных компанией в 2025 году и выше прогноза Уолл-стрит в $115,26 млрд, вызвало сомнения инвесторов в масштабах и устойчивости инвестиционных планов холдинга в связи с ростом капзатрат. Впрочем, в течение дня инвесторы отыграли падение акций Alphabet до 1 %, сопоставив рост расходов с резким ростом выручки и прибыли. Ожидается, что Alphabet и её конкуренты из числа крупных технологических компаний в совокупности потратят более полутриллиона долларов на ИИ в этом году. Meta✴ на прошлой неделе объявила об увеличении инвестиций в разработку ИИ в этом году на 73 %, в то время как Microsoft также сообщила о рекордных квартальных капитальных затратах. Сообщается, что капзатраты Meta✴ составят $125 млрд (по сравнению с $70 млрд в 2025 году), Alphabet — $180 ($91 млрд), Amazon — $175 млрд ($125 млрд), Microsoft — $145 млрд ($83 млрд), Oracle — $55 млрд ($35 млрд). То есть только эти пять компаний увеличат в 2026 году капзатраты по сравнению с прошлым годом почти на $300 млрд — с $404 млрд до $680 млрд. «Мы испытывали ограничения в поставках, даже несмотря на то, что наращивали наши мощности», — сказал гендиректор Сундар Пичаи (Sundar Pichai). — Очевидно, что наши капитальные затраты в этом году — это взгляд в будущее». «Мы видим, что наши инвестиции в ИИ и инфраструктуру стимулируют рост выручки», — отметил он в ходе общения с аналитиками, дополнительно высказав опасения, что Alphabet столкнётся с продолжающимися ограничениями в поставках в течение всего года. Пичаи отметил, что почти 75 % клиентов Google Cloud используют вертикально оптимизированный ИИ компании — от чипов и моделей до ИИ-платформ и корпоративных ИИ-агентов, которые обеспечивают высокую производительность, качество, безопасность и экономичность. «Эти клиенты, использующие ИИ, применяют в 1,8 раза больше продуктов, чем те, кто этого не делает, что позволяет нам диверсифицировать портфель продуктов, углублять отношения с клиентами и ускорять рост доходов», — подчеркнул гендиректор. Аналитики Barclays отметили: «Рост облачных сервисов поразителен, если измерять его любыми показателями: выручка, портфель заказов, количество полученных токенов API, внедрение Gemini в корпоративном секторе. Эти показатели в сочетании с прогрессом DeepMind в разработке моделей начинают оправдывать 100-% увеличение капитальных затрат в 2026 году». В RBC Capital Markets заявили, что динамика развития Gemini и резкий рост выручки Google Cloud в IV квартале являются «достаточными доказательствами, оправдывающими увеличение инвестиций» в 2026 году. Аналитики Deutsche Bank отметили, что Alphabet «поразила мир» своим масштабным планом капитальных затрат. «В условиях нынешних перемен в технологическом секторе неясно, хорошо это или плохо», — написали они. Добавим, что выручка сегмента Google Services — включающего доходы от рекламы в поиске и YouTube, на который приходится большая часть выручки Alphabet — выросла за квартал лишь на 14 % по сравнению с предыдущим годом до $95,86 млрд, что выше прогнозируемых $94,9 млрд согласно консенсус-прогнозам аналитиков, опрошенных Bloomberg. Акции Alphabet взлетели более чем на 70 % за последние шесть месяцев, и в прошлом месяце холдинг стала четвёртой компанией в истории, достигшей рыночной капитализации в $4 трлн, присоединившись к NVIDIA, Microsoft и Apple, отметил ресурс Forbes.

30.12.2025 [14:30], Руслан Авдеев

Нигерия ведёт с Google переговоры о прокладке нового подводного интернет-кабеляНигерия и Google ведут активные переговоры о прокладке нового подводного кабеля. Предполагается, что это поможет укрепить «цифровую устойчивость» страны, находящейся на западе Африки, сообщает Bloomberg со ссылкой на высокопоставленного нигерийского чиновника. В Google подтвердили, что переговоры действительно находятся на «продвинутой» стадии. В сентябре 2025 года Google сообщала о намерении создать четыре новых инфраструктурных центра в Африке для подключения новейших ВОЛС. Национальное агентство информационных технологий (National Information Technology Development Agency) страны заявляет, что Нигерия намерена расширить существующие подводные каналы связи. В агентстве назвали зависимость Нигерии от кабелей, проложенных по одному и тому же маршруту, «единой точкой отказа». В агентстве отмечают, что Нигерия ведёт переговоры не только с Google, но и с другими техногигантами. Помимо развития систем связи, страна стремится развивать цифровую инфраструктуру для улучшения доступа к надёжным облачным сервисам и вычислительным мощностям. Африка не раз страдала от серии интернет-сбоев из-за повреждения подводных кабелей. При этом на континенте рекордными темпами растёт численность населения и увеличивается потребность в улучшении доступа к передовым технологиям, в том числе ИИ. Власти страны надеются, что инвестиции помогут превратить Нигерию в региональный цифровой хаб. Как сообщает отраслевой техноблог Subsea Cables & Internet Infrastructure, с некоторых пор стало очевидно, что кабельные сети 2Africa и Equiano недостаточно эффективны, чтобы соответствовать росту африканского интернет-трафика. Во-первых, у Equiano не очень много посадочных станций: только в Того, Нигерии, Намибии и Южной Африке. Во-вторых, 2Africa обеспечивает пропускную способность только 180 Тбит/с, при этом обслуживая 17 африканских государств. Более того, кабельная система обслуживает и ближневосточные страны, Пакистан и Индию. Пока нет достоверных данных, где именно будет проложен новый кабельный маршрут. По некоторым сведениям, речь может идти о прямой «цифровой магистрали», связывающей интернет-хаб в Атланте или Эшберне (крупнейший дата-центр Equinix) с Лагосом (Нигерия). Не исключено и строительство прямой магистрали, связывающей Нигерию и Францию или Испанию.

27.12.2025 [00:45], Владимир Мироненко

Google избавляется в России от устаревших серверов GGCGoogle разослала российским интернет-провайдерам уведомления о том, что планирует забрать устаревшие кеширующие серверы Dell R720, срок службы которых давно закончился, сообщил ресурс РБК со ссылкой на источники среди провайдеров. Эти серверы используются в системе Google Global Cache (GGC) для кеширования наиболее востребованного контента с целью более быстрой его загрузки местными пользователями. После ухода с российского рынка в 2022 году Google больше не модернизировала систему GGC. В марте 2025 года из-за того, что её российская «дочка» находится в состоянии банкротства, Google отключила пиринговые соединения с некоторыми российскими точками обмена трафиком (IX) и ЦОД. В письмах, направленных интернет-провайдерам, являющимся партнёрами GGC, компания отметила, что будет выводить из эксплуатации серверы, которые сняты с производства и не имеют гарантийного обслуживания, с 26 января 2026 года. В связи с этим Google попросила операторов отключить и извлечь из стойки серверы, а также предоставить адрес, где их можно забрать. Источник РБК также сообщил, что вопросами передачи оборудования для Google занимается европейская компания MPK Asset Solutions. По его словам, часть серверов компания уже вывезла. При этом конкурсный управляющий по делу о банкротстве ООО «Гугл» заявил РБК, что не имеет информации о вывозе оборудования Google из России. Комментируя планы Google вывезти серверы из России, эксперты отметили, что речь идёт о старом оборудовании, официальная поддержка которого была прекращена ещё в 2018 году. Также они считают, что могут возникнуть сложности с его вывозом из-за отсутствия правовых оснований и продолжающейся процедуры банкротства юрлица Google в России. Ранее Google предложила операторам, причём не только российским, вместо GGC использовать прямое присоединение к своей сети. Google, равно как и другие гиперскейлеры, уже давно занимается строительством собственной глобальной сети. В апреле Google объявила о запуске Cloud WAN, полностью управляемой корпоративной WAN-платформы, обеспечившей доступ к её всемирной сетевой инфраструктуре всем организациям и компаниям.

24.12.2025 [15:55], Руслан Авдеев

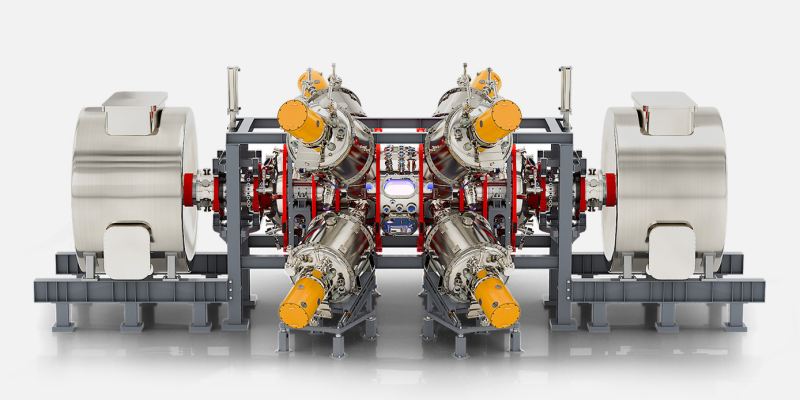

Холдинг Трампа слился с разработчиком термоядерных реакторов TAE Technologies, которого поддерживает GoogleВ рамках сделки на сумму $6 млрд состоялось слияние детища президента США Дональда Трампа (Donald Trump) Trump Media & Technology Group (TMTG) и TAE Technologies, занятой разработкой технологий термоядерного синтеза, сообщает Datacenter Dynamics. Новая компания должна объединить несколько структур, включая Truth Social, TAE Power Solutions и TAE Life Sciences. После того, как сделка завершится, акционеры компаний, участвующих в сделке, получат приблизительно 50-% доли объединённой компании. Сообщается, что TMTG согласилась предоставить TAE до $200 млн на момент подписания соглашения и ещё $100 млн после первоначальной подачи формы S-4. Руководством новой компанией должны совместно заняться действующий глава TMTG Девин Нуньес (Devin Nunes) и глава TAE Михл Бинденбауэр (Michl Binderbauer), оба будут работать генеральными директорами новой структуры. После объединения компаний планируется начать строительство первой в мире крупной термоядерной электростанции, мощность которой должна составить около 50 МВт. После этого будут строиться дополнительные станции мощностью 350–500 МВт. TMTG заявляет, что делает большой шаг вперёд к революционной технологии, позволяющей закрепить энергетическое превосходство США на поколения вперёд. Освоение термоядерной энергетики станет самым значимым технологическим прорывом в энергосфере со времён начала коммерческого использования атомной энергии в 1950-х гг. Новая технология в случае успеха снизит цены на электричество, увеличит его предложение и, вероятно, обеспечит превосходство Америки в сфере ИИ, возродит производственную базу США, а также укрепит национальную оборону. TMTG обеспечит капитал и доступ к публичному рынку, что позволит быстро вывести технологии TAE на коммерческий уровень.

Источник изображения: TAE Technologies Термоядерный синтез вызывает всё больше интереса у гиперскейлеров, рассчитывающих получить низкоуглеродный источник энергии в обозримом будущем. TAE впервые получила поддержку Google в 2015 году, теперь она сотрудничает с другими бизнесами для совершенствования технологии термоядерного синтеза с использованием машинного обучения. В июне 2025 года TAE привлекла более $150 млн при поддержке Google для финансирования работ над первым реактором. А всего с момента основания она привлекла уже более $1,3 млрд акционерного капитала. Хотя в разработку соответствующих технологий вкладываются огромные средства, успешная коммерциализация ядерного синтеза в ближайшем будущем до сих пор под вопросом. Большинство экспертов прогнозирует появление готовых коммерческих решений в середине 2040-х гг. Пока же ни одна компания или государство не смогли построить экономически эффективный терморядерный реактор. Помимо бизнеса, связанного с термоядерной энергетикой, у TAE есть две частично принадлежащих ей компании: TAE Power Solutions и TAE Life Sciences. В июне первая заключила партнёрское соглашение с майнинговой компанией MARA для разработки высокочастотной системы управления энергонагрузками для эффективного удовлетворения энергетических потребностей ЦОД, связанных с ИИ и HPC. Ставку на термоядерную энергию делают многие участники рынка ЦОД. Например, Microsoft надеется, что ИИ ускорит создание термоядерных реакторов для дата-центров. В июле Google договорилась о покупке термоядерной энергии у детища MIT — Commonwealth Fusion Systems, а в сентябре появилась информация, что последняя привлекла на развитие ещё $863 млн.

23.12.2025 [15:03], Руслан Авдеев

Google купит Intersect Power за $4,75 млрд, получив несколько гигаватт энергии для своих ИИ ЦОДGoogle объявила о покупке за $4,75 млрд американского девелопера энергетической инфраструктуры Intersect Power, сообщает Datacenter Dynamics. Google также возьмёт на себя долги приобретаемой компании. Сделка будет закрыта в I половине 2026 года. В рамках сделки «материнская» Google структура — Alphabet получит портфолио как строящихся, так и находящихся в разработке активов Intersect на несколько гигаватт. Google уже является миноритарным акционером Intersect. Google сообщает, что Intersect не только позволит расширить мощности и более гибко строить генерирующие мощности с учётом потребностей новых дата-центров, но и переосмыслить энергетические проекты, чтобы стимулировать инновации и обеспечить лидерство США в связанных сферах. При этом Intersect останется отдельным юридическим лицом, а некоторые активы в Техасе и Калифорнии будут функционировать как независимый бизнес, поддерживаемый TPG Rise Climate, Climate Adaptive Infrastructure и Greenbelt Capital Partners. После сделки Intersect получит новые технологии для наращивания и диверсификации поставок энергии. Компанией продолжит управлять действующий глава Шелдон Кимбер (Sheldon Kimber). В то же время предусмотрено сотрудничество с командой Google, занимающейся технической инфраструктурой. В числе прочего речь идёт о ранее анонсированной инициативе по созданию дата-центра и энергоплощадки в техасском округе Хаскелл (Haskell, Техас).

Источник изображения: Intersect Power Intersect Power специализируется на экологически чистой энергетике. Её портфолио включает солнечные энергетические установки и аккумуляторные энергохранилища на 2,4 ГВт∙ч, в первую очередь в Техасе и Калифорнии. В 2024 году компания впервые начала взаимодействовать с Google для разработки технологий размещения источников возобновляемой энергии и энергохранилищ при новых ЦОД по всей территории США. В рамках первоначального соглашения Intersect согласилась построить объекты «зелёной» энергетики для Google, которая намеревалась закупать энергию для кампусов ЦОД и стать якорным арендатором в новых технопарках. Также Intersect тесно взаимодействует с другими участниками технологической экосистемы, наиболее значимым из которых является Tesla. По данным Intersect, компания заключила соглашение о покупке аккумуляторных энергохранилищ Tesla Megapack на 17,7 ГВт∙ч, что делает её одним из крупнейших заказчиков такого рода в США.

18.12.2025 [17:21], Руслан Авдеев

Google на деньги военных проложит три подводных интернета-кабеля Pukpuk в Папуа-Новой Гвинее — Австралия и США не рады усилению Китая в регионеGoogle намерена проложить три подводных кабеля в Папуа-Новой Гвинее. Проект в акватории крупнейшего в Тихом океане островного государства финансируется Австралией в рамках договора о взаимной обороне, сообщает Reuters. Это станет ключевым шагом в модернизации цифровых магистралей страны. По мнению военных США и Австралии, богатая ресурсами, но относительно слабо развитая экономически Папуа-Новая Гвинея имеет стратегическое географическое положение, поскольку в регионе активно наращивает своё влияние Китай. Власти Папуа-Новой Гвинеи сообщают, что проект Pukpuk Connectivity Initiative стоимостью $120 млн позволит соединить север и юг государства, а также автономный регион Бугенвиль (Bougainville) кабелями с большой пропускной способностью. Проект финансируется в рамках договора Pukpuk Treaty, который обеспечит австралийским военным доступ к системам связи Папуа-Новой Гвинеи, включая спутниковые станции и кабели — все инвестиции осуществляются за счёт обязательства Австралии по взаимной обороне по договору от октября 2025 года. Военные связи со страной укрепляют и США — в 2023 году стороны подписали пакт об оборонном сотрудничестве. Кабели, как ожидается, будет прокладывать Google. Министерство иностранных дел Австралии заявило, что прокладка кабелей позволит снизить цены на интернет для потребителей, будет способствовать экономическому росту и расширит возможности образования для местных жителей. Представители Папуа надеются, что кабели позволят стране привлечь инвестиции гиперскейлеров и IT-компаний глобального масштаба.

Источник изображения: Ernests Vaga/unsplash.com По данным Datacenter Dynamic, сегодня к Папуа-Новой Гвинее подходят два подводных кабеля — Coral Sea Cable System (CS²) и PIPE Pacific Cable-1 (PPC-1), соединяющих регион с Австралией, Соломоновыми островами и Гуамом. Также до Папуа должен протянуться кабель Hawaiki Nui 1, соединяющий Австралию с Сингапуром через Индонезию. Kacific и SES предоставляют в стране спутниковые услуги. Локальная подводная кабельная сеть Папуа-Новой Гвинеи для внутренних коммуникаций была построена Huawei в 2018 году и профинансирована за счёт кредита, предоставленного китайским банком EXIM Bank. В последние годы Австралия и США неоднократно финансировали прокладку подводных кабелей для максимального охвата тихоокеанских островов — это должно было блокировать стремление Китая создавать телекоммуникационные линии в регионе — Австралия и её союзники рассматривают их, как угрозу безопасности. На эти нужды Австралия выделила более AU$450 млн ($300 млн). Средства предназначались для прокладки подводных кабелей через Тихий океан и Восточный Тимор, включая кабель Coral Sea между Папуа-Новой Гвинеей, Соломоновыми островами и Австралией. В ноябре Google сообщила о намерении проложить кабель от острова Рождества в Индийском океане до Австралии — это ещё одна важная для обороны локация. По данным Google, в Африку и Азию будут проложены ещё две кабельные системы, это должно «повысить устойчивость» интернет-инфраструктуры в Индийском океане.

11.12.2025 [09:03], Руслан Авдеев

Мы вам — ИИ, вы нам — энергию: Google и NextEra Energy совместно займутся постройкий ЦОД и развитием энергетикиЭнергетическая компания NextEra Energy заключила с Google Cloud соглашение о строительстве трёх кампусов ЦОД гигаваттного уровня с попутным созданием генерирующей и другой инфраструктуры, сообщает Datacenter Dynamics. Параллельно NextEra заключила с Meta✴ контракты на поставку 2,5 ГВт «чистой» энергии. В целом компании намерены совместно строить крупномасштабные ЦОД и энергетическую инфраструктуру, развивать передовые технологии и пересмотреть сами принципы работы энергетических компаний. В рамках партнёрства Google Cloud интегрирует генеративный ИИ и ИИ-агентов в инфраструктуру NextEra, чтобы помочь последней прогнозировать проблемы с оборудованием и выявлять прочие «узкие места» Партнёрство также обеспечит NextEra доступ к модели прогнозирования временных рядов TimesFM 2.5, метеомодели WeatherNext 2 и решению для моделирования перетоков мощности с учётом ограничений безопасности. За счёт этих технологий планируется получить более точные данные для оптимизации работы энергосети, что позволит улучшить планирование и качество управление сетью, снизить затраты и повысить надёжность электроснабжения клиентов NextEra Energy.

Источник изображения: NextEra Как считают в Google, интеграция компетенций NextEra с облачной ИИ-инфраструктурой Google Cloud, платформами и моделями компании поможет обеспечить «цифровое будущее» энергетической инфраструктуры. Первый коммерческий продукт для этой индустрии должен появиться на площадке Google Cloud Marketplace к середине 2026 года. Ранее Google и NextEra подписали 25-летнее соглашение на поставку электроэнергии (PPA), которое позволит перезапустить АЭС Duane Arnold Energy Center (DAEC), рядом с которой Google хочет построить до шесть ЦОД. С 2029 года практически вся энергия DAEC будет отправляться именно им. В результате Google получает стабильный и «чистый» источник энергии для своих ИИ-нагрузок, а NextEra — ресурсы для модернизации активов и передовые цифровые инструменты для повышения эффективности энергосети. Отдельно NextEra заключила соглашение с Meta✴ о поставках 2,5 ГВт «чистой» энергии в США. Речь идёт об 11 соглашениях о покупке энергии (PPA), и двух соглашениях о хранении энергии (Energy Storage Agreements, ESA). Соответствующие энергетические проекты должны заработать в 2026–2028 гг..

05.12.2025 [09:07], Руслан Авдеев

Google и Kioxia получат электроэнергию от модернизированной ГЭС в ЯпонииGoogle и японская Kioxia заключили партнёрское соглашение для получения электроэнергии от модернизированной гидроэлектростанции в префектуре Тюбу (Chubu) в Японии, сообщает Datacenter Dynamics. Ожидается, что проект, владельцем и оператором которого выступает бизнес-группа Chubu Electric Power, поможет обеим компаниям в их инициативах по декарбонизации. Kioxia уже начал закупки электричества. Ожидается, что ГЭС обеспечит компании 160 ГВт∙ч/год. Kioxia заявляет, что это поможет компании уже к 2040 году получать 100 % энергии из возобновляемых источников и достичь нулевых выбросов к 2050 году. Соглашение о закупках энергии позволит японскому производителю круглосуточно получать электричество, а Google — сократить непрямые выбросы Scope, не связанные непосредственно с деятельностью компании. В каких объёмах Google намерена закупать электроэнергию, не разглашается. В США она потратит $3 млрд на закупку энергии ГЭС. По словам Google, реализация проекта стала возможной благодаря усилиям IT-гиганта по обеспечению промышленных компаний Японии дополнительными, экономичными и экологически чистыми источниками энергии. Утверждается, что Google и Kioxia сосредоточились на модернизации уже существующей инфраструктуры и таким образом продвигают практичный и эффективный метод повышения доступности «чистой» энергии в Японии.

Источник изображения: Kaito Kinjo/unsplash.com Детели проекта, связанного с соглашением, не раскрываются. Chubu Electric владеет и управляет двумя сотнями ГЭС совокупной мощностью 5,477 ГВт, которые разбросаны по всей Японии. Сейчас компания модернизирует и реконструирует старые гидроэлектростанции для повышения их производительности и эффективности в целом. Google заключила в Японии два соглашения о поставках возобновляемой энергии для обеспечения работы своего единственного в стране дата-центра — он расположен в Индзае (Inzai). В 2024 году компания впервые подписала соглашение (PPA) о покупке «чистой» энергии с Clean Energy Connect и Shizen Energy, предусматривающее оплату 60 МВт в рамках двух «солнечных» проектов. В сентябре 2024 года Google заключила «виртуальное» PPA-соглашение на 15 МВт с японской энергетической группой Jera. Потребности Японии в энергии на фоне бума ЦОД продолжают расти. Ещё в мае 2024 года местные власти прогнозировали, что стране придётся производить на 35–50 % больше энергии к 2050 году. А год спустя уже сам глава NVIDIA лично призвал премьер-министра Японии к увеличению производства электроэнергии для развития ИИ-индустрии.

03.12.2025 [09:33], Владимир Мироненко

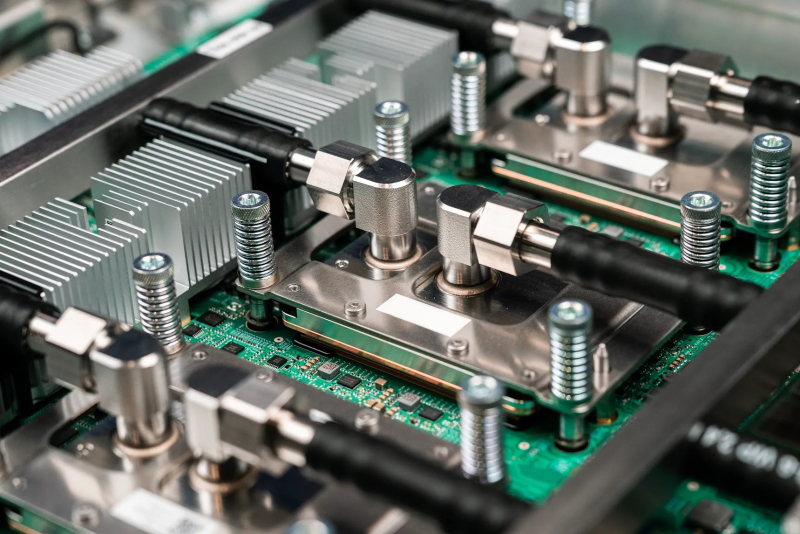

Foxconn поможет Google c TPU-серверами, а Google поможет Foxconn с «умными» роботамиFoxconn получила крупный заказ Google на поставку TPU-узлов, сообщил ресурс Taiwan Economic Daily со ссылкой на информированные источники. С учётом того, что Meta✴ планирует использовать ИИ-ускорители TPU в своих ИИ ЦОД в 2027 году, у Foxconn появилась возможность укрепить партнёрство с обоими гиперскейлерами. Да и самой Google уже сейчас катастрофически не хватает TPU для собственного облака. Foxconn уже является ключевым поставщиком платформ NVIDIA, хотя последняя всё больше ужесточает контроль над производством. По данным источников, ИИ-серверы для Google в основном поставляются в виде стоек с TPU. В этом году Google анонсировала тензорный ускоритель седьмого поколения TPU v7 Ironwood, первый чип компании, специально созданный для инференса, хотя область его применения также включает обучение крупномасштабных моделей и сложное обучение с подкреплением (RL). На его базе можно создавать кластеры (Pod) с объединением в единый вычислительный комплекс до 9216 чипов. По собственным данным Foxconn, он уже способна выпускать более 1000 ИИ-стоек в неделю. К концу 2026 года компания планирует увеличить этот показатель до более 2000 ед./нед. Также планы Foxconn включают расширение присутствия в США, где компания намерена не только осуществлять сборку серверов, но и наладить производство ключевых компонентов, таких как кабели, сетевое оборудование, системы теплоотвода и электропитания. Помимо выпуска ASIC-серверов, сотрудничество Foxconn и Google включает создание роботов, управляемых ИИ. Foxconn заключила партнерство с Intrinsic, робототехнической компанией, входящей в состав Alphabet, материнской компании Google, с целью создания совместного предприятия в США для строительства завода по выпуску роботов с поддержкой ИИ. Партнёры планируют интегрировать ИИ-платформу Intrinsic и интеллектуальную производственную платформу Foxconn для создания адаптивных интеллектуальных робототехнических решений, что ещё больше повысит эффективность производственных объектов Foxconn и всей её экосистемы. В прошлом месяце Google выпустила большую языковую модель Gemini 3, которая, как утверждается, превзошла OpenAI GPT-5 по нескольким ключевым показателям и ИИ-модели других конкурентов, что также способствовало росту популярности TPU. Согласно данным инсайдеров, Google призвала цепочку поставок ускориться в связи с предстоящим поступлением новых крупных заказов на TPU. |

|