Материалы по тегу: hardware

|

09.03.2026 [16:39], Владимир Мироненко

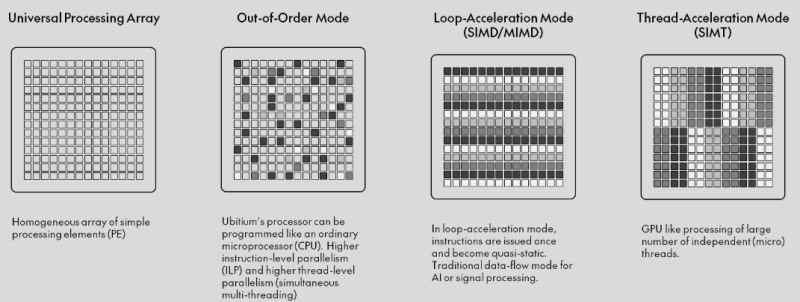

Ubitium стала на шаг ближе к выпуску универсального RISC-V процессора, заменяющего CPU, GPU, DSP и FPGAНемецкий стартап Ubitium объявил о завершении стадии tape-out (финальный этап проектирования) универсального RISC-V-процессора, изготовленного по 8-нм техпроцессу Samsung Foundry и предназначенного для рынка встроенных вычислительных систем автомобилей, промышленного оборудования и бытовой электроники, включая радарные и многосенсорные сигнальные цепи, аудио и голосовую связь в реальном времени, компьютерное зрение, периферийный ИИ, промышленный человеко-машинный интерфейс (HMI) и т.д. В основе процессора Ubitium лежит «универсальный процессорный массив» (Universal Processing Array) — программно-определяемая система с 256 элементами, объединяющая функции CPU, GPU, DSP и FPGA и способная мгновенно менять режимы выполнения во время работы. Такая унификация позволяет чипу переключаться между режимом работы в качестве CPU общего назначения для обслуживания ОС и режимом работы в качестве ИИ-ускорителя, избегая задержек при передаче данных между отдельными чипами.

Источник изображения: Ubitium Завершение tape-out на 8-нм техпроцессе Samsung подтверждает работоспособность основного процессорного массива и интерфейса LPDDR5. Для Ubitium доказательство того, что один процессор может обрабатывать общие вычислительные задачи, задачи обработки в реальном времени и задачи ИИ на одном кристалле, является важным шагом на пути к коммерческой жизнеспособности, отметил EE Times. «Это решение претворяет давно существующую концепцию в жизнь», — заявил Мартин Форбах (Martin Vorbach), технический директор Ubitium. «Встроенные системы переросли архитектуры, на которые сегодня опирается отрасль. Консолидация больше не является необязательной. Она неизбежна», — добавил он. Технология, лежащая в основе этого проекта, совершенствовалась более 15 лет. Для её воплощения в жизнь Форбахом совместно с рядом специалистов была создана в 2024 году компания Ubitium. Ускорить разработку позволило привлечение $3,7 млн в рамках посевного раунда в конце прошлого года, который совместно возглавили Runa Capital, Inflection и KBC Focus Fund. Инвестиции позволили Ubitium проверить архитектуру и подготовить наборы для разработки (IDK) для первых клиентов. «Индустрия процессоров объёмом $500 млрд построена на жёстких границах между вычислительными задачами», — сказал Хён Шин Чо (Hyun Shin Cho), генеральный директор Ubitium и соучредитель. — Мы стираем эти границы. Наш универсальный процессор делает всё — CPU, GPU, DSP, FPGA — на одном чипе, в одной архитектуре. Это не просто постепенное улучшение. Это смена парадигмы. Это архитектура процессора, которую требует эпоха ИИ». Как отметил EE Times, завершение tape-out продукта — это не просто большая победа для Ubitium. Это также поворотный момент для экосистемы RISC-V. Открытая архитектура RISC-V используется большей частью для создания обычных ядер, которые полагаются на внешние ускорители для сложных рабочих нагрузок. Ubitium расширяет границы использования архитектуры, сохраняя полную совместимость с RISC-V. Процессор поддерживает стандартные наборы инструментов RISC-V для разработки ПО и может работать под управлением Linux и RTOS. Кроме того, унифицированный программный стек устраняет необходимость в компиляторах для конкретного поставщика или проприетарных языках, что позволяет быстро внедрять инновации и сократить время разработки. Компания сотрудничает с Samsung Foundry и ADTechnology для завершения проектирования и с Siemens Digital Industries Software — для проверки микросхемы (pre-silicon validation). Вторая стадия tape-out запланирована на конец этого года, а серийное производство начнётся в 2027 году, сообщила компания.

09.03.2026 [15:46], Руслан Авдеев

Договаривайтесь заранее: Sandisk пообещала скидки предусмотрительным клиентам с долгосрочными контрактамиПо словам главы Sandisk Дэвида Геклера (David Goeckeler), компания стремится к заключению долгосрочных соглашений о поставке NAND-памяти клиентам, представляющим индустрию дата-центров. Рынок памяти находится на этапе структурных изменений, вызванных спросом со стороны ИИ-проектов. Многолетние контракты обеспечат баланс предсказуемого спроса и привлекательных экономических условий — это позволит отойти от традиционно применявшейся в отрасли поквартальной модели ценообразования. Sandisk подчёркивает, что в новой реальности соглашения превратились из инструментов переговоров о ценах в критически важные механизмы обеспечения поставок, поскольку индустрия ЦОД нуждается в крупных и долгосрочных поставках NAND-памяти. Sandisk рассчитывает, что на ЦОД будет приходиться крупнейшая доля рынка NAND-памяти в календарном 2026 году, рост составит 20–60 % в течение двух циклов прогнозирования. В минувшем квартале производитель сообщал о последовательном увеличении продаж в сегменте дата-центров на 64 %, после роста в 20 % в предыдущем отчётном периоде. Изменения свидетельствуют о фундаментальной трансформации рынка, поскольку гиперскейлерам требуется прогнозируемое предложение для удовлетворения растущих потребностей в оборудовании. Клиенты Sandisk уже передают компании прогнозы спроса до 2028 года включительно, теперь речь идёт об обсуждении соглашений сроком на 1–5 лет. Sandisk стремится добиться привлекательных и стабильных финансовых результатов своей деятельности. Кроме того, компания рассчитывает сформировать портфолио механизмов фиксированного и гибкого ценообразования, чтобы обеспечить оптимальные результаты в разных рыночных условиях. Подчёркивается, что клиенты, готовые к долгосрочным обязательствам, получат приоритетные поставки в условиях дефицита предложения. Те, кто предпочитает договариваться ежеквартально, могут оказаться в менее выгодной ситуации, столкнувшись с нехваткой компонентов. Sandisk намерена и дальше ежегодго наращивать производство памяти на уровне 15–19 %, к концу 2026 года основными станут чипы BiCS8. Слухи о возможном переходе к BiCS10 для удовлетворения спроса опровергаются — для закрытия текущих потребностей рынка достаточно имеющихся производственных мощностей. На SanDisk приходится приблизительно 25 % рынка периферийных вычислений. Сейчас она расширяет портфолио SSD для корпоративных клиентов. Проводятся квалификационные испытания продуктов гиперскейлерами, в т.ч. QLC SSD ёмкостью 128 Тбайт под кодовым названием Stargate, в финансовых отчётах поставки которых ещё не отмечены. Также совместно с южнокорейской SK Hynix разрабатывается память HBF. Ожидается, что прототипы соответствующих кристаллов появятся уже к концу 2026 года, а готовые для тестирования клиентами варианты — годом позже. Работу совместного предприятия Sandisk и Kioxia продлили ещё на пять лет, т.е. Sandisk обеспечила себе производственные мощности до 2034 года. Благодаря этому компания сможет инвестировать в исследования и разработки на уровне, сопоставимом с лидерами рынка, сохраняя лидерство по минимизации издержек.

09.03.2026 [13:15], Сергей Карасёв

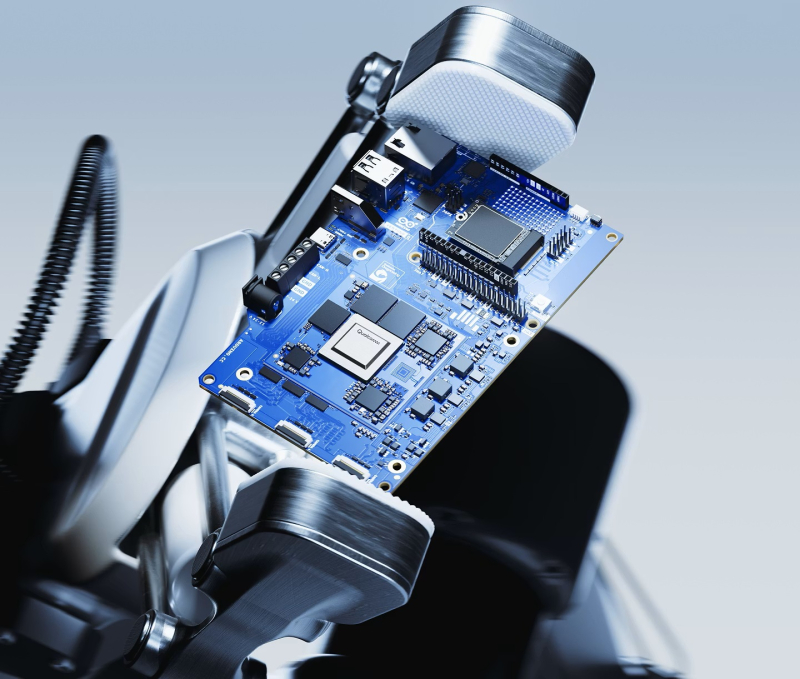

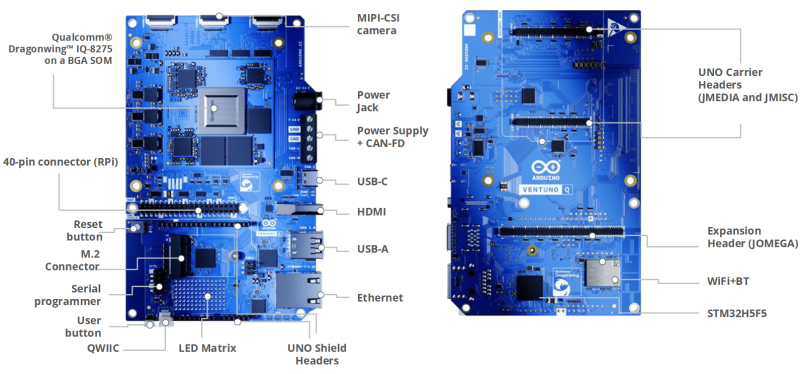

Arduino представила одноплатный компьютер Ventuno Q для ИИ-роботовУчастники проекта Arduino расширили ассортимент одноплатных компьютеров, анонсировав решение Ventuno Q: это старший собрат модели Uno Q, дебютировавшей в октябре прошлого года. Новинка предназначена для построения различных устройств с ИИ-функциями, таких как роботизированные платформы, системы машинного зрения, решения с распознаванием жестов и речи и пр. В основу Ventuno Q положен процессор Qualcomm Dragonwing IQ-8275. Чип содержит восемь вычислительных ядер Kryo с тактовой частотой до 2,35 ГГц, графический ускоритель Adreno 623 с поддержкой OpenGL ES 3.2, блок обработки изображений Spectra 690 и цифровой сигнальный процессор Hexagon. Заявленная ИИ-производительность достигает 40 TOPS. Говорится о возможности использования до 12 камер, двух дисплеев, памяти LPDDR5x-3200, интерфейсов USB 3.1, Ethernet и PCIe. В дополнение к процессору Dragonwing IQ-8275 задействован микроконтроллер реального времени STMicroelectronics STM32H5 на основе ядра Arm Cortex-M33 с частотой до 250 МГц, отвечающий за работу сенсоров, силовых приводов и пр. Основной процессор работает под управлением Ubuntu/Debian, тогда как микроконтроллер STM32H5 использует Arduino Core на базе Zephyr OS. Одноплатный компьютер несёт на борту 16 Гбайт LPDDR5, флеш-накопитель eMMC вместимостью 64 Гбайт, контроллеры Wi-Fi и Bluetooth, а также сетевой адаптер 2.5GbE. Кроме того, предусмотрен коннектор М.2 для дополнительного SSD. Реализованы интерфейсы MIPI-CSI (4 линии), MIPI-DSI, порты USB Type-C, USB Type-А и HDMI, а также 40-контактная колодка, совместимая с Raspberry Pi. Среди прочего упомянуты матрица светодиодов 13 × 8, коннекторы JMISC, JMEDIA и JOMEGA. Могут применяться модули Arduino Modulino, сенсоры Qwiic и платы Raspberry Pi Hat. В продажу Arduino Ventuno Q поступит во II квартале 2026 года. Приобрести одноплатный компьютер можно будет через магазин Arduino Store, а также через площадки реселлеров, включая DigiKey, Farnell, Macfos, Mouser и RS.

09.03.2026 [13:14], Сергей Карасёв

Индустриальный мини-компьютер AAEON Intelli TWL01 Edge поддерживает два 4K-дисплеяКомпания AAEON анонсировала компьютер небольшого форм-фактора Intelli TWL01 Edge, предназначенный для построения систем видеоконференцсвязи, видеостен и других коммерческих или индустриальных платформ. Устройство обеспечивает возможность вывода изображения одновременно на два дисплея формата 4К. Основой служит аппаратная платформа Intel Twin Lake. Максимальная конфигурация включает чип Intel Core 3 Processor N355 (восемь ядер; до 3,9 ГГц; 15 Вт) и 16 Гбайт LPDDR5. Есть встроенный флеш-накопитель eMMC вместимостью 64 Гбайт (опционально — 128 Гбайт), который может быть дополнен SSD (NVMe; PCIe x2) типоразмера M.2 2280. Компьютер оснащён двумя сетевыми портами 1GbE. Предусмотрен разъём M.2 2230 E-Key (PCIe x1, USB 2.0) для комбинированного адаптера Wi-Fi / Bluetooth. В арсенале новинки — четыре порта USB 3.1 Type-A (10 Гбит/с), два интерфейса HDMI 2.0b, два гнезда RJ45 для сетевых кабелей, последовательный порт RS-232/422/485, аудиогнездо на 3,5 мм и 10-контактная колодка GPIO. Устройство заключено в корпус с размерами 152 × 124 × 39 мм, масса составляет около 0,64 кг. Применено пассивное охлаждение; ребристая верхняя поверхность улучшает рассеяние тепла. Диапазон рабочих температур простирается от 0 до +50 °C. Возможен монтаж на DIN-рейку, стену и крепление VESA. Питание (9–36 В) подаётся через DC-коннектор; типовое энергопотребление находится в пределах от 15 до 37 Вт. Заявлена совместимость с Windows 11 LTSC, Ubuntu 24.04 LTS и Yocto 5.1. За безопасность отвечает модуль TPM 2.0.

08.03.2026 [14:50], Сергей Карасёв

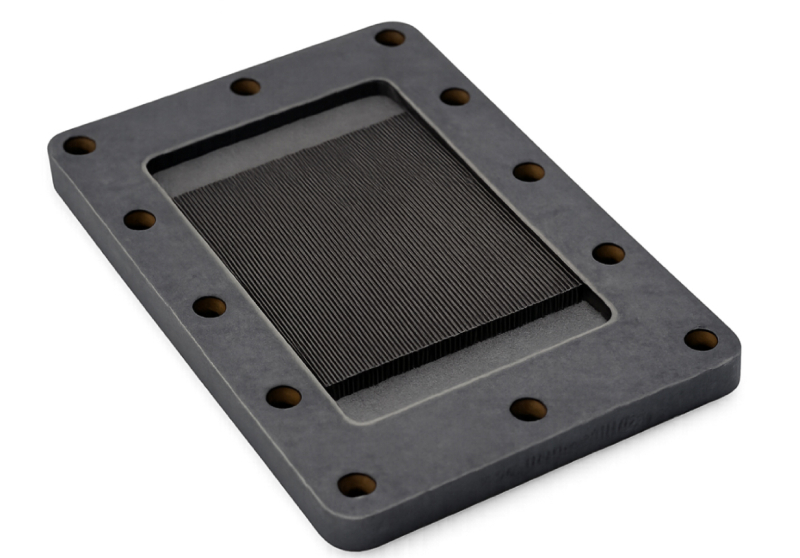

Карборунд-алмазные водоблоки Coherent Thermadite 800 вдвое теплопроводнее и к тому же легче медныхКомпания Coherent анонсировала охлаждающие пластины Thermadite 800 Liquid Cold Plates (LCP) для систем жидкостного охлаждения, рассчитанных на ИИ-ускорители следующего поколения. Новые изделия, как утверждается, способны снизить температуру чипа более чем на 15 °C по сравнению с обычными медными аналогами. Thermadite представляет собой композитный материал на основе реакционно-связанного карбида кремния (RB-SiC), который формируется путём инфильтрации кремния в пористую заготовку из карбида кремния и углерода. А благодаря включению алмаза в матрицу SiC материал Thermadite обеспечивает высокую теплопроводность, низкий коэффициент теплового расширения, жёсткость и стабильность размеров. Такие характеристики позволяют использовать Thermadite для отвода тепла от мощных электронных компонентов, в частности, от GPU в передовых ИИ-ускорителях. По заявлениям Coherent, Thermadite 800 обладает теплопроводностью 800 Вт/м⋅К — примерно вдвое больше, чем у меди. Кроме того, материал имеет приблизительно на 60 % меньшую плотность, чем медь, что позволяет использовать его в системах, к массе которых предъявляются жёсткие требования. При этом устраняются проблемы с деформацией и надёжностью, которые могут возникать в обычных металлических охлаждающих пластинах при работе под высоким давлением. Пластины Thermadite 800 имеют сложную микроканальную архитектуру, оптимизированную под конкретные чипы: это даёт возможность эффективно отводить тепло от наиболее горячих зон при минимизации расхода охлаждающей жидкости. В результате, снижаются общие эксплуатационные расходы.

08.03.2026 [14:20], Сергей Карасёв

ИИ-облако Iren закупит 50 тыс. ускорителей NVIDIA B300Неооблачная компания Iren объявила о заключении соглашения о покупке более 50 тыс. ускорителей NVIDIA B300. Эта сделка позволит Iren расширить общий парк установленных ускорителей примерно до 150 тыс. ед., что к концу 2026 года обеспечит доход от облачных ИИ-вычислений в размере свыше $3,7 млрд. Закупаемые ускорители NVIDIA B300 в течение этого года будут развёрнуты в существующих дата-центрах Iren с воздушным охлаждением в Маккензи (Британская Колумбия, Канада) и Чилдрессе (Техас, США). При этом подчёркивается, что площадки компании в Чилдрессе и Канал-Флэтс (Британская Колумбия) располагают возможностями для дальнейшего наращивания вычислительных мощностей. За последние восемь месяцев Iren привлекла $9,3 млрд в виде предоплат от клиентов, конвертируемых облигаций, лизинга и средств для приобретения оборудования. В частности, были получены $3,6 млрд на закупку ИИ-ускорителей для нужд Microsoft. Iren намерена использовать эти и другие источники средств для финансирования дополнительных капитальных затрат в размере приблизительно $3,5 млрд: деньги пойдут на покупку серверов, хранилищ, сетевых устройств и вспомогательного оборудования, а также на оплату труда. Условия соглашений предусматривают выполнение платежей после отгрузки техники — это повышает эффективность использования оборотного капитала. «Наращивание мощностей до 150 тыс. ускорителей ставит Iren в число крупнейших мировых поставщиков облачной инфраструктуры для ИИ», — говорит Дэниел Робертс (Daniel Roberts), соучредитель и один из генеральных директоров компании. На сегодняшний день Iren управляет несколькими кампусами ЦОД общей мощностью 810 МВт. Ещё 2,1 ГВт находятся в стадии строительства, 1 ГВт — в стадии разработки. Компания, ранее фокусировавшаяся на майнинге криптовалют, переориентирует свои ресурсы на задачи в сфере ИИ.

07.03.2026 [22:57], Владимир Мироненко

Oracle и OpenAI передумали расширять флагманский ИИ ЦОД Stargate в Техасе, чем может воспользоваться Meta✴Oracle и OpenAI отказались от планов расширения флагманского ИИ ЦОД в Абилине (Abilene, Техасе), одного из первый объектов проекта Stargate, сообщил Bloomberg. Строительство этого ЦОД на территории Clean Campus компании Lancium осуществляет разработчик проекта Crusoe Energy. Объект находится в ведении Oracle в интересах OpenAI. В сентябре прошлого года были введены в эксплуатацию два здания ЦОД, а в этом году планируется запуск ещё шести, в результате чего его мощность составит около 1,2 ГВт. Далее Oracle и OpenAI планировали увеличить мощность до 2 ГВт. Переговоры об этом между Oracle, Crusoe и OpenAI велись с середины 2025 года, но планы изменились. По словам источников, переговоры затянулись из-за проблем с финансированием, а также в связи с часто меняющимися прогнозами спроса OpenAI и изменением взглядов на Stargate, что в итоге привело к их срыву. Также на отношения между Oracle и Crusoe повлияли проблемы с надёжностью функционирования объекта. По словам источников, ранее в этом году ЦОД не функционировали в течение нескольких дней из-за зимней непогоды, повлиявшей на работу части оборудования жидкостного охлаждения. Вместе с тем, компании заверили что их партнёрство по-прежнему прочное, и что арендованная Oracle площадка в Абилине быстро развивается. «Crusoe и Oracle работают в тесном сотрудничестве, чтобы создать одну из крупнейших в мире ИИ-фабрик в Абилине, — говорится в заявлении Crusoe. — Наше сотрудничество позволяет создавать масштабную инфраструктуру быстрее, чем кто-либо другой в отрасли». Также в силе осталась договорённость OpenAI с Oracle, согласившейся поставить для неё 4,5 ГВт мощностей ЦОД. Как сообщает Bloomberg, эта сделка по-прежнему находится в процессе, и компании объявили о ряде проектов в других локациях, например, об объекте недалеко от Детройта, принадлежащем Related Digital. Что касается отказа от расширения проекта в Абилине, то после публикации статьи Bloomberg руководитель отдела инфраструктуры OpenAI Сачин Катти (Sachin Katti) сообщил в соцсетях следующее: «Наша флагманская площадка Stargate — один из крупнейших кампусов ИИ ЦОД в Соединённых Штатах. Мы рассматривали возможность дальнейшего расширения, но в конечном итоге решили разместить дополнительные мощности в других местах». «Сегодня у нас в разработке более полудюжины площадок в нескольких штатах, включая площадку, которую мы строим совместно с Oracle в Висконсине, где на этой неделе были установлены первые стальные балки», — добавил он, о чём сообщил Data Center Dynamics. По данным The Information, полноценное электроснабжение на площадке в Абилине будет доступно только через год, к тому времени OpenAI надеется использовать ускорители NVIDIA Vera Rubin вместо ускорителей Blackwell, которые будут установлены в Абилине, поэтому компания предпочла изменить планы. Кроме того, недалеко от первого техасского кампуса Stargate строится и второй — 1,4-ГВт ИИ ЦОД в округе Шакелфорд (Shackelford, Техас) возводится под началом Vantage Data Centers. Как рассказали источники, когда Crusoe начала подыскивать арендаторов для своего ЦОД в Абилине, к процессу подключилась NVIDIA. Чтобы избежать появления на этой площадке продукции конкурирующего разработчика чипов AMD, компания, как сообщается, внесла Crusoe депозит в размере $150 млн для обеспечения аренды площадки. Сообщается, что провал переговоров между Oracle и OpenAI создал возможность для Meta✴ по аренде запланированной для расширения площадки в Абилине, и NVIDIA ведёт с ней переговоры по этому поводу. Сделка между Crusoe и Meta✴ пока не подписана. Добавим, что только в этом году Meta✴ планирует направить на капитальные затраты до $135 млрд. В свою очередь, OpenAI намерена инвестировать в вычислительные мощности около $600 млрд к 2030 году, что гораздо меньше ранее заявленных $1,4 трлн к 2033 году. При этом до $300 млрд из этой суммы планируется выделить Oracle, которая сама испытывает трудности с финансированием строительства своих ЦОД, накапливает долги и планирует уволить тысячи сотрудников для снижения расходов.

07.03.2026 [22:20], Сергей Карасёв

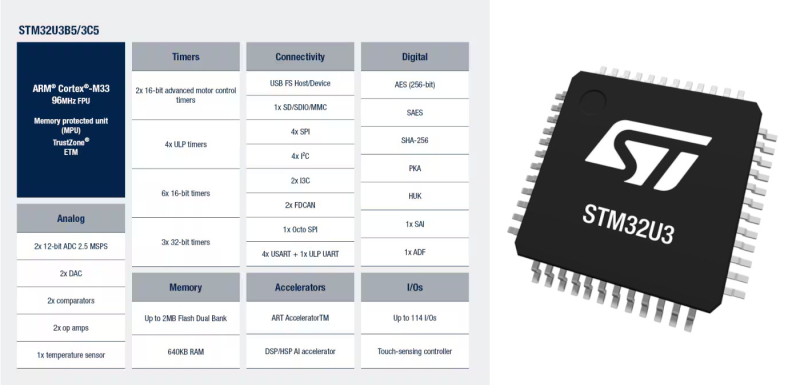

640 Кбайт хватит для ИИ: микроконтроллеры STM32U3B5/C5 со сверхнизким энергопотреблением могут работать даже без батарейSTMicroelectronics анонсировала микроконтроллеры STM32U3B5 и STM32U3C5, ориентированные на автономные устройства с функциями ИИ и машинного обучения. Изделия отличаются сверхнизким энергопотреблением и возможностью перехода в режим глубокого сна при отсутствии данных. Таким образом, допускается работа без батарей — исключительно за счёт преобразования энергии окружающей среды (свет, тепло, вибрации, радиоволны) в электрическую. Микроконтроллеры используют 32-бит ядро Arm Cortex-M33 с частотой 96 МГц. Заявленная производительность достигает 1,5 DMIPS/МГц (Dhrystone 2.1) и 395,4 CoreMark (4,12 CoreMark/МГц). В оснащение входит HSP (Hardware Signal Processor) — специальный блок, предназначенный для ускорения определенных вычислений, связанных с ИИ. Есть 640 Кбайт SRAM и 2 Мбайт флеш-памяти. Предусмотрены интерфейсы SDMMC и OCTOSPI с поддержкой внешней памяти SRAM, PSRAM, NOR, NAND и FRAM. Реализована поддержка 114 × GPIO, USB 2.0, SAI (Serial Audio Interface), 4 × I2C FM+, SMBus/PMBus, 3 × I3C (SDR), 3 × USART и 2 × UART (SPI, ISO 7816, LIN, IrDA, Modem), 1 × LPUART, 4 × SPI, 2 × CAN FD, GPDMA (12 каналов), 2 × 12-bit ADC, 12-bit DAC и др. Возможны различные варианты исполнения, в том числе UFQFPN48 (7 × 7 мм), LQFP48 (7 × 7 мм), LQFP64 (10 × 10 мм), WLCSP72 (3,67 × 3,58 мм), WLCSP99 (3,67 × 3,58 мм), LQFP100 (14 × 14 мм), WLCSP126 (3,67 × 3,58 мм), UFBGA132 (7 × 7 мм) и LQFP144 (20 × 20 мм). Диапазон рабочих температур простирается от -40 до +105 °C. В микроконтроллеры встроены развитые средства безопасности, включая Arm TrustZone, генератор случайных чисел TRNG, защиту от несанкционированного доступа и пр. Единственное различие между решениями STM32U3B5 и STM32U3C5 заключается в том, что второе включает криптографическое ядро для ускорения операций шифрования и дешифрования. Цена варьируется от $2,9298 до $4,6829 за штуку в зависимости от конфигурации при заказах партий от 10 тыс. единиц.

06.03.2026 [17:26], Владимир Мироненко

Акции Marvell подскочили после отчёта о росте продаж чипов для ИИ ЦОДАмериканская компания Marvell Technology, специализирующаяся на производстве процессоров, микроконтроллеров и телекоммуникационных решений, сообщила результаты IV квартала и всего 2026 финансового года, завершившегося 31 января 2026 года. Результаты превысили ожидания аналитиков. Также Marvell прогнозирует доходы в 2028 финансовом году выше оценок Уолл-стрит, что свидетельствует о высоком спросе на специализированные микросхемы и решения для интерконнекта, используемые в ИИ ЦОД, в результате чего ее акции подскочили на 15 % на дополнительных торгах, сообщило агентство Reuters. Выручка Marvell за IV квартал составила $2,22 млрд, что на 22 % больше год к году и $19,0 млн выше среднего значения прогноза компании, представленного 2 декабря 2025 года. Также это превысило консенсус-прогноз аналитиков, опрошенных FactSet, в размере $2,21 млрд (по данным Investors.com). Скорректированная прибыль на разводнённую акцию (non-GAAP) составила $0,80 при среднем прогнозе аналитиков в $0,79. Чистая прибыль (GAAP) составила $396,1 млн, или $0,46 на разводнённую акцию против $1,90 млрд и $2,20 на разводнённую акцию годом ранее. Выручка сегмента решений для ЦОД, на который пришлось 74 % от общего дохода компании, составила $1,65 млрд, увеличившись год к году на 21 %. Сегмент связи и прочих услуг принёс $567,4 млн, что на 26 % больше, чем годом ранее. Выручка за 2026 финансовый год составила $8,195 млрд, что на 42 % больше, чем годом ранее. Чистая прибыль (GAAP) равняется $2,67 млрд или $3,07 на разводнённую акцию, тогда как годом ранее у компании были убытки в размере $885 млн или $1,02 на разводнённую акцию. Скорректированная чистая прибыль (Non-GAAP) за 2026 финансовый год равна $2,47 млрд или $2,84 на разводненную акцию. Компания отметила, что выручка от коммутаторов превысила $300 млн в 2026 финансовом году и ожидается, что она превысит $600 млн в 2027 финансовом году. За прошедший год выручка от кастомных микросхем удвоилась и ожидается сильный рост в 2027 финансовом году. В I квартале 2027 года Marvell прогнозирует скорректированную прибыль в размере $0,79 на разводнённую акцию +/- $0,05 при выручке в $2,40 млрд ±5 %. Аналитики Уолл-стрит ожидают прибыль в размере $0,74 на разводнённую акцию при выручке в $2,28 млрд. За аналогичный период прошлого года Marvell заработала $0,62 на акцию прибыли при выручке в $1,9 млрд. Компания заявила, что квартальный прогноз включает ожидаемые результаты Celestial AI и XConn Technologies, приобретённых в конце прошлого и начале этого года. Marvell ожидает, что существенный вклад в выручку от Celestial AI начнётся во II половине 2028 финансового года, достигнув $500 млн в IV квартале 2028 финансового года и удвоившись до $1 млрд к IV кварталу 2029 финансового года. Также Marvell ожидает, что первоначальный вклад в выручку от XConn начнется в III квартале 2027 финансового года, достигнув $50 млн в годовом исчислении в IV квартале 2027 финансового года. В 2028 финансовом году Marvell ожидает, что XConn принесет $100 млн выручки. «Мы ожидаем, что рост выручки в годовом исчислении будет ускоряться каждый квартал в 2027 финансовом году благодаря устойчивому росту нашего бизнеса в сфере ЦОД, при этом объёмы заказов продолжают расти рекордными темпами. В дополнение к нашим сильным результатам и перспективам, количество заключенных нами контрактов на проектирование в 2026 финансовом году достигло исторического максимума, что, как мы ожидаем, будет и дальше способствовать нашему будущему росту», — заявил Мэтт Мерфи (Matt Murphy), председатель совета директоров и генеральный директор Marvell. Ожидается, что крупные технологические компании, включая Alphabet, Microsoft, Amazon и Meta✴, потратят в этом году не менее $630 млрд на развитие ИИ-инфраструктуры, что повысит спрос на чипы, используемые в серверах и сетевом оборудовании таких компаний, как Marvell. «Мы изучаем планы капитальных затрат крупных компаний на этот год и можем оценить темпы нашего привлечения клиентов, и мы очень уверены в достижении этих показателей», — заявил в интервью Reuters президент и главный операционный директор Крис Купманс (Chris Koopmans). Marvell также ожидает, что выручка вырастет почти на 40 % и приблизится к $15 млрд в 2028 финансовом году, что выше средней оценки аналитиков, по данным LSEG, в $12,92 млрд. Компания также повысила свой прогноз выручки на $2027 финансовый год, ожидая роста более чем на 30 % в годовом исчислении, до $11 млрд, по сравнению с предыдущим прогнозом в $10 млрд. Broadcom, приямой конкурент Marvell, рассчитывает изрядно заработать на кастомных ИИ-ускорителях.

06.03.2026 [17:01], Руслан Авдеев

Инференс-нагрузки Perplexity прописались в облаке CoreWeaveКомпания CoreWeave объявила о заключении долгосрочного соглашения с Perplexity. Стратегическое партнёрство призвано обеспечить выполнение рабочих ИИ-нагрузок последней, также предусмотрено пилотное внедрение в обеих организациях новых сервисов. Утверждается, что CoreWeave позволяет клиентам переходить от разработки непосредственно к внедрению без перепроектирования систем и инструментов. Соглашение предусматривает, что платформа CoreWeave будет использоваться Perplexity для инференса нового поколения. Выделенные кластеры на основе суперускорителей NVIDIA GB200 NVL72 гарантируют соответствие инфраструктуры облачного провайдера изменению задач Perplexity и высоким требованиям экосистемы на основе Sonar и Search API. В своё время Perplexity начинала с выполнения задач инференса с помощью CoreWeave Kubernetes Service и применения платформы W&B Models для (до-)обучения моделей и управления ими на всех этапах, от экспериментального до ввода в эксплуатацию. Дополнительно CoreWeave повсеместно внедрит в своей организации инструменты Perplexity Enterprise Max, что позволит её специалистам искать информацию в интернете и внутренней базе данных, проводить углублённые исследования, анализировать данные и визуализировать их. Партнёрство является свидетельством «мультиоблачной» стратегии Perplexity. Чуть более месяца назад Microsoft заключила крупную облачную сделку с Perplexity, но ключевым провайдером ИИ-поисковика останется AWS.

Источник изображения: CoreWeave/Perplexity Это лишь последняя из удачных сделок CoreWeave, сдающей в аренду мощности даже таким компаниям, как Microsoft, Meta✴ и OpenAI. В 2025 году компания получила средства от NVIDIA, которая арендовала свои же ускорители у CoreWeave. В сентябре 2025 года компания обязалась выкупить у неооблачного оператора все нераспроданные мощности. CoreWeave на волне роста спроса на облачные услуги удвоит в 2026 году капитальные затраты, хотя некоторые инвесторы сомневаются в целесообразности таких мер. |

|