Материалы по тегу: hardware

|

10.03.2026 [17:10], Руслан Авдеев

KKR задумала продать производителя СЖО CoolIT почти в 10 раз дороже, чем покупалаАмериканский инвестиционный гигант KKR рассчитывает хорошо заработать на продаже одной из именитых IT-компаний, работающей на рынке систем охлаждения с 2001 года. Бум ИИ привёл к тому, что оценочная стоимость компании CoolIT Systems выросла в несколько раз, сообщает The Financial Times. По данным знакомых с ситуацией источников, KKR и её консультанты работают над продажей компании за $3 млрд. CoolIT, переориентировавшаяся с выпуска систем охлаждения для игровых ПК на СЖО для дата-центров, в 2023 году, на момент покупки KKR контрольного пакета, стоила всего $270 млн. Миноритарной долей владеет суверенный государственный инвестор Mubadala из ОАЭ. По информации источников, пока обсуждение продажи CoolIT находится на ранней стадии и гарантии того, что сделка вообще состоится, отсутствуют. Тем не менее, несколько компаний уже выбраны в качестве потенциальных «стратегических» покупателей. По данным Datacenter Dynamics, ранее CoolIT привлекла около $10 млн в ходе четырёх раундов финансирования. В числе предыдущих инвесторов: Business Development Bank of Canada, nVent, Kline Hill Partners, Vistara Capital Partners, Inovia Partners, AVAC Group и Chart Venture Partners. Масштабная эволюция инфраструктуры ЦОД и развитие ИИ-технологий стали импульсом к росту сделок, напрямую не связанных с компаниями технологического сектора. В частности, речь идёт об энергетике и промышленных сделках с участием поставщиков для ИИ-инфраструктуры. Как свидетельствуют данные НКО American Edge Project, в США уже строятся или планируются к строительству около 3 тыс. дата-центров, не считая 4 тыс. уже действующих площадок. Это неизбежно увеличивает потенциальный спрос на оборудование и сервисы CoolIT. Тем не менее, инвесторы начинают ставить под сомнение окупаемость многих инвестиций крупных компаний в новые дата-центры. В 2025 году производственная компания Eaton заплатила $9,5 млрд за связанный с теплообменными решениями бизнес Boyd Corporation. Предполагается, что это позволит расширить портфолио решений для ЦОД. Купленный бизнес, вероятно, уже в 2026 году принесёт около $1,7 млрд выручки, причём большая её часть приходится на СЖО-решения. Конкурент Vertiv также купил компанию PurgeRite сходного профиля в том же году, заплатив около $1 млрд. На днях частные инвестиционные компании Global Infrastructure Partners (GIP, принадлежит BlackRock) и EQT заключили сделку на $33 млрд, организовав покупку энергокомпании AES Corporation. В своё распоряжение они получили бизнес, генерирующий возобновляемую энергию в огромных объёмах для дата-центров. В последние годы эксперты называют KKR одним из самых агрессивных частных инвесторов, скупающих ЦОД. В 2021 году совместно с GIP она приобрела американского оператора ЦОД CyrusOne. Сделка обошлась в $15 млрд, включая долг.

10.03.2026 [16:30], Руслан Авдеев

ИИ-неооблако Nscale привлекло ещё $2 млрдЗанимающаяся строительством ИИ-фабрик компания Nscale — ключевой элемент стратегии развития ИИ британских властей — объявила о привлечении $2 млрд в ходе раунда финансирования серии C, сообщает Computer Weekly. В итоге за период чуть более года объём финансирования бизнеса превысит $4,9 млрд, новый раунд довёл оценку капитализации компании приблизительно до $14,6 млрд. Во многом такие оценки основаны на планах строительства Nscale дата-центров общей мощностью более 1,3 ГВт. Также компания сообщила о контрактах на поставку 200 тыс. ИИ-ускорителей NVIDIA GB300 и сделках о предоставлении мощностей компании Microsoft на $23 млрд на многих из планируемых площадок. В 2025 году Nscale объявила о готовности вложить $2,5 млрд в дата-центры Великобритании до 2028 года. Речь идёт как о стационарных объектах, так и о модульных ЦОД. В середине 2024 года Nscale приобрела провайдера модульных ЦОД — Kontena. Такие дата-центры позволяют использовать предварительно изготовленные готовые решения, поставку которых можно организовать за считанные месяцы вместо двух-трёх лет для капитальных построек. Ключевой проект — кампус в Лоутоне (Loughton, Эссекс) мощностью от 50 МВт с возможностью расширения до 90 МВт; он считается крупнейшим ИИ ЦОД в Великобритании и предусматривает использование 23 тыс. NVIDIA GB300. Запуск планируется в IV квартале 2026 года. Площадка сочетает модульную конструкцию для быстрого развёртывания со «стационарными» мощностями, которые будут доступны несколько позднее. Дополнительно Nscale строит ЦОД в Гломфьорде (Glomfjord) в Норвегии, где уже имеются модульные мощности на 30 МВт, а также планируется построить ещё 60 МВт с питанием от ГЭС. В Норвегии также имеется проект Stargate Norway: к начальным 230 МВт планируется добавить инфраструктуру ещё на 290 МВт в рамках проекта, реализуемого совместно с OpenAI и Aker ASA. В Барстоу (Barstow, Техас) на арендованных мощностях для Microsoft будет развёрнуто 104 тыс. ИИ-ускорителей в рамках проекта мощностью 234 МВт. Проект должны ввести в эксплуатацию в III квартале 2027 года; позже его планируется масштабировать до 1,2 ГВт.

Источник изображения: Nscale В Синише (Sines, Португалия) изначально планируется развернуть 12,6 тыс. ускорителей NVIDIA GB300, мощность составит около 20 МВт; для охлаждения оборудования планируется использовать морскую воду. Наконец, в Кеблавике (Keflavík, Исландия) в 2026 году планируется развернуть порядка 4,6 тыс. ускорителей NVIDIA с энергопотреблением около 15 МВт, обеспечиваемым геотермальными источниками и ГЭС. Также Nscale имеет свободные мощности ЦОД в арендованных объектах на двух дополнительных площадках в Норвегии, а также в Северной Каролине и др. Nscale зарегистрирована в Великобритании. Лидерами нового раунда финансирования являются норвежская инвестиционная Aker ASA и американский инвестиционный фонд 8090 Industries. В числе других инвесторов — Dell, Lenovo, Nokia и NVIDIA. Компания позиционирует себя как единственного поставщика комплексной инфраструктуры для современного ИИ, а также упоминается в правительственных пресс-релизах, посвящённых сотрудничеству с OpenAI для создания суверенных вычислительных ИИ-мощностей и участию в проекте строительства ЦОД в Лоутоне. Одновременно с привлечением новых средств объявлено о назначении одного из известнейших британских политиков — бывшего вице-премьера Ника Клегга (Nick Clegg) — членом совета директоров. Параллельно Клегг числится партнёром инвестиционной компании Hiro Capital. Также он занимал должность президента по глобальным вопросам в Meta✴. Дополнительно в совет директоров вошли бывший операционный директор (COO) Meta✴ Шерил Сэндберг (Sheryl Sandberg) и бывший президент Yahoo Сьюзан Декер (Susan Decker).

10.03.2026 [16:25], Руслан Авдеев

CNBC: Oracle строит «вчерашние» дата-центры за счёт будущих долговПоколения ИИ-ускорителей обновляются значительно быстрее, чем строятся новые ЦОД. Эта тенденция представляет угрозу как для рынка ИИ-решений в целом, так и для экспансии Oracle, в значительной степени финансируемой за счёт долговых средств, сообщает CNBC. По последним данным, OpenAI больше не планирует расширять партнёрство с Oracle в Абилине (Abilene, Техас), где расположен флагманский ЦОД проекта Stargate. Причина в том, что ИИ-компания нуждается в кластерах с новейшими поколениями ускорителей NVIDIA, а возможности Oracle поставить их OpenAI — под вопросом. В воскресенье Oracle назвала новости о своей деятельности «ложными и неправильными», но в посте компании говорилось лишь о существующих проектах, а планов масштабирования объявление не касалось. Площадка в Абилине будет использовать ускорители NVIDIA Blackwell, но энергия для них начнёт поступать лишь через год. К тому времени OpenAI рассчитывает получить «расширенный» доступ к чипам NVIDIA нового поколения в более крупных кластерах, в других местах. В своё время Oracle получила землю, заказала оборудование и потратила миллиарды долларов на строительство и персонал в расчёте на будущий рост. Теперь в компании отказываются подробно комментировать эту информацию. Отказ от дальнейшего расширения был бы вполне логичным шагом для OpenAI, которой не нужны устаревшие чипы. Раньше NVIDIA представляла новое поколение ИИ-ускорителей каждые два года, но теперь её глава Дженсен Хуанг (Jensen Huang) объявил, что компания перешла на ежегодный цикл обновления, и каждое новое поколение значительно превосходит предыдущее по производительности. Например, представленные в январе 2026 года ускорители Vera Rubin впятеро производительнее Blackwell при инференсе.

Источник изображения: Amy Hirschi/unsplash.com Для компаний, создающих передовые ИИ-модели, малейшее отставание в производительности оборудования может означать серьёзное отставание в бенчмарках и рейтингах. При этом рейтинги внимательно отслеживаются специалистами и бизнесом и сильно влияют на уровень использования ИИ-продуктов, выручку и капитализацию. Тем временем у инфраструктурных компаний на получение участка, подключение электроэнергии, строительство и ввод в эксплуатацию дата-центра уходит минимум год-два, а клиентам требуется новейшее оборудование, которое теперь обновляется каждый год. Дополнительной проблемой Oracle является то, что это единственный гиперскейлер, строящий новую инфраструктуру преимущественно за счёт заёмных средств: долги достигли $100 млрд и продолжают расти. Напротив, Google, AWS и Microsoft пользуются полноводными потоками денег, получаемых от других направлений своей деятельности, приносящих значительную выручку. Сообщается, что партнёр Oracle — компания Blue Owl — отказалась финансировать дополнительный объект. 10 марта Oracle отчитывается о финансовых результатах третьего квартала финансового года, и инвесторы уделят особое внимание тому, как компания намерена обосновать план капитальных затрат в $50 млрд на фоне отрицательного свободного денежного потока. Они также будут оценивать, сохранится ли у компании доступ к источникам финансирования. В текущем году акции компании уже упали на 23 %, а с пика в сентябре 2025 года потеряли более половины своей стоимости. Впрочем, проблема устаревания ускорителей касается не только Oracle. Это угроза рынку ИИ в целом, которая может иметь последствия для всего «ИИ-ландшафта». Каждая из подписываемых сегодня инфраструктурных сделок может привести к тому, что оборудование устареет ещё до того, как к ЦОД подключат электроэнергию. Вместе с тем далеко не всем игрокам ИИ-рынка действительно нужны самые последние модели ускорителей, поскольку конкретные задачи и связанная с ними экономика могут заметно отличаться у разных компаний.

10.03.2026 [12:58], Сергей Карасёв

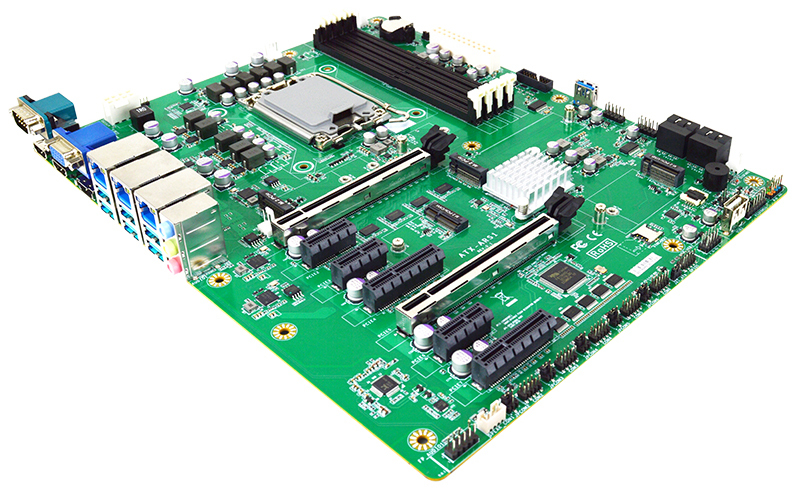

Jetway выпустила индустриальную плату ATX-ARS1-W880 на базе Intel Arrow Lake-SКомпания Jetway анонсировала индустриальную материнскую плату ATX-ARS1-W880, предназначенную для платформ автоматизации, робототехнических комплексов и пр. Новинка рассчитана на эксплуатацию в температурном диапазоне от -20 до +60 °С. Изделие выполнено в форм-факторе АТХ с размерами 305 × 244 мм. Применён набор логики Intel W880: возможна установка процессоров семейства Arrow Lake-S в исполнении LGA1851 с показателем TDP до 125 Вт. Доступны четыре слота CU-DIMM (Clocked Unbuffered DIMM) с поддержкой до 256 Гбайт памяти DDR5-6400. Плата располагает четырьмя портами SATA-3 для накопителей с возможностью формирования массивов RAID 0/1/5/10. Кроме того, имеются коннекторы М.2 M-Key 2242/2260/2280/22110 (PCIe 5.0 x4) и М.2 M-key 2280 (PCIe 4.0 x4) для NVMe SSD. В арсенале новинки — сетевой порт 2.5GbE RJ45 на основе контроллера Intel I226-LM и два порта 2.5GbE RJ45 на базе Intel I226-V. Реализованы слот M.2 E-Key 2230 (USB 2.0/PCIe 3.0 x1; CNVio) для комбинированного адаптера Wi-Fi / Bluetooth и разъём M.2 B-Key 3042/3052 (USB3.1/USB2.0/PCIe 3.0 x1 плюс NanoSIM) для сотового модема 4G/5G.

Источник изображения: Jetway Возможен вывод изображения одновременно на четыре независимых монитора через интерфейс DP1.4a (до 4096 × 2160; 60 Гц), два выхода HDMI 2.1 (до 3840 × 2160; 60 Гц) и аналоговый коннектор D-Sub (1920 × 1080; 60 Гц). Доступны шесть портов USB 3.1 Type-A (10 Гбит/с), последовательный порт RS-232/422/485 и набор аудиогнёзд на 3,5 мм. Через разъёмы на самой плате могут быть задействованы два порта USB 3.0 (5 Гбит/с), шесть портов USB 2.0, а также пять портов RS-232. Плата получила по два слота PCIe 5.0 x16 (1 × PCIe 5.0 ×16 или 2 × PCIe 5.0 x8) и PCIe 4.0 x4, а также три слота PCIe 4.0 x1. Есть два коннектора для вентиляторов охлаждения. Опционально может быть добавлен модуль TPM 2.0 (dTPM) для обеспечения безопасности. Заявлена совместимость с Windows 11 и Linux.

10.03.2026 [12:52], Сергей Карасёв

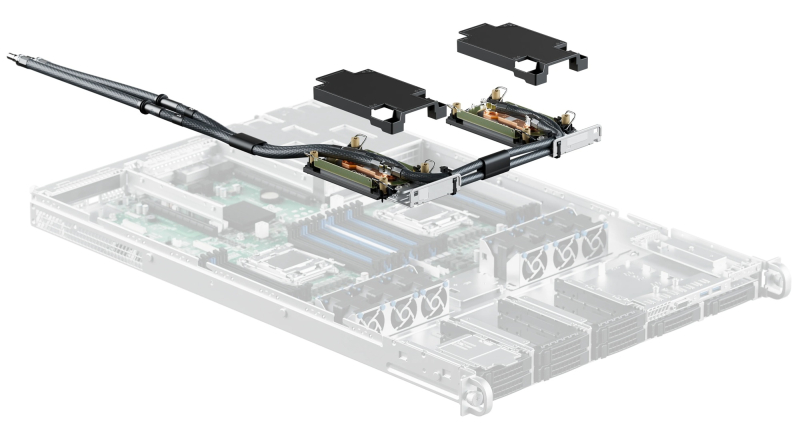

QCT представила сервер QuantaEdge EGN77C-2U на базе NVIDIA Grace для инфраструктур AI-RANКомпания Quanta Cloud Technology (QCT) анонсировала сервер QuantaEdge EGN77C-2U, использующий дизайн NVIDIA Aerial RAN Computer Pro (ARC-Pro) и подход Nokia anyRAN. Новинка, как ожидается, позволит телеком-операторам ускорить переход к программно-определяемым сетям 5G и 6G с поддержкой ИИ (AI-RAN). Устройство имеет архитектуру 2U2N — два узла в корпусе 2U. Задействованы чипы NVIDIA Grace, объединяющие 72 вычислительных ядра Arm Neoverse V2 (Armv9). Объём памяти LPDDR5X составляет 512 Гбайт в расчёте на узел. В оснащение каждого узла входят GPU-ускоритель NVIDIA RTX PRO 4500 Blackwell, сетевые адаптеры NVIDIA ConnectX-8 Ethernet SuperNIC, 16 портов 25GbE и два порта 400GbE. «Отрасль вступает в новую эпоху беспроводной связи, изначально основанную на ИИ. С помощью QuantaEdge EGN77C-2U, платформы NVIDIA AI Aerial и программного обеспечения Nokia anyRAN мы формируем единую среду, которая поддерживает бесшовную интеграцию ИИ и сетей радиодоступа следующего поколения», — говорит Майк Янг (Mike Yang), президент QCT. Подчёркивается, что сети, изначально созданные на основе ИИ, предлагают качественно новые возможности в плане производительности, эффективности и функциональности. Программно-определяемая архитектура RAN на базе ИИ поможет справляться с экспоненциальным ростом объёмов передаваемых данных и появлением новых ресурсоёмких рабочих нагрузок. Алгоритмы ИИ поддерживают интеллектуальное управление, что позволяет оптимизировать работу сетей в зависимости от текущей ситуации. В результате, может быть сформирован задел для будущих систем связи 6G, которые обеспечат высочайшие скорости передачи информации при минимальных задержках.

10.03.2026 [12:50], Сергей Карасёв

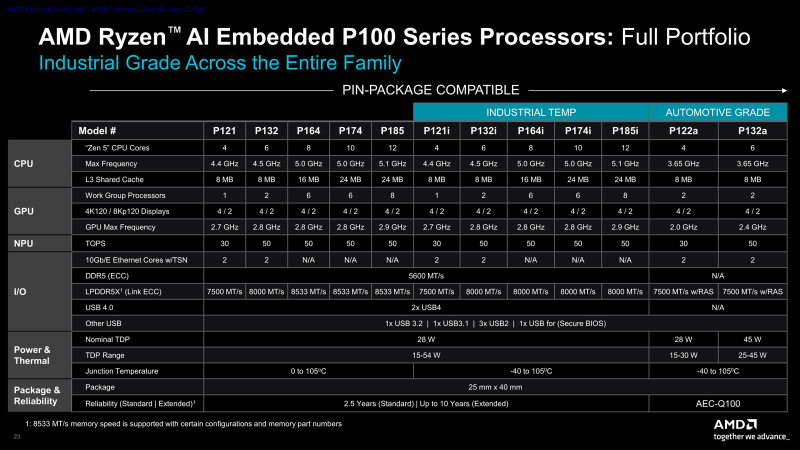

AMD пополнила семейство процессоров Ryzen AI Embedded P100 моделями, насчитывающими до 12 ядерКомпания AMD расширила ассортимент процессоров Ryzen AI Embedded P100, анонсировав модели, насчитывающие до 12 вычислительных ядер. Изделия оптимизированы для применения в промышленном секторе: они подходят для решения широкого спектра ИИ-задач на периферии, включая машинное зрение, автоматизацию, 3D-визуализацию и пр. Чипы Ryzen AI Embedded P100 дебютировали в январе нынешнего года. Изначально были выпущены модели с четырьмя и шестью ядрами. Теперь к ним добавились более производительные решения — процессоры P164/P164i, P174/P174i и P185/P185i с 8, 10 и 12 ядрами соответственно. Используется архитектура Zen 5. Номинальный показатель TDP находится на уровне 28 Вт, величина cTDP варьируется от 15 до 54 Вт. Диапазон рабочих температур простирается от 0 до +105 °C, а у версий с индексом «i» — от -40 до +105 °C. В состав изделий входят графический блок AMD RDNA 3.5 и нейронный узел (NPU) на архитектуре AMD XDNA 2 для ускорения выполнения задач ИИ. Суммарная ИИ-производительность (на уровне процессора) достигает 80 TOPS. Максимальная тактовая частота у новых процессоров составляет 5,0–5,1 ГГц, объём кеша L3 — 16 или 24 Мбайт (см. технические характеристики ниже). Возможно использование оперативной памяти LPDDR5X-8533 или DDR5-5600. Говорится о поддержке 16 линий PCIe 4.0, интерфейсов USB4, USB 3.2, USB 3.1 и USB 2.0. Упомянута совместимость с открытой программной экосистемой AMD ROCm. Процессоры Ryzen AI Embedded P100 рассчитаны на эксплуатацию в круглосуточном режиме. Пробные поставки изделий уже начались, а массовые отгрузки запланированы на июль нынешнего года.

10.03.2026 [09:34], Владимир Мироненко

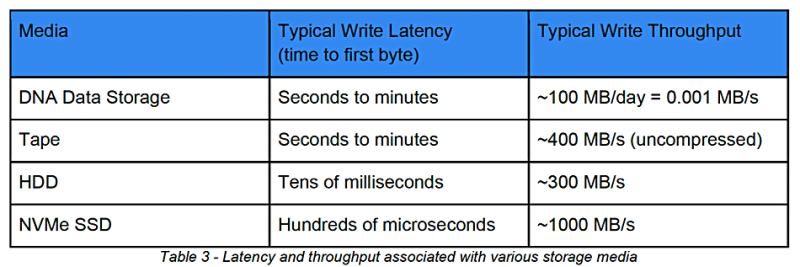

Biomemory вот-вот представит ЦОД-решение для хранения данных на основе ДНКФранцузская компания Biomemory, специализирующаяся на разработке решений в области СХД на основе ДНК для IT-индустрии и кибербезопасности, объявила о приобретении активов у Catalog Technologies, «бостонского пионера в области хранения и обработки данных на основе ДНК». Хранение данных на основе ДНК подходит для архивирования, регулируемых и обучающих наборов данных для ИИ, а также для записей о соответствии требованиям и критически важных резервных копий, пишет Blocks & Files. Обе компании разрабатывают технологии хранения данных на основе ДНК, которые кодируют цифровую информацию в синтетическую ДНК, полученную из бактерий, и редактируют её с помощью ферментов. Обе используют сопоставление цифровых данных с биобезопасными (защищёнными от несанкционированного доступа, кражи или утечки) блоками ДНК вместо попарного синтеза ДНК. Это позволяет повысить скорость чтения и снизить количество ошибок, а также открывает возможности для поиска и вычисления непосредственно в структурах данных ДНК. Catalog первой на рынке создала промышленные машины для записи данных на ДНК — в 2018 году она представила первый прототип устройства Shannon. Также Catalog запатентовала метод поиска данных в СХД на основе ДНК. Biomemory разрабатывает картриджи для хранения данных на основе ДНК, которые совместимы с существующим «железом» и ПО. «Мы работаем над оборудованием, которое можно устанавливать в стойку и которое по форм-фактору подходит для ЦОД», — сообщил ресурсу Techtarget Оливье Ловре (Olivier Lauvray), вице-президент по индустриализации и партнёрским отношениям в Biomemory. Biomemory позиционирует своё решение как ещё один уровень хранения с S3-доступом. В Biomemory сообщили, что технологии компаний «синергетически дополняют друг друга, сочетая ферментативную биозащищённую (защищённую от воздействия опасных биологических факторов) сборку блоков ДНК с масштабируемой высокоскоростной печатью, высокопроизводительным считыванием и низким уровнем ошибок». Сделка также расширяет присутствие в Северной Америке Biomemory, получившей офис в Бостоне и ключевых экспертов из Catalog для исследований и разработки, производства и поддержки. Благодаря сделке Biomemory сможет ускорить внедрение решений корпоративного уровня для безопасного хранения и обработки данных ДНК, и, используя свой запатентованный метод массового производства биобезопасной ДНК и ферментных расходных материалов, обеспечить конкурентоспособные операционные затраты (OpEx). Модульная, дружественная к ИТ-инфраструктуре архитектура и протокол квалификации, аналогичный ISO, позволяют быстро адаптироваться к приобретенной технологии, ПО и оборудованию. Biomemory DNA Card — запатентованный контейнер для надёжного хранения данных в течение 50, 100 или 150 лет с низким показателем неисправимых ошибок (UBER) и уникальным способом обеспечения пожизненной читаемости — в сочетании с решениями Catalog поможет быстро создать новые коммерческие решения для хранения данных или обеспечения кибербезопасности. Согласно пресс-релизу, многослойные решения для 3D-печати от Biomemory в сочетании с крупномасштабной высокопроизводительной печатью от Catalog ускорят уплотнение и миниатюризацию ДНК-хранилищ. Biomemory стремится стать первым поставщиком ДНК-хранилищ данных, развёрнутых в ЦОД. Первые коммерческие решения с использованием приобретённых активов компания планирует запустить во II половине 2026 года. По словам Ловре, потребуется примерно год, чтобы воспользоваться всеми разработками Catalog, и ещё два-три года, чтобы запустить производство принтеров и ДНК-карт для закупки предприятиями. В 2027 году Biomemory планирует построить и эксплуатировать собственные ЦОД для предложения клиентам в качестве услуги. Брент Эллис (Brent Ellis), ведущий аналитик Forrester Research, считает, что Biomemory предстоит преодолеть ещё немало препятствий, прежде чем она сможет выпустить коммерчески жизнеспособный продукт или услугу. Первая из проблем — наличие потенциального рынка для хранения данных ДНК. Эллис утверждает, что рынок слишком мал и большинству корпоративных организаций не нужна такая долговременная сохранность данных. «Более того, по прошествии определённого времени наличие данных становится обузой», — отметил он. Хранение данных в ДНК также имеет практические проблемы, такие как гораздо более низкая скорость чтения/записи по сравнению с конкурирующими методами долговременного архивирования, необходимость в специализированном оборудовании и ещё не достигнутые прорывы в масштабировании. В отчёте SNIA от 2025 года выражались аналогичные сомнения относительно возможности коммерциализации СХД на основе ДНК до конца этого десятилетия. Microsoft прекратила участие в разработке ДНК-хранилищ, отметив, что это «просто не даёт ожидаемого прироста на порядки». «Сторонники хвалили экстремальную плотность, но неясно, насколько это вообще актуально», — передаёт TechRadar. К тому же, есть конкурирующие предложения, например, доступное голографическое хранилище данных компании HoloMem, недавно завершивший первое пробное развёртывание своей системы хранения HoloDrive в существующей ленточной библиотеке. Компания намерена сделать голографическое хранение пригодным для массового производства к 2027 году. Хранение ДНК на порядки менее плотное, чем при использовании голографии, в то время как HoloMem и конкурирующие поставщики уже находятся в терабайтном диапазоне, отметил аналитик.

09.03.2026 [22:22], Руслан Авдеев

Google выделила $50 млн на устранение суперзагрязнителей из окружающей средыКомпания Google присоединилась к инициативе Super Pollutant Action, обязавшись выделить до 2030 года $50 млн на удаление из окружающей среды т.н. «суперзагрязнителей» — веществ, более опасных для атмосферы и климата, чем углекислота, в т.ч. метан и фторсодержащие газы. В инициативе уже участвуют компании Amazon и др., в общей сложности рассчитывающие инвестировать $100 млн, сообщает Datacenter Dynamics. Предполагается, что собранные средства помогут нарастить финансирование проектов, снижающих использование суперзагрязнителей. Организатором инициативы выступила коалиция Beyond Alliance, уделяющая основное внимание решениям, способным благоприятно сказаться на климате уже в ближайшей перспективе. Для этого предлагается масштабировать инвестиции в высокоинтегрированные климатические решения и снижение выбросов парниковых газов помимо CO2. По некоторым данным, на суперзагрязнителях различной природы лежит минимум половина вины за глобальное потепление. По словам Google, суперзагрязнители являются «ключевой» частью уравнения, призванного снизить глобальное потепление. Сокращение их использования — жизненно важная мера наряду с удалением из атмосферы избыточной углекислоты. Коалиция Beyond Alliance будет отвечать за исследования, доклады и информацию о проблеме. Она же составит план действий на ближайщее время. По мнению Beyond Alliance, сейчас решающее десятилетие для климата. Снижение уровня суперзагрязнителей — одна из мер, которая может быстро трансформировать кривую климатических изменений. Сообщается что инициатива демонстрирует, как частный капитал может применяться там, где это нужнее всего — для минимизации глобального потепления, улучшения качества воздуха и незамедлительного достижения измеримых результатов. Google уже поддержала ряд компаний, ищущих способы удаления суперзагрязнителей с помощью различных технологий. Например, в мае 2025 года она помогла Recoolit и Cool Effect в проекте, призванном устранить из атмосферы более 25 тыс. тонн суперзагрязнителей к 2030 году. В сентябре того же года она заключила соглашение с компанией Vaulted Deep об утилизации 50 тыс. тонн соответствующих отходов. Впрочем, дисбаланс в сфере защиты окружающей среды сегодня заметен, как никогда. Не так давно сообщалось, что операторы дата-центров используют всё больше экологически небезопасных газовых турбин, а в конце февраля 2026 года появились данные, что корпоративные закупки «чистой» энергии впервые упали в 2025 году после почти 10 лет роста. При этом практически в то же время сообщается, что Microsoft на 100 % компенсировала свои затраты энергии с помощью возобновляемой энергетики.

09.03.2026 [16:39], Владимир Мироненко

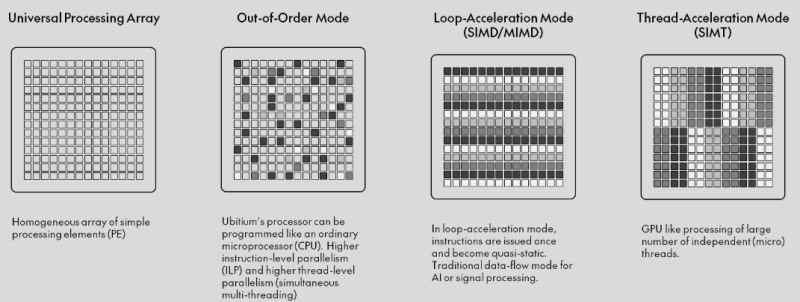

Ubitium стала на шаг ближе к выпуску универсального RISC-V процессора, заменяющего CPU, GPU, DSP и FPGAНемецкий стартап Ubitium объявил о завершении стадии tape-out (финальный этап проектирования) универсального RISC-V-процессора, изготовленного по 8-нм техпроцессу Samsung Foundry и предназначенного для рынка встроенных вычислительных систем автомобилей, промышленного оборудования и бытовой электроники, включая радарные и многосенсорные сигнальные цепи, аудио и голосовую связь в реальном времени, компьютерное зрение, периферийный ИИ, промышленный человеко-машинный интерфейс (HMI) и т.д. В основе процессора Ubitium лежит «универсальный процессорный массив» (Universal Processing Array) — программно-определяемая система с 256 элементами, объединяющая функции CPU, GPU, DSP и FPGA и способная мгновенно менять режимы выполнения во время работы. Такая унификация позволяет чипу переключаться между режимом работы в качестве CPU общего назначения для обслуживания ОС и режимом работы в качестве ИИ-ускорителя, избегая задержек при передаче данных между отдельными чипами.

Источник изображения: Ubitium Завершение tape-out на 8-нм техпроцессе Samsung подтверждает работоспособность основного процессорного массива и интерфейса LPDDR5. Для Ubitium доказательство того, что один процессор может обрабатывать общие вычислительные задачи, задачи обработки в реальном времени и задачи ИИ на одном кристалле, является важным шагом на пути к коммерческой жизнеспособности, отметил EE Times. «Это решение претворяет давно существующую концепцию в жизнь», — заявил Мартин Форбах (Martin Vorbach), технический директор Ubitium. «Встроенные системы переросли архитектуры, на которые сегодня опирается отрасль. Консолидация больше не является необязательной. Она неизбежна», — добавил он. Технология, лежащая в основе этого проекта, совершенствовалась более 15 лет. Для её воплощения в жизнь Форбахом совместно с рядом специалистов была создана в 2024 году компания Ubitium. Ускорить разработку позволило привлечение $3,7 млн в рамках посевного раунда в конце прошлого года, который совместно возглавили Runa Capital, Inflection и KBC Focus Fund. Инвестиции позволили Ubitium проверить архитектуру и подготовить наборы для разработки (IDK) для первых клиентов. «Индустрия процессоров объёмом $500 млрд построена на жёстких границах между вычислительными задачами», — сказал Хён Шин Чо (Hyun Shin Cho), генеральный директор Ubitium и соучредитель. — Мы стираем эти границы. Наш универсальный процессор делает всё — CPU, GPU, DSP, FPGA — на одном чипе, в одной архитектуре. Это не просто постепенное улучшение. Это смена парадигмы. Это архитектура процессора, которую требует эпоха ИИ». Как отметил EE Times, завершение tape-out продукта — это не просто большая победа для Ubitium. Это также поворотный момент для экосистемы RISC-V. Открытая архитектура RISC-V используется большей частью для создания обычных ядер, которые полагаются на внешние ускорители для сложных рабочих нагрузок. Ubitium расширяет границы использования архитектуры, сохраняя полную совместимость с RISC-V. Процессор поддерживает стандартные наборы инструментов RISC-V для разработки ПО и может работать под управлением Linux и RTOS. Кроме того, унифицированный программный стек устраняет необходимость в компиляторах для конкретного поставщика или проприетарных языках, что позволяет быстро внедрять инновации и сократить время разработки. Компания сотрудничает с Samsung Foundry и ADTechnology для завершения проектирования и с Siemens Digital Industries Software — для проверки микросхемы (pre-silicon validation). Вторая стадия tape-out запланирована на конец этого года, а серийное производство начнётся в 2027 году, сообщила компания.

09.03.2026 [15:46], Руслан Авдеев

Договаривайтесь заранее: Sandisk пообещала скидки предусмотрительным клиентам с долгосрочными контрактамиПо словам главы Sandisk Дэвида Геклера (David Goeckeler), компания стремится к заключению долгосрочных соглашений о поставке NAND-памяти клиентам, представляющим индустрию дата-центров. Рынок памяти находится на этапе структурных изменений, вызванных спросом со стороны ИИ-проектов. Многолетние контракты обеспечат баланс предсказуемого спроса и привлекательных экономических условий — это позволит отойти от традиционно применявшейся в отрасли поквартальной модели ценообразования. Sandisk подчёркивает, что в новой реальности соглашения превратились из инструментов переговоров о ценах в критически важные механизмы обеспечения поставок, поскольку индустрия ЦОД нуждается в крупных и долгосрочных поставках NAND-памяти. Sandisk рассчитывает, что на ЦОД будет приходиться крупнейшая доля рынка NAND-памяти в календарном 2026 году, рост составит 20–60 % в течение двух циклов прогнозирования. В минувшем квартале производитель сообщал о последовательном увеличении продаж в сегменте дата-центров на 64 %, после роста в 20 % в предыдущем отчётном периоде. Изменения свидетельствуют о фундаментальной трансформации рынка, поскольку гиперскейлерам требуется прогнозируемое предложение для удовлетворения растущих потребностей в оборудовании. Клиенты Sandisk уже передают компании прогнозы спроса до 2028 года включительно, теперь речь идёт об обсуждении соглашений сроком на 1–5 лет. Sandisk стремится добиться привлекательных и стабильных финансовых результатов своей деятельности. Кроме того, компания рассчитывает сформировать портфолио механизмов фиксированного и гибкого ценообразования, чтобы обеспечить оптимальные результаты в разных рыночных условиях. Подчёркивается, что клиенты, готовые к долгосрочным обязательствам, получат приоритетные поставки в условиях дефицита предложения. Те, кто предпочитает договариваться ежеквартально, могут оказаться в менее выгодной ситуации, столкнувшись с нехваткой компонентов. Sandisk намерена и дальше ежегодго наращивать производство памяти на уровне 15–19 %, к концу 2026 года основными станут чипы BiCS8. Слухи о возможном переходе к BiCS10 для удовлетворения спроса опровергаются — для закрытия текущих потребностей рынка достаточно имеющихся производственных мощностей. На SanDisk приходится приблизительно 25 % рынка периферийных вычислений. Сейчас она расширяет портфолио SSD для корпоративных клиентов. Проводятся квалификационные испытания продуктов гиперскейлерами, в т.ч. QLC SSD ёмкостью 128 Тбайт под кодовым названием Stargate, в финансовых отчётах поставки которых ещё не отмечены. Также совместно с южнокорейской SK Hynix разрабатывается память HBF. Ожидается, что прототипы соответствующих кристаллов появятся уже к концу 2026 года, а готовые для тестирования клиентами варианты — годом позже. Работу совместного предприятия Sandisk и Kioxia продлили ещё на пять лет, т.е. Sandisk обеспечила себе производственные мощности до 2034 года. Благодаря этому компания сможет инвестировать в исследования и разработки на уровне, сопоставимом с лидерами рынка, сохраняя лидерство по минимизации издержек. |

|