Материалы по тегу: amd

|

02.02.2026 [11:02], Сергей Карасёв

Giga Computing выпустила вычислительные узлы TO25-ZU4 и TO25-ZU5 на базе AMD EPYC TurinКомпания Giga Computing, подразделение Gigabyte, анонсировала серверные узлы TO25-ZU4 и TO25-ZU5 стандарта OCP ORV3, ориентированные на гиперскейлеров и облачных провайдеров. Решения формата 2OU (двухузловая конфигурация) выполнены на аппаратной платформе AMD. Устройства получили системную плату MZU3-MG0. Допускается установка одного процессора EPYC 9005 Turin или EPYC 9004 Genoa с показателем TDP до 500 Вт (до 192 вычислительных ядер). Доступны 12 слотов для модулей оперативной памяти DDR5-6400/4800. В оснащение входят контроллер ASPEED AST2600, двухпортовый сетевой адаптер 10GbE (Intel X710-AT2) и выделенный сетевой порт управления 1GbE. Модель TO25-ZU4 поддерживает два накопителя типоразмера E1.S (PCIe 5.0; NVMe) толщиной 9,5 мм и четыре SFF-накопителя (NVMe/SATA/SAS-4). Кроме того, есть по два слота для карт FHFL (PCIe 5.0 x16) и OCP NIC 3.0 (PCIe 5.0 x16). В свою очередь, модификация TO25-ZU5 оборудована посадочными местами для двух накопителей E1.S (PCIe 5.0; NVMe) и восьми изделий SFF (NVMe/SATA/SAS-4). При этом доступны два разъёма PCIe 5.0 x16 для низкопрофильных карт расширения.

Источник изображений: Giga Computing Во фронтальной части обоих узлов расположены интерфейсы USB 3.0 Type-C, Micro-USB и Mini-DP, а также три гнезда RJ45 для сетевых кабелей. Диапазон рабочих температур простирается от +10 до +30 °C. За безопасность отвечает опциональный модуль TPM 2.0. При необходимости может быть также добавлен RAID-адаптер. Габариты решений составляют 258 × 86 × 771 мм.

27.01.2026 [17:10], Владимир Мироненко

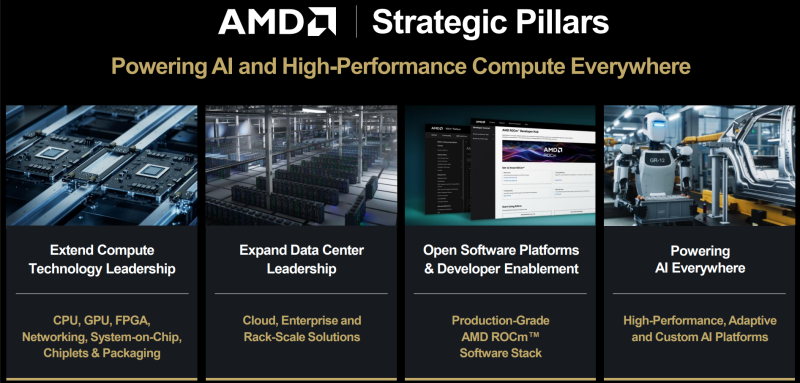

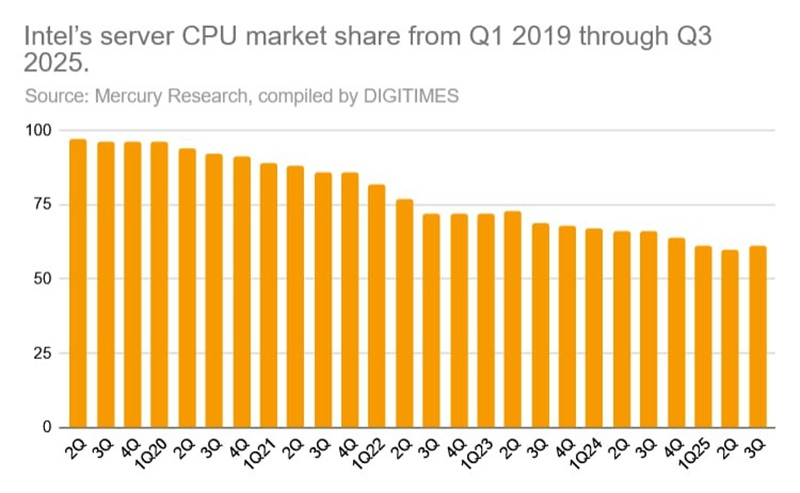

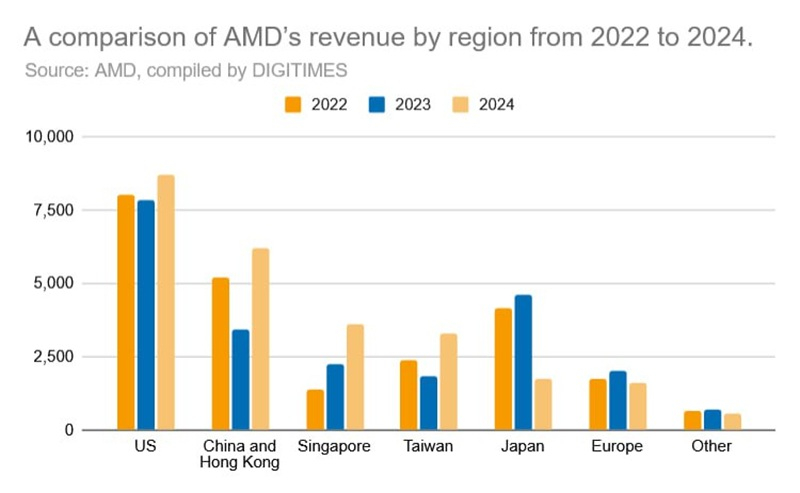

Дисциплина и чиплеты: Лиза Су раскрыла секрет успеха AMD на рынке серверных процессоровС момента внедрения архитектуры Zen в 2017 году компания AMD совершила впечатляющий рывок на рынке CPU, бросив вызов своему давнему конкуренту Intel, сообщила генеральный директор AMD Лиза Су (Lisa Su) в интервью в подкасте A Bit Personal, передаёт DigiTimes. Су подчеркнула трансформацию компании, отметив, что бизнес AMD в сфере решений для ЦОД, находившийся «на грани краха», теперь оказывает конкуренцию Intel на рынке серверных процессоров. Доля рынка AMD EPYC неуклонно растёт, увеличившись с 1 % до примерно 40 % на текущий момент. Слова Су подтверждаются данными Mercury Research, согласно которым за последние семь лет доля Intel на рынках процессоров для клиентских и серверных компьютеров снизилась, достигнув исторически низких показателей, в то время как рыночная доля AMD стабильно росла каждый квартал. Это значительно затруднило Intel поддержание общего доминирования, даже несмотря на сохранение лидерства в абсолютном выражении. По состоянию на III квартал 2025 года, по поставкам серверных процессоров Intel занимала 72 % рынка, но по выручке — всего 61 %, что значительно меньше по сравнению с долей рынка в 97 % в 2019 году. Когда Лиза Су возглавила AMD в 2014 году, отраслевые наблюдатели сомневались в том, что бывшему руководителю подразделения полупроводников IBM удастся вывести компанию из кризиса в условиях острой конкуренции. Однако Су рассматривала эту должность как личную и профессиональную веху — возможность для полной самореализации в полупроводниковой индустрии. Под руководством Су компания AMD совершила практически безупречный разворот, стратегически позиционируя себя для эры генеративного ИИ, отметил ресурс DigiTimes.

Источник изображения: DigiTimes В то время как NVIDIA остаётся главным игроком в сфере ИИ, AMD извлекла выгоду из экспоненциального роста на мировом ИИ-рынке, подкреплённого тесным сотрудничеством с TSMC. Сама Су была избрана в конце 2025 года председателем совета директоров Ассоциации полупроводниковой промышленности (SIA), что отражает признание её авторитета и растущее влияние в отрасли. Су объяснила успех AMD тремя ключевыми стратегическими решениями, поддержанными техническим директором Марком Пейпермастером (Mark Papermaster), который присоединился к компании тремя месяцами ранее. Первое касалось демонтажа существующей линейки продуктов для ЦОД. По словам Су, одним из самых сложных моментов в начале её работы было признать то, что планы AMD по развитию серверного сегмента больше не конкурентоспособны. Продолжение движения по этому пути только ускорило бы потерю компанией доли рынка. В конечном итоге было решено начать всё с «чистого листа». Вторым поворотным моментом стал смелый технологический сдвиг, отметила Су. Её команда отказалась от традиционного подхода к созданию всё более крупных монолитных процессоров в пользу чиплетной архитектуры в сочетании с передовой упаковкой. Это новаторское на тот момент решение несло значительный риск, когда парадигма проектирования Intel доминировала на рынке. Оглядываясь назад, можно сказать, что эта ставка AMD оправдалась. Intel в конечном итоге последовала её примеру, внедрив чиплетную архитектуру и передав часть производства на аутсорсинг TSMC, что позволило ей решить проблемы с выходом годных изделий.

Источник изображения: DigiTimes Третье стратегически важное решение касалось выбора партнёра по производству микросхем. Вместо GlobalFoundries, которая в конечном итоге отказалась от планов по использованию техпроцессов тоньше 7 нм, AMD обратилась к TSMC, хотя у неё в 2017–2019 гг. был ограниченный опыт работы с высокопроизводительными x86-процессорами, несмотря на лидерство в передовых технологических процессах. Тем не менее, использование передовых техпроцессов TSMC сыграло решающую роль, и AMD стала одним из ведущих клиентов компании. По мере роста спроса на чипы для ИИ-технологий ожидается дальнейшее увеличение объёмов производства AMD. Как отметила Су, эти решения демонстрируют сочетание стратегического видения, технической смелости и дисциплины в реализации выбранного пути, которые позволили AMD выйти из почти полной безвестности и стать одним из ключевых игроков на мировом рынке полупроводников и ИИ.

24.01.2026 [14:15], Сергей Карасёв

Nokia и Hypertec построили в Канаде 15-Пфлопс суперкомпьютер Nibi с погружным охлаждением

amd

emerald rapids

granite rapids

h100

hardware

hpc

intel

mi300

nokia

nvidia

ии

канада

отопление

погружное охлаждение

суперкомпьютер

Компании Nokia и Hypertec объявили о запуске суперкомпьютера Nibi, смонтированного в Университете Ватерлоо (University of Waterloo) в Канаде. Эта НРС-платформа будет использоваться для решения широкого спектра задач, в том числе в области ИИ. Проект Nibi финансируется канадским Министерством инноваций, науки и экономического развития через Канадский альянс цифровых исследований, а также Министерством колледжей, университетов, научных исследований и безопасности через некоммерческую организацию Compute Ontario. Система насчитывает в общей сложности более 750 вычислительных узлов. Это, в частности, 700 узлов CPU, каждый из которых несёт на борту два процессора Intel Xeon 6972P поколения Granite Rapids-AP (96C/192T, до 3,9 ГГц) и 748 Гбайт оперативной памяти. Кроме того, задействованы 10 узлов с двумя чипами Xeon 6972P и 6 Тбайт памяти каждый. В состав суперкомпьютера также входят 36 узлов GPU, которые содержат по два процессора Intel Xeon Platinum 8570 серии Emerald Rapids (56C/112T, до 4 ГГц), 2 Тбайт оперативной памяти и восемь ускорителей NVIDIA H100 SXM (80 GB), связанных посредством NVLink. Наконец, Nibi оперирует шестью узлами с четырьмя ускорителями AMD Instinct MI300A. Подсистема хранения VAST Data выполнена на основе SSD суммарной вместимостью 25 Пбайт. Пропускная способность каналов передачи данных между CPU- и GPU-узлами составляет 200 Гбит/с. Подключение к хранилищу обеспечивается благодаря 24 линиям на 100 Гбит/с. Заявленная пиковая производительность Nibi достигает 15 Пфлопс. Новая НРС-платформа оборудована высокоэффективной системой погружного жидкостного охлаждения. Сгенерированное тепло используется для обогрева центра квантовых и нанотехнологий имени Майка и Офелии Лазаридис (Mike and Ophelia Lazaridis Quantum-Nano Centre).

21.01.2026 [14:39], Сергей Карасёв

AMD Ryzen AI 9 HX 370 и 128 Гбайт RAM: вышли индустриальные компьютеры SolidRun Bedrock RAI300 с пассивным охлаждениемКомпания SolidRun анонсировала индустриальные компьютеры семейства Bedrock RAI300, предназначенные для решения ИИ-задач на периферии. Утверждается, что это первые устройства данного класса, в основу которых положен мобильный процессор AMD Ryzen AI 9 HX 370. Названный чип объединяет 12 ядер (24 потока): четыре ядра на архитектуре Zen 5 с частотой 2,0/5,1 ГГц и восемь ядер на архитектуре Zen 5c с частотой 2,0/3,3 ГГц. В состав изделия входят GPU Radeon 890M (RDNA 3.5) и NPU Ryzen AI (XDNA 2) с ИИ-производительностью до 50 TOPS. Суммарное ИИ-быстродействие (CPU+GPU+NPU) достигает 80 TOPS. Объём оперативной памяти DDR5-5600 составляет до 128 Гбайт в виде двух модулей SO-DIMM. Доступны три слота M.2 Key-M 2280 (PCIe 4.0 x4) для SSD (NVMe) или дополнительных ИИ-ускорителей Hailo-8/Hailo-10. Кроме того, предусмотрен коннектор M.2 Key-B 3042/3052 (USB 3.0) для сотового модема 4G/5G (плюс два разъёма для SIM-карт). В оснащение входят четыре сетевых порта 2.5GbE (RJ45) на основе контроллера Intel I226. В зависимости от конфигурации поддерживается вывод изображения одновременно на четыре монитора через интерфейсы HDMI 2.1, DisplayPort 2.1 и mini-DP (×2). Присутствуют три порта USB 3.0, по одному порту USB 4 Type-C и USB 3.1 Type-A. Говорится о совместимости с Windows 10/11/IoT и Linux. Компьютеры серии SolidRun Bedrock RAI300 доступны в тонкой версии Tile с габаритами 160 × 130 × 29 мм (0,6 л) и в более крупной модификации с размерами 160 × 130 × 73 мм (1,5 л), которая наделена внешними радиаторами для рассеяния тепла. В обоих случаях применяется пассивное охлаждение. Диапазон рабочих температур простирается от -40 до +85 °C. Питание подаётся через коннектор Phoenix. Возможен монтаж на DIN-рейку.

20.01.2026 [16:06], Руслан Авдеев

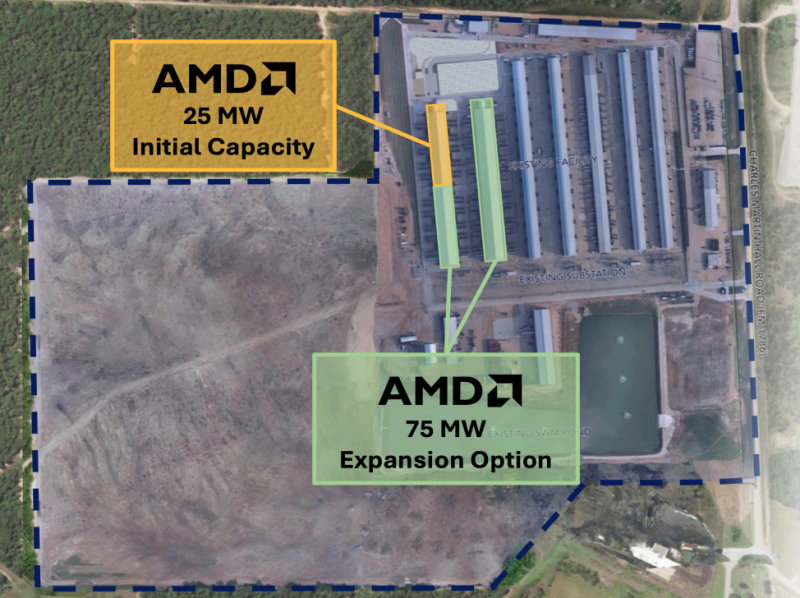

Криптомайнер Riot Platforms сменит профиль и сдаст AMD 25 МВт мощностей ЦОДЗанимающаяся криптомайнингом компания Riot Platforms (ранее Riot Blockchain) — последний в ряду «добытчиков» биткоинов, меняющий профиль на HPC/ИИ ЦОД. Компания приобрела более 80 га в техасском кампусе в Рокдейле (Rockdale) и будет сдавать в аренду мощности новой площадки AMD, сообщает Datacenter Dynamics. На днях компания анонсировала выкуп в полную собственность земли в Рокдейле, где у неё уже имеются мощности. Землю приобрели за $96 млн, полученных путём продажи около 1080 биткоинов с баланса Riot. Соглашение с AMD подразумевает поэтапное размещение IT-нагрузок. Первые 5 МВт должны стать доступны уже в январе, а к маю планируется предоставить AMD уже 25 МВт. AMD имеет возможность получения ещё 75 МВт и право преимущественного выкупа ещё 100 МВт IT-мощностей. Если обе опции реализуют, общая арендованная мощность AMD вырастет до 200 МВт — полная мощность двух объектов кампуса. На первом этапе будет использоваться существующая инфраструктура Riot, компания начала модернизировать одно из имеющихся зданий, капитальные издержки на первоначальное внедрение должны составить $89,8 млн. Договор аренды на 10 лет должен принести Riot до $311 млн. Контракт включает три опции продления на пять лет каждая, это может увеличить совокупный доход от сделки до $1 млрд.

Источник изображения: Riot Platforms Партнёрство с AMD, по словам компании, является признанием соответствие инфраструктуры Riot требованиям арендаторов флагманского уровня, строительных возможностей компании, привлекательности её площадок, доступности мощностей и возможности предлагать инновационные решения. Кампус в Рокдейле ранее полагался на долгосрочную аренду земли. Теперь же он полностью принадлежит и управляется Riot. Компания намерена превратить все доступные кампусу 700 МВт в «актив» для арендаторов ЦОД. В 2020–2023 гг. Riot возвела на территории кампуса семь объектов: два (200 МВт) с иммерсионным охлаждением, а остальные пять (500 МВт) — с воздушным. Riot Platforms — один из крупнейших майнинговых бизнесов в мире, занимающихся биткоинами. Впрочем, руководство ещё с 2024 года обсуждает переход бизнеса на ИИ и HPC ЦОД. Riot владеет более 445 га и 1,7 ГВт зарезервированных мощностей на двух объектах в Техасе. Помимо кампуса в Рокдейле у неё есть площадка в Корсикане (Corsicana), где продолжается строительство двух зданий на 56 МВт. Всего на площадке можно будет разместить до 11 зданий общей мощностью 672 МВт, с потенциалом расширения до 1 ГВт. Также компания владеет двумя площадками в Кентукки общей мощностью 60 МВт (возможно расширение до 300 МВт), которые достались ей после покупки Block Mining в июле 2024 года. В последние годы компании, занимавшиеся «добычей» криптовалют, включая CoreWeave, Core Scientific, Applied Digital, Mara, Iren, Cipher Mining, TeraWulf, Soluna, CleanSpark, Galaxy Digital, Hut 8, Bitfarms, Northern Data и др. переходят к хостингу облачных и ИИ-компаний на своих мощностях. Ранее аналитики предупреждали, что у майнеров осталось совсем немного времени, чтобы переключиться на ИИ.

20.01.2026 [10:02], Владимир Мироненко

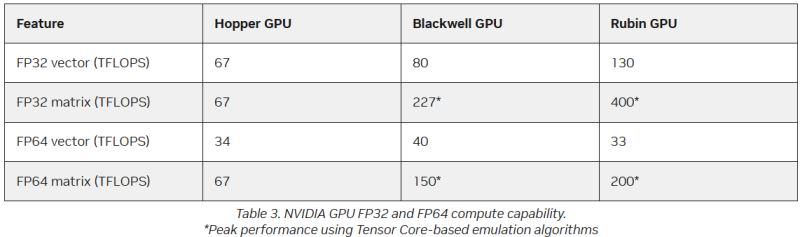

FP64 у вас ненастоящий: AMD сомневается в эффективности эмуляции научных расчётов на тензорных ядрах NVIDIAВместо создания специализированных чипов для аппаратных FP64-вычислений NVIDIA использует эмуляцию для повышения производительности HPC на ИИ-ускорителях, пишет The Register. Компания отказалась от развития FP64-блоков в поколении Blackwell Ultra, а в новейших ускорителях Rubin пиковая заявленная производительность векторных FP64-вычислений составляет 33 Тфлопс, тогда как у H100, вышедшего четыре года назад, она была равна 34 Тфлопс, а у Blackwell — около 40 Тфлопс. Если включить программную эмуляцию в библиотеках CUDA от NVIDIA, ускоритель, как утверждается, может достичь производительности до 200 Тфлопс в матричных FP64-вычислениях. Впрочем, и Blackwell с эмуляций способен выдать в этом случае до 150 Тфлопс, тогда как у Hopper были «честные» 67 Тфлопс. «В ходе многочисленных исследований с партнёрами и собственных внутренних изысканий мы обнаружили, что точность, достигаемая с помощью эмуляции, как минимум не уступает точности, получаемой от аппаратных тензорных ядер», — сообщил ресурсу The Register Дэн Эрнст (Dan Ernst), старший директор по суперкомпьютерным продуктам NVIDIA. В свою очередь, в AMD считают, что это утверждение справедливо не для всех сценариев. «В некоторых бенчмарках она показывает довольно хорошие результаты, но в реальных физических научных симуляциях это не очевидно», — говорит Николас Малайя (Nicholas Malaya), научный сотрудник AMD. Он выразил мнение, что, хотя эмуляция FP64, безусловно, заслуживает дальнейших исследований и экспериментов, такое решение ещё не готово к широкому применению. AMD и сама изучает возможность программной эмуляции FP64 на Instinct MI355X, чтобы определить области её возможного применения. Хотя чипы всё чаще используют типы данных с более низкой точностью, FP64 остаётся золотым стандартом для научных вычислений, и на то есть веские причины — FP64 не имеет себе равных по динамическому диапазону. Современные же LLM обучаются с использованием FP8-вычислений, а компактные типы данных MXFP8/MXFP4 или NVFP4 позволяют получить достаточный для ИИ диапазон значений. Это хорошее решение для нечёткой математики больших языковых моделей, но это не замена FP64 для HPC. ИИ-нагрузки обладают высокой устойчивостью к ошибкам, а HPC-задачи требуют высокой точности. AMD указала на то, что эмуляция FP64 у NVIDIA не совсем соответствует стандарту IEEE. Алгоритмы NVIDIA не учитывают такие понятия, как положительные и отрицательные нули, ошибки NaN (Not a Number) и ошибки infinite number (бесконечное число). Из-за этого небольшие ошибки в промежуточных вычислениях, используемых для эмуляции более высокой точности, могут привести к искажениям, способным повлиять на точность конечного результата, пояснил Малайя. По его словам, целесообразность использования эмуляции FP64 зависит от конкретного приложения. Эмуляция FP64 лучше всего работает для хорошо обусловленных проблем, где малые изменения «на входе» приводят к малым же изменениям в конечном результате. Ярким примером такой задачи является бенчмарк Linpack (HPL). «Но если вы посмотрите на материаловедение, коды для расчёта процессов горения, системы ленточых матриц и т.п., то увидите, что это гораздо менее обусловленные системы, и внезапно всё начинает давать сбои», — сказал он. Точность можно повысить, увеличив количество используемых операций, однако после определённого предела никаких преимуществ от эмуляции уже не будет. Вдобавок все эти операции требуют память. «У нас есть данные, которые показывают, что алгоритму Озаки требуется примерно вдвое больше памяти для эмуляции матриц FP64», — сказал Малайя. Поэтому компания готовит специализированные ускорители MI430X c повышенной FP64/FP32-производительностью, но, как опасаются учёные, она может оказаться не слишком в них заинтересована, поскольку ИИ-ускорители приносят больше денег. Эрнст утверждает, что для большинства специалистов в области HPC неполное соответствие стандарту IEEE не представляет большой проблемы. Всё во многом зависит от конкретного приложения. Тем не менее, NVIDIA разработала дополнительные алгоритмы для обнаружения и смягчения указанных выше ошибок и неэффективных операций эмуляции. Эрнст также признал, что использование памяти при эмуляции может быть несколько выше, но подчеркнул, что эти накладные расходы относятся к расчётам, а не к самому приложению — в большинстве случаев речь идёт о матрицах размером не более нескольких Гбайт. Впрочем, всё это не меняет того, что эмуляция полезна только для подмножества HPC-задач, которые полагаются на операции умножения плотных матриц (DGEMM). По словам Малайи, для 60–70 % рабочих нагрузок HPC эмуляция дает незначительные преимущества или ничего не меняет. «По нашим оценкам, подавляющее большинство реальных рабочих нагрузок HPC полагаются на векторное умножение (FMA), а не на DGEMM», — сказал он, отметив, что это действительно нишевый сегмент, хотя и не крошечная доля рынка. Для рабочих нагрузок, интенсивно использующих векторы, таких как вычислительная гидродинамика (CFD), ускорители Rubin по-прежнему будут полагаться на медленные векторные FP64-блоки.

13.01.2026 [09:03], Руслан Авдеев

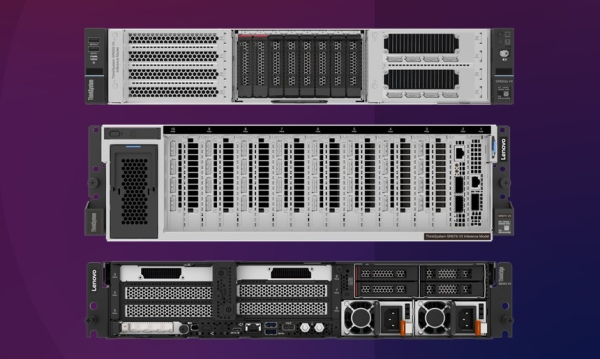

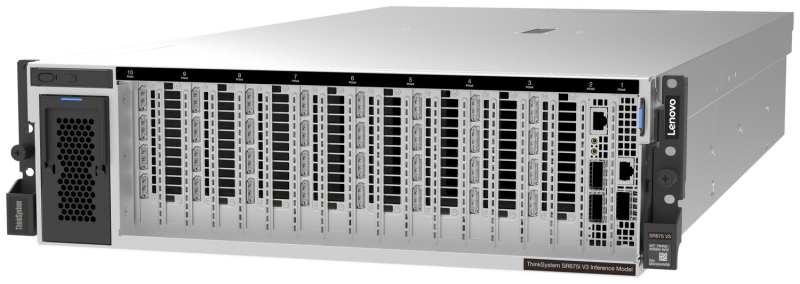

Lenovo представила серверы для ИИ-инференса: ThinkSystem SR675i V3/SR650i V4 и ThinkEdge ThinkEdge SE455i V4Lenovo представила новые серверные системы серии Lenovo Hybrid AI Advantage, оптимизированные для ИИ-инференса: ThinkSystem SR675i V3, ThinkSystem SR650i V4 и ThinkEdge SE455i V4. Если ранее акцент делался на решениях для обучения всё более производительных ИИ-моделей, то теперь бизнес обращает всё больше внимания на продукты для инференса. Новинки предлагаются параллельно с ПО для оптимизации инференса — для унификации и получения данных из разных источников для использования ИИ-моделями. Флагманской версией серии является ThinkSystem SR675i V3 в исполнении 3U на платформе AMD EPYC Turin 9535 (64C/128T, 2,4 ГГц, TDP 300 Вт). Сервер получил 1,5 Тбайт DDR5-6400 (24 × 64 Гбайт). За хранение данных отвечают до двух E3.S NVMe SSD по 3,84 Тбайт (PCIe 5.0 x4) и до двух M.2 NVMe SSD по 960 Гбайт (PCIe 4.0 x4). Возможна установка восьми ускорителей NVIDIA RTX PRO 6000 Blackwell Server Edition, а также пяти DPU NVIDIA BlueField-3 (4 × 400G, 1 × 200G). IPMI в данной модели не доступен. Для карт расширения доступно до шести слотов PCIe 5.0 х16 и один слот OCP 3.0 x8/x16. За питание отвечают четыре блока Titanium второго поколения (по 2300 Вт), а за охлаждение — пять вентиляторов. ThinkSystem SR650i V4 позиционируется в качестве системы для инференса и корпоративных рабочих нагрузок. Этот 2U-сервер получил два Intel Xeon Granite Rapids-SP 6530P (32C/64T, 2,3 ГГц, TDP 225 Вт), 512 Гбайт DDR5-6400 (8 × 64 Гбайт), два ускорителя RTX PRO 6000 Blackwell Server Edition. За хранение отвечают два 3,84-Тбайт U.2 NVMe SSD (PCIe 5.0 x4), хотя всего таких слотов восемь, а также RAID1-массив из пары 960-Гбайт M.2 SATA SSD. Всего доступно шесть слотов расширения PCIe 5.0 x16 и два слота OCP 3.0 x8/x16. Имеется двухпортовый 25GbE-адаптер Broadcom 57414 (SFP28). За питание отвечают два Titanium-блока мощностью 2700 Вт каждый, а за охлаждение шесть вентиляторов, но есть и опция установки фирменной СЖО Neptune. Наконец, Lenovo ThinkEdge SE455i V3 (2U) глубиной всего 440 мм представляет собой компактную модель, предназначенную для периферийного инференса — в ретейле, телекоммуникациях и промышленности. Сервер имеет защищённую конструкцию и может работать при температурах от -5 до +40 °C. Сервер построен на базе одного процессора AMD EPYC Embedded 8534P (64C/128T, 2,3 ГГц, TDP 200 Вт), дополненного 576 Гбайт DDR5-4800 (6 × 96 Гбайт) и двумя ускорителями NVIDIA L4 24 Гбайт (PCIe 4.0 x16). В комплекте идёт один 3,84-Тбайт NVMe SSD и один 960-Гбайт SATA SSD. Имеется два блока питания Platinum второго поколения с возможностью горячей замены. Для карт расширения есть до двух слотов PCIe 5.0 x16 и до четырёх слотов PCIe 4.0 x8, а также один слот OCP 3.0 (PCIe 5.0 x16). Установлен двухпортовый OCP-адаптер Broadcom 57416 (10GbE). IPMI отключён. Фактически компания предлагает готовые конфигурации, которые можно переконфигурировать лишь слегка, чаще всего добавив накопители и/или сетевые адаптеры. Платформы будут доступны в рамках подписки TruScale. Также компания анонсировала новые сервисы Hybrid AI Factory Services, в том числе консультации по инференсу, которые помогают развёртывать оборудование и управлять им для оптимизации ИИ-производительности.

12.01.2026 [12:59], Сергей Карасёв

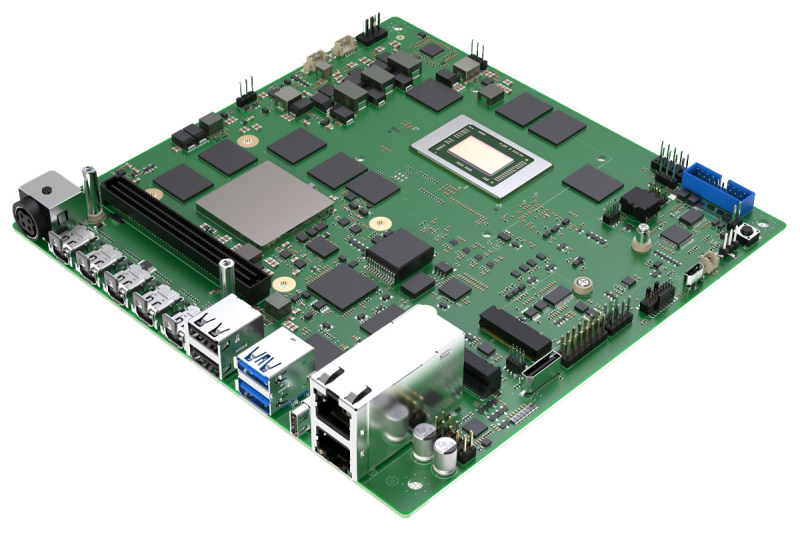

Sapphire представила Mini-ITX-плату EDGE+VPR-7P132 с чипом AMD Ryzen AI Embedded P132 и FPGA Versal AI Edge Gen2 VE3558Компания Sapphire Technology анонсировала плату EDGE+VPR-7P132 на платформе AMD Embedded+, предназначенную для построения различных периферийных устройств с ИИ-функциями. В новинке соседствуют процессор AMD Ryzen AI Embedded и адаптивная «система на чипе» AMD Versal AI Edge Gen 2. Решение выполнено в форм-факторе Mini-ITX с размерами 170 × 170 мм. Задействовано FPGA-решение Versal AI Edge Gen 2 VE3558 с восемью ядрами Arm Cortex-A78AE, десятью ядрами реального времени Arm Cortex-R52, графическим блоком Arm Mali-G78AE. Программируемая часть содержит 492 тыс. логических ячеек и 225 тыс. LUT. Чип обеспечивает ИИ-производительность до 123 TOPS на операциях INT8. Есть 16 Гбайт памяти LPDDR5-4266, флеш-модуль UFS 3.1 вместимостью 256 Гбайт, интерфейс Mini DisplayPort, а также модуль TPM 2.0 (Infineon OPTIGA TPM SLM 9672) и 250-контактный коннектор для плат расширения. CPU-секция получила процессор Ryzen AI Embedded P132 (V4526iX), который объединяет шесть ядер с архитектурой Zen 5 (12 потоков) с тактовой частотой до 4,5 ГГц, графический ускоритель AMD Radeon (RDNA 3.5) и нейропроцессорный блок с ИИ-производительностью до 50 TOPS в режиме INT8. Чип функционирует в тандеме с 64 Гбайт памяти LPDDR5-4266 (впаяна на плату). Предусмотрены коннектор M.2 Key M 2280 для SSD (PCIe 4.0 x4), слот M.2 Key E 2230 (PCIe 4.0 x1, I2S, USB 2.0) для адаптера Wi-Fi/Bluetooth и разъём OCulink x4. Плата получила два сетевых порта 10GbE, по два порта USB 3.2 Gen 2 Type-A и USB 2.0 Type-A, коннектор USB4 Type-C, четыре интерфейса Mini DisplayPort. Через внутренние разъёмы можно использовать аудиоинтерфейсы. Питание (12 В) подаётся через DC-коннектор. Диапазон рабочих температур простирается от 0 до +60 °C. Заявлена совместимость с RHEL/CentOS 7.9, RHEL 8.2-8.6 и Ubuntu 22.04. В качестве платы расширения упомянут модуль с поддержкой 12 камер для автомобильных систем и робототехники.

08.01.2026 [13:35], Руслан Авдеев

«Дата-центр в чемодане»: Odinn представила переносной нано-ЦОД Omnia с четырьмя NVIDIA H200Громоздкость оборудования для дата-центров не позволяет легко переносить его с места на место, но у стартапа Odinn своё видение этой проблемы. Компания представила на днях своеобразный «нано-ЦОД» с четырьмя ИИ-ускорителями NVIDIA H200 (NVL), сообщает The Register. По данным компании, 35-кг платформа Odinn Omnia помимом ускорителей включает до двух CPU AMD EPYC 9965 (Turin), до 6 Тбайт DDR5 ECC, 1 Пбайт NVMe SSD, 400GbE-адаптер, встроенный 23,8″ 4K-дисплей и откидную клавиатуру. Шасси снабжено рукоятками для переноски. Фактически речь идёт об устройстве размером с чемодан, хотя Omnia не позиционируется как портативный ПК или даже мобильная рабочая станция. «Чемоданный» ЦОД предлагается в нескольких конфигурациях, включая AI, Creator, Search и X. Использовать их можно для критически важных периферийных вычислений, военных миссий, симуляций корпоративного уровня, работы с киноматериалами буквально в любой локации. Кроме того, Omnia могут использоваться как модули для создания более масштабных структур, объединённых в кластеры Infinity Racks.

Источник изображения: Odinn Конечно, всё это обойдётся недёшево — один NVIDIA H200 стоит около $32 тыс. Можно предположить, что немногие компании позволят сотрудникам разгуливать с такими дорогими «чемоданами», которые довольно легко похитить. Впрочем, Odinn пока ничего не сообщает о цене устройств. Внешне, со встроенным дисплеем и откидной клавиатурой, Omnia отчасти напоминает портативные ПК далёкого прошлого. Если же встроенные дисплей и клавиатура не нужны, то есть решения попроще и в буквально смысле полегче. Так, 25-кг модульная платформа GigaIO Gryf объединяет в одном шасси-чемодане до пяти узлов различной конфигурации (плюс один обязательный модуль питания), в том числе с H200 NVL. Gryf тоже можно объединять в мини-кластеры.

06.01.2026 [22:15], Владимир Мироненко

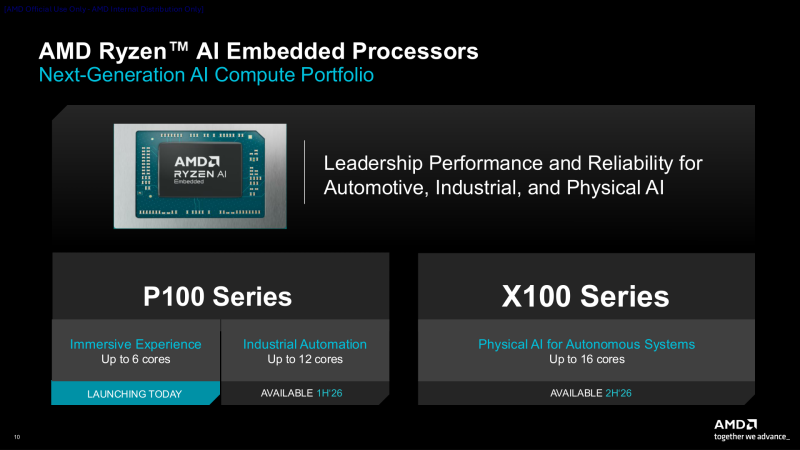

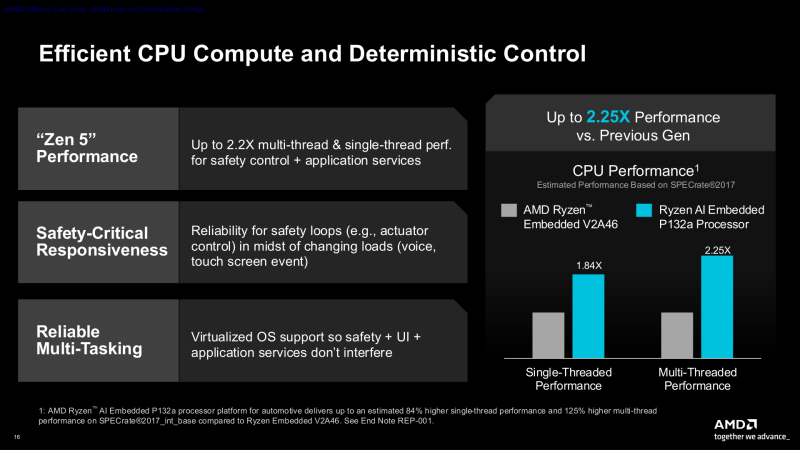

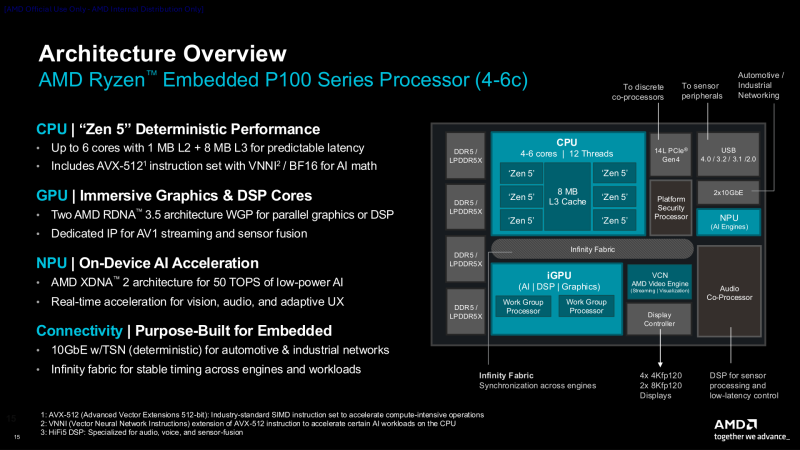

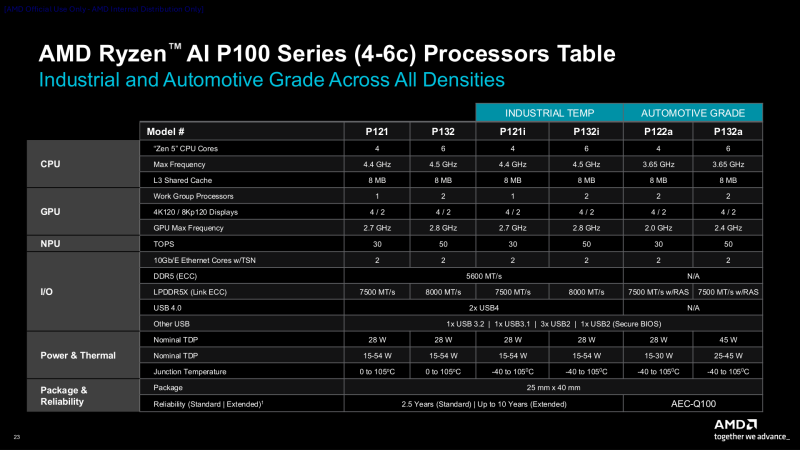

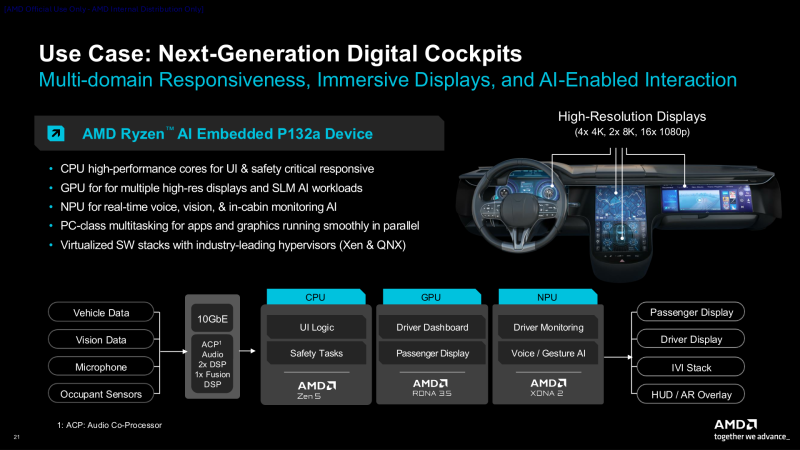

AMD анонсировала чипы Ryzen AI Embedded серий P100 и X100AMD представила процессоры AMD Ryzen AI Embedded серий P100 и X100, сочетающие высокопроизводительные ядра Zen 5, GPU RDNA 3.5 и NPU XDNA 2 для энергоэффективного ускорения ИИ. Процессоры серии P100 ориентированы на автомобильные решения и промышленную автоматизацию, а процессоры серии X100 с большим количеством ядер и повышенной ИИ-производительностью предназначены для более требовательных физических и автономных систем. Процессоры серии P100 с 4–6 ядрами, оптимизированные для цифровых кабин следующего поколения и HMI (человеко-машинных интерфейсов), обеспечивают рендеринг графики в реальном времени для автомобильных информационно-развлекательных дисплеев, взаимодействие на основе ИИ и быстродействие в многодоменных средах. Они обеспечивают до 2,2-кратное повышение производительности в многопоточных и однопоточных задачах по сравнению с предыдущим поколением. Чипы P100 имеют диапазон TDP от 15 Вт до 54 Вт, поддерживают память LPDDR5X и выполнены в BGA-корпусе размером 25 × 40 мм (FP8). Новые чипы с поддержкой работы при температуре от –40 °C до +105 °C созданы для сложных условий эксплуатации в ограниченном пространстве, включая безвентиляторные или полузащищённые конструкции, и рассчитаны на 10 лет работы в режиме 24/7. Чипы поддерживают память DDR5-5600 (ECC) и LPDRR5x-7500/8000 (Link ECC), а также имеют поддержку двух 10GbE-интерфейсов и двух USB4-подключений. AMD утверждает, что серия P100 обеспечивает до трёх раз большую ИИ-производительность (AI TOPS) по сравнению с серией Ryzen Embedded 8000. Это имеет важное значение для клиентов, модернизирующих существующие системы для достижения более высокой производительности ИИ на Ватт и на плату в целом, отметил ресурс Storagereview. Помимо автомобильного применения компания также ориентирует свои процессоры на вещательное оборудование, промышленные ПК, киоски, медицинские устройства и даже аэрокосмическую отрасль. Процессоры Ryzen AI Embedded обеспечивают согласованную среду разработки с унифицированным программным стеком, охватывающим CPU, GPU и NPU. Разработчики получат преимущества от оптимизированных библиотек CPU, открытых стандартных API GPU и архитектуры XDNA. Весь программный стек построен на базе открытой платформы виртуализации Xen, которая обеспечивает безопасную изоляцию нескольких доменов. Это позволяет использовать Yocto или Ubuntu для HMI, FreeRTOS для задач реального времени и Android или Windows для поддержки многофункциональных приложений, которые безопасно работают параллельно. Процессоры AMD Ryzen AI Embedded P100 с 4–6 ядрами, а также инструменты разработки и документация уже доступны для ознакомления избранным клиентам. Начало серийного производства чипов намечено на II квартал, а референсные платы появятся во II половине 2026 года. Процессоры серии P100 с 8–12 ядрами, предназначенные для приложений промышленной автоматизации, начнут поставляться в I квартале. Предоставление образцов процессоров серии X100 с до 16 ядер начнётся в I половине этого года. |

|