Материалы по тегу: gb300

|

11.02.2026 [13:38], Руслан Авдеев

Армения получит ещё 41 тыс. NVIDIA GB300 для ИИ ЦОД Firebird за $4 мдрдАмериканская компания Firebird, специализирующаяся на облачных и инфраструктурных решениях для ИИ, объявила о реализации второго этапа суперкомпьютерного мегапроекта в Армении. Она получила экспортные лицензии США и разрешения регуляторов на поставку в страну ещё 41 тыс. ускорителей NVIDIA GB300, сообщает HPC Wire. Расширение вычислительного кластера в Армении знаменует собой важную веху. Предполагается, что страна войдёт в пятёрку мест размещения крупнейших кластеров ИИ-ускорителей. Проект стоимостью $4 млрд — одно из крупнейших капиталовложений в технологическую сферу в истории страны. Подробности в ходе визита в Ереван раскрыл вице-президент США Джей Ди Вэнс (JD Vance) при участии вице-президента NVIDIA. По словам Вэнса, США «с гордостью» одобрили замечательное техническое соглашение с NVIDIA. Речь идёт об открытии новых рынков и новых рабочих мест как для американских работников, так и для армянских. 8 августа прошлого года Армения и США подписали меморандум в сфере ИИ и полупроводников. Выданная США экспортная лицензия свидетельствует о том, что проект полностью соответствует американским требованиям. Второй этап — продолжение реализации плана Firebird, выделившей $500 млн на создание в Армении первого ИИ-кластера. Реализация двух этапов обеспечит качественный скачок в технологической инфраструктуре страны. Он позволит проводить исследования в биологии, робототехнике, космической сфере и в сфере ИИ нового поколения. По словам представителей Firebird, новый кластер превращает Армению в глобальный центр суперкомпьютерных вычислений.

26.11.2025 [13:48], Сергей Карасёв

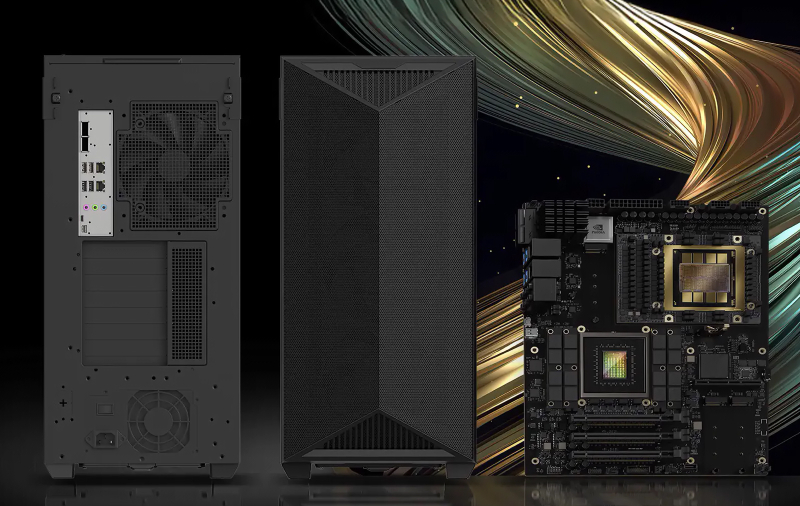

MSI представила рабочую станцию CT60-S8060 на базе NVIDIA GB300Компания MSI анонсировала мощную рабочую станцию CT60-S8060, ориентированную на ресурсоёмкие задачи в сфере ИИ, такие как обучение больших языковых моделей и инференс, а также на анализ крупных массивов данных и пр. Новинка построена на аппаратной платформе NVIDIA. В основу системы положен «персональный ИИ-суперкомпьютер» DGX Station. Используется суперчип GB300: объединены ускоритель B300 с 288 Гбайт памяти HBM3E (до 8 Тбайт/с) и процессор Grace с 72 Arm-ядрами. Присутствуют 496 Гбайт памяти LPDDR5X с пропускной способностью до 396 Гбайт/с. Блоки CPU и GPU связаны интерконнектом NVLink-C2C, который обеспечивает скорость передачи данных до 900 Гбайт/с. Рабочая станция заключена в корпус с габаритами 245 × 528,4 × 595 мм. Доступны два слота PCIe 5.0 x16 (на уровне сигналов x8 каждый) для карт расширения одинарной ширины и слот PCIe 5.0 x16 для карты двойной ширины. Кроме того, есть по два разъёма М.2 2280 с интерфейсом PCIe 5.0 x2 (NVMe) и M.2 2280 с интерфейсом PCIe 6.0 x4 (NVMe) для SSD, а также коннектор М.2 2232 (PCIe x1) для комбинированного адаптера Wi-Fi/Bluetooth. Система располагает контроллером Aspeed AST2600 BMC, сетевым адаптером NVIDIA ConnectX-8 с двумя портами 400GbE QSFP и контроллером Marvel AQC113, на основе которого реализован порт 10GbE RJ45. В тыльной части сосредоточены аудиогнёзда, порты USB Type-A и USB Type-C. Питание обеспечивает блок формата ATX мощностью 1600 Вт с сертификатом 80 PLUS Titanium.

21.11.2025 [14:14], Руслан Авдеев

AWS и Humain построят в Эр-Рияде кампус AI Zone, где развернут до 150 тыс. ИИ-ускорителей NVIDIA GB300 и Amazon TrainiumAWS и инвестиционная компания Humain из Саудовской Аравии объявили о планах развёртывания в кампусе AI Zone в Эр-Рияде до 150 тыс. ИИ-ускорителей. В рамках расширенного партнёрства компании намерены предоставлять вычислительные мощности и ИИ-сервисы из Саудовской Аравии клиентам со всего мира. Первый в своём роде в Саудовской Аравии кампус AI Zone будет применяться для обучения ИИ и инференса, с доступом к новейшей ИИ-инфраструктуре на основе ускорителей NVIDIA GB300 и Amazon Trainium. Клиенты смогут быстро переходить от стадии концепции к непосредственно работам, а «железо» и ПО NVIDIA будут бесшовно интегрированы с инфраструктурой и сервисами AWS. Поддержка Amazon Bedrock, AgentCore и SageMaker обеспечит клиентам немедленный доступ к базовым моделям в рамках единой платформы без необходимости управления базовой инфраструктурой. Для расширения возможностей AI Zone компания Humain присоединится к программе AWS Solution Provider Program. Это поможет реализации совместного плана, анонсированного в мае 2025 года и предусматривающего инвестиции более $5 млрд в ИИ-инфраструктуру, сервисы AWS, обучение и развитие ИИ-специалистов в Саудовской Аравии. Представитель AWS в регионе EMEA заявил, что объединяя локальный опыт и инвестиции Humain с решениями AWS в сфере ИИ, а также аппаратные решения NVIDIA, инновационную платформу Amazon Bedrock и решения для бизнес-пользователей, включая Amazon Quick Suite, партнёры создают инновационный центр мирового уровня, способный обслуживать клиентов по всему миру. AWS и Humain также ускорят внедрение ИИ в государственном и частном секторах, в том числе развитие LLM с поддержкой арабского языка, включая ALLAM, и создание единого маркетплейса ИИ-агентов для правительственных сервисов.

Истчоник изображения: backer Sha/unsplash.com Для подготовки квалифицированных кадров AWS обучит 100 тыс. граждан Саудовской Аравии работе с облачными технологиями и специфике генеративного ИИ в рамках программы Amazon Academy, отдельно планируется поддержать программу повышения квалификации для 10 тыс. женщин. Усилия направлены на подготовку кадров для «ИИ-центричной» экономики, которая, по прогнозам, к 2030 году внесёт в ВВП страны вклад в объёме $130 млрд. Подобные проекты стали возможны во многом благодаря визиту в США наследного принца Саудовской Аравии Мохаммеда бин Салмана (Mohammed bin Salman). Визит способствовал ряду соглашений американских компаний с саудовским бизнесом и Humain в частности — с участием AMD, xAI, NVIDIA и др., а также открыл дорогу для поставок в королевство передовых ИИ-чипов.

14.11.2025 [01:55], Владимир Мироненко

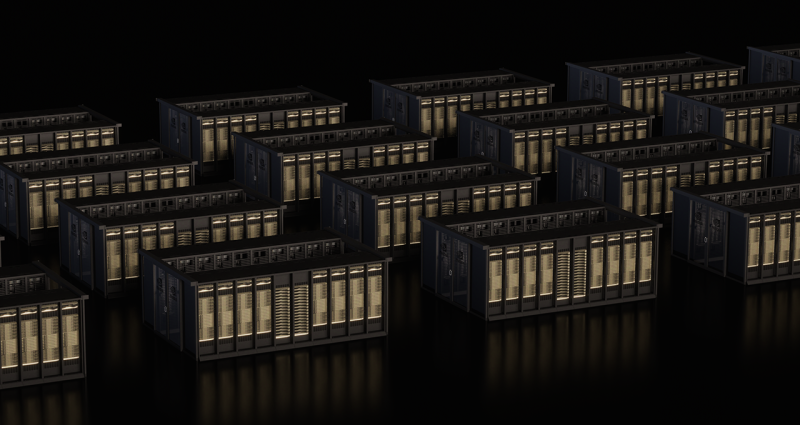

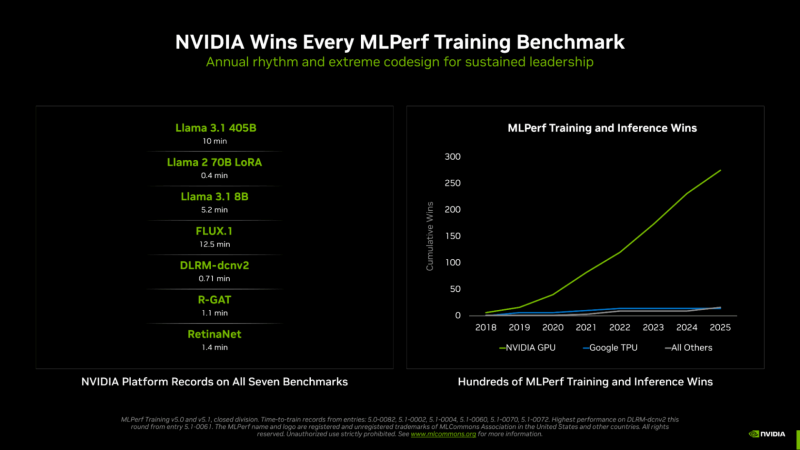

NVIDIA вновь впереди всех в новом раунде MLPerf Training v5.1Консорциум MLCommons опубликовал результаты тестирования различных аппаратных решений в бенчмарке MLPerf Training v5.1. На этот раз был установлен новый рекорд по разнообразию представленных систем. Участники этого раунда тестирования представили 65 уникальных систем, оснащённых 12 различными аппаратными ускорителями и различными программными платформами. Почти половина заявок была для многоузловых систем, что на 86 % больше, чем в раунде MLPerf Training 4.1 год назад, причём они так же отличались разнообразием сетевых архитектур. Раунд MLPerf Training v5.1 включает в себя результаты 20 компаний, подавших заявки: AMD, ASUS, Cisco, Dell, Giga Computing, HPE, Krai, Lambda, Lenovo, MangoBoost, MiTAC, Nebius, NVIDIA, Oracle, Quanta Cloud Technology (QCT), Supermicro, Supermicro + MangoBoost, Университет Флориды, Verda (DataCrunch), Wiwynn. Также сообщается, что структура заявок свидетельствует о растущем внимании к тестам, ориентированным на задачи генеративного ИИ: количество заявок на тест Llama 2 70B LoRa увеличилось на 24 %, а на новый тест Llama 3.1 8B — на 15 % по сравнению с тестом, который он заменил (BERT). NVIDIA объявила, что её чипы на архитектуре NVIDIA Blackwell заняли первые позиции во всех семи тестах MLPerf Training v5.1, обеспечив максимально быстрое обучение в работе с большими языковыми моделями (LLM), генерацией изображений, рекомендательными системами, компьютерным зрением и графическими нейронными сетями. NVIDIA подчеркнула, что была единственной платформой, которая предоставила результаты по всем тестам — это, по словам компании, «подчёркивает широкие возможности программирования ускорителей NVIDIA, а также зрелость и универсальность программного стека CUDA». Компания сообщила, что в этом раунде MLPerf Training дебютировала стоечная система GB300 NVL72, работающая на базе ускорителя NVIDIA Blackwell Ultra, показав рекордные результаты и доказав, что является наилучшим выбором для интенсивных рабочих ИИ-нагрузок. При предварительном обучении Llama 3.1 40B ускорители GB300 обеспечивают более чем вчетверо большую производительность по сравнению с H100 и почти вдвое — по сравнению с GB200. Аналогичным образом, при точной настройке Llama 2 70B восемь ускорителей GB300 обеспечили в пять раз большую производительность по сравнению с H100. NVIDIA отметила, что этого удалось достичь благодаря архитектурным усовершенствованиям Blackwell Ultra, включая новые тензорные ядра, которые обеспечивают ИИ-производительность в формате NVFP4 в размере 15 Пфлопс, вдвое большую производительность в работе механизма внимания (attention-layer compute) и 279 Гбайт HBM3e, а также новые методы обучения, которые позволили повысить вычислительную производительность архитектуры NVFP4. В MLPerf также дебютировала 800G-платформа Quantum-X800 InfiniBand, объединяющая несколько систем GB300 NVL72, которая удвоила пропускную способность сети по сравнению с предыдущим поколением. Но по словам компании, «ключом к выдающимся результатам в этом раунде было выполнение вычислений с использованием NVFP4 — впервые в истории MLPerf Training». NVIDIA обеспечила поддержку FP4 для обучения LLM на каждом уровне, что позволило удвоить скорость вычислений по сравнению с FP8. Ускоритель NVIDIA Blackwell может выполнять вычисления в формате FP4 (в т.ч. NVFP4 и др.) с удвоенной скоростью по сравнению с FP8, а Blackwell Ultra — с утроенной. На сегодняшний день NVIDIA является единственной платформой, которая представила результаты MLPerf Training с вычислениями, выполненными с использованием FP4 при соблюдении строгих требований к точности в тесте. Эти результаты были получены с использованием 5120 ускорителей Blackwell GB200, которым потребовалось всего 10 мин. на бенчмарк Llama 3.1 405B, что является новым рекордом. Это в 2,7 раза быстрее, чем лучший результат с использованием архитектуры Blackwell, показанный в предыдущем раунде бенчмарка. NVIDIA также установила рекорды производительности в двух новых тестах: Llama 3.1 8B и FLUX.1. Llama 3.1 8B — компактная, но обладающая высокой производительностью LLM — заменила модель BERT-large, добавив в линейку базовых моделей современную LLM малого размера. NVIDIA представила результаты с использованием до 512 ускорителей Blackwell Ultra, потратив 5,2 мин. на прохождение теста. FLUX.1 — современная модель генерации изображений — заменила Stable Diffusion v2, и только платформа NVIDIA представила результаты этого теста. NVIDIA представила результаты с использованием 1152 ускорителей Blackwell, установив рекорд — 12,5 мин. обучения.

12.11.2025 [15:17], Руслан Авдеев

Microsoft инвестирует $10 млрд в ИИ ЦОД в ПортугалииMicrosoft потратит $10 млрд на ИИ ЦОД на побережье Португалии. Это станет одной из крупнейших инвестиций компании в Европе в 2025 году, сообщает Bloomberg. Речь о проекте кампуса в Синише (Sines) в 150 км от Лиссабона. Строительством парка занимается Microsoft совместно с португальской Start Campus и британским стартапом Nscale. Информацию о проекте и сумме подтвердил президент Microsoft Брэд Смит (Brad Smith). Как отмечает Datacenter Dynamics, в начале года в кампусе введён в эксплуатацию первый из шести планируемых объектов — ЦОД SIN01. $10 млрд покроют расходы на развитие второй фазы проекта. Второй ЦОД SIN02 обеспечит 180 МВт и уже строится. Общая мощность кампуса должна составить 1,2 ГВт. Пока неизвестно, в скольких проектах ЦОД на площадке Microsoft и Nscale будут участвовать совместно. Партнёрство Microsoft, Nscale и Start Campus было анонсировано в октябре 2025 года. Nscale развернёт для Microsoft в Синише 12,6 тыс. ускорителей NVIDIA GB300. Столкнувшись с нехваткой мощностей, компания подписала соглашения с несколькими неооблаками на $60 млрд, в том числе с CoreWeave, Nebius, IREN и Lambda. Только за последний квартал на аренду потрачено $11,1 млрд. Мощности Nscale компания намерена арендовать в Великобритании, США и Норвегии. Всего Microsoft намерена арендовать у Nscale 116 тыс. ускорителей GB300. Хотя большинство ЦОД расположены в районе Лиссабона (присутствуют объекты AtlasEdge, Claranet, Edged, Tata Communications и Equinix), прибрежный город Синиш с населением порядка 15 тыс. человек становится ключевым инвестиционным хабом Португалии. Отсюда проложены и подводные кабели, ещё больше появится в будущем — Medusa, New CAM Ring, Nuvem и Olisipo. В мае китайская CALB Group начала строить в городе фабрику по производству аккумуляторов за €2 млрд ($2,3 млрд). Также Синиш, возможно, станет домом для «ИИ-гигафабрики», поддерживаемой Евросоюзом.

04.11.2025 [01:00], Владимир Мироненко

OpenAI потратит $38 млрд на аренду ускорителей NVIDIA у AWS, а AWS за $5,5 млрд арендует мощности у Cipher MiningAWS и OpenAI объявили о многолетнем стратегическом партнёрстве, в рамках которого AWS предоставит OpenAI ИИ-инфраструктуру. В рамках соглашения стоимостью $38 млрд OpenAI на семь лет получает доступ к вычислительным ресурсам AWS, включающим сотни тысяч ускорителей NVIDIA GB200/GB300 NVL72 в составе EC2 UltraServer, с возможностью расширения до десятков миллионов чипов для быстрого масштабирования агентных рабочих нагрузок. Согласно пресс-релизу, OpenAI сразу же начнёт использовать вычислительные ресурсы AWS. На первом этапе сделки будут использоваться существующие дата-центры AWS, а Amazon в конечном итоге развернёт дополнительную инфраструктуру для OpenAI. Развёртывание вычислительных мощностей планируется завершить до конца 2026 года. В 2027 году и далее возможно их расширение. В интервью ресурсу CNBC Дэйв Браун (Dave Brown), вице-президент по вычислительным сервисам и сервисам машинного обучения AWS, отметил, что OpenAI достанутся отдельные мощности, часть из которых уже доступна и используется. «Масштабирование передовых ИИ-технологий требует мощных и надёжных вычислений, — заявил генеральный директор OpenAI Сэм Альтман (Sam Altman). — Наше партнёрство с AWS укрепляет обширную вычислительную экосистему, которая станет движущей силой новой эры и сделает передовой ИИ доступным каждому». Примечательно, что для OpenAI будут развёрнуты узлы с преимущественно NVIDIA Connect-X, а не EFA, ради которых AWS переработала стойки GB300 NVL72, передаёт SemiAnalysis. Также OpenAI не будет использовать фирменные инструменты вроде SageMaker HyperPod, а задействует собственные решения для управления инфраструктурой. Т.е. речь идёт скорее о сдаче в аренду серверов, а не облачных сервисах. По-видимому, Project Ceiba также не относится к сделке. Вместе с тем OpenAI продолжит активно сотрудничать с Microsoft, обязавшись приобрести сервисы Azure на $250 млрд. Сделка была заключена после завершения реструктуризации OpenAI, в связи с чем ей уже нет необходимости получать одобрение Microsoft на покупку вычислительных сервисов у других компаний. В 2019–2023 гг. OpenAI использовала только вычислительные мощности Microsoft, являвшейся её основным инвестором. За последние 18 месяцев, несмотря на жалобы OpenAI на то, что ей не удалось получить от Microsoft всю необходимую вычислительную мощность, технологический гигант позволил стартапу заключить отдельные соглашения с двумя другими облачными провайдерами, пишет The New York Times. В последнее время OpenAI активно заключает сделки, в том числе, с такими компаниями, как AMD, CoreWeave, NVIDIA, Broadcom, Oracle и Google. Общая сумма сделок составила около $1,4 трлн, что побудило некоторых экспертов заявить о грядущем пузыре в сфере ИИ. Они также высказывают сомнения в наличии у США необходимых ресурсов и возможностей для воплощения этих амбициозных обещаний в реальность. Попутно стало известно о заключении AWS договора с оператором майнинговых дата-центров Cipher Mining на сумму около $5,5 млрд, согласно которому ей будут предоставлены в аренду на 15 лет площади и электропитание в ЦОД последней. Как сообщает Data Center Dynamics, согласно условиям договора, Cipher Mining предоставит AWS в 2026 году 300 МВт с поддержкой воздушного и жидкостного охлаждения стоек. Ранее Cipher Mining заключила сделку с Google и Fluidstack.

22.10.2025 [17:09], Владимир Мироненко

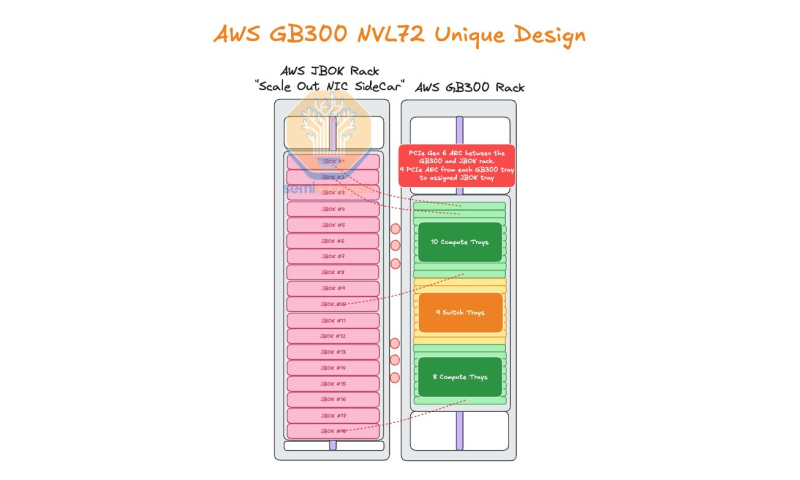

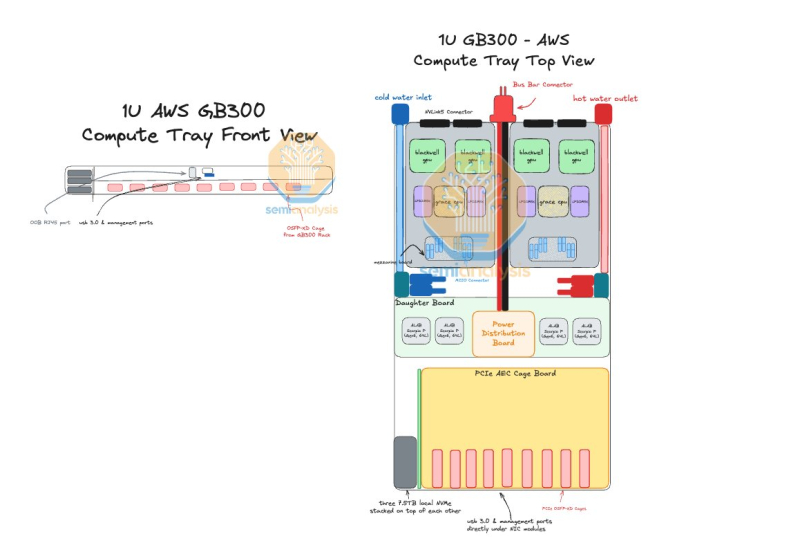

AWS пожертвовала компактностью GB300 NVL72, лишь бы снизить зависимость от NVIDIAAmazon Web Services (AWS) нашла выход, как использовать собственные Nitro DPU K2v5/6 (EFA) в новейших стоечных системах NVIDIA GB300 NVL72, которые, как считает гиперскейлер, превосходит адаптеры NVIDIA ConnectX-7/8 по производительности. В связи с тем, что в стойках NVIDIA Oberon используются укороченные лотки высотой 1U, AWS размещает NIC в отдельной стойке JBOK, предназначенной только для сетевых карт, пишет SemiAnalysis. Причина кроется в невозможности установить в 1U сразу девять фирменных адаптеров (8 × EFA + 1 × ENA/EBS). Для серверных систем GB200 NVL предыдущего поколения AWS выбрала вариант NVL36×2, поскольку только в этом случае использовались 2U-узлы, где достаточно места для всех NIC. Однако сдвоенная конфигурация менее эффективна, чем нативная конструкция NVL72. NVIDIA сама была не очень довольна вариантами NVL36. Meta✴, например, и вовсе «растянула» NVL36×2 на шесть стоек, чтобы обойтись воздушным охлаждением. AWS в случае Blackwell Ultra предпочла остановиться на NVL72-варианте, а DPU вынести в отдельную стойку — всего 18 узлов высотой 2U, по 9 NIC в каждом. С узлами NVIDIA они соединены активными электрическими кабелями (AEC) и портами OSFP-XD для передачи сигналов PCIe 6.0. По словам AWS, её адаптеры лучше справляются с нагрузками, чем ConnectX-8 (RoCEv2), что отчасти спорно. В любом случае таким образом компания снижается зависимость от NVIDIA. С точки зрения SemiAnalysis, доработка GB300 в AWS помогает устранить единую точку отказа в референсной архитектуре NVIDIA, где каждый ускоритель взаимодействует только с одним сетевым адаптером ConnectX-8, тогда как в конфигурации AWS каждый ускоритель общается с двумя NIC. У AWS накоплен богатый опыт разработки собственного оборудования для ЦОД. Ранее компания в партнёрстве с Broadcom разрабатывала специализированные сетевые коммутаторы. Также недавно представленные ею EC2-инстансы P6-B200 и P6e-GB200 оснащены собственным сетевым стеком Elastic Fabric Adapter (EFAv4) на базе собственных контроллеров Nitro, который оптимизирует обработку сетевых пакетов и снижает задержки для высокопроизводительных приложений.

20.10.2025 [09:11], Сергей Карасёв

Pegatron представила ИИ-систему RA4802-72N2 на базе NVIDIA GB300 NVL72Компания Pegatron представила систему RA4802-72N2, предназначенную для наиболее ресурсоёмких ИИ-нагрузок, включая обучение больших языковых моделей (LLM) в масштабе и инференс. В основу положена платформа NVIDIA GB300 NVL72. Изделие GB300 содержит Arm-процессор Grace с 72 ядрами Neoverse V2 (Demeter) и два чипа Blackwell Ultra. В составе RA4802-72N2 объединены 18 вычислительных лотков, каждый из которых несёт на борту два Grace и четыре Blackwell Ultra. В сумме это даёт 36 процессоров Grace и 72 чипа Blackwell Ultra. Каждый из вычислительных узлов располагает 960 Гбайт памяти LPDDR5X и 1152 Гбайт памяти HBM3e. Таким образом, в общей сложности система оперирует примерно 17 Тбайт LPDDR5X и 20 Тбайт HBM3e. ИИ-производительность достигает 720 Пфлопс на операциях FP8/FP6. В состав RA4802-72N2 также входят девять коммутационных лотков. Общая пропускная способность интерконнекта NVLink составляет 130 Тбайт/с. В расчёте на вычислительный узел используются два адаптера NVIDIA ConnectX-8 и один DPU NVIDIA BlueField-3. Прочие характеристики включают контроллер Aspeed AST2600, модуль TPM 2.0, восемь отсеков для накопителей E1.S NVMe, коннектор M.2 2280/22110 NVMe. Система выполнена в форм-факторе 48U MGX с габаритами 600 × 2296 × 1200 мм. Применяется полностью жидкостное охлаждение. Полка питания оснащена шестью 1U-модулями мощностью 33 кВт. Поставки машины RA4802-72N2 уже начались.

17.10.2025 [17:18], Руслан Авдеев

Poolside и CoreWeave построят в Техасе 2-ГВт кампус ИИ ЦОД, работающий на газе из Пермского бассейнаИИ-стартап Poolside объединился с CoreWeave для строительства кампуса ЦОД Project Horizon мощностью 2 ГВт на площади 230 га на территории ранчо Longfellow в Западном Техасе. Для электроснабжения планируется использовать природный газ, добываемый в местном Пермском бассейне, сообщает Datacenter Dynamics. ЦОД построят с использованием «гибридного модульного подхода», предполагающего «параллельное, а не последовательное строительство», которое будет завершено в I квартале 2027 года. CoreWeave станет ключевым арендатором первой фазы проекта, которая должна обеспечить мощность 250 МВт в соответствии с договором аренды на 15 лет. В будущем допускается увеличение арендуемых мощностей до 500 МВт. Также соглашение компаний предусматривает, что с декабря CoreWeave предоставит Poolside кластер NVIDIA GB300 NVL72 с более чем 40 тыс. чипов. По словам Poolside, партнёрство с CoreWeave обеспечит немедленный доступ к ускорителям новейшего поколения, что позволит обучать модели с триллионами параметров. Poolside основана в 2023 году. Стартап разрабатывает ПО для автоматизации написания программного кода с высокими корректностью и безопасностью, достаточных для того, чтобы его можно было использовать в государственных учреждениях. По данным Bloomberg, в 2024 году компания выпустила ИИ-агента для разработчиков государственного и оборонного секторов. Также ведутся работы и в области создания «общего искусственного интеллекта» (AGI).

Источник изображения: Bailey Alexander/unsplash.com Пока Poolside проводит раунд привлечения $2 млрд инвестиций, оценка стоимости компании по его итогам должна составить $14 млрд. Большую часть средств направят на приобретение 40 тыс. ускорителей NVIDIA. В 2024 года стартап уже привлёк $500 млн, получив оценку в $3 млрд. Компания является известным клиентом Fluidstack, а также арендовала некоторое количество NVIDIA H100 у Iris Energy. Благодаря большим запасам природного газа и относительно доступной электроэнергии в целом Техас стал весьма привлекательным местом для строителей дата-центров. По информации CBRE, сегодня это второй по величине рынок ЦОД в США. В штате реализуется первый проект в рамках инициативы Stargate, Meta✴ инициировала строительство ЦОД на 1 ГВт в Эль-Пасо, а Fermi America, будучи новичком на рынке дата-центров, заранее договорилась о подключение к газопроводу своего будущего 11-ГВт кампуса в Амарилло (Amarillo).

15.10.2025 [23:05], Владимир Мироненко

Microsoft арендует у Nscale ещё 116 тыс. ускорителей NVIDIA GB300Nscale и Microsoft заключили расширенное соглашение о предоставлении гиперскейлеру ИИ-инфраструктуры в США и Европе — 116,6 тыс. ускорителей на базе платформы NVIDIA GB300, сообщил Data Center Dynamics. Microsoft, как и другие крупные технологические компании, нуждается в увеличении вычислительных мощностей для удовлетворения растущего спроса на ИИ-технологии. С учётом более ранних контрактов Microsoft получит от Nscale почти 200 тыс. ускорителей. Nscale развернёт в течение следующих 12–18 мес. около 104 тыс. ускорителей в ЦОД Cedarvale в Барстоу (Barstow, шт. Техас), который она арендует у биткоин-майнера Ionic Digital в рамках десятилетнего соглашения стоимостью $2 млрд. На начальном этапе мощность инфраструктуры составит 240 МВт (хотя в пресс-релизе Ionic указано 234 МВт), а поэтапное предоставление её услуг Microsoft начнётся в III квартале 2026 года, сообщила Nscale. Nscale планирует в дальнейшем постепенно увеличить мощность объекта до 1,2 ГВт, при этом у Microsoft есть опцион на вторую фазу мощностью 700 МВт, начиная с конца 2027 года. В рамках соглашения Nscale также предоставит Microsoft для использования вычислительные мощности на базе до 12,6 тыс. ускорителей в кампусе Start Campus в Синише (Sines, Португалия). Монтаж оборудования здесь начнётся в I квартале 2026 года. На данный момент в эксплуатации находится один дата-центр кампуса, введённый в строй в январе 2025 года — SIN01. Сейчас ведётся строительство объекта SIN02 мощностью 180 МВт. Суммарно кампус будет включать шесть ЦОД. Nscale и Microsoft не назвали точную стоимость последних сделок, но исходя из аналогичной стоимости контракта на один ускоритель, их общая стоимость составляет до $14 млрд, сообщил ресурс The Financial Times. Ранее крупнейший среди неооблаков контракт был подписан между Microfoft и CoreWeave в интересах OpenAI, которая после разлада с Microsoft теперь напрямую закупает мощности у CoreWeave. В этом году Microsoft уже подписала сделки на аренду ИИ-мощностей с Nebius, Lambda и Nscale на общую сумму порядка $33 млрд. Новые сделки Nscale с Microsoft расширяют контракт стоимостью $6,2 млрд, в рамках которого Microsoft арендует вычислительные мощности на базе 52 тыс. ускорителей NVIDIA на объекте Nscale в Норвегии. Nscale и Microsoft также заняты реализацией крупного проекта в Великобритании. В прошлом месяце компании объявили о планах строительства самого мощного британского ИИ-суперкомпьютера в будущем ЦОД Nscale в Лоутоне (Loughton, граф. Эссекс), который, как ожидается, будет оснащён не менее 23 тыс. чипов Grace Blackwell Ultra. Но и от строительства собственных ИИ ЦОД Microsoft не отказывается. |

|