Материалы по тегу: nvidia

|

29.01.2026 [10:39], Руслан Авдеев

NVIDIA, Microsoft и Amazon ведут переговоры об инвестициях до $60 млрд в OpenAINVIDIA, Microsoft и Amazon ведут переговоры о новых инвестициях в OpenAI. Предполагается, что компании готовы вложить в бизнес партнёра до $60 млрд, сообщает The Information. Как заявляет The Information со ссылкой на «лицо, знакомое с ситуацией», NVIDIA — действующий инвестор, чьи чипы активно используются для работы с ИИ-моделями OpenAI, ведёт переговоры о том, чтобы вложить до $30 млрд. Microsoft, давно поддерживающая OpenAI, также ведёт переговоры, но готова потратить лишь менее $10 млрд. При этом Amazon (AWS), готовая стать новым инвестором, обсуждает о вложении значительно больше $10 млрд, потенциально — даже более $20 млрд. Сообщается, что OpenAI близка к тому, чтобы получить юридически не обязывающие меморандумы о договорённостях (term sheets) или инвестиционные обязательства от названных компаний. NVIDIA, Microsoft, Amazon и OpenAI пока новости не комментируют. Ранее сообщалось, что SoftBank Group ведёт переговоры об инвестициях дополнительных $30 млрд в OpenAI. Масштаб инвестиций Amazon может зависеть от отдельных переговоров, предусматривающих возможное расширение сделки по аренде облачных серверов у Amazon компанией OpenAI и заключение коммерческого соглашения о продаже OpenAI своих продуктов — Amazon может оформить корпоративные подписки на ChatGPT. Сейчас OpenAI пытается бороться с ростом цен на обучение и эксплуатацию своих ИИ-моделей на фоне ужесточающейся конкуренцией с компанией Google и более мелкими игроками. Впрочем, плохо контролируемые инвестиции могут быть весьма опасными. Так, американские банки уже крайне неохотно дают деньги Oracle, из-за уже имеющихся обязательств последней перед OpenAI. На днях сообщалось, что OpenAI готовит крупнейший в своей истории раунд финансирования на $50 млрд при участии инвесторов Ближнего Востока.

29.01.2026 [10:20], Руслан Авдеев

Конец неопределённости: Пекин одобрил импорт NVIDIA H200Китайские власти начали выдавать разрешения на импорт в страну ИИ-ускорителей NVIDIA H200. Это положит конец неопределённости, царившей после того, как поставки второго по производительности чипа NVIDIA в Поднебесную одобрили представители американских властей, сообщает гонконгская SCMP. Первая партия, как сообщают источники, поступит местным техногигантам, остро нуждающимся в передовых ускорителях. Впрочем, ожидается, что поддерживаемые государством компании вроде телеком-операторов, смогут покупать такие чипы только под жёстким контролем. Пока одобрены поставки более 400 тыс. ускорителей компаниям ByteDance, Alibaba Group Holding и Tencent Holdings, прочие бизнесы продолжают ожидать получения разрешений. В самой NVIDIA новости не комментируют. Это важные изменения китайской политики после того, как Пекин временно придержал поставки H200 ранее в январе 2026 года уже после того, как Вашингтон одобрил экспорт. Это отражает желание китайских властей сохранить баланс между необходимостью покупать передовые ИИ-чипы и стремлением добиться самодостаточности в этой сфере.

Источник изображения: NVIDIA По мнению экспертов, неограниченный доступ к закупкам чипов NVIDIA нанёс бы удар местной китайской индустрии ИИ-полупроводников. Поэтому регуляторам необходимо установить некоторые рамки для ограничения доли использования ИИ-ускорителей иностранного производства и управления спросом. Ранее допускалось, что китайские компании обяжут закупать определённое количество чипов местного производства при покупке H200 у NVIDIA. По мнению экспертов Национального университета Сингапура, одобрение Пекином импорта H200 вызвано стратегическими мотивами — это обеспечит дальнейшее ускоренное развитие китайских ИИ-технологий. Стоит отметить, что разрешение на поставки H200 довольно прохладно принято многочисленными политическими и бизнес-группами в США. Например, глава компании Anthropic сравнил такие продажи с поставками ядерного оружия Северной Корее.

27.01.2026 [12:53], Сергей Карасёв

Giga Computing представила ИИ-сервер на базе NVIDIA GB200 NVL4 с СЖОКомпания Giga Computing, подразделение Gigabyte Group, пополнила ассортимент серверов моделью XN24-VC0-LA61, ориентированной на ИИ-задачи и другие ресурсоёмкие нагрузки. Устройство выполнено в форм-факторе 2U на аппаратной платформе NVIDIA GB200 NVL4. В общей сложности задействованы четыре GPU поколения Blackwell со 186 Гбайт памяти HBM3E каждый (пропускная способность до 8 Тбайт/с) и два CPU Grace с 480 Гбайт памяти LPDDR5X (пропускная способность до 512 Гбайт/с). Применяется GPU — GPU интерконнект NVIDIA NVLink и CPU — GPU интерконнект NVIDIA NVLink-C2C. Реализована система прямого жидкостного охлаждения. Доступны четыре сетевых порта OSFP InfiniBand XDR на 800 Гбит/с или два порта Ethernet на 400 Гбит/с на базе NVIDIA ConnectX-8 SuperNIC. Кроме того, имеется порт 1GbE на основе Intel I210-AT и выделенный сетевой порт управления 1GbE. В оснащение входит контроллер ASPEED AST2600. Во фронтальной части расположены восемь посадочных мест для SFF-накопителей с интерфейсом PCIe 5.0 (NVMe) с жидкостным охлаждением. Опционально может быть установлен DPU NVIDIA BlueField-3. Есть внутренний разъём для SSD типоразмера M.2 2242/2260/2280/22110 с интерфейсом PCIe 5.0 x4, слот PCIe 5.0 х16 для карты FHHL с СЖО и ещё один разъём PCIe 5.0 х16 FHHL. Предусмотерны коннекторы USB 3.2 Gen1 Type-A, Micro-USB, Mini-DP и RJ45. Сервер имеет габариты 438 × 87 × 900 мм и массу 42,8 кг. За питание отвечают четыре блока мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур простирается от +10 до +35 °C.

26.01.2026 [21:48], Владимир Мироненко

NVIDIA инвестировала в CoreWeave ещё $2 млрд, чтобы та побыстрее построила ИИ ЦОД на 5 ГВтNVIDIA и CoreWeave объявили о расширении партнёрских отношений, что позволит CoreWeave ускорить создание более чем 5 ГВт мощностей ИИ ЦОД к 2030 году. NVIDIA также инвестировала $2 млрд в обыкновенные акции класса А CoreWeave по цене $87,20/шт. Как сообщается в пресс-релизе, «инвестиции отражают уверенность NVIDIA в бизнесе, команде и стратегии роста CoreWeave как облачной платформы, построенной на инфраструктуре NVIDIA». Акции CoreWeave выросли на 14 % в ходе утренних торгов и на 30 % с начала года, несмотря на продолжающиеся операционные убытки, отметил ресурс Investing. Компании сообщили, что с целью удовлетворения продолжающегося роста спроса на ИИ и потребности в вычислительных ресурсах они углубляют согласование своей инфраструктуры, ПО и платформ. Компании намерены:

Несмотря на то, что гендиректор NVIDIA Дженсен Хуанг (Jensen Huang) категорически не согласен с концепцией циклического финансирования, новые инвестиции вряд ли полностью развеют критику, отметил Investing. Многие аналитики по-прежнему рассматривают эти соглашения как косвенную поддержку NVIDIA спроса на собственные чипы. Глава CoreWeave Майкл Интратор (Michael Intrator) ранее назвал обвинения в циклическом финансировании «нелепыми», отметив, что общая доля NVIDIA остаётся относительно небольшой по сравнению с общим объёмом привлечённого CoreWeave капитала, превышающим $25 млрд.

Источник изображения: NVIDIA CoreWeave продолжает осуществлять диверсификацию своей клиентской базы. В ходе последнего квартального отчёта компания сообщила, что вклад крупнейшего заказчика в общую выручку не превышает 35 %. Для сравнения, в 2024-м году около 62 % от суммарной выручки CoreWeave приходилось на Microsoft. Вторым по величине заказчиком была NVIDIA (15 %), которая обязалась выкупить у CoreWeave все нераспроданные ИИ-мощности. У Microsoft имеются контракты с несколькими неооблаками на общую сумму более $60 млрд. Если ранее Microsoft скупала мощности в интересах OpenAI, то теперь OpenAI скупает мощности у CoreWeave напрямую, общая сумма контрактов достигла $22,4 млрд. Кроме того, в рамках партнёрского соглашения с IBM компания CoreWeave обязалась поставить ей один из своих первых ИИ-суперкомпьютеров на базе NVIDIA GB200 NVL72. В числе клиентов CoreWeave также Meta✴, заключившая с ней контракт на $14,2 млрд. Впрочем, для снижения рисков, связанных с крупными заимствованиями для развёртывания ИИ-инфраструктуры IT-гиганты проводят сделки по обеспечению своих проектов через компании специального назначения — SPV (special-purpose vehicle), финансируемые большей частью инвесторами с Уолл-стрит. Чтобы обеспечить выполнение обязательств по развёртыванию ИИ-инфраструктуры в рамках обязательств по контрактам с ИИ-компаниями, CoreWeave прибегает к заимствованиям. В частности, для развёртывания облачной инфраструктуры в рамках долгосрочного соглашения с OpenAI компания договорилась об отложенном кредите (DDTL 3.0) на сумму $2,6 млрд.

24.01.2026 [14:15], Сергей Карасёв

Nokia и Hypertec построили в Канаде 15-Пфлопс суперкомпьютер Nibi с погружным охлаждением

amd

emerald rapids

granite rapids

h100

hardware

hpc

intel

mi300

nokia

nvidia

ии

канада

отопление

погружное охлаждение

суперкомпьютер

Компании Nokia и Hypertec объявили о запуске суперкомпьютера Nibi, смонтированного в Университете Ватерлоо (University of Waterloo) в Канаде. Эта НРС-платформа будет использоваться для решения широкого спектра задач, в том числе в области ИИ. Проект Nibi финансируется канадским Министерством инноваций, науки и экономического развития через Канадский альянс цифровых исследований, а также Министерством колледжей, университетов, научных исследований и безопасности через некоммерческую организацию Compute Ontario. Система насчитывает в общей сложности более 750 вычислительных узлов. Это, в частности, 700 узлов CPU, каждый из которых несёт на борту два процессора Intel Xeon 6972P поколения Granite Rapids-AP (96C/192T, до 3,9 ГГц) и 748 Гбайт оперативной памяти. Кроме того, задействованы 10 узлов с двумя чипами Xeon 6972P и 6 Тбайт памяти каждый. В состав суперкомпьютера также входят 36 узлов GPU, которые содержат по два процессора Intel Xeon Platinum 8570 серии Emerald Rapids (56C/112T, до 4 ГГц), 2 Тбайт оперативной памяти и восемь ускорителей NVIDIA H100 SXM (80 GB), связанных посредством NVLink. Наконец, Nibi оперирует шестью узлами с четырьмя ускорителями AMD Instinct MI300A. Подсистема хранения VAST Data выполнена на основе SSD суммарной вместимостью 25 Пбайт. Пропускная способность каналов передачи данных между CPU- и GPU-узлами составляет 200 Гбит/с. Подключение к хранилищу обеспечивается благодаря 24 линиям на 100 Гбит/с. Заявленная пиковая производительность Nibi достигает 15 Пфлопс. Новая НРС-платформа оборудована высокоэффективной системой погружного жидкостного охлаждения. Сгенерированное тепло используется для обогрева центра квантовых и нанотехнологий имени Майка и Офелии Лазаридис (Mike and Ophelia Lazaridis Quantum-Nano Centre).

22.01.2026 [00:38], Владимир Мироненко

Глава NVIDIA объявил о крупнейшем в истории человечества строительстве ИИ-инфраструктурыГендиректор NVIDIA Дженсен Хуанг (Jensen Huang, на последнем фото справа), выступая на ежегодном заседании Всемирного экономического форума в Давосе (Швейцария), описал ИИ как основу «крупнейшего в истории человечества строительства инфраструктуры», способствующей созданию рабочих мест во всей мировой экономике. Хуанг представил ИИ не как единую технологию, а как «пятислойный торт», охватывающий энергетику, микросхемы и вычислительную инфраструктуру, облачные ЦОД, ИИ-модели и, в конечном итоге, прикладной уровень. По его словам, поскольку каждый слой ИИ-структуры должен быть построен и эксплуатироваться, перестройка платформы создаёт рабочие места во всей экономике — от энергетики и строительства до передового производства, облачных операций и разработки приложений. Прикладной уровень может быть сосредоточен на интеграции ИИ в финансовые услуги, здравоохранение или производство. «Именно этот верхний слой, в конечном счете, станет источником экономической выгоды», — отметил Хуанг. Развитие ИИ уже создаёт спрос на квалифицированную рабочую силу, начиная от производства электроэнергии и заканчивая изготовлением микросхем, строительством ЦОД и облачными операциями. Наибольшая экономическая выгода ожидается на уровне приложений, когда ИИ трансформирует такие отрасли, как здравоохранение, производство и финансовые услуги, и поменяет характер работы всей экономики, утверждает Хуанг. По словам Хуанга, венчурные инвестиции отражают то, как быстро ИИ меняет мировую экономику. Минувший год стал одним из крупнейших по объёму венчурного финансирования за всю историю, причем большая часть этого капитала поступила в так называемые «компании, изначально ориентированные на ИИ». Речь идёт о компаниях в здравоохранении, робототехнике, занимающихся производством и финансовыми услугами, то есть там, где, по словам Хуанга, «впервые модели достаточно хороши, чтобы что-то строить на их основе». Эти инвестиции напрямую обеспечивают создание рабочих мест. Хуанг отметил спрос на сантехников, электриков, строителей, сталелитейщиков, сетевых техников и бригады, ответственные за установку и эксплуатацию современного оборудования. Хуанг не считает, что ИИ ведёт к сокращению рабочих мест. Напротив, ИИ-технологии увеличивают спрос в таких областях, как радиология, и помогает справляться с административной работой в областях с нехваткой рабочей силы. Например, в США не хватает примерно 5 млн медсестёр, отчасти потому, что почти половину своего времени они тратят на ведение медицинской документации. Теперь эту обязанность можно возложить на ИИ. «ИИ — это инфраструктура», — заявил Хуанг, утверждая, что каждая страна должна относиться к ИИ так же, как к электричеству или дорогам. «ИИ должен быть частью вашей инфраструктуры», — отметил он. «Совершенно очевидно, что крайне важно научиться использовать ИИ — направлять его, управлять им, контролировать его работу, оценивать его», — сказал Хуанг, сравнивая эти навыки с лидерством и управлением персоналом. Для развивающихся стран ИИ обеспечит возможность сократить давние технологические пробелы. Что касается стран Европы, он призывал их объединить промышленные возможности с ИИ, чтобы раскрыть потенциал физического ИИ и робототехники. Участвовавший в дискуссии с Хуангом главный исполнительный директор BlackRock Лоренс Дуглас Финк (Laurence D. Fink) отметил, что исходя из вышесказанного можно сделать вывод о том, что мир далёк от «пузыря ИИ». Отвечая на вопрос, достаточно ли инвестиций в ИИ, Хуанг заявил, что необходимы крупные инвестиции, потому что «нужно создать инфраструктуру, необходимую для всех уровней ИИ». Он также отметил, что в 2025 году венчурные инвестиции составили рекордную сумму — более $100 млрд было вложено в ИИ по всему миру, большая часть — в стартапы, занимающиеся разработкой ИИ.

21.01.2026 [17:07], Руслан Авдеев

Глава Anthropic: продажа H200 в Китай равнозначна поставкам ядерного оружия Северной КорееГенеральный директор Anthropic Дарио Амодеи (Dario Amodei) недоволен тем, что США разрешили NVIDIA продавать китайским компаниям передовые ИИ-ускорители. Он сравнил это решение с раздачей ядерного оружия противникам, сообщает The Register. По словам Амодея, выступившего на Международном экономическом форуме в Давосе, руководители китайских компаний заявляют, что эмбарго на поставку американских чипов сдерживает их развитие. Он заявил, что продавать эти чипы — большая ошибка. Ранее США разрешили поставки ускорителей NVIDIA H200 китайским покупателям с пошлиной 25 %. Теперь слово за китайскими властями, которым ещё предстоит разрешить такие сделки. Anthropic желает, чтобы экспорт ИИ-технологий, наоборот, ужесточился — это заметно контрастирует с позициями NVIDIA и AMD, которые предупреждают, что запреты на экспорт только способствуют развитию ИИ-технологий в КНР. При этом на Китай приходится около половины исследователей в области искусственного интеллекта. Ранее Anthropic утверждала, что США и так лидируют в сфере ИИ-полупроводников, а экспортный контроль, на фоне того, что вычислительные мощности чипов удваиваются каждые два года, замедляет развитие Китая и укрепляет лидерство США. Компания уверена, что США на годы опережают Китай в способности выпускать передовые чипы. Доступ к американским разработкам позволит китайским создателям ПО вроде DeepSeek оказаться в лучшей позиции для конкуренции с Западом. При этом, как сообщает The Register, многие из наиболее производительных китайских LLM относятся к open source, поэтому их может использовать любой желающий, не опасаясь того, что данные его компании попадут в обучающий датасет, тогда как LLM американских компаний в основном «скрыты» за API, а сами компании расплывчато обещают не использовать пользовательские данные для обучения своих ИИ. При этом суды полны исков пользователей, связанных с нарушением прав на интеллектуальную собственность.

Источник изображения: CDC/unspalsh.com Слова Амодеи о том, что китайские разработчики LLM угрожают американскому бизнесу, слегка сгущают краски, но всё может действительно измениться, если китайские компании смогут импортировать передовые ускорители из США. Пока же, по словам бизнесмена, ИИ из КНР производителен только «на бумаге», а системы якобы специально оптимизируют для бенчмарков. Так или иначе, корпоративные пользователи действительно имеют немного вариантов, если желают получить доступ к хорошим открытым моделям — они в основном из Китая. Сама Anthropic называет главными конкурентами не стартапы из КНР, а OpenAI, Google и, чуть реже, другие американские компании. Anthropic пока не выкладывала ни одну из своих флагманских моделей в открытый доступ, но участвовала в нескольких совместных проектах с избранными клиентами, самым значимым из которых является AWS. Амодеи подчеркнул, что его продукты почти ни разу не проиграли в борьбе за контракт ИИ-модели из Поднебесной. Ключевое слово — «почти». Это означает, что китайским разработчикам всё-таки удавалось одержать верх несмотря на сложную ситуацию, в которой они находятся из-за экспортных ограничений. Компания последовательно критикует инициативы, способные обеспечить сотрудничество Запада с Китаем и даже не приветствует взаимодействие с другими мировыми игроками. Так, летом 2025 года сообщалось, что она намерена привлечь инвестиции с Ближнего Востока, но только потому, что избежать работы с регионом не удастся. В 2024 году Anthropic даже отказалась от инвестиций из Саудовской Аравии по соображениям «национальной безопасности».

20.01.2026 [10:02], Владимир Мироненко

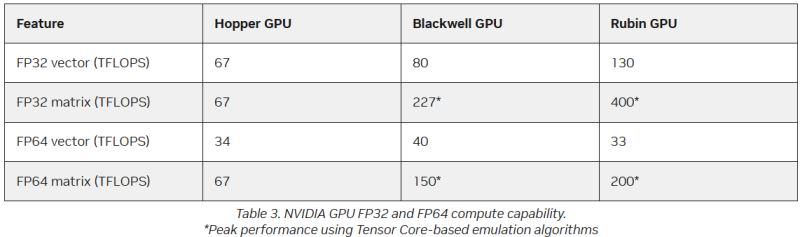

FP64 у вас ненастоящий: AMD сомневается в эффективности эмуляции научных расчётов на тензорных ядрах NVIDIAВместо создания специализированных чипов для аппаратных FP64-вычислений NVIDIA использует эмуляцию для повышения производительности HPC на ИИ-ускорителях, пишет The Register. Компания отказалась от развития FP64-блоков в поколении Blackwell Ultra, а в новейших ускорителях Rubin пиковая заявленная производительность векторных FP64-вычислений составляет 33 Тфлопс, тогда как у H100, вышедшего четыре года назад, она была равна 34 Тфлопс, а у Blackwell — около 40 Тфлопс. Если включить программную эмуляцию в библиотеках CUDA от NVIDIA, ускоритель, как утверждается, может достичь производительности до 200 Тфлопс в матричных FP64-вычислениях. Впрочем, и Blackwell с эмуляций способен выдать в этом случае до 150 Тфлопс, тогда как у Hopper были «честные» 67 Тфлопс. «В ходе многочисленных исследований с партнёрами и собственных внутренних изысканий мы обнаружили, что точность, достигаемая с помощью эмуляции, как минимум не уступает точности, получаемой от аппаратных тензорных ядер», — сообщил ресурсу The Register Дэн Эрнст (Dan Ernst), старший директор по суперкомпьютерным продуктам NVIDIA. В свою очередь, в AMD считают, что это утверждение справедливо не для всех сценариев. «В некоторых бенчмарках она показывает довольно хорошие результаты, но в реальных физических научных симуляциях это не очевидно», — говорит Николас Малайя (Nicholas Malaya), научный сотрудник AMD. Он выразил мнение, что, хотя эмуляция FP64, безусловно, заслуживает дальнейших исследований и экспериментов, такое решение ещё не готово к широкому применению. AMD и сама изучает возможность программной эмуляции FP64 на Instinct MI355X, чтобы определить области её возможного применения. Хотя чипы всё чаще используют типы данных с более низкой точностью, FP64 остаётся золотым стандартом для научных вычислений, и на то есть веские причины — FP64 не имеет себе равных по динамическому диапазону. Современные же LLM обучаются с использованием FP8-вычислений, а компактные типы данных MXFP8/MXFP4 или NVFP4 позволяют получить достаточный для ИИ диапазон значений. Это хорошее решение для нечёткой математики больших языковых моделей, но это не замена FP64 для HPC. ИИ-нагрузки обладают высокой устойчивостью к ошибкам, а HPC-задачи требуют высокой точности. AMD указала на то, что эмуляция FP64 у NVIDIA не совсем соответствует стандарту IEEE. Алгоритмы NVIDIA не учитывают такие понятия, как положительные и отрицательные нули, ошибки NaN (Not a Number) и ошибки infinite number (бесконечное число). Из-за этого небольшие ошибки в промежуточных вычислениях, используемых для эмуляции более высокой точности, могут привести к искажениям, способным повлиять на точность конечного результата, пояснил Малайя. По его словам, целесообразность использования эмуляции FP64 зависит от конкретного приложения. Эмуляция FP64 лучше всего работает для хорошо обусловленных проблем, где малые изменения «на входе» приводят к малым же изменениям в конечном результате. Ярким примером такой задачи является бенчмарк Linpack (HPL). «Но если вы посмотрите на материаловедение, коды для расчёта процессов горения, системы ленточых матриц и т.п., то увидите, что это гораздо менее обусловленные системы, и внезапно всё начинает давать сбои», — сказал он. Точность можно повысить, увеличив количество используемых операций, однако после определённого предела никаких преимуществ от эмуляции уже не будет. Вдобавок все эти операции требуют память. «У нас есть данные, которые показывают, что алгоритму Озаки требуется примерно вдвое больше памяти для эмуляции матриц FP64», — сказал Малайя. Поэтому компания готовит специализированные ускорители MI430X c повышенной FP64/FP32-производительностью, но, как опасаются учёные, она может оказаться не слишком в них заинтересована, поскольку ИИ-ускорители приносят больше денег. Эрнст утверждает, что для большинства специалистов в области HPC неполное соответствие стандарту IEEE не представляет большой проблемы. Всё во многом зависит от конкретного приложения. Тем не менее, NVIDIA разработала дополнительные алгоритмы для обнаружения и смягчения указанных выше ошибок и неэффективных операций эмуляции. Эрнст также признал, что использование памяти при эмуляции может быть несколько выше, но подчеркнул, что эти накладные расходы относятся к расчётам, а не к самому приложению — в большинстве случаев речь идёт о матрицах размером не более нескольких Гбайт. Впрочем, всё это не меняет того, что эмуляция полезна только для подмножества HPC-задач, которые полагаются на операции умножения плотных матриц (DGEMM). По словам Малайи, для 60–70 % рабочих нагрузок HPC эмуляция дает незначительные преимущества или ничего не меняет. «По нашим оценкам, подавляющее большинство реальных рабочих нагрузок HPC полагаются на векторное умножение (FMA), а не на DGEMM», — сказал он, отметив, что это действительно нишевый сегмент, хотя и не крошечная доля рынка. Для рабочих нагрузок, интенсивно использующих векторы, таких как вычислительная гидродинамика (CFD), ускорители Rubin по-прежнему будут полагаться на медленные векторные FP64-блоки.

17.01.2026 [13:07], Сергей Карасёв

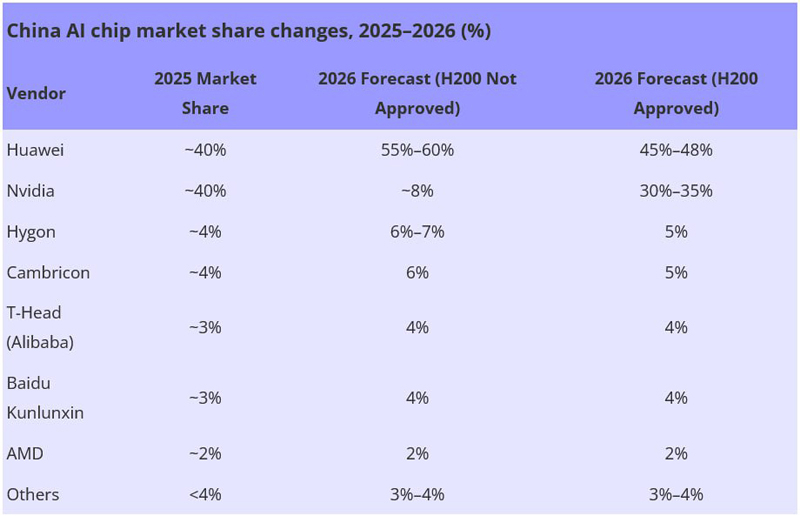

Huawei сравняла долю с NVIDIA на китайском рынке ИИ-чиповРезкий рост спроса на вычислительные мощности, геополитическое давление и ограничения в цепочках поставок приводят к трансформации китайского рынка ИИ-ускорителей. По оценкам Bernstein, которые приводит ресурс DigiTimes, позиции в КНР резко укрепила компания Huawei, которой удалось сравнять свою долю с NVIDIA. Объём сектора ИИ-чипов в Китае по итогам 2025 года достиг приблизительно $20,4 млрд. Примерно по 40 % от этой суммы, или по $8,16 млрд, приходится на Huawei и NVIDIA. Годом ранее доля Huawei составляла одну треть от показателей NVIDIA. Таким образом, сообща эти две компании контролируют около 80 % китайского рынка ИИ-ускорителей, что эквивалентно $16,32 млрд. Если не рассматривать двух лидеров, рынок ИИ-чипов в КНР является сильно фрагментированным. Так, Hygon и Cambricon занимают примерно по 4 %, при этом Hygon выигрывает от совместимости с архитектурой x86. T-Head Semiconductor, принадлежащая Alibaba, и Kunlunxin (Baidu) занимают по 3 % отрасли. Ещё около 2 % приходится на AMD. Все прочие игроки вместе взятые, включая Zixiao (Tencent), MetaX, Moore Threads и Biren, контролируют менее 4 % отрасли.

Источник изображения: DigiTimes Аналитики полагают, что в случае запрета поставок в Китай ускорителей H200 доля NVIDIA на местном рынке в 2026 году может сократиться до 8 %. При этом Huawei, как ожидается, укрепит позиции до 55–60 %. Если же поставки H200 в КНР будут одобрены, NVIDIA может занять 30–35 %, а Huawei — 45–48 %. При этом суммарная доля всех прочих игроков будет колебаться в пределах 24–27 %. По словам самой NVIDIA, запрет поставок ускорителей в Китай был большой ошибкой. В целом, считают эксперты, китайский рынок ИИ-чипов в период с 2023-го по 2028 году будет демонстрировать среднегодовой темп роста в сложных процентах (CAGR) на уровне 50 %. В результате, его объём за этот период увеличится с $11 млрд до $88 млрд.

16.01.2026 [23:14], Владимир Мироненко

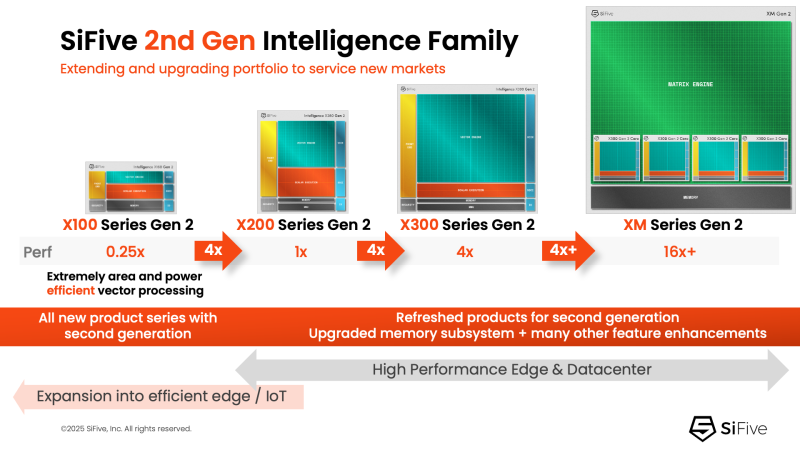

NVIDIA добралась до RISC-V: NVLink Fusion пропишется в серверных процессорах SiFiveПродолжая укреплять свои лидирующие позиции на ИИ-рынке NVIDIA не скрывает стремления построить целую экосистему ИИ-платформ с привязкой к своим решениям. Эти усилия активизировались в прошлом году с анонсом технологии NVLink Fusion, позволяющей использовать NVLink в чипах сторонних производителей. Как стало известно, вслед за Arm, Intel и AWS, присоединившимися к программе в прошлом году, экосистема NVLink Fusion пополнилась первым поставщиком чипов на архитектуре RISC-V — компанией SiFive, которая объявила о планах внедрить NVLink Fusion в свои будущие чипы для ЦОД. SiFive отметила, что ИИ-вычисления вступают в фазу, когда архитектурная гибкость и энергоэффективность так же важны, как и пиковая пропускная способность. Нагрузки обучения и инференса растут быстрее, чем энергетические бюджеты, заставляя операторов ЦОД переосмыслить способы подключения и управления CPU, GPU и ASIC. Теперь производительность на Вт и эффективность перемещения данных стали первостепенными ограничениями при проектировании чипов. Патрик Литтл (Patrick Little), президент и генеральный директор SiFive заявил, что ИИ-инфраструктура больше не строится из универсальных компонентов, а разрабатывается совместно с нуля: «Интегрируя NVLink Fusion с высокопроизводительными вычислительными подсистемами SiFive, мы предоставляем клиентам открытую и настраиваемую платформу CPU, которая легко интегрируется с ИИ-инфраструктурой NVIDIA, обеспечивая исключительную эффективность в масштабах ЦОД». Пресс-релиз SiFive не содержит каких-либо конкретных планов по продуктам, кроме сообщения о добавления поддержки NVLink к «высокопроизводительным решениям для ЦОД» SiFive. Предположительно, речь идёт о чипах платформы Vera Rubin или более поздних, т.е. о NVLink 6. Для SiFive — как поставщика IP-блоков RISC-V CPU — интерес заключается в использовании интерконнекта NVLink-C2C, который обеспечивает высокоскоростную, полностью кеш-когерентную связь между CPU и GPU, и это предпочтительный способ подключения к ускорителям NVIDIA в высокоинтегрированных системах. В рамках экосистемы NVLink Fusion NVIDIA предлагает NVLink-C2C в качестве лицензируемого IP-ядра, что упростит интеграцию шины в будущие чипы SiFive. Для SiFive это может стать конкурентным преимуществом. Кроме того, NVIDIA объявила о поддержке RISC-V — на эту архитектуру портируют CUDA и драйверы, что со временем откроет для компании новые рынки. |

|