Материалы по тегу: intel

|

19.02.2026 [12:26], Сергей Карасёв

«НВБС» представила российские серверы «Необайт» на платформах Intel и AMDКомпания «НВБС», российский системный интегратор и производитель технологических решений, анонсировала собственные серверы семейства «Необайт». Дебютировали модели NeoByte NBR220 и NeoByte NBR680 на аппаратной платформе Intel, а также NeoByte NBR685 с процессорами AMD. По словам компании, новинки «сопоставимы с решениями ведущих компаний на рынке, но при этом в среднем стоят на 10–15 % дешевле за счёт широкого пула поставщиков и оптимизированной логистики». Система NeoByte NBR220 типоразмера 2U может нести на борту два чипа Intel Xeon Sapphire Rapids или Emerald Rapids с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5-4800. В зависимости от конфигурации во фронтальной части возможна установка 12 накопителей LFF/SFF или 24 устройств SFF с интерфейсом SATA/SAS/NVMe. В тыльной зоне корпуса расположены посадочные места ещё для четырёх накопителей LFF/SFF (SATA/SAS/NVMe), тогда как внутри есть два коннектора для SSD формата M.2 (SATA/NVMe). Реализована поддержка до 10 стандартных слотов PCIe и одного слота OCP 3.0. В оснащение входят контроллер AST2600, два сетевых порта 1GbE, выделенный сетевой порт управления 1GbE, четыре порта USB 3.0 (по два спереди и сзади), два интерфейса D-Sub (по одному спереди и сзади) и последовательный порт. Питание обеспечивают два блока с резервированием мощностью 800/1300/1600/2000 Вт. Сервер оптимизирован для ИИ-задач, виртуализации, баз данных и файловых хранилищ. Платформа практически идентична представленным ранее серверам «Аквариус» AQserv T50 D224RS и T50 D212RS. Модель NeoByte NBR680 стандарта 6U имеет аналогичные характеристики подсистем CPU, ОЗУ, хранения данных и интерфейсов ввода/вывода. При этом возможна установка до восьми GPU-ускорителей двойной ширины. Есть пять стандартных слотов PCIe и один слот OCP; передняя панель поддерживает до трёх стандартных слотов PCIe и один слот OCP. Мощность каждого из двух блоков питания — 2700 или 3200 Вт. Машина предназначена для научных исследований и крупных ИИ-проектов. В свою очередь, GPU-сервер NeoByte NBR685 формата 6U рассчитан на два процессора AMD EPYC 9005 Turin или EPYC 9004 Genoa с показателем TDP до 500 Вт. Предусмотрены 24 слота для модулей оперативной памяти DDR5-4800. Прочие характеристики идентичны версии NeoByte NBR680, включая поддержку восьми GPU-ускорителей двойной ширины. Система подходит для анализа больших данных в реальном времени, криптографии и блокчейна. Все новинки могут быть опционально укомплектованы контроллером SAS RAID/HBA. Заявлена совместимость с Windows Server 2022 SLES 12.5 и выше, RHEL7.8 и выше, Ubuntu18.04 и выше, CentOS7.6 и выше, Vmware ESXi 7.0 GA и выше. Гарантия производителя достигает пяти лет. Также «НВБС» говорит, что «не зависит от санкций, что снижает риски ограничения поставок».

17.02.2026 [13:57], Владимир Мироненко

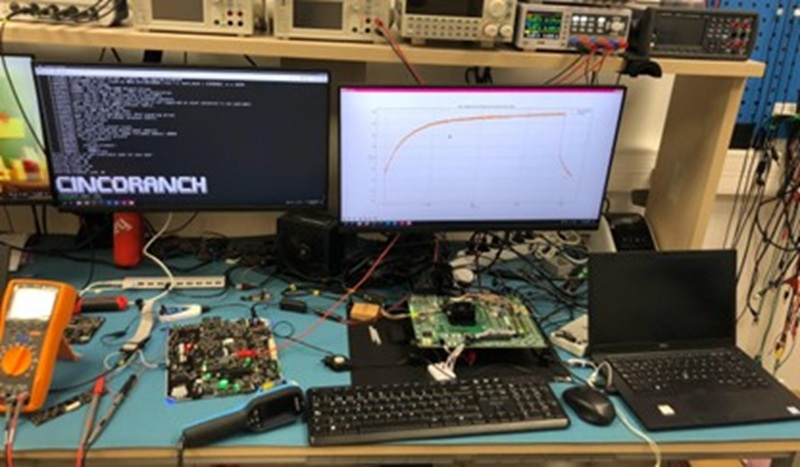

Первый европейский суверенный RISC-V-процессор Cinco Ranch изготовлен по техпроцессу Intel 3Лаборатория суперкомпьютерных вычислений (BZL) Национального центра суперкомпьютерных вычислений Барселоны (BSC-CNS) сообщила об успешном запуске тестового чипа Cinco Ranch TC1 на архитектуре RISC-V, изготовленного по передовому техпроцессу Intel 3. В заявлении отмечено, что результаты подтверждают надёжность конструкции и жизнеспособность вычислительной архитектуры на базе открытой платформы RISC-V. «Это достижение является ключевым этапом в процессе разработки чипа и качественным скачком на пути к суверенным суперкомпьютерным технологиям в Европе», — подчеркнула BZL, отметив, что готовый чип предлагает открытую, гибкую альтернативу, свободную от зависимости от проприетарных архитектур крупных транснациональных корпораций. Проект связан с Европейской инициативой по процессорам (EPI), целью которой является разработка отечественных процессоров для будущих европейских суперкомпьютеров и промышленных систем. «Успешная стабильная загрузка Linux и проверка достижения чипом ожидаемых частот подтверждают зрелость конструкции и качество работы, проделанной командами BZL», — говорит исследователь BSC и координатор аппаратной части лаборатории Zettascale в Барселоне. Cinco Ranch TC1 — это первый чип, произведенный в академической среде с использованием 3-нм техпроцесса Intel 3. На этапе проектирования, из-за невозможности прямого доступа к этой технологии, BZL провела внутренние оценки на сопоставимом техпроцессе TSMC N7, что позволило оценить конструкцию перед окончательной реализацией. Сообщается, что структура Cinco Ranch TC1 основана на трёх взаимодополняющих процессорных блоках, предназначенных для совместной работы и охвата различных вычислительных профилей. В чипе используются три блока RISC-V на одном кристалле, каждый из которых ориентировано на специализированные рабочие нагрузки. Три ядра используют микроархитектуры Sargantana, Lagarto Ka и Lagarto Ox, с основным упором на эффективность, векторные нагрузки и скалярную обработку соответственно. Подсистема CPU занимает всего 3,2 мм² на крошечном кристалле площадью 15,2 мм², который также включает высокоскоростные интерфейсы, такие как PCIe 5.0 и DDR5. Для сравнения, площадь CCD восьмиядерного процессора AMD Zen 5 составляет около 71 мм², и для этого чиплета также требуется отдельный кристалл I/O, отметил ресурс HotHardware.com.  Cinco Ranch TC1 был протестирован на оценочной плате Hawk Canyon V2, разработанной Intel для первоначальной проверки чипа после его производства. Следующим этапом станет функциональное тестирование и тестирование производительности, оптимизация ПО и полная проверка системы. В мае 2025 года на Cinco Ranch TC1 (Test Chip 1) была успешно загружена ОС Linux, а в июле 2025 года, после получения партии из 500 чипов, начались работы по характеризации и проверке. Вся партия продемонстрировала высокую функциональную производительность, при этом большинство устройств успешно запустили все три интегрированных процессора чипа. Также результаты тестов подтверждают, что Cinco Ranch TC1 работает на частоте до 1,25 ГГц, что превышает консервативные оценки, сделанные на этапе проектирования. Для BZL и её партнёров это достижение является важной вехой и доказательством того, что разработанные в Европе процессоры с открытой ISA могут быть реализованы на передовых технологиях производства и воплощены в реальных кремниевых решениях. Для Европы — это значимый шаг к технологической автономии в HPC. А для Intel это демонстрация того, что её бизнес может оказывать всестороннюю поддержку передовым внешним клиентам в сложных гетерогенных проектах.

16.02.2026 [10:11], Сергей Карасёв

Китайская Montage Technology выпустила серверные процессоры Jintide на базе Intel Xeon 6Китайская компания Montage Technology, на днях осуществившая первичное публичное размещение акций (IPO) на Гонконгской фондовой бирже, выпустила серверные процессоры Jintide следующего поколения, в основу которых положена архитектура Intel Xeon 6, доработанная под требования заказчиков в КНР. В частности, вышли изделия Jintide C6P, которые фактически представляют собой процессоры Intel Xeon 6 семейства Granite Rapids-SP на базе производительных ядер P-core. Их количество в китайских чипах достигает 86 с возможностью одновременной обработки до 172 потоков инструкций, а максимальный объем кеша L3 составляет 336 Мбайт. Реализована 8-канальная подсистема памяти DDR5 с поддержкой модулей RDIMM-6400 и MRDIMM-8000. Процессоры Jintide C6P могут применяться в одно- и двухсокетных конфигурациях. Говорится о поддержке 88 линий PCIe 5.0 и протокола CXL 2.0. Пропускная способность шины UPI достигает 24 ГТ/с. Обеспечивается полная совместимость с набором инструкций x86. Чипы ориентированы на дата-центры и облачные инфраструктуры с высокой вычислительной нагрузкой. Кроме того, дебютировали решения Jintide C6E — это модифицированные изделия Intel Xeon 6 Sierra Forest-SP с энергоэффективными ядрами E-core: их количество достигает 144. Размер кеша L3 составляет до 108 Мбайт. Процессоры имеют восемь каналов памяти DDR5-6400 и до 88 линий PCIe 5.0. Упомянута поддержка CXL 2.0 и шины UPI с пропускной способностью до 24 ГТ/с. Решения Jintide C6E могут устанавливаться в одно-и двухсокетные системы. Компания также анонсировала чип Jintide M88STAR5(N), на основе которого реализуются различные функции безопасности. Изделие, использующее технологию Mont-TSSE (Trust & Security System Extension), отвечает за аппаратное шифрование/дешифрование данных в соответствии с местными стандартами и доверенные вычисления. На кристалле присутствуют нескольких генераторов случайных чисел, а общая пропускная способность достигает 160 Гбит/с через PCIe 5.0 х8. Упомянута поддержка стандартов TPM, TCM и TPCM, а также интерфейсов SMBus, I3C, UART, SPI и GPIO. Наконец, Montage Technology представила чип Jintide M88IO3032 IOH (I/O Hub), предназначенный для использования с CPU нового поколения. Изделие обеспечивает поддержку PCIe 3.0, SATA 3.2 (до 20 портов; RAID 0/1/5/10), USB 3.2/2.0 и пр.

12.02.2026 [13:32], Сергей Карасёв

Защищённый компьютер AAEON Pico-ADN4-Semi Rev.B на базе Intel Alder Lake-N ориентирован на телеком-секторКомпания AAEON анонсировала индустриальный компьютер небольшого форм-фактора Pico-ADN4-Semi Rev.B в защищённом исполнении. Устройство рассчитано на эксплуатацию в круглосуточном режиме, в том числе на открытом воздухе. Среди ключевых сфер применения названы встраиваемые системы и телекоммуникационные инфраструктуры. В основу положена аппаратная платформа Intel Alder Lake-N. Может быть установлен чип Core i3-N305 (8C/8T; до 3,8 ГГц; 15 Вт) или Processor N97 (4C/4T; до 3,6 ГГц; 12 Вт). Есть один слот SO-DIMM с поддержкой до 16 Гбайт оперативной памяти DDR5-4800. Компьютер заключён в усиленный корпус с габаритами 140 × 100 × 43 мм, а масса составляет 0,7 кг. Используется пассивное охлаждение, при этом ребристая верхняя поверхность служит в качестве радиатора для рассеяния тепла. Диапазон рабочих температур простирается от -40 до +50 °C. Допускается монтаж на стену или на DIN-рейку. Питание подаётся через DC-разъём: диапазон входного напряжения варьируется от 9 до 36 В. В оснащение входят сетевые контроллеры 2.5GbE (Intel I226) и 1GbE (Realtek RTL8111H-CG); опционально может быть добавлен звуковой кодек Realtek ALC256. Имеется интерфейс HDMI 1.4 с возможностью вывода изображения с разрешением до 3840 × 2160 пикселей (30 Гц). Устройство получило полноразмерный слот mSATA/mPCIe и коннектор M.2 2230 E-Key (PCIe x1 + USB 2.0), что позволяет применять модули беспроводной связи. Предусмотрены два порта USB 3.1 Type-A (10 Гбит/с), два последовательных порта RS-232/422/485 и два гнезда RJ45 для сетевых кабелей. Заявлена совместимость с Windows 10/11 и Ubuntu 22.04.2 (Kernel 5.19). Упомянут также модуль TPM 2.0 для обеспечения безопасности.

11.02.2026 [12:14], Сергей Карасёв

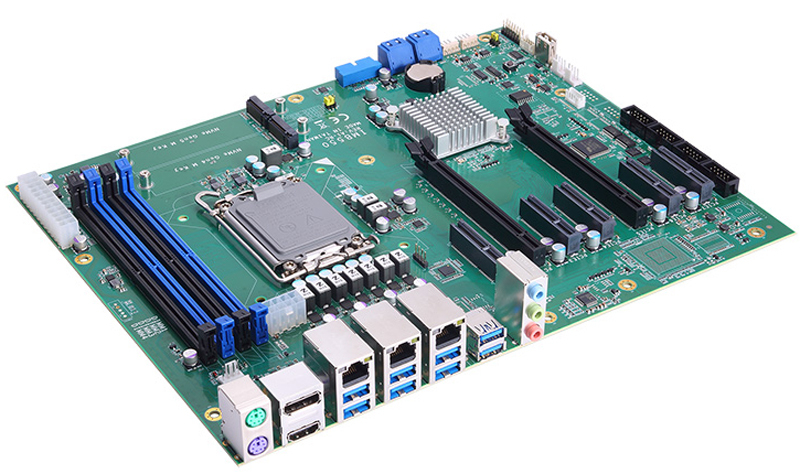

Axiomtek выпустила плату IMB550 на базе Intel Arrow Lake-S для ИИ-приложенийКомпания Axiomtek анонсировала материнскую плату IMB550 типоразмера АТХ, предназначенную для построения индустриальных серверов, встраиваемых НРС-платформ и систем, ориентированных на ИИ-нагрузки, такие как машинное зрение и анализ изображений. Новинка выполнена на наборе логики Intel W880. Допускается установка процессоров Core Ultra 9/7/5 поколения Arrow Lake-S в исполнении LGA1851 с показателем TDP до 125 Вт. Доступны четыре слота для модулей оперативной памяти DDR5-5600 ECC/non-ECC суммарным объёмом до 192 Гбайт. Накопители могут быть подключены к четырём портам SATA-3; допускается формирование массивов RAID 0/1/5/10. Кроме того, есть два коннектора M.2 Key-M 2280 для SSD с интерфейсом PCIe x4 в том числе в конфигурациях RAID 0/1.

Источник изображения: Axiomtek Плата располагает двумя слотами PCIe x16 (PCIe 5.0 x16 + PCIe x0 или PCIe 5.0 x8 + PCIe 4.0 x8) и пятью слотами PCIe x4 (3 × PCIe x4 и 2 × PCIe x2). В оснащение входят два сетевых порта 2.5GbE (на базе Intel I226-V), порт 1GbE (Intel I219-LM) и дополнительный порт 1GbE IPMI (Intel I210-AT; AST2600 — опционально). За безопасность отвечает модуль TPM 2.0. Интерфейсный блок содержит гнёзда PS/2 для клавиатуры и мыши, разъёмы HDMI 1.4b, (до 4096 × 2160 пикселей; 24 Гц) и Displayport++ (DP 1.2; до 4096 × 2304 точки; 60 Гц), по четыре порта USB 3.1 (10 Гбит/с) и USB 3.0 (5 Гбит/с), коннекторы RJ45 для сетевых кабелей и набор аудиогнёзд на 3,5 мм. Через разъёмы на плате можно задействовать до четырёх последовательных портов — по два RS-232 и RS-232/422/485. Габариты новинки составляют 305 × 244 мм. Диапазон рабочих температур простирается от 0 до +60 °C.

09.02.2026 [12:22], Сергей Карасёв

ASUS IoT представила защищённый индустриальный компьютер PE1000U на базе Intel Arrow LakeКомпания ASUS IoT, подразделение ASUS по выпуску умных устройств для интернета вещей, анонсировала индустриальный компьютер PE1000U в защищённом исполнении, предназначенный для систем машинного зрения, роботизированных платформ и пр. Устройство выполнено в корпусе повышенной прочности в соответствии со стандартами IP40 и MIL-STD-810H. Диапазон рабочих температур простирается от -25 до +70 °C. Ребристая верхняя поверхность улучшает рассеяние тепла. Габариты составляют 63 × 110 × 160 мм, масса — около 1 кг. Допускается монтаж на DIN-рейку. Применена аппаратная платформа Intel Arrow Lake. Максимальная конфигурация включает процессор Core Ultra 7 265U с 12 ядрами (2P+8E+2LPE; 14 потоков), работающими на частоте 1,7–5,3 ГГц. В состав чипа входят графический ускоритель Intel Xe и нейропроцессорный блок Intel AI Boost с производительностью 12 TOPS (INT8). Суммарное ИИ-быстродействие (CPU + GPU + NPU) достигает 24 TOPS. Доступны два слота SO-DIMM для модулей оперативной памяти DDR5 общим объёмом до 64 Гбайт. Компьютер может быть оборудован SFF-накопителем с интерфейсом SATA и SSD формата M.2 2280 с интерфейсом PCIe x4 (NVMe). Есть два сетевых порта 2.5GbE на основе Intel i226-IT, коннектор M.2 2230 E-key (CNVi, PCIe x1, USB 2.0) для комбинированного адаптера Wi-Fi 6 / Bluetooth 5.2 и слот M.2 3042/3052 B-key (PCIe x1, USB 3.0, USB 2.0 плюс Nano SIM) для сотового модема 4G/5G. Предусмотрены интерфейсы DisplayPort (до 5120 × 3200 точек; 60 Гц) и HDMI 2.0 (до 4096 × 2160 пикселей; 60 Гц), четыре порта USB 3.1 Type-A (10 Гбит/с), аудиогнёзда на 3,5 мм, два гнезда RJ45 для сетевых кабелей. Поддерживаются до четырёх последовательных портов RS-232/422/485. Питание (9–36 В) подаётся через 3-контактный DC-коннектор. Заявлена совместимость с Windows 11 IoT Enterprise.

09.02.2026 [10:09], Сергей Карасёв

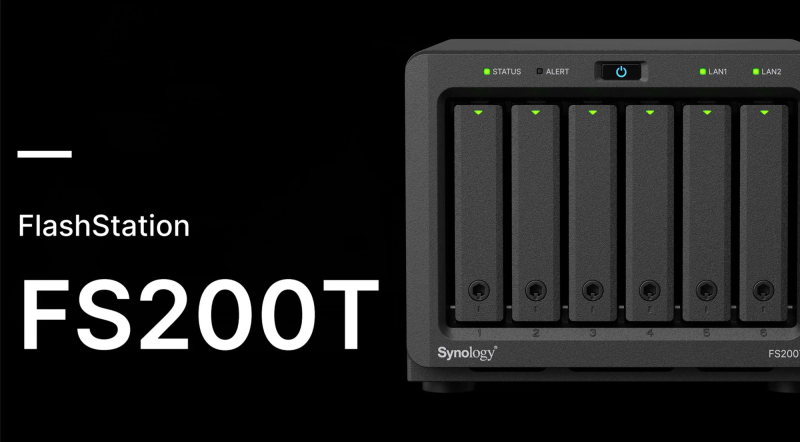

Synology готовит сетевое хранилище FS200T на шесть SATA SSDКомпания Synology, по сообщению NAS Compares, готовит к выпуску NAS в «настольном» форм-факторе FS200T на аппаратной платформе Intel. Устройство, ориентированное прежде всего на небольшие офисы, поступит в продажу во II половине текущего года. Применён процессор Celeron J4125 поколения Gemini Lake Refresh. Чип содержит четыре ядра (без многопоточности) с тактовой частотой 2,0–2,7 ГГц. Показатель TDP равен 10 Вт. Объём оперативной памяти DDR4 в базовой конфигурации составляет 4 Гбайт (без поддержки ECC), в максимальной — 8 Гбайт (два модуля SO-DIMM). Устройство располагает шестью фронтальными отсеками для SFF-накопителей с интерфейсом SATA-3 (допускается горячая замена). По имеющейся информации, могут применяться только фирменные SSD семейства Synology SAT5200 корпоративного класса: стоимость таких изделий варьируется от €160 за модель вместимостью 480 Гбайт до €1900 за вариант на 7 Тбайт. Таким образом, в максимальной конфигурации цена NAS перевалит за €11 тыс. Впрочем, как ожидается, в дальнейшем будет обеспечена поддержка накопителей сторонних производителей, что снизит общую стоимость. Хранилище оснащено одним портом 2.5GbE (RJ45) и одним портом 1GbE (RJ45), а также двумя разъёмами USB 3.2 Gen1 (5 Гбит/с). Габариты составляют 121 × 151 × 175 мм, масса — 1,4 кг. В тыльной части располагается вентилятор охлаждения диаметром 80 мм. Задействована фирменная программная платформа Synology DiskStation Manager (DSM) с набором экосистемных приложений.

09.02.2026 [09:10], Владимир Мироненко

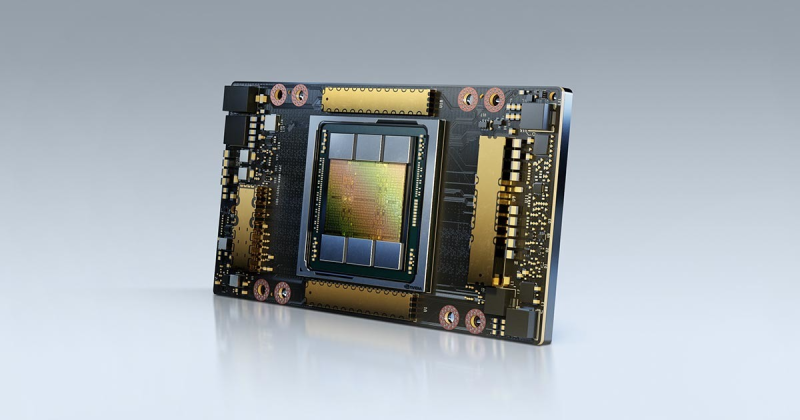

Хоть инвестиций клок: SambaNova проведёт раунд на $350 млн при поддержке IntelСтартап в сфере разработки ИИ-чипов SambaNova Systems ведёт переговоры о привлечении более $350 млн в рамках раунда финансировании серии E, сообщило агентство Reuters. Раунд возглавляет частная инвестиционная компания Vista Equity Partners, которая до этого инвестировала исключительно в компании, занимающиеся корпоративным ПО. Компания, известная крупными сделками в сфере ПО, приобрела в 2022 году компанию облачных вычислений Citrix Systems и компанию-разработчика ПО Nexthink в 2025 году. Сообщается, что это изменение может быть вызвано масштабной распродажей акций компаний-разработчиков ПО на этой неделе. По данным источников Reuters, в раунде также примут участие венчурная компания Cambium Capital и Intel. В частности, Intel, как сообщается, планирует инвестировать около $100 млн с потенциальным обязательством направить $150 млн. Оценка рыночной стоимости, которую SambaNova может получить по итогам раунда, не уточняется. Источники предупредили, что привлечение средств продолжается, и окончательные условия раунда могут измениться. Источники сообщили, что SambaNova начала искать новое финансирование в прошлом месяце после того, как переговоры о её приобретении компанией Intel зашли в тупик. В декабре появилась информация о том, что Intel предложила за SambaNova $1,6 млрд, включая долг. Это примерно треть от суммы в $5 млрд, в которую оценивалась рыночная стоимость SambaNova после последнего раунда финансирования в 2021 году, возглавляемого фондом SoftBank Vision Fund 2. С момента основания в 2017 году SambaNova привлекла более $1 млрд инвестиций и переориентировалась на разработку решений в области ИИ и облачных сервисов. С тех пор компания столкнулась с трудностями и провела сокращения персонала в 2024 году. В прошлом месяце компания сообщила сотрудникам, что превысила целевой показатель продаж за 2025 финансовый год. Рост числа клиентов SambaNova может быть одной из причин, по которой компания привлекла интерес институциональных инвесторов и Intel, допускает ресурс SiliconANGLE. В июле прошлого года SambaNova представила услугу SambaManaged, которая сокращает время развёртывания ИИ-оборудования в типовом ЦОД до 90 дней. В течение следующих шести месяцев компания заключила контракты на поставку оборудования с четырьмя различными операторами ЦОД. В рамках одного из контрактов SambaNova будет поставлять чипы для суверенного облачного кампуса в Шотландии с запланированной мощностью более 2 ГВт. Флагманский продукт SambaNova — ИИ-ускоритель для инференса SN40L, содержащий 1040 ядер, изготовленных с использованием 5-нм техпроцесса TSMC, имеет производительность 638 Тфлопс в режиме BF16. Компания поставляет чипы в составе системы SambaStack с воздушным охлаждением, которая содержит 16 ускорителей SN40L, а также включает в себя сетевое оборудование и компоненты управления питанием. SambaStack позволяет запускать ИИ-модели с до 5 трлн параметров.

07.02.2026 [17:23], Руслан Авдеев

AWS: ни один сервер с NVIDIA A100 не выведен из эксплуатации, а некоторые клиенты всё ещё используют Intel Haswell — не всем нужен ИИПо словам главы AWS Мэтта Гармана (Matt Garman), клиенты до сих пор использует серверы на основе ИИ-ускорителей NVIDIA A100, представленных в 2020 году. Отчасти это происходит потому, что спрос на вычислительные ресурсы превышает предложение, так что устаревшие чипы по-прежнему востребованы, передаёт Datacenter Dynamics. По словам Гармана, все ресурсы фактически распроданы, а серверы с A100 из эксплуатации никогда не выводились. Комментарии Гармана перекликаются с прошлогодним заявлением Амина Вахдата (Amin Vahdat), отвечающего в Google за ИИ и инфраструктуру. По его словам, в Google одновременно работают семь поколений тензорных ускорителей (TPU). Ускорители возрастом семь-восемь лет загружены на 100 %, а спрос на TPU так высок, что Google вынуждена отказывать некоторым клиентам. Впрочем, оба топ-менеджера, возможно, несколько кривят душой и пытаются развеять опасения инвесторов относительно того, что ИИ-ускорители, на которые тратятся огромные деньги, через два-три года придётся выкинуть, чтобы купить более современные, энергоэффективные и, конечно же, дорогие. И что за это время они не успеют окупиться. Хотя Гарман назвал главной причиной сохранения работы серверов на A100 высокий спрос, он признал, что есть и другие причины. В частности, современные ИИ-чипы снижают точность вычислений с плавающей запятой. В результате некоторые клиенты попросту не могут перейти на Blackwell или вовсе вынуждены использовать Intel Xeon Haswell десятилетней давности для HPC-подобных вычислений, поскольку точности у современных ИИ-ускорителей недостаточно. В июне 2025 года AWS заявила о снижении цены доступа к устаревшим NVIDIA H100, H200 и A100 на своей платформе, причём для A100 стоимость снизилась на треть.

Источник изображения: NVIDIA Стоит отметить, что «устаревшие» ускорители долго остаются востребованными, поскольку всё равно обладают большой производительностью. Наиболее яркий пример — разрешение на поставку в Китай чипов NVIDIA H200. Хотя США и их союзники готовятся к внедрению ускорителей поколения Vera Rubin, китайский бизнес готов покупать H200, поскольку те значительно производительнее, экономически выгоднее и удобнее отечественных ускорителей.

04.02.2026 [18:37], Сергей Карасёв

«Рикор» выпустил российские 2U-серверы на базе Intel Xeon Emerald RapidsКомпания «Рикор» анонсировала российские серверы Rikor 7212DSP5 и Rikor 7225DSP5, построенные на аппаратной платформе Intel Xeon Emerald Rapids. Устройства, как утверждается, подходят для решения широко спектра задач, включая виртуализацию, гиперконвергентную инфраструктуру, облачные сервисы, анализ данных, машинное обучение и приложения ИИ. Новинки выполнены в форм-факторе 2U. Допускается установка двух процессоров Xeon и 32 модулей оперативной памяти DDR5 суммарным объёмом до 8 Тбайт. Реализована поддержка интерфейса PCIe 5.0. Серверы различаются конфигурацией подсистемы хранения данных: модель Rikor 7212DSP5 рассчитана на 12 накопителей с доступом через фронтальную панель, а модификация Rikor 7225DSP5 — на 25. Прочие технические характеристики пока не раскрываются. Одним из ключевых преимуществ решений производитель называет использование корпусов собственной разработки. Это, как утверждается, обеспечивает контроль качества металла и сборки, а также ускоряет процесс выпуска систем. Кроме того, «Рикор» может предлагать заказчикам уникальные решения по оптимизации внутреннего пространства. В результате, клиенты получают «более гибкие, технологичные и экономически выгодные серверы, наиболее полно соответствующие требованиям по локализации и технологической независимости». Производство серверов осуществляется на роботизированном заводе. «Рикор» уже принимает заказы на новые модели, а их отгрузки начнутся в ближайшее время. Компания гарантирует стабильность поставок. |

|