Материалы по тегу: сжо

|

01.12.2025 [09:15], Руслан Авдеев

Японская Daikin намерена утроить продажи систем охлаждения ЦОД в Северной Америке, надеясь на гиперскейлеров и ИИ-бумЯпонская Daikin Industries рассчитывает утроить продажи охлаждающего оборудования для ЦОД в Северной Америке на фоне бума ИИ-технологий — до более чем ¥300 млрд ($1,92 млрд) к 2030 финансовому году, сообщает Nikkei Asian Review. Сейчас Daikin скупает технологии охлаждения американских компаний и намерена учредить отдельную штаб-квартиру для североамериканского рынка в 2026 финансовом году. Основная цель — работа со всеми гиперскейлерами. По оценкам Daikin, на Северную Америку приходится 40 % мирового рынка решений для охлаждения ЦОД, и её доля, вероятно, продолжит расти. Ключевыми заказчиками являются гиперскейлеры, и Daikin уже работает с Google и Amazon. Крупные HVAC-системы нередко приобретаются для нескольких зданий одновременно, так что объёмы единовременных продаж обычно составляют десятки миллионов долларов. Доля Daikin на североамериканском рынке, по её собственным оценкам, составляет около 12 %. Она занимает третье место в своём сегменте. К 2030 году компания намерена довести долю до 30 %. Конкуренцию ей составит как минимум LG, которая будет поставлять свои системы охлаждения для ИИ ЦОД Microsoft. В 2007 году Daikin купила малайзийскую OYL Industries, которая владела американским производителем кондиционеров McQuay International (бренд Applied). В 2023 году за ¥30 млрд ($192 млн) она купила американскую Alliance Air Products, специалиста по оборудованию для обработки воздуха. В августе того же года она приобрела американскую же Dynamic Data Centers Solutions, разрабатывавшую технологию индивидуального охлаждения стоек. Наконец, в ноябре компания купила американский стартап Chilldyne, специализирующийся на СЖО. Массовое производство систем воздушного и жидкостного охлаждения для серверов начнётся весной следующего года. По прогнозам Daikin, приблизительно 70 % рынка к 2030 году будет приходиться на системы воздушного охлаждения и около 30 % — на СЖО. Daikin намерена предлагать оптимальные комбинации этих методов для операторов ЦОД и отраслевых подрядчиков. Дополнительно она предлагает и системы контроля охлаждения. Также компания сообщает, что намерена создать в США хаб по выпуску решений для ЦОД в 2026 фискальном году для контроля над североамериканским рынком. По данным индийской Fortune Business Insights, мировой рынок систем охлаждения для ЦОД должен вырасти более чем вдвое с 2024 по 2032 гг. до $42,4 млрд. Впрочем, гиперскейлеры работают над собственными решениями, которые позволят обрести им «суверенитет» от независимых вендоров. Например, собственную СЖО всего за 11 месяцев разработала и запустила в производство AWS. А Meta✴ пришлось пойти на ухищрения, чтобы обойтись воздушным охлаждением ИИ-стоек.

24.11.2025 [10:17], Руслан Авдеев

Перекрыть потоки: NVIDIA усиливает контроль над цепочкой поставок СЖО для Vera Rubin

cooler master

delta electronics

foxconn

hardware

nvidia

odm

qct

vr200

wistron

водоблок

ии

производство

сжо

NVIDIA намерена серьёзно изменить управление цепочкой поставок для серверной платформы новейшего поколения Vera Rubin. Она ужесточает контроль над сборкой и поставкой ключевых компонентов систем охлаждения, что связано с ростом энергопотребления и обязательным применением СЖО, сообщает DigiTimes. Это ещё один шаг в процессе усиления контроля над выпуском ИИ-платформ. NVIDIA уже давно внимательно следит за цепочками поставок для ускорителей и плат, но теперь намерена перейти на новый уровень. Источники сообщают, что компания намерена отобрать четырёх поставщиков водоблоков, перейти к координации производства и централизованным закупкам. Предполагается, что это будут Cooler Master, Asia Vital Components (AVC), Auras Technology и Delta Electronics. Ранее СЖО для NVIDIA занимались, в основном, Cooler Master, AVC и некоторые другие поставщики. Ожидается, что для Vera Rubin вместо поставки лишь отдельных компонентов (L6), NVIDIA будет участвовать в процессе и на более позднем этапе (L10), взяв ответственность за интеграцию и сборку готовых серверных шкафов. В целом окончательную сборку поручат Foxconn, Wistron и Quanta. Из-за необходимости быстрого выпуска продукции на поставщиков легла дополнительная нагрузка. Некоторые из них в частном порядке жалуются, что NVIDIA настаивает на запуске массового производства ещё до утверждения окончательного дизайна платформ, а новое поколение платформ часто появляется до того, как предыдущее достигло стабильного уровня производства и качества. Централизованные закупки помогут NVIDIA оптимизировать поставки и контролировать качество, но рентабельность работы поставщиков может пострадать, поскольку NVIDIA сама будет управлять спросом и торговаться по поводу цен. При этом отказ от подобных условий практически невозможен, учитывая доминирующее положение компании на рынке ИИ-инфраструктуры. В результате снижается самостоятельность как ODM, так и облачных провайдеров. Из-за этого же, как считается, во многом замедлено и развитие погружных СЖО — NVIDIA попросту не готова сертифицировать такие системы. Эксперты всё чаще говорят о росте напряжённости, которая со временем приведёт к открытому конфликту. Новый подход NVIDIA, вероятно, повлияет на цепочку поставок двумя путями. Во-первых, контракты на сборку консолидируются вокруг небольшого пула производителей, а выпуск водоблоков сконцентрируется в руках трёх-четырёх компаний. Облачным провайдерам, вероятно, тоже придётся идти на поводу NVIDIA при размещении крупных оптовых заказов, хотя они как раз предпочитают создавать собственные СЖО, что в целом тоже негативно влияет на некоторых игроков. Во-вторых, рост объёмов поставок не гарантирует роста рентабельности. Поставщики предполагают, что цена за единицу продукции в рамках попыток NVIDIA сконцентрировать производителей уменьшится, а более жёсткий контроль над проектированием снизит и стратегическую ценность индивидуальных разработок. Компании уже шутят, что статус крупнейшего поставщика NVIDIA может буквально навредить, поскольку по мере роста объёмов обычно растут и дисконты. Ожидается, что стойки поколения Vera Rubin обеспечат значительно более высокую плотность вычислений, чем уже доступные платформы GB200 и GB300, а для традиционного воздушного охлаждения места уже не останется. В отрасли ожидают, что Vera Rubin представят во II половине 2026 года. Платформа представляет собой важный шаг к созданию ИИ-инфраструктуры с полностью жидкостным охлаждением. Новейшая стратегия NVIDIA, касающаяся цепочек поставок, свидетельствует о решимости компании усилить прямой контроль качества, поставок и их стоимости по мере роста плотности мощности. В JPMorgan утверждают, что NVIDIA станет напрямую поставлять системы L10. Компания унифицирует конструкцию и заставит подрядчиков строго придерживаться предлагаемых чертежей и дизайна без использования проприетарных архитектур, созданных самими подрядчиками. Для NVIDIA это выгодно, поскольку позволяет значительно ускорить отгрузки и кратно сократить сроки развёртывания ИИ-инфраструктур (до 3 мес. вместо 9 мес.), опираясь на единые стандарты — от одного узла до целой ИИ-фабрики. При этом AWS, вероятно, придётся тяжелее всех, поскольку она пытается снизить зависимость от NVIDIA и в то же время не является активным сторонником OCP.

17.11.2025 [10:14], Руслан Авдеев

Vertiv представила иммерсионные СЖО CoolCenter Immersion на 25–240 кВтVertiv объявила о выпуске системы погружного охлаждения CoolCenter Immersion. Иммерсионная СЖО обеспечивает поддерживает отвод от 25 кВт до 240 кВт на модуль ёмкостью 24U до 52U, обеспечивая при этом PUE на уровне 1,08. По словам компания, иммерсионное охлаждение играет всё более важную роль из-за повсеместного внедрения HPC- и ИИ-платформ. В Vertiv CoolCenter Immersion применяется многолетний опыт, полученный Vertiv в сфере СЖО для создания спроектированных «под ключ» систем, безопасно и эффективно справляющихся с высокоплотными системами. Операторы ЦОД смогут практично масштабировать ИИ-инфраструктуру без ущерба надёжности и удобству обслуживания. Каждая система включает внутренний или внешний резервуар для теплоносителя, блок распределения жидкости (CDU), датчики температуры, а также насосы с регулируемой скоростью работы и трубки. Модуль включает два источника питания и резервные насосы, а также встроенные датчики мониторинга состояния и 9″ сенсорный дисплей. Предусмотрена возможность подключения к системе управления зданием (BMS). Тепло отводится через пластинчатый теплообменник во внешний водяной контур. Vertiv уже заключила контракт с Digital Realty в Италии на поставку электроэнергии и систем охлаждения для римского объекта Digital ROM1 мощностью 3 МВт. Запуск ЦОД запланирован на 2027 год. На объекте будет использоваться фрикулинг и система охлаждения, готовая к ИИ-нагрузкам, передаёт DataCenter Dynamics. Сделка стала ещё одной в череде европейских проектов Digital Realty в Париже, Мадриде, Амстердаме и др.

Источник изображения: Vertiv В Digital Realty подчеркнули, что Рим становится важнейшим шлюзом для цифровой инфраструктуры между Европой и Средиземноморским регионом. Передовые технологии для ROM1 помогут стать дата-центру стратегическим ИИ-хабом, задающим новые стандарты энергоэффективности и производительности в сфере HPC. Также Vertiv работает с Nextra в Африке и намерена сотрудничать с Ezditek для создания ЦОД в Саудовской Аравии. Ранее сообщалось, что нежелание NVIDIA сертифицировать иммерсионные СЖО во многом тормозит их развитие. Прямое жидкостное охлаждение (DLC) менее эффективно, чем иммерсионные системы, но NVIDIA всё ещё считает, что пока достаточно этого. Впрочем, эксперты прогнозируют, что настоящий расцвет технологии придётся на 2027–2028 гг. Ожидается, что она будут активно распространяться после выхода ускорителей NVIDIA Rubin Ultra.

07.11.2025 [13:51], Сергей Карасёв

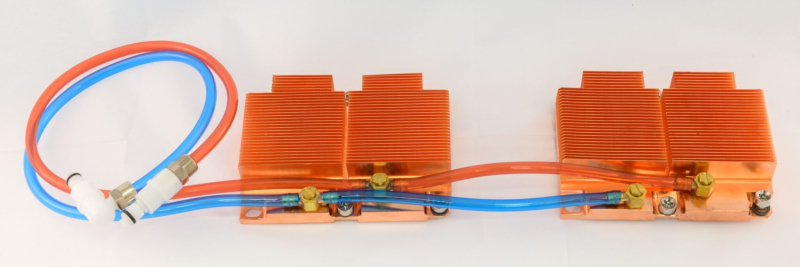

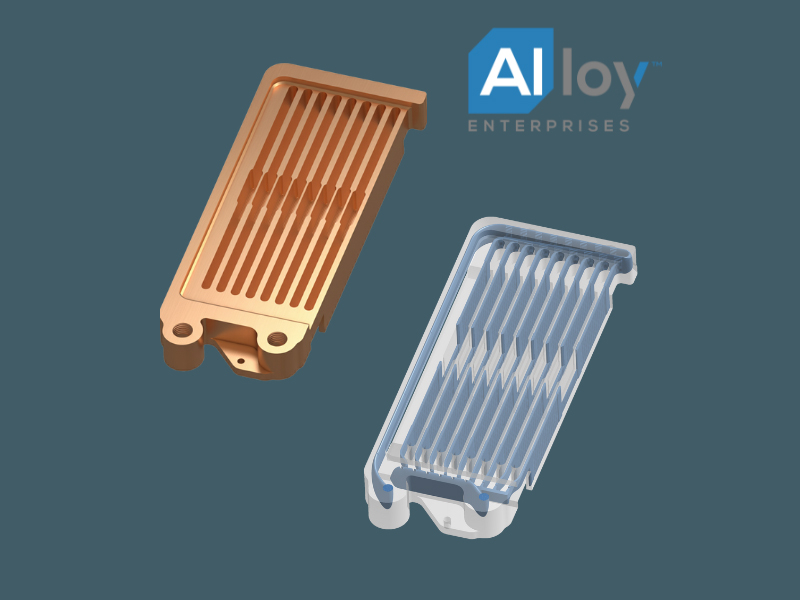

Alloy Enterprises представила водоблоки СЖО для всех компонентов blade-серверовКомпания Alloy Enterprises анонсировала цельные охлаждающие модули с защитой от протечек, обеспечивающие возможность прямого жидкостного охлаждения (DLC) всех компонентов в составе blade-серверов, включая оперативную память, сетевые адаптеры и оптические элементы QSFP. Alloy Enterprises отмечает, что на фоне стремительного развития ИИ и НРС меняется архитектура серверов, а следовательно, и тепловой баланс высокопроизводительных систем. Исторически на GPU-ускорители приходилось около 80 % от всего энергопотребления blade-узлов, тогда как оставшиеся 20 % сообща расходовали модули DIMM, сетевые карты, QSFP-корзины и другие компоненты, которые могли довольствоваться воздушным охлаждением. При этом в традиционных HPC-платформах 100-% жидкостное охлаждение компонентов уже давно не редкость.

Источник изображения: Alloy Enterprises Энергопотребление современной стойки NVIDIA GB200 NVL72 составляет 120–140 кВт в номинальном режиме. При этом на периферийные устройства приходится 24–28 кВт, что пока укладывается в возможности воздушного охлаждения. Однако в будущих системах класса 600 кВт, таких как платформа NVIDIA Kyber, только периферийным компонентам потребуется до 100 кВт энергии, а поэтому воздушного охлаждения окажется недостаточно. В результате, потребуются качественно новые решения, в том числе на основе DLC. Новые охлаждающие модули Alloy Enterprises выполнены с использованием запатентованной технологии Stack Forging. Они сочетают особую внутреннюю микрогеометрию с монолитной конструкцией, благодаря чему обеспечивается эффективное охлаждение под высоким давлением без утечек. Изделия рассчитаны на давление до 138 бар без деформации, что позволяет сохранять структурную целостность в экстремальных условиях. Alloy Enterprises говорит о возможности оптимизации отвода тепла для каждого периферийного устройства. Изделия для оперативной памяти поддерживают двустороннее охлаждение модулей DIMM мощностью свыше 40 Вт, что соответствует спецификациям JEDEC следующего поколения. Возможна замена без слива жидкости из охлаждающего контура. Для оптических модулей 800G и 1,6T допускается отвод до 50 Вт/порт. В случае сетевых адаптеров низкопрофильные монолитные пластины обеспечивают равномерное охлаждение и механическую стабильность, говорит компания.

07.11.2025 [12:17], Сергей Карасёв

Sugon ScaleX640 — первая в мире стоечная система с 640 ИИ-ускорителямиКитайская компания Sugon (Dawning Information Industry), специализирующаяся на разработке суперкомпьютеров, серверов и СХД, представила ИИ-систему ScaleX640. Это, как утверждается, первое в мире решение в виде одной стойки, допускающее использование до 640 ускорителей. Суперускоритель выполнен на «сверхскоростной ортогональной архитектуре». Используются вычислительные узлы высокой плотности, которые допускают установку ИИ-карт различных производителей. Говорится о совместимости с существующей экосистемой ПО для задач ИИ. Платформа ScaleX640 предусматривает применение иммерсионного жидкостного охлаждения с фазовым переходом и высоковольтных источников питания постоянного тока (DC). СЖО способна отвести до 1,72 МВт. По заявлениям Sugon, по плотности вычислений новинка до 20 раз превосходит другие суперузлы, доступные на рынке. При этом обеспечивается высокий показатель эффективности использования электроэнергии (PUE) — 1,04. Два суперузла ScaleX640 могут формировать вычислительный блок с поддержкой 1280 ускорителей ИИ. Стойки соединяются между собой посредством высокоскоростной сети. В целом, возможно развёртывание кластеров, насчитывающих до 100 тыс. ИИ-карт. Sugon утверждает, что по сравнению с традиционными платформами новая система обеспечивает повышение производительности на 30–40 % в сценариях обучения больших языковых моделей (LLM) с триллионами параметров и инференса. Проведённое всестороннее тестирование ScaleX640 говорит о высокой надёжности и стабильности работы комплекса.

06.11.2025 [17:12], Руслан Авдеев

Daikin Applied купила разработчика необычных СЖО с отрицательным давлением ChilldyneDaikin Applied Americas сообщила о покупке компании Chilldyne — лидера в сфере СЖО с отрицательным давлением, применяемых в HCP/ИИ-платформах. Покупка поможет пополнить существующее портфолио Applied для дата-центров, поддерживая миссию компании по предоставлению комплексных решений для охлаждения, отвечающих требованиям гиперскейлеров для дата-центров следующего поколения. Сделка позволит Chilldyne быстро расширить присутствие на рынке. Как заявляют в Daikin Applied Materials, покупая Chilldyne, компания стремится удовлетворить меняющиеся потребности клиентов и задать новый стандарт при обеспечении производительности и работы без сбоев. Утверждается, что системы компании с отрицательным давлением в контуре выгоднее экономически и надёжнее в сравнении с традиционными системами для ЦОД с положительным давлением. Проще говоря, в случае повреждения контура СЖО Chilldyne Cool-Flo охлаждающая жидкость будет из него высосана, что снизит риск повреждения оборудования, вероятность незапланированных простоев и стомость обслуживания. Покупка Chilldyne стала поворотным моментом в реализации более широкой стратегии Daikin Applied по созданию всеобъемлющей экосистемы решений для охлаждения для ЦОД гиперскейл-уровня. Chilldyne и DDC Solutions, купленная Daikin Applied в августе 2025 года, позволяет интегрировать СЖО Chilldyne с модульными охлаждающими шкафами DDC. Вместе они обеспечат высокоэффективные и надёжные решения для стоек высокой плотности. Это уже третья по счёту сделка в области СЖО для ЦОД за последние недели. Так, на днях появилась новость, что Vertiv купит за $1 млрд поставщика сервисов для СЖО и HVAC PurgeRite, а Eaton поглотит Boyd Thermal, чтобы пополнить портфолио решений для ИИ ЦОД передовыми СЖО.

06.11.2025 [08:46], Руслан Авдеев

Vertiv купит за $1 млрд поставщика сервисов для СЖО и HVAC PurgeRiteVertiv Holdings объявила о покупке Purge Rite Intermediate (PurgeRite) — ведущего в США провайдера сервисов промывки, продувки и очистки HVAC и иных систем для ЦОД и других критических важных объектов. Компанию купят у Milton Street Capital приблизительно за $1 млрд наличными. Ещё до $250 млн будет выплачено в случае достижения Purge Rite определённых финансовых показателей в 2026 году. Цена покупки вдесятеро выше прогнозируемой прибыли по EBITDA за 2026 год. Ожидается, что покупка будет способствовать росту рентабельности сервисного направления Vertiv. Ожидается, что PurgeRite будет способствовать развитию возможностей Vertiv и укрепит позиции компании в качестве мирового лидера в области терморегулирования и жидкостного охлаждения. Основная цель — рынок СЖО для ИИ ЦОД. Поскольку HPC- и ИИ-фабрики будущего требуют все большей энергетической плотности, крайне важно развивать и поддерживать частоту контуров циркуляции охлаждающих жидкостей. Управление жидкостями, включая экспресс-промывку контуров для удаления засоров, продувку, удаление воздуха и иных газов, а также и заполнение чистой жидкостью — важнейший сервис, обеспечивающий работу высокоплотных ЦОД. У PurgeRite имеется инженерный опыт, собственные технологии и возможности масштабирования для обеспечения комплексного жидкостного охлаждения ЦОД по всей цепочке — от чиллеров до CDU. Благодаря прочным связям с гиперскейлерами и другими компаниями отрасли, PurgeRite, по её же словам, стала лидером в области сервисного обслуживания. После закрытия сделки активы PurgeRite объединят с существующими сервисами Vertiv, связанными с СЖО. Это обеспечит комплексные решения по управлению температурой «под ключ» — от объекта до помещения, от ряда до стойки. Ожидается, что сделка будет закрыта с IV квартале 2025 года. В это же время Eaton объявила о покупке за $9,5 млрд Boyd Thermal, одного из мировых лидеров в производстве компонентов для терморегулирования критически важных объектов, в том числе ЦОД. А Daikin Applied Americas, поставщик HVAC-решений, объявила о покупке разработчика СЖО Chilldyne. В августе она также купила поставщика стоек для HPC/ИИ-систем DDC Solutions.

05.11.2025 [14:42], Руслан Авдеев

Eaton поглотит Boyd Thermal и пополнит портфолио решений для ИИ ЦОД передовыми СЖОEaton объявила о покупке бизнеса Boyd Thermal компании Boyd Corporation, принадлежащей Goldman Sachs Asset Management. Boyd Thermal является одним из мировых лидеров в производстве компонентов для терморегулирования, систем и защищённых решений для ЦОД, аэрокосмической отрасли и других рынков, сообщает пресс-служба Eaton. Eaton обязалась заплатить $9,5 млрд за новый актив — это в 22,5 раза выше предполагаемой скорректированной прибыли EBITDA Boyd Thermal за 2026 год. Объём продаж Boyd Thermal в 2026 году прогнозируется на уровне $1,7 млрд, из которых $1,5 млрд придётся на жидкостное охлаждение. В Eaton подчеркнули, что объединение передовых технологий Boyd с глобальной сервисной моделью, существующими продуктами и масштабом Eaton обеспечит дополнительные преимущества для клиентов. В частности, объединённый опыт в области электропитания и жидкостного охлаждения позволит заказчикам быстрее удовлетворять растущие потребности в обеих областях. В Boyd заявили, что «с нетерпением» ждут объединения с Eaton, поскольку совместная продуктовая линейка позволит предлагать клиентам инновации, отвечающие требованиям ИИ ЦОД.

Источник изображения: Eaton Boyd Thermal — компания со штаб-квартирой в США, штатом более 5 тыс. сотрудников и производственными площадками в Северной Америке, Азии и Европе. Она начинала с поставок систем терморегулирования для аэрокосмической отрасли, а сегодня обслуживает рынки ЦОД, промышленности и др. В Eaton ожидают, что Boyd Thermal увеличит скорректированную прибыль на второй год после закрытия сделки. Завершение сделки запланировано на II квартал 2026 года. Eaton основана в 1911 году, специализируется на интеллектуальном управлении электроэнергией и выпускает продукцию для дата-центров, коммунальных компаний, промышленности, жилищного строительства, рынка мобильных технологий и других сфер. В 2024 году выручка компании составила почти $25 млрд — она обслуживает клиентов более чем в 160 странах. После завершения сделки бизнес Boyd по выпуску высокотехнологичных материалов продолжит действовать как независимая компания под брендом Boyd Corporation при поддержке Goldman Sachs Alternatives. Как сообщает Datacenter Dynamics, в июле 2025 года компания представила CDU-систему охлаждения, способную отводить 2,3 МВт тепла, что позволяет охлаждать более десяти стоек NVIDIA GB200 NVL72. В середине октября OCP запустила инициативу Open Data Center for AI для стандартизации инфраструктуры передовых ИИ ЦОД с мегаваттными стойками. Это может сказаться на многих отраслях, связанных с инфраструктурой дата-центров.

14.10.2025 [02:00], Сергей Карасёв

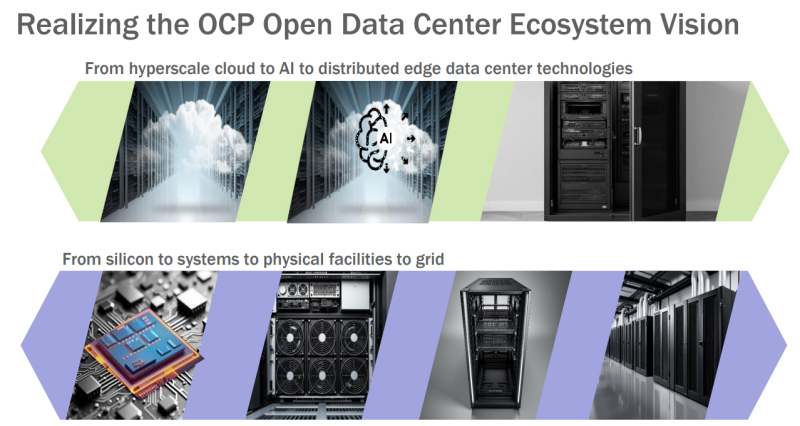

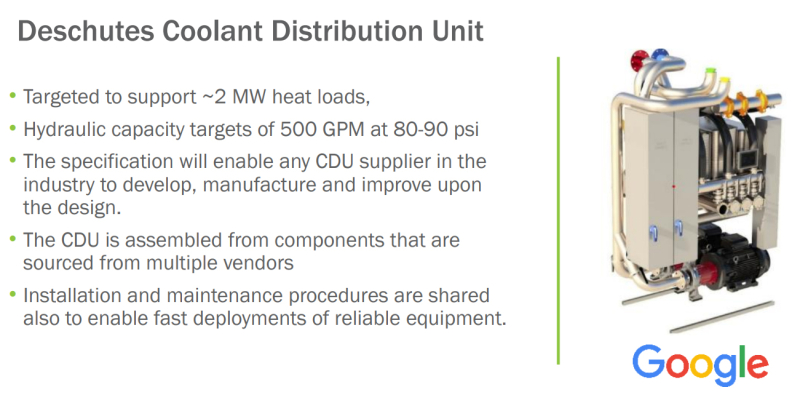

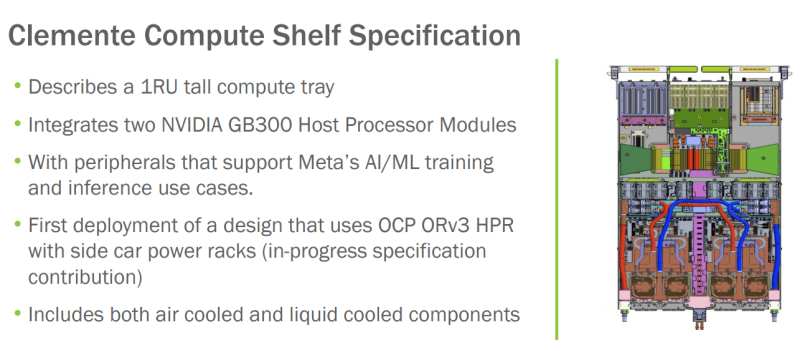

OCP запустила инициативу Open Data Center for AI для стандартизации инфраструктуры передовых ИИ ЦОД с мегаваттными стойкамиНекоммерческая организация Open Compute Project Foundation (OCP) анонсировала инициативу Open Data Center for AI по стандартизации компонентов физической инфраструктуры дата-центров, ориентированных на задачи ИИ и другие ресурсоёмкие нагрузки. Проект Open Data Center for AI является частью программы OCP Open Systems for AI, которая была представлена в январе 2024 года при участии Intel, Microsoft, Google, Meta✴, NVIDIA, AMD, Arm, Ampere, Samsung, Seagate, SuperMicro, Dell и Broadcom. Цель заключается в разработке открытых стандартов для кластеров ИИ и ЦОД, в которых размещаются такие системы. Запуск Open Data Center for AI продиктован быстрым развитием экосистемы дата-центров, результатами, полученными в рамках OCP Open Systems for AI, и новым открытым письмом о сотрудничестве, подготовленным Google, Meta✴ и Microsoft. В настоящее время, как отмечается, отрасль ЦОД сталкивается с проблемами, связанными с тем, что разрозненные усилия её участников, включая гиперскейлеров и колокейшн-провайдеров, порождают различные требования к проектированию инфраструктуры. Это замедляет внедрение инноваций и увеличивает сроки развёртывания передовых площадок. Цель Open Data Center for AI заключается в том, чтобы стандартизовать требования к системам электропитания, охлаждения и телеметрии, а также к механическим компонентам в ЦОД. Предполагается, что это обеспечит взаимозаменяемость элементов физической инфраструктуры дата-центров. При реализации инициативы Open Data Center for AI планируется использовать уже имеющиеся наработки сообщества OCP в области блоков распределения охлаждающей жидкости (CDU) и блоков распределения питания (PDU). Это, в частности, проект Mt. Diablo, который реализуется Meta✴, Microsoft и Google. Он предполагает создание общих стандартов электрических и механических интерфейсов. Идея заключается в разделении стойки на независимые шкафы для компонентов подсистемы питания и вычислительного оборудования. При этом планируется переход от единой шины питания постоянного тока с напряжением 48 В на архитектуру 400 В DC (Diablo 400). Ещё одним проектом, наработки которого пригодятся в рамках Open Data Center for AI, назван CDU Deschutes, разработанный Google. Это решение с резервными теплообменниками и насосами обеспечивает уровень доступности 99,999 %. Система Deschutes рассчитана на тепловые нагрузки до 2 МВт. Открытая спецификация позволит любой компании совершенствовать конструкцию CDU и производить изделия данного типа. Наконец, упоминаются серверные шасси Clemente, разработанные в Meta✴. Это узлы 1U, содержащие два суперчипа NVIDIA Grace Blackwell GB300 для ресурсоёмких ИИ-нагрузок. Платформа предполагает применение жидкостного охлаждения для CPU, GPU и коммутатора, а также воздушного охлаждения для других компонентов.

03.10.2025 [17:24], Руслан Авдеев

UKPN начнёт отапливать дома британских малоимущих кластерами из сотен Raspberry Pi

hardware

raspberry pi

великобритания

кластер

микро-цод

облако

отопление

периферийные вычисления

погружное охлаждение

сжо

экология

Британская UK Power Networks (UKPN) в рамках программы SHIELD (Smart Heat and Intelligent Energy in Low-income Districts) начала устанавливать микро-ЦОД на базе одноплатных компьютеров Raspberry Pi — для отопления домохозяйств, нуждающихся в деньгах для оплаты коммунальных услуг, сообщает The Register. Выбранные домохозяйства оснастят солнечными элементами питания и аккумуляторными системами, треть из них получит и систему HeatHub — сверхкомпактный ЦОД размером с большой тепловой насос, который заменит традиционные газовые котлы. Полученные в рамках пробного развёртывания данные используют для масштабирования SHIELD, к 2030 году UKPN намерена ежегодно развёртывать 100 тыс. систем. Платформа HeatHub разработана компанией Thermify. Она предназначена для запуска облачных контейнеризированных нагрузок. Каждый HeatHub включает до 500 модулей Raspberry Pi CM4 или CM5, погружённых в масло. Полученное тепло передаётся в системы отопления и горячего водоснабжения, а сам HeatHub легко установить вместо бойлера. HeatHub имеет собственное выделенное интернет-подключение. Над внедрением «низкоуглеродных» технологий SHIELD компания UKPN сотрудничает с Power Circle Projects, жилищной ассоциацией Eastlight Community Homes и Essex Community Energy. Также она участвует над установлением нового социального тарифа на отопление на востоке и юго-востоке Англии. Малоимущие клиенты будут платить фиксированную ставку в £5,60 ($7,52) ежемесячно, а SHIELD поможет им сократить счета за электричество на 20–40 %. Куратор SHIELD со стороны Eastlight Community Homes заявил, что результаты пилотного проекта обнадёживают, его планируют опробовать ещё в сотнях домов. Это поможет семьям поддерживать комфортные условия проживания, не беспокоясь о росте цен на энергию. Для обычных пользователей у Thermify иные условия — модуль для типового дома с тремя спальнями обойдётся в £2500 ($3365), ещё £500 ($673) возьмут за установку, а за отопление будут брать £50/мес. ($67/мес.). В особых случаях плата может быть снижена вдвое, а в экстремальных ситуациях тепло будет предоставляться бесплатно. Это уже не первый проект подобного рода. Так, Heata — изначально принадлежавшая British Gas, предлагает использовать серверы в качестве домашних водонагревателей, что позволяет сократить расходы на электричество для домовладельцев. Тепло вырабатывается за счёт рабочих нагрузок облачного оператора Civo. Также пару лет назад начала работать британская Deep Green — она обеспечивает теплом предприятия и бассейны с помощью мини-ЦОД, размещаемых на их территории. |

|