Материалы по тегу: сервер

|

22.02.2026 [15:58], Владимир Мироненко

Российский бизнес распробовал ИИ: рынок ИИ-серверов достиг 60 млрд рублейВ 2025 году в России на закупку ИИ-серверов компании потратили около 60 млрд руб., без учёта аренды вычислительных мощностей, обслуживания и модернизации сообщил коммерческий директор YADRO (входит в «ИКС холдинг») Александр Бакулин на цифровом форуме «Инфраструктурные вызовы для развития ИИ в России» в рамках Недели российского бизнеса, о чём пишут «Ведомости». Он добавил, что рынок находится «в стадии перелома» — за последние два года ИИ перестал быть «надстройкой» над IT-инфраструктурой, а стал менять правила проектирования вычислительных систем. Формируется новая инфраструктурная ниша, сравнимая с энергетикой и телекоммуникациями. Ключевые заказчики переходят от экспериментов к промышленной эксплуатации, начинают встраивать решение машинного обучения больших языковых моделей в свои бизнес-процессы и планы. И при этом на ИИ наблюдается большой спрос, сообщил Бакулин. По словам Бакулина, мировой рынок ИИ-серверов, который во многом формируют облачные провайдеры и крупные технологические компании, оценивается в сотни миллиардов долларов, демонстрируя устойчивую высокую динамику. Как и на мировом рынке основной спрос в России формируют крупные компании, работающие с большими массивами данных и развивающие собственные языковые модели, например крупные игроки e-commerce, финтеха и интернет-сервисов. Ранее «АТК консалтинг» сообщила, что закупки программных продуктов с ИИ в 2025 выросли год к году в 7,4 раза до 1,8 млрд руб. Как отметили тогда «Ведомости», рынок «железа» для ИИ в деньгах вырос значительно больше. В частности, это связано с подорожанием чипов памяти, на которую в современных серверах может приходиться до двух третей себестоимости. В «Группе Астра» считают, что 60 млрд руб. на ИИ-серверы звучит реалистично, но важнее динамика. Так, совокупный российский рынок серверов и СХД в 2025 году в целом составил 280 млрд руб. против 155 млрд руб. в 2024-м, сообщали «Ведомости» со ссылкой на данные YADRO и Fplus. Наибольшая часть рынка — около 55–60 % от суммы — пришлась на госзакупки по 44-ФЗ и 223-ФЗ, уточнили тогда в YADRO. По оценкам «Группы Астра», к концу 2026 года госзакупки, связанные с ИИ, вырастут на 20–30 %, а год к году — вполовину. Рынок действительно идёт к промышленной эксплуатации ИИ, считают в ЦКНТИ по направлению «Технологии хранения и анализа больших данных» МГУ, отметив, что банки, телеком, ретейл встраивают ИИ-модели в скоринг, поддержку, операционные процессы. До конца года рынок может вырасти за счёт дооснащения и повторных закупок, а год к году — на 25–40 %, если не будет жёстких ограничений по поставкам ускорителей и финансированию.

19.02.2026 [12:26], Сергей Карасёв

«НВБС» представила российские серверы «Необайт» на платформах Intel и AMDКомпания «НВБС», российский системный интегратор и производитель технологических решений, анонсировала собственные серверы семейства «Необайт». Дебютировали модели NeoByte NBR220 и NeoByte NBR680 на аппаратной платформе Intel, а также NeoByte NBR685 с процессорами AMD. По словам компании, новинки «сопоставимы с решениями ведущих компаний на рынке, но при этом в среднем стоят на 10–15 % дешевле за счёт широкого пула поставщиков и оптимизированной логистики». Система NeoByte NBR220 типоразмера 2U может нести на борту два чипа Intel Xeon Sapphire Rapids или Emerald Rapids с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5-4800. В зависимости от конфигурации во фронтальной части возможна установка 12 накопителей LFF/SFF или 24 устройств SFF с интерфейсом SATA/SAS/NVMe. В тыльной зоне корпуса расположены посадочные места ещё для четырёх накопителей LFF/SFF (SATA/SAS/NVMe), тогда как внутри есть два коннектора для SSD формата M.2 (SATA/NVMe). Реализована поддержка до 10 стандартных слотов PCIe и одного слота OCP 3.0. В оснащение входят контроллер AST2600, два сетевых порта 1GbE, выделенный сетевой порт управления 1GbE, четыре порта USB 3.0 (по два спереди и сзади), два интерфейса D-Sub (по одному спереди и сзади) и последовательный порт. Питание обеспечивают два блока с резервированием мощностью 800/1300/1600/2000 Вт. Сервер оптимизирован для ИИ-задач, виртуализации, баз данных и файловых хранилищ. Платформа практически идентична представленным ранее серверам «Аквариус» AQserv T50 D224RS и T50 D212RS. Модель NeoByte NBR680 стандарта 6U имеет аналогичные характеристики подсистем CPU, ОЗУ, хранения данных и интерфейсов ввода/вывода. При этом возможна установка до восьми GPU-ускорителей двойной ширины. Есть пять стандартных слотов PCIe и один слот OCP; передняя панель поддерживает до трёх стандартных слотов PCIe и один слот OCP. Мощность каждого из двух блоков питания — 2700 или 3200 Вт. Машина предназначена для научных исследований и крупных ИИ-проектов. В свою очередь, GPU-сервер NeoByte NBR685 формата 6U рассчитан на два процессора AMD EPYC 9005 Turin или EPYC 9004 Genoa с показателем TDP до 500 Вт. Предусмотрены 24 слота для модулей оперативной памяти DDR5-4800. Прочие характеристики идентичны версии NeoByte NBR680, включая поддержку восьми GPU-ускорителей двойной ширины. Система подходит для анализа больших данных в реальном времени, криптографии и блокчейна. Все новинки могут быть опционально укомплектованы контроллером SAS RAID/HBA. Заявлена совместимость с Windows Server 2022 SLES 12.5 и выше, RHEL7.8 и выше, Ubuntu18.04 и выше, CentOS7.6 и выше, Vmware ESXi 7.0 GA и выше. Гарантия производителя достигает пяти лет. Также «НВБС» говорит, что «не зависит от санкций, что снижает риски ограничения поставок».

16.02.2026 [16:15], Сергей Карасёв

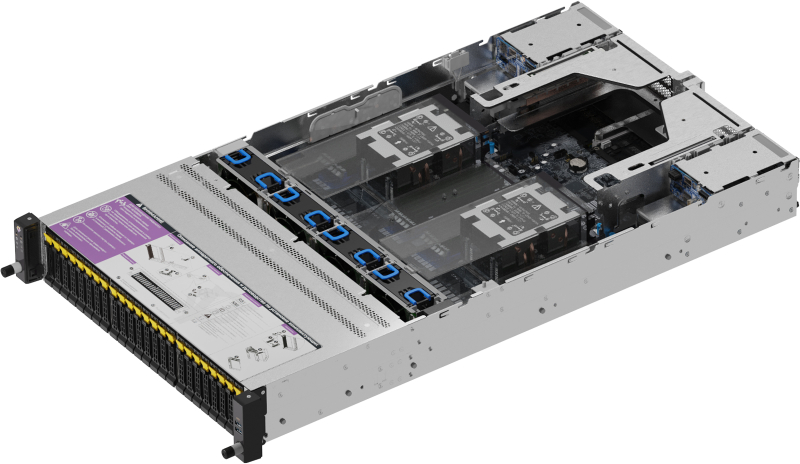

Oxide Computer готовит блейд-платформу на базе AMD EPYC TurinКомпания Oxide Computer, по сообщению The Register, провела раунд финансирования Series C, в ходе которого на дальнейшее развитие привлечено $200 млн. Стартап планирует направить средства в том числе на создание новой стоечной платформы на аппаратной платформе AMD EPYC 9005 Turin. Oxide Computer основана в 2019 году группой бывших инженеров Joyent и Sun Microsystems. Стартап занимается разработкой оборудования для дата-центров. При этом в качестве новой вычислительной единицы компания рассматривает целую стойку, а не отдельный сервер. Система Oxide Computer первого поколения несёт на борту 32 вычислительных модуля, оснащённых чипами AMD EPYC 7713P (Milan). Каждый модуль содержит 64 ядра CPU, до 1 Тбайт DDR4-3200 и 10 NMVe-накопителей U.2 суммарной вместимостью 32 Тбайт. Применённая объединительная плата обеспечивает питание и коммутационную способность до 12,8 Тбит/с. Общее энергопотребление стойки находится на уровне 15 кВт.

Источник изображения: Oxide Computer По словам генерального директора Oxide Computer Стива Така (Steve Tuck), компания проектирует обновлённую версию своей стоечной системы, в которую будут устанавливаться процессоры EPYC поколения Turin. Такие чипы насчитывают до 192 вычислительных ядер. Говорится об использовании памяти DDR5-6400. Вкупе это даст значительный прирост производительности по сравнению с оригинальной машиной. Важным преимуществом Turin является поддержка инструкций AVX-512, предназначенных для ускорения ресурсоёмких вычислений, таких как обработка больших массивов данных, задачи ИИ и пр. Какие именно модели процессоров будут задействованы в новых серверных модулях, Так уточнять не стал. Кроме того, Oxide Computer рассматривает возможность перехода на новые коммутационные решения, которые в перспективе придут на смену ныне применяющимся изделиям Intel Tofino 2. Одним из вариантов является чип-коммутатор Xsight Labs X2, обеспечивающий пропускную способность до 12,8 Тбит/с. При этом изучаются и другие альтернативы. Oxide Computer также не исключает, что в будущем начнёт оснащать свои системы ИИ-ускорителями на базе GPU.

14.02.2026 [12:12], Сергей Карасёв

Сделано в Японии: Fujitsu организует производство суверенных ИИ-серверовКорпорация Fujitsu с марта текущего года начнёт выпускать в Японии суверенные серверы, ориентированные на задачи ИИ и другие ресурсоёмкие нагрузки. Такие системы с маркировкой «Made in Japan» будут выпускаться на предприятии Fujitsu Group в Касасиме (Kasashima) по полному циклу. Fujitsu отмечает, что геополитическая напряжённость, усиливающиеся киберугрозы и более жёсткие требования регулирующих органов приводят к необходимости усиления защиты критически важной информации. В Японии, в частности, в рамках Закона о содействии экономической безопасности управление системными рисками и цифровой суверенитет имеют первостепенное значение для клиентов, работающих с критической информационной инфраструктурой (КИИ). С целью удовлетворения растущего спроса на суверенные решения Fujitsu организует в Японии выпуск серверов, оборудованных ускорителями NVIDIA HGX B300 и NVIDIA RTX Pro 6000 Blackwell Server Edition. Кроме того, до конца 2026 финансового года (заканчивается 31 марта 2027-го) корпорация освоит производство систем на основе фирменных чипов Fujitsu Monaka, которые насчитывают до 144 вычислительных ядер с архитектурой Arm.

Источник изображения: Fujitsu Подчёркивается, что при изготовлении суверенных серверов завод Fujitsu Group будет использовать опыт, полученный при создании суперкомпьютера Fugaku и других высоконадёжных систем. Интегрированный процесс производства охватывает все этапы — от получения печатных плат до сборки устройств, что обеспечит полную отслеживаемость и прозрачность. Продукцию «Made in Japan» планируется поставлять на местный рынок, а также европейским заказчикам. Кром того, Fujitsu расширит сотрудничество с Supermicro для обеспечения непрерывного планирования, разработки, производства, продаж и технического обслуживания ИИ-серверов. В конце 2020 года «белую сборку» серверов наладила в США HPE. Эти машины тоже ориентированы в первую очередь на заказчиков из госсектор, а не обычных потребителей.

10.02.2026 [15:33], Владимир Мироненко

IBM сворачивает продажи серверов POWER10Спустя несколько месяцев после презентации серверов POWER11 компания IBM уведомила клиентов о предстоящем прекращении продаж систем на базе процессоров POWER10. Как отметил ресурс ITJungle, обычно IBM делает такие объявления заблаговременно, как правило, за полгода или более. В информационном письме AD26-0012 IBM сообщила, что следующие модели не будут продаваться после 31 июля 2026 года, за исключением Китая и Южной Кореи, где их можно будет приобрести до 30 июля 2027 года и где платформы POWER9 и POWER10 оказались чрезвычайно популярны в банковской и финансовых сферах, а также в индустрии страхования:

В перечень снятых с производства серверов не вошёл POWER S1012 Mini, анонсированный в мае 2024 года, поскольку его преемник POWER S1112 Mini всё ещё не анонсирован. Снятие с производства не распространяется на модернизацию POWER E1080 — то, что IBM называет спецификацией дополнительного оборудования (Miscellaneous Equipment Specification, MES). Модернизация на POWER E1080 с предыдущих систем по-прежнему будет доступна, что помогает продлить амортизацию. Это важно для балансов компаний, использующих крупногабаритное оборудование POWER. По данным ITJungle, для других устройств линейки POWER10 модернизация с использованием MES с предыдущих моделей недоступна, а для машин начального и среднего уровня в линейке POWER Systems её давно нет. После июльских дат 2026 и 2027 годов также будет отключена возможность активации процессоров на этих устройствах в процессе перехода с одной модели на другую (что не то же самое, что обновление в понимании IBM). Однако по традиции это не касается оставшихся, но ещё не активированных в рамках одной машины процессоров и памяти. Также после указанных дат для снятых с производства серверов POWER10 не будут предлагаться различные уровни услуг Advanced Expert Care и POWER Expert Care от IBM. Некоторые кабели также будут исключены из каталога, а для более компактных моделей будет снят с продажи ряд плат расширения, адаптеров, памяти DDR5, флеш-накопителей и других периферийных устройств. Это касается только заказов на новые системы. Как полагает ITJungle, немногие клиенты перейдут с POWER10 на POWER11, если только они не приобрели POWER10 на очень раннем этапе цикла. Безусловно, между POWER10 и POWER11 есть важные различия, но их недостаточно, чтобы оправдать масштабное и сложное обновление или переход на новую систему. Согласно прогнозу ITJungle, клиенты POWER10 будут мигрировать уже на POWER12 — возможно, года через три.

09.02.2026 [14:20], Сергей Карасёв

OpenYard выпустила российский двухсокетный сервер RS202A на базе AMD EPYC TurinРоссийский разработчик и производитель корпоративного оборудования OpenYard объявил о начале серийного выпуска серверов RS202A на аппаратной платформе AMD. Устройства предназначены для построения масштабируемых и отказоустойчивых IT-инфраструктур, включая виртуальные среды, аналитические системы и хранилища данных. Серверы выполнены в форм-факторе 2U. Допускается установка двух процессоров AMD EPYC 9005 поколения Turin в исполнении LGA 6096 (SP5) с показателем TDP до 500 Вт. Предусмотрены 24 слота для модулей оперативной памяти DDR5-6400 суммарным объёмом до 6 Тбайт. В оснащение входят контроллер ASPEED AST2600, двухпортовый сетевой адаптер 1GbE (Intel I350-AM2) и выделенный сетевой порт управления 1GbE. Во фронтальной части корпуса в зависимости от модификации располагаются 24 отсека для SFF-накопителей (SATA/SAS-4/NVMe PCIe 5.0) или 12 отсеков для LFF-изделий. В тыльной секции находятся четыре посадочных места для SFF-изделий с интерфейсом SATA/SAS-4. Во всех случаях допускается горячая замена. Кроме того, сеть два внутренних слота для SSD типоразмера M.2 2280/22110 с интерфейсом PCIe 3.0 x4 и один слот M.2 2280/22110 PCIe 3.0 x2. Доступны до пяти разъёмов PCIe 5.0 x16 для карт расширения FHHL и до двух разъёмов OCP 3.0 PCIe 5.0 x16 с поддержкой NCSI. Габариты составляют 438 × 87,5 × 815 мм. Установлены два блока питания мощностью 2000 Вт с сертификатом 80 PLUS Platinum. Упомянуты два порта USB 3.2, коннектор Mini-DP и три гнезда RJ45 для сетевых кабелей. Диапазон рабочих температур — от +10 до +35 °C. Производство серверов RS202A осуществляется на собственной площадке OpenYard в Рязани. В настоящее время системы проходят пилотные внедрения в корпоративных IT-средах, а объёмы выпуска планируется масштабировать в зависимости от рыночного спроса, говорит компания.

05.02.2026 [12:31], Руслан Авдеев

Omdia прогнозирует рост цен на всё более дефицитные серверные CPUВ 2026 году дата-центры могут столкнуться не только с уже имеющимся дефицитом памяти, но и не менее серьёзной проблемой, связанной с ограничением поставок классических серверных процессоров, сообщает The Register со ссылкой на аналитику Omdia. Тем не менее, эксперты ожидают, что поставки будут расти двузначными темпами. В обзоре Cloud and Datacenter Market Snapshot компания Omdia сообщила, что серверных CPU тоже не хватает и это, вероятно, приведёт к росту цен и увеличению общей стоимости вычислительных систем. По мнению экспертов, как минимум отчасти это связано со сложностью переноса объёмов производства между разными техпроцессами. По мере масштабирования планов производителям CPU приходится выпускать продукцию на разных техпроцессах, например 3 нм и 5 нм. При этом перераспределение объёмов производства между разными технологическими линиями — процесс довольно сложный и трудоёмкий. Дефициту может способствовать и более высокий, чем ожидалось, процент брака готовой продукции.

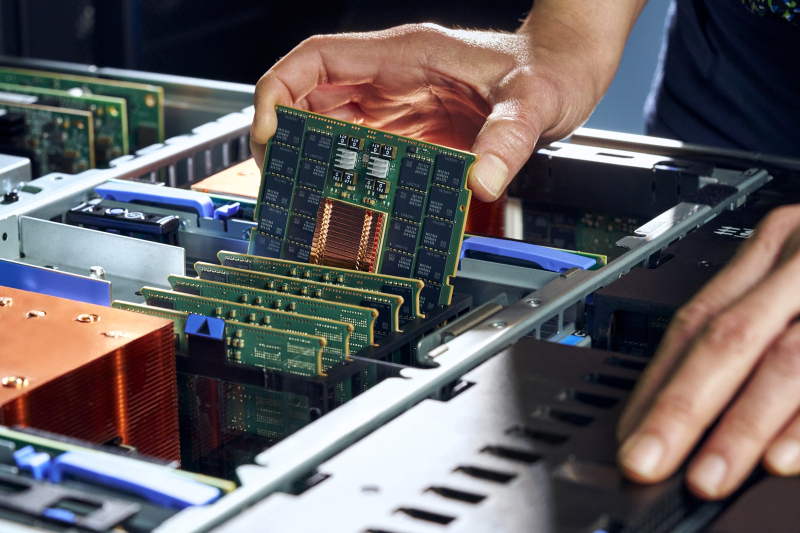

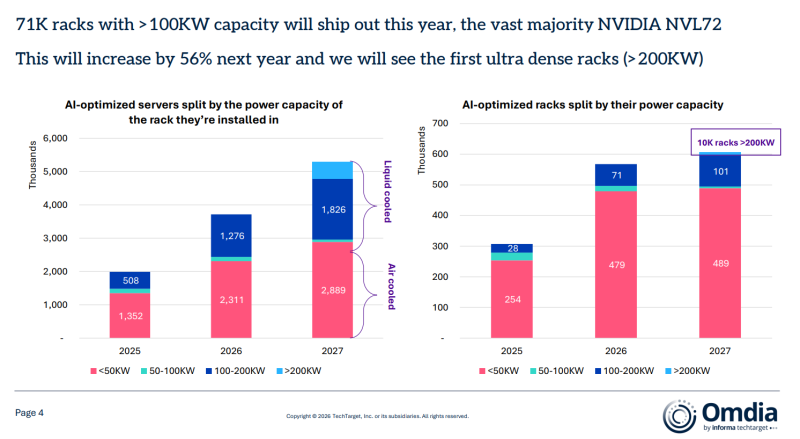

Источник изображения: Intel Как считает Omdia, в результате цены на серверные процессоры, возможно, вырастут на 10–15 % из-за дефицита предложения. Стоит учесть, что крупнейшие клиенты имеют долгосрочные соглашения с производителями с фиксированными ценами, иначе прогнозы были бы ещё хуже. Вместе с тем акции AMD и Intel упали из-за слабого, по мнению инвесторов, прогноза. Любые проблемы с CPU усугубят непростую ситуацию в цепочке поставок IT-оборудования. На фоне дефицита цены на DRAM-модули в данном квартале, вероятно, почти удвоятся, а цены на память NAND вырастут более чем на 30 %. Обычная DRAM оказалась в дефиците не в последнюю очередь потому, что производители перепрофилировали свои мощности на выпуск высокорентабельных продуктов — HBM-модулей для ИИ-ускорителей. Omdia обеспокоена тем, что дефицит оперативной памяти может сказаться на темпах производства серверов, что способно повлиять на сроки завершения уже реализуемых проектов ЦОД. Тем не менее, эксперты прогнозируют рост поставок серверов в 2026 году на 12 %. Основным драйвером выступает «цикл обновления» — необходимость закупки новых серверов общего назначения, что будет способствовать увеличению их поставок. При этом дефицит памяти называется большей угрозой, чем нехватка процессоров. Что касается стоек с серверами на базе ИИ-ускорителей, Omdia предполагает, что в 2026 году будет поставлено не менее 71 тыс. единиц с IT-нагрузкой более 100 кВт, в основном на базе систем NVIDIA NVL72. Благодаря высокому спросу на ИИ-инфраструктуру, Omdia ожидает, что в следующем году спрос увеличится ещё на 56 %, появятся и первые «сверхплотные» стойки мощностью более 200 кВт и дело на этом, вероятно, не закончится.

04.02.2026 [18:37], Сергей Карасёв

«Рикор» выпустил российские 2U-серверы на базе Intel Xeon Emerald RapidsКомпания «Рикор» анонсировала российские серверы Rikor 7212DSP5 и Rikor 7225DSP5, построенные на аппаратной платформе Intel Xeon Emerald Rapids. Устройства, как утверждается, подходят для решения широко спектра задач, включая виртуализацию, гиперконвергентную инфраструктуру, облачные сервисы, анализ данных, машинное обучение и приложения ИИ. Новинки выполнены в форм-факторе 2U. Допускается установка двух процессоров Xeon и 32 модулей оперативной памяти DDR5 суммарным объёмом до 8 Тбайт. Реализована поддержка интерфейса PCIe 5.0. Серверы различаются конфигурацией подсистемы хранения данных: модель Rikor 7212DSP5 рассчитана на 12 накопителей с доступом через фронтальную панель, а модификация Rikor 7225DSP5 — на 25. Прочие технические характеристики пока не раскрываются. Одним из ключевых преимуществ решений производитель называет использование корпусов собственной разработки. Это, как утверждается, обеспечивает контроль качества металла и сборки, а также ускоряет процесс выпуска систем. Кроме того, «Рикор» может предлагать заказчикам уникальные решения по оптимизации внутреннего пространства. В результате, клиенты получают «более гибкие, технологичные и экономически выгодные серверы, наиболее полно соответствующие требованиям по локализации и технологической независимости». Производство серверов осуществляется на роботизированном заводе. «Рикор» уже принимает заказы на новые модели, а их отгрузки начнутся в ближайшее время. Компания гарантирует стабильность поставок.

02.02.2026 [22:50], Владимир Мироненко

В 2025 году в России значительно выросли затраты на закупки серверов и СХД на фоне их удорожанияВ 2025 году российский рынок серверов и СХД вырос почти вдвое, составив 280 млрд руб. с учётом НДС (по данным YADRO), тогда как в 2024 году его объём составил 155 млрд руб. (по данным Fplus), сообщили «Ведомости». По оценкам экспертов, увеличение рынка большей частью связано с удорожанием серверов и их комплектующих. Как отметили в SNDGlobal, при росте совокупного бюджета более чем на 40 % число закупок сократилось, что говорит о повышении среднего чека на сервер или хранилище. Этого мнения придерживаются и в Fplus. По словам представителя Fplus, в реальности рост рынка в деньгах отражает лишь увеличение стоимости устройств, в то время как количество поставляемых серверов стало гораздо меньше. Одной из причин он назвал подорожание памяти, при этом в современных серверах на память может приходиться до двух третей себестоимости конечного оборудования. Также удорожание серверов в 2025 году связано с тем, что российские вендоры стали выпускать модели с дорогими иностранными GPU, добавили в ComNews Group, отметив, что на увеличение стоимости повлияло удорожание и других комплектующих — микросхем памяти или процессоров, от которых зависит примерно 30–50 % стоимости устройства. Ввиду того, что комплектующие импортные, к цене добавляется и довольно высокая стоимость логистики. Львиная доля рынка — около 55–60 % — пришлась на госзакупки по № 44-ФЗ и 223-ФЗ, уточнил представитель YADRO. По данным «Тендерплан», совокупная стоимость госзакупок серверов и хранилищ по № 44-ФЗ и 223-ФЗ за II полугодие 2025 года выросла год к году на 42 % на фоне сокращения количества госзакупок — с 5819 закупок на 51,6 млрд руб. во II полугодии 2024 года до 5308 закупок на 72,8 млрд руб. Большей частью закупали российскую технику, хотя было и иностранное оборудование. В некоторых случаях покупатель указывал конкретного вендора, оборудование которого он хотел бы приобрести. В таких закупках во II полугодии 2025 года продукция YADRO указывалась 100 раз против 74 годом ранее, уточнили в «Тендерплане». Общий объём этих закупок увеличился с 4,2 млрд до 7 млрд руб. В свою очередь, закупки серверов и СХД Depo выросли с 603 млн до 1,5 млрд руб., в то время как общее количество закупок – с 81 до 98. Закупки оборудования «Аквариуса» увеличились с 2,6 млрд до 3,1 млрд руб., а «Аэродиска» — снизилась с 1,9 млрд до 886,2 млн руб. На фоне роста закупок отечественного оборудования снизилась доля импортного. По данным «Тендерплана», во II полугодии 2024 года оборудование Huawei упоминалось в 70 закупках на сумму 745,6 млн руб., а во втором полугодии 2025 года — в 60 закупках на 888,7 млн руб. Закупки техники IBM сократились во II полугодии 2025 года относительно того же периода 2024 года с 1,2 млрд до 638,9 млн руб. Закупки оборудования Hitachi остались на уровне 66,9 млн руб. И лишь закупки оборудования Lenovo показали рост, причём значительный — с 776,3 млн руб. в 2024 году до 1,2 млрд руб. в 2025 году.

02.02.2026 [11:02], Сергей Карасёв

Giga Computing выпустила вычислительные узлы TO25-ZU4 и TO25-ZU5 на базе AMD EPYC TurinКомпания Giga Computing, подразделение Gigabyte, анонсировала серверные узлы TO25-ZU4 и TO25-ZU5 стандарта OCP ORV3, ориентированные на гиперскейлеров и облачных провайдеров. Решения формата 2OU (двухузловая конфигурация) выполнены на аппаратной платформе AMD. Устройства получили системную плату MZU3-MG0. Допускается установка одного процессора EPYC 9005 Turin или EPYC 9004 Genoa с показателем TDP до 500 Вт (до 192 вычислительных ядер). Доступны 12 слотов для модулей оперативной памяти DDR5-6400/4800. В оснащение входят контроллер ASPEED AST2600, двухпортовый сетевой адаптер 10GbE (Intel X710-AT2) и выделенный сетевой порт управления 1GbE. Модель TO25-ZU4 поддерживает два накопителя типоразмера E1.S (PCIe 5.0; NVMe) толщиной 9,5 мм и четыре SFF-накопителя (NVMe/SATA/SAS-4). Кроме того, есть по два слота для карт FHFL (PCIe 5.0 x16) и OCP NIC 3.0 (PCIe 5.0 x16). В свою очередь, модификация TO25-ZU5 оборудована посадочными местами для двух накопителей E1.S (PCIe 5.0; NVMe) и восьми изделий SFF (NVMe/SATA/SAS-4). При этом доступны два разъёма PCIe 5.0 x16 для низкопрофильных карт расширения.

Источник изображений: Giga Computing Во фронтальной части обоих узлов расположены интерфейсы USB 3.0 Type-C, Micro-USB и Mini-DP, а также три гнезда RJ45 для сетевых кабелей. Диапазон рабочих температур простирается от +10 до +30 °C. За безопасность отвечает опциональный модуль TPM 2.0. При необходимости может быть также добавлен RAID-адаптер. Габариты решений составляют 258 × 86 × 771 мм.  |

|