Материалы по тегу: ram

|

05.03.2026 [14:21], Владимир Мироненко

Дефицит памяти поможет Broadcom подзаработать, но не так, как вы подумалиВ связи с ростом цен на оперативную память на фоне её дефицита, который, по прогнозам экспертов, сохранится и в 2027 году, VMware (подразделение Broadcom) предложила частное облако VMware Cloud Foundation (VCF) 9.0 в качестве решения, необходимого для работы в новых условиях. VMware заявила, что «традиционный подход, заключающийся в увеличении количества оборудования для решения проблем производительности и масштабируемости, больше не является жизнеспособным». «Broadcom разработала VCF 9.0 специально для решения этой экономической задачи, предложив три различных подхода: снижение совокупной стоимости владения за счёт многоуровневого хранения памяти, отсрочка капитальных затрат за счёт передовых технологий повышения эффективности и обеспечение немедленного внедрения в существующий парк оборудования», — сообщила она. Как отметил The Register, VMware всегда продвигала многоуровневую организацию памяти VCF 9 как возможность снизить затраты на инфраструктуру за счёт уменьшения установленного объёма DRAM путём прозрачного переноса части данных на NVMe. Вместе с тем, не следует забывать, что стоимость SSD также выросла. VMware также признаёт, что её архитектура памяти подходит не для всех рабочих нагрузок и не предназначена для виртуальных машин, чувствительных к задержкам, или очень больших инстансов. Но VMware всё равно утверждает, что «наиболее прямое решение проблемы стремительного роста цен на DRAM — это просто использовать её меньше», а VCF 9.0 позволяет «заменить дорогостоящую DRAM значительно более дешёвым хранилищем NVMe». Многоуровневое распределение памяти VMware в настоящее время превосходит альтернативу в виде CXL, пишет The Register. Кроме того, новые поколения серверных процессоров AMD и Intel создали возможность очередного этапа консолидации нагрузок. Dell утверждает, что её клиенты заменяют семь серверов одной новой машиной; Intel говорит о консолидации 5:1. Новые серверы позволяют запускать огромное количество ВМ, что концентрирует риски и требует огромного количества дорогостоящей памяти. Но VMware и не требует, чтобы в каждом хосте в кластере использовалось многоуровневое распределение памяти. Так что VCF 9 в текущей ситуации действительно может оказаться эффективным средством снижения затрат. В то же время The Register отметил, что многие пользователей vSphere считают VCF 9 очень дорогим продуктом, несмотря на уверения Broadcom в обратном. При этом Broadcom, похоже, в принципе не готова идти на ценовые уступки — или бери, или уходи.

02.03.2026 [12:35], Сергей Карасёв

Team Group анонсировала новые индустриальные NVMe SSD и модули памятиTeam Group готовит новые SSD в различных форм-факторах, а также модули оперативной памяти для индустриальных и встраиваемых систем. В частности, готовятся накопители Team Group Industrial R252 стандарта U.2 (NVMe), предназначенные для серверов. Эти устройства оснащены интерфейсом PCIe 5.0 x4. Они обеспечивают скорость последовательного чтения информации до 14 000 Мбайт/с, скорость последовательной записи — до 10 000 Мбайт/с. Кроме того, выйдут SSD серии Team Group Industrial R253, ориентированные на решение разнообразных задач в современных дата-центрах и на периферии. Такие устройства, получившие формат EDSFF E3.S, позиционируются в качестве накопителей большой ёмкости с улучшенной защитой данных. Они подходят для обработки ИИ-нагрузок, аналитики в реальном времени и пр. Дебютируют также SSD семейства Team Group Industrial R251 стандарта EDSFF E1.S, оптимизированные для серверов форм-фактора 1U. Эти накопители имеют сертификацию по стандартам виброустойчивости MIL-STD, что означает надёжность при эксплуатации в системах с высокой плотностью размещения оборудования.

Источник изображений: Team Group В сегменте оперативной памяти Team Group представит новые модули Industrial DDR4 U-DIMM и SO-DIMM, специально разработанные для промышленного применения и IoT-устройств. Помимо этого, готовятся изделия Industrial DDR5 CU-DIMM и CSO-DIMM с частотой до 7200 МГц, рассчитанные на ИИ-платформы. На системы со значительной интенсивностью вычислений ориентированы решения Team Group Industrial LPDDR5X CAMM2: они обеспечивают высокую пропускную способность и низкую задержку.

05.02.2026 [17:58], Сергей Карасёв

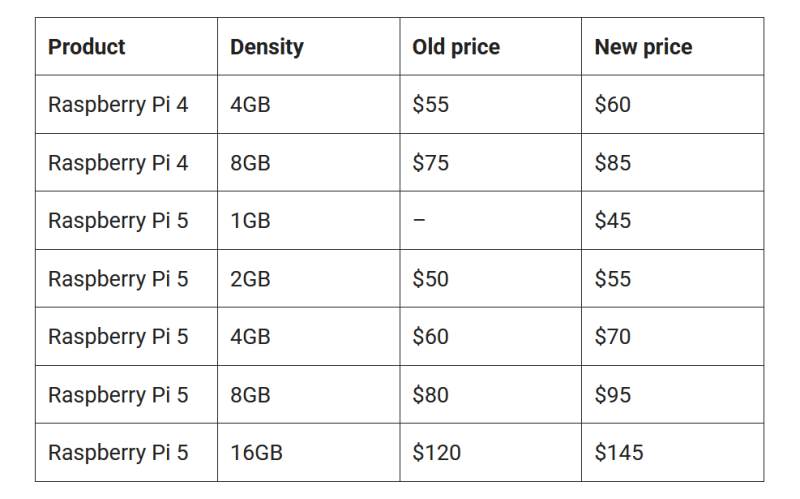

Из-за дефицита памяти у Raspberry Pi 4 появился версия со «сдвоенной» RAM, а 16-Гбайт версия Raspberry Pi 5 существенно подорожалаКомпания Raspberry Pi, по сообщению ресурса CNX Software, из-за дефицита чипов памяти, сформировавшегося на фоне бума ИИ, продолжает поднимать цены на свои одноплатные компьютеры. А в конструкцию отдельных моделей даже внесены изменения с целью обеспечения гибкости в цепочке поставок DRAM. Напомним, в конце прошлого года повысились цены на изделия Raspberry Pi 4 и Raspberry Pi 5: прирост составил от $5 до $25 в зависимости от модификации. Очередное изменение стоимости затронуло названные одноплатные компьютеры, а также вычислительные модули Raspberry Pi Compute Module 4 и Raspberry Pi Compute Module 5, несущие на борту 2 Гбайт оперативной памяти и более (модификации с 1 Гбайт ОЗУ предлагаются по прежней цене). Прибавка выглядит следующим образом:

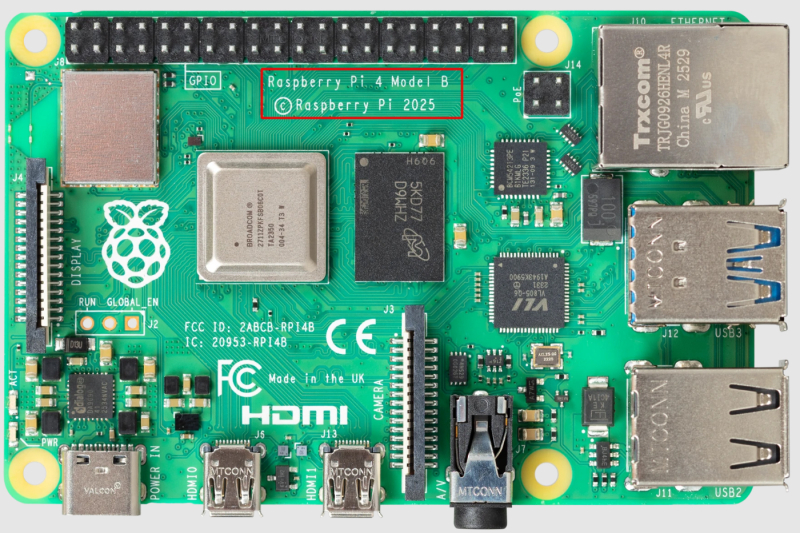

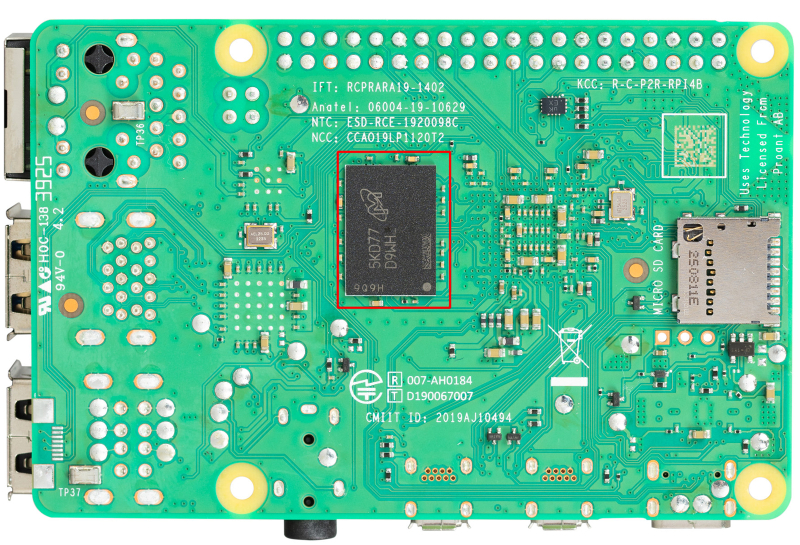

Вместе с тем выпущен новый вариант Raspberry Pi 4 — изделие Raspberry Pi 4 v1.5 Dual RAM (маркировка «Raspberry Pi 4 Model B © Raspberry Pi 2025»). У такого одноплатного компьютера вместо одного чипа LPDDR4 используются два, которые расположены на лицевой и обратной сторонах. CNX Software отмечает, что на фоне нехватки компонентов DRAM может сложиться ситуация, когда два чипа памяти на 4 Гбайт будут стоить дешевле одного на 8 Гбайт. Кроме того, такая компоновка позволит решить проблему недоступности модулей LPDDR4 большой ёмкости: производитель сможет заменять их парой чипов вдвое меньшего объема.

04.02.2026 [10:12], Сергей Карасёв

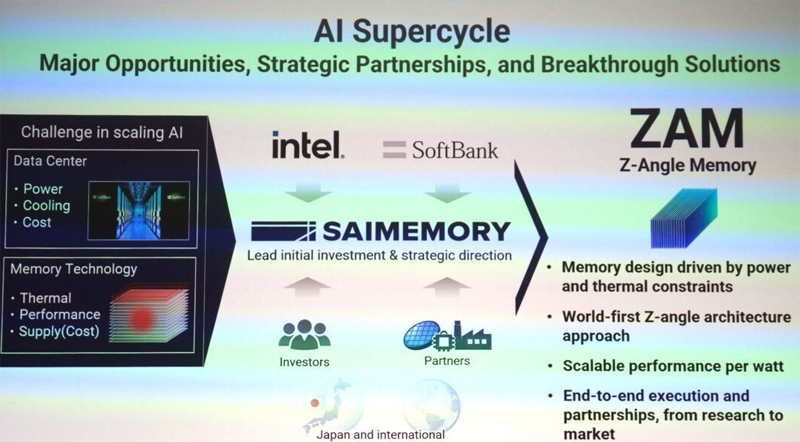

Intel и SoftBank займутся разработкой памяти Z-Angle Memory (ZAM) — альтернативы HBM для ИИ-системКорпорации Intel и SoftBank объявили о сотрудничестве в рамках проекта по разработке высокопроизводительной памяти нового типа Z-Angle Memory (ZAM), ориентированной на ИИ-системы. Предполагается, что в перспективе такие решения составят конкуренцию HBM. В инициативе принимает участие Saimemory — дочернее предприятие SoftBank, сформированное в декабре 2024 года. Речь идёт о разработке многослойной архитектуры DRAM с вертикальной компоновкой. Цель заключается в увеличении ёмкости чипов памяти и их пропускной способности по сравнению с HBM при одновременном снижении энергопотребления. Проект ZAM основан на результатах исследований, полученных по программе передовых технологий памяти AMT (Advanced Memory Technology), которая управляется Министерством энергетики США (DOE) и Администрацией по национальной ядерной безопасности США (NNSA). В данной программе участвуют Сандийские национальные лаборатории (SNL), Ливерморская национальная лаборатория имени Лоуренса (LLNL) и Лос-Аламосская национальная лаборатория (LANL) в составе DOE. Планируется использование технологии сборки Intel Next Generation DRAM Bonding (NGDB), которая, как утверждается, значительно повышает производительность DRAM, снижает энергопотребление и оптимизирует затраты на память.

Источник изображения: TechPowerUp В целом, в рамках нового проекта Intel и Saimemory планируют увеличить ёмкость модулей памяти в два–три раза по сравнению с современными HBM, снизить энергопотребление на 40–50 % и при этом сохранить конкурентоспособную стоимость. Предполагается, что появление ZAM позволит устранить ключевые узкие места при масштабировании высокопроизводительных систем ИИ. Работы над памятью нового типа начнутся в текущем квартале. Демонстрация прототипов запланирована на 2027 год, а коммерциализация технологии — на 2030-й.

29.12.2025 [14:09], Руслан Авдеев

Fujitsu поможет SoftBank в создании дешёвой и доступной альтернативы HBMКомпания Fujitsu присоединится к проекту, возглавляемому японской инвестиционной группе SoftBank. Партнёры намерены разрабатывать память нового поколения для ИИ и суперкомпьютеров, сообщает Nikkei Asian Review. Япония намерена восстановить компетенции, в своё время позволившие стране стать одним из лидеров в сфере производства модулей памяти. «Командным центром» для реализации государственно-частного проекта должна стать компания Saimemory, основанная SoftBank; участие, помимо Fujitsu, примут и другие партнёры. Saimemory рассчитывает разработать высокопроизводительную память, способную стать альтернативой HBM. Проект предусматривает инвестиции в ¥8 млрд ($51,2 млн) в 2027 финансовом году для завершения создания прототипа. Массовое производство должно начаться к 2029 финансовому году. Сама SoftBank к 2027 финансовому году выделит Saimemory ¥3 млрд, Fujitsu и японский научно-исследовательский институт Riken в совокупности вложат около ¥1 млрд. Часть расходов, как ожидается, должно компенсировать японское правительство посредством программ поддержки разработки полупроводников нового поколения. В своё время Fujitsu была ключевым игроком в некогда ведущей в мире японской полупроводниковой индустрии. Хотя она со временем отказалась от производства памяти, у неё накоплен богатый опыт в области массового производства модулей и контроля их качества. Сейчас компания продолжает заниматься разработкой энергоэффективных CPU и сохраняет прочные связи с клиентами.

Источник изображения: Fujitsu Saimemory намерена наладить масовое производство памяти с ёмкостью вдвое или втрое больше, чем у HBM при энергопотреблении вдвое ниже, при этом цена будет сопоставимой или даже более привлекательной. Компания рассчитывает использовать полупроводниковые технологии, разработанные Intel и Токийским университетом, а Shinko Electric Industries и тайваньская Powerchip Semiconductor Manufacturing помогут с производством и созданием прототипов. Intel обеспечит базовую технологию вертикального штабелирования, разработанную при поддержке американского военного ведомства DARPA, которая позволит увеличить количество чипов памяти на единицу площади и сократить расстояние передачи данных. Также будут применяться технологии Токийского университета и других компаний для рассеивания тепла и упрощения передачи данных. Saimemory будет специализироваться на управлении интеллектуальной собственностью и разработке чипов, передавая заказы на производство сторонним компаниям. С распространением систем генеративного ИИ, требуемая вычислительная мощность в Японии, по некоторым оценкам, увеличится более чем в 300 раз между 2020 и 2030 гг. Тем не менее Япония, некогда бывшая одним из лидеров в производстве полупроводников, теперь сильно зависит от зарубежных компаний. В результате существуют риски перебоев с поставками и вероятность неконтролируемого роста цена на них. На южнокорейские компании приходится около 90 % доли выпуска HBM-памяти. По данным Nikkei, в своё время японский бизнес постепенно прекратил производство собственной памяти приблизительно в 2000 году. Появление и развитие ИИ-технологий может изменить положение. SoftBank движется к строительству собственных больших дата-центров, а Fujitsu уже выпускает CPU для ЦОД и инфраструктуру связи, практическое применение которым, вероятно, найдут уже в 2027 году.

23.12.2025 [12:28], Сергей Карасёв

Goodram представила 122,88-Тбайт SSD для ЦОД с иммерсионным охлаждениемКомпания Goodram Industrial, принадлежащая Wilk Elektronik SA, без громких анонсов представила свой первый SSD вместимостью 122,88 Тбайт, предназначенный для использования в системах с иммерсионным (погружным) жидкостным охлаждением. Устройство рассчитано на дата-центры и площадки гиперскейлеров. Накопитель относится к семейству DC25F. В его основу положены чипы флеш-памяти QLC NAND. Доступны модификации в форм-факторах E3.S и E3.L: в обоих случаях для подключения служит интерфейс PCIe 5.0 x4. Заявленная скорость последовательного чтения информации достигает 14 600 Мбайт/с, скорость последовательной записи — 3200 Мбайт/с. Показатель IOPS составляет до 3 млн при произвольном чтении данных 4K-блоками и до 35 тыс. при произвольной записи. Накопители способны выдерживать 0,3 полных перезаписи в сутки (0,3 DWPD) на протяжении пяти лет. Это ставит их в один ряд с другими QLC-устройствами корпоративного класса, предназначенными для «теплого» и «холодного» хранения данных.

Источник изображения: Goodram Goodram отмечает, что накопители прошли всестороннее тестирование с использованием различных диэлектрических жидкостей для иммерсионного охлаждения, включая составы Shell и Chevron. Утверждается, что эти SSD рассчитаны на длительную эксплуатацию без деградации. Помимо модели вместимостью 122,88 Тбайт, Goodram предлагает широкий выбор других SSD для систем с иммерсионным охлаждением. Это устройства ёмкостью от 1,92 Тбайт и выше на основе чипов TLC NAND и QLC NAND с интерфейсами SATA, PCIe 4.0 и PCIe 5.0. Они доступны в форм-факторах SFF U.2 и U.3, E3.S и E1.S, M.2 2280 и M.2 22110.

01.12.2025 [19:10], Владимир Мироненко

Дефицит памяти добрался и до Raspberry Pi: цены на четвёртую и пятую «малинку» вырослиРост цен на компоненты для вычислительных систем, который в основном объясняют бумом на ИИ-рынке, привёл к удорожанию даже традиционно дешёвых одноплатных компьютеров Raspberry Pi. Как сообщила компания, после увеличения в октябре цен на вычислительные модули CM4/CM5 из-за ограничений поставок памяти DDR4, ей пришлось повысить цены на Raspberry Pi 4 и 5. Для тех, кто ищет более доступный вариант, компания выпустила модель Raspberry Pi 5 1 Гбайт. Однако его цена выше традиционных $35 — сразу $45. Впрочем, цена Raspberry Pi 4 1 Гбайт не изменилась и по-прежнему составляет $35. Напомним, что в октябре цена CM4/CM5 с 4 Гбайт памяти выросла на $5, с 8 Гбайт памяти — на $10. Стоимость Raspberry Pi 500 была увеличена на $10 — до $100. Компания пообещала вернуть цены к прежним значениям, как только снизится цена памяти. Ранее она так уже делала. «…, чтобы компенсировать недавний беспрецедентный рост стоимости памяти LPDDR4, мы объявляем о повышении цен на некоторые модели Raspberry Pi 4 и 5. Эти изменения во многом отражают повышение цен на наши вычислительные модули, о котором мы объявили в октябре, и помогут нам обеспечить поставки памяти в условиях всё более ограниченного рынка в 2026 году», — объявила Raspberry Pi. Ниже показано, как изменились цены на компьютеры Raspberry Pi. В перечне не указаны модели Raspberry Pi 4 2 Гбайт, Raspberry Pi 3+ и более ранние модели, а также семейство Raspberry Pi Zero, которых не коснулось изменение цен. Как отметил ресурс CNX Software, Raspberry Pi 5 1 Гбайт доступен ограниченно, поскольку, по всей видимости, он продаётся в основном через европейских реселлеров, а также через Canakit в США и Канаде. Однако найти его в Азии будет сложно, и ни у одного из реселлеров «остального мира» эта модель не имеется в наличии, отметил ресурс.

11.11.2025 [12:03], Сергей Карасёв

Стартап Majestic Labs обещает ИИ-серверы со 128 Тбайт RAMКомпания Majestic Labs, занимающаяся разработкой серверов нового поколения для наиболее ресурсоёмких задач ИИ, объявила о выходе из скрытого режима (Stealth) и проведении раунда финансирования Series A. В общей сложности стартап на сегодняшний день получил на развитие $100 млн. Majestic Labs основана бывшими сотрудниками Google и Meta✴. Компания разрабатывает серверы высокой плотности, способные справляться с самыми масштабными и сложными задачами ИИ, для которых в настоящее время требуются несколько стоек с вычислительным оборудованием и коммутаторами. По оценкам Стэнфордского университета (Stanford University), размер кластеров для обучения ИИ-моделей удваивается каждые пять месяцев, объём наборов данных — каждые восемь, а энергопотребление — ежегодно. При этом узким местом, по заявлениям Majestic Labs, является память ИИ-систем: наблюдается разрыв между её объемом и производительностью и собственно вычислительными возможностями ускорителей. В результате, компании вынуждены приобретать избыточные дорогостоящие ИИ-карты только для того, чтобы получить доступ к большему объёму памяти. Majestic Labs рассчитывает решить проблему путём использования принципиально новой архитектуры ИИ-серверов, меняющей баланс памяти и вычислительных мощностей. Стартап заявляет, что каждый сервер нового типа сможет нести на борту столько же памяти, сколько 10 или более современных стоек. Разрабатываемая архитектура позволит радикально сократить затраты на охлаждение, сетевое оборудование и другие компоненты, которые используются в традиционных системах. «Серверы Majestic будут обладать всеми вычислительными возможностями современных устройств на базе GPU и TPU в сочетании с 1000-кратным увеличением объёма памяти», — говорит соучредитель и генеральный директор стартапа Офер Шахам (Ofer Shacham). Архитектура Majestic Labs предусматривает разделение памяти и вычислительных ресурсов. В серверах будут применяться специализированные ИИ-ускорители и блоки «чрезвычайно быстрой и энергоэффективной памяти с высокой пропускной способностью» (тип не уточняется). Каждый сервер сможет нести на борту до 128 Тбайт RAM, что позволит работать с самыми крупными моделями LLM с огромными контекстными окнами. При этом будет обеспечиваться значительное снижение энергопотребления по сравнению с традиционными системами сопоставимого уровня, объединяющими несколько стоек с оборудованием. Программу финансирования Series A на сумму в $71 млн возглавляет Bow Wave Capital. Предыдущим посевным раундом руководила инвестиционная компания Lux Capital. Кроме того, поддержку стартапу оказывают SBI, Upfront, Grove Ventures, Hetz Ventures, QP Ventures, Aidenlair Global и TAL Ventures. Majestic Labs планирует продавать своё оборудование гиперскейлерам, операторам крупных дата-центров, финансовым учреждениям и фармацевтическим компаниям. Стартап рассчитывает выпустить первые коммерческие серверы в 2027 году. Привлечённые средства будут также использованы для расширения команды инженеров и улучшения программного стека, обеспечивающего работу систем нового типа.

04.11.2025 [16:35], Сергей Карасёв

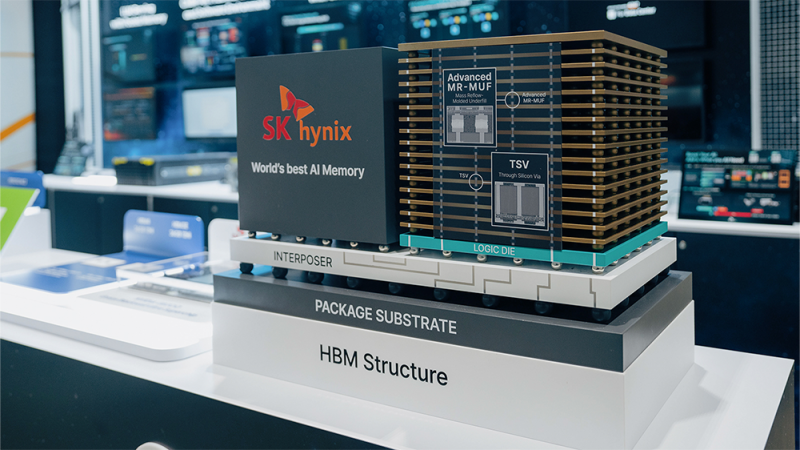

SK hynix разрабатывает AI-D — память для устранения узких мест в ИИ-системахКомпания SK hynix, по сообщению ресурса Blocks & Files, проектирует память нового типа AI DRAM (AI-D) для высокопроизводительных ИИ-платформ. Изделия нового типа будут предлагаться в трёх модификациях — AI-D O (Optimization), AI-D B (Breakthrough) и AI-D E (Expansion), что, как ожидается, позволит устранить узкие места современных систем. SK hynix является одним из лидеров рынка памяти HBM (Hgh Bandwidth Memory) для ИИ-ускорителей. Однако достижения в данной сфере отстают от развития GPU, из-за чего возникает препятствие в виде «стены памяти»: наблюдается разрыв между объёмом и производительностью HBM и вычислительными возможностями ускорителей. Проще говоря, GPU простаивают в ожидании данных. Одним из способов решения проблемы является создание кастомизированных чипов HBM, предназначенных для удовлетворения конкретных потребностей клиентов. Вторым вариантом SK hynix считает выпуск специализированной памяти AI-D, спроектированной для различных ИИ-нагрузок. В частности, вариант AI-D O предполагает разработку энергосберегающей высокопроизводительной DRAM, которая позволит снизить общую стоимость владения ИИ-платформ. Для таких изделий предусмотрено применение технологий MRDIMM, SOCAMM2 и LPDDR5R. Продукты семейства AI-D B помогут решить проблему нехватки памяти. Такие изделия будут отличаться «сверхвысокой ёмкостью с возможностью гибкого распределения». Упомянуты технологии CMM (Compute eXpress Link Memory Module) и PIM (Processing-In-Memory). Это означает интеграцию вычислительных возможностей непосредственно в память, что позволит устранить узкие места в перемещении данных и повысить общее быстродействие ИИ-систем. Ёмкость AI-D B составит до 2 Тбайт — в виде массива из 16 модулей SOCAMM2 на 128 Гбайт каждый. Причём память отдельных ускорителей сможет объединяться в общее адресное пространство объёмом до 16 Пбайт. Любой GPU сможет заимствовать свободную память из этого пула для расширения собственных возможностей по мере роста нагрузки. Наконец, архитектура AI-D E подразумевает использование памяти, включая HBM, за пределами дата-центров. SK hynix планирует применять DRAM в таких областях, как робототехника, мобильные устройства и платформы промышленной автоматизации.

26.10.2025 [14:15], Сергей Карасёв

Micron представила 192-Гбайт модули памяти SOCAMM2 для ИИ-серверовКомпания Micron Technology анонсировала компактные модули оперативной памяти SOCAMM2 (Small Outline Compression Attached Memory Modules), предназначенные для использования в серверах для задачи ИИ. Изделия, выполненные на энергоэффективных чипах LPDDR5X, имеют ёмкость 192 Гбайт. Модули SOCAMM первого поколения были анонсированы в марте нынешнего года. Их размеры составляют 14 × 90 мм. При изготовлении применяется техпроцесс DRAM 1β (пятое поколение 10-нм класса), а объём равен 128 Гбайт. Решения SOCAMM2 производятся по наиболее передовой технологии Micron — DRAM 1γ (шестое поколение памяти 10-нм класса). По сравнению с оригинальными модулями ёмкость SOCAMM2 увеличилась в полтора раза при сохранении прежних габаритных размеров. Энергетическая эффективность при этом повысилась более чем на 20 %. По сравнению с сопоставимыми по классу решениями DDR5 RDIMM энергоэффективность улучшена более чем на 66 %. Заявленная скорость передачи данных достигает 9,6 Гбит/с на контакт. Таким образом, по заявлениям Micron, технологии, положенные в основу SOCAMM2, превращают маломощную память LPDDR5X, изначально разработанную для смартфонов, в эффективные решения для дата-центров. При этом модульная конструкция SOCAMM2 и инновационная технология стекирования повышают удобство обслуживания и облегчают проектирование серверов с жидкостным охлаждением. Пробные поставки образцов новой памяти уже начались. Micron принимает активное участие в разработке спецификации JEDEC SOCAMM2 и тесно сотрудничает с отраслевыми партнёрами с целью вывода решений на коммерческий рынок. Пока что модули SOCAMM используются в NVIDIA GB300. |

|