Материалы по тегу: socamm

|

04.11.2025 [16:35], Сергей Карасёв

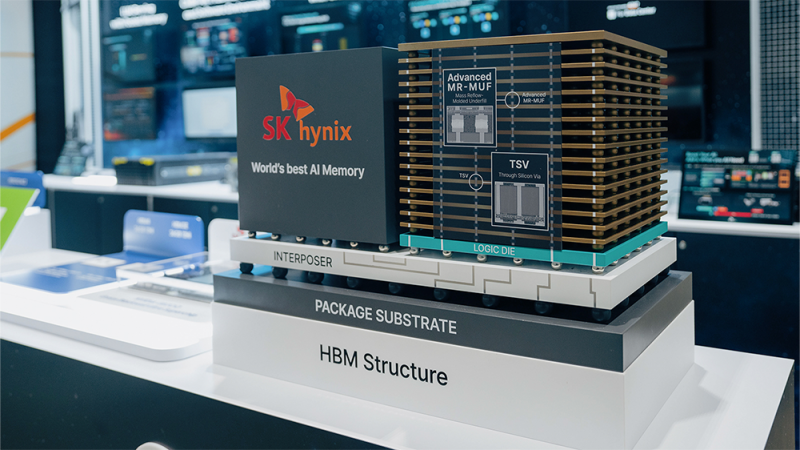

SK hynix разрабатывает AI-D — память для устранения узких мест в ИИ-системахКомпания SK hynix, по сообщению ресурса Blocks & Files, проектирует память нового типа AI DRAM (AI-D) для высокопроизводительных ИИ-платформ. Изделия нового типа будут предлагаться в трёх модификациях — AI-D O (Optimization), AI-D B (Breakthrough) и AI-D E (Expansion), что, как ожидается, позволит устранить узкие места современных систем. SK hynix является одним из лидеров рынка памяти HBM (Hgh Bandwidth Memory) для ИИ-ускорителей. Однако достижения в данной сфере отстают от развития GPU, из-за чего возникает препятствие в виде «стены памяти»: наблюдается разрыв между объёмом и производительностью HBM и вычислительными возможностями ускорителей. Проще говоря, GPU простаивают в ожидании данных. Одним из способов решения проблемы является создание кастомизированных чипов HBM, предназначенных для удовлетворения конкретных потребностей клиентов. Вторым вариантом SK hynix считает выпуск специализированной памяти AI-D, спроектированной для различных ИИ-нагрузок. В частности, вариант AI-D O предполагает разработку энергосберегающей высокопроизводительной DRAM, которая позволит снизить общую стоимость владения ИИ-платформ. Для таких изделий предусмотрено применение технологий MRDIMM, SOCAMM2 и LPDDR5R. Продукты семейства AI-D B помогут решить проблему нехватки памяти. Такие изделия будут отличаться «сверхвысокой ёмкостью с возможностью гибкого распределения». Упомянуты технологии CMM (Compute eXpress Link Memory Module) и PIM (Processing-In-Memory). Это означает интеграцию вычислительных возможностей непосредственно в память, что позволит устранить узкие места в перемещении данных и повысить общее быстродействие ИИ-систем. Ёмкость AI-D B составит до 2 Тбайт — в виде массива из 16 модулей SOCAMM2 на 128 Гбайт каждый. Причём память отдельных ускорителей сможет объединяться в общее адресное пространство объёмом до 16 Пбайт. Любой GPU сможет заимствовать свободную память из этого пула для расширения собственных возможностей по мере роста нагрузки. Наконец, архитектура AI-D E подразумевает использование памяти, включая HBM, за пределами дата-центров. SK hynix планирует применять DRAM в таких областях, как робототехника, мобильные устройства и платформы промышленной автоматизации.

26.10.2025 [14:15], Сергей Карасёв

Micron представила 192-Гбайт модули памяти SOCAMM2 для ИИ-серверовКомпания Micron Technology анонсировала компактные модули оперативной памяти SOCAMM2 (Small Outline Compression Attached Memory Modules), предназначенные для использования в серверах для задачи ИИ. Изделия, выполненные на энергоэффективных чипах LPDDR5X, имеют ёмкость 192 Гбайт. Модули SOCAMM первого поколения были анонсированы в марте нынешнего года. Их размеры составляют 14 × 90 мм. При изготовлении применяется техпроцесс DRAM 1β (пятое поколение 10-нм класса), а объём равен 128 Гбайт. Решения SOCAMM2 производятся по наиболее передовой технологии Micron — DRAM 1γ (шестое поколение памяти 10-нм класса). По сравнению с оригинальными модулями ёмкость SOCAMM2 увеличилась в полтора раза при сохранении прежних габаритных размеров. Энергетическая эффективность при этом повысилась более чем на 20 %. По сравнению с сопоставимыми по классу решениями DDR5 RDIMM энергоэффективность улучшена более чем на 66 %. Заявленная скорость передачи данных достигает 9,6 Гбит/с на контакт. Таким образом, по заявлениям Micron, технологии, положенные в основу SOCAMM2, превращают маломощную память LPDDR5X, изначально разработанную для смартфонов, в эффективные решения для дата-центров. При этом модульная конструкция SOCAMM2 и инновационная технология стекирования повышают удобство обслуживания и облегчают проектирование серверов с жидкостным охлаждением. Пробные поставки образцов новой памяти уже начались. Micron принимает активное участие в разработке спецификации JEDEC SOCAMM2 и тесно сотрудничает с отраслевыми партнёрами с целью вывода решений на коммерческий рынок. Пока что модули SOCAMM используются в NVIDIA GB300.

20.03.2025 [13:14], Сергей Карасёв

Micron, Samsung и SK hynix представили компактные модули памяти SOCAMM для ИИ-серверовКомпании Micron, Samsung и SK hynix, по сообщению ресурса Tom's Hardware, создали модули оперативной памяти SOCAMM (Small Outline Compression Attached Memory Modules) на основе чипов LPDDR5X. Изделия ориентированы на ИИ-системы и серверы с пониженным энергопотреблением. Модули SOCAMM имеют размеры 14 × 90 мм, что примерно в три раза меньше по сравнению с традиционными решениями RDIMM. В состав SOCAMM входят до четырёх 16-кристальных стеков памяти LPDDR5X. Изделия нового формата спроектированы специально для дата-центров, оптимизированных для приложений ИИ. Micron разработала модули SOCAMM ёмкостью 128 Гбайт, при производстве которых используется техпроцесс DRAM 1β (пятое поколение 10-нм техпроцесса). Скоростные показатели не раскрываются. Но Micron говорит о производительности на уровне 9,6 GT/s (млрд пересылок в секунду). В свою очередь, SK Hynix на конференции NVIDIA GTC 2025 представила модули SOCAMM, для которых заявлена скорость в 7,5 GT/s. Отмечается, что на оперативную память приходится значительная доля энергопотребления серверов. Например, в системах, оснащённых терабайтами DDR5, энергопотребление ОЗУ может превышать энергопотребление CPU. Компания NVIDIA учла это при разработке чипов Grace, выбрав для них память LPDDR5X, которая потребляет меньше энергии, чем DDR5. Однако в случае GB200 Grace Blackwell пришлось использовать впаянные блоки LPDDR5X, поскольку самостоятельные стандартные модули LPDDR5X не соответствовали требованиям в плане ёмкости. Изделия SOCAMM, массовое производство которых уже началось, позволяют решить данную проблему. На первом этапе модули SOCAMM будут применяться в серверах на основе суперчипов NVIDIA GB300. Но пока не ясно, станут ли решения SOCAMM отраслевым стандартом, поддерживаемым JEDEC, или останутся фирменным продуктом, разработанным Micron, Samsung, SK hynix и NVIDIA для серверов, построенных на чипах Grace и Vera. |

|