Материалы по тегу: cxl

|

07.02.2026 [13:53], Сергей Карасёв

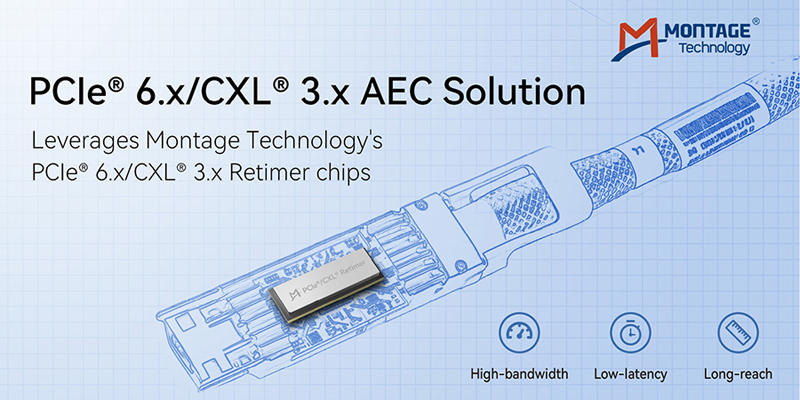

Montage Technology представила активные кабели PCIe 6.x/CXL 3.xКомпания Montage Technology объявила о разработке активных электрических кабелей (AEC) PCIe 6.x/CXL 3.x, предназначенных для организации высокоскоростного интерконнекта с низкой задержкой в дата-центрах, ориентированных на ресурсоёмкие задачи ИИ и НРС. Отмечается, что на фоне стремительного внедрения ИИ и продолжающегося развития облачных вычислений быстро растёт нагрузка на ЦОД. При этом PCIe остаётся основным стандартом для обмена данными между CPU, GPU, сетевыми картами и высокопроизводительными хранилищами. Интерконнект на базе PCIe применяется как в рамках серверных стоек, так и в составе суперузлов, в связи с чем требуется увеличивать протяжённость соединений. В таких условиях, подчёркивает Montage Technology, медные линии на базе AEC имеют решающее значение для обеспечения целостности сигнала на больших расстояниях.

Источник изображения: Montage Technology Кабели Montage Technology PCIe 6.x/CXL 3.x с ретаймером используют фирменные блоки SerDes и передовую архитектуру DSP. Применён высокоплотный форм-фактор OSFP-XD. Говорится о развитых функциях мониторинга и диагностики каналов связи, что упрощает обслуживание систем и повышает их эффективность. Возможно использование в инфраструктурах с различными топологиями. В разработке решения, как утверждается, принимали участие ведущие китайские производители кабелей. Проведены успешные тесты на совместимость с CPU, xPU, коммутаторами PCIe, сетевыми адаптерами и другими устройствами. В дальнейшем компания Montage Technology намерена развивать направление высокоскоростного интерконнекта, включая выпуск ретаймеров PCIe 7.0.

06.02.2026 [10:53], Владимир Мироненко

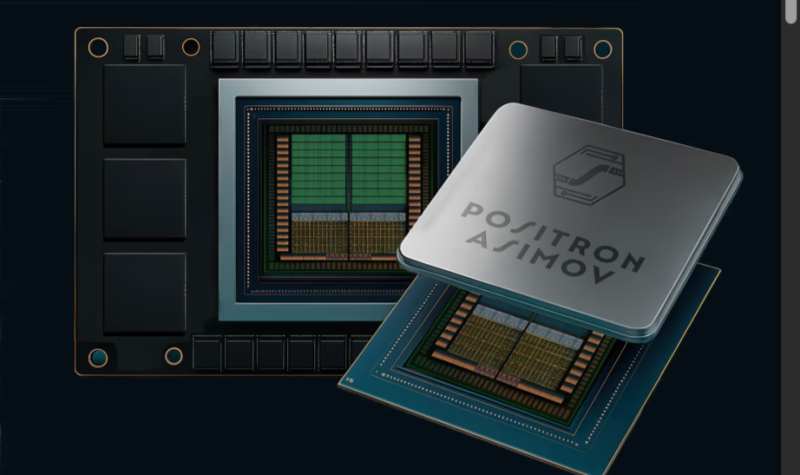

Без дефицитной HBM: Positron AI готовит ИИ-ускоритель Asimov с терабайтами LPDDR5xКомпания Positron AI сообщила о привлечении $230 млн инвестиций в рамках переподписанного раунда финансирования серии B, в результате которого оценка её рыночной стоимости превысила $1 млрд. Раунд возглавили ARENA Private Wealth, Jump Trading и Unless при участии новых инвесторов Qatar Investment Authority (QIA), Arm и Helena, а также существующих инвесторов Valor Equity Partners, Atreides Management, DFJ Growth, Resilience Reserve, Flume Ventures и 1517. Объявление было сделано на мероприятии Web Summit Qatar, что подчеркивает растущий международный авторитет компании, отметил ресурс eWeek. На то, чтобы перейти в категорию единорогов, Positron AI потребовалось 34 месяца. Positron AI отметила решение Jump Trading стать одним из лидеров раунда после того, как эта компания стала её клиентом. «Для рабочих нагрузок, которые нас интересуют, узкими местами всё чаще становятся память и энергопотребление, а не теоретические вычисления», — сказал технический директор Jump Trading. — В ходе наших тестов Positron Atlas показал примерно в три раза меньшую сквозную задержку, чем сопоставимая система на базе NVIDIA H100, при оценке рабочих нагрузок инференса, в готовом к производству корпусе с воздушным охлаждением и цепочкой поставок, которую мы можем спланировать». Полученные инвестиции позволят ускорить выход платформы следующего поколения Asimov, разработанной на заказ. Компания планирует завершить тестирование Asimov к концу III квартала, а пробные версии появятся в конце I квартала 2027 года. В Asimov будет использоваться память LPDDR (без HBM), но возможность приблизиться к теоретической пиковой пропускной способности памяти означает, что компании и не нужно полагаться на HBM для быстрой генерации токенов, сообщил ресурсу EE Times технический директор Positron. Вычислительные элементы Asimov — это эволюция блоков Atlas с добавлением ядер Arm и улучшенным интерконнектом. Расширить память LPDDR5x в Asimov можно с помощью CXL — с 864 Гбайт до 2,3 Тбайт на чип. Чип позволяет создать два независимых домена памяти, чтобы лучше утилизировать её. Хосит-интерфейс чипа — PCI 6.0 x32. Хотя LPDDR5x дешевле и ёмче HBM, она значительно уступает ей по пропускной способности. Если ускорители Rubin от NVIDIA оснащены 288 Гбайт памяти HBM4 с пиковой пропускной способностью 22 Тбайт/с, то для Asimov, по-видимому, потолок составляет около 3 Тбайт/с, пишет The Register (в спецификациях указано 2,76 Тбайт/с). По словам Positron, разница в том, что её чипы действительно могут использовать 90 % этой пропускной способности, в то время как GPU на базе HBM в реальных условиях едва достигают 30 % пиковой пропускной способности, хотя память Rubin даже в этом случае примерно в 2,4 раза быстрее, чем у Asimov. Компания сообщила, что 400-Вт чип оснащён систолической матрицей 512×512, работающей на частоте 2 ГГц и поддерживающей типы данных TF32, FP16/BF16, FP8, NVFP4 и INT4. Эта матрица управляется рядом ядер Armv9 и может быть переконфигурирована, например, в 128×512 (GEMV) или 512×128 (GEMM), в зависимости от того, какой вариант более выгоден для решения конкретной задачи. Четыре чипа Asimov образуют 4U-платформу Titan с воздушным охлаждением и пропускной способностью между чипами 16 Тбит/с. Компания отметила, что Asimov рассчитан на поддержку 2 Тбайт памяти на ускоритель и 8 Тбайт памяти на систему Titan с аналогичной пропускной способностью памяти, как у ускорителя NVIDIA Rubin. В масштабе стойки это означает объём памяти более 100 Тбайт. До 4096 систем Titan (16384 ускорителя) могут быть объединены в единый масштабируемый домен с более чем 32 Пбайт памяти. Это достигается с помощью чистого межчипового интерконнекта, а не коммутируемых масштабируемых сетей, как в стоечных архитектурах NVIDIA или AMD. Positron подчеркнула, что её архитектура, ориентированная на память, открывает доступ к высокоэффективным задачам инференса, включая большие языковые модели с длинным контекстом, агентные рабочие процессы и модели медиа и видео следующего поколения.

19.01.2026 [09:03], Сергей Карасёв

Panmnesia представила чип-коммутатор Panswitch с поддержкой PCIe 6.4 и CXL 3.2Южнокорейский стартап Panmnesia анонсировал чип-коммутатор Panswitch (модель H1SW06245ACFAA), предназначенный для использования в составе масштабных HPC-платформ и дата-центров, ориентированных на задачи ИИ. Кроме того, представлена сопутствующая плата для разработчиков PanRDK. Как утверждается, Panswitch — это первое в мире изделие в своём классе, полностью поддерживающее ключевые функции, описанные в спецификации CXL 3.2, включая Port-based Routing (PBR). Это позволяет соединять тысячи устройств в единой вычислительной среде посредством CXL. Отмечается, что Panswitch даёт возможность формировать сети с различными топологиями — от простых древовидных структур до ячеистых (mesh) конфигураций, систем Dragonfly и пр. Это позволяет оптимизировать пути передачи данных в зависимости от конкретных рабочих нагрузок. В состав Panswitch входит проприетарный CXL-контроллер Panmnesia со сверхнизкой задержкой. Говорится о поддержке интерфейса PCIe 6.4. В целом, как подчёркивает разработчик, Panswitch обеспечивает повышенную производительность и эффективность при крупномасштабных развёртываниях ИИ. В свою очередь, плата PanRDK предназначена для тестирования чипа-коммутатора в реальных условиях. Это решение оснащено FPGA, благодаря чему может быть настроено для работы в качестве различных устройств, в том числе CXL CPU, CXL GPU и пула памяти CXL. Предусмотрены слоты MCIO и CEM, что позволяет сформировать полноценную систему с поддержкой CXL. Плата совместима не только с изделиями Panmnesia, но и с широким спектром решений сторонних производителей, соответствующих стандарту CXL. Поставки чипов Panswitch и пилотных систем уже начались.

07.01.2026 [16:47], Владимир Мироненко

В попытке догнать Broadcom: Marvell купила за $540 млн XConn, разработчика коммутаторов PCIe и CXLПосле объявления о заключении окончательного соглашения о приобретении XConn Technologies, поставщика передовых коммутаторов PCIe и CXL, акции Marvell Technology пошли в гору — их цена выросла на 4 %, сообщил ресурс SiliconANGLE. Сумма сделки составляет около $540 млн. Примерно 60 % будет выплачено наличными и 40 % — акциями Marvell, при этом стоимость последних будет определяться на основе средневзвешенной цены за 20 дней. По словам Marvell, приобретение позволит ей расширить портфель коммутационных решений продуктами XConn PCIe и CXL, а также укрепить команду по разработке решений UALink высококвалифицированными инженерами XConn с глубокими знаниями в области высокопроизводительной коммутации. Коммутация необходима для соединения большого количества ИИ-микросхем в гигантские кластеры для запуска мощных больших языковых моделей. Компания XConn, основанная в 2020 году и финансируемая частными инвесторами, выпустила в марте 2024 года первый в отрасли коммутатор Apollo с поддержкой CXL 2.0 и PCIe 5.0, обеспечивающий 256 линий. Его выпускает TSMC с использованием техпроцессов N16 и N5, сообщил ресурс Data Center Dynamics. Затем она выпустила в марте 2025 года гибридный коммутатор Apollo 2, объединяющий CXL 3.1 и PCIe 6.2 на одном чипе в конфигурациях от 64 до 260 линий. Когда-то Marvell считалась одной из самых перспективных компаний после NVIDIA, и многие эксперты полагали, что она станет одним из главных бенефициаров бума ИИ. Однако она по-прежнему уступает по темпам развития NVIDIA, а заодно и своему основному конкуренту Broadcom, который разрабатывает чипы как минимум для четырёх гиперскейлеров. Покупка XConn призвана исправить ситуацию, дополняя недавнее приобретение Celestial AI. По словам Marvell, приобретение XConn добавит проверенные коммутационные продукты PCIe и CXL, IP-решения и инженерные кадры для расширения команды по масштабируемым коммутаторам UALink. «В сочетании с предстоящим приобретением Celestial AI мы будем иметь все возможности для предоставления клиентам производительности, гибкости и архитектурного выбора, необходимых им по мере роста размеров и сложности ИИ-систем», — отметил он. Сделка позволит Marvell расширить свой общий целевой рынок (Total Addressable Market, TAM) за счёт освоения растущих возможностей коммутаторов PCIe и CXL. PCIe-коммутаторы становятся критически важным строительным блоком для ИИ-инфраструктуры. В то же время CXL необходим для дезагрегации памяти в современных ЦОД. Сочетание контроллеров памяти Marvell CXL с коммутаторами XConn CXL позволит создать самый обширный в отрасли портфель коммутаторов для поддержки ресурсоёмких ИИ-задач. На данный момент у XConn насчитывается более чем 20 клиентов. Marvell ожидает, что продукты XConn CXL и PCIe начнут приносить доход во II половине 2027 финансового года. Также ожидается, что в результате сделки Marvell получит около $100 млн дополнительного дохода в 2028 финансовом году.

28.11.2025 [12:50], Сергей Карасёв

Сервер Giga Computing R284-A91 получил 16 отсеков для CXL-модулей формата E3.S 2TКомпания Giga Computing (дочерняя структура Gigabyte) анонсировала сервер R284-A91-AAL3 для задач НРС. Новинка, выполненная в форм-факторе 2U, использует аппаратную платформу Intel с двумя процессорами Xeon 6900 семейства Granite Rapids-AP с показателем TDP до 500 Вт. Система располагает 24 слотами для модулей оперативной памяти DDR5: могут использоваться изделия RDIMM-6400 и MRDIMM-8800. В оснащение входят контроллер ASPEED AST2600, два сетевых порта 1GbE на основе Intel I350-AM2, выделенный сетевой порт управления 1GbE, два разъёма USB 3.0 Type-A и интерфейс Mini-DP. Предусмотрено по одному слоту PCIe 5.0 x16 для карты FHHL и OCP NIC 3.0 (PCIe 5.0 x16). Особенностью сервера является наличие 16 фронтальных отсеков для CXL-модулей формата E3.S 2T (PCIe 5.0 x8). Такие изделия, в частности, ранее представила компания Innodisk. Модули CXL дают возможность масштабировать ресурсы памяти системы для выполнения сложных задач. Кроме того, там же предусмотрены четыре посадочных места для E3.S NVMe SSD (PCIe 5.0). Есть два тыльных отсека для SFF-устройств SATA/SAS-4 с возможностью горячей замены и два внутренних коннектора M.2 для SSD формата 2280/22110 с интерфейсом PCIe 5.0 x4. Габариты сервера составляют 438 × 87,5 × 815 мм, масса — 21,2 кг. Питание обеспечивают два блока с резервированием мощностью 2700 Вт с сертификатом 80 PLUS Titanium. Применено воздушное охлаждение с четырьмя системными вентиляторами диаметром 80 мм. Диапазон рабочих температур — от +10 до +35 °C. Гарантирована совместимость с Windows Server 2025. Опционально может быть установлен модуль TPM 2.0.

22.11.2025 [12:23], Сергей Карасёв

В Microsoft Azure появились инстансы с Intel Xeon 6 и CXL-памятьюКорпорация Microsoft в партнёрстве с SAP и Intel запустила в облаке Azure новые виртуальные машины семейства M-Series с технологией Compute Express Link (CXL). В настоящее время эти инстансы работают в режиме закрытого тестирования. Интерконнект CXL основан на интерфейсе PCIe: он обеспечивает высокоскоростную передачу данных с малой задержкой между хост-процессором и буферами памяти, акселераторами, устройствами ввода/вывода и пр. На днях была обнародована спецификация CXL 4.0, которая предусматривает поддержку линий с пропускной способности до 128 ГТ/с. Новые инстансы Azure базируются на процессорах Intel Xeon 6500P и 6700P поколения Granite Rapids-SP. В этих чипах реализована технология CXL Flat Memory Mode, которая позволяет оптимизировать соотношение вычислительных мощностей и ресурсов памяти. Это обеспечивает улучшенную масштабируемость без ущерба для производительности, что важно при работе с приложениями, требовательными к объёму памяти. В случае представленных виртуальных машин Azure поддержка CXL способствует более эффективной работе SAP S/4HANA. В частности, достигается большая гибкость в плане конфигурирования платформы, что помогает удовлетворять потребности конкретных бизнес-пользователей при одновременном снижении совокупной стоимости владения. «Инновационная архитектура инстансов с поддержкой CXL Flat Memory Mode ориентирована на повышение экономической эффективности и оптимизацию производительности программных решений SAP», — отмечает Intel.

20.11.2025 [09:34], Владимир Мироненко

Представлены спецификации CXL 4.0: PCIe 7.0, агрегация портов и поддержка четырёх ретаймеровКонсорциум CXL Consortium объявил о выходе спецификации Compute Express Link (CXL) 4.0, которая более соответствует растущим требованиям рабочих нагрузок в современных ЦОД. По словам Дерека Роде (Derek Rohde), президента CXL Consortium, также занимающего пост главного инженера в NVIDIA, выпуск спецификации CXL 4.0 открывает новую веху в развитии когерентной работы с памятью, удваивая пропускную способность по сравнению с предыдущим поколением и предлагая новые функции. Он отметил, что выпуск отражает стремление компаний-членов консорциума продвигать открытые стандарты, которые способствуют инновациям и открывают всей отрасли возможность масштабироваться для будущих моделей использования. Новый стандарт CXL 4.0 получил поддержку линий с пропускной способности в 128 ГТ/с, что вдвое больше по сравнению с предыдущим, причём без увеличения задержки. Фактически стандарт приведён в соответствие с PCI Express 7.0. Также были сохранены ранее реализованные улучшения протокола CXL 3.0: FLIT-кадры размером 256 байт, FEC и CRC. Сохраняется и полная обратная совместимость со всеми предыдущими версиями — CXL 3.x, 2.0, 1.1 и 1.0. Впрочем, тут есть нюансы. В CXL 4.0 появилась агрегация физических портов (Bundled Ports) в один логический порт, позволяющая одному устройству Type 1/2 одновременно подключаться к нескольким root-портам хоста или коммутатора для увеличения пропускной способности. При этом один из физических портов должен быть полнофункциональным, тогда как остальные порты могут быть оптимизированы исключительно для передачи данных. Агрегированные порты также поддерживают 256-байт FLIT-режим, но как минимум один физический порт должен поддерживать 68-байт режим ради обратной совместимости. Также спецификация реализует поддержку до четырёх ретаймеров для увеличения дальности передачи сигнала, повышение надёжности (RAS), снижение количества возможных ошибок, а также более детальные и актуальные отчёты о проблемах. Кроме того, появилась функция Post Package Repair (PPR), позволяющая хосту инициировать проверку устройства во время загрузки, т.е. до запуска рабочих нагрузок. Комментируя выход CXL 4.0, Alibaba заявила, что как член-учредитель консорциума CXL, она активно поддерживает экосистему CXL: «Мы рады выпуску CXL 4.0, поддерживающей PCIe 7.0 и объединение портов, что отвечает растущим требованиям к пропускной способности памяти для современных облачных рабочих нагрузок. Кроме того, CXL 4.0 повышает надёжность и удобство обслуживания памяти благодаря расширенным возможностям оповещения об ошибках и резервирования памяти. Мы считаем, что CXL 4.0 представляет собой еще одну важную веху на пути к компонуемым, масштабируемыми надёжным стоечным архитектурам для ЦОД нового поколения».

04.11.2025 [16:35], Сергей Карасёв

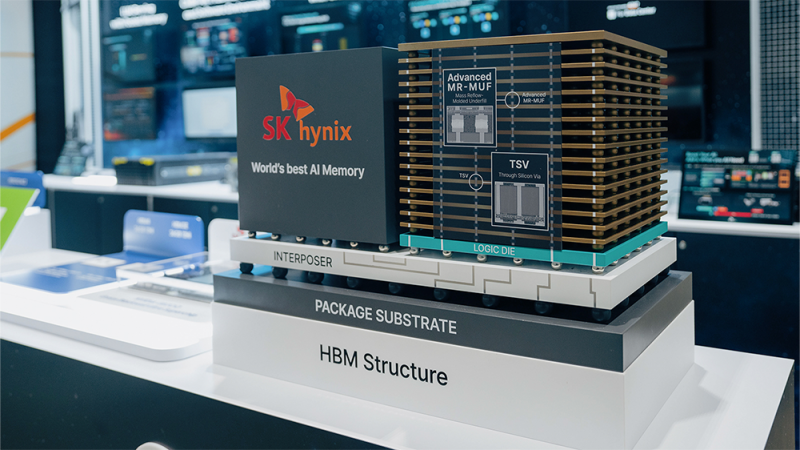

SK hynix разрабатывает AI-D — память для устранения узких мест в ИИ-системахКомпания SK hynix, по сообщению ресурса Blocks & Files, проектирует память нового типа AI DRAM (AI-D) для высокопроизводительных ИИ-платформ. Изделия нового типа будут предлагаться в трёх модификациях — AI-D O (Optimization), AI-D B (Breakthrough) и AI-D E (Expansion), что, как ожидается, позволит устранить узкие места современных систем. SK hynix является одним из лидеров рынка памяти HBM (Hgh Bandwidth Memory) для ИИ-ускорителей. Однако достижения в данной сфере отстают от развития GPU, из-за чего возникает препятствие в виде «стены памяти»: наблюдается разрыв между объёмом и производительностью HBM и вычислительными возможностями ускорителей. Проще говоря, GPU простаивают в ожидании данных. Одним из способов решения проблемы является создание кастомизированных чипов HBM, предназначенных для удовлетворения конкретных потребностей клиентов. Вторым вариантом SK hynix считает выпуск специализированной памяти AI-D, спроектированной для различных ИИ-нагрузок. В частности, вариант AI-D O предполагает разработку энергосберегающей высокопроизводительной DRAM, которая позволит снизить общую стоимость владения ИИ-платформ. Для таких изделий предусмотрено применение технологий MRDIMM, SOCAMM2 и LPDDR5R. Продукты семейства AI-D B помогут решить проблему нехватки памяти. Такие изделия будут отличаться «сверхвысокой ёмкостью с возможностью гибкого распределения». Упомянуты технологии CMM (Compute eXpress Link Memory Module) и PIM (Processing-In-Memory). Это означает интеграцию вычислительных возможностей непосредственно в память, что позволит устранить узкие места в перемещении данных и повысить общее быстродействие ИИ-систем. Ёмкость AI-D B составит до 2 Тбайт — в виде массива из 16 модулей SOCAMM2 на 128 Гбайт каждый. Причём память отдельных ускорителей сможет объединяться в общее адресное пространство объёмом до 16 Пбайт. Любой GPU сможет заимствовать свободную память из этого пула для расширения собственных возможностей по мере роста нагрузки. Наконец, архитектура AI-D E подразумевает использование памяти, включая HBM, за пределами дата-центров. SK hynix планирует применять DRAM в таких областях, как робототехника, мобильные устройства и платформы промышленной автоматизации.

30.09.2025 [20:43], Владимир Мироненко

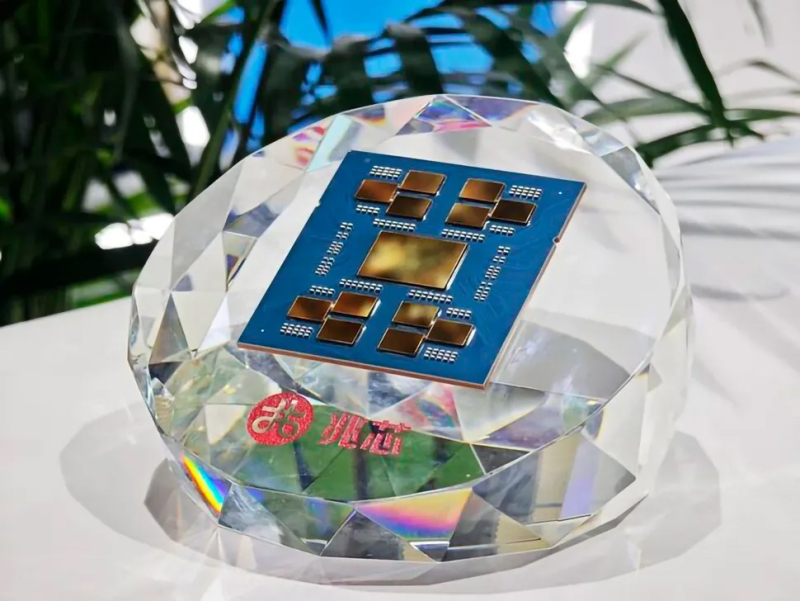

Zhaoxin представила серверный x86-процессор KH-50000: 96 ядер без SMT и 12 каналов DDR5-5200Китайская компания Zhaoxin объявила о выходе серверного процессора нового поколения KH-50000 на x86-совместимой архитектуре Zhaoxin Century Avenue, анонсированного в июле этого года. Новинка предназначена для обеспечения выполнения широкого круга задач, включая обработку ИИ-нагрузок, облачные вычисления и Big Data. KH-50000 представлен в двух вариантах: с 72 и 96 ядрами. Чип имеет размеры 72 × 76 мм. Используется чиплетная компоновка с массивным IO-кристаллом и четырьмя вычислительными кластерами, содержащими по три чиплета каждый. Каждый чиплет содержит до 8 ядер и 32 Мбайт кеша L3 — итого 96 ядер и 384 Мбайт кеша L3. KH-50000 поддерживает 32- и 64-бит инструкции x86, включая SSE4.2, AVX и AVX2. Также реализована поддержка виртуализации, но нет поддержки SMT. 96-ядерный вариант KH-50000 поддерживает тактовую частоту 2,2 ГГц и 3,0 ГГц в режиме Boost. У 72-ядерного чипа базовая тактовая частота составляет 2,6 ГГц и 3,0 ГГц в режиме Boost. Данных о TDP нет. KH-50000 поддерживает масштабирование 2S и 4S, что позволяет увеличить количество ядер до 384 на сервер. Для межчипового взаимодействия используется интерфейс ZPI 5.0 (Zhaoxin Processor Interconnect) собственной разработки. Процессор поддерживает до 12 каналов DDR5-5200 ECC RDIMM, что позволяет использовать в общей сложности до 3 Тбайт памяти, в отличие от 2 Тбайт DDR4-3200 у предшественника KH-40000. Также сообщается о наличии 128 линий PCIe 5.0 совместимых с ZPI/CXL и 16 линий PCIe 4.0 по сравнению со 128 линиями PCIe 3.0 в KH-40000. Количество портов SATA и USB несколько уменьшилось по сравнению с KH-4000, но теперь реализована поддержка спецификации USB 3.2 Gen2 (четыре порта). Также указана поддержка 12 портов SATA III. Как отметил ресурс Tom's Hardware, в соответствии с требованиями безопасности Китая KH-5000 поддерживает фирменные стандарты шифрования SM2, SM3 и SM4. В частности, Zhaoxin интегрировала в KH-50000 чип четвёртого поколения от National Technology (вероятно, NS350). Этот чип соответствует требованиям безопасности китайского стандарта криптографических модулей GM/T 0012-2020 и международному стандарту TPM 2.0 (SPEC 1.59).

30.09.2025 [15:12], Сергей Карасёв

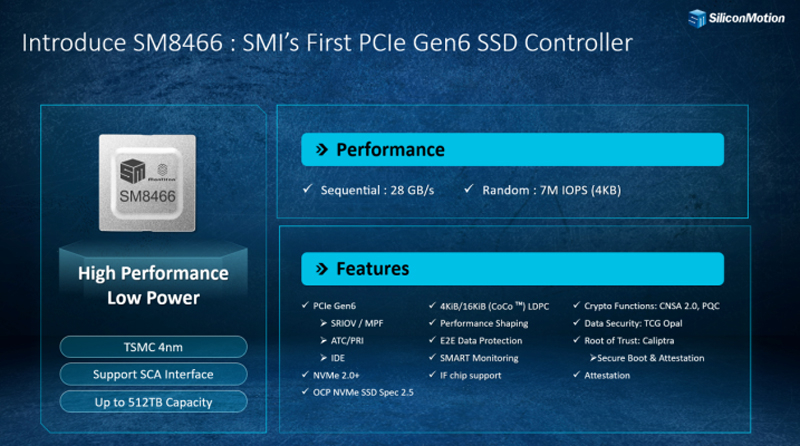

Samsung готовит SSD вместимостью 512 Тбайт с интерфейсом PCIe 6.0На мероприятии Global Memory Innovation Forum (GMIF) 2025 в Шэньчжэне (Китай) сразу несколько крупных компаний поделились планами по разработке SSD с интерфейсом PCIe 6.0, предназначенных для дата-центров и корпоративных инфраструктур. В частности, Samsung работает над продуктами CMM-D с CXL 3.1 и PCIe 6.0, выпуск которых запланирован на следующий год. Дебютируют SSD семейства PM1763 с интерфейсом PCIe 6.0, которые, по утверждениям южнокорейского производителя, обеспечат вдвое большую производительность и значительно более высокую энергоэффективность по сравнению с нынешними накопителями. Энергопотребление заявлено на уровне 25 Вт. Ориентировочно в 2027 году Samsung планирует выпустить SSD с интерфейсом PCIe 6.0 вместимостью до 512 Тбайт. Такие устройства будут предлагаться в форм-факторе EDSFF 1T. Кроме того, компания готовит флеш-память Z-NAND седьмого поколения с технологией GIDS (GPU-Initiated Direct Storage Access), которая позволит ИИ-ускорителям напрямую обращаться к устройствам хранения Z-NAND, минуя CPU и RAM. В свою очередь, Silicon Motion раскрыла дополнительную информацию о контроллере SM8466 с поддержкой PCIe 6.0, о разработке которого стало известно в январе нынешнего года. Это изделие обеспечит скорость последовательной передачи данных до 28 Гбайт/с и величину IOPS до 7 млн. Новый контроллер позволит создавать SSD ёмкостью до 512 Тбайт. Производиться решение будет на предприятии TSMC по 4-нм технологии. Выпуск первых SSD корпоративного класса на основе SM8466 намечен на 2026 год.

Источник изображения: Silicon Motion via Wccftech Накопители PCIe 6.0 также проектирует InnoGrit. Эта компания в 2026-м намерена представить устройства, у которых показатель IOPS (операций ввода/вывода в секунду) будет достигать 25 млн. |

|