Материалы по тегу: risc-v

|

09.03.2026 [16:39], Владимир Мироненко

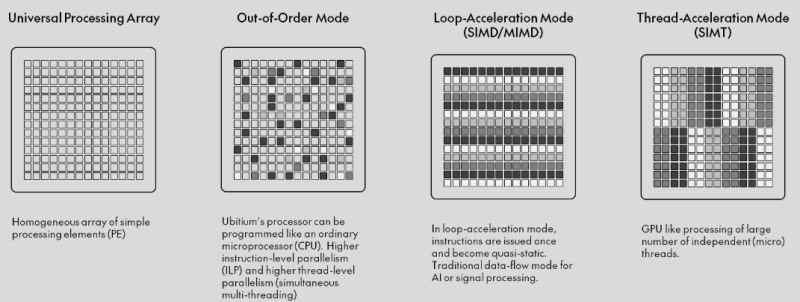

Ubitium стала на шаг ближе к выпуску универсального RISC-V процессора, заменяющего CPU, GPU, DSP и FPGAНемецкий стартап Ubitium объявил о завершении стадии tape-out (финальный этап проектирования) универсального RISC-V-процессора, изготовленного по 8-нм техпроцессу Samsung Foundry и предназначенного для рынка встроенных вычислительных систем автомобилей, промышленного оборудования и бытовой электроники, включая радарные и многосенсорные сигнальные цепи, аудио и голосовую связь в реальном времени, компьютерное зрение, периферийный ИИ, промышленный человеко-машинный интерфейс (HMI) и т.д. В основе процессора Ubitium лежит «универсальный процессорный массив» (Universal Processing Array) — программно-определяемая система с 256 элементами, объединяющая функции CPU, GPU, DSP и FPGA и способная мгновенно менять режимы выполнения во время работы. Такая унификация позволяет чипу переключаться между режимом работы в качестве CPU общего назначения для обслуживания ОС и режимом работы в качестве ИИ-ускорителя, избегая задержек при передаче данных между отдельными чипами.

Источник изображения: Ubitium Завершение tape-out на 8-нм техпроцессе Samsung подтверждает работоспособность основного процессорного массива и интерфейса LPDDR5. Для Ubitium доказательство того, что один процессор может обрабатывать общие вычислительные задачи, задачи обработки в реальном времени и задачи ИИ на одном кристалле, является важным шагом на пути к коммерческой жизнеспособности, отметил EE Times. «Это решение претворяет давно существующую концепцию в жизнь», — заявил Мартин Форбах (Martin Vorbach), технический директор Ubitium. «Встроенные системы переросли архитектуры, на которые сегодня опирается отрасль. Консолидация больше не является необязательной. Она неизбежна», — добавил он. Технология, лежащая в основе этого проекта, совершенствовалась более 15 лет. Для её воплощения в жизнь Форбахом совместно с рядом специалистов была создана в 2024 году компания Ubitium. Ускорить разработку позволило привлечение $3,7 млн в рамках посевного раунда в конце прошлого года, который совместно возглавили Runa Capital, Inflection и KBC Focus Fund. Инвестиции позволили Ubitium проверить архитектуру и подготовить наборы для разработки (IDK) для первых клиентов. «Индустрия процессоров объёмом $500 млрд построена на жёстких границах между вычислительными задачами», — сказал Хён Шин Чо (Hyun Shin Cho), генеральный директор Ubitium и соучредитель. — Мы стираем эти границы. Наш универсальный процессор делает всё — CPU, GPU, DSP, FPGA — на одном чипе, в одной архитектуре. Это не просто постепенное улучшение. Это смена парадигмы. Это архитектура процессора, которую требует эпоха ИИ». Как отметил EE Times, завершение tape-out продукта — это не просто большая победа для Ubitium. Это также поворотный момент для экосистемы RISC-V. Открытая архитектура RISC-V используется большей частью для создания обычных ядер, которые полагаются на внешние ускорители для сложных рабочих нагрузок. Ubitium расширяет границы использования архитектуры, сохраняя полную совместимость с RISC-V. Процессор поддерживает стандартные наборы инструментов RISC-V для разработки ПО и может работать под управлением Linux и RTOS. Кроме того, унифицированный программный стек устраняет необходимость в компиляторах для конкретного поставщика или проприетарных языках, что позволяет быстро внедрять инновации и сократить время разработки. Компания сотрудничает с Samsung Foundry и ADTechnology для завершения проектирования и с Siemens Digital Industries Software — для проверки микросхемы (pre-silicon validation). Вторая стадия tape-out запланирована на конец этого года, а серийное производство начнётся в 2027 году, сообщила компания.

17.02.2026 [13:57], Владимир Мироненко

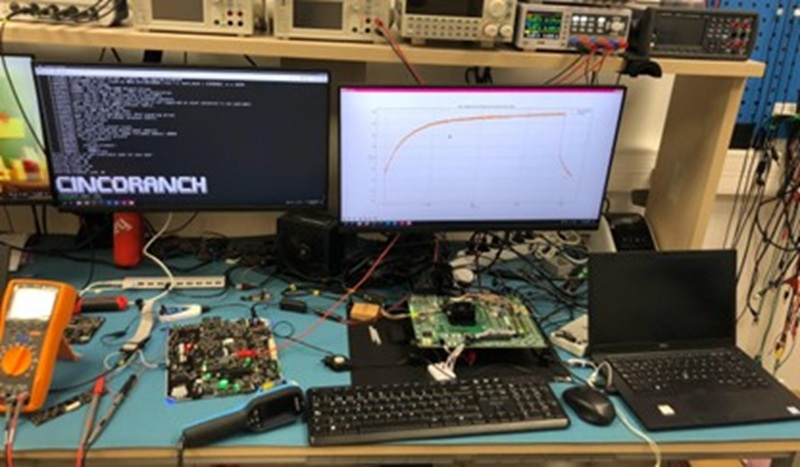

Первый европейский суверенный RISC-V-процессор Cinco Ranch изготовлен по техпроцессу Intel 3Лаборатория суперкомпьютерных вычислений (BZL) Национального центра суперкомпьютерных вычислений Барселоны (BSC-CNS) сообщила об успешном запуске тестового чипа Cinco Ranch TC1 на архитектуре RISC-V, изготовленного по передовому техпроцессу Intel 3. В заявлении отмечено, что результаты подтверждают надёжность конструкции и жизнеспособность вычислительной архитектуры на базе открытой платформы RISC-V. «Это достижение является ключевым этапом в процессе разработки чипа и качественным скачком на пути к суверенным суперкомпьютерным технологиям в Европе», — подчеркнула BZL, отметив, что готовый чип предлагает открытую, гибкую альтернативу, свободную от зависимости от проприетарных архитектур крупных транснациональных корпораций. Проект связан с Европейской инициативой по процессорам (EPI), целью которой является разработка отечественных процессоров для будущих европейских суперкомпьютеров и промышленных систем. «Успешная стабильная загрузка Linux и проверка достижения чипом ожидаемых частот подтверждают зрелость конструкции и качество работы, проделанной командами BZL», — говорит исследователь BSC и координатор аппаратной части лаборатории Zettascale в Барселоне. Cinco Ranch TC1 — это первый чип, произведенный в академической среде с использованием 3-нм техпроцесса Intel 3. На этапе проектирования, из-за невозможности прямого доступа к этой технологии, BZL провела внутренние оценки на сопоставимом техпроцессе TSMC N7, что позволило оценить конструкцию перед окончательной реализацией. Сообщается, что структура Cinco Ranch TC1 основана на трёх взаимодополняющих процессорных блоках, предназначенных для совместной работы и охвата различных вычислительных профилей. В чипе используются три блока RISC-V на одном кристалле, каждый из которых ориентировано на специализированные рабочие нагрузки. Три ядра используют микроархитектуры Sargantana, Lagarto Ka и Lagarto Ox, с основным упором на эффективность, векторные нагрузки и скалярную обработку соответственно. Подсистема CPU занимает всего 3,2 мм² на крошечном кристалле площадью 15,2 мм², который также включает высокоскоростные интерфейсы, такие как PCIe 5.0 и DDR5. Для сравнения, площадь CCD восьмиядерного процессора AMD Zen 5 составляет около 71 мм², и для этого чиплета также требуется отдельный кристалл I/O, отметил ресурс HotHardware.com.  Cinco Ranch TC1 был протестирован на оценочной плате Hawk Canyon V2, разработанной Intel для первоначальной проверки чипа после его производства. Следующим этапом станет функциональное тестирование и тестирование производительности, оптимизация ПО и полная проверка системы. В мае 2025 года на Cinco Ranch TC1 (Test Chip 1) была успешно загружена ОС Linux, а в июле 2025 года, после получения партии из 500 чипов, начались работы по характеризации и проверке. Вся партия продемонстрировала высокую функциональную производительность, при этом большинство устройств успешно запустили все три интегрированных процессора чипа. Также результаты тестов подтверждают, что Cinco Ranch TC1 работает на частоте до 1,25 ГГц, что превышает консервативные оценки, сделанные на этапе проектирования. Для BZL и её партнёров это достижение является важной вехой и доказательством того, что разработанные в Европе процессоры с открытой ISA могут быть реализованы на передовых технологиях производства и воплощены в реальных кремниевых решениях. Для Европы — это значимый шаг к технологической автономии в HPC. А для Intel это демонстрация того, что её бизнес может оказывать всестороннюю поддержку передовым внешним клиентам в сложных гетерогенных проектах.

10.02.2026 [12:09], Сергей Карасёв

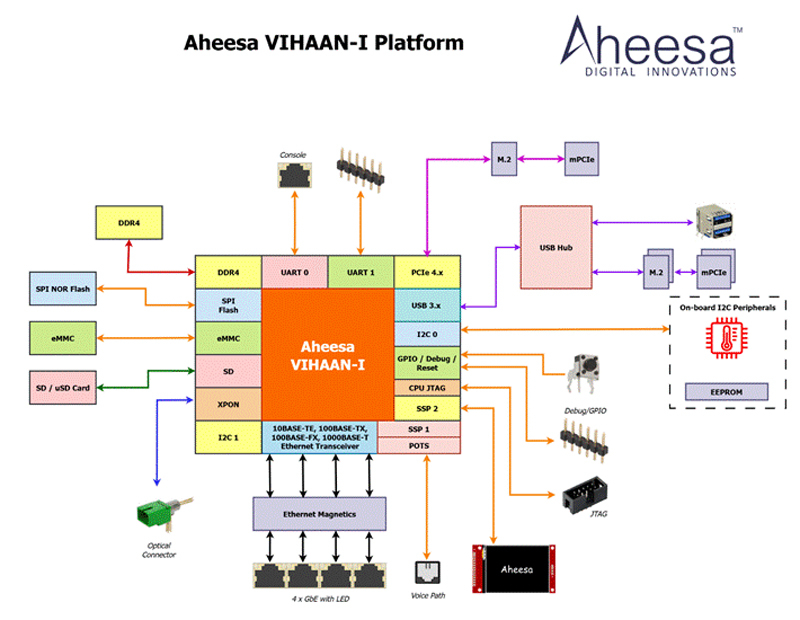

Стартап Aheesa создал первый в Индии чип RISC-V для PON-сетейИндийский безфабричный стартап Aheesa Digital Innovations, по сообщению EE Times, завершил разработку первой в стране «системы на чипе» (SoC) с архитектурой RISC-V, ориентированной на волоконно-оптические сети широкополосного доступа в интернет. Изделие получило обозначение VIHAAN-I. Новинка предназначена для инфраструктур GPON (Gigabit Passive Optical Network) и EPON (Ethernet Passive Optical Network). Решение объединяет на одном кристалле вычислительные ресурсы, средства управления и широкополосного доступа. VIHAAN-I является частью платформы Aheesa Seshnag. В состав новинки входит RISC-V-ядро C-DAC Vega. Реализована поддержка памяти DDR4 и SPI NOR, флеш-карт SD и microSD, а также интерфейса xPON. Заявлена совместимость с Ethernet-стандартами 10BASE-TE, 100BASE-TX, 100BASE-FX и 1000BASE-T. Изделие объединяет многопортовый гигабитный Ethernet и прямое оптоволоконное соединение. Среди прочего упомянуты интерфейсы USB и PCIe (четыре линии) с возможностью использование модулей M.2 и mini-PCIe. Кроме того, предусмотрена интегрированная поддержка голосовой связи. SoC будет производиться на предприятии UMC с применением 28-нм технологии.

Источник изображения: Aheesa Digital Innovations / EE Times Выбор архитектуры RISC-V, как заявляет Aheesa Digital Innovations, обусловлен прежде всего соображениями безопасности. Поддерживаются стандартные сетевые функции, такие как коммутация Ethernet, маршрутизация, службы межсетевого экрана, VPN, протокол динамической конфигурации хоста и пр. Примерно на 60% решение состоит из стандартных лицензированных компонентов, таких как контроллеры памяти и интерфейсные блоки. Заявлена совместимость с последними версиями ядра Linux. Aheesa Digital Innovations основана в 2021 году Шридхараном Мани (Sridharan Mani), который занимает пост генерального директора. Компания получила поддержку в рамках индийской программы стимулирования разработок. Стартап сотрудничает с рядом государственных учреждений, включая Министерство электроники и информационных технологий (MEITy) и Центр развития передовых вычислительных технологий (C-DAC). Aheesa Digital Innovations намерена предлагать свои решения OEM- и ODM-производителям, системным интеграторам и дистрибьюторам, которые поставляют устройства телекоммуникационным операторам. В дальнейшем стартап планирует активно развивать семейство собственных SoC. В частности, готовятся решения с поддержкой 10GbE и Wi-Fi 7.

07.02.2026 [23:53], Игорь Осколков

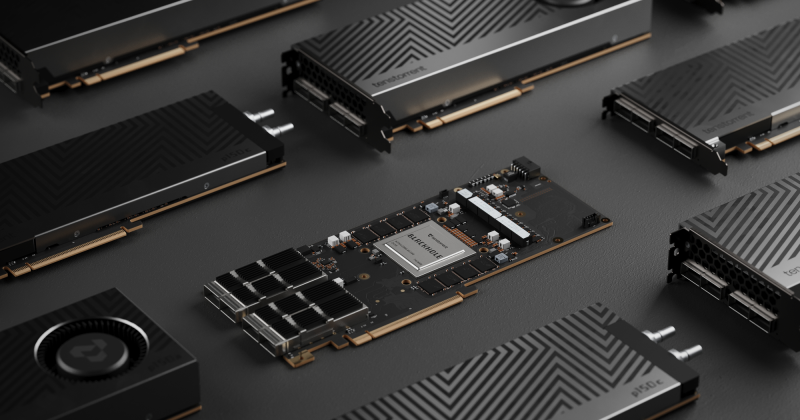

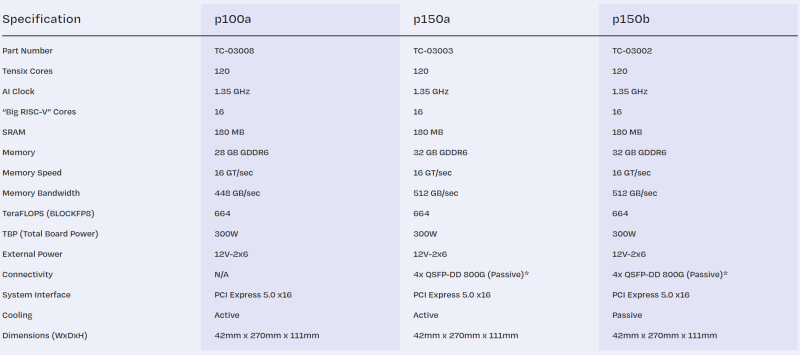

Tenstorrent принудительно «отрезала» ИИ-ядра у ускорителей Blackhole, даже у уже проданныхРазработчик ИИ-ускорителей Tenstorrent, возглавляемый Джимом Келлером, неожиданно изменил конфигурацию своих чипов Blackhole. Последнее обновление прошивки для карт p150a/p150b принудительно снижает количество активных ИИ-ядер Tensix со 140 до 120, причём это касается уже выпущенных и проданных карт. Описание p150a/p150b на сайте тоже обновилось. Хотя количество ядер уменьшится более чем на 14 %, компания обещает, что в типичных рабочих нагрузках разница в производительности составит лишь 1–2 %. Однако если ранее пиковая заявленная производительность составляла 774 Тфлопс (BLOCKFP8), то теперь она равна 664 Тфлопс. Таким образом, формально вычислительные блоки у младшей p100a и старших p150a/p150b теперь одинаковые. Вся разница в технических характеристиках между ними, помимо сетевого интерфейса, теперь заключается в объёме и скорости набортной памяти — 28 Гбайт GDDR6 (448 Гбайт/с) у младшей модели против 32 Гбайт (512 Гбайт/с) у старших. Причину такого внезапного изменения характеристик компания не назвала. В Сети есть предположения, что Tenstorrent таким образом пытается, к примеру, увеличить выход годных чипов. Или же она столкнулась с какими-то другими ограничениями, к примеру, по питанию и/или охлаждению. В частности, в том же самом апдейте снижен TDP у решения Galaxy на базе ускорителей Wormhole, чтобы, как сказано в описании, оставаться в рамках лимита по питанию. Наконец, изменение может быть связано и с подготовкой двухчиповой версии ускорителей Blackhole p300, которые получат 64 Гбайт памяти (1 Тбайт/с).

31.01.2026 [20:37], Сергей Карасёв

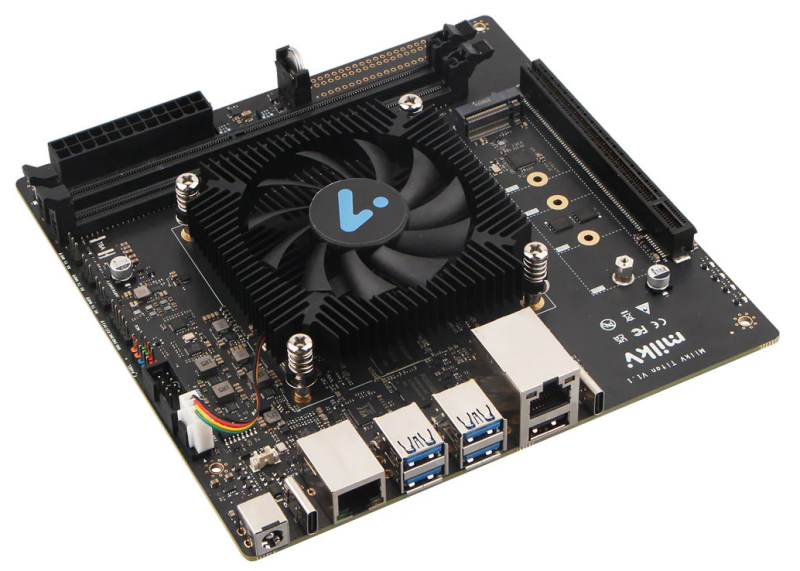

RISC-V, Wi-Fi 6, Bluetooth 5.2 и 10GbE SFP+: представлен одноплатный компьютер Milk-V Jupiter 2Компания Shenzhen MilkV Technology (Milk-V), по сообщению ресурса CNX Software, готовит к выпуску одноплатный компьютер Jupiter 2 на архитектуре RISC-V. Это, как утверждается, первое изделие в своём классе с поддержкой профиля RVA23. Устройство может использоваться для работы с приложениями ИИ. В основу положен чип SpacemiT K3 в составе модуля K3-CoM260 (Jupiter 2 NX). Процессор объединяет восемь 64-бит вычислительных ядер RISC-V X100 с тактовой частотой до 2,4 ГГц и восемь ИИ-ядер RISC-V A100. Заявленная производительность на операциях INT4 достигает 60 TOPS. В состав изделия входит графический ускоритель Imagination Technologies BXM4-64-MC1 с поддержкой Vulkan 1.3, OpenGL 3.0 и OpenGL ES 1.1/2.0/3.2. Блок VPU обеспечивает возможность декодирования материалов H.265, H.264, VP9 в формате до 4K (120 к/с) и кодирования H.265, H.264 до 4K (60 к/с). Объём оперативной памяти LPDDR5-6400 достигает 32 Гбайт, вместимость флеш-накопителя UFS — 256 Гбайт. Есть слот microSD. Модуль K3-CoM260 подключается через 260-контактный коннектор SO-DIMM. Одноплатный компьютер несёт на борту адаптеры Wi-Fi 6 и Bluetooth 5.2. Доступны разъём M.2 M-Key 2280 для SSD с интерфейсом PCIe 3.0 x4 и коннектор M.2 B-Key 2242/3052 (PCIe x2 + USB 2.0) для модема 4G/5G (плюс слот для карты Nano SIM). Реализованы сетевые порты 10GbE SFP+ на базе RealTek RTL8127 и 1GbE RJ45 на основе RealTek RTL8211. Присутствуют интерфейсы USB 3.2 Type-C (DP 1.2 Alt Mode и USB PD) и USB 3.2 Type-C OTG, а также четыре разъёма USB 2.0 Type-A. Новинка выполнена в форм-факторе Pico-ITX Plus с размерами 100 × 86 мм (103 × 90,5 × 35 мм с радиатором охлаждения). Питание может подаваться через 2-контактный коннектор ATX или порт USB Type-C. Говорится о совместимости с Bianbu 3.0 OS, Ubuntu 26.04, OpenHarmony 6.0, OpenKylin 2.0, Deepin 25 и Fedora. Цена — от $200.

16.01.2026 [23:14], Владимир Мироненко

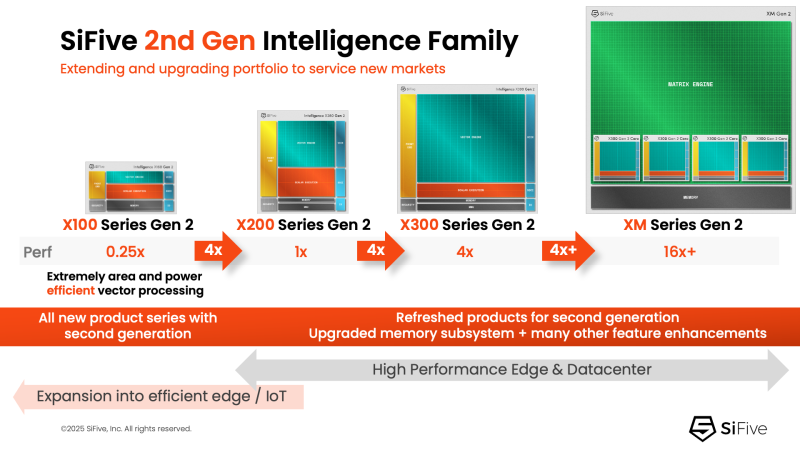

NVIDIA добралась до RISC-V: NVLink Fusion пропишется в серверных процессорах SiFiveПродолжая укреплять свои лидирующие позиции на ИИ-рынке NVIDIA не скрывает стремления построить целую экосистему ИИ-платформ с привязкой к своим решениям. Эти усилия активизировались в прошлом году с анонсом технологии NVLink Fusion, позволяющей использовать NVLink в чипах сторонних производителей. Как стало известно, вслед за Arm, Intel и AWS, присоединившимися к программе в прошлом году, экосистема NVLink Fusion пополнилась первым поставщиком чипов на архитектуре RISC-V — компанией SiFive, которая объявила о планах внедрить NVLink Fusion в свои будущие чипы для ЦОД. SiFive отметила, что ИИ-вычисления вступают в фазу, когда архитектурная гибкость и энергоэффективность так же важны, как и пиковая пропускная способность. Нагрузки обучения и инференса растут быстрее, чем энергетические бюджеты, заставляя операторов ЦОД переосмыслить способы подключения и управления CPU, GPU и ASIC. Теперь производительность на Вт и эффективность перемещения данных стали первостепенными ограничениями при проектировании чипов. Патрик Литтл (Patrick Little), президент и генеральный директор SiFive заявил, что ИИ-инфраструктура больше не строится из универсальных компонентов, а разрабатывается совместно с нуля: «Интегрируя NVLink Fusion с высокопроизводительными вычислительными подсистемами SiFive, мы предоставляем клиентам открытую и настраиваемую платформу CPU, которая легко интегрируется с ИИ-инфраструктурой NVIDIA, обеспечивая исключительную эффективность в масштабах ЦОД». Пресс-релиз SiFive не содержит каких-либо конкретных планов по продуктам, кроме сообщения о добавления поддержки NVLink к «высокопроизводительным решениям для ЦОД» SiFive. Предположительно, речь идёт о чипах платформы Vera Rubin или более поздних, т.е. о NVLink 6. Для SiFive — как поставщика IP-блоков RISC-V CPU — интерес заключается в использовании интерконнекта NVLink-C2C, который обеспечивает высокоскоростную, полностью кеш-когерентную связь между CPU и GPU, и это предпочтительный способ подключения к ускорителям NVIDIA в высокоинтегрированных системах. В рамках экосистемы NVLink Fusion NVIDIA предлагает NVLink-C2C в качестве лицензируемого IP-ядра, что упростит интеграцию шины в будущие чипы SiFive. Для SiFive это может стать конкурентным преимуществом. Кроме того, NVIDIA объявила о поддержке RISC-V — на эту архитектуру портируют CUDA и драйверы, что со временем откроет для компании новые рынки.

13.01.2026 [13:47], Сергей Карасёв

8 ядер RISC-V и слот PCIe 4.0 x16: вышла плата Milk-V Titan формата Mini-ITXКомпания Shenzhen MilkV Technology (Milk-V), по сообщению ресурса CNX Software, начала приём заказов на плату Milk-V Titan. Особенностью новинки является наличие полноценного слота PCIe 4.0 x16, в который может быть установлен дискретный графический ускоритель. Изделие выполнено в форм-факторе Mini-ITX с размерами 170 × 170 мм. Применён процессор UltraRISC UR-DP1000 с восемью ядрами UR-CP100 (RV64GCBHX) с архитектурой RISC-V, работающими на частоте до 2 ГГц. Говорится о поддержке аппаратной виртуализации и расширений RISC-V RV64 ISA H (v1.0), а также о полной совместимости со стандартом RVA22. Возможно подключение вентилятора охлаждения с ШИМ-управлением. Предусмотрены два слота для модулей оперативной памяти DDR4-3200 ECC суммарным объёмом до 64 Гбайт. Имеется коннектор M.2 M-Key для SSD с интерфейсом PCIe 4.0 x4 (NVMe). Плата получила сетевой порт 1GbE RJ45 и дополнительный порт управления 100MbE RJ45 (плюс разъёмы USB Type-C и USB 2.0 Type-A для BMC-накопителя). Есть четыре порта USB 3.0 Type-A и отладочный порт USB Type-C. Питание (12 В) подаётся через DC-коннектор 5,5/2,5 мм или разъём АТХ. Энергопотребление при полной нагрузке составляет около 30 Вт, в режиме простоя — приблизительно 14 Вт. У платы Milk-V Titan нет собственного видеовыхода, поэтому для подключения мониторов необходимо установить видеокарту: говорится, что новинка протестирована на работу с адаптерами AMD RX 9070 XT, RX 580, RX 550 и R5 230. Заявлена совместимость с Ubuntu, Debian и Fedora. Приобрести решение можно по ориентировочной цене $330.

17.12.2025 [17:38], Сергей Карасёв

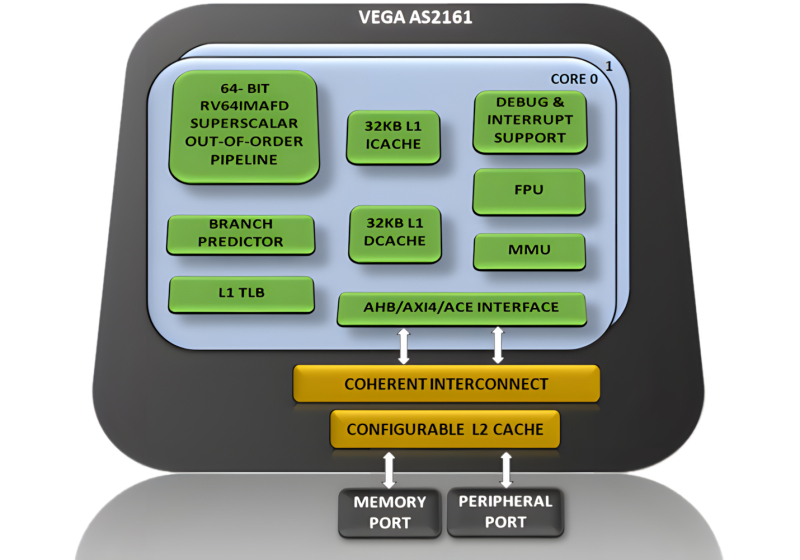

Два ядра и 1 ГГц: Индия создала собственный процессор DHRUV64 с архитектурой RISC-VЦентр развития передовых вычислений (C-DAC), ведущая научно-исследовательская организация Индии, представил процессор собственной разработки DHRUV64 (Vega AS2161). Утверждается, что на сегодняшний день это самый совершенный чип, полностью спроектированный внутри страны. Изделие объединяет два вычислительных ядра с архитектурой RISC-V (набор инструкций RV64IMAFD). Максимальная тактовая частота составляет 1 ГГц. Конструкция включает кеш L1 и L2 (с возможностью конфигурирования), блок управления памятью (MMU), контроллер прерываний на уровне платформы (до 127 прерываний), внешний интерфейс, совместимый с AXI4/ACE, и пр. Процессор использует Гарвардскую архитектуру с отдельной памятью для команд (инструкций) и данных. Упомянута поддержка расширенного алгоритма прогнозирования ветвлений (BTB, BHT, RAS) и векторных прерываний. Изделие изготавливается по 28-нм технологии; показатель TDP не раскрывается. Говорится о совместимости с Linux. В качестве возможных сфер применения названы инфраструктура 5G, автомобильные системы, бытовая электроника, платформы промышленной автоматизации и интернет вещей (IoT). «Выпуск DHRUV64 знаменует собой важную веху в развитии самодостаточной экосистемы процессоров в Индии. Благодаря использованию открытой архитектуры исключаются затраты на лицензирование. Это способствует долгосрочному внедрению процессора в различных областях», — отмечается в заявлении местных властей. Кроме того, C-DAC раскрыл планы по дальнейшей разработке процессоров на базе RISC-V. В частности, готовятся решения DHANUSH64 и DHANUSH64+ в виде «систем на кристалле» (SoC). Они получат четыре вычислительных ядра с максимальной частотой 1,2 ГГц и 2,0 ГГц соответственно. Для первого из этих чипов предусмотрен 28-нм техпроцесс, для второго — 14- или 16-нм.

11.12.2025 [01:30], Владимир Мироненко

Qualcomm купила разработчика серверных RISC-V процессоров Ventana Micro SystemsQualcomm объявила о приобретении стартапа Ventana Micro Systems, специализирующегося на разработке серверных процессоров на основе архитектуры RISC-V. Как пояснила компания, это свидетельствует о её приверженности развитию RISC-V, открытой альтернативы Arm и x86. По словам Qualcomm, сделка расширит её возможности в разработке чипов на базе RISC-V и кастомных процессоров Oryon за счёт интеграции имеющегося у Ventana опыта в этом направлении. Qualcomm делает ставку на Oryon в деле завоевания новых рынков, в том числе серверного, в рамках продолжающейся диверсификации бизнеса. Компания получила ядра Oryon, совместимые с Arm, вместе с приобретением стартапа Nuvia за $1,4 млрд в 2021 году. Oryon уже прописались в процессорах Snapdragon X Series. Теперь же Qualcomm намерена предпринять ещё одну попытку разработки серверных процессоров. Прошлая попытка с процессорами Centriq 2400 завершилась неудачей. В этом году эти усилия были подкреплены наймом бывшего главного архитектора Intel Xeon и сделкой по приобретению Alphawave Semi за 2,4 млрд, пишет CRN. Qualcomm, которая уже использует архитектуру RISC-V в некоторых продуктах за пределами рынков ПК и серверов, заявила, что вклад Ventana укрепит ее «технологическое лидерство в эпоху ИИ во всех сферах бизнеса», указывая на большие надежды, возлагаемые на это приобретение: «Мы считаем, что ISA RISC-V имеет потенциал для продвижения технологий процессоров, обеспечивая инновации во всех продуктах. Приобретение Ventana Micro Systems знаменует собой важный шаг на нашем пути к предоставлению передовых в отрасли технологий процессоров на базе RISC-V для всех продуктов». Ventana Micro Systems, базирующаяся в Купертино (Cupertino), была основана в 2018 году. Как сообщается на сайте компании, разработанная ею технология изготовления процессоров на базе RISC-V, обеспечивает «производительность, сопоставимую с новейшими процессорами на Arm и x86 для ЦОД». Эта технология доступна в виде многоядерных UCIe-чиплетов, а также может быть интегрирована другими компаниями в собственные SoC. И первое, и второе поколение процессоров Ventana Veyron предлагало до 192 ядер RISC-V. Свои разработки Ventana рассчитывает использовать в различных сферах, включая облачные вычисления, корпоративные ЦОД, системы гиперскейлеров, 5G, периферийные вычисления, ИИ и машинное обучение, а также автомобильную промышленность. По некоторым оценкам, годовая выручка Ventana составляет $37,4 млн. Так что ей в каком-то смысле повезло, поскольку даже достаточно заметные разработчики решений на базе RISC-V часто не могут конкурировать с крупными игроками и готовы или продаться кому-нибудь, или вынуждены сокращать штат, или закрываться целиком. Сообщение о покупке Ventana последовало после того, как Qualcomm в сентябре заявила о «полной победе» в судебном споре с Arm, которая добивалась прекращения продаж и уничтожения всех чипов Qualcomm, содержащих ядра Oryon, из-за предполагаемых нарушений лицензий на архитектуру Arm со стороны Qualcomm и Nuvia. Любопытно, что в 2022 году Ventana объявила о стратегическом партнёрстве с Intel в рамках IFS. Последняя годом позже закрыла программу Pathfinder for RISC-V.

10.12.2025 [09:24], Владимир Мироненко

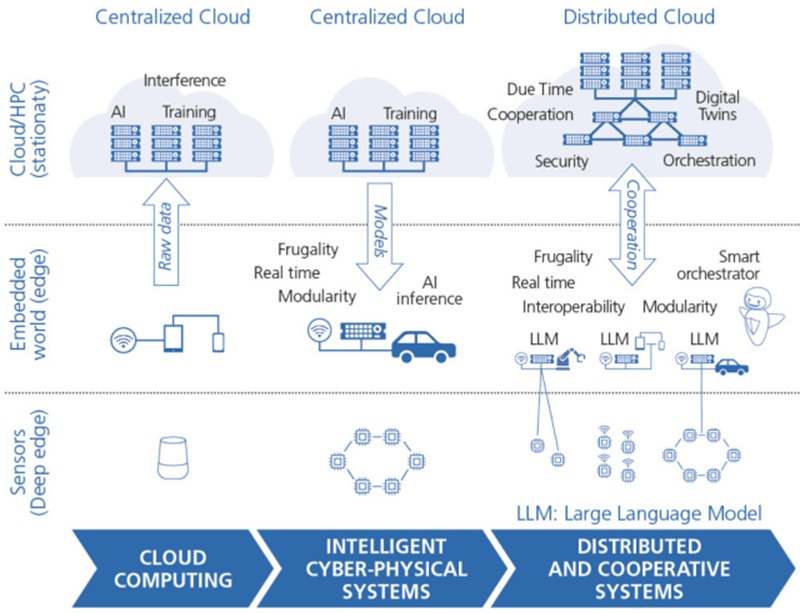

Евросоюз опять захотел занять 20 % рынка полупроводников, но Китай и США уже «улетели в стратосферу»Реализация планов Европейского союза по ускорению движения к технологическому суверенитету вступает во вторую, критически важную фазу, пишет ресурс EE Times. «Европейский закон о чипах» (European Chips Act), принятый в апреле 2023 года с целью ускорения развития новых технологий и увеличения доли Европы на мировом рынке чипов до 20 % к 2030 году с нынешних 10 %, позволил мобилизовать капитал — общие обязательства по инвестициям достигли почти €69 млрд. «Закон ЕС о чипах 2.0», который находится в разработке, должен внести существенные изменения в политику ЕС и сместить акцент с производственных обязательств на обеспечение разработки следующего поколения вычислительной архитектуры и развитии кадрового потенциала. Цели ЕС также включают укрепление внутренних цепочек поставок полупроводников в Европе и стимулирование инвестиций в микросхемы для нагрузок ИИ и HPC, пишет ioplus.nl. Стратегический поворот в стратегии ЕС находит свою интеллектуальную опору в HiPEAC Vision 2025 — долгосрочной программе европейской сети HiPEAC (High Performance, Edge and Cloud computing), утверждающей, что будущая значимость Европы зависит не только от производства «кремния», но и от освоения парадигмы распределённых, устойчивых вычислений, которая сегодня требуется для развития ИИ-технологий. Эта переоценка становится неотложной необходимостью в связи с реальностью «Великого перераспределения» (Great Reallocation) США, которые с помощью агрессивной торговой политики и масштабных субсидий способствуют оттоку из Европы в США капиталов и интеллектуальной собственности, создавая сложности для развития промышленной базы Европы. Кроме того, отмечается «стратосферный рост» компаний из США и Китае на фоне отставания европейских в сфере вычислительных технологий. HiPEAC Vision, определяющее курс европейских исследований в области вычислений на следующее десятилетие, основано на концепции «Следующей вычислительной парадигмы» (Next Computing Paradigm, NCP), охватывающей высокопроизводительные экзафлопсные вычисления, облачные ЦОД и встраиваемые устройства. HiPEAC рассматривает этот сдвиг как динамичную совокупность «федеративных и распределённых сервисов». У Европы всё ещё есть сильные стороны, такие как мощный потенциал для разработки «периферийных и локальных устройств», сложных киберфизических систем (cyber-physical systems, CPS) и инструментов промышленной автоматизации. Важнейшим аспектом в NCP краткосрочной перспективе является использование и развитие «распределённого агентного ИИ» с акцентом на локальной обработке данных и федеративности с целью снижения зависимость от централизованных иностранных решений гиперскейлеров для обеспечения безопасности критически важных данных и инфраструктуры. Хотя сейчас Евросоюз готов признать, что отказаться от американских облаков «почти невозможно». При этом и гиперскейлеры признают, что уже не могут гарантировать суверенитет данных в Европе.

Источник изображения: HiPEAC, Denis Dutoit, CEA/EE Times Хотя «Европейский закон о чипах» позволил привлечь иностранные инвестиции, включая крупные проекты в Германии и Франции, углубленный анализ показывает «структурные ограничения, которые угрожают его долгосрочной эффективности». Также наблюдается перекос в пользу компаний, впервые реализующих инновационные технологии в реальных условиях и в коммерческом масштабе (First-of-a-Kind, FOAK), оставляя без достаточной поддержки более широкую цепочку поставок — проектные организации, производителей оборудования и поставщиков ключевых материалов. Вдобавок заявленная цель увеличить до 20 % долю на мировом рынке полупроводников к 2030 году вызывает в отрасли большие сомнения — отсутствие гарантированного рыночного спроса в Европе остаётся «главным сдерживающим фактором для инвестиций». В связи с этим SEMI Europe выступает за фундаментальное изменение инструментария стимулирования, рекомендуя, чтобы «Закон ЕС о чипах 2.0» обязывал государства-участников блока принять рамочную программу «гармонизированных налоговых льгот для НИОКР и капитальных затрат в области полупроводников», чтобы поддерживать инновации и производство на начальном этапе для дальнейшего укрепления европейской экосистемы с упором на поставщиков материалов и оборудования, проектирование и современную упаковку. Также отмечается, что налоговые льготы обеспечивают «предсказуемость и снижение административных расходов» по сравнению со сложными грантами. Они особенно эффективны для поддержки малых и средних предприятий (МСП) и модернизации существующих объектов. Согласно HiPEAC Vision, инвестиции в экосистему МСП имеют жизненно важное значение, поскольку именно МСП являются движущей силой прорывных инноваций. Необходимость разработки единой европейской стратегии также связана с агрессивной индустриальной политикой США, пишет EE Times. После принятия программы «Миссия Генезис» (The Genesis Mission) и угрозы введения «100-% пошлины на импортные полупроводники» правительством США ведущие технологические компании направляют миллиарды долларов инвестиций в инфраструктуру США, создавая ощутимый отток капитала из Европы. Так, Nokia уже пообещала инвестировать $4 млрд в США, а Ericsson расширила свой «умный» завод в Техасе, чтобы и далее участвовать в федеральных закупках. Чтобы Европа не стала просто рынком потребления зарубежных технологий, новый закон должен принять философские основы HiPEAC Vision: приоритет экосистемы проектирования и инструментальных средств, считают эксперты. Создание совместного предприятия по разработке чипов (Chips JU) вместо KDT JU направлено на решение этой проблемы путём развитии передовых мощностей проектирования и создании платформы виртуального проектирования (VDP). Этот процесс должен быть ускорен за счёт поддержки важнейших технологий, продвигаемых HiPEAC, таких как чиплеты и открытое аппаратное обеспечение, например, RISC-V, которые снижают барьеры для выхода на рынок и уменьшают зависимость от иностранцев. Ориентируясь в своей стратегии на фокусе на распределённом интеллекте и устойчивом развитии, сформулированном HiPEAC, и внедряя механизмы промышленной поддержки, предлагаемые SEMI Europe, Европа может превратить новый «Закон о чипах» из чрезвычайной меры в последовательную долгосрочную промышленную стратегию. Этот переход закрепляет за Европой статус не только площадки для размещения иностранных заводов, но и суверенного архитектора цифрового будущего. |

|