Материалы по тегу: hpc

|

20.02.2026 [09:10], Руслан Авдеев

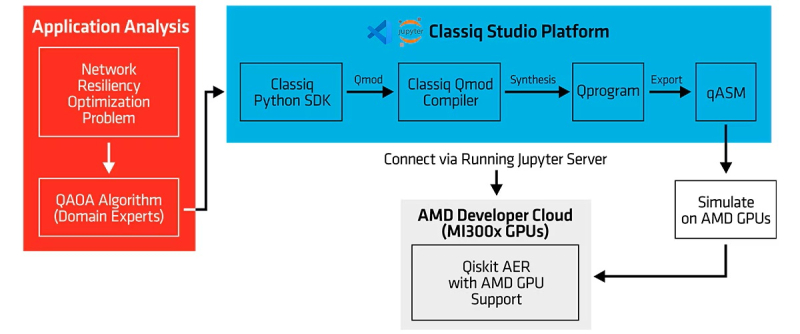

AMD, Classiq и Comcast «квантово» улучшили интернетРазработчик программного обеспечения для квантовых вычислений Classiq совместно с Comcast и AMD объявили о завершении испытаний, направленных на совершенствование доставки интернет-трафика путём использования квантовых алгоритмов для повышения надёжности маршрутизации в Сети, сообщает HPC Wire. Comcast заявила, что клиентам нужно быстрое, безопасное и надёжное подключение, но при управлении большой и динамичной сетью достижение этой цели становится сложной задачей, особенно в условиях растущего спроса. Поэтому в прошлом году были начаты эксперименты по выяснению того, как квантовое ПО и технологии могут решать реальные сетевые задачи. Результаты показали, что квантовые вычисления для оптимизации сети — не теория, а вполне практическое, масштабируемое решение. В ходе тестов решалась фундаментальная задача проектирования сети — определение независимых резервных маршрутов для сетевых узлов в общей конкурентной среде при проведении технического обслуживания и изменении топологии сети, причём с сохранением минимально возможной задержки, высокой устойчивостью к одновременным сбоям и высокой же пропускной способностью. Такая задача регулярно возникает на реальных сетях, где и без планового обслуживания не обойтись, и от одновременных сбоев никто застрахован.

Источник изображения: Dynamic Wang/unsplash.com В ходе эксперимента с использованием квантовых технологий и HPC-платформ AMD на базе ускорителей Instinct MI300X проверялась возможность квантовых алгоритмов успешно определять резервные пути для трафика в режиме реального времени в различных сценариях. Использовались как моделирование с использованием Instinct для достижения значимых вычислительных мощностей (кубитного уровня), что позволило быстро перебирать различные алгоритмы, так и реальный квантовый компьютер IonQ Forte с 29 алгоритмическими кубитами для проверки успешности реализации алгоритмов. Задача оптимизации глобальных телекоммуникационных сетей — крайне ресурсоёмкая комбинаторная задача, экспоненциально усложняющаяся по мере роста размера сети. Такая задача является идеальным вызовом для систем квантовых вычислений. По словам представителя Classiq, исследования и разработки в сфере квантовых технологий требуют быстрых итераций с внесением улучшений на каждом цикле и воспроизводимых рабочих процессов. AMD заявила, что будущее HPC — в конвергенции классических и квантовых вычислений.

19.02.2026 [09:52], Владимир Мироненко

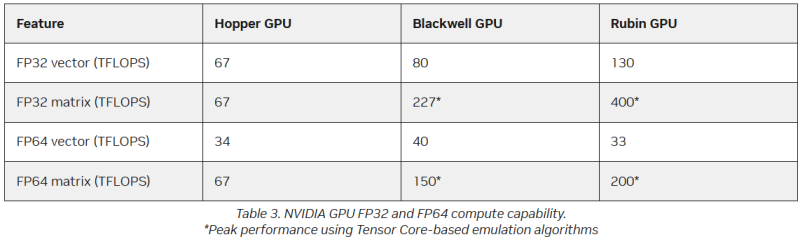

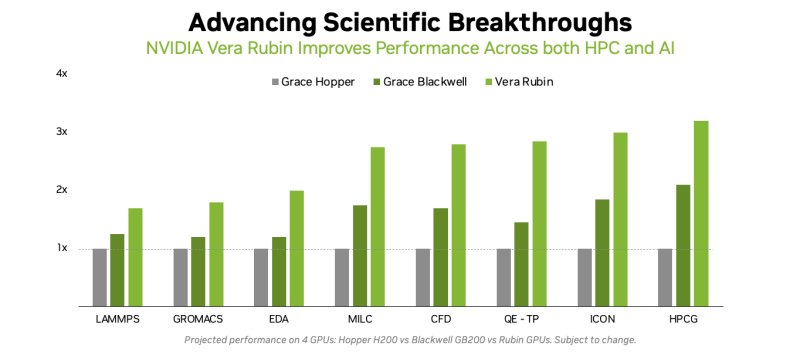

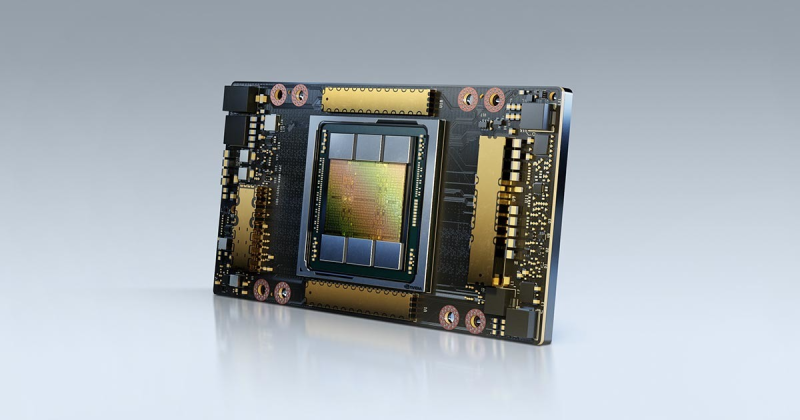

Американская «Миссия Генезис» будет во многом полагаться на «ненастоящие» FP64-вычисленияХотя последнее поколение GPU ориентировано на вычисления с более низкой точностью, которые предпочтительны для ИИ-задач, FP64-вычисления с более высокой точностью по-прежнему «очень важны» для «Миссии Генезис» (Genesis Mission) и её цели — ускорения научных открытий с помощью ИИ, заявил заместитель министра энергетики США по науке и инновациям Дарио Гил (Darío Gil) в интервью HPCwire. «В ходе обсуждений, которые я провел как с [генеральным директором AMD] Лизой Су (Lisa Su), так и с [генеральным директором NVIDIA] Дженсеном [Хуангом] (Jensen Huang), они выразили твёрдую приверженность FP64, подтвердив, что поддержка формата будет продолжаться, — сказал Гил. — Для нас это очень важно, потому что мы не рассматриваем это как замену. Это взаимодополняющие технологии». Он отметил, что для обеспечения вычислительных задач моделирования и симуляции, которые традиционно составляют основу научных вычислений, а также для новых методов ИИ, важно иметь высокопроизводительное оборудование. Гил добавил, что эти два типа вычислений будут работать вместе, чтобы поддержать цель миссии Genesis — расширение границ науки и техники на основе ИИ-технологий. «У вас есть высокоточные симуляционные коды, работающие с FP64. После проверки вы используете их в качестве основы для генерации примеров, на которых вы обучаете суррогатную модель, которую затем запускаете на ИИ-суперкомпьютере, — рассказал Гил. — В итоге вы получаете преимущества с точки зрения производительности и времени решения, часто в 10, 20, 100 раз». Он отметил, что благодаря использованию ИИ-моделей можно получить громадное повышение производительности, но оно зависит от сохранения всего цикла работ, состоящего из экспериментов, моделирования и обучения. «Если вы разорвёте этот цикл и скажете, что у вас больше нет кодов моделирования, то возникнет проблема», — сказал Гил. «Для нас это имеет фундаментальное значение, не только для устаревших кодов, которые мы должны сопровождать и которые так важны для миссии, но и для обеспечения рабочего ИИ-процесса. Поэтому для нас очень важно поддерживать различные архитектурные подходы», — добавил он. В HPC-сообществе возникла обеспокоенность по поводу отсутствия прироста производительности для FP64 в новейших GPU. Напомним, что чип NVIDIA H100, выпущенный в 2022 году, обеспечивает 67 Тфлопс в формате FP64 на тензорных ядрах (34 Тфлопс в векторных вычислениях), в то время как B200 предлагает лишь 37 Тфлопс, а B300 — всего лишь 1,3 Тфлопс. Программная эмуляция FP64-вычислений на тензорных ядрах Blackwell позволяет получить «нечестные» 150 Тфлопс, а из новейших Rubin она позволяет «выжать» 200 Тфлопс. При этом пиковая заявленная производительность векторных FP64-вычислений у Rubin составляет лишь 33 Тфлопс, т.е. нет никакого прироста в сравнении с Hopper. Отметим, что в AMD раскритиковали такой подход, заявив, что он эффективен не для всех сценариев и поэтому такое решение ещё не готово к широкому применению. В свою очередь, эксперты предупреждают, что смещение фокуса производителей на выпуск чипов для ИИ-нагрузок, которые отлично работают с вычислениями с низкой точностью, может привести к дефициту чипов с поддержкой FP64 для HPC, а это грозит потерей лидерства США в этом сегменте рынка. По мере того, как NVIDIA наращивает мощность для выполнения ИИ-задач с низкой точностью вычислений Rubin, компания будет всё больше полагаться на cuBLAS, библиотеку стандартных математических операций CUDA-X, которая эмулирует вычисления с двойной точностью на тензорных ядрах, чтобы постоянно наращивать показатели FP64-производительности. «Мы пытаемся предоставить эти возможности среде разработчиков, чтобы они могли… получить необходимую точность FP64», — заявил в декабре HPCwire Дион Харрис (Dion Harris), старший директор NVIDIA по ИИ/HPC-решениям для гиперскейлеров. Методы эмуляции NVIDIA основаны на схеме Озаки (Ozaki), позволяющей выполнять умножение матриц с высокой точностью, используя многократные вычисления с низкой точностью на тензорных ядрах. NVIDIA утверждает, что использование алгоритма Озаки оправдано, поскольку увеличение производительности FP64 путём добавления большего количества ядер CUDA фактически не повысит общую производительность HPC-приложений, но сделает чипы менее гибкими. По словам компании, анализ реальных нагрузок показывает, что «наивысшая устойчивая производительность FP64 часто достигается на умножении матриц». В Hopper для этого были отдельные аппаратные блоки, но в Blackwell и в Rubin NVIDIA больше опирается на эмуляцию. В то же время, производительность векторных FP64-вычислений остаётся критически важной для научных приложений, в которых не доминируют матричные ядра, признаёт NVIDIA, однако тут же утверждает, что в этих случаях производительность ограничивается перемещением данных через регистры, кеши и HBM, а не непосредственно вычислительными ресурсами. Поэтому сбалансированная конструкция GPU «обеспечивает достаточное количество ресурсов FP64 для насыщения доступной пропускной способности памяти, избегая избыточного выделения вычислительной мощности, которая не может быть эффективно использована». Иными словам, компания ничего менять не собирается. Проект Genesis Mission, вероятно, будет создавать разнообразные ИИ-приложения для научных и инженерных задач, и каждое из них, скорее всего, будет иметь несколько иные вычислительные потребности. Достигли ли NVIDIA и AMD оптимального баланса, используя вычислительные ядра для матричных вычислений и опираясь на эмуляцию Озаки для FP64, ещё предстоит выяснить, пишет HPCwire.

17.02.2026 [13:57], Владимир Мироненко

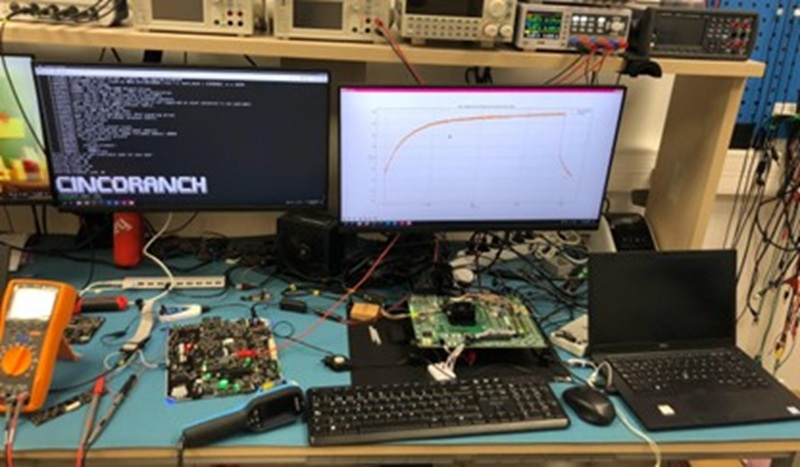

Первый европейский суверенный RISC-V-процессор Cinco Ranch изготовлен по техпроцессу Intel 3Лаборатория суперкомпьютерных вычислений (BZL) Национального центра суперкомпьютерных вычислений Барселоны (BSC-CNS) сообщила об успешном запуске тестового чипа Cinco Ranch TC1 на архитектуре RISC-V, изготовленного по передовому техпроцессу Intel 3. В заявлении отмечено, что результаты подтверждают надёжность конструкции и жизнеспособность вычислительной архитектуры на базе открытой платформы RISC-V. «Это достижение является ключевым этапом в процессе разработки чипа и качественным скачком на пути к суверенным суперкомпьютерным технологиям в Европе», — подчеркнула BZL, отметив, что готовый чип предлагает открытую, гибкую альтернативу, свободную от зависимости от проприетарных архитектур крупных транснациональных корпораций. Проект связан с Европейской инициативой по процессорам (EPI), целью которой является разработка отечественных процессоров для будущих европейских суперкомпьютеров и промышленных систем. «Успешная стабильная загрузка Linux и проверка достижения чипом ожидаемых частот подтверждают зрелость конструкции и качество работы, проделанной командами BZL», — говорит исследователь BSC и координатор аппаратной части лаборатории Zettascale в Барселоне. Cinco Ranch TC1 — это первый чип, произведенный в академической среде с использованием 3-нм техпроцесса Intel 3. На этапе проектирования, из-за невозможности прямого доступа к этой технологии, BZL провела внутренние оценки на сопоставимом техпроцессе TSMC N7, что позволило оценить конструкцию перед окончательной реализацией. Сообщается, что структура Cinco Ranch TC1 основана на трёх взаимодополняющих процессорных блоках, предназначенных для совместной работы и охвата различных вычислительных профилей. В чипе используются три блока RISC-V на одном кристалле, каждый из которых ориентировано на специализированные рабочие нагрузки. Три ядра используют микроархитектуры Sargantana, Lagarto Ka и Lagarto Ox, с основным упором на эффективность, векторные нагрузки и скалярную обработку соответственно. Подсистема CPU занимает всего 3,2 мм² на крошечном кристалле площадью 15,2 мм², который также включает высокоскоростные интерфейсы, такие как PCIe 5.0 и DDR5. Для сравнения, площадь CCD восьмиядерного процессора AMD Zen 5 составляет около 71 мм², и для этого чиплета также требуется отдельный кристалл I/O, отметил ресурс HotHardware.com.  Cinco Ranch TC1 был протестирован на оценочной плате Hawk Canyon V2, разработанной Intel для первоначальной проверки чипа после его производства. Следующим этапом станет функциональное тестирование и тестирование производительности, оптимизация ПО и полная проверка системы. В мае 2025 года на Cinco Ranch TC1 (Test Chip 1) была успешно загружена ОС Linux, а в июле 2025 года, после получения партии из 500 чипов, начались работы по характеризации и проверке. Вся партия продемонстрировала высокую функциональную производительность, при этом большинство устройств успешно запустили все три интегрированных процессора чипа. Также результаты тестов подтверждают, что Cinco Ranch TC1 работает на частоте до 1,25 ГГц, что превышает консервативные оценки, сделанные на этапе проектирования. Для BZL и её партнёров это достижение является важной вехой и доказательством того, что разработанные в Европе процессоры с открытой ISA могут быть реализованы на передовых технологиях производства и воплощены в реальных кремниевых решениях. Для Европы — это значимый шаг к технологической автономии в HPC. А для Intel это демонстрация того, что её бизнес может оказывать всестороннюю поддержку передовым внешним клиентам в сложных гетерогенных проектах.

14.02.2026 [11:52], Сергей Карасёв

В Германии запущен 54-кубитный квантовый компьютер Euro-Q-Exa в рамках проекта EuroHPCЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) объявило о запуске квантового компьютера Euro-Q-Exa, расположенного в Мюнхене (Германия). Ввод системы в эксплуатацию, как отмечается, знаменует собой важную веху в формировании современной инфраструктуры квантовых вычислений в Европе. Комплекс Euro-Q-Exa развёрнут в Суперкомпьютерном центре Лейбница (LRZ) Баварской академии наук. Проект реализован при совместной финансовой поддержке EuroHPC, Федерального министерства исследований, технологий и космоса Германии (BMFTR), а также Министерства науки и искусств Баварии (StWK). Система Euro-Q-Exa разработана компанией IQM Quantum Computers на основе платформы Radiance. Изначально машина включает 54 сверхпроводящих кубита. К концу 2026 года будет смонтирована модернизированная установка, оперирующая 150 кубитами. Благодаря интеграции Euro-Q-Exa в НРС-среду LRZ европейские исследователи смогут разрабатывать, тестировать и масштабировать приложения на основе гибридных квантово-классических вычислений в различных областях. Среди них названы исследования нейродегенеративных заболеваний, фармакология и климатическое моделирование. Европейские исследователи смогут получить доступ к системе через Мюнхенский квантовый портал (MQP) или портал EuroHPC JU. Euro-Q-Exa — один из шести квантовых компьютеров, которые устанавливаются в передовых суперкомпьютерных центрах в Европе, наряду с системами в Чехии, Франции, Италии, Польше и Испании. Развитие данной инфраструктуры позволяет объединить сильные стороны квантовых вычислений и традиционных суперкомпьютеров, что открывает перед исследователями качественно новые возможности при решении сложнейших задач.

13.02.2026 [10:50], Сергей Карасёв

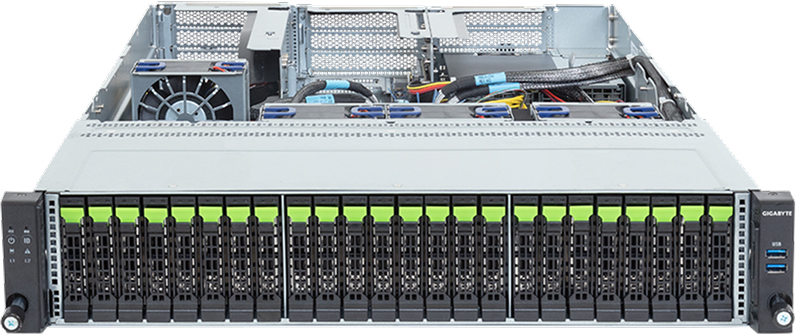

Xinnor представила All-Flash платформу хранения xiNAS для задач ИИ и НРСКомпания Xinnor анонсировала платформу xiNAS — это высокопроизводительное решение для хранения данных, ориентированное на задачи ИИ, НРС и другие ресурсоёмкие рабочие нагрузки. Изделие, относящееся к классу All-Flash, поддерживает линейное масштабирование пропускной способности по мере добавления узлов. xiNAS объединяет программный RAID-движок Xinnor xiRAID с оптимизированной файловой системой XFS и высокопроизводительным транспортным протоколом NFS over RDMA. По заявлениям разработчика, такая комбинация позволяет максимизировать быстродействие базового оборудования. В качестве последнего могут использоваться серверы Supermicro. Тестирование осуществлялось на машине Supermicro AS-1116CS-TN типоразмера 1U, оборудованной одним процессором AMD EPYC 9004 Genoa, DPU NVIDIA BlueField-3 и 12 накопителями NVMe с интерфейсом PCIe 5.0. Пропускная способность на операциях чтения составила до 74,5 Гбайт/с, на операциях записи — до 39,5 Гбайт/с. При использовании двухузловой конфигурации показатели повысились до 117 и 79,6 Гбайт/с соответственно.

Источник изображений: Xinnor Среди преимуществ платформы xiNAS компания Xinnor выделяет отсутствие проприетарного клиентского ПО, что обеспечивает простоту развёртывания и интеграции. Благодаря xiRAID достигаются высокий уровень защиты данных и стабильность работы при сбоях.  В качестве возможных конфигураций xiNAS приводятся серверы формата 1U и 2U, оснащённые соответственно процессором AMD EPYC 9384X с 32 ядрами и EPYC 9474F с 48 ядрами. Оба устройства располагают 128 Гбайт оперативной памяти и адаптерами ConnectX-7 на 400 Гбит/с (одна и две штуки). Младшая версия несёт на борту 10 накопителей Kioxia CM7-R стандарта E3.S (PCIe 5.0) на 15 Тбайт каждый и два таких же SSD на 2 Тбайт. Пропускная способность системы при последовательном чтении достигает 45 Гбайт/с, при последовательной записи — 20 Гбайт/с. Сервер в 2U-корпусе оборудован 18 накопителями Micron 7450 стандарта U3 (PCIe 5.0) на 15 Тбайт и двумя SSD Micron 7450 E3.S вместимостью 3 Тбайт. Заявленная пропускная способность при последовательном чтении — до 90 Гбайт/с, при последовательной записи — до 45 Гбайт/с.

09.02.2026 [13:17], Сергей Карасёв

«Ядерный» суперкомпьютер Teton производительностью 20,8 Пфлопс полагается только на AMD EPYC TurinНациональная лаборатория Айдахо (INL) в составе Министерства энергетики США (DOE) сообщила о запуске суперкомпьютера Teton. Система присоединилась к четырём другим НРС-комплексам лаборатории — Bitterroot, Hoodoo, Wind River и Sawtooth, увеличив доступные вычислительные ресурсы вчетверо. В основу Teton положена платформа HPE Cray EX 4000. Объединены 1024 вычислительных узла, каждый из которых содержит 384 ядра CPU и 768 Гбайт памяти. Задействованы процессоры AMD EPYC 9005 поколения Turin. Таким образом, в общей сложности используются около 393 тыс. CPU-ядер и 768 Тбайт памяти. Как отмечает INL, на сегодняшний день Teton — это один из самых мощных суперкомпьютеров в мире, архитектура которого базируется исключительно на CPU (без применения GPU и других специализированных компонентов). Такая конфигурация обусловлена спецификой использования системы: комплекс предназначен для сложных физических моделирований в рамках проектов по разработке передовых реакторов на быстрых нейтронах, малых модульных реакторов и микрореакторов. Утверждается, что традиционные CPU лучше подходят для подобных расчётов, нежели GPU.

Источник изображений: INL «Teton позволит исследователям моделировать ядерные технологии следующего поколения с беспрецедентной точностью, что значительно сократит время работ от создания концепции до внедрения критически важных проектов в области ядерной энергетики», — отмечает Бренден Хайдрих (Brenden Heidrich), руководитель научной программы Nuclear Science User Facilities (NSUF), реализуемой DOE.  В рамках NSUF исследователям в области ядерной энергетики предоставляется доступ к широкому спектру ресурсов INL и других учреждений. Новый суперкомпьютер поможет учёным моделировать сложную физику реакторов, поведение перспективных материалов и процессы топливного цикла.

07.02.2026 [17:23], Руслан Авдеев

AWS: ни один сервер с NVIDIA A100 не выведен из эксплуатации, а некоторые клиенты всё ещё используют Intel Haswell — не всем нужен ИИПо словам главы AWS Мэтта Гармана (Matt Garman), клиенты до сих пор использует серверы на основе ИИ-ускорителей NVIDIA A100, представленных в 2020 году. Отчасти это происходит потому, что спрос на вычислительные ресурсы превышает предложение, так что устаревшие чипы по-прежнему востребованы, передаёт Datacenter Dynamics. По словам Гармана, все ресурсы фактически распроданы, а серверы с A100 из эксплуатации никогда не выводились. Комментарии Гармана перекликаются с прошлогодним заявлением Амина Вахдата (Amin Vahdat), отвечающего в Google за ИИ и инфраструктуру. По его словам, в Google одновременно работают семь поколений тензорных ускорителей (TPU). Ускорители возрастом семь-восемь лет загружены на 100 %, а спрос на TPU так высок, что Google вынуждена отказывать некоторым клиентам. Впрочем, оба топ-менеджера, возможно, несколько кривят душой и пытаются развеять опасения инвесторов относительно того, что ИИ-ускорители, на которые тратятся огромные деньги, через два-три года придётся выкинуть, чтобы купить более современные, энергоэффективные и, конечно же, дорогие. И что за это время они не успеют окупиться. Хотя Гарман назвал главной причиной сохранения работы серверов на A100 высокий спрос, он признал, что есть и другие причины. В частности, современные ИИ-чипы снижают точность вычислений с плавающей запятой. В результате некоторые клиенты попросту не могут перейти на Blackwell или вовсе вынуждены использовать Intel Xeon Haswell десятилетней давности для HPC-подобных вычислений, поскольку точности у современных ИИ-ускорителей недостаточно. В июне 2025 года AWS заявила о снижении цены доступа к устаревшим NVIDIA H100, H200 и A100 на своей платформе, причём для A100 стоимость снизилась на треть.

Источник изображения: NVIDIA Стоит отметить, что «устаревшие» ускорители долго остаются востребованными, поскольку всё равно обладают большой производительностью. Наиболее яркий пример — разрешение на поставку в Китай чипов NVIDIA H200. Хотя США и их союзники готовятся к внедрению ускорителей поколения Vera Rubin, китайский бизнес готов покупать H200, поскольку те значительно производительнее, экономически выгоднее и удобнее отечественных ускорителей.

06.02.2026 [09:00], Руслан Авдеев

TeraWulf превратит в ИИ ЦОД бывший алюминиевый завод в Кентукки и купит электростанцию в МэрилендеБывший алюминиевый завод в Хоусвилле (Hawesville) в Кентукки превратят в дата-центр. Century Aluminum продала своё предприятие компании Raylan Data Holdings — дочерней структуре американского оператора ЦОД TeraWulf, сообщает Datacenter Dynamics. Участок площадью более 300 га, по слухам, куплен за $200 млн. Century сохранит за собой в проекте «неконтролирующую» миноритарную долю в 6,8 %. По словам главы Century, сделка принесёт пользу всему штату, а подписанное соглашение позволяет компании иметь связь с проектом и оказывать поддержку местным жителям по мере перестройки площадки. TeraWulf намерена построить на участке кампус ИИ/HPC ЦОД. Подробности сделки пока не разглашаются, но TerWulf заявила, что площадка даёт немедленный доступ к надёжной энергетической инфраструктуре, в т.ч. имеются несколько высоковольтных ЛЭП, собственная подстанция и прямое подключение к региональной электросети. Площадке уже доступно приблизительно 480 МВт с возможностью расширения в будущем. Одновременно TeraWulf объявила о покупке работающей на мазуте 210-МВт электростанции Morgantown Generating Station в Мэриленде, которая подключена к энергосети. Сделка включает электрическую инфраструктуру и связанную с ней недвижимость. Первый этап проекта предусматривает увеличение мощности до 500 МВт, а в перспективе и до 1 ГВт. Закрытие сделки зависит от согласия неких «третьих сторон» и получения одобрения регуляторов, в т.ч. Федеральной комиссии по регулированию энергетики (FERC). Ведомство нередко отказывает в выдаче тех или иных разрешений — в своё время оно не дало добро на прямую поставку энергии кампусу ЦОД Amazon (AWS) от АЭС Susquehanna. TeraWulf отмечает, что Хоусвилл обеспечивает немедленный доступ к масштабируемым источникам энергии, а электростанция в Мэриленде позволяет нарастить генерирующие мощности для удовлетворения растущего спроса так, чтобы это приносило пользу энергосистеме. После закрытия сделок портфель инфраструктурных объектов TeraWulf вырастет до 2,8 ГВт на пяти площадках. Недавно бизнес сообщил о создании совместного предприятия с компанией Fluidstack для строительства кампуса ЦОД в Техасе, проект поддержан Google. В своё время покупка бывшего завода Electrolux позволила xAI в кратчайшие сроки развернуть ИИ-суперкомпьютер Colossus. Площадка тоже была подключена к энергосети, хотя потом для наращивания мощности пришлось задействовать газовые турбины. Кроме того, у бывших промышленных предприятий нашёлся и ещё один плюс — их перекрытия достаточно прочны для современных ИИ-стоек.

02.02.2026 [10:17], Руслан Авдеев

Ещё один криптомайнер отказывается от биткоинов в пользу ИИ — Bitfarms переоборудует свои ЦОД под NVIDIA Vera RubinКриптомайнинговая компания Bitfarms готовится к упразднению бывшего объекта для майнинга биткоинов в штате Вашингтон — он будет переделан в HPC/ИИ ЦОД, сообщает Datacenter Dynamics. Обновлённый объект, как ожидается, будет готов к декабрю 2026 года, он пополнит растущее число дата-центров, пользующихся прохладным климатом и относительно низкими региональными ценами на электроэнергию. Объект Bitfarms на площади около 2,4 га получит ЦОД уровня Tier III площадью до 9290 м2, а также офисные помещения. По словам представителя Bitfarms, компания продолжает реализацию стратегии инфрастурктурного развития для HPC и ИИ, а в её распоряжении — полностью профинансированная цепочка поставок. Объект в Вашингтоне планируется оборудовать для использование ИИ-ускорителей NVIDIA GB300 с СЖО. Подключенная мощность объекта составляет 18 Мт и таковой, вероятно, и останется. Компания подчёркивает, что основная задача — развитие инфраструктуры для поддержки ускорителей Vera Rubin нового поколения в большей части её портфолио. Для этого доступны почти $1 млрд наличных средств, неиспользованные кредитные линии, биткоины и другие варианты финансирования. Bitfarms планирует свернуть майнинговые операции в следующие два года и уже назначила ответственного за переоборудованием объектов в США, Канаде и Аргентине. Например, мощность объекта в Шэроне (Sharon, США) вырастет с 30 МВт до 110 МВт.

Источник изображения: Bitfarms Изменить стратегию Bitfarms пришлось после того, как компания отчиталась о чистых убытках в объёме $46 млн в III квартале 2025 года. Тогда руководство компании заявило, что ИИ-инфраструктура обещает гораздо большую отдачу, чем криптомайнинг. Хотя доля объекта в Вашингтоне составляет менее 1 % от общего портфолио компании, её руководство полагает, что одно лишь его преобразование для предоставления GPUaaS потенциально может принести больше чистого операционного дохода, чем компания когда-либо получала в результате майнинга биткоинов. Это не единственная майнинговая компания, отказывающаяся от своей основной деятельности в последнее время. Буквально на днях появились новости о том, что Riot Platforms сменит профиль и сдаст AMD 25 МВт мощностей ЦОД.

30.01.2026 [20:24], Руслан Авдеев

От технологического наследия к построению будущего — Atos перезапустила бренд Bull для HPC, ИИ и квантовых инновацийПечально известная своими финансовыми проблемами французская компания Atos официально перезапустила один из своих ведущих брендов. Теперь Bull позиционируется как глобальный лидер в HPC-, ИИ- и квантовых системах. Bull разрабатывает, внедряет и обслуживает оборудование и ПО, в том числе суперкомпьютеры. Bull позиционируется, как единственный европейский игрок, способный разрабатывать, выпускать и внедрять решения такого класса. Работа поддерживается командой исследователей и инженеров, производственными возможностями и др. Bull, как сообщают в самой компании, позволяет странам и отраслям полностью контролировать свои ИИ-мощности и данные. Бизнес Bull основан на более чем вековом опыте в сфере вычислений и исследований, связанных с data science. Как утверждают в Atos, возрождение Bull — стратегически важная веха на пути бренда к формированию частной, независимой компании после подписания соглашения о покупке акций Францией 31 июля 2025 года. Корни у бренда европейские, но сейчас он, по словам Atos, занимает лидирующие позиции ещё и в Латинской Америке и Индии. Bull владеет полным технологическим стеком, от разработки интегральных микросхем и интерконнектов до ИИ-платформ и приложений. Бренд обеспечивает надёжные решения промышленного уровня для критически важных секторов, включая, например, оборону и энергетику, одновременно снижая совокупную стоимость владения. По словам руководства бренда, с запуском Bull осуществляется «переподключение» к технологическому наследию для строительства будущего. Миссией компании называется обеспечение мощных, устойчивых и суверенных вычислений и ИИ-технологий, позволяющих уверенно и осмысленно внедрять инновации на уровне отраслей и целых наций.

Источник изображения: Bull Примечательна судьба самой Atos Group. Хотя сама компания позиционирует себя как лидера в сфере цифровой трансформации с 63 тыс. сотрудников и ежегодной выручкой €8 млрд, действующим в 61 странах под двумя брендами (Atos для сервисов и Eviden для продуктов), дела у компании идут, мягко говоря, непросто. Atos не первый год теряет выручку по всем направлениям, а будущее компании всё более туманно. Поэтому Atos заключила сделку с французским государством, согласно которой ему будут переданы «золотые акции» Bull SA. После неоднократных попыток спасти компанию, частой смены директоров и даже новостей о её возможной национализации Францией, летом 2025 года появилась информация, что власти Франции сделали предложение купить подразделение Advanced Computing в составе группы Atos. |

|