Материалы по тегу: h200

|

25.02.2026 [11:55], Сергей Карасёв

Akash Systems начала поставки первых в мире GPU-серверов с алмазным охлаждениемКомпания Akash Systems, базирующаяся в Сан-Франциско (Калифорния, США), объявила о начале поставок первых в мире ИИ-серверов, оснащённых системой алмазного охлаждения Diamond Cooling. Заказчиком выступил NxtGen AI PVT Ltd — крупнейший в Индии государственный облачный провайдер. Технология Diamond Cooling основана на применении синтетических алмазов. Этот материал обладает самой высокой теплопроводностью из всех известных соединений. Akash Systems подчёркивает, что синтетические алмазы способны отводить тепло от чипов в пять раз эффективнее по сравнению с медью, что открывает качественно новые возможности в плане охлаждения современного оборудования высокой плотности для дата-центров, ориентированных на задачи ИИ и НРС. Akash Systems поставляет серверы на базе NVIDIA H200, для охлаждения которых применяется система Diamond Cooling. В отличие от стандартных ЦОД, оборудование в которых функционирует при температурах от +24 до +29 °C, серверы с технологией Diamond Cooled способны обеспечивать максимальную производительность при температуре окружающей среды до +50 °C. Благодаря этому снижаются общие требования к системам охлаждения дата-центров, что позволяет уменьшить эксплуатационные расходы. Среди одного из ключевых преимуществ Diamond Cooling разработчики называют устранение теплового троттлинга: это обеспечивает наилучшее быстродействие при выполнении ресурсоёмких задач, таких как обучение больших языковых моделей (LLM) и инференс. Кроме того, достигается повышение производительности (Флопс/Вт) до 15 % на каждый сервер. Плюс к этому существенно сокращается общее энергопотребление ЦОД, поскольку отпадает необходимость в интенсивном охлаждении. «Система Diamond Cooling решает две самые сложные проблемы в гонке ИИ — повышение энергоэффективности и сокращение капиталовложений. В ситуации, когда увеличение вычислительной мощности на 1–2 % имеет большое значение, повышение на 15 % фактически меняет правила игры», — говорит доктор Феликс Эджекам (Felix Ejeckam), соучредитель и генеральный директор Akash Systems.

29.01.2026 [10:20], Руслан Авдеев

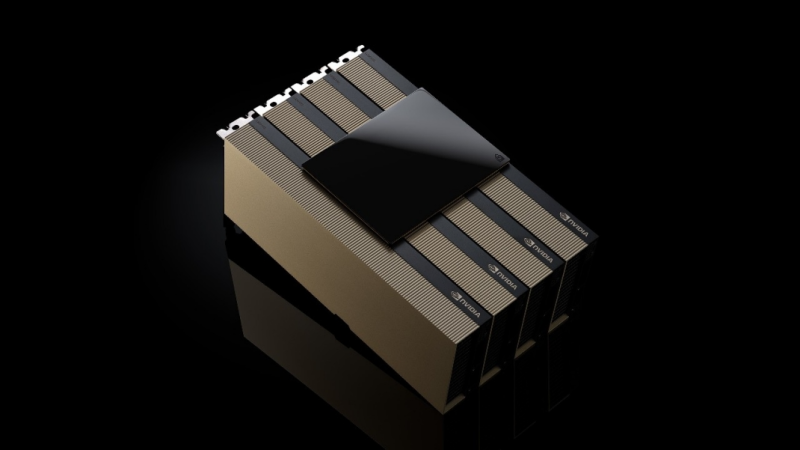

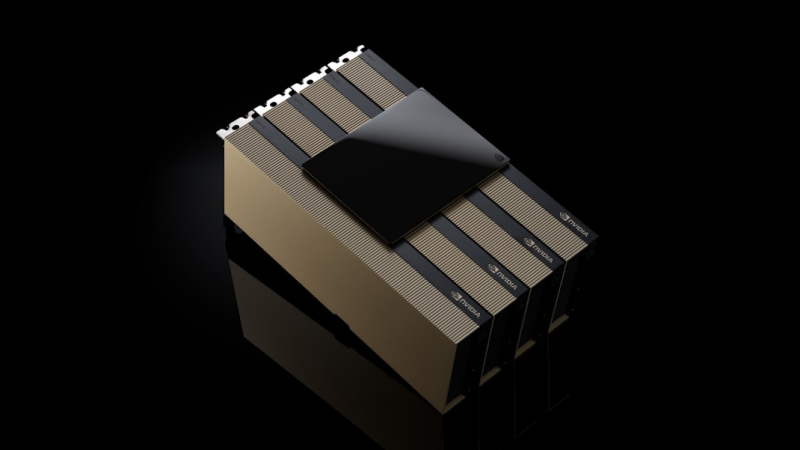

Конец неопределённости: Пекин одобрил импорт NVIDIA H200Китайские власти начали выдавать разрешения на импорт в страну ИИ-ускорителей NVIDIA H200. Это положит конец неопределённости, царившей после того, как поставки второго по производительности чипа NVIDIA в Поднебесную одобрили представители американских властей, сообщает гонконгская SCMP. Первая партия, как сообщают источники, поступит местным техногигантам, остро нуждающимся в передовых ускорителях. Впрочем, ожидается, что поддерживаемые государством компании вроде телеком-операторов, смогут покупать такие чипы только под жёстким контролем. Пока одобрены поставки более 400 тыс. ускорителей компаниям ByteDance, Alibaba Group Holding и Tencent Holdings, прочие бизнесы продолжают ожидать получения разрешений. В самой NVIDIA новости не комментируют. Это важные изменения китайской политики после того, как Пекин временно придержал поставки H200 ранее в январе 2026 года уже после того, как Вашингтон одобрил экспорт. Это отражает желание китайских властей сохранить баланс между необходимостью покупать передовые ИИ-чипы и стремлением добиться самодостаточности в этой сфере.

Источник изображения: NVIDIA По мнению экспертов, неограниченный доступ к закупкам чипов NVIDIA нанёс бы удар местной китайской индустрии ИИ-полупроводников. Поэтому регуляторам необходимо установить некоторые рамки для ограничения доли использования ИИ-ускорителей иностранного производства и управления спросом. Ранее допускалось, что китайские компании обяжут закупать определённое количество чипов местного производства при покупке H200 у NVIDIA. По мнению экспертов Национального университета Сингапура, одобрение Пекином импорта H200 вызвано стратегическими мотивами — это обеспечит дальнейшее ускоренное развитие китайских ИИ-технологий. Стоит отметить, что разрешение на поставки H200 довольно прохладно принято многочисленными политическими и бизнес-группами в США. Например, глава компании Anthropic сравнил такие продажи с поставками ядерного оружия Северной Корее.

21.01.2026 [17:07], Руслан Авдеев

Глава Anthropic: продажа H200 в Китай равнозначна поставкам ядерного оружия Северной КорееГенеральный директор Anthropic Дарио Амодеи (Dario Amodei) недоволен тем, что США разрешили NVIDIA продавать китайским компаниям передовые ИИ-ускорители. Он сравнил это решение с раздачей ядерного оружия противникам, сообщает The Register. По словам Амодея, выступившего на Международном экономическом форуме в Давосе, руководители китайских компаний заявляют, что эмбарго на поставку американских чипов сдерживает их развитие. Он заявил, что продавать эти чипы — большая ошибка. Ранее США разрешили поставки ускорителей NVIDIA H200 китайским покупателям с пошлиной 25 %. Теперь слово за китайскими властями, которым ещё предстоит разрешить такие сделки. Anthropic желает, чтобы экспорт ИИ-технологий, наоборот, ужесточился — это заметно контрастирует с позициями NVIDIA и AMD, которые предупреждают, что запреты на экспорт только способствуют развитию ИИ-технологий в КНР. При этом на Китай приходится около половины исследователей в области искусственного интеллекта. Ранее Anthropic утверждала, что США и так лидируют в сфере ИИ-полупроводников, а экспортный контроль, на фоне того, что вычислительные мощности чипов удваиваются каждые два года, замедляет развитие Китая и укрепляет лидерство США. Компания уверена, что США на годы опережают Китай в способности выпускать передовые чипы. Доступ к американским разработкам позволит китайским создателям ПО вроде DeepSeek оказаться в лучшей позиции для конкуренции с Западом. При этом, как сообщает The Register, многие из наиболее производительных китайских LLM относятся к open source, поэтому их может использовать любой желающий, не опасаясь того, что данные его компании попадут в обучающий датасет, тогда как LLM американских компаний в основном «скрыты» за API, а сами компании расплывчато обещают не использовать пользовательские данные для обучения своих ИИ. При этом суды полны исков пользователей, связанных с нарушением прав на интеллектуальную собственность.

Источник изображения: CDC/unspalsh.com Слова Амодеи о том, что китайские разработчики LLM угрожают американскому бизнесу, слегка сгущают краски, но всё может действительно измениться, если китайские компании смогут импортировать передовые ускорители из США. Пока же, по словам бизнесмена, ИИ из КНР производителен только «на бумаге», а системы якобы специально оптимизируют для бенчмарков. Так или иначе, корпоративные пользователи действительно имеют немного вариантов, если желают получить доступ к хорошим открытым моделям — они в основном из Китая. Сама Anthropic называет главными конкурентами не стартапы из КНР, а OpenAI, Google и, чуть реже, другие американские компании. Anthropic пока не выкладывала ни одну из своих флагманских моделей в открытый доступ, но участвовала в нескольких совместных проектах с избранными клиентами, самым значимым из которых является AWS. Амодеи подчеркнул, что его продукты почти ни разу не проиграли в борьбе за контракт ИИ-модели из Поднебесной. Ключевое слово — «почти». Это означает, что китайским разработчикам всё-таки удавалось одержать верх несмотря на сложную ситуацию, в которой они находятся из-за экспортных ограничений. Компания последовательно критикует инициативы, способные обеспечить сотрудничество Запада с Китаем и даже не приветствует взаимодействие с другими мировыми игроками. Так, летом 2025 года сообщалось, что она намерена привлечь инвестиции с Ближнего Востока, но только потому, что избежать работы с регионом не удастся. В 2024 году Anthropic даже отказалась от инвестиций из Саудовской Аравии по соображениям «национальной безопасности».

14.01.2026 [15:39], Руслан Авдеев

США разрешили экспорт NVIDIA H200 в Китай, а Китай импорт H200 не разрешилСША официально разрешили поставки чипов NVIDIA H200 китайским клиентам несмотря на неодобрение некоторых политиков. Впрочем, как оказалось, в Китае эти ускорители не очень ждут, сообщает Reuters. Параллельно США прикрыли лазейку в законах, позволявшую КНР пользоваться передовыми ИИ-чипами в зарубежных ЦОД и облаках. Согласно новым американским правилам, продаваемые в КНР чипы должны перед поставками проверяться независимыми лабораториями для подтверждения их технических характеристик. При этом в Поднебесную запрещено продавать более 50 % от общего объёма чипов, продаваемых американским клиентам. NVIDIA придётся доказать, что в США достаточно ускорителей H200, а китайские клиенты должны пройти «необходимые процедуры безопасности» и не должны использовать полупроводники в военных целях. Ранее об этих условиях не сообщалось. В NVIDIA подчёркивают, что критики новых правил непреднамеренно продвигают интересы конкурентов компании, находящихся в американском «чёрном списке». В декабре было объявлено о возможности продавать чипы NVIDIA H200 в КНР с условием уплаты в американский бюджет пошлины в объёме 25 % от их стоимости. Китайским технологическим компаниям нужно порядка 2 млн H200, причём каждый из ускорителей стоит около $27 тыс. Это превышает запасы NVIDIA, на складах которой имеется не более 700 тыс. таких чипов. Глава NVIDIA Дженсен Хуанг (Jensen Huang) заявил, что компания нарастит производство H200. По словам Reuters, пожелавшие остаться анонимными сотрудники китайской таможни заявили, что ввоз чипов NVIDIA H200 в Китай пока не разрешён. Также, по некоторым данным, китайские власти пригласили представителей местных технологических компаний на встречу, в ходе которой недвусмысленно указали не покупать H200 без крайней необходимости. Фактически, по данным источников СЧМИ, речь идёт о временном запрете закупок, который может стать постоянным. H200 в последнее время находится в центре обсуждений американо-китайских отношений. Хотя спрос со стороны китайского бизнеса велик, есть вероятность, что Пекин вовсе запретит ввоз таких чипов, чтобы местные разработчики ИИ-чипов могли развивать собственные проекты. Также возможно, что вопросы, касающиеся поставок H200, станут предметом торга с Вашингтоном. Пока нет данных, касается ли запрет уже сделанных заказов, или только новых. Желая замедлить развитие Китая в сфере ИИ и технологий в целом, США с 2022 года ввела ограничения на экспорт в КНР передовых полупроводников. В 2025 году США сначала запретили, а позже разрешили экспорт ускорителей H20, но поставки с августа фактически заблокировал сам Китай. Дженсен Хуанг заявлял, что доля NVIDIA на рынке ИИ-чипов КНР уменьшилась до нуля. H200 приблизительно в шесть раз производительнее H20 и отказаться от такого предложения полностью КНР будет весьма затруднительно, особенно с учётом того, что собственные чипы китайской разработки далеко не столь производительны.

09.01.2026 [19:23], Владимир Мироненко

Pay 'n' Pray: NVIDIA требует полную предоплату за поставку H200 в КитайПосле того, как США дали NVIDIA добро на поставку ИИ-ускорителей H200 в Китай в обмен на выплату 25 % от суммы продаж, китайские компании выразили готовность приобрести у чипмейкера более 2 млн ускорителей. Это в несколько раз превышает имеющиеся запасы на складах NVIDIA. Ранее сообщалось, что NVIDIA готова отгрузить первые партии H200 в середине февраля до наступления лунного Нового года. Китайские власти пока не дали разрешение на импорт этих чипов, но, как утверждает Bloomberg со ссылкой на проверенные источники, правительство готово уже в этом квартале разрешить приобретение H200 для отдельных коммерческих целей. При этом из-за соображений безопасности под запретом окажутся закупки чипов для военных организаций, госучреждений, объектов критической инфраструктуры и предприятий с госсобственностью. По словам источника, власти КНР попросили некоторые китайские технологические компании приостановить на время размещение заказов на чипы H200, поскольку регуляторами пока не решено, в каком соотношении к покупке ускорителей американской компании они должны будут приобрести чипы отечественного производства.

Источник изображения: NVIDIA Для NVIDIA возобновление поставок означает возврат на ключевой рынок. Генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) заявил, что спрос клиентов в Китае на чипы H200 «довольно высок» и что компания «запустила свою цепочку поставок» для наращивания производства. Хуанг отметил, что вне зависимости от официального заявления правительства Китая об одобрении, поступление заявок от китайских компаний на покупку «будет означать, что они могут размещать заказы». По словам источников агентства Reuters, в случае с поставками H200 компания решила полностью переложить на клиентов риски, связанные с неопределённостью ситуации, потребовав полную предоплату за заказ. NVIDIA и раньше требовала предоплату, хотя могла в порядке исключения согласиться и на размещение депозита. При полной предоплате поставок, если Китай вдруг изменит решение и заблокирует импорт чипов, возврата предоплаты не будет и убытки полностью лягут на плечи китайских клиентов американской компании. UPD 13.01.2026: NVIDIA опровергла сообщения о предоплате, заявив, что «никогда не стал бы требовать от клиентов оплаты за товары, которые они не получают».

08.01.2026 [13:35], Руслан Авдеев

«Дата-центр в чемодане»: Odinn представила переносной нано-ЦОД Omnia с четырьмя NVIDIA H200Громоздкость оборудования для дата-центров не позволяет легко переносить его с места на место, но у стартапа Odinn своё видение этой проблемы. Компания представила на днях своеобразный «нано-ЦОД» с четырьмя ИИ-ускорителями NVIDIA H200 (NVL), сообщает The Register. По данным компании, 35-кг платформа Odinn Omnia помимом ускорителей включает до двух CPU AMD EPYC 9965 (Turin), до 6 Тбайт DDR5 ECC, 1 Пбайт NVMe SSD, 400GbE-адаптер, встроенный 23,8″ 4K-дисплей и откидную клавиатуру. Шасси снабжено рукоятками для переноски. Фактически речь идёт об устройстве размером с чемодан, хотя Omnia не позиционируется как портативный ПК или даже мобильная рабочая станция. «Чемоданный» ЦОД предлагается в нескольких конфигурациях, включая AI, Creator, Search и X. Использовать их можно для критически важных периферийных вычислений, военных миссий, симуляций корпоративного уровня, работы с киноматериалами буквально в любой локации. Кроме того, Omnia могут использоваться как модули для создания более масштабных структур, объединённых в кластеры Infinity Racks.

Источник изображения: Odinn Конечно, всё это обойдётся недёшево — один NVIDIA H200 стоит около $32 тыс. Можно предположить, что немногие компании позволят сотрудникам разгуливать с такими дорогими «чемоданами», которые довольно легко похитить. Впрочем, Odinn пока ничего не сообщает о цене устройств. Внешне, со встроенным дисплеем и откидной клавиатурой, Omnia отчасти напоминает портативные ПК далёкого прошлого. Если же встроенные дисплей и клавиатура не нужны, то есть решения попроще и в буквально смысле полегче. Так, 25-кг модульная платформа GigaIO Gryf объединяет в одном шасси-чемодане до пяти узлов различной конфигурации (плюс один обязательный модуль питания), в том числе с H200 NVL. Gryf тоже можно объединять в мини-кластеры.

31.12.2025 [18:30], Владимир Мироненко

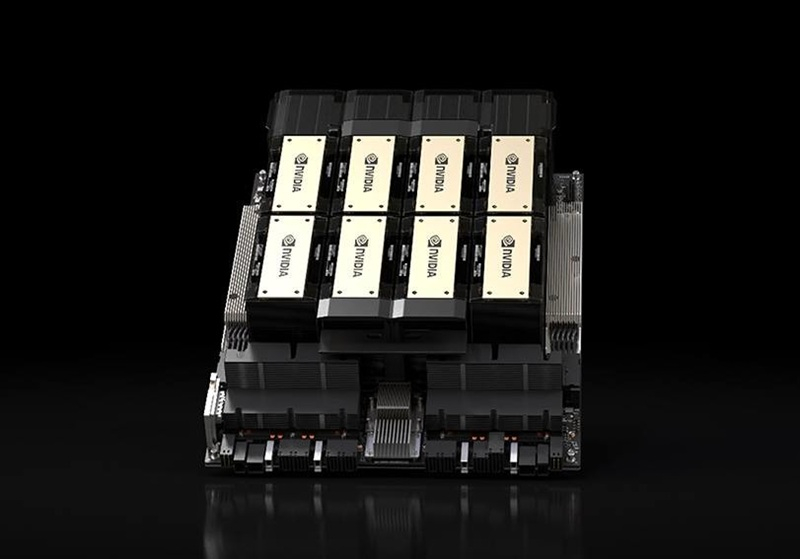

Потребность китайских компаний в H200 в несколько раз выше запасов NVIDIAПосле того, как США дали NVIDIA добро на поставку ИИ-ускорителей H200 в Китай, выяснилось, что потребности ключевого для компании рынка в этих чипах гораздо выше имеющихся у неё запасов. По данным источников Reuters, компания уже обратилась к TSMC с запросом на увеличение производства H200. Однако существует определённый риск, что правительство КНР может не дать разрешение на ввоз в страну H200, хотя и официального заявления по поводу запрета пока тоже не поступало. Как сообщают источники, сейчас у NVIDIA насчитывается на складах порядка 700 тыс. ускорителей H200, включая 100 тыс. суперчипов GH200, в то время как поступило заказов от китайских технологических компаний более чем на 2 млн ускорителей. Газета South China Morning Post сообщила со ссылкой на источники, что только ByteDance планирует потратить в 2026 году около ¥100 млрд (около $14,3 млрд) на чипы NVIDIA, по сравнению с примерно ¥85 млрд (около $12,2 млрд) в 2025 году, если, опять же, Китай разрешит поставки H200. Власти КНР пока не определились с тем, стоит ли разрешать ли импорт H200, опасаясь, что доступ к передовым зарубежным чипам может замедлить развитие местной полупроводниковой промышленности в ИИ-сфере. Один из рассматриваемых вариантов предполагает, что могут в качестве условия поставки потребовать комплектовать закупки H200 определённым количеством чипов китайского производства. Ранее сообщалось, что первая партия NVIDIA H200 может поступить в Китай в середине февраля. По данным источников Reuters, NVIDIA уже решила, какие варианты H200 она будет предлагать китайским клиентам, установив цену около $27 тыс./шт.. При этом цена будет зависеть от объёма закупок и конкретных договорённостей с клиентами. Сообщается, что восьмичиповый модуль с H200 будет стоить около ¥1,5 млн (около $214 тыс.), что немного дороже, чем поставлявшийся до введения запрета Китаем по цене ¥1,2 млн (около $172 тыс.) модуль с ускорителями H20. Однако, с учётом того, что H200 обеспечивает примерно в шесть раз большую производительность, чем H20, китайские интернет-компании считают цену привлекательной, отметили источники. Также это дешевле цены серого рынка примерно на 15 %. Хотя потенциальный заказ означает значительное расширение производства H200, в комментарии для Reuters в NVIDIA сообщили, что «лицензионные продажи H200 авторизованным клиентам в Китае никак не повлияют на способность компании поставлять продукцию клиентам в США». «Китай — это высококонкурентный рынок с быстрорастущими местными поставщиками чипов. Блокировка всего экспорта из США подорвала нашу национальную и экономическую безопасность и лишь пошла на пользу иностранным конкурентам», — отметили в компании.

25.12.2025 [14:48], Руслан Авдеев

В 2026 году ByteDance увеличит инвестиции в ИИ-инфраструктуру до $23 млрдВладеющая TikTok китайская ByteDance рассчитывает нарастить свои инвестиции в ИИ-проекты, чтобы не отстать от американских конкурентов — компания намерена увеличить капитальные затраты до ¥160 млрд ($23 млрд) в 2026 году, сообщает The Financial Times. Для сравнения, в 2025 году инвестиции компании в ИИ-инфраструктуру составили порядка ¥150 млрд. ¥85 млрд планируется потратить на закупку передовых ИИ-ускорителей, хотя вопрос с доступом к чипам NVIDIA пока не решён окончательно. Сама NVIDIA рассчитывает начать поставки H200 уже в феврале следующего года. ByteDance — один из крупнейших китайских строителей ИИ-инфраструктуры, компания стремится стать одним из мировых лидеров в этой сфере. Впрочем, в сравнении с инвестициями в ИИ ЦОД, на которые ушли уже сотни миллиардов долларов, расходы ByteDance относительно невелики. Пока китайские компании не могут приобретать передовые чипы NVIDIA из-за ограничений со стороны американских властей. В результате они стремятся к программным оптимизациям и к обучению ИИ-моделей за рубежом. При этом аренда обычно учитывается не как капитальные затраты, а как операционные расходы.

Источник изображения: ByteDance В декабре 2025 года США отменили запрет на продажу ускорителей NVIDIA H200 некоторым клиентам в Китай. Такие чипы менее производительны, чем самые современные модели. Кроме того, определённые круги в Пекине и Вашингтоне выступают против продаж по разным причинам. Так или иначе, источники свидетельствуют, что в случае разрешения поставок ByteDance и другие китайские технологические группы будут охотно покупать H200 в больших масштабах. Так, ByteDance якобы намерена закупить 20 тыс. H200 в рамках «пробного» заказа, стоимость каждого ускорителя может составить порядка $20 тыс. Если гигант получит неограниченные квоты для закупки, он может значительно нарастить капитальные затраты на 2026 год. По словам экспертов, в сравнении с другими китайскими техногигантами ByteDance выигрывает потому, что её акции не торгуются публично, т.ч. она лучше защищена от инвестиционных манипуляций и способна играть «вдолгую» на рынке ИИ. Хотя, по данным The Financial Times, производительность открытых ИИ-моделей ByteDance Doubao отстаёт от Alibaba Qwen и DeepSeek, компания доминирует в сфере ИИ-приложений, рассчитанных на потребителей. Так, по статистике QuestMobile, чат-бот Doubao обогнал DeepSeek и уже стал самым популярным в КНР по количеству ежемесячных активных пользователей. Компания активно конкурирует и с Alibaba, продвигая облачный сервис Volcano Engine для бизнеса. По информации Goldman Sachs, предложенные ByteDance ИИ-продукты обеспечили себе статус самых востребованных в Китае. По статистике, в октябре ByteDance отметила существенный рост спроса — более 30 трлн токенов в день. Для сравнения, у Google тот же показатель составил 43 трлн.

23.12.2025 [13:40], Руслан Авдеев

NVIDIA намерена начать поставки в Китай ИИ-чипов H200 к середине февраляКомпания NVIDIA заявила китайским клиентам о намерении начать поставки ИИ-ускорителей NVIDIA H200 в середине февраля 2026 года, сообщает Reuters со ссылкой на источники, знакомые с ситуацией. Утверждается, что первые заказы из КНР выполнят из уже имеющихся запасов. По данным источников, объём поставок составит 5–10 тыс. ИИ-модулей, т.е. приблизительно 40–80 тыс. ИИ-ускорителей H200. Также китайским покупателям якобы объявили о планах нарастить производственные мощности для выпуска таких чипов, заказы на них начнут принимать во II квартале 2026 года. Источники свидетельствуют, что пока Пекин не одобрил ни одной закупки, а расписание поставок может зависеть от решений китайского правительства. В заявлении для Reuters NVIDIA сообщила, что постоянно контролирует цепочку поставок и лицензионные продажи ускорителей H200 в КНР никак не повлияют на продажи клиентам в США. Это первые официальные партии поставок чипов H200 в Китай после того, как Вашингтон разрешил подобные продажи с пошлиной 25 %. На днях сообщалось, что администрацией США начата межведомственная проверка заявок на получение разрешений на продажу H200 в КНР. H200 не относится к самым передовым моделям. При этом чип входит в линейку Hopper, которая до сих пор широко востребована на рынке ИИ, хотя на смену ей пришли Blackwell и уже готовятся Rubin. Это затрудняет организацию поставок H200, поскольку ресурсы выделены уже на другие решения. Решение США во многом принято из опасений, вызванных активными действиями Китая по развитию собственного производства ИИ-полупроводников. Поскольку китайские ИИ-ускорители пока значительно слабее американских вариантов, разрешение на продажи H200 может замедлить развитие ИИ-технологий КНР. Недавно появилась информация, что китайские власти провели ряд экстренных совещаний в начале декабря для обсуждения политики в отношении закупок и производства полупроводников в новых условиях. Рассматривается возможность разрешения поставок в Китай, но при этом не исключается обязательная покупка китайскими клиентами нескольких чипов «домашнего» производства на каждый купленный H200. Для китайских IT-гигантов вроде Alibaba Group и ByteDance, выразивших заинтересованность в покупке H200, вариант будет значительно более привлекательным, чем поставки «ослабленных» для Китая ускорителей H20, продававшихся ранее. Модель H200 приблизительно в шесть раз более производительна и искусственному ухудшению не подвергалась.

14.12.2025 [14:40], Руслан Авдеев

NVIDIA рассматривает увеличение выпуска ускорителей H200 из-за большого спроса на них в КитаеПо данным отраслевых источников, NVIDIA сообщила клиентам в Китае, что уже рассматрвиает возможность нарастить производство ИИ-ускорителей H200. По данным Reuters, объёмы заказов уже превышают доступный сегодня уровень производства. Ранее сообщалось, что руководство США рассматривает разрешение поставок H200 в КНР, а в минувший вторник президент страны объявил о том, что этот вопрос решён положительно. При этом власти будут получать комиссию в 25 % с продаж ускорителей в Китай. Спрос на современные ИИ-чипы в Китае столь высок, что NVIDIA допускает расширение их производства. В самой NVIDIA прокомментировали слух, заявив, что управляют цепочкой поставок таким образом, чтобы продажи авторизованным клиентам в Китае не повлияли на способность поставлять продукцию покупателям из США. Пока чипов H200 производится очень немного, поскольку NVIDIA сосредоточилась на выпуске передовых ускорителей Blackwell, а также будущего семейства — Rubin. Крупные китайские компании, включая Alibaba и ByteDance уже связались с NVIDIA на днях по поводу закупок H200 и, как утверждается, заинтересованы в размещении крупных заказов. Впрочем, пока неопределённость сохраняется, поскольку закупки H200 не одобрили в самом Китае. По словам источников, в прошлую среду китайские чиновники провели ряд экстренных совещаний для обсуждения вопроса и принятия решения о том, стоит ли в принципе разрешать поставки H200.

Источник изображения: bruce mars/unsplash.com H200 поступили в массовое производство в 2024 году и являются самыми быстрыми ускорителями NVIDIA поколения Hopper. Высокий спрос на H200 в Китае обусловлен тем, что это самый производительный чип, который будет доступен китайскому бизнесу на данный момент. Он приблизительно вшестеро производительнее «урезанной» модели H20. Решение США принято на фоне стремления Китая активно развивать собственную полупроводниковую индустрию для ИИ-проектов. Поскольку продукция, сопоставимая с H200 в продаже пока отсутствует, в Китае уже возникли опасения, что выход американских чипов на локальный рынок может затормозить развитие местной отрасли. По мнению некоторых китайских экспертов, вычислительная мощность H200 в два-три раза выше, чем у самых передовых чипов из КНР — многие поставщики облачных услуг и корпоративные клиенты активно размещают заказы и лоббируют ослабление ограничений. При этом отмечается, что спрос в Китае в любом случае превышает возможности местного производства. По сведениям источников, в ходе экстренных совещаний предлагалось разрешить покупать каждый ускоритель H200 только при условии покупки определённого количества чипов китайского производства. При этом у китайских IT-гигантов теоретически остаётся запасной вариант — размещение H200 в собственных ЦОД за пределами Китая. Они и так обучают модели в дата-центрах вне КНР, пусть и не своих. Для NVIDIA же наращивать производственные мощности тоже непросто, поскольку она занята наладкой массового производства Rubin и конкурирует за мощности TSMC с компаниями уровня Google. |

|