Материалы по тегу: облако

|

23.02.2026 [20:40], Владимир Мироненко

Вовремя сбежавший в Исландию вице-президент NetApp отвертелся от суда в СШАФедеральный окружной суд США по Среднему округу Флориды отклонил «без ущерба для дальнейшего разбирательства» (without prejudice) из-за вопросов по поводу юрисдикции иск NetApp с обвинением бывшего технического директора и старшего вице-президента Йона Торгримура Стефанссона (Jón Thorgrímur Stefánsson), неожиданно скрывшегося в Исландии, в нарушении контракта и незаконном присвоении коммерческой тайны. NetApp уже подала апелляцию, уведомив об этом на прошлой неделе, сообщил ресурс Blocks & Files. История берёт начало в августе 2017 года, когда NetApp приобрела исландскую компанию Greenqloud и её ПО Qstack для оркестрации и управления облачными сервисами в гибридных облачных средах за $51 млн. Генеральный директор Greenqloud Стефанссон вместе с командой присоединился к NetApp. В июне 2025 года Стефанссон и ещё пять сотрудников Greenqloud покинули NetApp и основали Red Stapler. Через два месяца компания VAST Data приобрела этот стартап. Стефанссон стал генеральным директором по облачным технологиям в VAST Data, а пять его коллег заняли должности архитекторов и инженеров ПО. По мнению NetApp, все они фактически участвовали в разработке VAST AI OS, которая получила сходную с ONTAP Data Fabric функциональность в части работы с облаками. Причём, как считает NetApp разработать эти функции за десять недель между созданием и продажей Red Stapler никак не могла, т.е. дорогостоящие наработки были украдены у NetApp и переданы VAST Data, а Red Stapler была создана лишь для прикрытия. Стефанссон заявил, что не передавал никакую интеллектуальную собственность NetApp конкурентам, в то время как NetApp утверждала, что приобретение Red Stapler «было лишь средством конкурента для найма Стефанссона и его команды». Отметим, что сама VAST Data не указана в качестве ответчика в иске NetApp. В постановлении суда говорится, что есть два трудовых договора между Стефанссоном и NetApp, подписанных примерно в одно и то же время. Когда Стефанссон присоединился к NetApp в 2017 году, он проживал в Исландии, где отсутствует закон о неконкуренции (non-compete law). Он подписал трудовой договор и «Соглашение о конфиденциальной информации, изобретениях и неразглашении» (PIIA), которое обязывало Стефанссона передавать NetApp «любые изобретения, разработанные во время его работы, уведомлять компанию о любых изобретениях, разработанных им в течение шести месяцев после увольнения, воздерживаться от незаконного присвоения конфиденциальной и коммерческой информации NetApp и воздерживаться от переманивания сотрудников и деловых партнёров NetApp». Трудовой договор «подлежал исключительной юрисдикции судов Исландии», что было указано в пункте о выборе подсудности. При этом и соглашение PIIA также подлежало исландской юрисдикции, если оно было включено в трудовой договор. В январе 2023 года Стефанссон переехал в Орландо (Orlando, шт. Флорида) по трёхлетней визе, официально став старшим вице-президентом NetApp, в результате чего прошлый трудовой договор был расторгнут. Позже он переехал в Исландию, но затем «вернулся во Флориду, чтобы собрать вещи, подготовить дом к продаже и уладить все дела». В это время NetApp подала на него в суд, ссылаясь на соглашение PIIA, но не на трудовой договор. В итоге спор свёлся к вопросу юрисдикции. Адвокаты Стефанссона заявили, что спор должен рассматриваться в исландском суде, поскольку Флорида не обладает юрисдикцией в этом деле. Юристы настаивали на том, чтобы дело было прекращено, поскольку в трудовом договоре было указано, что юридические вопросы, касающиеся этого дела, должны решаться в исландском суде. Адвокаты также утверждали, что соглашение о предоставлении юридической помощи (PIIA) фактически объединено с трудовым договором в одном документе, что означает, что Исландия обладает общей юридической юрисдикцией. NetApp заявила, что надлежащим местом рассмотрения дела является суд Флориды, поскольку Стефанссон работал во Флориде и «ему лично вручили судебные документы, когда он добровольно находился в этом штате». Также компания утверждала, что «пункт о выборе подсудности в трудовом договоре Стефанссона неприменим к этому спору, поскольку она подала иск против Стефанссона исключительно на основании соглашения PIIA, которое имеет свои собственные положения о выборе права и подсудности». Окружной судья Джули Снид (Julie Sneed) не согласилась с аргументами NetApp, указав в постановлении, что «NetApp не доказала, что это исключительный случай, когда факторы общественного интереса в подавляющем большинстве случаев не позволяют применять пункт о выборе подсудности сторон». Она удовлетворила ходатайство Стефанссона об отклонении иска, но без ущерба для дальнейшего разбирательства в соответствии с доктриной forum non conveniens. Это означает, что суд счёл, что для рассмотрения этого вопроса есть более подходящий суд и юрисдикция. Компания NetApp заявила: «Флоридский суд отклонил иск без ущерба для дальнейшего рассмотрения исключительно по причине несоответствия подсудности, не рассматривая дело по существу. NetApp уже обжаловала это решение и предпринимает отдельные юридические действия в Исландии, чтобы обеспечить прямое и решительное рассмотрение этих вопросов».

20.02.2026 [15:23], Владимир Мироненко

Anthropic планирует увеличить к 2029 году расходы на облака до $80 млрдК 2029 году затраты на облачные сервисы ИИ-стартапа Anthropic, согласно его собственным прогнозам, достигнут $80 млрд, сообщил ресурс The Information со ссылкой на свои источники. Расходы будут распределены между Google, Microsoft и Amazon. Помимо оплаты аренды серверов для моделей Claude, Anthropic также делится с облачными провайдерами частью прибыли от продаж своих ИИ-сервисов на их платформах. The Information сообщил со ссылкой на данные стартапа, что в 2024 году эта сумма составила $1,3 млн, и, согласно «самым оптимистичным прогнозам» ресурса, в 2025 году она составила $360 млн, в 2026 году вырастет до $1,9 млрд, а в 2027 году — до $6,4 млрд. Также, по словам источника, Anthropic отчисляет клиентам до 50 % своей валовой прибыли от продаж ИИ-решений на AWS, рассчитываемой на основе выручки за вычетом расходов на облачные ресурсы. Для сравнения, Google обычно получает от 20 % до 30 % чистой выручки после вычета затрат на инфраструктуру от перепродажи ПО своих партнёров. Как утверждает генеральный директор Anthropic Дарио Амодеи (Dario Amodei), компания тратит меньше средств на вычислительные мощности ЦОД по сравнению с другими компаниями в сфере ИИ. Он отметил, что чрезмерные расходы могут быть «разорительными» в случае, когда выручка не гарантирована. Anthropic давно пользуется услугами Google Cloud, и в октябре прошлого года заключила сделку, обеспечивающую ей доступ к облачным ресурсам провайдера мощностью более 1 ГВт с возможностью использования до 1 млн TPU от Google. С этим проектом может быть связана сделка Anthropic по поводу $50 млрд инвестиций в вычислительную инфраструктуру в США в сотрудничестве с Fluidstack. Кроме того, у Anthropic очень тесные отношения с AWS, которая много инвестировала в стартап и развернула для него один из крупнейших в мире ИИ-кластеров Project Rainier. Наконец, в прошлом году компания подписала крупное соглашение с Microsoft Azure.

18.02.2026 [11:29], Сергей Карасёв

AWS внедрила вложенную виртуализацию для инстансов EC2Облачная платформа AWS сообщила о том, что некоторые её инстансы EC2 получили поддержку вложенной виртуализации (Nested Virtualization). Это позволяет решать определённые специфичные задачи, например, работать с эмуляторами мобильных приложений или выполнять моделирование автомобильного оборудования. Вложенная виртуализация даёт возможность запускать гипервизор внутри виртуальной машины, которая сама работает на другом гипервизоре. Иными словами, формируется виртуальная машина внутри виртуальной машины. Такой подход ориентирован на разработку и тестирование различных программных решений без использования физических серверов. Метод может быть полезен в производственной среде для контейнеризированных рабочих нагрузок, где часто применяются инструменты вроде Kubernetes и Docker.

Источник изображения: AWS AWS внедрила поддержку вложенной виртуализации в инстансы EC2 C8i, M8i и R8i. Все они базируются на платформе Intel Xeon 6 в кастомном исполнении. В этих процессорах реализована усовершенствованная технология Trust Domain Extensions (TDX), которая обеспечивает улучшенную изоляцию между гостевой ОС и гипервизором. Все экземпляры EC2 работают под управлением собственного гипервизора Amazon Nitro. В целом, архитектура вложенной виртуализации состоит из трех уровней. Это физическая инфраструктура AWS и гипервизор Nitro, формирующие нулевой уровень (L0). На первом уровне (L1) функционирует клиентский экземпляр EC2 с гипервизором. Второй уровень (L2) состоит из одной или нескольких виртуальных машин, созданных в инстансе EC2. В качестве гипервизоров уровня L1 в настоящее время могут использоваться Microsoft Hyper-V и KVM. Вложенная виртуализация доступна во всех регионах присутствия AWS.

17.02.2026 [19:40], Владимир Мироненко

Российский бизнес распробовал ИИ от Яндекса — потребление токенов за год выросло всемеро«Яндекс» сообщила неаудированные финансовые результаты за IV квартал и весь 2025 год, завершившийся 31 декабря 2025 года. Выручка компании выросла за IV квартал год к году на 28 % до 436,0 млрд руб. и на 32 % за весь год до 1441,1 млрд руб. Скорректированная чистая прибыль составила за квартал 53,5 млрд руб., увеличившись на 70 % год к году, и 141,4 млрд руб. за 2025 год (рост — 40 %). Скорректированный показатель EBITDA вырос в IV квартале год к году на 80 % до 87,8 млрд руб., за 2025 год рост составил 49 % — до 280,8 млрд руб. Выручка сегмента «Б2Б Тех» выросла за квартал год к году на 42 % до 13,9 млрд руб., за 2025 год — на 48 % — до 48,2 млрд руб. Скорректированный показатель EBITDA за IV квартал составил 2,9 млрд руб., увеличившись на 95 %, за 2025 год рост показателя составил 141 % — до 9,4 млрд руб. Рентабельность скорректированного показателя EBITDA увеличилась за отчётный квартал на 5,7 п.п. до 20,9 %, за 2025 год — на 7,6 п.п. до 19,6 %. В 2026 году компания ожидает рост выручки порядка 20 % год к году и скорректированный показатель EBITDA около 350 млрд руб. Компания отметила, что по темпам роста «Б2Б Тех» в IV квартале по-прежнему существенно опережал российский рынок корпоративных IT-решений — в 1,9 раза. Основная часть клиентов Yandex Cloud — внешние, на них приходится 93 % выручки направления. Количество клиентов выросло на 17 % год к году до почти 51 тыс. Львиную долю выручки (54 %) приносят крупные компании. Доля выручки от ИИ- и ИБ-сервисов, выросла почти в два раза до около 9 % от общей выручки Yandex Cloud. Сервисами безопасности пользовался каждый четвёртый коммерческий клиент. За 2025 год выручка ИБ-сервисов выросла в 2,3 раза год к году. Решения on-premise, которые помогают привлекать крупный бизнес, принесли в 2025 году 3,4 % от выручки Yandex Cloud. Отдельно отмечается, что темп роста корпоративных ИИ-сервисов значительно опережает рыночный. Так, квартальная выручка Yandex AI Studio выросла почти вдвое, до 2 млрд руб. Потребление токенов посредством API выросло примерно всемеро — 234 млрд токенов за весь 2025 год, из них более 150 млрд пришлось на IV квартал. Сервисами Яндекс 360 пользуются более 170 тыс. компаний, а их ежемесячная аудитория превышает 102 млн пользователей. На конец 2025 года общее количество платных учётных записей Яндекс 360 составило 8,1 млн, при этом свыше 2,2 млн приходится на крупные организации. Ежемесячная аудитория облачного сервиса «Яндекс Диск» составляет 61,5 млн человек. Также сообщается, что запущено тестирование «Яндекс Документов» и «Яндекс Диска» в варианте on-premise. До конца 2026 года в формате on-premise станут доступны в общей сложности 11 сервисов Яндекс 360.

17.02.2026 [15:33], Руслан Авдеев

Индийская Neysa привлечёт $1,2 млрд для расширения ИИ-облакаИндийский облачный стартап Neysa Networks Pvt. Ltd. Объявил о намерении привлечь до $1,2 млрд для расширения своей инфраструктуры дата-центров, сообщает Silicon Angle. Возглавляемый Blackstone консорциум обеспечит до половины суммы в виде акционерного финансирования, что обеспечит группе инвесторов мажоритарную долю в Neysa. Ещё $600 млн придётся на долговое финансирование. Компания рассчитывает, что привлечённые средства помогут утроить выручку в следующие несколько лет. Как заявляет Blackstone, инвестиции позволят Neysa сыграть важную роль в развитии ИИ-инфраструктуры в Индии и дают возможность компаниям и государственным структурам эффективнее и быстрее внедрять ИИ-технологии. Сейчас Neysa управляет публичной облачной платформой, оптимизированной для ИИ-задач, которая, по слухам, основана на около 2 тыс. ИИ-ускорителей, наиболее передовыми из которых являются NVIDIA H200. Также платформа оснащена чипами более общего назначения NVIDIA L40S. Предлагаются и классические CPU-инстансы. Neysa планирует увеличить количество используемых ИИ-ускорителей приблизительно в десять раз, до 20 тыс. По оценкам Blackstone, это примерно треть от всех ИИ-ускорителей, развёрнутых сейчас в индийских ЦОД. Впрочем, Neysa, вероятно захочет приобрести более современные решения, включая Vera Rubin. По-видимому, как минимум часть из них будет развёрнута в дата-центре в Хайдарабаде, о котором сообщалось в апреле 2025 года. Объект стоит как раз $1,2 млрд и вместит до 25 тыс. ИИ-ускорителей.

Источник изображения: Prashanth Pinha/unsplash.com Помимо набора программных инструментов, компания предлагает и инфраструктурные сервисы. Платформа Neysa позволяет клиентам дообучать открытые ИИ-модели под конкретные задачи. Кроме того, разработчики могут создать несколько вариантов той или иной модели, чтобы выбрать наилучший при помощи инструментов Nesya, которые также помогают отслеживать эффективность использования таких кастомных моделей и обеспечивают средства безопасности и контроля доступа. Также компания намерена улучшить наблюдаемость и управляемость нагрузок.

17.02.2026 [11:48], Руслан Авдеев

Прогноз — мультиоблачно: Policliud развернёт тысячу суверенных микро-ЦОД за пять летОблачный стартап Policliud из Франции поделился планом развернуть сотни периферийных суверенных дата-центров в следующие пять лет, сообщает Datacenter Dynamics. В ходе мероприятия World AI Cannes Festival 2026 компания объявила о намерении построить около 1 тыс. микро-ЦОД к концу 2030 года с использованием более 250 тыс. ИИ-ускорителей. Компания специализируется на малых «суверенных» проектах дата-центров, но на текущий момент ввела в эксплуатацию лишь восемь из них — во Франции, в странах, входящих в Совет сотрудничества арабских государств Персидского залива (GCC) и США. По данным компании, фактически речь идёт о контрактах на сумму около €10,5 млн ($12,44 млн) и использовании 1,2 тыс. ИИ-ускорителей. В 2026 году Policloud намерена ввести в эксплуатацию 100 ЦОД в 2026 году с суммарно более чем 25 тыс. ИИ-ускорителей. Компания применяет модульные микро-ЦОД без водяного охлаждения, расположенные как можно ближе к источнику данных. Это контейнерные дата-центры, вмещающие до 400 ускорителей на каждый модуль, площадью до 100 м2 и мощностью до 500 кВт. ЦОД используют распределённую облачную платформу Hivenet. Детали об используемых ИИ-ускорителях и вспомогательном оборудовании пока не раскрываются.

Источник изображения: Policloud Компания основана Дэвидом Гурле (David Gurlé), бывшим топ-менеджером Microsoft и основателем коммуникационной платформу Symphony для бизнеса со сквозным шифрованием трафика. В июне 2025 года Policloud привлекла €7,5 млн ($8,8 млн) в ходе начального раунда финансирования, возглавленного Global Ventures. В нём также приняли участие MI8 Limited, OneRagtime и Национальный институт исследований в области цифровых наук и технологий Франции (INRIA), а также частные инвесторы.

16.02.2026 [16:15], Сергей Карасёв

Oxide Computer готовит блейд-платформу на базе AMD EPYC TurinКомпания Oxide Computer, по сообщению The Register, провела раунд финансирования Series C, в ходе которого на дальнейшее развитие привлечено $200 млн. Стартап планирует направить средства в том числе на создание новой стоечной платформы на аппаратной платформе AMD EPYC 9005 Turin. Oxide Computer основана в 2019 году группой бывших инженеров Joyent и Sun Microsystems. Стартап занимается разработкой оборудования для дата-центров. При этом в качестве новой вычислительной единицы компания рассматривает целую стойку, а не отдельный сервер. Система Oxide Computer первого поколения несёт на борту 32 вычислительных модуля, оснащённых чипами AMD EPYC 7713P (Milan). Каждый модуль содержит 64 ядра CPU, до 1 Тбайт DDR4-3200 и 10 NMVe-накопителей U.2 суммарной вместимостью 32 Тбайт. Применённая объединительная плата обеспечивает питание и коммутационную способность до 12,8 Тбит/с. Общее энергопотребление стойки находится на уровне 15 кВт.

Источник изображения: Oxide Computer По словам генерального директора Oxide Computer Стива Така (Steve Tuck), компания проектирует обновлённую версию своей стоечной системы, в которую будут устанавливаться процессоры EPYC поколения Turin. Такие чипы насчитывают до 192 вычислительных ядер. Говорится об использовании памяти DDR5-6400. Вкупе это даст значительный прирост производительности по сравнению с оригинальной машиной. Важным преимуществом Turin является поддержка инструкций AVX-512, предназначенных для ускорения ресурсоёмких вычислений, таких как обработка больших массивов данных, задачи ИИ и пр. Какие именно модели процессоров будут задействованы в новых серверных модулях, Так уточнять не стал. Кроме того, Oxide Computer рассматривает возможность перехода на новые коммутационные решения, которые в перспективе придут на смену ныне применяющимся изделиям Intel Tofino 2. Одним из вариантов является чип-коммутатор Xsight Labs X2, обеспечивающий пропускную способность до 12,8 Тбит/с. При этом изучаются и другие альтернативы. Oxide Computer также не исключает, что в будущем начнёт оснащать свои системы ИИ-ускорителями на базе GPU.

16.02.2026 [15:49], Владимир Мироненко

Облачные сервисы в 2025 году росли в России самыми быстрыми темпами, опередив ИИ-сегментВ 2025 году рынок облачных инфраструктурных и платформенных сервисов показал самые высокие темпы роста среди сегментов российской IT-индустрии, составив 226,9 млрд руб. (рост год к году — на 36,7 %), сообщается в исследовании MWS Cloud (входит в МТС Web Services). Он опередил по темпам роста даже бурно развивающийся ИИ-рынок, увеличившийся на 35,1 % — до 60,8 млрд руб. Третье место в этом рейтинге занял сегмент ПО для взаимодействия с клиентами, увеличившийся на 26,6 %, от которого ненамного отстал сегмент офисного ПО (26,4 %). Всего российский рынок софта в 2025 года вырос на 23 % — до 1491,8 млрд руб. Согласно исследованию, на втором месте в России по объёму в прошлом год был рынок ПО для управления предприятиями и бухгалтерией — 173,6 млрд руб., на третьем — рынок управления данными — 156,9 млрд руб. Далее следуют рынки ПО для взаимодействия с клиентами — 155,7 млрд руб., информационной безопасности — 146,3 млрд руб., платформенного софта — 142,6 млрд руб., приложений для управления бизнесом — 106,2 млрд руб., офисного ПО — 100,4 млрд руб. Доля облачных решений на рынке софта России выросла с 10,7 % в 2021 году до 15,2 % в 2025 году, и, как ожидают в MWS Cloud, в 2026 года составит 15,8 %. Исследователи отметили, что доля Топ-5 облачных провайдеров на облачном рынке также растёт: с 63 % в 2022 году до 71 % в 2024-м и 72 % — в 2025-м. В 2026 году, как ожидается, она достигнет 74 %. Сообщается, что основной спрос формируется за счёт масштабирования ранее внедрённых облачных решений, оптимизации эксплуатационных затрат и перехода компаний от капитальной модели инвестиций к операционной. В структуре облачного рынка доля IaaS превышает 80 % совокупного объёма, что отражает продолжающуюся миграцию базовых ИТ-систем и вычислительных ресурсов в облако. В свою очередь, сегмент PaaS и платформенных сервисов отличается более высокими темпами роста при сравнительно небольшой текущей базе. Аналитики ожидают дальнейшего ускорения роста сегмента PaaS в текущем году на фоне распространения платформенных инструментов разработки, роста числа проектов с контейнеризацией и микросервисной архитектурой, а также стремления компаний сократить нагрузку на ИТ-команды за счёт использования управляемых сервисов.

11.02.2026 [15:34], Андрей Крупин

MWS Cloud запустила сервис Managed Kubernetes в промышленную эксплуатациюКомпания MWS Cloud (входит в МТС Web Services) сообщила о запуске Managed Kubernetes — управляемого PaaS-сервиса для развёртывания и эксплуатации кластеров Kubernetes в облаке. Managed Kubernetes позволяет создавать кластеры Kubernetes в облачном окружении MWS Cloud Platform и берёт на себя большую часть работ по обслуживанию кластеров, в том числе: обновление операционных систем и программного обеспечения, обеспечение работоспособности и безопасности контейнерной инфраструктуры, мониторинг управляющих компонентов. Решение также предоставляет роли для управления доступом к кластерам и возможность интеграции с другими инструментами MWS Cloud Platform — например, с Artifact Registry для работы с образами и Helm-чартами. Сервис поддерживает Kubernetes версии 1.34.x.

Источник изображения: Luke Peters / unsplash.com В рамках сервиса также доступны автоматическое масштабирование рабочих узлов, гибкая настройка ресурсов, сервисные окна для плановых операций, интеграция с IAM и сетевой инфраструктурой облака. Поддерживаются подключения постоянных томов хранения данных с использованием CSI (Container Storage Interface) и управление сетевой балансировкой на уровне кластера при помощи Cloud Controller Manager (CCM). Managed Kubernetes подходит для использования в широком спектре отраслей — от информационных технологий и e‑commerce до финансового сектора, медиа и промышленности. Развёртывание кластера занимает несколько минут и доступно в режиме self‑service через консоль MWS Cloud Platform, а также с использованием CLI и API.

11.02.2026 [12:17], Сергей Карасёв

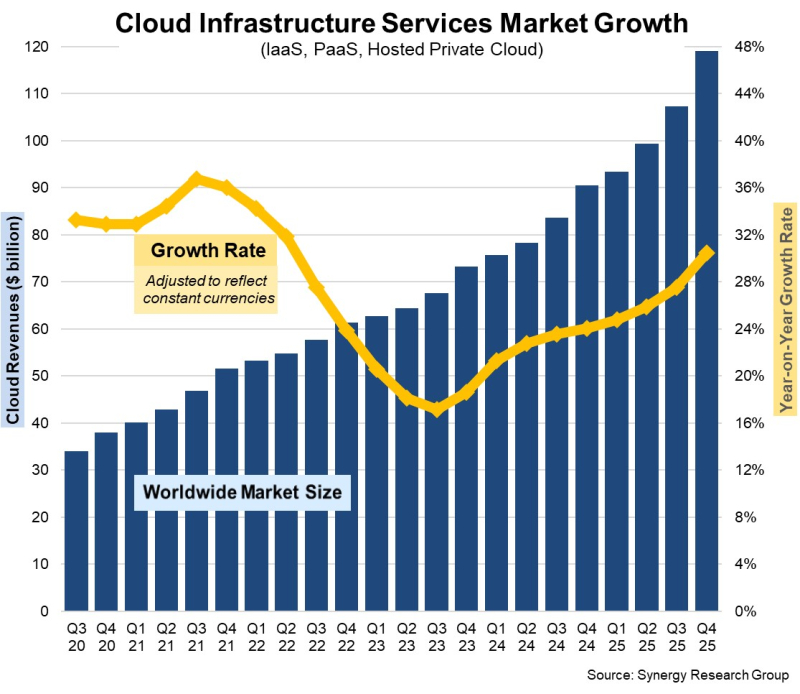

Квартальные расходы на облачные инфраструктуры приблизились к $120 млрдКомпания Synergy Research Group подвела итоги исследования мирового рынка облачных инфраструктур в IV квартале 2025 года. Затраты составили $119,1 млрд, что на 30 %, или на $29 млрд, больше по сравнению с последней четвертью 2024-го. В квартальном исчислении зафиксирована прибавка в размере $12 млрд. Аналитики отмечают, что рынок продолжает быстро расширяться на фоне стремительного внедрения ИИ, прежде всего генеративных сервисов. Темпы роста затрат на облачные инфраструктуры повышаются на протяжении девяти кварталов подряд. На публичные услуги IaaS и PaaS приходится основная доля расходов: в этих сегментах выручка в IV квартале 2025-го поднялась на 34 %. Ведущими поставщиками облачных услуг остаются AWS, Microsoft Azure и Google Cloud с долями соответственно 28 %, 21 % и 14 % в последней четверти 2025 года. На этих провайдеров приходится 68 % сектора публичных облаков. Среди игроков второго эшелона самые высокие темпы роста наблюдаются у CoreWeave, OpenAI, Oracle, Crusoe и Nebius. Причём компания CoreWeave, которая два года назад начинала свою деятельность практически с нуля, вошла в десятку крупнейших облачных провайдеров с квартальной выручкой на уровне $1,5 млрд. Рынок продолжает демонстрировать уверенный рост во всех регионах мира. В пересчете на местные валюты наиболее значительная динамика отмечена в Австралии, Индии, Индонезии, Ирландии, Мексике, Южной Африке и на Тайване, где темпы роста превышают среднемировые. В географическом плане США остаются крупнейшим игроком: здесь затраты увеличились на 30 % по итогам IV квартала 2025 года. В Европе лидируют Великобритания и Германия, а самые высокие темпы роста показывают Ирландия, Польша и Швеция. В 2025 году в целом объём глобального рынка облачных инфраструктур достиг $419 млрд. Для сравнения, годом ранее этот показатель составлял $330 млрд. Таким образом, зафиксировано увеличение примерно на 27 %. |

|