Материалы по тегу: trainium

|

17.12.2025 [16:41], Владимир Мироненко

Amazon не прочь инвестировать $10 млрд в OpenAI и дать стартапу фирменные ИИ-ускорители TrainiumAmazon ведет переговоры с OpenAI о возможных инвестициях более $10 млрд в стартап, предоставлении ему ускорителей серии Trainium и сдаче в аренду дополнительных вычислительных мощностей, сообщила газета The Financial Times. По словам её источников, знакомых с ситуацией, в случае заключения сделки капитализация OpenAI может превысить $500 млрд. Впрочем, переговоры находятся на ранней стадии и говорить об этом пока рано. Переговоры проходят после пересмотра первоначальной сделки стартапа с его ранним инвестором Microsoft. Компании реструктурировали свои отношения, что позволило OpenAI заключить соглашения об использовании вычислительных мощностей конкурирующих с Microsoft облачных провайдеров. В частности, стартап подписал сделку с Amazon, обязавшись потратить $38 млрд на аренду ИИ-ускорителей NVIDIA в течение семи лет. Обсуждаемое сейчас соглашение об инвестициях и облачных сервисах будет заключено в дополнение к этому соглашению. Ранее OpenAI обязался использовать сервисы Azure на $250 млрд. Microsoft сохраняет эксклюзивные права на передовые модели OpenAI до 2032 года. На данный момент стартапом заключены соглашения на сумму $1,5 трлн с NVIDIA, Oracle, AMD и Broadcom на поставку чипов и услуги вычислительной инфраструктуры. Циклический характер заключённых OpenAI сделок, а также отсутствие понятных механизмов коммерциализации ИИ и обоснованных расчётов стартапа по обеспечению окупаемости инвестиций, вызывает обеспокоенность некоторых инвесторов, считающих, что ИИ-индустрия находится на пути к формированию пузыря. OpenAI не единственная, кто заключает сделки с поставщиками. Например, разработчик ИИ-моделей Anthropic, привлёк в общей сложности около $26 млрд инвестиций от Amazon, Google, Microsoft и NVIDIA, используя их оборудование и сервисы. Amazon является одним из крупнейших инвесторов Anthropic. С 2023 года она вложила в стартап около $8 млрд. Обсуждаемая с Amazon сделка также знаменует собой еще один шаг в попытках OpenAI диверсифицировать чипы, используемые для обучения и запуска своих моделей. Источники сообщили, что Amazon и OpenAI также обсуждают коммерческое сотрудничество, связанное с маркетплейсом технологического гиганта. Стартап стремится закрепиться в сфере электронной коммерции и уже заключил сделки с Etsy, Shopify и Instacart с целью создания новых источников дохода.

03.12.2025 [13:25], Сергей Карасёв

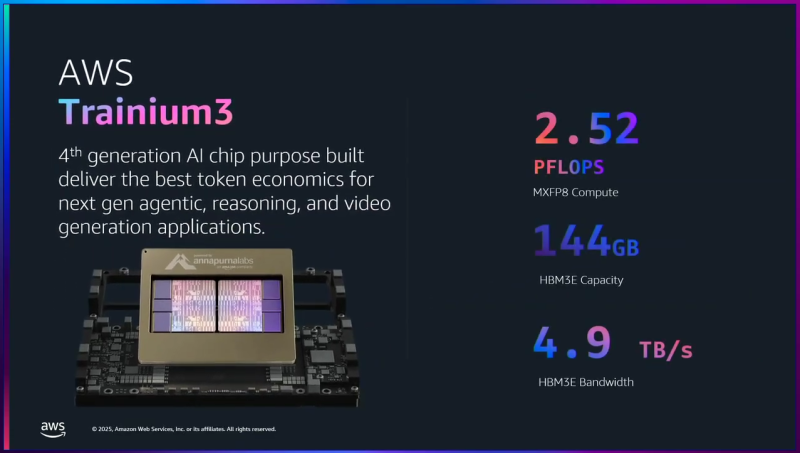

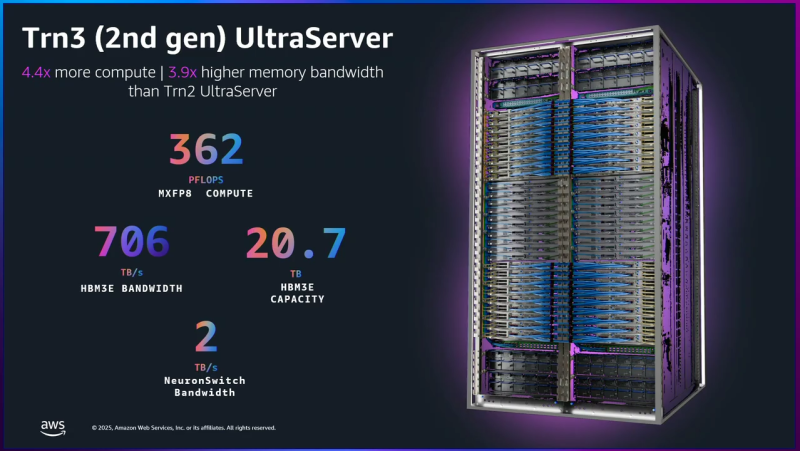

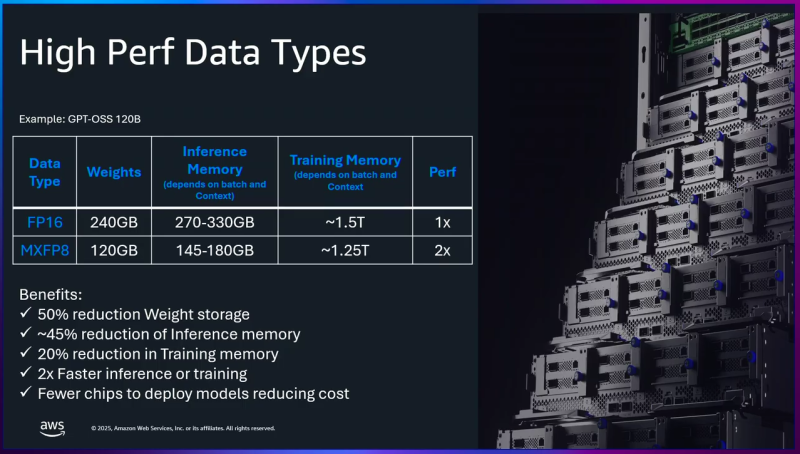

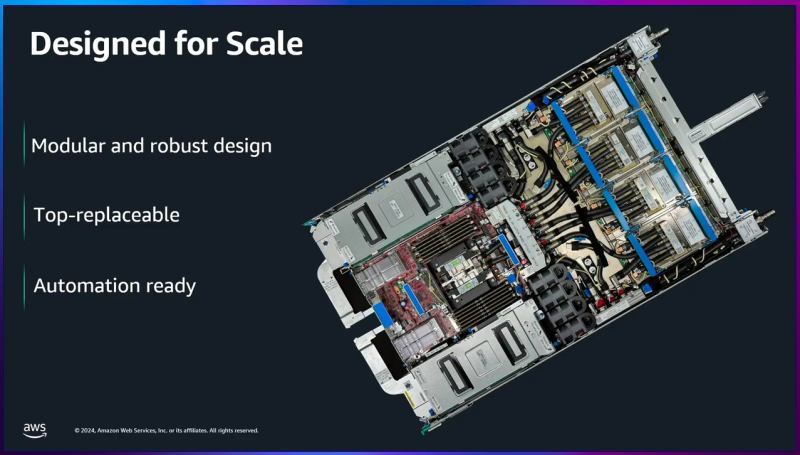

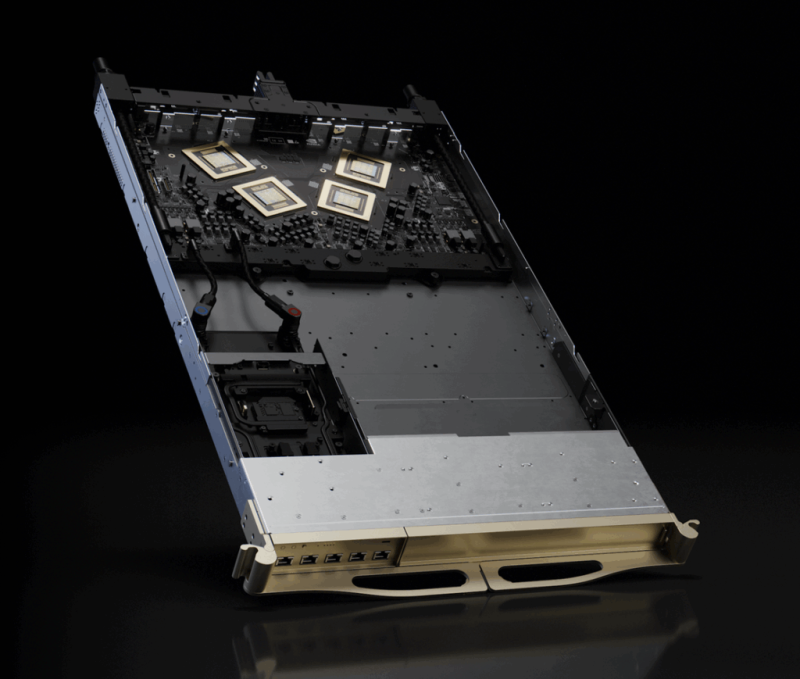

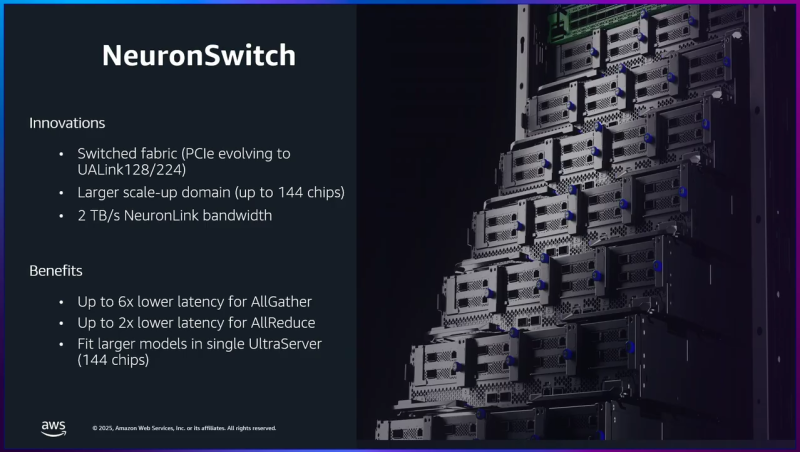

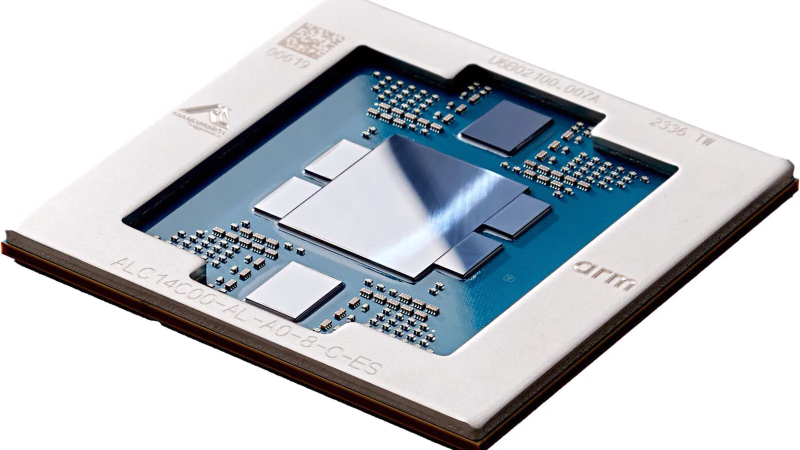

AWS представила ИИ-ускорители Trainium3: 144 Гбайт памяти HBM3E и 2,52 Пфлопс в режиме FP8Облачная платформа Amazon Web Services (AWS) анонсировала ускорители Trainium3 для задач ИИ, а также серверы Trainium3 UltraServer (Trn3 UltraServer). Эти машины, как утверждается, превосходят решения предыдущего поколения — Trainium2 UltraServer — в 4,4 раза по производительности, в 4 раза по энергоэффективности и почти в 4 раза по пропускной способности памяти. Чипы Trainium3 изготавливаются по 3-нм технологии TSMC. Они оснащены 144 Гбайт памяти HBM3E с пропускной способностью до 4,9 Тбайт/с. По сравнению с Trainium2 объём памяти увеличился в 1,5 раза, её пропускная способность — в 1,7 раза. Ранее сообщалось, что энергопотребление новых ускорителей может достигать 1 кВт. Изделие Trainium3 предназначено для высокоплотных и сложных параллельных рабочих нагрузок с использованием расширенных типов данных (MXFP8 и MXFP4). По утверждениям AWS, на операциях FP8 быстродействие достигает 2,52 Пфлопс. Для сравнения, AMD Instinct MI355X показывает результат в 10,1 Пфлопс, а чип поколения NVIDIA Blackwell — 9 Пфлопс. Как уточняет The Register, ускорители Trainium3 используют структурированную разрежённость (structured sparsity) формата 16:4, что фактически поднимает производительность в четыре раза — до 10 Пфлопс — на таких задачах, как обучение ИИ-моделей. Системы Trainium3 UltraServer объединяют 144 ускорителя Trainium3, которые соединены посредством интерконнекта NeuronSwitch-v1: эта технология, по оценкам AWS, увеличивает пропускную способность в два раза по сравнению с машинами UltraServer предыдущего поколения. Усовершенствованная сетевая архитектура Neuron Fabric сокращает задержки при передаче данных между чипами до менее чем 10 мкс. Каждая система Trainium3 UltraServer оперирует 20,7 Тбайт памяти HBM3E с общей пропускной способностью 706 Тбайт/с. Заявленная производительность достигает 362 Пфлопс в режиме FP8. Применённые в Trainium3 технологии, как заявляет AWS, дают возможность создавать приложения ИИ с практически мгновенным откликом. Платформа EC2 UltraClusters 3.0 позволяет объединять тысячи систем UltraServer, содержащих до 1 млн ускорителей Trainium, что в 10 раз больше, чем в случае изделий предыдущего поколения. При этом следующее поколение ускорителей Trainium4 получит интерконнект NVLink Fusion шестого поколения.

03.12.2025 [01:28], Владимир Мироненко

AWS «сдалась на милость» NVIDIA: анонсированы ИИ-ускорители Trainium4 с шиной NVLink FusionAWS готовит Arm-процессоры Graviton5, которые составят компанию ИИ-ускорителям Trainium4 с интерконнектом NVLink Fusion, фирменными EFA-адаптерам и DPU Nitro 6 с движком Nitro Isolation Engine. Но что более важно, все они будут «упакованы» в стойки стандарта NVIDIA MGX. Amazon и NVIDIA объявили о долгосрочном партнёрстве, в рамках которого ИИ-ускорители Trainium4 получит шину NVIDIA NVLink Fusion шестого поколения (по-видимому, 3,6 Тбайт/с в дуплексе), которая позволит создать стоечную платформу нового поколения, причём, что интересно, на базе архитектуры NVIDIA MGX, которая передана в OCP. Пикантность ситуации в том, что AWS годами практически игнорировала OCP, самостоятельно создавая стойки, их компоненты, включая СЖО, и архитектуру ИИ ЦОД в целом. Даже в нынешнем поколении стоек с GB300 NVL72 отказалась от референсного дизайна NVIDIA. NVIDIA же напирает на то, что для гиперскейлерам крайне трудно заниматься кастомными решениями — циклы разработки стоечной архитектуры занимают много времени, поскольку помимо проектирования специализированного ИИ-чипа, гиперскейлеры должны озаботиться вертикальным и горизонтальным масштабированием, интерконнектами, хранилищем, а также самой конструкцией стойки, включая лотки, охлаждение, питание и ПО.

Источник изображения: NVIDIA Вместе с тем управление цепочкой поставок отличается высокой сложностью, так как требуется обеспечить согласованную работу десятков поставщиков, ответственных за десятки тысяч компонентов. И даже одна задержка поставки или замена одного компонента может поставить под угрозу весь проект. Платформа NVIDIA если не устраняет целиком, то хотя бы смягчает эти проблемы, предлагая готовые стандартизированные решения, которые могут поставлять множество игроков рынка. По словам NVIDIA, в отличие от других подходов к масштабированию сетей, NVLink — проверенная и широко распространённая технология. В сочетании с фирменным ПО NVLink Switch обеспечивает увеличение производительности и дохода от ИИ-инференса до трёх раз, объединяя 72 ускорителя в одном домене. Пользователи, внедрившие NVLink Fusion, могут использовать любую часть платформы — каждый компонент может помочь им быстро масштабироваться для удовлетворения требований интенсивного инференса и обучения моделей агентного ИИ, говорит NVIDIA. Что касается самих ускорителей Trainium4, то в сравнении с Trainium3 они будут вшестеро быстрее в FP4-расчётах, втрое быстрее в FP8-вычислениях, а пропускная способность памяти будет увеличена вчетверо. Впрочем, пока собственные ускорители Amazon не всегда могут составить конкуренцию чипам NVIDIA. Любопытно и то, что в рассказе о Trainium3 компания отметила о переходе от PCIe к UALink в коммутаторах NeuronSwitch для фирменного интерконнекта NeuronLink, объединяющего до 144 чипов Trainium. Однако после крупных инвестиций NVIDIA в Synopsys развитие UALink как открытой альтернативы NVLink теперь под вопросом.

21.11.2025 [14:14], Руслан Авдеев

AWS и Humain построят в Эр-Рияде кампус AI Zone, где развернут до 150 тыс. ИИ-ускорителей NVIDIA GB300 и Amazon TrainiumAWS и инвестиционная компания Humain из Саудовской Аравии объявили о планах развёртывания в кампусе AI Zone в Эр-Рияде до 150 тыс. ИИ-ускорителей. В рамках расширенного партнёрства компании намерены предоставлять вычислительные мощности и ИИ-сервисы из Саудовской Аравии клиентам со всего мира. Первый в своём роде в Саудовской Аравии кампус AI Zone будет применяться для обучения ИИ и инференса, с доступом к новейшей ИИ-инфраструктуре на основе ускорителей NVIDIA GB300 и Amazon Trainium. Клиенты смогут быстро переходить от стадии концепции к непосредственно работам, а «железо» и ПО NVIDIA будут бесшовно интегрированы с инфраструктурой и сервисами AWS. Поддержка Amazon Bedrock, AgentCore и SageMaker обеспечит клиентам немедленный доступ к базовым моделям в рамках единой платформы без необходимости управления базовой инфраструктурой. Для расширения возможностей AI Zone компания Humain присоединится к программе AWS Solution Provider Program. Это поможет реализации совместного плана, анонсированного в мае 2025 года и предусматривающего инвестиции более $5 млрд в ИИ-инфраструктуру, сервисы AWS, обучение и развитие ИИ-специалистов в Саудовской Аравии. Представитель AWS в регионе EMEA заявил, что объединяя локальный опыт и инвестиции Humain с решениями AWS в сфере ИИ, а также аппаратные решения NVIDIA, инновационную платформу Amazon Bedrock и решения для бизнес-пользователей, включая Amazon Quick Suite, партнёры создают инновационный центр мирового уровня, способный обслуживать клиентов по всему миру. AWS и Humain также ускорят внедрение ИИ в государственном и частном секторах, в том числе развитие LLM с поддержкой арабского языка, включая ALLAM, и создание единого маркетплейса ИИ-агентов для правительственных сервисов.

Истчоник изображения: backer Sha/unsplash.com Для подготовки квалифицированных кадров AWS обучит 100 тыс. граждан Саудовской Аравии работе с облачными технологиями и специфике генеративного ИИ в рамках программы Amazon Academy, отдельно планируется поддержать программу повышения квалификации для 10 тыс. женщин. Усилия направлены на подготовку кадров для «ИИ-центричной» экономики, которая, по прогнозам, к 2030 году внесёт в ВВП страны вклад в объёме $130 млрд. Подобные проекты стали возможны во многом благодаря визиту в США наследного принца Саудовской Аравии Мохаммеда бин Салмана (Mohammed bin Salman). Визит способствовал ряду соглашений американских компаний с саудовским бизнесом и Humain в частности — с участием AMD, xAI, NVIDIA и др., а также открыл дорогу для поставок в королевство передовых ИИ-чипов.

10.11.2025 [15:00], Владимир Мироненко

Фирменные ИИ-ускорители Amazon всё ещё не могут конкурировать с чипами NVIDIA, считают некоторые стартапыНекоторые стартапы считают, что ИИ-чипы Trainium и Inferenetia собственной разработки Amazon менее конкурентоспособны, чем ускорители NVIDIA, сообщил ресурс Business Insider со ссылкой на внутреннюю документацию AWS. Согласно июльскому «конфиденциальному» внутреннему документу Amazon, ИИ-стартап Cohere обнаружил, что чипы Amazon Trainium 1 и 2 «уступают по производительности» ускорителям NVIDIA H100. Стартап отметил, что доступ к Trainium2 был «крайне ограничен», а в работе наблюдались частые перебои. Amazon и её подразделение Annapurna Labs всё еще изучают возникшие у Cohere «проблемы с производительностью», но прогресс в решении этих проблем был «ограниченным», отмечено в официальном документе. Также в нём упоминается стартап Stability AI, разработавший, в том числе, ИИ-генератор изображений Stable Diffusion, который высказывал схожие претензии. В частности, говорится, что чипы Amazon Trainium2 уступают NVIDIA H100 по задержке, что делает их «менее конкурентоспособными» с точки зрения скорости и стоимости. Ставка Amazon на чипы собственной разработки является частью её усилий по обеспечению конкурентоспособности в ИИ-гонке. Её прибыльность основана в том числе на использовании собственных процессоров Graviton вместо дорогостоящих чипов Intel. И сейчас Amazon тоже стремится задействовать собственные чипы для обработки ИИ-нагрузок. Если некоторые клиенты AWS не захотят использовать Trainium и будут настаивать на том, чтобы AWS запускала свои облачные ИИ-системы с использованием чипов NVIDIA, которые гораздо дороже её собственных решений, это отразится на её прибыли от облачных вычислений, отметил Business Insider. Рынок стартапов давно является важным для AWS, поэтому их претензии имеют большое значение для компании. Представитель Amazon заявил, что компания «благодарна» клиентам за отзывы, которые помогают сделать её чипы «еще лучше и более широко используемыми». Он добавил, что кейс с Cohere «не является актуальным», отметив, что её чипы Trainium и Inferentia «достигли отличных результатов» с такими клиентами, как Ricoh, Datadog и Metagenomi. «Мы очень довольны ростом и внедрением Trainium2, который на данном этапе в основном используется небольшим числом очень крупных клиентов, таких как Anthropic», — написал представитель в электронном письме ресурсу Business Insider. AWS утверждает, что ее собственные ИИ-ускорители предлагают на 30-40 % лучшие ценовые характеристики, чем нынешнее поколение GPU. Компания обладает «невероятными талантами» в области проектирования чипов и работает над новыми поколениями ускорителей. «Мы рассчитываем привлечь больше клиентов, начиная с Trainium 3, превью которого ожидается позже в этом году», — сказал представитель Amazon. Генеральный директор Amazon Энди Джасси (Andy Jassy) заявил во время отчёта о доходах компании, что чипы Trainium2 «полностью распределены по подписке» и теперь являются «многомиллиардным» бизнесом, который последовательно увеличивается на 150 % от квартала к кварталу. Жалобы клиентов Amazon на её чипы поступали и раньше. Согласно июльскому документу, стартап Typhoon обнаружил, что устаревшие ускорители NVIDIA A100 в три раза экономичнее для определённых рабочих нагрузок, чем чипы Inferentia2 от AWS, ориентированные на инференс. В свою очередь, исследовательская группа AI Singapore установила, что серверы AWS G6, оснащённые ускорителями NVIDIA, более экономичны по сравнению с Inferentia2 при различных вариантах использования. В прошлом году клиенты облака Amazon также отмечали «проблемы при внедрении» её пользовательских ИИ-чипов, которые создают «проблемные области», что ведёт к снижению их использования. Эти проблемы нашли отражение в доле рынка Amazon. По данным исследовательской компании Omdia, NVIDIA доминирует на рынке ИИ-чипов с долей более 78 %. За ней следуют Google и AMD, владеющие по чуть более 4 %. AWS занимает лишь шестое место с 2 % рынка. Наглядно иллюстрирует проблемы Amazon в этом отношении соглашение AWS и OpenAI стоимостью $38 млрд. Сделка предполагает использование облачных ИИ-серверов на базе ускорителей NVIDIA, без упоминания чипов Trainium. Ускорители NVIDIA не только обеспечивают высокую производительность, но подкрепляются широко распространённой платформой CUDA. Это качество особенно ценно при разработке крупных проектов в области ИИ с высоким уровнем риска, когда надёжность и имеющийся опыт могут сыграть решающую роль. В июльском документе сотрудники Amazon отметили, что технические ограничения и другие проблемы, связанные со сравнением пользовательских ИИ-чипов компании и ускорителей NVIDIA, стали «критическим препятствием» для клиентов, задумывающихся о переходе на чипы AWS. До публикации отчёта о доходах Amazon на прошлой неделе аналитики Bank of America соблюдали осторожность в оценке прогресса Tranium. В аналитической заметке, опубликованной в конце октября, они предупредили, что инвесторы «скептически» относятся к возможностям Trainium, и что «неясно», проявится ли высокий спрос на них «за пределами Anthropic». Недавно AWS запустила проект Project Rainier — ИИ-кластер из полумиллиона чипов Trainium2, которые будут использоваться для обучения LLM следующего поколения Anthropic. Ожидается, что к концу года Anthropic получит более 1 млн чипов Trainium2, но решение по этому вопросу ещё не принято. Если реализация проекта будет успешной, это станет огромным подспорьем для Amazon. Вместе с тем в прошлом месяце Anthropic подписала многомиллиардный контракт на использование Google TPU, отметив, что продолжит использовать Trainium. Хотя Anthropic публично признала сложность использования архитектур с разными чипами, представитель Amazon сообщил Business Insider, что Anthropic продолжает расширять использование Trainium и подчеркнул стремление компании предлагать клиентам широкий спектр аппаратных опций в рамках своих облачных сервисов. В ходе общения с аналитиками на прошлой неделе Джасси подчеркнул, что AWS сосредоточена на предоставлении «нескольких вариантов чипов». Он отметил, что цель состоит не в том, чтобы заменить чипы NVIDIA, а в том, чтобы предоставить клиентам больше выбора. Этой стратегии AWS придерживается и в других областях облачных вычислений, сказал он. «В истории AWS никогда не было случая, чтобы какой-то один игрок в течение длительного периода времени владел всем сегментом рынка, а затем мог удовлетворить потребности всех во всех аспектах», — сказал Джасси. В долгосрочной перспективе не слишком удачные продажи собственных ускорителей не лучшим образом скажутся на AWS. Компания понимает, что её решения могут быть менее производительны и удобны, поэтому и предлагает их по меньшей цене, чем ускорители NVIDIA. Однако стоимость их производства сравнима со стоимостью производства чипов такого же класса, и со временем она будет только расти. Проще говоря, Amazon меньше зарабатывает на своих чипах, а в худшем случае может терять на них деньги.

30.10.2025 [16:18], Руслан Авдеев

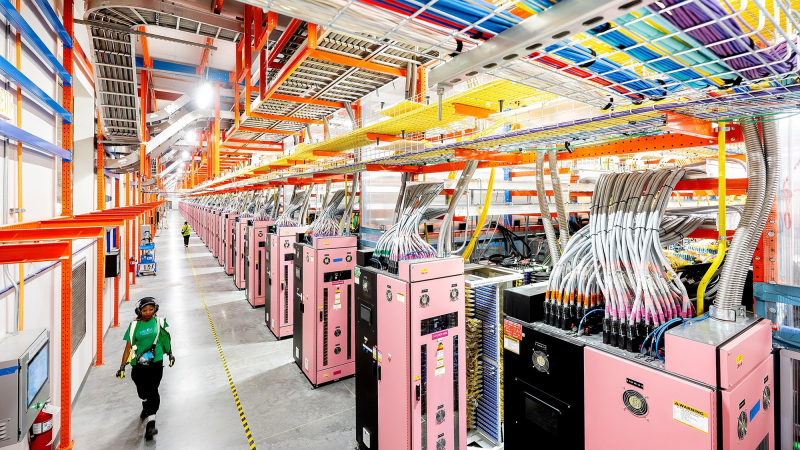

Полмиллиона ускорителей Trainium2: AWS развернула для Anthropic один из крупнейших в мире ИИ-кластеров Project RainierAWS объявила о запуске одного из крупнейших в мире ИИ-кластеров Project Rainier. Фактически амбициозный проект представляет собой распределённый между несколькими ЦОД ИИ-суперкомпьютер — это важная веха в стремлении AWS к развитию ИИ-инфраструктуры, сообщает пресс-служба Amazon. Платформа создавалась под нужды Anthropic, которая буквально на днях подписала многомиллиардный контракт на использование Google TPU. В рамках Project Rainier компания AWS сотрудничала со стартапом Anthropic. В проекте задействовано около 500 тыс. чипов Trainium2, а вычислительная мощность в пять раз выше той, что Anthropic использовала для обучения предыдущих ИИ-моделей. Project Rainier применяется Anthropic для создания и внедрения моделей семейства Claude. К концу 2025 года предполагается использование более миллиона чипов Trainium2 для обучения и инференса. В рамках Project Rainier в AWS уже создали инфраструктуру на основе Tranium2, на 70 % превосходящую любую другую вычислительную ИИ-платформу в истории AWS. Проект охватывает несколько дата-центров в США и не имеет аналогов среди инициатив AWS. Он задуман как гигантский кластер EC2 UltraCluster из серверов Trainium2 UltraServer. UltraServer объединяет четыре физических сервера, каждый из которых имеет 16 чипов Trainium2. Они взаимодействуют через фирменный интерконнект NeuronLink, обеспечивающий быстрые соединения внутри системы, что значительно ускоряет вычисления на всех 64 чипах. Десятки тысяч UltraServer объединяются в UltraCluster посредством фабрики EFA. Эксплуатация такого ЦОД требует повышенной надёжности. В отличие от большинства облачных провайдеров, AWS создаёт собственное оборудование и может контролировать каждый компонент, от чипов до систем охлаждения и архитектуру дата-центров в целом. Управляющие ЦОД команды уделяют повышенное внимание энергоэффективности, от компоновки стоек до распределения энергии и выбора методов охлаждения. Кроме того, в 2023 году вся энергия, потребляемая Amazon, полностью компенсировалась электричеством из возобновляемых источников. В Amazon утверждают, что в последние пять лет компания является крупнейшим покупателем возобновляемой энергии и стремится к достижению нулевых выбросов к 2040 году.

Источник изображения: AWS Миллиарды долларов инвестируются в ядерную энергетику и АКБ, а также крупные проекты в области возобновляемой энергетики для ЦОД. В 2024 году компания объявила о внедрении новых компонентов для ЦОД, сочетающих технологии электропитания, охлаждения и аппаратного обеспечения, причём не только для строящихся, но и уже для имеющихся объектов. Новые компоненты, предположительно, позволят снизить энергопотребление некоторых компонентов до -46 % и сократить углеродный след используемого бетона на 35 %.

Источник изображения: AWS Для новых объектов, строящихся в рамках Project Rainier и за его пределами, предусмотрено использование целого ряда новых технологий для повышения энергоэффективности и экоустойчивости. Некоторые технологии связаны с рациональным использованием водных ресурсов. AWS проектирует объекты так, чтобы использовать минимум воды, или вовсе не использовать её. Один из способов — отказ от её применения в системах охлаждения на многих объектах большую часть года, с переходом на охлаждение наружным воздухом.

Источник изображения: AWS Так, один из объектов Project Rainier в Индиане будет максимально использовать именно уличный воздух, а с октября по март дата-центры вовсе не станут использовать воду для охлаждения, с апреля по сентябрь в среднем вода будет применяться по несколько часов в день. Согласно отчёту Национальной лаборатории им. Лоуренса в Беркли (LBNL), стандартный показатель WUE для ЦОД 0,375 л/кВт·ч. В AWS этот показатель равен 0,15 л/кВт·ч, что на 40 % лучше, чем в 2021 году.

01.07.2025 [09:02], Владимир Мироненко

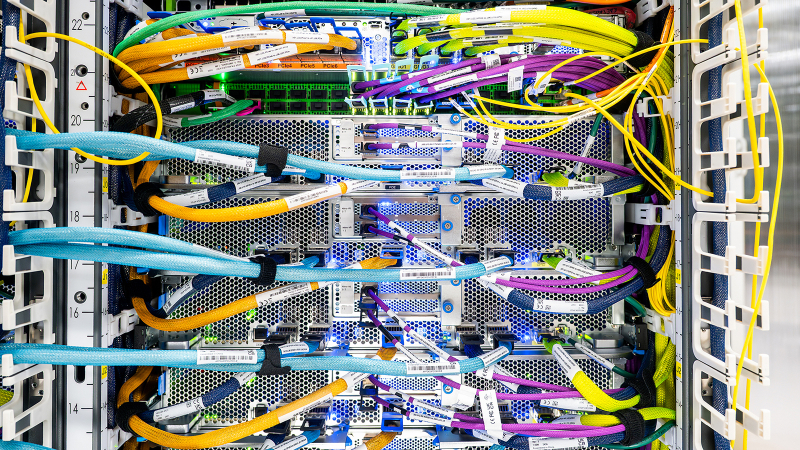

Крупнейший в истории AWS ИИ-суперкомпьютер Project Rainier охватит несколько ЦОД, но будет экологичнымВ настоящее время Amazon Web Services (AWS) занимается строительством ИИ-суперкомпьютера Project Rainier. Проект, охватывающий несколько ЦОД в США, по своим масштабам не похож ни на что, что когда-либо пыталась реализовать AWS. Этот огромный уникальный суперкомпьютер разработан для создания и работы ИИ-моделей следующего поколения. Партнёром AWS в реализации проекта выступает ИИ-стартап Anthropic, который будет использовать новый ИИ-кластер для создания и развёртывания будущих версий LLM Claude. У компаний довольно тесные отношения, а появление Project Rainier снизит зависимость Anthropic и AWS от дефицитных ускорителей NVIDIA, которых не хватает и для собственных нужд Amazon. «Rainier обеспечит в пять раз больше вычислительной мощности по сравнению с крупнейшим в настоящее время кластером Anthropic», — сообщил Гади Хатт (Gadi Hutt), директор по разработке и проектированию продуктов Annapurna Labs, подразделения AWS по разработке чипов. Чем больше вычислений вложить в обучение Claude, тем умнее и точнее будет модель. «Мы создаём вычислительную мощность в масштабах, которых никогда не было раньше, и мы делаем это с беспрецедентной скоростью и гибкостью», — подчеркнул Хатт. Сообщается, что Project Rainier спроектирован как огромный кластер EC2 UltraCluster, состоящий из серверов UltraServers с Trainium2. Trainium2 — ИИ-ускоритель собственной разработки Amazon, предназначенный для обучения ИИ-моделей. UltraServer — новый тип вычислительной системы, которая объединяет четыре физических сервера, каждый из которых содержит 16 ускорителей Trainium2, взаимодействие между которыми осуществляется с помощью интерконнекта NeuronLinks (кабели синего цвета на фото). Связь между компонентами суперкомпьютера реализуется на двух критических уровнях: NeuronLinks обеспечивают высокоскоростные соединения внутри UltraServer, в то время как DPU Elastic Fabric Adapter (EFA) объединяет UltraServer внутри ЦОД и между ЦОД. Этот двухуровневый подход позволяет максимизировать скорость в местах, где в этом больше всего есть потребность, сохраняя гибкость масштабирования в рамках нескольких дата-центров. Эксплуатация и обслуживание такого огромного вычислительного кластера отличается повышенной сложностью. И в данном случае надёжность системы имеет первостепенное значение. Именно здесь подход компании к разработке оборудования и ПО действительно выходит на первый план, говорит компания. Благодаря тому, что AWS сама занимается разработкой оборудования, она может контролировать каждый аспект технологического стека, от мельчайших компонентов чипа до ПО и архитектуры самого ЦОД. Это также позволяет ускорить внедрение технологий и снизить затраты при внедрении ИИ. «Когда у вас есть полная картина, от чипа до ПО и самих серверов, вы можете проводить оптимизацию там, где это имеет наибольший смысл», — говорит директор по инжинирингу Annapurna Labs Рами Синно (Rami Sinno). «Иногда лучшим решением может быть перепроектирование того, как подаётся питание серверов, или переписывание ПО, которое всё координирует. Это может происходить и одновременно. Поскольку у нас есть обзор всего на каждом уровне, мы можем быстро устранять неполадки и внедрять инновации гораздо быстрее», — добавил он. Вместе с тем, по словам Amazon, внедрение мощной ИИ-инфраструктуры будет достаточно экологичным. Вся электроэнергия, потребляемая Amazon, включая её ЦОД, в 2023 году была полностью компенсирована закупками из возобновляемых источников энергии. В течение последних пяти лет Amazon была крупнейшим корпоративным покупателем возобновляемой энергии в мире. Компания инвестирует миллиарды долларов в ядерную энергию и использование аккумуляторов, а также в финансирование масштабных проектов возобновляемой энергии по всему миру. Amazon по-прежнему намерена добиться нулевого уровня выбросов углерода к 2040 году. И Project Rainier ей в этом поможет. В прошлом году AWS объявила, что будет развёртывать новые компоненты, которые объединяют достижения в области питания и охлаждения, не только в строящихся, но и в существующих ЦОД. Их использование, как ожидается, позволит снизить потребление энергии механизмами до 46 % и сократить выбросы парниковых газов при производстве бетона на 35 %. Новые объекты для Project Rainier будут включать в себя различные усовершенствования для повышения энергоэффективности и экологичности с акцентом на сокращение потребления водных ресурсов и использованию забортного воздуха для охлаждения. Например, в ЦОД в округе Сент-Джозеф (St. Joseph), штат Индиана, с октября по март ЦОД вообще не будут использовать воду для охлаждения, а с апреля по сентябрь питьевая вода будет нужна только в течение нескольких часов в день. Amazon не уточняет, о каком именно кампусе идёт речь, но уже известно, что компания строит в Индиане дата-центр, который будет потреблять энергии как половина населения штата. Благодаря инженерным инновациям AWS является лидером отрасли по эффективности использования воды, заявляет компания. На основании результатов недавнего исследования Национальной лаборатории Лоуренса в Беркли, посвящённого эффективности использования воды в ЦОД, отраслевой стандартный показатель составляет 0,375 л/кВт·ч, тогда как у AWS он равен всего 0,15 л/кВт·ч. Компания улучшила этот параметр на 40 % по сравнению с 2021 годом.

19.06.2025 [11:21], Сергей Карасёв

AWS готовит чип Graviton и ускоритель Trainium следующего поколенияОблачная платформа Amazon Web Services (AWS), по сообщению ресурса CNBC, готовит обновлённую модификацию своего серверного процессора Graviton4, а также ускоритель Trainium следующего поколения, предназначенный для ресурсоёмких приложений ИИ. Оригинальная версия Graviton4 дебютировала в конце 2023 года. Изделие, разработанное подразделением Annapurna Labs в составе AWS, содержит 96 ядер Neoverse V2 Demeter с 2 Мбайт кеша L2 в расчёте на ядро. Используются 12 каналов памяти DDR5-5600. В общей сложности чип насчитывает 73 млрд транзисторов и изготавливается по 4-нм техпроцессу TSMC. По имеющейся информации, у инстансов на базе обновлённой версии Graviton4 пропускная способность сетевой подсистемы увеличится в 12 раз — с нынешних 50 Гбит/с до 600 Гбит/с. Прочие технические характеристики готовящегося изделия не раскрываются, но известно, что информацию о сроках его доступности AWS раскроет до конца текущего месяца. Сообщается также, что ускоритель Trainium следующего поколения выйдет до конца текущего года. Нынешнее решение Trainium2, основанное на ядрах NeuronCore-V3, было представлено в ноябре 2023-го. Его производительность достигает 1,29 Пфлопс в режиме FP8. Утверждается, что быстродействие Trainium3 увеличится в два раза, то есть будет составлять до 2,58 Пфлопс (FP8). Ранее появлялась информация, что энергопотребление Trainium3 может достигать 1000 Вт. Теперь говорится, что в плане энергетической эффективности ИИ-ускоритель нового поколения на 50 % превзойдёт предшественника. Возможно, имеется в виду быстродействие в расчёте на 1 Вт затрачиваемой энергии.

04.12.2024 [17:43], Сергей Карасёв

AWS построит распределённый ИИ-суперкомпьютер Project Rainier с десятками тысяч ИИ-ускорителей Trainium2Облачная платформа AWS официально представила инстансы EC2 Trn2 и Trn2 UltraServer — самые высокопроизводительные решения EC2, ориентированные на ИИ-приложения, машинное обучение и задачи инференса. В основу положены фирменные ускорители Amazon Trainium2 второго поколения. ИИ-ускорители Trainium2 содержат восемь ядер NeuronCore и 96 ГиБ памяти HBM с пропускной способностью 2,9 Тбайт/с. Ядра могут адресоваться и использоваться по отдельности или же пары физических ядер могут быть сгруппированы в один логический блок. Trainium2 обеспечивает FP8-быстродействие до 1,3 Пфлопс, а FP8-производительность в разреженных вычислениях достигает 5,2 Пфлопс. Инстансы EC2 Trn2 содержат 16 ускорителей Trainum2, связанных посредством интерконнекта NeuronLink. В сумме это даёт 128 ядер NeuronCore и 1,5 ТиБ памяти HBM с суммарной пропускной способностью 46 Тбайт/с. Производительность на операциях FP8 достигает 20,8 Пфлопс. Каждый инстанс включает 192 vCPU, 2 ТиБ памяти и адаптеры AWS Elastic Fabric Adapter (EFA) v3 на 3,2 Тбит/с. Утверждается, что инстансы Trn2 обеспечивают в четыре раза более высокую производительность, в четыре раза большую пропускную способность памяти и в три раза большую ёмкость памяти, нежели инстансы Trn1. Кроме того, экземпляры Trn2 предлагают на 30–40 % лучшее соотношение цены и производительности, чем EC2 P5e и P5en на базе GPU. Инстансы Trn2 доступны в регионе AWS US East (Огайо), а в ближайшем будущем появятся и в других зонах. В свою очередь, платформа UltraServer включает четыре инстанса Trn2 (64 ускорителя Trainum2) с интерконнектом NeuronLink с низкой задержкой. В сумме это даёт 512 ядер NeuronCore и 6 ТиБ памяти HBM с суммарной пропускной способностью 185 Тбайт/с. Быстродействие на операциях FP8 составляет 83 Пфлопс (332 Пфлопс в разреженных вычислениях). Новые узлы используют СЖО. Десятки тысяч ускорителей Trainium2 могут формировать кластеры EC2 UltraCluster. В частности, такую систему в рамках инициативы Project Rainier компания Amazon намерена создать в партнёрстве со стартапом Anthropic, который специализируются на технологиях генеративного ИИ. Интересно, что ИИ-суперкомпьютер Project Rainier будет распределённым — его узлы разместятся сразу в нескольких ЦОД. ВОЛС между дата-центрами организует Lumen. Одной из причин от попытки построить один гигантский кампус называется невозможность быстро получить достаточно энергии в одном месте, хотя у компании уже есть площадка рядом с АЭС. Недавно Amazon объявила о намерении удвоить инвестиции в Anthropic, доведя их до $8 млрд. Создание системы Rainier планируется завершить в следующем году. Ожидается, что она станет одним из крупнейших в мире вычислительных кластеров для обучения моделей ИИ. По заявлениям AWS, комплекс обеспечит в пять раз более высокую производительность по сравнению с платформой, которую Anthropic использовала до сих пор для разработки своих языковых моделей. Достанутся ли Anthropic и ресурсы ещё облачного ИИ-суперкомпьютера Project Ceiba, который получит 21 тыс. суперчипов NVIDIA Blackwell, не уточняется. Кроме того, по сообщению The Register, компания Amazon приоткрыла завесу тайны над ИИ-ускорителями следующего поколения — изделиями Trainium3. По сравнению с предшественниками они, как утверждается, обеспечат четырёхкратное увеличение быстродействия. Говорится, что Trainium3 станет первым специализированным ускорителем для ИИ и машинного обучения, созданным на основе 3-нм техпроцесса. Эффективность по сравнению с Trainium2 увеличится примерно на 40 %. Ожидается, что на коммерческом рынке изделия Trainium3 появятся в конце 2025 года.

25.11.2024 [20:50], Руслан Авдеев

Amazon вложит ещё $4 млрд в Anthropic и снизит её зависимость от NvidiaКомпания Amazon (AWS) раскрыла планы удвоить инвестиции в Anthropic, доведя их до $8 млрд. Объявление о новых вложениях было сделано через год после того, как гиперскейлер сообщил о выделении стартапу $4 млрд, сообщает Silicon Angle. На тот момент главный конкурент OpenAI назвал AWS своим ключевым облачным провайдером. С новой сделкой роль AWS в обучении моделей Anthropic только усилится. Anthropic представила свою наиболее передовую модель Claude 3.5 Sonnet в прошлом месяце — это улучшенная версия большой языковой модели (LLM) той же серии, дебютировавшей несколько месяцев назад. Новая Claude 3.5 Sonnet лучше предшественницы в выполнении некоторых задач, включая написание кода. Она также обошла OpenAI GPT-4o в нескольких бенчмарках. Anthropic предлагает свои LLM через сервис Amazon Bedrock, обеспечивающий доступ к управляемым ИИ-моделям. Расширенное сотрудничество обеспечит пользователям ранний доступ к функции, позволяющей настраивать модели Claude с использованием кастомных датасетов. Также планируется поддержать друг друга в разработках. Anthropic будет использовать ИИ-ускорители Trainium и Inferentia для внутренних задач. В компании подчеркнули, что задействуют ускорители для крупнейших базовых моделей. В то же время специалисты Anthropic поддержат AWS в разработке новых чипов Tranium. Стек ПО Neutron включает компилятор, оптимизирующий ИИ-модели для работы на инстансах Tranium, и некоторые другие инструменты. Компания также работает над низкоуровневыми программными ядрами, распределяющими задачи между вычислительными ядрами ускорителей. Последний раунд финансирования Anthropic состоится через два месяца после того, как OpenAI привлекла рекордные для стартапа $6,6 млрд. Также она получила кредитную линию на $4 млрд от группы банков. OpenAI, оцениваемая в $157 млрд, будет инвестировать средства в ИИ-исследования и вычислительную инфраструктуру. |

|