Материалы по тегу: software

|

10.03.2026 [17:14], Руслан Авдеев

IBM второй раз пытается заключить контракт с Почтой Великобритании для замены скандального софта Fujitsu HorizonАмериканский IT-гигант IBM подал заявку на заключение контракта с Почтой Великобритании стоимостью в сотни миллионов фунтов стерлингов. Задолго до этого компания уже претендовала на то, чтобы заменить проблемное ПО Horizon японской Fujitsu, но на тот момент не преуспела, сообщает Computer Weekly. Теперь IBM предпринимает вторую попытку. В рамках плана Почты по замене Horizon партнёром по заявке выступает американская DXC. В 2013 году IBM участвовала в проекте с несколькими участниками и уже начала выполнение работ, но заявку отменили в 2015 году. С тех пор Почта должна IBM деньги за уже проделанные работы. Не так давно выяснилось, что работы в своё время не удалось завершить, поскольку понять структуру ПО Horizon без участия Fujitsu было весьма проблематично. Буквально никто не знал, как работает программное обеспечение, и справиться с управлением им без помощи Fujitsu было «феноменально» трудно. Из-за этого возникли сомнения, что с миграцией можно справиться до завершения контракта с японской компанией, поэтому пришлось просто продлить договор на обслуживание с ней. Система Horizon используется и по сей день, а работа IBM полностью так и не была завершена.

Источник изображения: Vitaly Gariev/unspalsh.com Недавно представитель Почты Великобритании в одном из интервью заявил, что следующим летом сотрудничество с Fujitsu прекратится, а к 2030 году от ПО Horizon, состоящего из более чем 80 компонентов, «не останется следов». Сейчас на контракт стоимостью £323 млн претендует IBM. В числе прочего предусмотрены техническая поддержка почтовых служащих, разработка ПО и управление релизами, миграция из собственного ЦОД в облако, а также строительство облачной платформы для внутренних операций и др. Это лишь первая часть тендера; заявки уже подали несколько компаний. Второй лот стоимостью £160 млн призван найти поставщика EPOS-системы пользовательских терминалов для замены устаревшего интерфейса Horizon. Заявки уже подала дюжина потенциальных исполнителей, но только трое из них вошли в шорт-лист. Среди них — компания Escher, занимающаяся разработкой ПО для EPOS и поставлявшая промежуточное ПО (middleware) для системы Horizon в прошлом. Почтовая служба не комментирует состав участников, поскольку тендер ещё не завершён. Одним из требований к возможным исполнителям, уже знакомым с проблемами ПО Horizon, является готовность исправить сложившуюся ситуацию на британской почте. Впервые информация о скандальных проблемах Почты Великобритании появилась ещё в 2009 году. В то время из-за сбоев японского ПО невинно пострадали многочисленные почтовые служащие, некоторые из которых понесли уголовную ответственность. Fujitsu и почтовые чиновники до сих пор перекладывают вину друг на друга, а суд подчеркнул, что и почта, и компания должны были знать о дефектах системы.

06.03.2026 [01:05], Владимир Мироненко

Планирование пошло не по плану: аналоги ERP SAP и Oracle причислили к КИИВ России признали ERP-системы, аналогичные продуктам зарубежных SAP и Oracle, объектами критической информационной инфраструктуры (КИИ). Распоряжением правительства №360-р они были добавлены в единый перечень из 397 типовых отраслевых объектов КИИ. Они прямо включены в перечень объектов КИИ для химической, металлургической, горнодобывающей, ракетно-космической и оборонной промышленности, сообщил «Коммерсантъ». Ресурс отметил, что решение правительства формализует принятые ранее отраслевые перечни (с 2024 года) и обязывает предприятия проводить категорирование ERP, усиливать их защиту по требованиям ФСТЭК, что влечёт за собой дополнительные расходы. Также включение в перечень стимулирует к переходу на отечественные аналоги вместо иностранных SAP или Oracle из-за возможных штрафов, производственных простоев и роста IT-затрат. Ранее было предложено создание национального аналога SAP, но она не нашла поддержки у бизнеса. Импортозамещение ERP-систем, в том числе в субъектах КИИ, сейчас курирует Национальный центр компетенций по информационным системам управления (НЦК ИСУ). Он предлагает поэтапный подход, чтобы минимизировать риски: сначала провести категорирование объектов с обязательным аудитом текущих платформ (включая SAP и Oracle), а затем начать миграцию на отечественные аналоги с сохранением ключевых бизнес-процессов. НЦК ИСУ отметил, что вводимые правила в итоге затруднят категорирование ERP, приведут к усложнению проектов и росту затрат на них, а причисление ERP к КИИ означает, что регулятор видит риски защищённости самих этих решений. Вместе с тем эксперты отметили, что явных требований к самим системам распоряжение правительства не добавляет, а существующие приказы ФСТЭК и других ведомств описывают лишь меры обеспечения защиты от различных угроз. Поэтому следует ожидать, что поддержка иностранных ERP-решений, которая всё ещё осуществляется без участия западных вендоров, сохранится. Как ожидается, из-за перевода в объекты КИИ затраты компаний вырастут из-за внедрения дополнительных средств защиты, сегментации сети, резервирования и пересмотра архитектуры, но основная сумма пойдёт не на лицензии, а на интеграцию, аудит и сопровождение.

05.03.2026 [22:49], Андрей Крупин

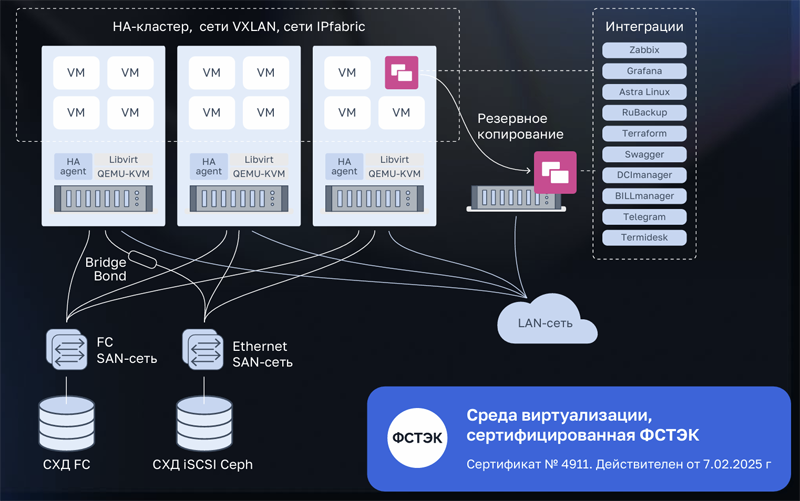

Платформа серверной виртуализации VMmanager дополнилась инструментами резервного копирования RuBackup«Группа Астра» объявила о выпуске комплексного решения, объединяющего платформу серверной виртуализации VMmanager и систему резервного копирования RuBackup. Платформа VMmanager предназначена для решения задач серверной виртуализации и построения отказоустойчивых кластеров — в её составе представлены все необходимые инструменты для создания отказоустойчивой среды виртуализации, включая High Availability, живую миграцию, автоматическую балансировку и поддержку аппаратных систем хранения данных. В свою очередь, RuBackup обеспечивает защиту обрабатываемой информации. Интеграция продуктов выполнена на системном уровне: копирование выполняется безагентно через API гипервизора без остановки приложений, с поддержкой полных, инкрементальных и дифференциальных копий при минимальном влиянии на производительность.

Архитектура платформы серверной виртуализации VMmanager (источник изображения: astra.ru) По словам разработчиков, объединение VMmanager с RuBackup даёт заказчику комплексный эффект. С одной стороны, это операционная и коммерческая эффективность: единая закупка, общая техническая поддержка и снижение совокупной стоимости владения. С другой — технологическая синергия: платформы развиваются с учётом друг друга, а их взаимодействие реализовано до уровня, когда защита данных становится естественной функцией виртуальной среды. Обе разработки имеют сертификаты ФСТЭК России и включены в реестр отечественного ПО Минцифры, что гарантирует соответствие требованиям безопасности и готовность к использованию в государственных и корпоративных проектах.

05.03.2026 [19:07], Андрей Крупин

Представлена российская GitOps-платформа HyperDrive для автоматизации процессов разработкиКомпания Orion soft, занимающаяся разработкой экосистемы инфраструктурного программного обеспечения для Enterprise-сегмента, выпустила новый продукт — GitOps-платформу HyperDrive. HyperDrive помогает стандартизировать динамическую инфраструктуру для процессов разработки ПО, автоматизировать типовые задачи бизнеса по созданию софтверных решений и сократить время вывода новых продуктов на рынок без увеличения штата и операционных рисков. Система позволяет командам разработки и DevOps предоставлять комплексные среды «по запросу» через веб-интерфейс или как код, управлять Kubernetes и инфраструктурными сервисами декларативно и без ручных операций. Платформа фиксирует целевое состояние инфраструктуры в коде, также следит за его параметрами и вносимыми изменениями.

Источник изображения: Flipsnack / unsplash.com Отдельный акцент в HyperDrive сделан на безопасности и соответствии требованиям регуляторов. Платформа поддерживает управление доступами, аудит, работу с секретами и сертификатами, что делает её применимой в регулируемых отраслях, где SaaS-решения невозможны. HyperDrive поставляется как готовый продукт с поддержкой и гибкой кастомизацией. Программный комплекс разворачивается в контуре заказчика и поддерживает интеграцию с CI/CD- и корпоративными системами.

05.03.2026 [14:21], Владимир Мироненко

Дефицит памяти поможет Broadcom подзаработать, но не так, как вы подумалиВ связи с ростом цен на оперативную память на фоне её дефицита, который, по прогнозам экспертов, сохранится и в 2027 году, VMware (подразделение Broadcom) предложила частное облако VMware Cloud Foundation (VCF) 9.0 в качестве решения, необходимого для работы в новых условиях. VMware заявила, что «традиционный подход, заключающийся в увеличении количества оборудования для решения проблем производительности и масштабируемости, больше не является жизнеспособным». «Broadcom разработала VCF 9.0 специально для решения этой экономической задачи, предложив три различных подхода: снижение совокупной стоимости владения за счёт многоуровневого хранения памяти, отсрочка капитальных затрат за счёт передовых технологий повышения эффективности и обеспечение немедленного внедрения в существующий парк оборудования», — сообщила она. Как отметил The Register, VMware всегда продвигала многоуровневую организацию памяти VCF 9 как возможность снизить затраты на инфраструктуру за счёт уменьшения установленного объёма DRAM путём прозрачного переноса части данных на NVMe. Вместе с тем, не следует забывать, что стоимость SSD также выросла. VMware также признаёт, что её архитектура памяти подходит не для всех рабочих нагрузок и не предназначена для виртуальных машин, чувствительных к задержкам, или очень больших инстансов. Но VMware всё равно утверждает, что «наиболее прямое решение проблемы стремительного роста цен на DRAM — это просто использовать её меньше», а VCF 9.0 позволяет «заменить дорогостоящую DRAM значительно более дешёвым хранилищем NVMe». Многоуровневое распределение памяти VMware в настоящее время превосходит альтернативу в виде CXL, пишет The Register. Кроме того, новые поколения серверных процессоров AMD и Intel создали возможность очередного этапа консолидации нагрузок. Dell утверждает, что её клиенты заменяют семь серверов одной новой машиной; Intel говорит о консолидации 5:1. Новые серверы позволяют запускать огромное количество ВМ, что концентрирует риски и требует огромного количества дорогостоящей памяти. Но VMware и не требует, чтобы в каждом хосте в кластере использовалось многоуровневое распределение памяти. Так что VCF 9 в текущей ситуации действительно может оказаться эффективным средством снижения затрат. В то же время The Register отметил, что многие пользователей vSphere считают VCF 9 очень дорогим продуктом, несмотря на уверения Broadcom в обратном. При этом Broadcom, похоже, в принципе не готова идти на ценовые уступки — или бери, или уходи.

04.03.2026 [10:00], Сергей Карасёв

«Базис» создаёт собственный протокол передачи данных для удалённой работыКомпания «Базис», лидер российского рынка ПО управления динамической ИТ-инфраструктурой, разрабатывает собственный протокол для доступа к виртуальным рабочим местам — Basis Connect. Протокол станет частью VDI-платформы Basis Workplace версии 3.3 и обеспечит её пользователям качественную передачу изображения и быстрый отклик даже на медленных каналах связи. Первая версия Basis Connect будет доступна заказчикам для тестирования уже в I квартале этого года. Протокол передачи данных является важной частью инфраструктуры виртуальных рабочих столов, он должен обеспечивать быстрый отклик на действия пользователя, поддерживать периферийные устройства, передавать большие объёмы информации, не допускать потери качества аудио- и видеопотоков. От перечисленного зависит, сможет ли сотрудник комфортно взаимодействовать с ресурсоёмкими приложениями (графическими и видеоредакторами, инструментами 2D- и 3D-проектирования), использовать внешние и сетевые устройства, принимать участие в видеоконференциях. Вместе с ростом популярности VDI, растут и требования к продуктам, в том числе к качеству и скорости обмена данными между клиентом и сервером. Подключение сторонних протоколов создаёт ряд дополнительных сложностей при внедрении VDI-платформы: для использования проприетарных решений необходимо приобретать соответствующие лицензии, а протоколы с открытым исходным кодом требуют доработки под требования заказчика и сложны в поддержке. Наличие качественного собственного протокола, который является частью VDI-платформы и не требует дополнительного лицензирования, позволяет провести внедрение быстрее и с меньшим количеством сложностей. При разработке Basis Connect компания ориентируется на задачи, которые необходимо решать заказчикам, и требования, которые они предъявляют к присутствующим на рынке протоколам. В первой публичной версии Basis Connect будет реализована передача изображения, звука и содержимого буфера обмена (текст, файлы, папки, картинки), а также поддержка клавиатуры, мыши, принтеров, сканеров и других периферийных устройств, в том числе USB-токенов для использования сертификатов внутри виртуального рабочего места. В качестве серверной и клиентской ОС для работы с протоколом можно будет использовать популярные российские ОС: АLT Linux 10, Astra Linux 1.8, «РЕД ОС 8». По мере дальнейшего развития Basis Connect будут реализованы гибкие настройки самого протокола — например, в части разграничения прав пользователей — и ряд других возможностей. При этом «Базис» не будет отказываться от поддержки сторонних протоколов, поскольку это одно из преимуществ платформы Basis Workplace, востребованное у заказчиков. «Требования к отечественным VDI-решениям постоянно растут, и мы должны отвечать на вызовы рынка, быть гибкими и функциональными. Поэтому создание собственного протокола — важный шаг в развитии решения Basis Workplace. Мы даём заказчикам возможность использовать качественное совместимое решение без необходимости приобретать лицензии на проприетарные протоколы или дорабатывать протоколы с открытым исходным кодом. Создание Basis Connect потребовало значительных ресурсов, однако успешное решение этой задачи позволило не только улучшить наше продуктовое предложение, но и усилить компетенции команды», — отметил Дмитрий Сорокин, технический директор компании «Базис».

03.03.2026 [17:09], Владимир Мироненко

SAP выплатит почти полмиллиарда доларров за то, что «заманила» Teradata в невыгодное совместное предприятие почти 20 лет назадНемецкий разработчик ПО для управления бизнесом SAP урегулировал спор с американской компанией-разработчиком ПО Teradata всего за несколько недель до начала судебного разбирательства. Соглашение было достигнуто после того, как немецкий поставщик ERP-систем согласился выплатить Teradata $480 млн во внесудебном порядке, пишет ресурс The Register. Согласно заявлению Teradata, поданному в прошлом месяце в Комиссию по ценным бумагам и биржам США (SEC), обе стороны заключили мировое соглашение для «урегулирования всех прошлых и текущих судебных споров» между ними, включая обвинение компании SAP в нарушении антимонопольного законодательства. «В результате Teradata получит общую выплату в размере $480 млн… После получения Teradata подтверждения оплаты стороны обратятся в суд с просьбой отклонить все иски, возражения и встречные иски с лишением права на повторное обращение», — говорится в заявлении. Согласно подсчётам Teradata, после всех издержек она получит от $355 до $362 млн до уплаты налогов. Конфликт компаний берёт начало в 2018 году, когда Teradata подала в суд на SAP, утверждая, что в течение десяти лет она вела «кампанию по незаконному присвоению коммерческой тайны, нарушению авторских прав и антимонопольного законодательства». Teradata утверждала, что SAP воспользовалась свой сильной позицией на рынке ERP-решений, чтобы «заманить» её в совместное предприятие в 2008 году, а затем «быстро захватить долю рынка» в сфере хранилищ данных. В сентябре того же года SAP обратилась в суд с ходатайством об отклонении иска ввиду его необоснованности, которое калифорнийский суд отказался удовлетворить. Судебная тяжба сопровождалась взаимными обвинениями. Согласно документам, представленным Teradata в регулирующие органы, SAP подала встречные иски о нарушении патентов в июле 2019 года. В августе 2020 года Teradata подала второй иск против SAP, обвиняя компанию в нарушении четырёх своих патентов США. В феврале 2021 года SAP подала дополнительные встречные иски о нарушении патентов и инициировала судебный процесс в Германии по поводу нарушения одного немецкого патента. В ноябре 2021 года антимонопольные иски Teradata, утверждавшей, что немецкая компания якобы объединила продажу своего корпоративного ПО с программой анализа данных HANA, которая конкурирует с аналогичным продуктом от Teradata, а также большинство её обвинений в нарушении коммерческой тайны в первом иске были отклонены. Компания обжаловала это решение. В результате коллегия из трёх судей заслушала устные аргументы в феврале 2024 года, после чего Teradata и SAP заключили частичное соглашение. В декабре 2024 года суд отменил постановление о вынесении решения в порядке упрощённого производства против Teradata. В январе 2025 года SAP безуспешно пыталась добиться пересмотра дела, подав затем ходатайство в Верховный суд США, который отказался принять это дело к рассмотрению, фактически одобрив дальнейшее разбирательство в суде низшей инстанции. Начало судебного разбирательства с отбором присяжных было запланировано на конец марта 2026 года. Сообщается, что соглашение об урегулировании включает положения о будущем сотрудничестве между двумя фирмами. При этом SAP сохраняет свою позицию о независимой разработке HANA. Как утверждает ресурс Tech Edu Byte, урегулирование этого громкого дела позитивно отразится на рынке ПО и клиентах SAP, которые могут ожидать более предсказуемых обновлений и улучшений линейки её продуктов. Корпоративные клиенты SAP и Teradata теперь могут быть более уверены в своих технологических инвестициях, не опасаясь неопределённости, связанной с продолжающимися судебными разбирательствами, влияющими на планы развития продуктов и поддержку. Для Teradata, помимо денежной компенсации, позитив заключается в том, что соглашение признаёт ценность её портфеля интеллектуальной собственности.

02.03.2026 [09:56], Руслан Авдеев

И не звони мне больше: Microsoft представила по-настоящему автономное частное облако Azure Local

azure stack

microsoft

microsoft azure

software

евросоюз

информационная безопасность

конфиденциальность

облако

частное облако

Microsoft улучшила автономность решения Azure Local, позволяющего теперь создавать полностью «карманные» облака без подключения к интернету. На фоне политических трений между руководством США и Евросоюза всё больше европейских клиентов желают обеспечить себе цифровой суверенитет, сообщает The Register. Как и конкуренты из числа американских гиперскейлеров, Microsoft представила для Европы инициативы, призванные устранить сомнения местных заказчиков в безопасности их данных, включая возможность блокировки доступа к ним или получение доступа к информации американскими властями в рамках закона US CLOUD Act. В марте 2025 года Microsoft завершила формирование сервиса EU Data Boundary, а в ноябре добавила новые функции, призванные дополнительно укрепить уверенность европейских клиентов. Тем не менее всё больше организаций в Европе требуют полного контроля над своими данными, чего сервис обеспечить не может, поскольку Microsoft подчиняется американским законам. Компания даже пообещала судиться с правительством США, если то попытается лишить европейских клиентов её продуктов. Azure Local (Azure Stack HCI) — ответ Microsoft на опасения Европы. Azure Local и ранее позволял работать на собственных мощностях, но требовал подключение к «большому» облаку хотя бы раз в 30 дней для обновлений, мониторинга и проверки лицензий, в противном случае функциональность ограничивалась. Теперь же в Azure Local доступны полностью изолированные от публичных облаков операции. Другими словами, связь с «метрополией» больше не нужна. Кроме того, компания обеспечила локальный доступ к Microsoft 365 Local (в частности, Exchange Server, SharePoint Server и Skype for Business Server), а также анонсировала Foundry Local для «квалифицированных клиентов». Заверения Microsoft могут быть восприняты с недоверием — особенно с учётом того, что в 2025 году компания признала во Франции, что буквально не имеет возможности обеспечить данным полный суверенитет — если с требованием предоставить доступ к данным выступят американские власти. Возможность работать полностью независимо от Сети должна убедить клиентов в привлекательности работы с IT-гигантом, даже с учётом того, что ПО разрабатывается за океаном. По словам представителя ассоциации европейских облачных провайдеров CISPE, суверенитет всё более становится обязательным требованием, поэтому инструменты, позволяющие работать на локальных облачных платформах, приветствуются. Ассоциация намерена оценить новое предложения на предмет гарантий суверенитета и надёжности в рамках программы CISPE Sovereign Cloud Services Framework. CISPE и Microsoft достигли в 2024 году соглашения, в соответствии с которым IT-гигант обещал разработать версию Azure Local для европейских провайдеров и хорошо заплатить, а CISPE обязалась отказаться от обвинений компании в неконкурентных практиках. Правда, Microsoft уже пропустила оговоренные сроки. Microsft — не единственный техногигант, работающий над обеспечением суверенитета для своих клиентов. Amazon Web Services (AWS) предложила всеобщий доступ к своему суверенному облаку European Sovereign Cloud, а Google продаёт клиентам множество суверенных решений, включая Google Cloud Airgapped — сервис работает на серверах, полностью отключенных от интернета. Впрочем, Google в основном предпочитает совместные партнёрские решения с европейскими компаниями. Удовлетворит ли новое решение клиентов Microsoft, покажет практика его применения и то, каким будет определение «суверенитета». Возможность полного отключения от Сети удовлетворит некоторых клиентов, хотя некоторых по-прежнему может беспокоить то, что программное обеспечение может оставаться под контролем Microsoft. И даже если внутренние данные никуда не «утекут», всё равно остаётся вероятность того, что компания сможет тем или иным образом отключить сервисы Azure Local. Корпоративные клиенты уже ищут альтернативные предложения от локальных облачных провайдеров. В конце 2025 года немецкая SAP объявила, что инвестирует более €20 млрд ($23,3 млрд) в расширение суверенного облачного сервиса в Европе. Правда, глава SAP Кристиан Кляйн (Christian Klein) ранее заявлял, что не видит смысла в построении в Европе собственной облачной инфраструктуры в противовес уже созданной здесь американцами. Кроме того, у компании весьма тесные отношения с Azure. Доля же истинно европейских облаков годами остаётся низкой, поэтому отказаться от услуг заокеанских компаний практически невозможно, а open source в обозримом будущем вряд ли поможет.

26.02.2026 [23:11], Владимир Мироненко

AMD инвестирует в Nutanix $250 млн и создаст совместную платформу для агентного ИИAMD и Nutanix объявили о заключении соглашения о многолетнем стратегическом партнёрстве с целью разработки открытой инфраструктурной платформы для корпоративных приложений в области агентного ИИ, первая версия которой должна появиться к концу этого года. В рамках соглашения AMD инвестирует $150 млн в обыкновенные акции Nutanix по цене $36,26/шт. и предоставит до $100 млн дополнительного финансирования для совместных инженерных и маркетинговых инициатив, а также сотрудничества в области выхода на рынок с целью ускорения внедрения совместной платформы агентного ИИ. Ожидается, что сделка по инвестиции в акционерный капитал будет завершена во II квартале 2026 года после получения необходимых разрешений регулирующих органов. Совместно разработанная платформа агентного ИИ предназначена для обеспечения ускорения инференса на базе ускорителей Instinct и процессоров EPYC, HPC и оркестрации с использованием EPYC, а также унифицированного управления жизненным циклом с помощью Nutanix Enterprise AI, что позволит развёртывать открытые и коммерческие ИИ-модели без зависимости от вертикально интегрированных стеков ИИ. В рамках сделки Nutanix также интегрирует ПО AMD ROCm и Enterprise AI в свою облачную платформу Nutanix Cloud и платформу Nutanix Kubernetes, отметил ресурс SiliconANGLE. В настоящее время Nutanix поддерживает только ускорители NVIDIA. Благодаря этой сделке Nutanix будет поддерживать и ускорители AMD, что, как ожидается, позволит AMD расширить круг клиентов. «Наша цель — предоставить клиентам выбор, — заявил глава Nutanix Раджив Рамасвами (Rajiv Ramaswami) изданию The Register. — NVIDIA — лидер рынка, а AMD — ещё одна крупная компания, владеющая платформой». О сделке было объявлено после того, как Nutanix сообщила о финансовых результатах за II квартал 2026 финансового года. Выручка компании выросла год к году на 10 % до $723 млн. Скорректированная прибыль на акцию составила 56¢. Оба показателя превысили прогнозы аналитиков, ожидавших $710,35 млн выручки и 44¢ на акцию скорректированной прибыли. Высокие показатели были достигнуты благодаря росту клиентской базы: годовой доход от регулярных платежей по состоянию на конец января составил $2,36 млрд, что на 16 % больше, чем годом ранее. Рамасвами сообщил, что за прошедший квартал компания заключила 1000 новых контрактов с клиентами, и большинство из них намерены перейти с VMware на Nutanix. Вместе с тем дефицит в цепочках поставок процессоров и комплектующих, включая память и накопители, привёл к тому, что компания снизила свой прогноз на весь год с $2,82–$2,86 млрд до $2,80–$2,84 млрд. После объявления о сделке AMD и Nutanix акции Nutanix выросли в цене на 15 %.

26.02.2026 [17:31], Сергей Карасёв

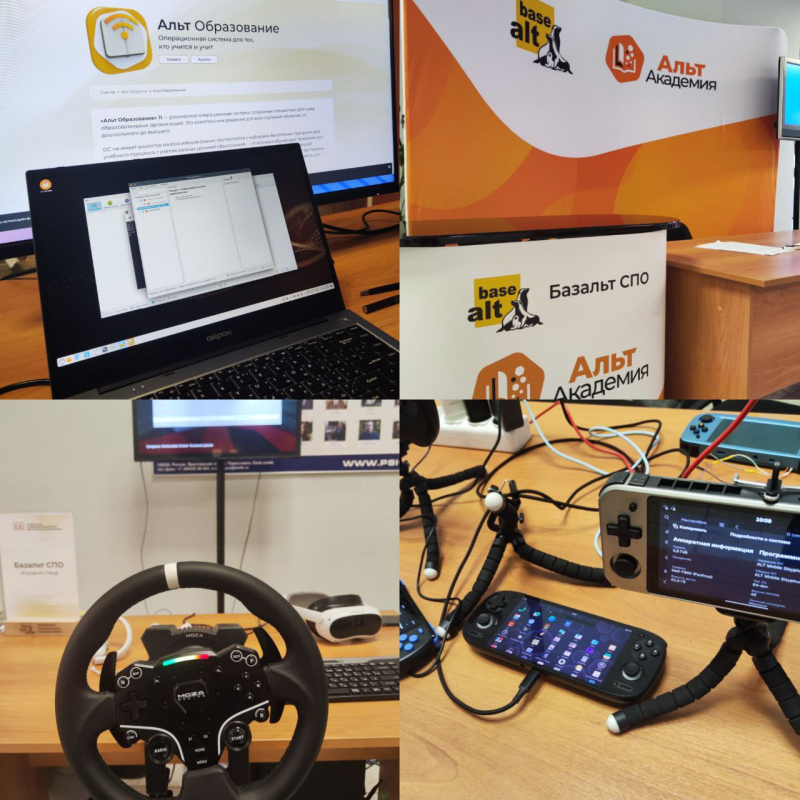

Искусственный интеллект в образовании, сетевая безопасность и открытые технологии: «Базальт СПО» провела XXI ежегодную конференцию «СПО в высшей школе»В Переславле-Залесском с 6 по 8 февраля 2026 года прошла ХXI конференция «Свободное программное обеспечение в высшей школе». Мероприятие объединило студентов, преподавателей и разработчиков из разных регионов России. Участники обсудили, как ИИ влияет на достоверную оценку знаний и какие решения позволят контролировать успеваемость учеников. Также на конференции представили новые форматы учебных материалов, продемонстрировали операционные системы для организации лабораторных работ и рассказали про комплексные решения, позволяющие незрячим специалистам осваивать ИТ-профессии. Организаторами мероприятия выступили «Базальт СПО» и Институт программных систем имени А.К. Айламазяна РАН (ИПС РАН). «За три дня с докладами выступили преподаватели и студенты почти 20 вузов. Кто-то уже успешно применяет свободные программы в образовательных целях, кто-то участвует в разработке, а кто-то приехал перенять опыт. Участники обсудили значение свободного ПО для повышения качества образования и для преодоления технологической зависимости», — отметил Алексей Смирнов, председатель совета директоров компании «Базальт СПО. Искусственный интеллект и образование — кто кого?Георгий Курячий, преподаватель МГУ им М. В. Ломоносова, проанализировал влияние нейросетей на современный учебный процесс. По словам эксперта, за последние несколько лет ИИ‑системы достигли уровня, позволяющего успешно выполнять типовые учебные задания по широкому кругу дисциплин. Из-за этого снижается достоверность оценки знаний, искажается система отбора студентов, утрачиваются практические навыки. Предлагаемые решения этих проблем неэффективны: они либо не достигают поставленных целей, либо требуют неоправданно много ресурсов. Часто предлагается признать пользу ИИ и разрешить студентам пользоваться этим инструментом. Но в этом случае они не обучаются базовым навыкам. По мнению эксперта, традиционные образовательные модели сталкиваются с системным кризисом и вопрос адаптации к новым реалиям остаётся открытым. Далее обсуждение использования ИИ в учебном процессе перешло в формат круглого стола. Старший преподаватель кафедры японской филологии ИСАА МГУ им М. В. Ломоносова Людмила Васильева рассказала, как студенты используют популярные онлайн-переводчики для выполнения заданий. Однако выдаваемый перевод содержит грамматические и стилистические ошибки, которые в дальнейшем ученики не редактируют. Для решения этой проблемы преподаватель задавала устные вопросы, чтобы удостовериться в переводческих навыках студентов. По её мнению, студенты обращаются к ИИ из‑за высокой учебной нагрузки и стремления всё успеть. В завершение своего выступления Людмила Васильева отметила, что нужно приспосабливаться к наличию ИИ и учиться им правильно пользоваться. Ряд участников обсуждения считают, что в сегодняшних условиях выявить реальные знания студентов могут устные экзамены и живое общение. Операционные системы для учёбы: атомарные, минимальные и переносныеВ рамках проекта ALT Atomic Семён Фомченков, разработчик «Базальт СПО» и активный участник сообщества ALT Gnome, продемонстрировал Atomic Package Manager. Это инструмент для управления состоянием системы через декларативное описание её состава. Можно создавать профили операционных систем для разных ролей, например, для рабочей станции или сервера. Для учебных целей удобно сформировать стандартизированные образы. В них студенты могут экспериментировать с ОС. При необходимости система быстро откатывается до начального состояния. Артём Осипчук, студент МГУ им. М.В. Ломоносова, поделился опытом использования специализированных образов операционной системы «Альт» для лабораторных работ по сетевым протоколам. При помощи инструмента mkimage-profiles на кафедре вычислительной математики и кибернетики были собраны минимальные образы (JeOS) с точно заданным набором пакетов, сервисов и настроек. Их используют, чтобы быстро разворачивать и клонировать виртуальные машины для моделирования сетевых топологий. Образы легко адаптируются и обновляются, что упрощает обучение студентов сетевым протоколам. В перспективе планируется создать сервис для автоматической настройки целых сетевых лабораторий на основе этих образов. Никита Шалаев, доцент СЗИУ РАНХиГС, рассказал про дистрибутив Linux — MiniOS. Он предназначен для быстрого развёртывания произвольного количества однотипных сред на рабочих местах, в учебных заведениях и на мероприятиях. MiniOS запускается с флешки по принципу LiveCD — «живой системы» и сохраняет изменения на загрузочном носителе. Презентации в браузере и «бесконечный свиток» — альтернативные формы учебных материаловВасилий Меленчук, старший преподаватель БрГТУ, представил набор инструментов для создания HTML‑презентаций. Для написания контента в формате AsciiDoc применяется фреймворк reveal.js для интерактивного отображения презентаций в браузере. Чтобы запустить локальный веб-сервер, конвертацию и экспорт HTML‑файлов, использовалось расширение для Visual Studio Code — AsciiDoc Presentations. Решение уже применяется для подготовки лекционных материалов по ИТ‑дисциплинам. Стас Фомин, преподаватель МФТИ, представил инструмент для создания инфографических конспектов — компактной и визуально насыщенной альтернативы статьям, книгам и презентациям. Проект содержит Markdown-редактор, расширения к code-server/code-oss/vscode и CSS-стили. Конспект преобразовывается в «майндмаппер на бесконечном свитке». Он вытягивается по вертикали для последовательного рассказа, а содержание темы уходит в горизонтальные ответвления. С помощью расширения «Freeze Markdown» можно преобразовать конспект в HTML-файл. Эксперт использовал решение для преподавания студентам, командной работы с IT-специалистами и подготовки докладов и видеороликов. Построение сетей и защита от киберугрозСтепан Мальчевский, студент МГУ им. М.В. Ломоносова, разработал серию лабораторных работ по изучению сетевых протоколов на базе виртуальных машин Linux в среде VirtualBox. При помощи инструмента mkimage-profiles был создан специализированный образ виртуальной машины без графической среды и с минимальным набором пакетов. На нём в среде VirtualBox реализованы лабораторные занятия по темам: VLAN, STP, статическая и динамическая маршрутизация (RIP, OSPF), фильтрация трафика, туннелирование и VPN. При этом студенты осваивают логику технологий, а не особенности конкретного ПО. Максим Зайка, студент Донецкого государственного университета, представил опыт использования эмулятора GNS3 для моделирования конфигурации сети и обучения основам сетевой безопасности. В рамках проекта была создана модель школьной локальной сети на маршрутизаторах Cisco. На этой модели можно изучать работу сетевых протоколов, тестировать варианты атак на сеть и отрабатывать методы защиты от киберугроз. Мобильные приложения для растениеводства и бизнесаДарья Морель, студент НИУ ВШЭ, представила мобильное приложение для удалённого управления системой гидропонного выращивания HotbedAgroControl. Пользователь может:

Планируется интегрировать в приложение искусственный интеллект, который будет давать рекомендации по выращиванию растений. Алиса Киселева, студентка НИУ МИЭТ, представила механизм настраиваемых уведомлений в мобильном приложении для управления бизнес-процессами RunaWFE. Также она рассказала про мобильный клиент RunaWFE Free для ОС ALT Mobile. Как пробудить интерес к разработке и экспериментамОбразовательный проект «Национальная киберфизическая платформа» направлен на обучение школьников программированию, электронике и созданию умных автономных устройств. О его работе рассказал президент Ассоциации участников технологических кружков Алексей Федосеев. Для обучения используется визуальный язык программирования (ПРИМС) который позволяет:

Такой метод обучения применяется в технологических кружках и на олимпиадах. Платформа Arduino помогает создать измерительные приборы для мониторинга окружающей среды. Александр Чернышов, доцент Мытищинского филиала МГТУ им. Н. Э. Баумана, рассказал про систему, которая используется на кафедре прикладной математики, информатики и вычислительной техники. В основе платформы лежит среда разработки микроконтроллеров Arduino IDE. С её помощью разработаны приборы, выполняющие измерения: атмосферного давления, влажности и температуры воздуха, уровня углекислого газа и т. д. Создан общедоступный сервер, где накапливается информация о проведённых измерениях и настройках приборов. Это позволило фиксировать результаты и передавать опыт следующим поколениям студентов. Александр Речицкий, преподаватель Computer Science, представил методику «Install Fest» для обучения основам системного тестирования с использованием ReactOS. Это свободная операционная система с открытым исходным кодом, архитектурно близкая к Windows. Студенты могут установить ОС на ПК через сетевую PXE‑загрузку с преподавательского сервера. В ходе «Install Fest» студенты фиксируют проблемы (отсутствие поддержки оборудования, ошибки драйверов, сбои), анализируют их причины, работают с документацией и ищут решения. Такая методика позволяет совместить теорию и практику и сформировать навыки работы с открытыми инженерными знаниями и сообществом Open Source. Комплексные решения для автоматизации, компьютерной графики и цифровой доступностиАлексей Драгунов, директор ГБУ ПО «Региональный центр информационных технологий», представил решение для автоматизации обмена данными между разрозненными информационными системами школ. Образовательным организациям необходимо одновременно работать с множеством веб-сервисов: госпаблики ВК, сайты, каналы в мессенджере MAX, электронные журналы. Ручная синхронизация данных между ними отнимает много времени и ресурсов. В качестве решения используются: инструмент для автоматизации действий в веб‑браузерах Selenium, библиотека для управления браузером WebDriver и Python‑скрипт. Эта технология позволяет:

Павел Жданович, доцент Волгоградского государственного социально-педагогического университета, поделился опытом внедрения языка программирования Asymptote в образовательный процесс вуза. Решение позволяет генерировать векторные изображения (в том числе 3D и анимации) через код. Особенности Asymptote:

Проект используется для построения чертежей и визуализации задач, освоения генерации кода и компьютерной графики. Программист Алексей Фитисов представил комплекс отечественных цифровых решений, которые позволяют незрячим пользователям полноценно обучаться и работать в ИТ-сфере. В него входят:

Представленный комплекс отечественных технологий формирует практическую основу для IT-образования и трудоустройства незрячих специалистов в России. Докладчик сам является незрячим и работает разработчиком в «Базальт СПО». Павел Митрофанов, студент МИФИ, рассказал про применение нейросетей для обработки аудио в реальном времени. Он разработал StudioFx — прототип системы, которая в реальном времени подавляет шумы, распознаёт речь и классифицирует звуковые команды. Проект содержит:

PipeWire захватывает звук с микрофона и передает данные в Gstreamer. Далее аудиопоток передается в RNNoise для обработки данных в реальном времени. Чтобы избежать задержек и сбоев, использовались кольцевые буферы для захвата звука, очереди без блокировок и группировка кадров. Проект ещё в разработке, но в планах сделать StudioFx доступным на всех платформах. На стендах показали VR-игры на Linux и решения для образованияВ перерывах между докладами участники могли поиграть в VR-игры через PortProton, увидеть ALT Mobile на нескольких портативных устройствах и телефонах, ознакомиться с решением ALT Atomic и с обновлённой версией ОС «Альт Рабочая станция» с графической оболочкой GNOME. Были представлены стенды с операционной системой для образовательных организаций ОС «Альт Образование». На стенде «Альт Академии» участникам рассказали о курсах и сертификации специалистов в области сетевого и системного администрирования. «Р7-Офис» продемонстрировали функции офисных пакетов, а на стенде RunaWFE можно было подробнее ознакомиться с мобильной версией приложения для управления бизнес-процессами. Запись трансляции конференции доступна на канале «Базальт СПО». |

|