Материалы по тегу: software

|

31.01.2026 [13:19], Андрей Крупин

ФСТЭК России опубликовала рекомендации по безопасной настройке Samba

active directory

software

администрирование

защита предприятия

информационная безопасность

кии

фстэк россии

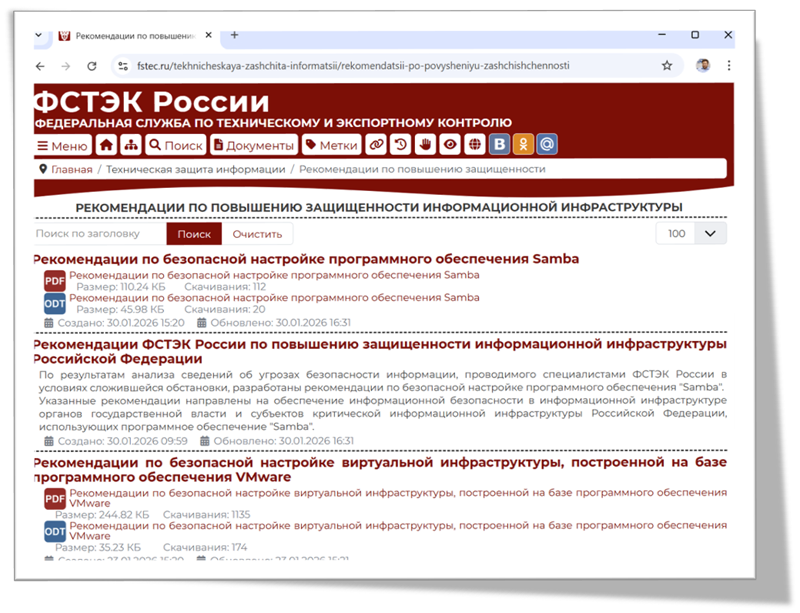

Федеральная служба по техническому и экспортному контролю выпустила рекомендации по безопасной настройке программного обеспечения Samba в IT-инфраструктуре органов государственной власти и субъектов критической информационной инфраструктуры РФ. Документ подготовлен по результатам анализа сведений о киберугрозах, проводимого специалистами ведомства. Samba представляет собой свободно распространяемый многофункциональный серверный продукт, который используется в качестве моста между операционными системами Windows и Unix-подобными системами (Linux, macOS, BSD и др.) для совместного использования файлов и принтеров. Решение поддерживает протоколы SMB/CIFS (Server Message Block / Common Internet File System), может выступать в роли контроллера домена Active Directory, совместимого с реализацией Windows Server 2008 и способного обслуживать все поддерживаемые Microsoft версии Windows-клиентов, в том числе Windows 11. Также Samba может использоваться в качестве файлового сервера, сервиса печати и сервера идентификации.  В опубликованных ФСТЭК России рекомендациях перечислены различные аспекты и нюансы конфигурирования ПО Samba. В частности, затронуты вопросы парольной политики, разграничения прав доступа к файлам, отключения устаревшего протокола SMBv1, настройки аудита и журналирования событий, средств шифрования и резервного копирования данных. Отдельное внимание уделено конфигурированию ключевых подсистем и групповых политик. Документ размещён на информационном портале Федеральной службы по техническому и экспортному контролю fstec.ru в разделе «Техническая защита информации → Рекомендации по повышению защищённости информационной инфраструктуры». Напомним, что ФСТЭК России ведёт централизованный учёт информационных систем и иных объектов КИИ по отраслям экономики, а также мониторинг и оценку текущего состояния технической защиты информации и обеспечения безопасности значимых объектов критической информационной инфраструктуры. Также в числе обязанностей ведомства значится оперативное информирование органов власти, местного самоуправления и организаций об угрозах безопасности информации и уязвимостях информационных систем и иных объектов КИИ, а также о мерах по технической защите от этих угроз и уязвимостей.

29.01.2026 [16:38], Владимир Мироненко

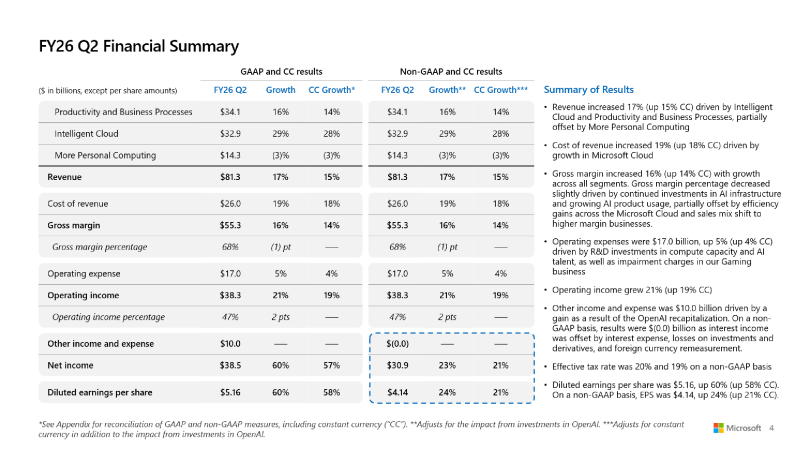

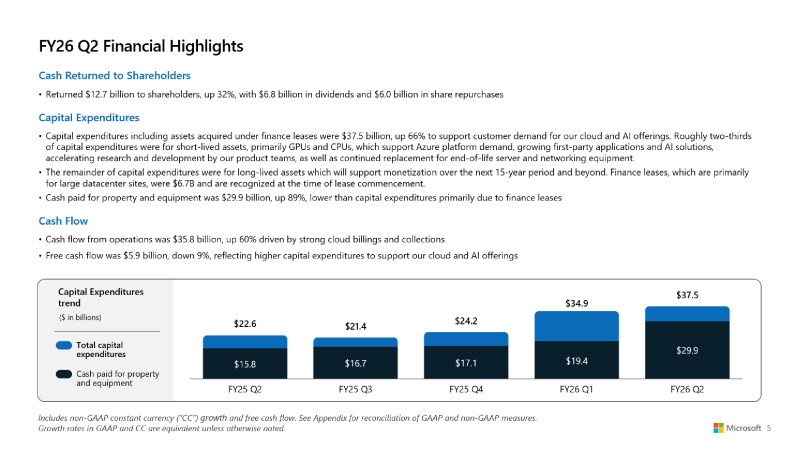

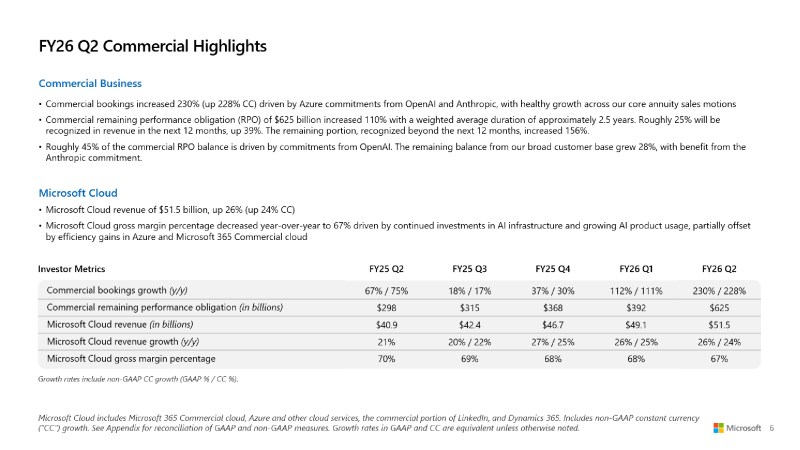

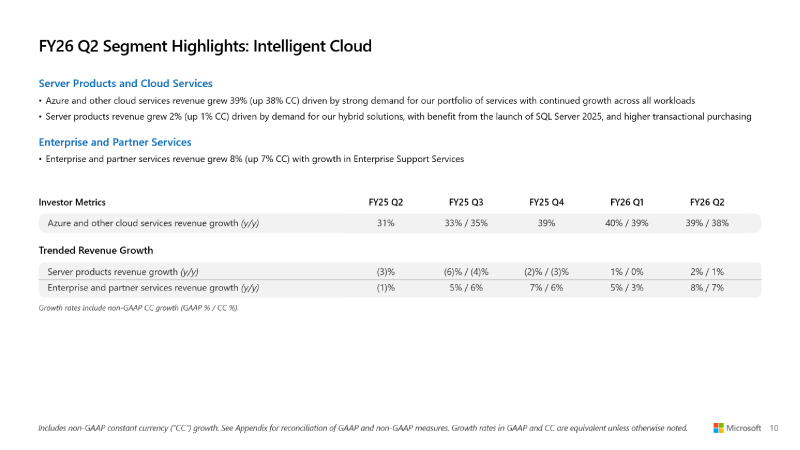

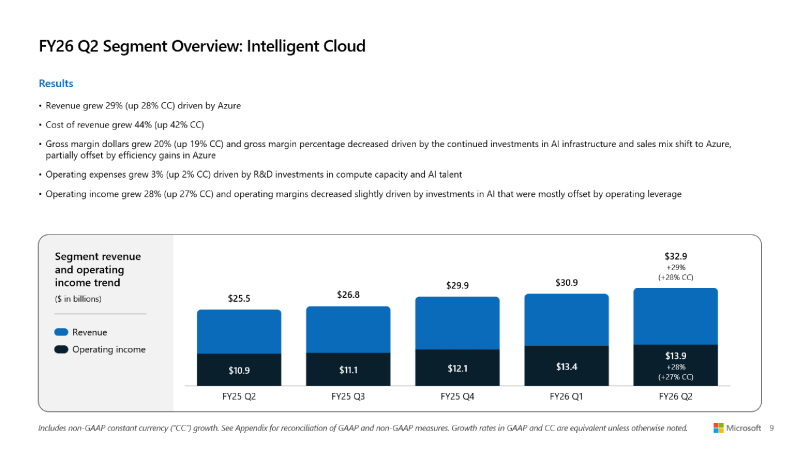

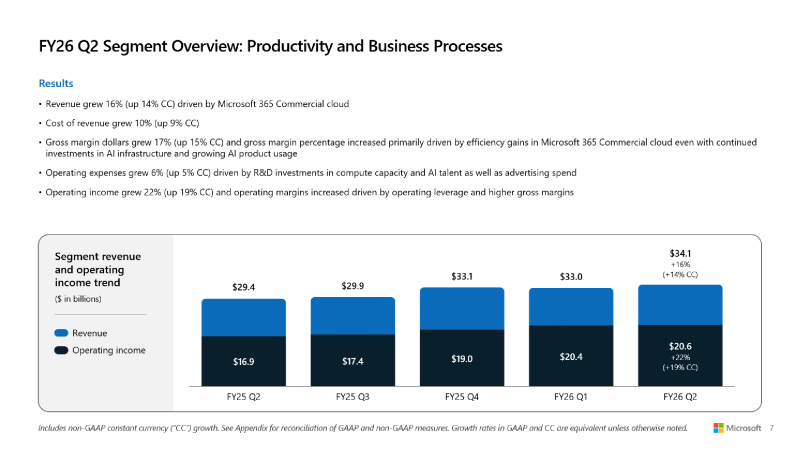

Microsoft превысила прогнозы Уолл-стрит, но её акции упали из-за замедления роста облачных сервисовMicrosoft объявила результаты за II квартал 2026 финансового года, закончившийся 31 декабря 2025 года. Несмотря на то, что результаты компании превысили прогнозы Уолл-стрит, её акции упали на 7 % на внебиржевых торгах в среду после сообщения о замедлении роста облачных сервисов, пишет ресурс CNBC. Скорректированная прибыль (Non-GAAP) Microsoft на разводнённую акцию составила $4,14 при объёме продаж в $81,27 млрд, в то время как аналитики, опрошенные LSEG, ожидали $3,97 скорректированной прибыли при выручке в размере $80,27 млрд. Microsoft уточнила, что скорректированная прибыль не включает влияние инвестиций компании в OpenAI. Согласно отчёту Microsoft, её выручка за второй финансовый квартал выросла на 16,7 % по сравнению с аналогичным периодом предыдущего финансового года. Чистая прибыль (GAAP) составила $38,46 млрд или $5,16 на акцию, что на 60 % выше показателя годом ранее в $24,11 млрд или $3,23 на акцию. Валовая маржа компании была самой низкой за три года, составив чуть более 68 %. «Выручка Microsoft Cloud в этом квартале превысила $50 млрд, что отражает высокий спрос на наш портфель услуг», — сообщила Эми Худ (Amy Hood), исполнительный вице-президент и главный финансовый директор Microsoft, добавив, что компания превзошла ожидания по выручке, операционной прибыли и прибыли на акцию. Выручка Microsoft Cloud выросла на 26 % до $51,5 млрд, а оставшиеся коммерческие обязательства компании по исполнению контрактов, представляющие собой незаработанную выручку и суммы, которые будут признаны в качестве выручки позже, выросли на 110 % до $625 млрд. Это стало возможным благодаря оставшимся коммерческим обязательствам OpenAI перед Microsoft в области облачных сервисов на сумму $250 млрд в течение квартала. Microsoft заявила, что 45 % оставшихся коммерческих обязательств связаны с OpenAI, а оставшаяся часть суммы выросла на 28 %. «Портфель заказов действительно хорош, но информация о том, что OpenAI составляет 45 % от их портфеля, возвращает нас к вопросу: сможет ли OpenAI достичь этих финансовых целей, чтобы расплатиться с Oracle, Microsoft и многими другими поставщиками?» — задался вопросом аналитик Jefferies Брент Тилл (Brent Thill) в программе Closing Bell Overtime на CNBC. Остальная часть оставшихся обязательств по коммерческому выполнению контрактов «больше, чем у большинства конкурентов, более диверсифицирована, чем у большинства конкурентов, и, честно говоря, я думаю, что мы очень уверены в этом», — сказала Эми Худ. Она отметила, что Microsoft остаётся «мастштабным поставщиком» для OpenAI. Microsoft сообщила, что чистые убытки от инвестиций в OpenAI составила $7,58 млрд, или $1,02 на акцию. Компания также отметила, что её прочие доходы во II финансовом квартале составили $9,97 млрд, что обусловлено рекапитализацией OpenAI, пишет ресурс Constellationr. Сегмент Microsoft Intelligent Cloud, включающий облачную инфраструктуру Azure, принес $32,91 млрд выручки (рост 29 %), что больше консенсус-прогноза StreetAccount в размере $32,40 млрд. Рост Azure и других облачных сервисов составил 39 % по сравнению с 40-% ростом в I финансовом квартале. Аналитики, опрошенные StreetAccount и CNBC, ожидали рост на 39,4 и 38,9 % соответственно. Выручка в сегменте «Производительность и бизнес-процессы» (Microsoft Productivity and Business Processes) выросла на 16 % до $34,12 млрд, что выше консенсус-прогноза в $33,48 млрд аналитиков, опрошенных StreetAccount. Доход от облачного сервиса Microsoft 365 увеличился на 17 %, от потребительского облачного сервиса Microsoft 365 — на 29 %, от LinkedIn — на 11 %, от Dynamics 365 — на 19 %. В настоящее время у компании 15 млн коммерческих подписчиков Microsoft 365 Copilot. До этого момента Microsoft не сообщала о количестве пользователей, имеющих доступ к Copilot. У Copilot есть потенциал роста. В настоящее время Microsoft располагает более чем 450 млн платных коммерческих пользователей Microsoft 365. Сегмент More Personal Computing, включающий Windows, Xbox, Surface и Bing, принес $14,25 млрд выручки (падение год к году на 3 %), что ниже консенсус-прогноза аналитиков StreetAccount в $14,38 млрд. В отчётном квартале капитальные затраты и финансовая аренда Microsoft составили $37,5 млрд, что на 66 % больше в годичном исчислении и выше прогноза аналитиков, опрошенных Visible Alpha, в $34,31 млрд. Худ сообщила, что примерно две трети из них приходится на краткосрочные активы, такие как GPU и CPU (согласно MarketBeat). Microsoft активно инвестирует в ЦОД для удовлетворения спроса на ИИ и другие облачные вычислительные услуги. Однако компания ожидает снижения капитальных затрат в третьем финансовом квартале, подчеркнул ресурс Investors. «Мы находимся только на начальных этапах распространения ИИ, и Microsoft уже построила бизнес в сфере ИИ», — заявил генеральный директор Microsoft Сатья Надела (Satya Nadella). «В общей сложности за этот квартал мы добавили почти один гигаватт вычислительных мощностей», — сообщил он во время телефонной конференции. Наделла подчеркнул необходимость создания решений для «гетерогенных и распределённых» рабочих нагрузок ИИ и заявил, что Microsoft оптимизирует свои решения, ориентируясь на «токены на ватт на доллар», что, по его словам, способствует повышению эффективности использования и снижению общей стоимости владения за счет полупроводниковых компонентов, систем и ПО. Он отметил «50-% увеличение пропускной способности» для рабочих нагрузок инференса OpenAI, обеспечивающих работу Copilot, и сказал, что Microsoft соединила площадки ЦОД через AI WAN, создав, по его словам, «первую в своем роде суперфабрику ИИ» для ЦОД Fairwater. В III финансовом квартале Microsoft прогнозирует выручку в размере от $80,65 до $81,75 млрд. Средний показатель составил $81,2 млрд, что соответствует консенсус-прогнозу LSEG в $81,19 млрд. Прогноз компании по квартальному росту облачных сервисов Azure составил от 37 до 38 % при консенсус-прогнозе StreetAccount в размере 37,1 %. Ожидаемая операционная маржа компании в III квартале 2026 финансового года равна 45,1 %, что ниже консенсус-прогноза StreetAccount в 45,5 %. Операционные расходы будут включать инвестиции в вычислительные мощности и персонал для ИИ.

28.01.2026 [14:00], Руслан Авдеев

Франция пересадит госслужащих с Zoom и Teams на суверенный видеочат Visio

software

видеоконференцсвязь

импортозамещение

информационная безопасность

конфиденциальность

сша

франция

Франция объявила, что американские приложения для видеоконференций должны уйти, уступив место местному продукту — пока для государственных служащих. Новый план предполагает полное замещение соответствующих приложений из США — Zoom, Teams, Webex и Google Meet уступят место разработанной на государственном уровне французской альтернативе, сообщает The Register. Париж заявляет, что данные и инфраструктура будут находиться «дома», под французской юрисдикцией. Платформа Visio разрабатывается местным Межведомственным цифровым управлением (DINUM). Она должна стать «приложением по умолчанием», а позже и единственным приложением для видеосвязи для французских государственных служащих. Объявление сделано Министерством экономики и финансов Франции в рамках более широкого плана страны по обретению цифрового суверенитета. Правительство утверждает, что использование иностранных ВКС-платформ для официальных переговоров заставляет полагаться на зарубежную инфраструктуру. Кроме того, распоряжение информацией будет зависеть от иностранных законов и возможного политического давления. В правительстве Франции утверждают, что нельзя рисковать материалами научных исследований, конфиденциальными данными, стратегическими инновациями и размещать их на площадках «неевропейских» игроков. Цифровой суверенитет обязателен для государственных служб — это и возможности для французского бизнеса, и страховка от возможных будущих угроз. По имеющимся данным, сервис Visio уже тестировался десятками тысяч чиновников и теперь использование продукта масштабируется в министерствах, агентствах и прочих госструктурах. К 2027 году использование Visio должно стать рутинной процедурой, после чего лицензии на прочие приложения для видеоконференций больше не будут обновляться. Переход уже начали значительные части госсектора, от налоговых ведомств до социальных служб. Основной акцент делается на обеспечение безопасности переговоров. Париж подчёркивает, что Visio работает на подконтрольной Франции инфраструктуре в соответствии с законами Франции и Евросоюза о защите данных и конфиденциальности. Конечно, не последнюю роль играют и деньги. По оценкам властей, переход даже 100 тыс. пользователей с коммерческих платформ позволяет экономить €1 млн в год на лицензиях. Французские чиновники также подчёркивают, что Visio будет довольно современным продуктом с транскрипцией диалогов, «живыми» субтитрами — но без пересылки аудиоматериалов в чужие облака, например, подчиняющиеся законам США. Не так давно Microsoft признала, что не сможет обеспечить полную конфиденциальность данных в европейских облаках и вынуждена будет поделиться ими, если того потребуют американские законы. Пока трудно сказать, преуспеет ли Visio или пополнит длинный список IT-проектов, так и не сумевших заменить полюбившиеся людям инструменты. Так или иначе, пока Франция дала понять, что «поучаствовать» в официальных переговорах США больше не приглашают.

26.01.2026 [11:37], Руслан Авдеев

Просчитались: Broadcom продаст госслужбам США ПО VMware со скидкой до 64 %, но vSphere это не касаетсяУправление общих служб США (GSA) о закупке в рамках соглашения OneGov Agreement продуктов VMware (Broadcom) со скидкой до 64 %. Нюанс в том, что собственно гипервизор vSphere в соглашение не включили, сообщает The Register. Скидка распространяется на VMware Tanzu Platform, Tanzu Data Intelligence, Avi Load Balancer, vDefend и Tanzu AI Starter Kit, тогда как ключевая платформа виртуализации vSphere Foundation, используемая большинством государственных ведомств США, в списке отсутствует. При этом в администрации президента США подчеркнули, что новый договор — важная веха в рамках инициативы OneGov, координирующей спрос государственных ведомств на ПО и услуги, а само соглашение «со скидкой» способствует внедрению ИИ в госструктурах. Скидки для GSA будут действовать до мая 2027 года, поэтому у IT-команд государственных ведомств осталось не очень много времени на принятие решений о закупке или отказе от решений Broadcom в базовой инфраструктуре. Broadcom позиционирует сделку как возможность помочь государственным ведомствам получить больше результатов от инвестиций в её платформу частного облака и достичь модели «нулевого доверия» с использованием многоуровневой защиты. Защищать действительно есть что. Так, ещё в 2024 году американские военные и другие государственные ведомства подписали соглашения о получении лицензий VMware на $477 млн. Отдельный контракт на $173 млн подписан ВМС США. В 2025 году агентство DISA (Агентство информационных систем) в составе Пентагона подписало контракт почти на $1 млрд через посредника Carahsoft.

Источник изображения: Icons8 Team/unsplash.com Стоит отметить, что поглощение VMware компанией Broadcom до сих пор вызывает недовольство многих клиентов. Дело в изменении условий лицензирования и самой продуктовой линейки, из-за которой многие организации вовсе отказываются от взаимодействия с VMware вовсе. Так, британский ретейлер Tesco подал на Broadcom её реселлера Computacenter в суд, обвинив их в нарушении условий контракта, а Computacenter сама выступила с иском к Broadcom и Dell. Недовольны изменениями и гиганты уровня Samsung, Siemens, Telefónica и др. Впрочем, Broadcom не собирается отступать от действующей стратегии, рассчитанной на крупных клиентов и радикальное изменение бизнес-моделей. Не так давно компания просто изъяла пакет VMware vSphere Foundation с некоторых рынков региона EMEA. Эксперты полагают, что это может нанести значимый ущерб многим небольшим клиентам. С прошлой осени приобретение лицензий VMware осуществляется напрямую у Broadcom, купившую VMware почти за $70 млрд. В России VMware больше не работает, но её продукты всё ещё популярны.

23.01.2026 [22:51], Руслан Авдеев

Продано: Oracle и Майкл Делл стали инвесторами американского предприятия TikTok USDS

bytedance

dell

g42

oracle

oracle cloud infrastructure

silver lake

software

tiktok

инвестиции

китай

реструктуризация

сделка

сша

Социальная сеть TikTok китайского происхождения объявила о создании совместного предприятия, которое станет управлять её деятельностью в США. Только на этих условиях компания сохранит возможность работы в Америке. Новая компания TikTok USDS Joint Venture LLC объявила о трёх управляющих инвесторах: Oracle, частной инвестиционной компании Silver Lake и инвесторе MGX из ОАЭ, каждый из них получит по 15 % в совместном предприятии. ByteDance, управляющей TikTok в других странах, принадлежит доля в 19,9 %. Инвестором выступает и компания Майкла Делла (Michael Dell) — Dell Family Office. Об участии Делла в сделке сообщалось ещё в сентябре 2025 года. Oracle будет играть ключевую роль в работе TikTok в США — данные американских пользователей будут размещаться в её облаке, также она выступит «доверенным партнёром» нового консорциума в сфере обеспечения безопасности. В частности, её эксперты займутся проверкой исходного кода. Также планируется переобучить и обновить рекомендательные алгоритмы на основе данных американских пользователей. Технически данные американских пользователей в рамках Project Texas уже перенесли в облако Oracle в 2022 году. В рамках аналогичного Project Clover данные пользователей из Европы переехали в ЦОД в Ирландии и Норвегии. Пока неизвестно, сколько было заплачено ByteDance за новый формат партнёрства, но есть данные, что ByteDance будет по-прежнему управлять электронной коммерцией, рекламой и маркетингом американской платформы, а также глобальной совместимостью продуктов. Последнее важно, поскольку планируется обеспечить «заметность» американских создателей контента и работу американских бизнесов в мировом масштабе.

Источник изображения: SEO Galaxy/unsplash.com Одним из руководителей совместного предприятия назван гражданин Сингапура, генеральный директор TikTok Шоу Чу (Shou Chew). При этом совет директоров состоит «в основном из американцев». В частности, генеральным директором назначен Адам Прессер (Adam Presser), а директором по безопасности — Уилл Фаррелл (Will Farrell). Сделка готовилась очень долго. В своё время Конгресс США принял закон, обязывающий ByteDance найти покупателя американского сегмента компании, иначе социальной сети пришлось бы прекратить деятельность в Соединённых Штатах — предлогом выступила угроза национальной безопасности США от приложений иностранных противников. По имеющимся данным, новое совместное предприятие будет заниматься и делами прочих приложений ByteDance, включая CapCut и Lemon8.

23.01.2026 [21:58], Андрей Крупин

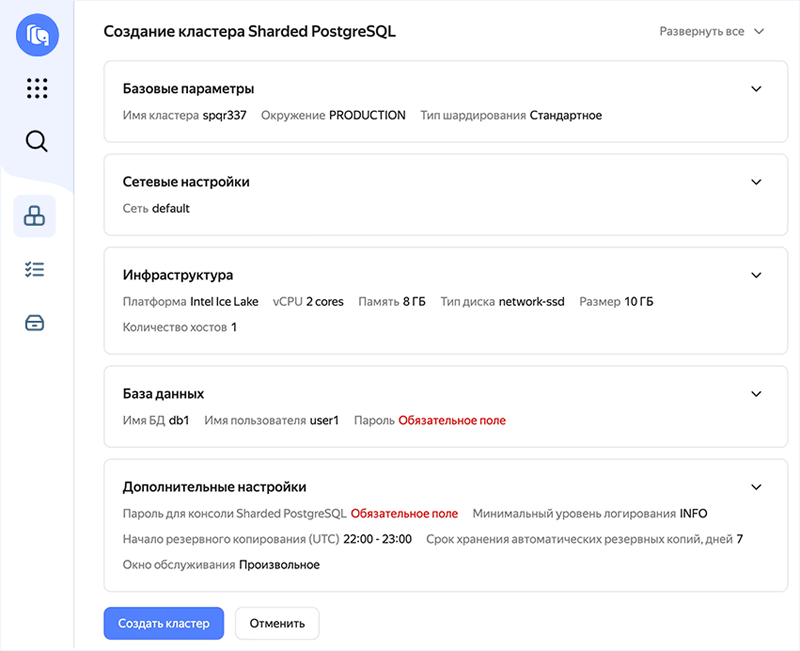

Yandex B2B Tech запустила сервис горизонтального масштабирования PostgreSQLYandex B2B Tech (бизнес-группа «Яндекса», объединяющая технологии и инструменты компании для корпоративных пользователей, включая продукты Yandex Cloud и «Яндекс 360») сообщила о запуске сервиса горизонтального масштабирования СУБД PostgreSQL в облачной инфраструктуре Yandex Cloud. Новый инструмент получил название Yandex Managed Service for Sharded PostgreSQL и построен на базе SPQR (Stateless Postgres Query Router) — системы горизонтального масштабирования PostgreSQL через шардирование, основанной на технологиях Yandex Open Source. Решение позволяет увеличивать производительность баз данных без смены СУБД, распределять нагрузку по шардам и сохранять работу бизнес-приложений без изменений кода благодаря единому PostgreSQL‑совместимому эндпоинту.

Пользовательский интерфейс Yandex Managed Service for Sharded PostgreSQL (источник изображения: yandex.cloud) По умолчанию в PostgreSQL функций горизонтального масштабирования (добавление новых серверов в систему и распределение нагрузки между ними) нет. При этом именно оно позволяет справиться с огромными объемами данных, когда вертикальное масштабирование (увеличение мощности одного сервера) не работает. Yandex Managed Service for Sharded PostgreSQL работает на уровне протокола PostgreSQL. Это предполагает полную совместимость с разными редакциями СУБД. На начало 2026 года это версии 14, 15, 16, 17 и 18. Сервис полностью совместим со стандартными типами данных PostgreSQL, включая JSONB. Платформа Yandex Cloud объединяет 18 сервисов для работы с OLTP- и OLAP-нагрузками. Недавно компания также запустила управляемые сервисы на базе решений с открытым исходным кодом — Yandex Managed Service for Spark и сервис управления распределённым аналитическим массивно‑параллельным движком обработки больших данных Trino.

21.01.2026 [15:28], Руслан Авдеев

ByteDance стремительно завоёвывает рынок облачных ИИ-сервисов КитаяКомпания ByteDance агрессивно осваивает китайский облачный рынок. Владелец популярной социальной сети TikTok пытается использовать свои достижения в сфере ИИ для выхода за пределы рынка пользовательских приложений, обеспечивших в своё время успех компании, сообщает The Financial Times. Компания продвигает облачные решения Volcano Engine для корпоративных клиентов, увеличивая команду продаж и устраивая ценовые войны с конкурентами. Источники сообщают, что ByteDance предлагает корпоративным клиентам собственные обширные данные и вычислительные ресурсы, например, для создания ИИ-агентов с использованием собственных моделей ByteDance. Тем самым она теснит Alibaba, Tencent и Huawei, которые долго доминировали на этом рынке. По данным IDC, Volcano Engine является в Китае вторым по величине провайдером ИИ-инфраструктуры и ПО после Alibaba. На долю ByteDance в I половине 2025 года приходилось около 13 % выручки от китайских облачных ИИ-сервисов ($390 млн), на долю Alibaba — 23 %. При этом на китайском облачном рынке в целом ByteDance имеет долю лишь 3 %. Иными словами, ByteDance стала лидером в сфере ИИ-сервисов, самом быстрорастущем сегменте рынка. По мнению некоторых аналитиков, компания может стать одним из ключевых игроков в Китае в сегменте кастомных ИИ-инструментов благодаря крупным собранным датасетам и развитой аппаратной инфраструктуре, добавив для достижения успеха агрессивное ценообразование и глубокую интеграцию со своей экосистемой пользователей.

Источник изображения: Liren/unsplash.com ByteDance хорошо разбирается в пользовательских технологиях, имея в портфолио социальную сеть TikTok и её китайский вариант Douyin, а также видеоредактор CapCut и новостной агрегатор Toutiao. Именно эти площадки обеспечивают большую часть выручки компании благодаря рекламе, продажам и подпискам. Согласно данным, предоставленным инвесторам, в III квартале выручка составила $50 млрд. Последние попытки выйти на рынок корпоративного ПО, включая премьеру похожего на Slack продукта Lark, не увенчались особенным успехом. Стратегия роста, ориентированная на ИИ, могла бы придать импульс для будущего выхода на IPO, которого инвесторы ожидают годами. ByteDance агрессивно выводит в коммерческую плоскость свои ИИ-возможности благодаря Volcano Engine. Компания акцентирует внимание на продажах флагманского сервиса HiAgent, посредством которого создаются кастомные ИИ-агенты для корпоративных клиентов. Стратегия опирается на массивные инвестиции в вычислительные мощности. ByteDance сегодня — в числе крупнейших покупателей ИИ-оборудования, она же была крупнейшим клиентом NVIDIA в 2024 году. По данным The Financial Times, в этом году значительная часть из ¥85 млрд, выделенных на ИИ-ускорители, будет потрачена на покупку NVIDIA H200, с некоторых пор разрешённых для поставок в КНР — если это одобрят китайские власти. При этом некоторые эксперты отмечают, что ByteDance имеет сильные позиции в разработке ПО и достаточные аппаратные ресурсы для получения значимой доли облачного рынка, но ей не хватает опыта в обслуживании корпоративных клиентов в сравнении с Tencent и Huawei, поэтому приходится навёрстывать упущенное.

Источник изображения: Claudio Schwarz/unsplash.com Крупные китайские игроки сами дают ByteDance такую возможность. Например, Tencent заявляла, что будет тратить ресурсы ИИ-ускорителей для внутренних нужд, не планируя масштабного расширения облачных сервисов для клиентов. Huawei, тем временем, сократила свои облачные ИИ-амбиции за последний год, сфокусировавшись на продаже чипов Ascend напрямую клиентам. По данным IDC, доля обеих компаний на облачном ИИ-рынке КНР слегка уменьшилась в I половине 2025 года. Становление ByteDance в качестве одного из китайских ИИ-гигантов привлекло меньше внимания, чем успехи DeepSeek и Alibaba, которые развивают успешные открытые ИИ-модели и одновременно публикуют исследования о своих методиках обучения ИИ. Напротив, ByteDance сохранила полный контроль над своими самыми передовыми моделями и компании-клиенты имеют к ним доступ только по подписке. К слову, Alibaba, яро выступавшая за open source подход к распространению моделей, в последние месяцы оставила некоторые из передовых вариантов «закрытыми». Другими словами, успехи ByteDance в сфере ИИ-моделей не освещаются слишком широко, поскольку отдача open source продуктов вызывает некоторые сомнения у многих разработчиков. Один из представителей команды ByteDance подчеркнул, что компания концентрирует усилия на создании лучших ИИ-моделей для клиентов, а не на гонке в сегменте open source.

20.01.2026 [17:15], Сергей Карасёв

«Базальт СПО» приглашает на XXI ежегодную конференцию «Свободное программное обеспечение в высшей школе»«Базальт СПО» совместно с Институтом программных систем им. А.К. Айламазяна РАН проводит XXI Ежегодную конференцию «Свободное программное обеспечение в высшей школе» (OSEDUCONF). Мероприятие пройдёт 6–8 февраля 2026 года в г. Переславле-Залесском на базе ИПС РАН. Ведущие учёные, педагоги, разработчики и администраторы расскажут об опыте внедрения СПО и организации образовательного процесса, создания благоприятных условий для вовлечения студентов в реальные проекты разработки свободных программных продуктов. Оргкомитет принимает заявки на доклады по следующим темам:

Сроки подачи заявок Для слушателей:

Участие бесплатное. Онлайн-трансляция конференции будет доступна на VK Видео и странице конференции. Зарегистрироваться на конференцию и ознакомиться с информацией о форматах и шаблонах тезисов можно на сайте. По вопросам, связанным с докладами, тезисами, программой конференции, регистрацией, размещением, трансфером можно обратиться к организаторам по электронной почте conference@lists.altlinux.org.

17.01.2026 [23:37], Владимир Мироненко

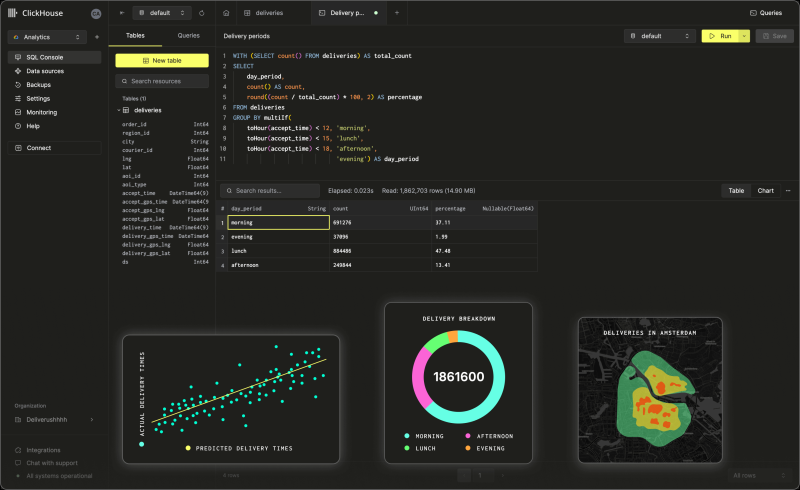

Капитализация ClickHouse после очередного раунда финансирования достигла $15 млрдClickHouse, разработчик колоночной СУБД с открытым исходным кодом, отделившийся более четырёх лет назад от Yandex NV, сообщил об успешном завершении раунда финансирования серии D, в ходе которого он привлёк $400 млн при оценке рыночной стоимости в $15 млрд. В предыдущем раунде, прошедшем в мае, оценка рыночной стоимости компании составила $6,35 млрд. Раунд возглавила инвестиционная группа Dragoneer Investment Group при участии Bessemer Venture Partners, GIC, Index Ventures, Khosla Ventures, Lightspeed Venture Partners, консультантов T. Rowe Price Associates и WCM Investment Management. Соучредитель и генеральный директор ClickHouse Аарон Кац (Aaron Katz) сообщил агентству Bloomberg, что компания планирует использовать полученные средства для ускорения разработки продукта, а также для увеличения продаж и маркетинга. ClickHouse отметила, что финансирование было получено на фоне продолжительного периода устойчивого роста компании. Её годовой регулярный доход (ARR) вырос более чем на 250 % в годовом исчислении. В настоящее время у её полностью управляемого сервиса ClickHouse Cloud насчитывается более 3 тыс. клиентов, включая Meta✴, Cursor, Sony и Tesla. Кац заявил, что ClickHouse была создана для обеспечения исключительной производительности и экономичности при работе с самыми требовательными рабочими нагрузками по обработке данных. Сейчас компания занимается внедрением унифицированной поддержой транзакционных и аналитических рабочих нагрузок, чего давно не хватало, а также наблюдаемостью (observability) LLM, чтобы разработчики ИИ-приложений могли оценивать качество результатов и поведение ИИ-моделей по мере их развёртывания. «Дополнительное финансирование в сочетании с продолжающимся развитием продукта позволяет нам предоставлять лидирующую платформу для сбора данных и мониторинга LLM в эпоху ИИ», — подчеркнул гендиректор ClickHouse. Инвестиционная компания Dragoneer отметила, что по мере того, как ИИ-системы переходят от экспериментов к продуктовому развёртыванию, требования, предъявляемые к базовой инфраструктуре обработки данных, возрастают, и всё большую ценность приобретают инфраструктурные платформы, которые обеспечивают крупномасштабные производственные нагрузки с большим объёмом данных: «По мере того, как модели становятся более функциональными, узкое место перемещается в инфраструктуру данных. ClickHouse выделяется тем, что обеспечивает производительность, экономичность и надёжность, необходимые для ИИ-систем, работающих в больших масштабах». ClickHouse также сообщила о приобретении стартапа Langfuse GmbH, разрабатывающего открытый инструмент для мониторинга LLM. Как сообщает SiliconANGLE, компании используют ПО Langfuse для отслеживания задержки и использования инфраструктуры своих приложений, работающих на основе LLM, что упрощает выявление первопричины сбоев и поиска решения. Эта сделка позволит ClickHouse улучшить интеграцию двух платформ. ClickHouse заявила, что цель состоит в том, чтобы сделать свою СУБД более конкурентоспособной среди разработчиков ИИ-приложений.

16.01.2026 [16:26], Владимир Мироненко

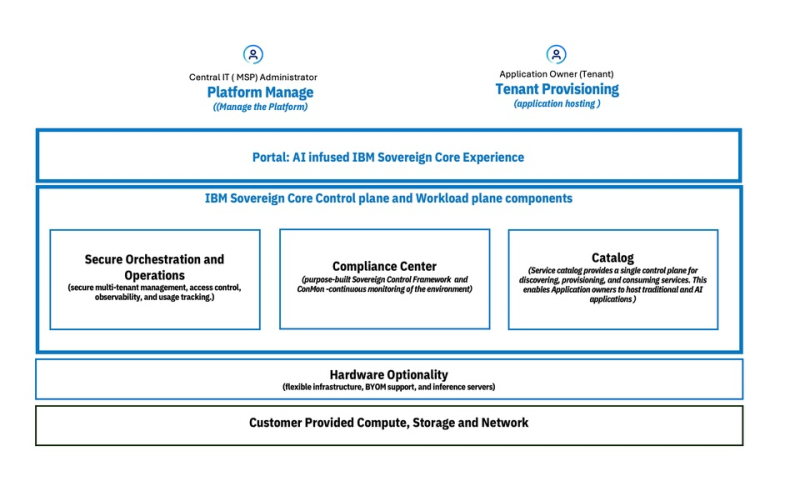

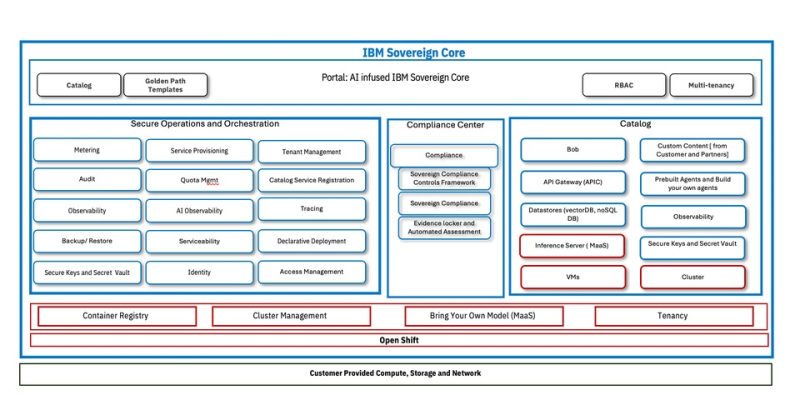

IBM представила облачную платформу IBM Sovereign Core для обеспечения непрерывного и проверяемого цифрового суверенитетаКомпания IBM представила программную платформу IBM Sovereign Core, разработанную для обеспечения более полного контроля обработки ИИ-приложений и облачных рабочих нагрузок на фоне дальнейшего ужесточения требований регулирующих органов к обеспечению цифрового суверенитета. IBM отметила, что цифровой суверенитет касается не только места размещения данных. Он также включает управление и контроль над технологической средой, контроль доступа и управление данными, управление исполнением рабочих нагрузок и юрисдикцию работы ИИ-моделей. Компания заявила, что организации при разработке инноваций испытывают всё большее давление в плане необходимости соответствия требованиям регуляторов, контроля операционной среды и хранения конфиденциальных данных в пределах национальных или региональных границ. IBM привела данные прогноза Gartner, согласно которому к 2030 году у более 75 % всех предприятий будет стратегия обеспечения цифрового суверенитета. IBM Sovereign Core — первое, по словам компании, в отрасли ПО с поддержкой суверенитета, предназначенное для создания, развёртывания и управления облачными и ИИ-нагрузками под собственным контролем организации в выбранных юрисдикциях. Оно базируется на открытых решениях Red Hat и, в отличие от предложений других провайдеров, предлагающих суверенные сервисы в виде наложения на существующие архитектуры политик или управляемых ими механизмов, предлагает суверенитет как встроенную функцию. Сачин Прасад (Sachin Prasad), программный директор по управлению продуктами в области ИИ и данных в IBM подчеркнул в интервью SiliconANGLE, что ИИ не относится к второстепенным элементам, он должен быть встроен в структуру. IBM сообщила, что при разработке IBM Sovereign Core основывалась на трёх фундаментальных принципах, которые формируют ПО от начала до конца. Во-первых, суверенитет — это возможность платформы, и он должен быть доказуемым. В IBM Sovereign Core суверенитет обеспечивается архитектурно, а не договорно. Управление основано не на наложении политик на существующие решения вендора, а на автоматизированных постоянно действующем контроле управления, принадлежащем пользователю. Платформа базируется на технологиях Red Hat OpenShift с изоляцией ПО, работающим как SaaS, но полностью находящимся под контролем компании и местных властей. Идентификация, ключи шифрования, журналы, телеметрия и аудиторские данные остаются полностью в пределах суверенных границ. Возможности постоянного соответствия требованиям встроены непосредственно в платформу, позволяя организациям по запросу получать готовые к проверке регуляторами доказательства суверенности. Во-вторых, платформа обеспечивает и суверенитет ИИ. В пределах суверенных границ организации могут развёртывать кластеры на базе CPU/GPU, использовать утверждённые открытые или проприетарные модели и управлять доступом к моделям, инструментам и источникам знаний через контролируемые шлюзы. Инференс и агенты работают локально, без экспорта данных или телеметрии внешним поставщикам. Что не менее важно, IBM Sovereign Core обеспечивает суверенитет во время выполнения, а не только во время конфигурации. Идентификация, доступ, использование моделей и активность постоянно отслеживаются и записываются, создавая чёткий аудиторский след для ИИ-систем, работающих в регулируемых областях. И в-третьих, суверенитет реализован не в ущерб производительности и масштабируемости. IBM Sovereign Core можно быстро развернуть и управлять тысячами ядер и сотнями узлов с различными требованиями и средствами контроля суверенности из единого центра. Автоматическая настройка идентификации, безопасности и соответствия требованиям заложена с самого начала, а самообслуживание для предоставления ресурсов CPU, GPU, ВМ и сред ИИ-инференса обеспечивает повторяемое развёртывание в корпоративных и многопользовательских моделях без ущерба для контроля — локально, в облаке или в партнёрских средах поставщиков услуг, где требуется лишь поддержка Kubernetes. Эта гибкость, по словам IBM, позволяет клиентам перемещать рабочие нагрузки не только между регионами, но и между различными инфраструктурами, что в сочетании с возможностью устанавливать уникальные параметры управления, позволит адаптироваться по мере изменения нормативных требований с развитием ИИ-технологий. Благодаря проверяемому аудиторскому следу, документирующему непрерывное соответствие требованиям, компания сможет в любой момент продемонстрировать соответствие нормам в области суверенитета и, таким образом, сократить расходы, связанные с аудитом. «Соответствие требованиям и аудит обходятся дорого с точки зрения времени и ресурсов, и ситуация только ухудшается», — сообщил главный аналитик Moor Insights and Strategy Джейсон Андерсен (Jason Andersen). «Всё, что упростит и оптимизирует этот процесс, принесёт большую пользу IT-специалистам и поставщикам управляемых услуг», — добавил он. Андерсен также отметил, что хотя на рынке предлагаются облачные решения для обеспечения суверенитета от AWS, Google и Microsoft, он «ещё не увидел ничего, созданного для гибридных сред, подобного тому, что предлагает IBM». По словам Прасада, при развёртывании новой платформы IBM первоначально сотрудничает с европейскими поставщиками услуг, прежде чем расширить сотрудничество на более широкий круг партнёров. Такой подход призван получить обратную связь, но не ограничит распространение. Он добавил, что IBM рассчитывает продавать пакет напрямую: «Он будет продаваться так же, как и любой другой продукт». Компания сообщила, что начиная с февраля, IBM Sovereign Core будет доступна в режиме предварительного тестирования, а выход полной общедоступной версии запланирован на середину 2026 года. |

|