Материалы по тегу: ibm

|

11.02.2026 [16:48], Владимир Мироненко

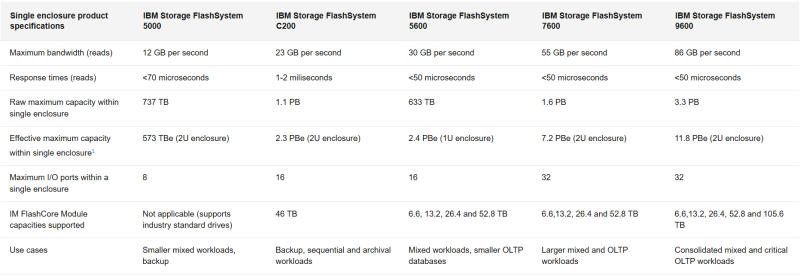

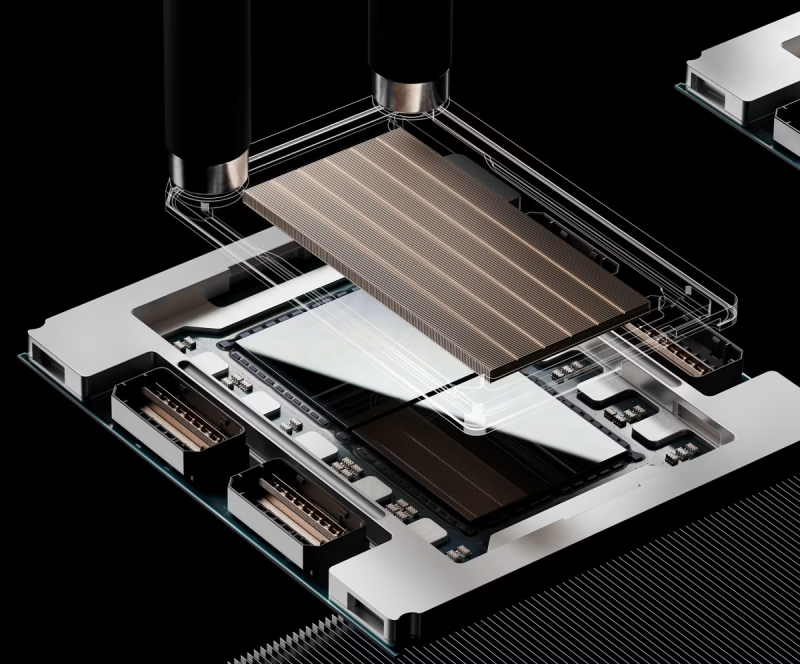

All-Flash СХД IBM FlashSystem 5600, 7600 и 9600 получили автономное ИИ-управлениеIBM представила системы хранения данных FlashSystem класса All-Flash следующего поколения 5600, 7600 и 9600, которые, как утверждается, обеспечивают до 40 % большую эффективность обработки данных, ёмкость и производительность по сравнению с предыдущим поколением. Компания назвала выход сразу трёх новых систем самым значительным обновлением FlashSystem за последние шесть лет. IBM сообщила, что расширяя существующие возможности FlashSystem с помощью агентного ИИ, она переосмысливает отказоустойчивость за счёт постоянной защиты, автономного анализа угроз и индивидуальных рекомендаций по восстановлению. Генеральный директор IBM Storage Сэм Вернер (Sam Werner) описывает новую FlashSystem как постоянно доступный интеллектуальный слой, использующий автономных ИИ-агентов для повышения производительности, безопасности и снижения затрат. Он отметил, что IBM позиционирует этот релиз как шаг к созданию СХД, которая будет служить стратегическим партнёром по ИИ для ИТ-руководителей, а не статическим хранилищем, требующим постоянного ручного контроля. FlashSystems — это классические двухконтроллерные массивы, работающие под управлением ОС SAN Volume Controller и поддерживающие блочное хранение данных. В новых системах установлен флеш-накопитель пятого поколения FlashCore Module ёмкостью до 105,6 Тбайт, разработанный для обеспечения аппаратного ускорения обнаружения программ-вымогателей в реальном времени, сокращения объёма данных, аналитики и управления, с расширенной телеметрией и стабильно низкой задержкой. Система FlashSystem 5600 ориентирована на организации, которым требуются функции корпоративного класса в компактном форм-факторе. Заявлена эффективная ёмкостью до 2,5 Пбайт, пропускная способность до 30 Гбайт/с и производительность до 2,6 млн IOPS (чтение 4K-блоками) в одном 1U-шасси. Узел включает два 12-ядерных Intel Xeon и 256 или 512 Гбайт RAM. Общее количество IO-портов не превышает 16: 10/25/40/100GbE с поддержкой iSCSI и NVMe/TCP или FC32/64 с NVMe/FC (такие же опции и у старших моделей). Система разработана для развёртывания в условиях ограниченного пространства, таких как периферийные узлы, удалённые офисы и небольшие ЦОД. IBM FlashSystem 7600 предназначена для высокопроизводительных масштабируемых сред с растущими рабочими нагрузками, обеспечивает до 7,2 Пбайт эффективной ёмкости в одной системе форм-фактора 2U, 55 Гбайт/с и до 4,3 млн IOPS. 7600 предназначена для работы с большими виртуализированными средами, аналитическими платформами и консолидированными приложениями, требующими большей ёмкости и более быстрого отклика. Узел содержит два 16-ядерных AMD EPYC и 768 Гбайт или 1,5 Тбайт RAM. IBM FlashSystem 9600 создана для критически важных операций, требующих экстремальной производительности и максимальной масштабируемости, обеспечивает до 11,8 Пбайт эффективной ёмкости в одной системе форм-фактора 2U, до 86 Гбайт/с и до 6,3 млн IOPS. Количество портов — до 32. Узлы включают два 48-ядерных AMD EPYC и 1,5 или 3 Тбайт RAM. Типичные сценарии использования системы включают основные банковские системы, ERP-платформы и приложения на основе ИИ, требующие скорости и расширенной безопасности. По данным компании, использование FlashSystem 9600 позволяет снизить эксплуатационные расходы на 57 % за счёт ИИ и консолидации по сравнению с предыдущим поколением. IBM сообщила, что IBM FlashSystem уменьшает требуемый объём хранилища на 30–75 % в зависимости от модели за счёт оптимизированного размещения и консолидации по сравнению с предыдущим поколением. У FlashSystem 7600 и 9600 есть интерактивные светодиодные панели, позволяющие отслеживать состояние системы. IBM также представила FlashSystem.ai, новый набор интеллектуальных сервисов обработки данных на основе ИИ, предназначенных для управления, мониторинга, диагностики и решения проблем на всём пути передачи данных. FlashSystem.ai обеспечивает бесперебойную работу в режиме самообслуживания, автоматизируя ручные и подверженные ошибкам задачи. Благодаря модели, обученной на десятках миллиардов точек данных, собранных с помощью расширенной телеметрии и многолетнего опыта реального работы с данными, платформа может выполнять тысячи автоматизированных решений в день, которые ранее требовали человеческого контроля. Помимо автоматизации, IBM подчеркивает адаптивное поведение СХД. Функции агентного ИИ позволяют понимать шаблоны приложений в течение нескольких часов, объяснять свои рассуждения и учитывать отзывы администраторов для улучшения предложений с течением времени. В последних FlashSystem, по утверждению IBM, FlashSystem.ai может сократить время, затрачиваемое на документацию по аудиту и соответствию требованиям, вдвое благодаря объяснимым рассуждениям ИИ. Системы разработаны для проактивной настройки и интеллектуального размещения рабочих нагрузок, обеспечивая беспрепятственное перемещение данных между конфигурациями хранения, включая массивы сторонних производителей. IBM также утверждает, что ее новый метод обнаружения угроз, обученный на десятках миллиардов точек телеметрических данных, может снизить количество ложных срабатываний до менее 1 %. Компания также заявила, что платформа, используя FlashCore, может обеспечить обнаружение программ-вымогателей и оповещение с помощью ИИ менее чем за 60 с, а также выполнить автономные действия по восстановлению на аппаратном уровне.

10.02.2026 [15:33], Владимир Мироненко

IBM сворачивает продажи серверов POWER10Спустя несколько месяцев после презентации серверов POWER11 компания IBM уведомила клиентов о предстоящем прекращении продаж систем на базе процессоров POWER10. Как отметил ресурс ITJungle, обычно IBM делает такие объявления заблаговременно, как правило, за полгода или более. В информационном письме AD26-0012 IBM сообщила, что следующие модели не будут продаваться после 31 июля 2026 года, за исключением Китая и Южной Кореи, где их можно будет приобрести до 30 июля 2027 года и где платформы POWER9 и POWER10 оказались чрезвычайно популярны в банковской и финансовых сферах, а также в индустрии страхования:

В перечень снятых с производства серверов не вошёл POWER S1012 Mini, анонсированный в мае 2024 года, поскольку его преемник POWER S1112 Mini всё ещё не анонсирован. Снятие с производства не распространяется на модернизацию POWER E1080 — то, что IBM называет спецификацией дополнительного оборудования (Miscellaneous Equipment Specification, MES). Модернизация на POWER E1080 с предыдущих систем по-прежнему будет доступна, что помогает продлить амортизацию. Это важно для балансов компаний, использующих крупногабаритное оборудование POWER. По данным ITJungle, для других устройств линейки POWER10 модернизация с использованием MES с предыдущих моделей недоступна, а для машин начального и среднего уровня в линейке POWER Systems её давно нет. После июльских дат 2026 и 2027 годов также будет отключена возможность активации процессоров на этих устройствах в процессе перехода с одной модели на другую (что не то же самое, что обновление в понимании IBM). Однако по традиции это не касается оставшихся, но ещё не активированных в рамках одной машины процессоров и памяти. Также после указанных дат для снятых с производства серверов POWER10 не будут предлагаться различные уровни услуг Advanced Expert Care и POWER Expert Care от IBM. Некоторые кабели также будут исключены из каталога, а для более компактных моделей будет снят с продажи ряд плат расширения, адаптеров, памяти DDR5, флеш-накопителей и других периферийных устройств. Это касается только заказов на новые системы. Как полагает ITJungle, немногие клиенты перейдут с POWER10 на POWER11, если только они не приобрели POWER10 на очень раннем этапе цикла. Безусловно, между POWER10 и POWER11 есть важные различия, но их недостаточно, чтобы оправдать масштабное и сложное обновление или переход на новую систему. Согласно прогнозу ITJungle, клиенты POWER10 будут мигрировать уже на POWER12 — возможно, года через три.

31.01.2026 [21:05], Владимир Мироненко

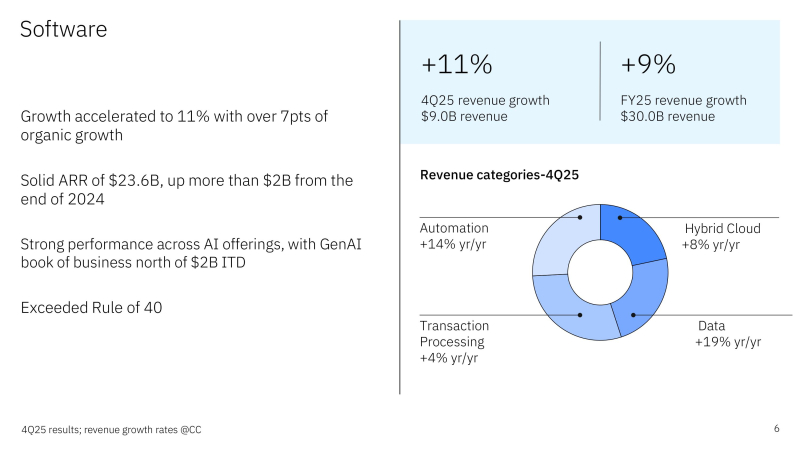

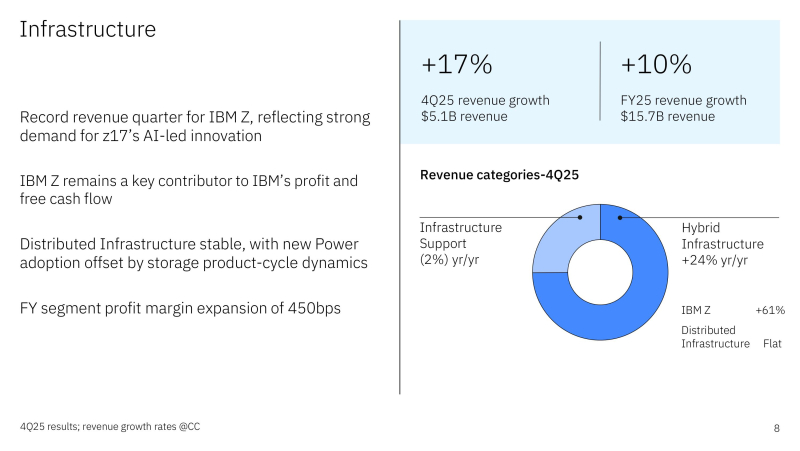

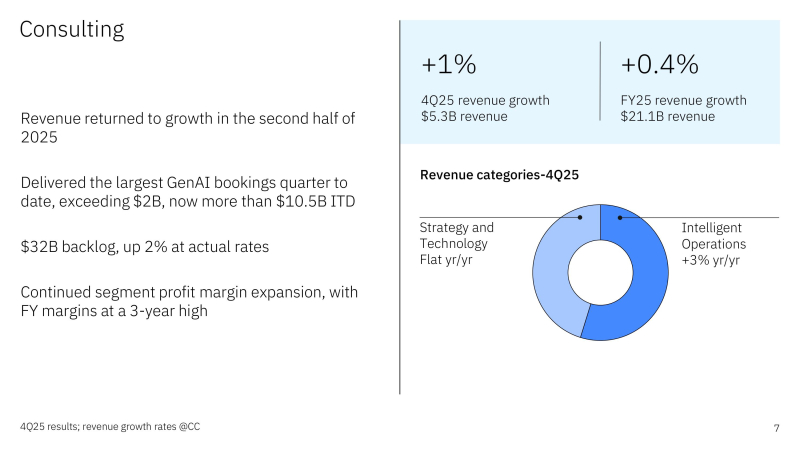

IBM превзошла прогнозы Уолл-стрит благодаря спросу на ИИ, а мейнфреймы показали лучший старт продаж за всю историюIBM опубликовала финансовые результаты за IV квартал и весь 2025 год, завершившийся 31 декабря 2025 года. IBM превзошла прогнозы Уолл-стрит по выручке и прибыли за IV квартал, поскольку быстрое внедрение ИИ увеличило спрос на её программные решения, от управления огромными объёмами данных до автоматизации ИТ-процессов, отметило агентство Reuters. Акции компании выросли почти на 9 % на дополнительных торгах. Глава IBM Арвинд Кришна (Arvind Krishna) сообщил, что объём портфеля заказов в сфере генеративного ИИ сейчас превышает $12,5 млрд. «Мы вступаем в 2026 год с хорошим настроем и в сильной позиции, что даёт нам уверенность в наших прогнозах на весь год: рост выручки более чем на 5 % в постоянной валюте и увеличение свободного денежного потока примерно на $1 млрд в годовом исчислении», — отметил он в пресс-релизе. Аналитики прогнозируют рост продаж на 4,6 % в 2026 году, согласно данным опроса LSEG. Выручка IBM за квартал выросла год к году на 12 % до $19,69 млрд при консенсус-прогнозе от LSEG в $19,23 млрд. Скорректированная чистая прибыль (Non-GAAP) на разводнённую акцию составила $4,52 при прогнозе $4,32. Чистая прибыль (GAAP) увеличилась до $5,6 млрд, или $5,88 на разводнённую акцию, с $2,92 млрд, или $3,09 на разводнённую акцию годом ранее. Выручка IBM от разработки ПО выросла год к году на 14 % до $9,03 млрд, что также выше прогноза Уолл-стрит в $8,77 млрд. При этом выручка подразделения по автоматизации увеличилась на 18 %, выручка подразделения по обработке данных и ИИ — на 22 %, выручка от обработки транзакций — на 8 %. Однако рост продаж в высокорентабельном подразделении гибридных облачных решений, включающем Red Hat, замедлился до 10 % по сравнению с 14 % в III квартале и 16 % во II квартале. Как пояснил финансовый директор Джим Кавано (Jim Kavanaugh) в интервью Reuters, на росте подразделения гибридных облачных решений негативно отразилась самая длительная в истории приостановка работы (шатдаун) правительства США, которая произошла в отчётном квартале. Шатдаун уменьшил рост выручки Red Hat на «несколько процентных пунктов», сказал Кавано, отметив, что на федеральное правительство приходится около 15 % всех заказов на гибридные облачные решения. Выручка инфраструктурного подразделения (IBM Infrastructure), занимающегося продажей серверов, СХД, коммутаторов и системного ПО, составила $5,13 млрд, что на 20,6 % больше, чем годом ранее, а его прибыль до налогообложения — $1,6 млрд. Согласно оценкам аналитиков ресурса The Next Platform, продажи аппаратного обеспечения и системного ПО выросли на 29 % до $3,85 млрд, а поступления за техническую поддержку инфраструктуры — на 1 % до $1,29 млрд. IBM не публикует данные о выручке от продажи серверов отдельно, но сообщила, что продажи System z выросли на 67 %, а продажи POWER Systems и продуктов хранения данных вместе взятых — то, что компания называет «распределенной инфраструктурой», хотя большая часть её предназначена для корпоративного оборудования бэк-офиса, — выросли на 3 %. Арвинд Кришна сообщил, что система z17 показала «самый сильный старт» за три квартала с момента запуска среди всех поколений мейнфреймов IBM. Как пишет Data Center Dynamics, говоря об успехе мейнфреймов, Кришна отметил, что каждое новое поколение мейнфреймов показывает лучшие результаты, чем предыдущее, и это «постоянное улучшение». По его словам, успех z17 частично обусловлен возросшим интересом к цифровому суверенитету или «локальному управлению», а также экономической выгодой. «Я думаю, что всё больше и больше клиентов осознали, что для определённых рабочих нагрузок мейнфрейм фактически является платформой с наименьшей себестоимостью, и это действительно важно», — заявил Кришна. Он добавил, что последняя версия мейнфреймов также упрощает развёртывание ИИ для клиентов, в том числе благодаря добавлению ускорителя Spyre AI. Также следует отметить, что подразделение IBM z достигло самого высокого годового дохода за последние 20 лет благодаря последнему поколению мейнфреймов. Подразделение консалтинга обеспечило выручку в размере $5,35 млрд, что на 3,4 % больше год к году, при этом продажи в сегменте стратегий и технологий выросли на 2 % до $2,9 млрд, а продажи в сегменте интеллектуальных операций (который, по сути, является хостингом приложений) — на 5 % до $2,4 млрд. Кришна отметил, что генеративный ИИ составляет 25 % от текущего портфеля заказов на выручку в $32 млрд и около 15 % выручки от консалтинга. Годовой оборот консалтинговых услуг GenAI к концу IV квартала 2025 года составил $3,6 млрд. Платформа Red Hat OpenShift, включающая различные варианты ИИ со встроенными моделями и фреймворками, приносит компании более $2 млрд дохода в год и растет на 30 % в год. Объём бизнеса компании в сфере ИИ вырос до $12,5 млрд в IV квартале, что на $3 млрд больше, чем в предыдущем квартале. IBM прекратит публиковать этот показатель отдельно с I квартала, предупредил Кавано, поскольку, по его словам, эти цифры неточно отражают общую сумму доходов от ИИ, полученных от корпоративных клиентов IBM. Выручка IBM за весь год составила $67,53 млрд (рост на 8 %), из которых $15,72 млрд приходится на инфраструктуру (рост — 12,1 %). Выручка от разработки ПО достигла $29,69 млрд (рост — на 10,6 %), консалтинговых услуг — $21,06 млрд (рост — 1,8 %). Кавано также сообщил, что у IBM в 2026 году произойдёт разводнение акционерного капитала примерно на $600 млн в результате приобретения Confluent, в основном за счёт компенсаций акциями и процентных расходов. Кроме того, Кришна заявил, что компания планирует запустить свой первый крупномасштабный квантовый компьютер к 2029 году.

16.01.2026 [16:26], Владимир Мироненко

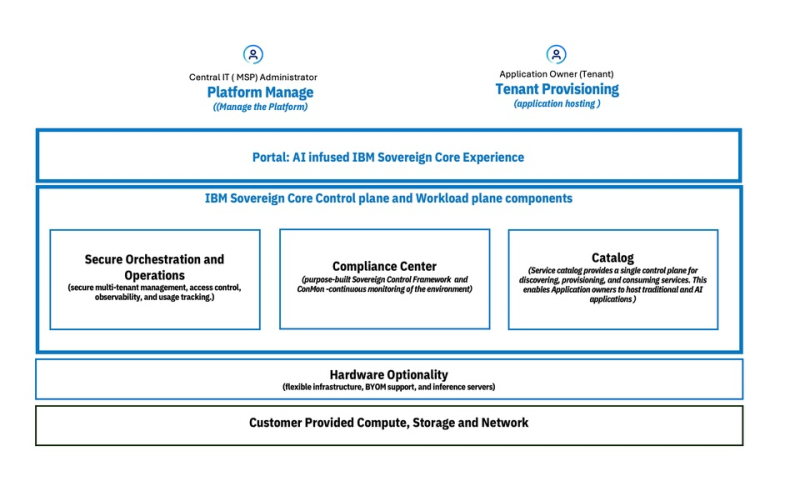

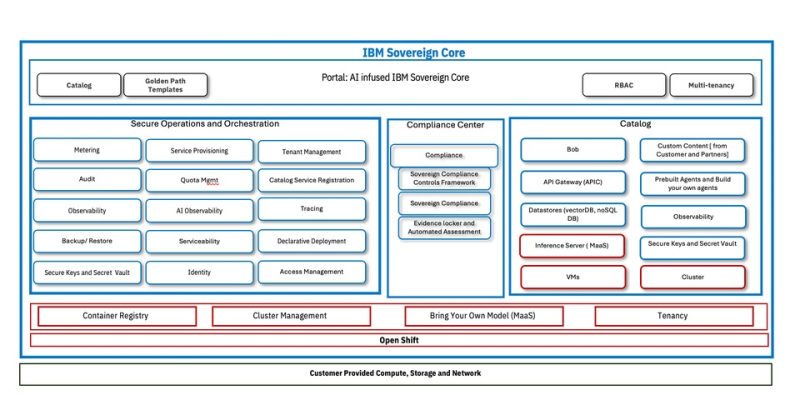

IBM представила облачную платформу IBM Sovereign Core для обеспечения непрерывного и проверяемого цифрового суверенитетаКомпания IBM представила программную платформу IBM Sovereign Core, разработанную для обеспечения более полного контроля обработки ИИ-приложений и облачных рабочих нагрузок на фоне дальнейшего ужесточения требований регулирующих органов к обеспечению цифрового суверенитета. IBM отметила, что цифровой суверенитет касается не только места размещения данных. Он также включает управление и контроль над технологической средой, контроль доступа и управление данными, управление исполнением рабочих нагрузок и юрисдикцию работы ИИ-моделей. Компания заявила, что организации при разработке инноваций испытывают всё большее давление в плане необходимости соответствия требованиям регуляторов, контроля операционной среды и хранения конфиденциальных данных в пределах национальных или региональных границ. IBM привела данные прогноза Gartner, согласно которому к 2030 году у более 75 % всех предприятий будет стратегия обеспечения цифрового суверенитета. IBM Sovereign Core — первое, по словам компании, в отрасли ПО с поддержкой суверенитета, предназначенное для создания, развёртывания и управления облачными и ИИ-нагрузками под собственным контролем организации в выбранных юрисдикциях. Оно базируется на открытых решениях Red Hat и, в отличие от предложений других провайдеров, предлагающих суверенные сервисы в виде наложения на существующие архитектуры политик или управляемых ими механизмов, предлагает суверенитет как встроенную функцию. Сачин Прасад (Sachin Prasad), программный директор по управлению продуктами в области ИИ и данных в IBM подчеркнул в интервью SiliconANGLE, что ИИ не относится к второстепенным элементам, он должен быть встроен в структуру. IBM сообщила, что при разработке IBM Sovereign Core основывалась на трёх фундаментальных принципах, которые формируют ПО от начала до конца. Во-первых, суверенитет — это возможность платформы, и он должен быть доказуемым. В IBM Sovereign Core суверенитет обеспечивается архитектурно, а не договорно. Управление основано не на наложении политик на существующие решения вендора, а на автоматизированных постоянно действующем контроле управления, принадлежащем пользователю. Платформа базируется на технологиях Red Hat OpenShift с изоляцией ПО, работающим как SaaS, но полностью находящимся под контролем компании и местных властей. Идентификация, ключи шифрования, журналы, телеметрия и аудиторские данные остаются полностью в пределах суверенных границ. Возможности постоянного соответствия требованиям встроены непосредственно в платформу, позволяя организациям по запросу получать готовые к проверке регуляторами доказательства суверенности. Во-вторых, платформа обеспечивает и суверенитет ИИ. В пределах суверенных границ организации могут развёртывать кластеры на базе CPU/GPU, использовать утверждённые открытые или проприетарные модели и управлять доступом к моделям, инструментам и источникам знаний через контролируемые шлюзы. Инференс и агенты работают локально, без экспорта данных или телеметрии внешним поставщикам. Что не менее важно, IBM Sovereign Core обеспечивает суверенитет во время выполнения, а не только во время конфигурации. Идентификация, доступ, использование моделей и активность постоянно отслеживаются и записываются, создавая чёткий аудиторский след для ИИ-систем, работающих в регулируемых областях. И в-третьих, суверенитет реализован не в ущерб производительности и масштабируемости. IBM Sovereign Core можно быстро развернуть и управлять тысячами ядер и сотнями узлов с различными требованиями и средствами контроля суверенности из единого центра. Автоматическая настройка идентификации, безопасности и соответствия требованиям заложена с самого начала, а самообслуживание для предоставления ресурсов CPU, GPU, ВМ и сред ИИ-инференса обеспечивает повторяемое развёртывание в корпоративных и многопользовательских моделях без ущерба для контроля — локально, в облаке или в партнёрских средах поставщиков услуг, где требуется лишь поддержка Kubernetes. Эта гибкость, по словам IBM, позволяет клиентам перемещать рабочие нагрузки не только между регионами, но и между различными инфраструктурами, что в сочетании с возможностью устанавливать уникальные параметры управления, позволит адаптироваться по мере изменения нормативных требований с развитием ИИ-технологий. Благодаря проверяемому аудиторскому следу, документирующему непрерывное соответствие требованиям, компания сможет в любой момент продемонстрировать соответствие нормам в области суверенитета и, таким образом, сократить расходы, связанные с аудитом. «Соответствие требованиям и аудит обходятся дорого с точки зрения времени и ресурсов, и ситуация только ухудшается», — сообщил главный аналитик Moor Insights and Strategy Джейсон Андерсен (Jason Andersen). «Всё, что упростит и оптимизирует этот процесс, принесёт большую пользу IT-специалистам и поставщикам управляемых услуг», — добавил он. Андерсен также отметил, что хотя на рынке предлагаются облачные решения для обеспечения суверенитета от AWS, Google и Microsoft, он «ещё не увидел ничего, созданного для гибридных сред, подобного тому, что предлагает IBM». По словам Прасада, при развёртывании новой платформы IBM первоначально сотрудничает с европейскими поставщиками услуг, прежде чем расширить сотрудничество на более широкий круг партнёров. Такой подход призван получить обратную связь, но не ограничит распространение. Он добавил, что IBM рассчитывает продавать пакет напрямую: «Он будет продаваться так же, как и любой другой продукт». Компания сообщила, что начиная с февраля, IBM Sovereign Core будет доступна в режиме предварительного тестирования, а выход полной общедоступной версии запланирован на середину 2026 года.

16.01.2026 [12:20], Сергей Карасёв

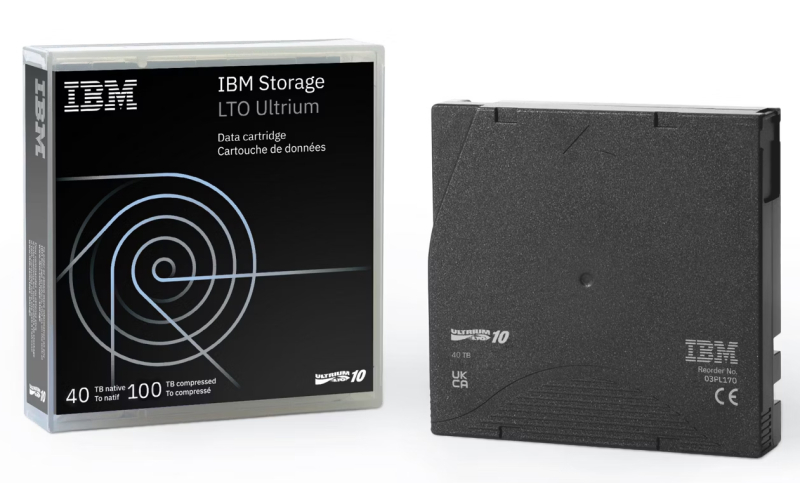

Новые картриджи IBM LTO Ultrium 10 вмещают 100 Тбайт данныхКорпорация IBM представила ленточные картриджи LTO Ultrium 10 (LTO-10), рассчитанные на хранение 40 Тбайт данных в «сыром» виде. При использовании компрессии 2,5:1 вместимость достигает 100 Тбайт. Изделия также доступны в варианте ёмкостью 30 и 75 Тбайт соответственно. Как и ранее анонсированные решения Fujifilm LTO Ultrium 10 на 40 Тбайт, новинки IBM используют подложку ленты на основе арамида: этот материал позволяет уменьшить толщину ленты, а следовательно, увеличить её длину внутри стандартного картриджа. В результате, становится возможным повышение вместимости. Картриджи IBM LTO Ultrium 10 доступны в варианте с поддержкой перезаписи и в версии WORM (однократная запись и многократное чтение), которая исключает возможность изменения информации. В качестве опции доступны изделия с RFID-метками. Возможно шифрование данных по алгоритму AES-256. Изделия IBM LTO Ultrium 10 на 40 Тбайт будут поставляться в комплектах из 5 и 20 штук. Диапазон рабочих температур простирается от +10 до +45 °C. Изделия станут доступны в начале марта. Спрос на ленточные накопители продолжает устойчиво расти. По оценкам, суммарная вместимость отгруженных LTO-картриджей в 2024 году достигла рекордных 176,5 Эбайт с учётом компрессии 2,5:1. Для сравнения: годом ранее поставки оценивались в 152,9 Эбайт, а в 2020 году — в 105,2 Эбайт. Ключевыми преимуществами ленточных систем являются высокая ёмкость и низкая стоимость хранения информации в расчёте на 1 Тбайт, долговечность и безопасность (благодаря возможности формирования «воздушного зазора»).

09.12.2025 [00:17], Владимир Мироненко

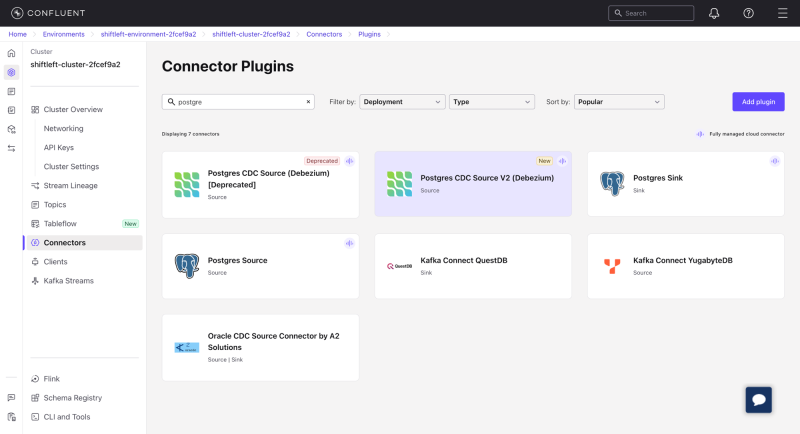

IBM купила Confluent за $11 млрд, чтобы побольше заработать на ИИIBM объявила о приобретении поставщика инфраструктуры для обработки потоковых данных Confluent. Согласно соглашению, IBM приобретает все выпущенные и находящиеся в обращении обыкновенные акции Confluent по цене $31/ед., что на 25,5 % превышает текущую цену акций в $23,14 и соответствует общей стоимости предприятия в $11 млрд. Оплата будет произведена IBM за счёт имеющихся денежных средств. Покупка Confluent станет крупнейшей сделкой для IBM за последнее время, поскольку компания переориентирует свой бизнес на ИИ, пишет The Wall Street Journal. После объявления о сделке акции Confluent взлетели более чем на 25 % на премаркете, в то время как акции IBM немного упали в цене. В июне 2021 года Confluent вышла на биржу, получив в ходе первичного размещения $828 млн при оценке рыночной стоимости в $4,5 млрд. В настоящее время рыночная капитализация Confluent составляет $8,09 млрд. Confluent была основана в 2014 году тремя бывшими инженерами LinkedIn, разработавшими ПО Apache Kafka. В 2015 году компания запустила самоуправляемую платформу Confluent, а в 2020 году — полностью управляемое SaaS-решение Confluent Cloud. У компании насчитывается более 6500 клиентов в основных отраслях промышленности. Более 40 % из них входят в список Fortune 500. Confluent сотрудничает в технологической отрасли с такими компаниями, как Anthropic, AWS, GCP, Microsoft, Snowflake и т.д. Сделка уже одобрена советом директоров IBM, а также советом директоров и независимым специальным комитетом Confluent. Теперь дело за одобрением акционерами Confluent и получением разрешений регулирующих органов. IBM сообщила, что заключила соглашение с крупнейшими акционерами и инвесторами Confluent, которым в совокупности принадлежит около 62 % голосующих акций, находящихся в обращении. Согласно этому соглашению, они будут голосовать за одобрение сделки только с IBM. Как ожидается, с учётом необходимых процедур, сделка будет закрыта к середине 2026 года.

Источник изображения: Confluent Confluent является разработчиком корпоративной open source платформы для работы с потоками данных в режиме реального времени. IBM отметила, что Confluent «превосходно» справляется с подготовкой данных для ИИ, поддерживая их чистоту и связность и устраняя разрозненность, присущую агентному ИИ. За последние четыре года общий объём доступного рынка Confluent (TAM) удвоился с $50 до $100 млрд. Возможности Confluent в сочетании с ПО IBM для ИИ-инфраструктуры и решениями IBM для автоматизации обеспечат более эффективную работу компаний в сфере ИИ. Благодаря сделке IBM получит мощный механизм и платформу для стриминговой обработки данных в режиме реального времени, которые она сможет интегрировать в свои решения для ИИ-конвейеров, в том числе в агентов watsonx, отметил ресурс Blocks & Files. В мае 2025 года IBM приобрела примерно за $3 млрд DataStax, разработчика AstraDB — облачной NoSQL-СУБД на базе Apache Cassandra, интеграция технологий которой в IBM watsonx поможет управлять и упрощать доступ к огромным объёмам данных, которые необходимы для генеративного ИИ. В свою очередь, Salesforce в мае приобрела компанию Informatica, занимающуюся инфраструктурой данных, примерно за $8 млрд, а Databricks в октябре анонсировала продукт для стриминговой работы с данными, что может ограничить рынок Confluent, пишет Blocks & Files.

03.12.2025 [17:56], Руслан Авдеев

Арифметика не сходится: без прорыва инвестиции в ИИ не окупятся «ни при каких обстоятельствах», заявил глава IBMПо словам генерального директора IBM Арвинда Кришны (Arvind Krishna), занимающиеся ИИ-проектами компании тратят миллиарды долларов в гонке за создание «общего искусственного интеллекта» (AGI), способного сравняться с человеком или заменить его. Но в экономической целесообразности таких проектов он сомневается, сообщает Business Insider. По его словам, расходы на ИИ-инфраструктуру постоянно растут, но компании, вероятно, «никаким образом» не смогут окупить такие затраты на дата-центры. По грубым оценкам бизнесмена, сегодня для дата-центра мощностью 1 ГВт требуется около $80 млрд. Если компания намерена построить дата-центры на 20–30 ГВт, её понадобится $1,5 трлн капиталовложений. При этом уже через пять лет ИИ-чипы в ЦОД потеряют актуальность, после чего будет необходимо всё «выбросить и заменить». Как заявил Кришна, если смотреть на инвестиции в сфере разработки AGI, то они составляют около 100 ГВт. При текущем уровне затрат на инфраструктуру общая стоимость гонки составит приблизительно $8 трлн. По словам Кришны, никакой прибыли ждать не приходится, поскольку только для выплаты процентов с $8 трлн кредитов потребуется около $800 млрд ежегодно. При этом без внешней финансовой и иной помощи не обойтись. В октябрьском послании к американским властям глава OpenAI Сэм Альтман (Sam Altman) рекомендовал США строить по 100 ГВт генерирующих мощностей в год, а сама OpenAI обязалась потратить около $1,4 трлн на различные сделки. Кришна не вполне согласен с Альтманом. Глава IBM вообще не уверен, что доступные сегодня технологии в принципе позволят создать AGI. Вероятность появления AGI без технологической революции Кришна оценил не более в чем 1 %. Простым масштабирование вычислительных мощностей, по-видимому, не обойтись. Скептически к идее ускорения создания AGI отнеслись и некоторые другие лидеры технологических компаний. Глава Salesforce Марк Бениофф (Marc Benioff) заявлял, что с «крайним подозрением» относится к продвижению AGI, сравнив процесс с гипнозом. Руководивший проектом Google Brain Эндрю Ын (Andrew Ng) говорил, что AGI «переоценен», а генеральный директор Mistral Артур Менш (Arthur Mensch) назвал AGI «маркетинговым ходом». По словам соучредителя OpenAI Ильи Суцкевера, эпоха масштабирования прошла, и даже стократное увеличение масштаба LLM не поможет сделать настоящий качественный скачок. Мир снова возвращается в эпоху исследований, только с очень большими компьютерами. Сам Кришна ничего против ИИ как такового не имеет. По его словам, ИИ-инструменты позволят предприятиям повысить эффективность, дав им триллионы долларов. Тем не менее, для AGI нужно больше технологий, чем просто современные LLM. Для его создания понадобится объединить LLM с «фундаментальными знаниями» (hard knowledge). Но даже в этом случае вероятность создания AGI можно отнести лишь к категории «возможно». Хотя оптимистичный прогноз NVIDIA снизил опасения по поводу возможного возникновения «пузыря» на рынке ИИ, о возможности его появления эксперты и участники отрасли высказывались неоднократно. При этом в ноябре The Wall Street Journal рассказал, что IT-гиганты вкладывают в отрасль всё больше средств, без оглядки на опасения.

24.11.2025 [09:09], Сергей Карасёв

IBM утроила вместимость СХД Storage Scale System 6000 — до 47 Пбайт на стойкуКорпорация IBM объявила о выпуске обновлённой СХД Storage Scale System 6000, предназначенной для работы с ресурсоёмкими ИИ-приложениями, а также с нагрузками, которым требуется интенсивный обмен большими объёмами информации. Платформа Storage Scale System 6000 дебютировала в конце 2024 года. Устройство типоразмера 4U оснащено двумя контроллерами, работающими в режиме «активный — активный». Применяются процессоры AMD EPYC Genoa 7642 (48C/96T; 2,3–3,3 ГГц; 225 Вт) или EPYC Embedded 9454 (48C/96T; 2,75–3,8 ГГц; 290 Вт), а максимальный объём оперативной памяти в расчёте на систему составляет 3072 Гбайт. Допускается установка 48 NVMe-накопителей. Также поддерживаются фирменные FCM-модули со сжатием на лету. Вместимость оригинальной версии достигала 2,2 Пбайт (при использовании комбинации SSD на 30 и 60 Тбайт). При подключении девяти дополнительных JBOD-массивов показатель вырастал до 15 Пбайт. Заявленная производительность — до 13 млн IOPS. Пропускная способность при чтении — до 330 Гбайт/с, при записи — до 155 Гбайт/с.

Источник изображения: IBM В случае обновлённой модификации Storage Scale System 6000 реализована поддержка QLC-накопителей вместимостью до 122 Тбайт. Кроме того, представлены новые модули расширения All-Flash Expansion Enclosure стандарта 2U, рассчитанные на 26 двухпортовых накопителей QLC. В результате, общая ёмкость СХД в конфигурации в виде стойки 42U достигает 47 Пбайт, что примерно втрое больше по сравнению с оригинальным вариантом. При этом быстродействие поднялось до 28 млн IOPS, а пропускная способность в режиме чтения — до 340 Гбайт/с. В состав All-Flash Expansion Enclosure входят DPU NVIDIA BlueField-3 (до 4 шт.). Каждый модуль расширения может обеспечить пропускную способность до 100 Гбайт/с. Решение оптимизировано для обучения больших языковых моделей, инференса, НРС-задач и пр. В продажу изделие поступит в декабре; тогда же станет доступно улучшенное ПО для СХД — IBM Storage Scale System 7.0.0.

23.10.2025 [23:43], Владимир Мироненко

Инвесторы остались недовольны замедлением роста выручки от ПО IBM — акции упали, несмотря на рост показателейКорпорация IBM опубликовала финансовые результаты за III квартал 2025 года, завершившийся 30 сентября, которые превзошли ожидания Уолл-стрит, и повысила свой прогноз в связи с благоприятными условиями для развития ИИ-технологий. Однако акции компании упали на 5 %, поскольку инвесторы остались недовольны замедлением роста выручки от продаж в ключевом сегменте облачного ПО, пишет Reuters, Выручка IBM выросла за отчётный период год к году на 9 % до $16,33 млрд, что выше консенсус-прогноза аналитиков, опрошенных LSEG, равного $16,09 млрд. Скорректированная прибыль (Non-GAAP) на акцию равняется $2,65 при целевом показателе аналитиков от LSEG в размере $2,45 на акцию. Чистая прибыль (GAAP) за квартал составила $1,74 млрд, тогда как годом ранее у компании были убытки в $330 млн, обусловленные пенсионными выплатами в размере $2,7 млрд. Глава IBM Арвинд Кришна (Arvind Krishna) охарактеризовал минувший квартал как успешный: благодаря росту показателей во всех сегментах компания превзошла прогнозы экспертов по выручке, прибыли и свободному денежному потоку. «Клиенты по всему миру продолжают использовать наши технологии и экспертные знания для повышения производительности своих операций и создания реальной бизнес-ценности с помощью ИИ», — отметил он. Кришна сообщил, что портфель заказов компании в сфере ИИ, объединяющий бронирование с фактическими продажами различных продуктов и услуг на базе ИИ, вырос по сравнению с предыдущим кварталом на $7,5 млрд, превысив $9,5 млрд. Выручка IBM от разработки ПО выросла год к году на 10 % до $7,21 млрд, что соответствует прогнозу StreetAccount. При этом выручка в категории гибридного облачного ПО, включающей Red Hat, увеличилась на 14 %, тогда как в предыдущем квартале её рост составил 16 %. Замедление роста выручки стало поводом для недовольства инвесторов. Кришна заверил аналитиков в ходе телефонной конференции, что подразделение гибридного облака вернется к росту в среднем на 15 % или близко к этому уровню к началу 2026 года. «Замедление роста выручки и продаж Red Hat… разочарует тех, кто надеялся на ускорение роста в этом высокорентабельном сегменте», — заявил Майкл Эшли Шульман (Michael Ashley Schulman), директор по инвестициям Running Point Capital. Как пишет SiliconANGLE, с его мнением совпало мнение аналитика Evercore ISI Амита Дарьянани (Amit Daryanani) и аналитика Jeffries Брента Тилла (Brent Thill), который в своей записке для инвесторов сообщил, что перспективы софтверного бизнеса IBM в значительной степени зависят от того, сможет ли Red Hat найти способ возобновить рост: «Ускорение роста бизнеса IBM в сфере ПО в ближайшие несколько кварталов будет зависеть от динамики развития Red Hat, которая остаётся краеугольным камнем стратегии роста IBM в сфере ПО, и руководство подтверждает уверенность в сохранении роста на уровне около 15 %». Выручка подразделения по автоматизации увеличилась год к году на 24 %, выручка подразделения по обработке данных и ИИ — на 8 %. Выручка от обработки транзакций снизилась на 1 % год к году. Выручка от консалтинговых услуг составила $5,3 млрд, превысив прогноз Уолл-стрит в $5,24 млрд. В сегменте инфраструктуры выручка увеличилась на 17 % до $3,56 млрд. При этом продажи мейнфреймов IBM Z выросли на 61 %. Новый мейнфрейм z17, ориентированный на ИИ, широко используется в финансовой отрасли, позволяя поддерживать строгие правила хранения и шифрования данных в процессе внедрения ИИ-технологий, сообщил агентству Reuters финансовый директор IBM Джим Кавано (Jim Kavanaugh). ИИ также внёс свой вклад в рост выручки, поскольку, как отметил Кришна, СХД являются ключевой частью ИИ-инфраструктуры, поэтому у IBM их активно покупают, пишет The Register. IBM повысила свой прогноз выручки и заявила, что теперь ожидает её роста «более чем» на 5 % по сравнению с «как минимум» 5 %, ожидавшимся ранее. Также ожидается, что свободный денежный поток за год составит $14 млрд, что выше прогноза в $13,5 млрд, сделанного в предыдущем квартале. Кришна cообщил, что IBM сотрудничает с гиперскейлерами, а также является одним из крупных клиентов CoreWeave. «Мы также часто используем инфраструктуру AWS, Azure и GCP, — сказал он. — У нас есть прекрасная возможность выполнять как консалтинговые проекты, так и развёртывать наше ПО на этих инфраструктурах для наших клиентов». Он рассказал, что один из «очень крупных клиентов в сфере медицинского страхования» предпочитает не использовать публичное облако, «но его вполне устраивает возможность использовать частные инстансы в облаке и разворачивать там модели, разворачивать там наши программные стеки и добиваться роста. Поэтому мы, как правило, так и поступаем». По мнению The Register, это свидетельствует в пользу того, что IBM не собирается закупать ускорители в больших количествах или состязаться с гиперскейлерами в объёме капвложений, предпочитая брать вычислительные мощности в аренду.

21.10.2025 [00:35], Владимир Мироненко

Ещё одна альтернатива платформам NVIDIA — IBM объединила усилия с GroqIBM и Groq объявили о стратегическом партнёрстве с целью предоставления клиентам возможностей высокоскоростного ИИ-инференса по доступной цене путём объединения watsonx Orchestrate от IBM с аппаратными решениями Groq, что позволит ускорить развёртывание агентных систем ИИ. В рамках партнёрства Groq и IBM планируют интегрировать и усовершенствовать технологию Red Hat vLLM с архитектурой LPU Groq. Ожидается, что совместное решение позволит клиентам использовать возможности watsonx Orchestrate привычным образом и с привычными инструментам в инференс-платформе GroqCloud, предоставляющей разработчикам доступ к высокоскоростной и недорогой обработке LLM. Эта интеграция позволит удовлетворить ключевые потребности разработчиков ИИ-решений, включая оркестрацию инференса, балансировку нагрузки и аппаратное ускорение, что в конечном итоге оптимизирует сам процесс инференса. Также планируется поддержка моделей IBM Granite в GroqCloud для клиентов IBM. IBM отметила, что предприятия при переводе ИИ-агентов из пилотной версии в промышленную эксплуатацию продолжают сталкиваться с проблемами обеспечения скорости, стоимости и надёжности. Партнёрство IBM и Groq позволяет объединить скорость инференса Groq, экономическую эффективность и доступ к новейшим open source моделям с оркестрацией агентского ИИ IBM, предоставляя клиентам инфраструктуру, необходимую для их масштабирования, говорит компания. IBM сообщила, что LPU обеспечивают минимум в пять раз более быстрый и экономичный инференс, чем системы на ускорителях конкурентов, имея, по всей видимости, в виду NVIDIA. Это позволяет обеспечить стабильно низкую задержку и производительность при масштабировании нагрузок, что особенно важно для ИИ-агентов в регулируемых отраслях. В качестве примера IBM привела деятельность клиентов из сферы здравоохранения, которые одновременно получают тысячи сложных вопросов пациентов. Благодаря Groq ИИ-агенты IBM смогут анализировать информацию в режиме реального времени и мгновенно предоставлять точные ответы, позволяя организациям в этой сфере принимать более оперативные и обоснованные решения. В нерегулируемых отраслях клиенты IBM с помощью платформы GroqCloud смогут ускорить работу ИИ-агентов и повысить автоматизацию кадровых процессов и производительность сотрудников. IBM объявила, что сразу же предоставит клиентам доступ к возможностям GroqCloud, а совместные с Groq команды сосредоточатся на предоставлении заказчикам IBM следующих возможностей:

Groq привлекла инвестиции в размере $1,8 млрд, включая раунд финансирования на сумму $750 млн в прошлом месяце с оценкой в $6,9 млрд. В числе её инвесторов — Cisco и Samsung. Также Groq сотрудничает с саудовской Aramco Digital. По данным WSJ, компания развернула в этом году 12 ЦОД и намерена развернуть как минимум ещё 12 в 2026 году. В 2024 году Groq сменила модель работы — с тех пор она больше не продаёт свои ИИ-ускорители, предлагая вместо этого создание ЦОД или облака. |

|