Лента новостей

|

12.03.2026 [10:05], Руслан Авдеев

NVIDIA инвестирует в Nebius $2 млрд в рамках стратегического партнёрства в сфере ИИ ЦОДNVIDIA объявила о намерении инвестировать $2 млрд в компанию Nebius Group в рамках стратегического партнёрства, предусматривающего разработку и строительство ИИ ЦОД, сообщает Bloomberg. В последние дни новости об очередных миллиардных инвестициях NVIDIA публикуются почти регулярно. В этот раз NVIDIA потратит средства на Nebius в рамках стратегического партнёрства — фактически компания нередко вкладывает средства в бизнесы, покупающие её ускорители. Базирующаяся в Амстердаме Nebius к концу 2030 года намерена внедрить более 5 ГВт систем на решениях NVIDIA; такой энергии приблизительно хватило бы для электроснабжения 3,8 млн домохозяйств. Речь идёт о сотрудничестве, касающемся полного стека ИИ-технологий — от разработки архитектуры ИИ-фабрик до взаимодействия в сфере программного обеспечения. Это позволит Nebius ускорить строительство передовой облачной платформы. Nebius активно внедряет технологии NVIDIA на глобальном уровне, включая строительство многочисленных ИИ-фабрик гигаваттного уровня в США. Чтобы Nebius смогла обеспечить более 5 ГВт к концу 2030 года, NVIDIA поддержит раннее внедрение компанией своих ИИ-ускорителей новейшего поколения.

Источник изображения: NVIDIA В рамках партнёрства предусмотрено несколько векторов взаимодействия:

NVIDIA нередко использует свои, почти неисчерпаемые финансовые ресурсы для финансирования расширения ИИ-инфраструктуры на своих чипах. Это уже вызвало критику экспертов, допускающих, что такие циркулярные инвестиции способствуют возникновению пузыря на рынке ИИ. В январе 2026 года NVIDIA анонсировала вложение $2 млрд в конкурента Nebius — компанию CoreWeave для внедрения своих продуктов, а совсем недавно NVIDIA поддержала развёртывание 1 ГВт мощностей стартапом Thinking Machines Lab. Неооблачный провайдер Nebius появился после раскола «Яндекса» и продажи его российской части бизнеса в 2024 году за $5,2 млрд российским покупателям. В конце того же года Nebius привлекла $700 млн от группы инвесторов, включавшей NVIDIA. По состоянию на конец 2024 года NVIDIA владела акциями компании на сумму $33 млн. Совсем недавно IT-гигант выделил ещё $4 млрд на связанные с ИИ проекты. NVIDIA инвестировала по $2 млрд в поставщиков лазеров и фотоники для ИИ ЦОД — компании Lumentum и Coherent.

12.03.2026 [09:13], Сергей Карасёв

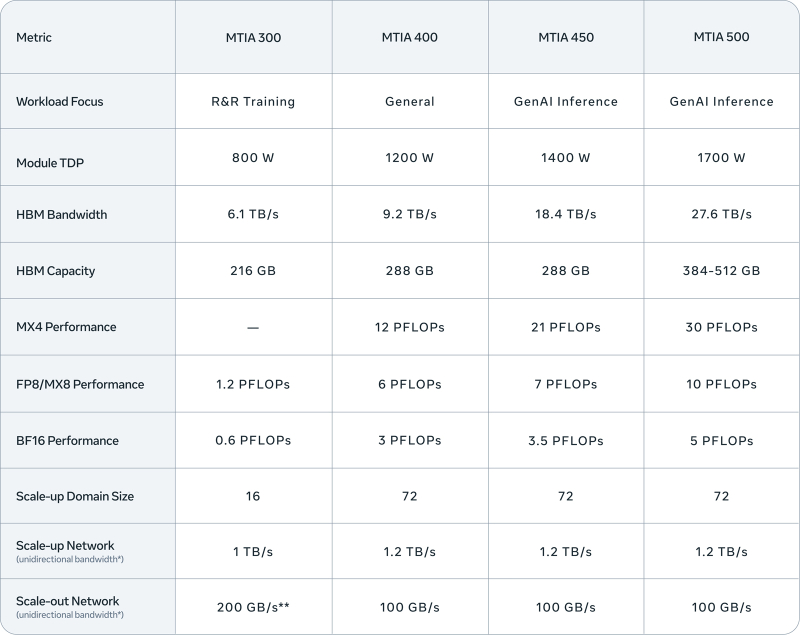

Meta✴ представила четыре новых ИИ-ускорителя MTIA — с FP8-производительностью до 10 ПфлопсКомпания Meta✴ анонсировала ИИ-ускорители MTIA (Meta✴ Training and Inference Accelerator) сразу четырёх новых поколений. Это решения MTIA 300, 400, 450 и 500: внедрение некоторых из них уже началось, тогда как развёртывание других запланировано на текущий и следующий годы. Устройства ориентированы на различные ИИ-нагрузки, включая инференс и генеративные сервисы. ИИ-процессор MTIA первого поколения (MTIA 100), напомним, дебютировал в 2023 году: изделие получило в общей сложности 128 ядер RISC-V и 128 Мбайт памяти SRAM. В 2024-м вышло решение второго поколения MTIA 200 с повышенной производительностью. В каждом из четырёх новых продуктов, по заявлениям Meta✴, упор сделан на улучшении вычислительных характеристик, пропускной способности памяти и эффективности.

Источник изображений: Meta✴ Конструкция ускорителя MTIA 300 включает один вычислительный чиплет, два сетевых чиплета (NIC) и несколько стеков HBM. Каждый вычислительный чиплет состоит из матрицы процессорных элементов (PE), содержащих по два векторных ядра RISC-V. Объём памяти HBM составляет 216 Гбайт, её пропускная способность — 6,1 Тбайт/с. Заявленная ИИ-производительность в режимах FP8/МХ8 достигает 1,2 Пфлопс. Показатель TDP равен 800 Вт. Реализован движок DMA для взаимодействия с локальной памятью. Ускоритель, уже применяющийся в дата-центрах Meta✴, оптимизирован для задач обучения по принципу Rephrase and Respond (R&R). Ступенью выше располагается решение MTIA 400 общего назначения. Оно объединяет два вычислительных чиплета, а объём памяти HBM увеличен до 288 Гбайт (пропускная способность — 9,2 Тбайт/с). У этого ускорителя быстродействие на операциях FP8/МХ8 составляет до 6 Пфлопс. Величина TDP равна 1200 Вт. Стойка с 72 ускорителями MTIA 400, соединёнными через коммутируемую объединительную плату, образует единый масштабируемый домен. При этом может использоваться жидкостное охлаждение с воздушной поддержкой или полностью жидкостное охлаждение. На сегодняшний день Meta✴ завершила тестирование MTIA 400 и находится на этапе внедрения изделий. Вариант MTIA 450, в свою очередь, ориентирован на задачи инференса в сфере генеративного ИИ. Этот ускоритель также использует 288 Гбайт памяти HBM, но её пропускная способность достигает 18,4 Тбайт/с. Значение TDP подросло до 1400 Вт. Решение обеспечивает ИИ-производительность в режимах FP8/МХ8 до 7 Пфлопс, в режиме МХ4 — 21 Пфлопс. MTIA 450 также поддерживает смешанные вычисления с низкой точностью без дополнительного программного преобразования данных. Внедрение устройства в ЦОД Meta✴ намечено на начало 2027 года. Наконец, самый мощный из готовящихся ускорителей — MTIA 500 — также рассчитан на инференс в сфере генеративного ИИ. Используется конфигурация вычислительных чиплетов 2 × 2, окруженных несколькими стеками HBM и двумя сетевыми чиплетами. Это устройство может использовать от 384 до 512 Гбайт памяти HBM с пропускной способностью до 27,6 Тбайт/с. Показатель TDP достигает 1700 Вт. Заявленная производительность FP8/МХ8 — до 10 Пфлопс, МХ4 — до 30 Пфлопс. Массовое внедрение MTIA 500 запланировано на 2027 год. На системном уровне MTIA 400, 450 и 500 используют одно и то же шасси, стойку и сетевую инфраструктуру. Это обеспечивает возможность модернизации с минимальными затратами при переходе на изделия следующего поколения.

12.03.2026 [09:00], Сергей Карасёв

«Эксперт РА» перешло на ПО для управления динамической ИТ-инфраструктурой от «Базиса»Крупнейшее в России кредитное рейтинговое агентство «Эксперт РА» сообщило о переходе на отечественную платформу виртуализации рабочих мест и терминального доступа Basis Workplace и программно-определяемую СХД Basis SDS — решения лидера российского рынка ПО для управления динамической ИТ-инфраструктурой «Базис». Внедрение проводилось авторизованным партнёром — системным интегратором «КИТ-Системс». Основные сценарии использования флагманской платформы вендора охватывают удалённый доступ сотрудников к внутренней инфраструктуре и создание изолированных сред с повышенными требованиями к информационной безопасности. Basis Workplace позволяет использовать серверные мощности командам, которые работают на портативных устройствах, в том числе ноутбуках и планшетах. Ещё одно значимое преимущество — возможность автоматизировать жизненный цикл виртуальных сред. Система горизонтально масштабируется и устойчива к высоким нагрузкам, возможна реализация геораспределённой инсталляции для упрощения построения катастрофоустойчивых решений. При выборе платформы учитывались такие параметры, как рыночная доля вендора, зрелость решений, наличие успешных внедрений, стоимость и поддержка гиперконвергентных сценариев. В процессе эксплуатации Basis Workplace подтвердила стабильность, функциональность и соответствие требованиям к защите данных. Администрирование продукта осуществляется собственной ИТ-службой «Эксперт РА». Для обеспечения качественной эксплуатации специалисты прошли обучающий курс по работе с платформой, разработанный «Базисом» для системных администраторов. «Решение "Эксперт РА" перейти на отечественные разработки при отсутствии срочных регуляторных требований — сильный и показательный шаг. Это стратегическое решение — не про замену компонентов, а про контроль над критической инфраструктурой в долгосрочной перспективе», — подчеркнул Иван Ермаков, коммерческий директор «Базиса». «Для нас ключевым фактором было понимание того, кто стоит за продуктом. Мы не искали решения с неопределённой судьбой в открытом сообществе, а выбрали вендора с проприетарными разработками, прозрачной дорожной картой и полной ответственностью за развитие своих решений. И Basis Workplace, и Basis SDS соответствуют нашим требованиям к безопасности и устойчивости», — сообщил Денис Казанцев, директор по информационным сервисам и инфраструктуре «Эксперт РА». «Внедрение VDI способствует развитию в Агентстве гибкой ИТ-среды, где высокий уровень управляемости и простота эксплуатации оказывают позитивное влияние на непрерывность операционных процессов, что даёт бизнесу устойчивость при росте и адаптации к новым задачам», — отметил Алексей Милушин, директор по цифровой трансформации «Эксперт РА». «Эксперт РА» — старейшее и крупнейшее кредитное рейтинговое агентство в России, с 1997 года специализирующееся на оценке кредитоспособности, устойчивости и надёжности финансовых институтов, корпоративного сектора и органов власти. «Эксперт РА» включено в реестр кредитных рейтинговых агентств Банка России. Рейтинги «Эксперт РА» входят в перечни официальных требований к банкам, страховщикам, пенсионным фондам, эмитентам. Реклама | ООО "БАЗИС" ИНН 7731316059 erid: F7NfYUJCUneTVSpZ8JvU

11.03.2026 [15:30], Руслан Авдеев

В жаркие дни ИИ ЦОД способны потреблять воды как весь Нью-Йорк за деньДаже если среднегодовое потребление воды дата-центрами США будет относительно скромным, в самые жаркие дни оно окажется огромным. Для модернизации американской системы водоснабжения в соответствии с запросами в такие периоды потребуются миллиардные инвестиции, сообщает The Register. Исследование на соответствующую тему провели учёные Калифорнийского университета в Риверсайде. Результаты показали, что вода эффективно охлаждает ИИ-оборудование, но растущий спрос на неё приведёт к огромным расходам этого ресурса в отдельные дни — и современные системы водоснабжения не способны удовлетворить потребности, особенно в жаркую погоду. Без внедрения новых технологий к 2030 году дополнительно может потребоваться 2,6–5,49 млн м³ воды в дни пикового спроса. Для сравнения: Нью-Йорк за сутки потребляет около 3,8 млн м³. Даже при самых оптимистичных сценариях внедрения новых технологий, сокращающих водопотребление ЦОД, новые мощности могут тратить половину объёма водоснабжения Нью-Йорка в течение значительной части года.

Источник изображения: Matteo Catanese/unsplash.com В исследовании подчеркнули, что охлаждение ЦОД обычно происходит в два этапа. Во-первых, охлаждение на уровне серверов, когда тепло передаётся в промежуточный теплообменник на уровне объекта с помощью воздушного или жидкостного охлаждения (замкнутого контура). В обоих случаях вода обычно не расходуется. Второй этап — охлаждение на уровне объекта. Тепло передаётся во внешнюю среду, при этом не исключено потребление воды, в том числе в градирнях, функционирующих за счёт испарения. Используются и другие системы охлаждения. При этом крупный комплекс ЦОД с испарительным охлаждением использует тысячи кубометров воды ежедневно, особенно в самые жаркие дни года. Впрочем, часть воды может «возвращаться» в систему охлаждения. Тем не менее объёмы воды, забираемые ЦОД, становятся недоступны другим пользователям, поэтому с проблемами столкнутся уже другие потребители. Согласно отчёту, в США около 50 тыс. коммунальных систем водоснабжения. Из них около 40 тыс. — небольшие, обслуживающие не более 3,3 тыс. человек; около 9 тыс. — среднего размера; и лишь 708 — крупные, обслуживающие более 100 тыс. человек. Практически все ЦОД гиперскейлеров снабжаются водой из централизованных систем (в основном питьевой), и лишь немногие организовали снабжение из частных подземных источников. По расчётам учёных, в зависимости от климата и особенностей систем охлаждения IT-нагрузка в 100 МВт требует 1892–9463 м³ воды в день. При этом по всей Америке планируется развёртывание дата-центров гигаваттного масштаба. С учётом резерва надёжности многим публичным системам водоснабжения будет сложно обеспечить потребности даже 100-МВт систем, не говоря об объектах гигантского масштаба. Фактически, по данным учёных, многие проекты ЦОД требовали существенной модернизации местной инфраструктуры водоснабжения даже тогда, когда пиковый спрос на воду составлял около 378 м³ в сутки. В целом исследователи пришли к выводу, что американским ЦОД потребуется дополнительно от 2,3 до 5,5 млн м³ воды ежесуточно. На модернизацию понадобится около $58 млрд — объёмы сопоставимы с суточным водопотреблением Нью-Йорка.

Источник изображения: Pawel Czerwinski/unsplash.com Операторам дата-центров рекомендуется обнародовать информацию о пиковом потреблении воды, а не только средние показатели за год. Кроме того, они могли бы взаимодействовать с местными сообществами для финансирования модернизации локальной инфраструктуры водоснабжения, а также наладить контакты с коммунальными предприятиями, корректируя методы охлаждения. Например, при перегрузке электросетей можно было бы использовать водяное охлаждение, а при перегрузке системы водоснабжения — воздушное. Правда, можно предположить, что основная проблема возникнет именно в жаркие дни, когда обе системы будут использоваться по максимуму. В декабре 2025 года появились данные о том, почему ЦОД никак не могут «напиться». В некоторых регионах не хватает даже воды для питья. Эксперты предлагают операторам дата-центров вкладывать средства в опреснительные установки, сети распределения воды, локальные очистные сооружения и другие решения для более широкого использования испарительных охладителей. По некоторым расчётам, опреснение и транспортировка воды с морского побережья пока эффективнее, чем отказ от испарительных систем — даже с доставкой не по трубопроводам, а в цистернах. Впрочем, Microsoft готовит дата-центры с почти нулевым расходом воды, а ранее экспериментировала со сбором дождевой . AWS обещала перевести ещё 100 дата-центров на использование очищенных сточных вод для охлаждения. В феврале власти США призвали операторов — Microsoft, Google, Amazon, Meta✴ и OpenAI — добровольно заключить соглашение, устанавливающее принципы ответственного потребления электроэнергии, воды и взаимодействия с жителями в местах размещения дата-центров.

11.03.2026 [13:07], Руслан Авдеев

Эскалация конфликта на Ближнем Востоке угрожает буму ИИ ЦОД в регионеРасширение конфликта на Ближнем Востоке начало негативно сказываться на мировой индустрии дата-центров. Под вопросом оказалась безопасность проектов, поддерживаемых странами Персидского залива, а также надёжность облачной инфраструктуры региона в целом. Ожидалось, что страны залива инвестируют в ЦОД, чипы и прочую ИИ-инфраструктуру более $300 млрд, но недавние атаки на ЦОД AWS показали, что такие проекты весьма уязвимы, сообщает DigiTimes. Атаки беспилотников показали, что безопасность ИИ-инфраструктуры становится всё более связанной с геополитикой. По имеющимся данным, от ударов пострадали две зоны доступности в ОАЭ и одна в Бахрейне. Это сказалось на работе нескольких сервисов AWS в регионе и усилило опасения относительно безопасности реализуемых в странах Персидского залива проектов. Сбои также частично повлияли на работу повседневных сервисов в некоторых частях ОАЭ: жители не могли получить доступ к банковским услугам, заказать доставку еды и воспользоваться сервисами заказа такси. Это вызывает обеспокоенность многих экспертов, поскольку страны региона в последние годы позиционировались как важный центр для ИИ-инвестиций. Саудовская Аравия, ОАЭ, Кувейт и Катар активно инвестировали в землю, энергетику, чипы и разработку ИИ-моделей на местных диалектах; одним из ключевых и самых дорогих компонентов стали ИИ-ускорители NVIDIA. Не так давно Саудовская Аравия озвучила планы инвестировать в полупроводники в краткосрочной перспективе $50 млрд, а ОАЭ только до конца следующего года рассчитывали потратить более $30 млрд на ускорители NVIDIA. Тем не менее дальнейшие инвестиции зависят как от финансовых возможностей местных властей, так и от их способности обеспечить безопасность дата-центров.

Источник изображения: Zaid Ahmad/unsplash.com Вероятно, крупнейший в регионе инфраструктурный ИИ-проект реализуют ОАЭ: кампус ЦОД площадью более 25 км2 должен потреблять 5 ГВт электроэнергии. Активное участие в нём принимают OpenAI и Oracle, расширяющие Stargate за пределы США. Тем временем Саудовская Аравия планирует построить дата-центры, потребляющие до 6,6 ГВт электроэнергии к 2034 году, а xAI взаимодействует с Humain для строительства объекта, который будет потреблять около 500 МВт. Humain заявляла, что компания располагает более 200 участком земли в Саудовской Аравии и полагается на «географическое разнообразие» и многочисленные оптоволоконные маршруты для снижения риска сбоев сервисов. Впрочем, эксперты уверены, что правительства и инвесторы всё равно пересмотрят инфраструктурную стратегию в регионе. IDC утверждает, что траты на ИИ в Персидском заливе продолжатся и в краткосрочной перспективе, но предупреждает, что если конфликт продлится несколько месяцев, это может привести к «разрушительной паузе» в случае с некоторыми инвестициями. Эксперты по безопасности также предполагают, что крупные ИИ-ЦОД в регионе могут в конечном счёте потребовать защиты, в том числе с помощью ракетных систем. В то же время ИИ играет огромную роль и в «оркестрации» самого конфликта. По данным The Wall Street Journal, США и Израиль используют ИИ-инструменты для сбора разведывательной информации, идентификации целей, планирования бомбардировок и оценки урона на поле боя — с помощью искусственного интеллекта это можно делать гораздо быстрее, чем в прошлом. Также технология используется для процессов, не связанных напрямую с боевыми действиями, — анализа разведданных, организации логистики и планирования миссий в целом.

Источник изображения: luke fancher/unspalsh.com По данным DigiTimes, израильские разведывательные ведомства всё больше полагаются на ИИ для анализа больших объёмов материалов видеонаблюдения и данных переговоров. Расширяет использование ИИ-систем для военных целей и Пентагон. При этом военные отмечают, что обучение специализированного «военного» ИИ — довольно сложная задача, поскольку данные для обучения в значительной части устаревшие или неполные. В любом случае рост эффективности благодаря ИИ может оказаться значительным. По данным американских учёных, 18-й воздушно-десантный корпус армии США использовал ПО Palantir для выбора целей с участием всего 20 человек — для сравнения, в ходе последней кампании в Ираке США привлекли к аналогичным операциям более 2 тыс. военных. Совокупность этих факторов позволяет оценить растущее влияние ИИ на современные войны и инфраструктуру, поддерживающую глобальные ИИ-проекты. Другими словами, рост амбиций стран Персидского залива теперь тесно связан с геополитическими процессами. Ранее эксперты уже прогнозировали, что атака БПЛА на ближневосточные дата-центры AWS заставит пересмотреть подход к отказоустойчивости облаков. Помимо военной защиты (как предсказывал в своё время Эрик Шмидт), возможно, потребуется пересмотреть саму архитектуру инфраструктуры — например, проекты с близким размещением дата-центров в одном кампусе для современных условий могут оказаться не слишком пригодными. Также не исключено, что гораздо более востребованными станут и подземные дата-центры, нередко расположенные в бывших бункерах, оставшихся с прошлых конфликтов, или в шахтах и рудниках. Как минимум несколько проектов есть в США и Европе (Швеции, Германии, России и др.), а в Израиле подземные ЦОД строят с нуля.

11.03.2026 [11:20], Владимир Мироненко

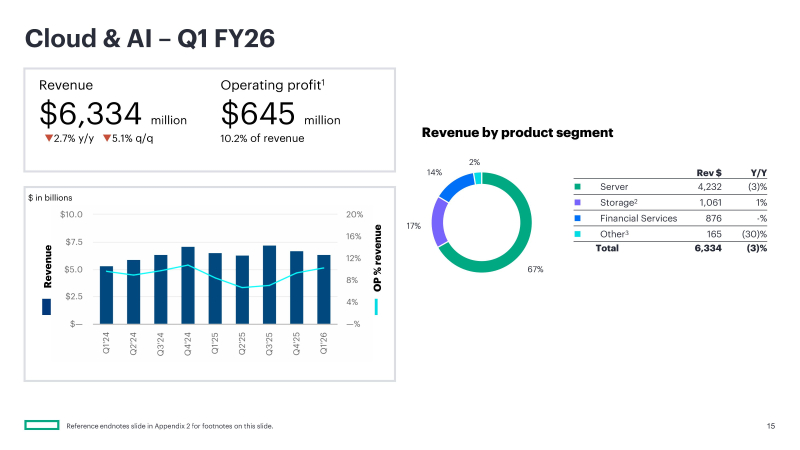

Спрос на сетевые решения для ИИ обеспечил HPE один из самых прибыльных кварталовКомпания HPE объявила финансовые результаты за I квартал 2026 финансового года, закончившийся 31 января 2026 года. Показатели в основном превзошли ожидания аналитиков благодаря растущему спросу на сетевые решения для ИИ, отметил ресурс Datacenterknowledge.com. Выручка компании выросла год к году на 18 % — до $9,30 млрд, что немного ниже консенсус-прогноза аналитиков, опрошенных LSEG, в размере $9,33 млрд (по данным Reuters). Скорректированная прибыль (non-GAAP) на разводнённую акцию в размере $0,65 превысила прогноз Уолл-стрит в $0,59. Чистая прибыль (GAAP) составила $423 млн и $0,31 на разводнённую акцию, что ниже показателей годом ранее — $598 млн и $0,44, но выше собственного прогноза компании. Антонио Нери (Antonio Neri), президент и генеральный директор HPE, заявил, что это был один из самых прибыльных кварталов за всю историю компании. «Высокий спрос, разумное управление затратами и более быстрая, чем планировалось, синергия Juniper и Catalyst способствовали нашим результатам», — сообщила финансовый директор Мари Майерс (Marie Myers). Выручка нового сегмента HPE «Облачные технологии и ИИ», объединяющего бизнес HPE в области серверов, хранения данных и финансовых услуг, составила $6,3 млрд, что на 2,7 % меньше, чем за аналогичный период прошлого года, при этом маржа операционной прибыли составила 10,2 % против 8,4 % годом ранее. В том числе выручка от продаж серверов составила $4,2 млрд (снижение год к году на 2,7 %), продажи СХД — $1,1 млрд (рост на 0,6 %), выручка от финансовых услуг — $0,9 млрд (рост на 0,3 %). Выручка сегмента «Сетевое оборудование», который включает бывший сегмент «Интеллектуальная периферия» и Juniper Networks, составила $2,7 млрд, что на 151,5 % больше, чем за аналогичный период прошлого года. В том числе выручка от кампусных и филиальных сетей (Campus & Branch) достигла $1,2 млрд (рост на 42 % год к году). Продажи сетевого оборудования для ЦОД принесли $444 млн (рост на 382,6 %) благодаря увеличению спроса на высокопроизводительные сети, используемые в ИИ-кластерах. Продукты безопасности принесли $255 млн выручки, что на 114 % больше год к году, а направление маршрутизации — $780 млн по сравнению с $1 млн в аналогичном периоде прошлого года, что отражает добавление портфеля маршрутизации Juniper. Операционная маржа сегмента составила 23,7 %, что ниже, чем в прошлом году (29,7 %), в основном из-за затрат на интеграцию и изменений в ассортименте продукции. Выручка от корпоративных инвестиций и прочих услуг составила $261 млн, что на 2,2 % меньше, чем за аналогичный период прошлого года, при этом маржа операционной прибыли составила −4,6 % по сравнению с −3,0 % годом ранее. В этот сегмент входят консультационные и профессиональные услуги, а также результаты деятельности лаборатории Hewlett Packard. В него также в 2026 финансовом году были включены телекоммуникационный бизнес и Instant On. HPE сообщила, что её портфель заказов на ИИ-решения превысил $5 млрд, при этом на корпоративных и государственных клиентов приходится 64 % от общего объёма заказов. В текущем финансовом квартале компания ожидает, что квартальная выручка составит от $9,6 до $10,0 млрд, что выше средней оценки аналитиков, опрошенных LSEG, в $9,58 млрд. HPE повысила свой прогноз по скорректированной прибыли на акцию (non-GAAP) на 2026 финансовый год до $2,30–$2,50 по сравнению с предыдущим прогнозом в $2,25–$2,45. Также компания повысила прогноз по годовому росту выручки в сегменте сетевого оборудования до 68–73 %. Акции компании выросли примерно на 1,3 % на дополнительных торгах после публикации финансовых результатов. Вместе с тем с начала года акции HPE упали примерно на 9 %, в то время как у конкурента, компании Dell, был зафиксирован рост на 16,4 %.

11.03.2026 [10:54], Руслан Авдеев

Alibaba Cloud ускорит строительство шанхайского ИИ ЦОД с собственными ускорителями ZhenwuAlibaba Cloud прилагает усилия, чтобы ускорить строительство ранее запланированного дата-центра в Шанхае. Китайский облачный гигант объявил о подписании соглашения с властями района Цзиньшань городского подчинения, предусматривающего строительство в городе дата-центра для использования ИИ-чипов собственной разработки, сообщает Datacenter Dynamics. Речь идёт о части проекта Aspara Cloud Intelligent East China Computing Center. По данным Alibaba, новый ЦОД будет одним из крупнейших «умных вычислительных хабов» в Восточном Китае. Оборудование будет построено на ИИ-ускорителях Zhenwu, который разработаны подразделением Alibaba T-Head. Новейшей моделью является чип Zhenwu 810E, имеющий 96 Гбайт памяти HBM2e. Она разработана для обучения ИИ и инференса и полностью работает с ПО собственной разработки. Alibaba и Цзиньшань взаимодействуют довольно давно, в 2021 году они совместно запустили вычислительный центр с инвестициями порядка ¥40 млрд ($5,8 млрд). Согласно новому договору, Alibaba Cloud построит вычислительный объект, который станет образцом для создания «зелёных» ЦОД. Предусмотрена полная независимость от сторонних технологий, включая использование чипов и вычислительных платформ собственной разработки, а также программного обеспечения.

Источник изображения: Henry Chen/unsplash.com У Alibaba Cloud уже имеются «умные вычислительные хабы» в Чжанбэе и Уланчабе, которые компания рассчитывает объединить для создания национальной сети вычислений. Китайский облачный провайдер сегодня оперирует более чем 94 зонами доступности в 29 регионах. Ранее в 2026 году компания заявила, что рассматривает возможность увеличить капитальные расходы на ИИ-инфраструктуру до ¥480 млрд ($69,05 млрд) в следующие три года; в начале 2025 года речь шла о ¥380 млрд ($52,4 млрд). Согласно данным Omdia, в Китае Alibaba контролирует более трети локального рынка ИИ-облаков. По информации гонконгского издания SCMP, в распоряжении Alibaba Cloud было 35,8 % соответствующих мощностей. Второе место занимала Volcano Engine (фактически ByteDance) с 14,8 %. Впрочем, имеются и другие данные. По информации Frost & Sullivan, среди китайских облачных провайдеров, контролирующих всю цепочку создания стоимости «от чипа до облака», лидерами являются Huawei и Baidu. В январе 2026 года сообщалось, что Alibaba Group запустила совместное предприятие с государственной компанией China National Nuclear Company (CNNC), занимающейся реализацией атомных проектов. Проект оценивается в ¥250 млн ($35,9 млн) и, возможно, поможет обеспечивать мощности IT-гиганта энергией, хотя реальный масштаб сотрудничества пока не раскрывается.

11.03.2026 [09:39], Руслан Авдеев

Thinking Machines Lab развернёт 1 ГВт мощностей на основе Vera Rubin при поддержке NVIDIANVIDIA заключила соглашение с Thinking Machines Lab о развёртывании оборудования на основе ускорителей Vera Rubin мощностью не менее 1 ГВт. Проект будет реализован для поддержки обучения передовых моделей стартапа, сообщает Datacenter Dynamics. Глава NVIDIA Дженсен Хуанга (Jensen Huang) заявил, что ИИ — мощнейший инструмент познания в истории человечества, и компания рада сотрудничать с Thinking Machines для воплощения в жизнь захватывающего видения будущего ИИ, предложенного стартапом. NVIDIA также добавила, что вложила в Thinking Machines значительные средства. Кроме того, в рамках партнёрства компании намерены совместно разрабатывать системы обучения, оптимизированные для архитектуры NVIDIA, а также расширять доступ к передовым ИИ-моделям. Где и когда будет развёрнуто оборудование, объявят позже; финансовые подробности сделки также пока не раскрываются. NVIDIA сообщила, что развёртывание оборудования на основе Vera Rubin планируется в начале 2027 года.

Источник изображения: NVIDIA Thinking Machines, основанная в феврале 2025 года бывшим техническим директором OpenAI Мирой Мурати (Mira Murati), по данным самой компании, разрабатывает «мультимодальные системы, работающие совместно с людьми» — в противовес полностью автономным ИИ-системам, над которыми работают другие ИИ-компании. В октябре 2025 года Thinking Machines анонсировала так называемый API Tinker — он разработан для упрощения тонкой настройки open source-моделей. По данным Reuters, на июль 2025 года компания привлекла $2 млрд инвестиций от NVIDIA, AMD, Cisco и других инвесторов; её капитализация составляла $12 млрд. Впрочем, не всё идёт гладко: в январе она лишилась двух соучредителей, которые предпочли вернуться в OpenAI. При этом NVIDIA активно инвестирует и в OpenAI — недавно стороны договорились о вложении в последнюю $30 млрд в обмен на её акции.

11.03.2026 [09:25], Сергей Карасёв

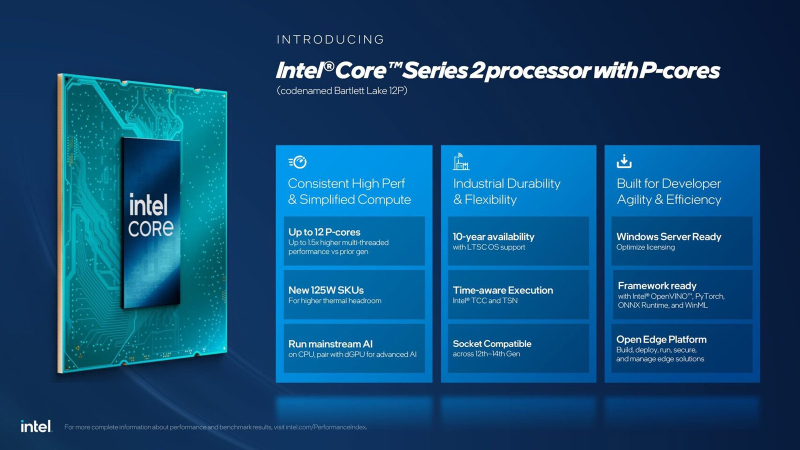

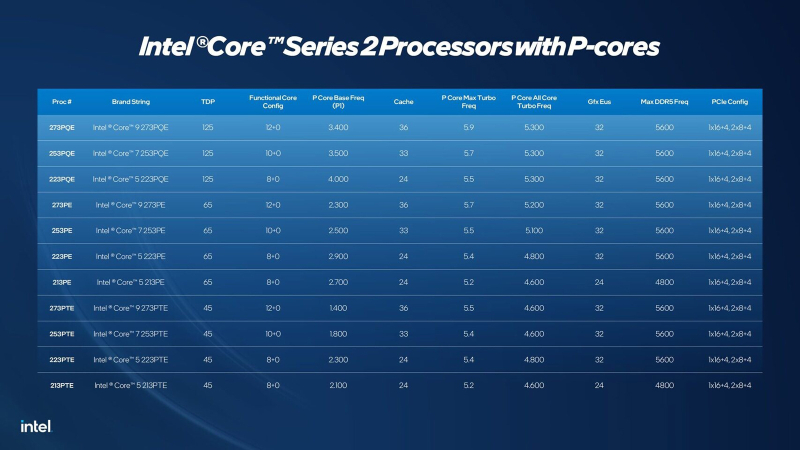

Intel выпустила Bartlett Lake — LGA 1700-процессоры исключительно на P-ядрах Raptor Cove для периферийных системКорпорация Intel в ходе конференции Embedded World 2026, которая с 10 по 12 марта проходит в Нюрнберге (Германия), анонсировала процессоры Core Series 2 семейства Bartlett Lake, рассчитанные на использование в критически важных периферийных системах и промышленном оборудовании. Представленные чипы используют исключительно производительные Р-ядра, количество которых варьируется от 8 до 12 (с возможностью обработки до 24 потоков инструкций). Показатель TDP в зависимости от модификации составляет 45, 65 или 125 Вт. На сегодняшний день в семейство Core Series 2 входят 11 процессоров (см. технические характеристики ниже). Их базовая тактовая частота варьируется от 1,4 до 3,5 ГГц, максимальная частота — от 5,2 до 5,9 ГГц (в турбо-режиме). Объём кеша — от 24 до 36 Мбайт. Чипы могут использовать до 192 Гбайт оперативной памяти DDR5-5600 или DDR4-3200 с поддержкой ECC. В состав изделий входит ускоритель UHD Graphics 770; возможен вывод изображения одновременно на четыре дисплея (вплоть до 4К). Процессоры предлагают до 20 линий PCIe (16 × PCIe 5.0 и 4 × PCIe 4.0). Упомянута поддержка высокоскоростной шины DMI 4.0 (Direct Media Interface 4.0). Кроме того, говорится о совместимости с чипами Core 12-го, 13-го и 14-го поколений для периферийных устройств, что должно упростить модернизацию существующих встраиваемых систем на базе LGA1700. По заявлениям Intel, процессоры Core Series 2 обеспечивают прирост производительности до 1,8 раза (TOPS) по сравнению с решениями предыдущего поколения. Новые чипы оптимизированы для работы с операционными системами реального времени (RTOS). Сопутствующий чипсет Intel PCH обеспечивает поддержку до 12 линий PCIe 4.0 и до 16 линий PCIe 3.0, Wi-Fi 7 и Bluetooth 5.4, 2.5GbE и пр.

10.03.2026 [17:49], Владимир Мироненко

Groq увеличил заказ на производство ИИ-чипов у Samsung более чем в 1,5 разаИИ-стартап Groq, приобретённый NVIDIA за $20 млрд, направил Samsung Electronics запрос на увеличение производства своих чипов, сообщил Chosunbiz со ссылкой на информированные источники. Источники утверждают, что Groq недавно принял решение увеличить производство ИИ-чипов, которое в прошлом году было передано на аутсорсинг подразделению Samsung Electronics, с примерно 9 тыс. пластин до примерно 15 тыс. Если в прошлом году объём производства был ограничен изготовлением опытных образцов чипов для определения их эффективности при использовании для ИИ-инференса, то в этом году, судя по объёму, Groq находится на ранней стадии массового производства для выхода на коммерческие рельсы. Как отметил Chosunbiz, хотя объём поставок Groq для Samsung Electronics невелик, подразделение Samsung Electronics активно работает с потенциальными клиентами, чтобы заложить основу для получения крупных заказов на поставку ИИ-чипов. Помимо Groq, подразделение Samsung Electronics также производит весь ассортимент процессоров для HyperExcel — южнокорейского стартапа по разработке чипов для ИИ-инференса. Samsung Electronics производит ИИ-чипы для Groq и HyperExcel по 4-нм техпроцессу. По словам источника в полупроводниковой отрасли, «4-нм техпроцесс, используемый Samsung Electronics для массового производства чипов Groq для ИИ-нагрузок, включает ряд улучшенных процессов для повышения производительности чипа. Учитывая высокую стоимость процесса и самый высокий спрос в отрасли на 4–5-нм техпроцессы, это также имеет важное значение для обеспечения конкурентного преимущества перед TSMC». Собеседник ресурса Chosunbiz прогнозирует, что с учётом выхода NVIDIA на рынок ИИ-чипов и увеличения производства Groq ожидается бурный рост рынка чипов для ИИ-инференса. Ожидается, что на мероприятии GTC 2026 NVIDIA представит чип для ИИ-инференса на основе дизайна, разработанного Groq, в котором используется память SRAM вместо HBM. Как сообщают источники, одним из заказчиков нового чипа будет OpenAI. |

|