Материалы по тегу: ethernet

|

10.02.2026 [12:09], Сергей Карасёв

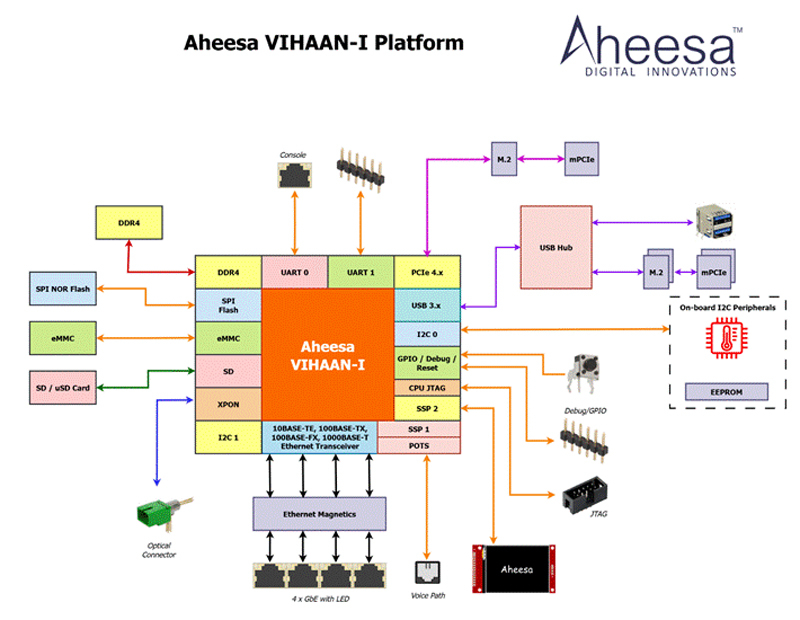

Стартап Aheesa создал первый в Индии чип RISC-V для PON-сетейИндийский безфабричный стартап Aheesa Digital Innovations, по сообщению EE Times, завершил разработку первой в стране «системы на чипе» (SoC) с архитектурой RISC-V, ориентированной на волоконно-оптические сети широкополосного доступа в интернет. Изделие получило обозначение VIHAAN-I. Новинка предназначена для инфраструктур GPON (Gigabit Passive Optical Network) и EPON (Ethernet Passive Optical Network). Решение объединяет на одном кристалле вычислительные ресурсы, средства управления и широкополосного доступа. VIHAAN-I является частью платформы Aheesa Seshnag. В состав новинки входит RISC-V-ядро C-DAC Vega. Реализована поддержка памяти DDR4 и SPI NOR, флеш-карт SD и microSD, а также интерфейса xPON. Заявлена совместимость с Ethernet-стандартами 10BASE-TE, 100BASE-TX, 100BASE-FX и 1000BASE-T. Изделие объединяет многопортовый гигабитный Ethernet и прямое оптоволоконное соединение. Среди прочего упомянуты интерфейсы USB и PCIe (четыре линии) с возможностью использование модулей M.2 и mini-PCIe. Кроме того, предусмотрена интегрированная поддержка голосовой связи. SoC будет производиться на предприятии UMC с применением 28-нм технологии.

Источник изображения: Aheesa Digital Innovations / EE Times Выбор архитектуры RISC-V, как заявляет Aheesa Digital Innovations, обусловлен прежде всего соображениями безопасности. Поддерживаются стандартные сетевые функции, такие как коммутация Ethernet, маршрутизация, службы межсетевого экрана, VPN, протокол динамической конфигурации хоста и пр. Примерно на 60% решение состоит из стандартных лицензированных компонентов, таких как контроллеры памяти и интерфейсные блоки. Заявлена совместимость с последними версиями ядра Linux. Aheesa Digital Innovations основана в 2021 году Шридхараном Мани (Sridharan Mani), который занимает пост генерального директора. Компания получила поддержку в рамках индийской программы стимулирования разработок. Стартап сотрудничает с рядом государственных учреждений, включая Министерство электроники и информационных технологий (MEITy) и Центр развития передовых вычислительных технологий (C-DAC). Aheesa Digital Innovations намерена предлагать свои решения OEM- и ODM-производителям, системным интеграторам и дистрибьюторам, которые поставляют устройства телекоммуникационным операторам. В дальнейшем стартап планирует активно развивать семейство собственных SoC. В частности, готовятся решения с поддержкой 10GbE и Wi-Fi 7.

06.02.2026 [11:30], Сергей Карасёв

102,4 Тбит/с и СЖО: Aria Networks представила коммутаторы на платформе Broadcom Tomahawk 6 для ИИ-инфраструктурСтартап Aria Networks, базирующийся в Санта-Кларе (Калифорния, США), вышел из скрытого режима, анонсировав высокопроизводительные коммутаторы для крупномасштабных кластеров ИИ. В основу устройств положена аппаратная платформа Broadcom Tomahawk 6 (TH6). В новое семейство вошли три модели: Aria Tomahawk 6 (High Radix), Aria Tomahawk 6 (Liquid) и Aria Tomahawk 6 (Air). Все они обеспечивают суммарную коммутационную способность до 102,4 Тбит/с. Разработчик заявляет, что устройства могут применяться в составе ИИ-платформ с любыми типами ускорителей, будь то GPU NVIDIA и AMD, тензорные чипы или специализированные решения вроде Cerebras.

Источник изображения: Aria Networks Модель Aria Tomahawk 6 (Air) выполнена в форм-факторе 4U и оборудована воздушным охлаждением. Задействованы 512 блоков SerDes 200G. Коммутатор располагает 64 портами с пропускной способностью 1,6 Тбит/с каждый. Модификация Aria Tomahawk 6 (Liquid) имеет аналогичные технические характеристики, но заключена в 2U-корпус с жидкостным охлаждением. Наконец, вариант Aria Tomahawk 6 (High Radix) типоразмера 4U использует 1024 блока SerDes 100G. Устройство оборудовано 128 портами 800GbE; применяется воздушное охлаждение. На базе этого коммутатора могут формироваться кластеры с простой двухуровневой топологией, насчитывающие до 32 тыс. ИИ-ускорителей. Компания Aria Networks основана Мансуром Карамом (Mansour Karam), учредителем фирмы Apstra, которую в 2019 году приобрёл американский производитель сетевого оборудования Juniper Networks. Стартап Aria Networks фокусируется на разработке высокопроизводительных решений, сочетающих возможности стандартного Ethernet со специализированным программным уровнем, позволяющим управлять большим количеством модульных коммутаторов как единой системой. Утверждается, что этот унифицированный программный слой оптимизирует производительность и гарантирует надёжность инфраструктуры. Для эффективного управления коммутаторами применяются ИИ-алгоритмы.

22.01.2026 [16:04], Владимир Мироненко

Upscale AI привлёк $200 млн для запуска ИИ-интерконнекта и коммутатора SkyHammerСтартап Upscale AI, специализирующий на разработке ИИ-интерконнекта, объявил о привлечении $200 млн в рамках раунда финансирования серии А. С учётом предыдущего раунда общая сумма инвестиций в Upscale AI достигла $300 млн, а оценка его рыночной стоимости превысила $1 млрд, что придало ему статус «единорога». Это большая сумма для любой технологической компании со 150 сотрудниками, большинство из которых инженеры. Раунд серии А возглавили Tiger Global, Premji Invest и Xora Innovation, также в нём приняли участие Maverick Silicon, StepStone Group, Mayfield, Prosperity7 Ventures, Intel Capital и Qualcomm Ventures. Upscale AI отметил, что поддержка инвесторов отражает растущее в отрасли мнение, что сети являются критически узким местом для масштабирования ИИ, а традиционные сетевые архитектуры, предназначенные для соединения вычислительных ресурсов общего назначения и хранилищ, принципиально не подходят для эпохи ИИ. Устаревшие сетевые решения для ЦОД были разработаны до появления ИИ, и слабо подходят для масштабного, синхронизированного масштабирования на уровне стоек. Когда Upscale AI был основан в начале 2024 года, консорциум UALink и стандарт ESUN, предложенный Meta✴ Platforms, ещё не были обнародованы, но идея гетерогенной инфраструктуры, безусловно, уже была, отметил ресурс The Next Platform. Созданная Upscale AI платформа объединяет GPU, ИИ-ускорители, память, хранилище и сетевые возможности в единый синхронизированный ИИ-движок. Для этого стартап разработал ASIC SkyHammer, который поддерживает ESUN, UALink, Ultra Ethernet, SONiC и Switch Abstraction Interface (SAI). Фактически Upscale AI хочет составить конкуренцию NVIDIA NVSwitch, дав возможность выбора интерконнекта при создании ИИ-инфраструктур. Upscale AI сообщил, что благодаря дополнительному финансированию представит первую полнофункциональную, готовую к использованию платформу, охватывающую кремниевые компоненты, системы и ПО. Также полученные средства будут направлены на расширение инженерных, торговых и операционных команд по мере перехода к коммерческому внедрению решения. По словам Арвинда Шрикумара (Arvind Srikumar), старшего вице-президента по продуктам и маркетингу компании, поставки образцов SkyHammer клиентам начнутся в конце 2026 года, а массовые поставки — в 2027 году, когда в это же время выйдут новые поколения GPU, XPU, коммутаторов и стоек. Коммутаторы должны быть у OEM/ODM-производителей за два квартала до того, как вычислительные ядра будут готовы к поставкам, чтобы они могли собрать системы и протестировать их. «Я всегда считал, что гетерогенные вычисления — это правильный путь, и гетерогенные сети — это тоже правильный путь», — сообщил Шрикумар изданию The Next Platform. Он отметил, что Upscale AI фокусируется на демократизации интерконнекта для ИИ. Шрикумар признал, что у NVIDIA отличные технологии, и что это «потрясающая» компания, когда дело касается инноваций. Вместе с тем он считает, что в будущем, с учётом темпов развития ИИ, вряд ли одна компания сможет предоставить все необходимые технологии для ИИ. Шрикумар считает, что PCIe-коммутация хорошо работает, когда несколько СPU взаимодействуют с несколькими GPU, относительная пропускная способность памяти GPU довольно низкая, а СPU и GPU расположены довольно близко друг к другу в серверном узле. В то же время Upscale AI скептически относится к попыткам создания коммутаторов UALink, ESUN или SUE путем использования ASIC-чипов для PCIe или путём извлечения начинки ASIC-чипов Ethernet-коммутаторов. «Те, кто давно занят в сфере ASIC, знают, что можно удалить много блоков, но основные элементы остаются прежними. Базовая ДНК каждого ASIC остается неизменной», — отметил Шрикумар. Поэтому в Upscale AI решили создать ASIC с нуля, а затем обеспечить поддержку протоколов семантики памяти по мере их появления.

15.12.2025 [12:11], Сергей Карасёв

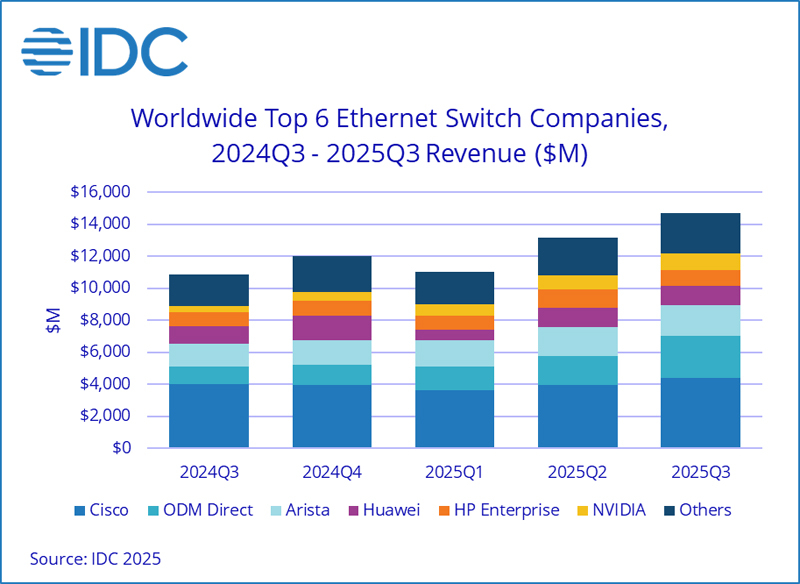

Квартальные продажи Ethernet-коммутаторов подскочили на треть благодаря спросу со стороны ЦОДКомпания International Data Corporation (IDC) подсчитала, что в III квартале уходящего года объём мирового рынка Ethernet-коммутаторов корпоративного класса достиг $14,7 млрд: это на 35,2 % больше по сравнению с аналогичным периодом 2024-го. Вместе с тем продажи маршрутизаторов для предприятий и поставщиков услуг увеличились на 15,8 % в годовом исчислении — до $3,6 млрд. Значительная положительная динамика обусловлена прежде всего развитием сегмента дата-центров. Гиперскейлеры и крупные облачные провайдеры активно закупают сетевое оборудование на фоне стремительного внедрения ИИ, которое сопровождается расширением инфраструктуры ЦОД. Поставки Ethernet-коммутаторов для дата-центров в денежном выражении выросли на 62,0 % по отношению к III четверти 2024 года. Выручка от устройств стандарта 800GbE подскочила на 91,6 % в квартальном исчислении, а их доля в общем объёме ЦОД-рынка составила 18,3 %. Продажи решений 200/400GbE взлетели на 97,8 % в годовом исчислении: на них приходится 43,9 % от общей выручки в сегменте дата-центров. В категории Ethernet-коммутаторов, не связанных с ЦОД, продажи за год поднялись на 8,2 %. Выручка от поставок решений 1GbE выросла на 1,2 %, 10GbE — на 14,3 %, 25/50GbE — на 20,9 % по сравнению с III кварталом 2024-го.

Источник изображения: IDC С географической точки зрения в Северной и Южной Америке рынок коммутаторов Ethernet в целом расширился на 41,6 %, чему способствовал активный рост в дата-центрах США. В регионе EMEA (Европа, Ближний Восток и Африка) продажи поднялись на 24,7 % в годовом исчислении, в Азиатско-Тихоокеанском регионе — на 32,7 %. В рейтинг крупнейших поставщиков коммутаторов Ethernet в глобальном масштабе входят Cisco, Arista Networks, HPE, NVIDIA и Huawei с долями соответственно 29,8 %, 12,8 %, 12,5 %, 11,6 % и 8,2 %. Отмечается, что выручка NVIDIA на рынке Ethernet-коммутаторов за год взлетела на 167,7 %. В секторе маршрутизаторов на поставщиков услуг пришлось 74,0 % от общего объёма выручки с ростом на 20,2 % в годовом исчислении. Корпоративное направление принесло 26,0 % продаж, показав прибавку на уровне 4,7 %. В региональном плане поставки маршрутизаторов в Северной и Южной Америке поднялись на 31,5 % в годовом исчислении, в Азиатско-Тихоокеанском регионе — на 7,7 %, а в регионе EMEA — на 3,5 %.

12.12.2025 [12:44], Сергей Карасёв

Чипы-коммутаторы Xsight Labs X2 пропишутся в спутниках SpaceX Starlink V3Компания Xsight Labs объявила о том, что её программируемые чипы-коммутаторы X2 будут использоваться в составе космических аппаратов SpaceX Starlink V3, предназначенных для организации высокоскоростного спутникового интернет-доступа в глобальном масштабе. Изделия Xsight X2 изготавливаются по техпроцессу TSMC N5. Они обеспечивают пропускную способность до 12,8 Тбит/с. Возможно использование до 128 портов; поддерживаются режимы 100GbE, 200GbE и 400GbE. Заявленное энергопотребление составляет менее 200 Вт. Задержка при работе на скорости 100GbE — менее 700 нс. Чипы выполнены в корпусе с размерами 55 × 55 мм. Каждый спутник Starlink V3 обеспечивает пропускную способность канала связи свыше 1 Тбит/с, что более чем в 10 раз превышает показатель Starlink V2. При этом скорость передачи данных по восходящему каналу составляет около 160 Гбит/с. Решения Xsight X2 помогут в обеспечении надёжной связи при больших нагрузках. Отмечается, что работа глобальной инфраструктуры Starlink зависит от передачи больших объёмов данных в реальном времени, включая трафик, передаваемый по оптическим каналам между спутниками. При этом задействованы технологии адаптивного управления лучом. В такой ситуации полностью программируемая архитектура чипа Xsight X2 позволяет динамически адаптироваться к меняющимся требованиям орбитальных линий связи, обеспечивая оптимальную производительность в различных условиях. В результате, для конечных потребителей услуг обеспечивается скорость интернет-доступа, сопоставимая с оптическими каналами. Утверждается, что изделия Xsight X2 прошли комплексные испытания на соответствие требованиям, предъявляемым к компонентам для работы в экстремальных условиях космического пространства. Речь идет об устойчивости к вибрации, радиации, низким температурам и пр.

10.12.2025 [13:18], Сергей Карасёв

«Гравитон» представил SmartNIC SNC-QSFP2-SH01 с FPGA, 100GbE-портами и слотом SO-DIMMКомпания «Гравитон», российский производитель вычислительной техники, анонсировала сетевой адаптер SNC-QSFP2-SH01 класса SmartNIC, предназначенный для использования в дата-центрах. Устройство обеспечивает аппаратное ускорение различных сетевых функций. В основу решения положена неназванная ПЛИС, которая насчитывает свыше 1 млн логических ячеек и содержит более 50 Мбит встроенной блочной памяти. Адаптер может нести на борту до 32 Гбайт оперативной памяти DDR4. Также упоминается отечественный центральный микроконтроллер первого уровня. Карта оснащена двумя 100GbE-портами QSFP28, что, впрочем, видится избыточным, поскольку используемое подключение PCIe 3.0 x8 не способно «прокачать» столько трафика. За охлаждение отвечают радиатор и вентилятор тангенциального типа. Заявлена поддержка библиотек DPDK и совместимость с платформами Linux и Windows Благодаря возможности реконфигурирования FPGA адаптер может использоваться для решения широкого спектра задач. Среди них названы ускорение работы облачных сервисов, виртуализация, проверка сетевых пакетов по их содержимому (DPI) для регулирования и фильтрации трафика, межсетевые экраны нового поколения (NGFW). Изделие также может применяться в комплексных решениях в сфере кибербезопасности для поиска и устранения угроз в сетевом трафике.

Источник изображения: «Гравитон» «Использование архитектуры на базе ПЛИС позволило нам создать устройство, которое не просто передаёт пакеты, а берёт на себя ресурсоёмкие вычисления: от балансировки нагрузки до глубокой инспекции пакетов. Мы предлагаем рынку мощный инструмент, который поможет оптимизировать работу облачных сервисов и систем информационной безопасности, высвобождая ресурсы CPU для прикладных задач», — говорит «Гравитон».

24.11.2025 [08:45], Сергей Карасёв

Cornelis анонсировала 800G-адаптер CN6000 SuperNIC с поддержкой Omni-Path, RoCEv2 и Ultra Ethernet для ИИ и НРСКомпания Cornelis Networks анонсировала сетевой адаптер CN6000 SuperNIC со скоростью передачи данных до 800 Гбит/с, разработанный для систем ИИ и НРС. О намерении использовать решение объявили многие отраслевые игроки, включая Lenovo, Synopsys и Atipa Technologies. В устройстве реализована архитектура Omni-Path. Говорится о полной совместимости со стандартами Ultra Ethernet и RoCEv2. Таким образом, адаптер может применяться в высоконагруженных средах, где требуются максимальная пропускная способность при низких задержках. Адаптер CN6000 SuperNIC обеспечивает быстродействие до 1,6 млрд сообщений в секунду. Утверждается, что новинка поможет организациям ускорить обучение крупных ИИ-моделей при одновременном снижении расходов на электроэнергию и эксплуатацию дата-центров. Cornelis заявляет, что традиционные архитектуры RoCEv2 испытывают трудности при масштабировании в рамках масштабных GPU-кластеров из-за требований к ресурсам памяти при управлении парами связанных очередей (Queue Pair, QP) для отправки и приёма данных. CN6000 SuperNIC позволяет решить проблему благодаря принципиально иной конструкции: задействованы «облегчённые» алгоритмы QP и аппаратно-ускоренные таблицы RoCEv2 In-Flight (RiF), что даёт возможность отслеживать миллионы одновременных операций с минимальными требованиями к ресурсам. Это гарантирует предсказуемую задержку при максимальной пропускной способности в системах любого масштаба. Пробные поставки CN6000 SuperNIC планируется начать к середине 2026 года, после чего будет организовано массовое производство.

17.11.2025 [12:14], Сергей Карасёв

Nokia представила коммутаторы с пропускной способностью до 102,4 Тбит/сКомпания Nokia анонсировала высокопроизводительные коммутаторы семейства 7220 IXR-H6 для дата-центров, ориентированных на ресурсоёмкие нагрузки ИИ. Новинки соответствуют спецификациям Ultra Ethernet Consortium (UEC), поддерживая расширенные функции для оптимизации и управления потоками данных, предотвращения перегрузок и повышения эффективности в крупномасштабных средах. Коммутаторы обеспечивают пропускную способность до 102,4 Тбит/с благодаря интерфейсам 800GbE и 1.6TbE, что вдвое больше по сравнению с решениями предыдущего поколения. В серию 7220 IXR-H6 вошли две модели с 64 портами (1.6TbE), оборудованные воздушным и жидкостным охлаждением. В первом случае допускается горячая замена блоков вентиляторов. Кроме того, дебютировала модификация со 128 портами (800GbE). О типе применённого чипсета пока ничего не сообщается.

Источник изображения: Nokia Устройства комплектуются блоками питания с резервированием и возможностью горячей замены. Предусмотрены сетевой порт управления RJ45, разъём USB 3.0 и консольный порт. Коммутаторы могут поставляться с сетевой операционной системой SR Linux NOS или SONiC (Software for Open Networking in the Cloud). По заявлениям Nokia, решения семейства 7220 IXR-H6 могут применяться в составе платформ облачных провайдеров и гиперскейлеров, а также в ИИ-кластерах, насчитывающих более 1 млн ускорителей разных типов (XPU). Говорится о совместимости с серверными стойками различных конфигураций. В продажу коммутаторы поступят в I квартале следующего года.

12.11.2025 [23:23], Владимир Мироненко

От ИИ ЦОД до роботов: AMD анонсировала долгосрочную стратегию роста

amd

cpu

dpu

epyc

hardware

instinct

mi400

mi500

ocp

pensando systems

ualink

ultra ethernet

venice

verano

xilinx

ии

ускоритель

финансы

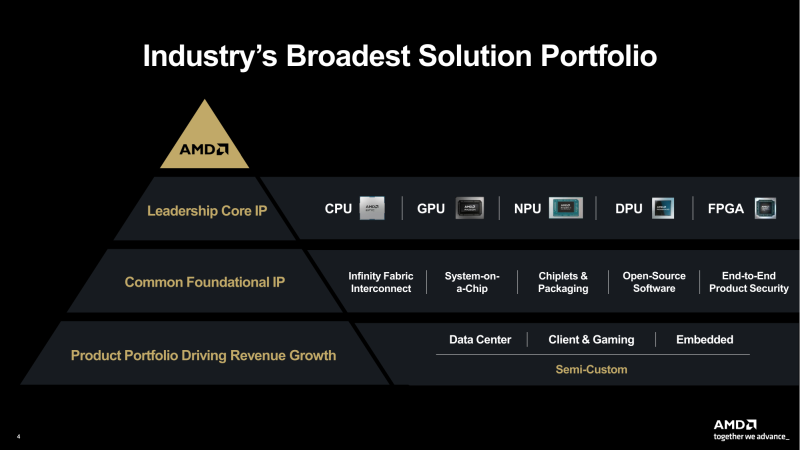

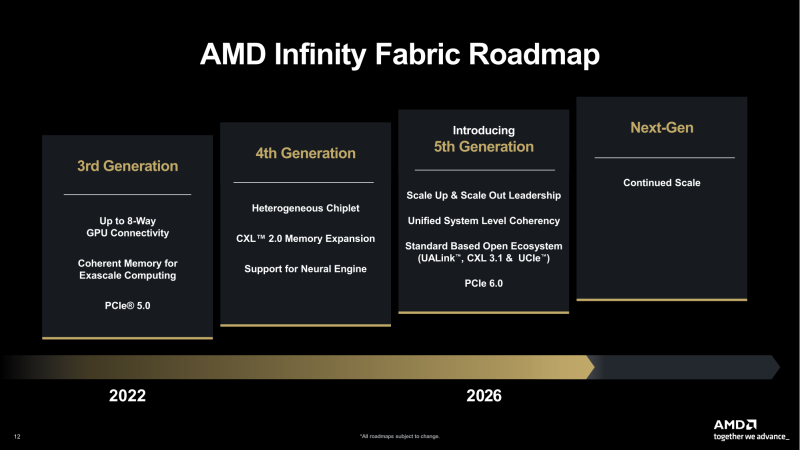

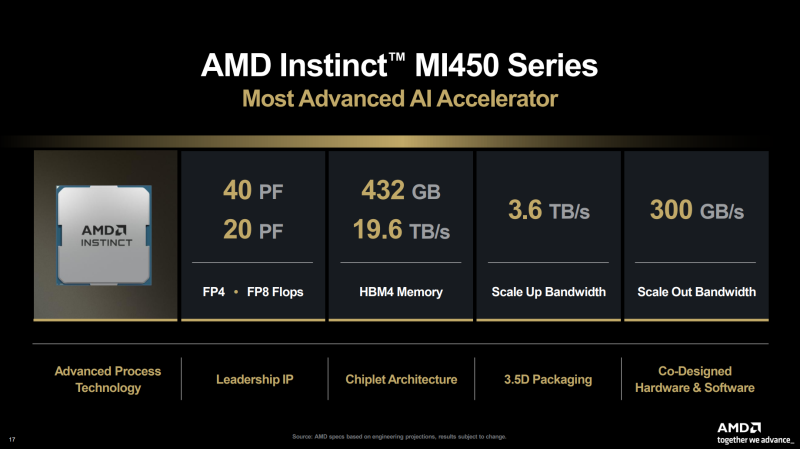

AMD представила на мероприятии Financial Analyst Day 2025 план по достижению лидерства на рынке вычислительных технологий объёмом $1 трлн. Долгосрочная стратегия роста AMD построена на четырех столпах: лидерство в сфере ЦОД, повышение производительности ИИ, открытое ПО и расширение присутствия на рынках встраиваемых и полукастомных кремниевых решений. AMD ожидает, что только её бизнес в сфере ЦОД будет приносить более $100 млрд годовой выручки, с увеличением совокупного среднегодового темпа роста (CAGR) до более чем 60 %, при этом CAGR дохода от ИИ-решений увеличится до более чем 80 %. Генеральный директор AMD Лиза Су (Lisa Su) заявила, что следующий этап будет основан на унифицированной вычислительной платформе AMD, объединяющей процессоры EPYC, ускорители Instinct, сетевые решения Pensando и ПО ROCm. Новый план развития AMD призван обеспечить ей конкуренцию с NVIDIA и Intel на корпоративных рынках и в борьбе за заказы гиперскейлеров. Ускорители серии Instinct MI350, уже развёрнутые Oracle (ещё 50 тыс. MI450 будут развёрнуты во II половине 2026 г.), являются самыми популярными ускорителями AMD на сегодняшний день. Следующей платформой станет серия MI450, которая будет запущена вместе со стоечной платформой Helios в III квартале 2026 года. Helios обеспечит пропускную способность интерконнекта 3,6 Тбайт/с на каждый ускоритель и до 72 ускорителей на стойку с совокупной пропускной способностью 260 Тбайт/с, соединённых между собой посредством UALink и Ultra Ethernet (UEC). Система поддерживает разделяемую память между ускорителями, что обеспечивает обучение крупномасштабных моделей с бесперебойным доступом к памяти и отказоустойчивой сетью с шестью плоскостями. AMD характеризует Helios как свою первую ИИ-платформу стоечного масштаба — полностью интегрированную систему с открытой архитектурой, которая объединяет вычислительные мощности, ускорение, сетевые технологии и ПО в единую структуру. В отличие от традиционных серверных кластеров, Helios реализует всю стойку как единый высокопроизводительный вычислительный домен. Каждая стойка объединяет процессоры AMD EPYC Venice, CDNA5-ускорители Instinct MI450X (будет и вариант MI430X с полноценными FP64-блоками) и 400G/800G-карты Pensando Vulcano, связанные Infinity Fabric пятого поколения (PCIe 6.0, CXL 3.1, UCIe) и UALink. Эта архитектура минимизирует накладные расходы на перемещение данных, увеличивает пропускную способность между ускорителями и обеспечивает эффективность класса экзафлопсных вычислений в компактном корпусе. Helios фактически представляет собой проект AMD для ИИ-фабрики будущего с возможностью модульного расширения, позволяя объединять сотни стоек в одну систему в ЦОД. В 2027 году AMD планирует выпустить ускорители серии MI500 и процессоры EPYC Verano, продолжая тем самым ежегодный цикл совместной разработки процессоров, ускорителей и сетей. AMD заявила, что EPYC Venice, намеченные к выпуску в 2026 году, будут обладать лучшими в отрасли показателями плотности (1,3x по количеству потоков в сравнении с текущими решениями) и энергоэффективности (1,7x). Они пополнятся оптимизированными для ИИ наборами инструкций для обработки инференса и выполнения вычислений общего назначения. Указанные компоненты станут основой ИИ-фабрики, способной масштабироваться от одной стойки до глобально распределённых кластеров. Исполнительный вице-президент AMD Форрест Норрод (Forrest Norrod) подчеркнул в своём выступлении, что производительность ИИ всё больше зависит от сети. Сетевые карты AMD Pensando Pollara и Vulcano для ИИ образуют связующую ткань архитектуры Helios. Сетевая карта Pollara 400 обеспечивает пропускную способность 400 Гбит/с, а готовящаяся к выходу сетевая карта Vulcano удвоит её до 800 Гбит/с, обеспечивая связь Ultra Ethernet между крупными кластерами ускорителей. AMD представила четырёхуровневую архитектуру сети для масштабных ИИ-инфраструктур. Front-End часть обслуживает пользователей, хранилище и приложения. Она опирается на DPU Pensando и P4-движки, отвечающие за разгрузку сетевых функций, функции безопасности и шифрования, и работу с СХД. Вертикальное масштабирование в пределах стойки обеспечивает 3,6-Тбайт/с подключение на каждый GPU. Горизонтальное масштабирование реализуется благодаря UEC — внутренние тесты показали снижение затрат на коммутацию до 58 % по сравнению с традиционными сетями типа Fat-Tree. Наконец, Scale-Across (пространственное масштабирование) позволит объединить географически распределённые ЦОД в кластеры с интеллектуальным управлением трафиком и адаптивной балансировкой нагрузки. AMD отметила, что открытый программный стек ROCm (Radeon open compute) по-прежнему лежит в основе её стратегии в области ИИ-платформ. По сравнению с прошлым годом число его загрузок выросло в десять раз и теперь на HuggingFace поддерживается более 2 млн моделей. ROCm интегрируется с ведущими фреймворками, включая PyTorch, TensorFlow, JAX, Triton, vLLM, ComfyUI и Ollama, и поддерживает проекты с открытым исходным кодом, такие как Unsloth. AMD также расширила своё видение «физического ИИ», когда вычисления выходят за рамки облака и охватывают роботов, транспортные средства и промышленные системы. Подразделение встраиваемых систем, усиленное приобретением Xilinx в 2022 году, превратилось из бизнеса, ориентированного на FPGA, в многоплатформенный двигатель роста, охватывающий адаптивные системы на кристалле (SoC), встраиваемые x86-процессоры и заказные кремниевые решения. По словам компании, с 2022 года решения в этой области принесли более $50 млрд. AMD рассчитывает превысить 70 % доли рынка адаптивных вычислений. Говоря о перспективах, компания отметила, что ЦОД остаются основным драйвером роста, но наряду с этим она будет диверсифицировать свою деятельность по всем сегментам. Финансовые цели AMD включают:

28.10.2025 [20:35], Сергей Карасёв

NVIDIA анонсировала DPU BlueField-4: 800G-порты, ConnectX-9, CPU Grace и PCIe 6.0NVIDIA анонсировала DPU BlueField 4, рассчитанный на использование в составе масштабных инфраструктур ИИ. Устройство оснащено 800G-портами. Новинка в этом отношении вдвое быстрее BlueField-3, дебютировавших ещё в 2021 году. NVIDIA отмечает, что ИИ-фабрики продолжают развиваться с беспрецедентной скоростью. При этом требуется обработка колоссальных массивов структурированных и неструктурированных данных. Для удовлетворения этих потребностей необходимо формирование инфраструктуры нового класса, на которую как раз и ориентирован DPU BlueField-4. Новинка использует программно-определяемую архитектуру для ускорения сетевых операций, функций безопасности и задач хранения данных. По заявлениям NVIDIA, BlueField-4 позволяет трансформировать дата-центры в безопасную интеллектуальную ИИ-инфраструктуру с высокой производительностью. BlueField-4 объединяет 64-ядерный Arm-процессор NVIDIA Grace (114 Мбайт L3-кеш), 128 Гбайт LPDDR5, 512 Гбайт SSD, сетевой адаптер NVIDIA ConnectX-9 SuperNic (1,6 Тбит/с), а также коммутатор PCIe 6.0 с 48 линиями. Новинка будет доступна в виде карты расширения (PCIe 6.0 x16) и в виде модуля для узлов VR NVL144. Утверждается, что по сравнению с BlueField-3 вычислительная производительность выросла в шесть раз. При этом возможно формирование ИИ-фабрик вчетверо большего масштаба. Кроме того, BlueField-4 поддерживает многопользовательскую сеть, быстрый доступ к данным и микросервисы NVIDIA DOCA. Задействована архитектура NVIDIA BlueField Advanced Secure Trusted Resource Architecture. Предполагается, что BlueField-4 возьмут на вооружение такие производители серверов и платформ хранения данных, как Cisco, DDN, Dell Technologies, HPE, IBM, Lenovo, Supermicro, VAST Data и WEKA. О поддержке новинки заявили Armis, Check Point, Cisco, F5, Forescout, Palo Alto Networks и Trend Micro, а также системные интеграторы Accenture, Deloitte и World Wide Technology. Интегрировать BlueField-4 в свои платформы намерены Canonical, Mirantis, Nutanix, Rafay, Red Hat, Spectro Cloud и SUSE. На рынок BlueField-4 поступит в 2026 году как часть экосистемы Vera Rubin. |

|