Материалы по тегу: aws

|

20.02.2026 [15:23], Владимир Мироненко

Anthropic планирует увеличить к 2029 году расходы на облака до $80 млрдК 2029 году затраты на облачные сервисы ИИ-стартапа Anthropic, согласно его собственным прогнозам, достигнут $80 млрд, сообщил ресурс The Information со ссылкой на свои источники. Расходы будут распределены между Google, Microsoft и Amazon. Помимо оплаты аренды серверов для моделей Claude, Anthropic также делится с облачными провайдерами частью прибыли от продаж своих ИИ-сервисов на их платформах. The Information сообщил со ссылкой на данные стартапа, что в 2024 году эта сумма составила $1,3 млн, и, согласно «самым оптимистичным прогнозам» ресурса, в 2025 году она составила $360 млн, в 2026 году вырастет до $1,9 млрд, а в 2027 году — до $6,4 млрд. Также, по словам источника, Anthropic отчисляет клиентам до 50 % своей валовой прибыли от продаж ИИ-решений на AWS, рассчитываемой на основе выручки за вычетом расходов на облачные ресурсы. Для сравнения, Google обычно получает от 20 % до 30 % чистой выручки после вычета затрат на инфраструктуру от перепродажи ПО своих партнёров. Как утверждает генеральный директор Anthropic Дарио Амодеи (Dario Amodei), компания тратит меньше средств на вычислительные мощности ЦОД по сравнению с другими компаниями в сфере ИИ. Он отметил, что чрезмерные расходы могут быть «разорительными» в случае, когда выручка не гарантирована. Anthropic давно пользуется услугами Google Cloud, и в октябре прошлого года заключила сделку, обеспечивающую ей доступ к облачным ресурсам провайдера мощностью более 1 ГВт с возможностью использования до 1 млн TPU от Google. С этим проектом может быть связана сделка Anthropic по поводу $50 млрд инвестиций в вычислительную инфраструктуру в США в сотрудничестве с Fluidstack. Кроме того, у Anthropic очень тесные отношения с AWS, которая много инвестировала в стартап и развернула для него один из крупнейших в мире ИИ-кластеров Project Rainier. Наконец, в прошлом году компания подписала крупное соглашение с Microsoft Azure.

18.02.2026 [11:29], Сергей Карасёв

AWS внедрила вложенную виртуализацию для инстансов EC2Облачная платформа AWS сообщила о том, что некоторые её инстансы EC2 получили поддержку вложенной виртуализации (Nested Virtualization). Это позволяет решать определённые специфичные задачи, например, работать с эмуляторами мобильных приложений или выполнять моделирование автомобильного оборудования. Вложенная виртуализация даёт возможность запускать гипервизор внутри виртуальной машины, которая сама работает на другом гипервизоре. Иными словами, формируется виртуальная машина внутри виртуальной машины. Такой подход ориентирован на разработку и тестирование различных программных решений без использования физических серверов. Метод может быть полезен в производственной среде для контейнеризированных рабочих нагрузок, где часто применяются инструменты вроде Kubernetes и Docker.

Источник изображения: AWS AWS внедрила поддержку вложенной виртуализации в инстансы EC2 C8i, M8i и R8i. Все они базируются на платформе Intel Xeon 6 в кастомном исполнении. В этих процессорах реализована усовершенствованная технология Trust Domain Extensions (TDX), которая обеспечивает улучшенную изоляцию между гостевой ОС и гипервизором. Все экземпляры EC2 работают под управлением собственного гипервизора Amazon Nitro. В целом, архитектура вложенной виртуализации состоит из трех уровней. Это физическая инфраструктура AWS и гипервизор Nitro, формирующие нулевой уровень (L0). На первом уровне (L1) функционирует клиентский экземпляр EC2 с гипервизором. Второй уровень (L2) состоит из одной или нескольких виртуальных машин, созданных в инстансе EC2. В качестве гипервизоров уровня L1 в настоящее время могут использоваться Microsoft Hyper-V и KVM. Вложенная виртуализация доступна во всех регионах присутствия AWS.

16.02.2026 [11:16], Руслан Авдеев

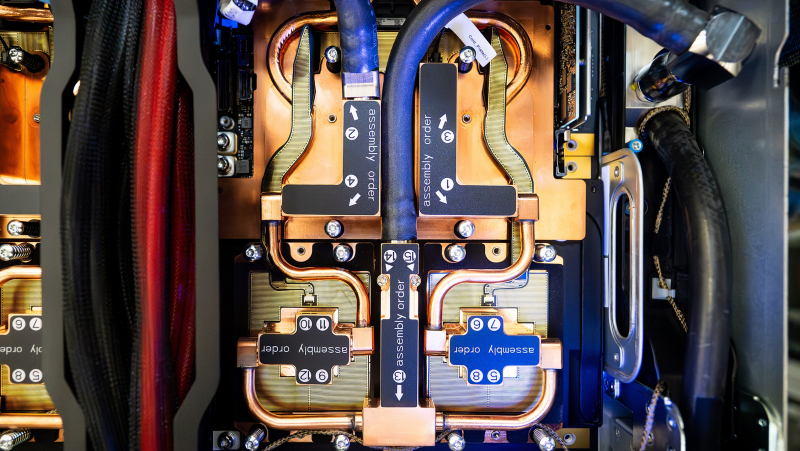

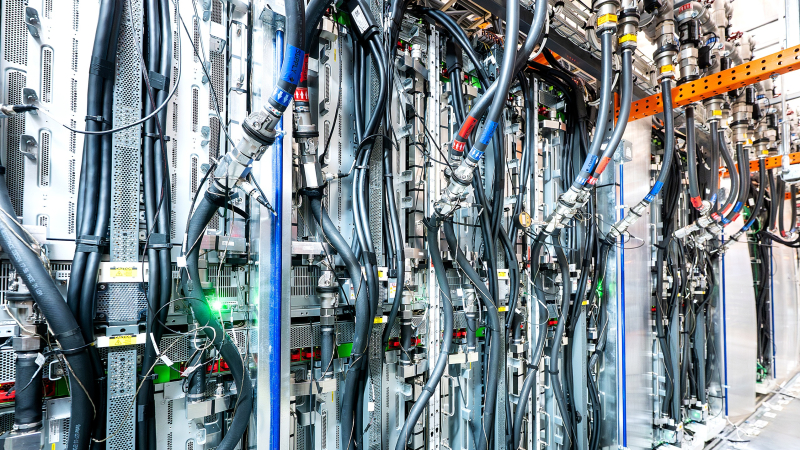

Попутного ветра: AWS резко сократила развёртывание СЖО для Trainium3, решив обойтись преимущественно воздушным охлаждениемAmazon Web Services (AWS) резко увеличит долю воздушного охлаждения в серверах на базе ускорителей Trainium3. Производство серверов намерены нарастить во II квартале 2026 года, но жидкостное охлаждение в них будут применять далеко не так активно, как ожидалось, сообщает DigiTimes. Если ранее планировалось применять системы жидкостного и воздушного охлаждения с соотношением 1:1, то теперь на первые будет приходиться лишь 10 % от общего числа, что способно замедлить внедрение СЖО в ЦОД. При этом ранее отраслевые эксперты прогнозировали, что проникновение СЖО на рынок ИИ-серверов вырастет с менее 20 % в 2025 году до более 50 % в 2026-м. Это должно было случиться за счёт расширения поставок GPU- и ASIC. AWS даже смогла разработать в рекордно короткие сроки собственную платформу СЖО, что привело к падению акций Vertiv, одного из бенефициаров ИИ-бума. Новый подход к оборудованию Trainium3 ставит под вопрос будущее и динамику перехода к жидкостному охлаждению. Тем не менее, рост производства Tranium 3 в любом случае поддержит спрос на продукцию ключевых партнёров AWS: Wiwynn, Accton, Auras, Taiwan Microloops и Nan Juen International (Repon). Вероятно, спрос позволит загрузить производственные мощности до конца 2026 года. По мнению аналитиков, решение AWS во многом связано с TDP ускорителей на уровне 800 Вт (хотя раньше говорили об 1000 Вт) — для них, вероятно, достаточно и для современного воздушного охлаждения, что снижает необходимость перехода на более дорогие и сложные СЖО. По данным AWS, Trainium3 приблизительно на 40 % производительнее в сравнении с ускорителями предыдущего поколения. Также компания объявила о капитальных затратах до $200 млрд на расширение ИИ-инфраструктуры, в т.ч. производство собственно ускорителей — на 2027 год запланированы поставки уже Trainium4. Так или иначе, даже после снижения доли СЖО спрос на компоненты у партнёров должен увеличиться за счёт роста производства в целом. Рост популярности жидкостного охлаждения в ИИ ЦОД в последние годы во многом обусловлен ростом TDP ускорителей NVIDIA. Если у H200 показатель был на уровне около 700 Вт, то у B200 — порядка 1000 Вт, а у B300 — уже 1400 Вт. Для будущих архитектур с двумя чипами значения будут ещё выше. В результате операторам ЦОД требуется эффективный отвод тепла, что могут обеспечить СЖО. Кроме того, это позволяет повысить плотность размещения оборудования. В сегменте ASIC рост TDP заметно ниже. Так, для Trainium2 речь шла об около 500 Вт, у Trainium3 — всего 800 Вт, поэтому воздушное охлаждение — вполне рабочий вариант, за исключением некоторых сценариев, например, с высокой плотностью размещения оборудования. Также источники в цепочке поставок подчёркивают, что жидкостные системы дороже устанавливать и обслуживать в сравнении с современными воздушными вариантами. При этом экосистема производства и обслуживания СЖО часто оценивается как «менее зрелая». Благодаря этому организовать поставки серверов с воздушным охлаждением можно быстрее, и они будут более стабильными. Беспокойство операторов ЦОД может вызывать и репутация жидкостных систем. Например, в конце января Wave Power объявила о том, что некоторые проданные компоненты СЖО для ИИ-систем привели к повреждению оборудования, поэтому компании пришлось выложить $4,5 млн, чтобы заключить мировое соглашение. По мнению экспертов, утечки в СЖО — довольно распространённое явление, не привязанное к конкретному вендору, но каждый подобный инцидент свидетельствует о потенциальных проблемах, которые заказчикам приходится принимать в расчёт. Хотя системы жидкостного охлаждения технически предпочтительнее для самых энергоёмких нагрузок благодаря высокой эффективности теплоотвода, потенциалу снижения показателя PUE и способности обеспечить экономию пространства, на примере Trainium3 можно оценить, как совокупность факторов, включая совокупную стоимость владения (TCO) и операционные риски влияют на сроки внедрения СЖО. Изменение планов AWS может повлиять на всю индустрию ИИ ЦОД, которая может замедлить повсеместный переход на жидкостное охлаждение, по крайней мере, в краткосрочной перспективе. Вместе с тем даже для ИИ-платформ нынешнего поколения гиперскейлеры разработали гибридные варианты охлаждения, позволяющие использовать современные системы в старых ЦОД, не рассчитанных изначально на крупномасштабные СЖО. Так, Meta✴ «растянула» суперускорители NVIDIA GB200 на шесть стоек вместо одной, чтобы разместить там теплообменники, а Microsoft с той же целью «пристроила» к стойке с оборудованием модуль шириной в ещё пару стоек. Google же предпочитает для своих TPU именно СЖО.

07.02.2026 [17:23], Руслан Авдеев

AWS: ни один сервер с NVIDIA A100 не выведен из эксплуатации, а некоторые клиенты всё ещё используют Intel Haswell — не всем нужен ИИПо словам главы AWS Мэтта Гармана (Matt Garman), клиенты до сих пор использует серверы на основе ИИ-ускорителей NVIDIA A100, представленных в 2020 году. Отчасти это происходит потому, что спрос на вычислительные ресурсы превышает предложение, так что устаревшие чипы по-прежнему востребованы, передаёт Datacenter Dynamics. По словам Гармана, все ресурсы фактически распроданы, а серверы с A100 из эксплуатации никогда не выводились. Комментарии Гармана перекликаются с прошлогодним заявлением Амина Вахдата (Amin Vahdat), отвечающего в Google за ИИ и инфраструктуру. По его словам, в Google одновременно работают семь поколений тензорных ускорителей (TPU). Ускорители возрастом семь-восемь лет загружены на 100 %, а спрос на TPU так высок, что Google вынуждена отказывать некоторым клиентам. Впрочем, оба топ-менеджера, возможно, несколько кривят душой и пытаются развеять опасения инвесторов относительно того, что ИИ-ускорители, на которые тратятся огромные деньги, через два-три года придётся выкинуть, чтобы купить более современные, энергоэффективные и, конечно же, дорогие. И что за это время они не успеют окупиться. Хотя Гарман назвал главной причиной сохранения работы серверов на A100 высокий спрос, он признал, что есть и другие причины. В частности, современные ИИ-чипы снижают точность вычислений с плавающей запятой. В результате некоторые клиенты попросту не могут перейти на Blackwell или вовсе вынуждены использовать Intel Xeon Haswell десятилетней давности для HPC-подобных вычислений, поскольку точности у современных ИИ-ускорителей недостаточно. В июне 2025 года AWS заявила о снижении цены доступа к устаревшим NVIDIA H100, H200 и A100 на своей платформе, причём для A100 стоимость снизилась на треть.

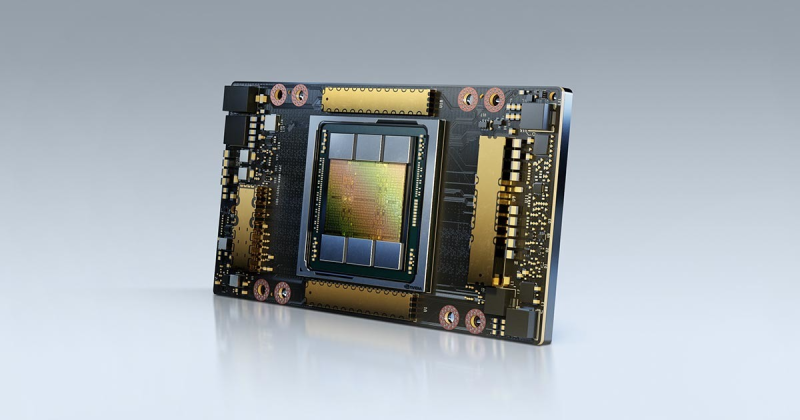

Источник изображения: NVIDIA Стоит отметить, что «устаревшие» ускорители долго остаются востребованными, поскольку всё равно обладают большой производительностью. Наиболее яркий пример — разрешение на поставку в Китай чипов NVIDIA H200. Хотя США и их союзники готовятся к внедрению ускорителей поколения Vera Rubin, китайский бизнес готов покупать H200, поскольку те значительно производительнее, экономически выгоднее и удобнее отечественных ускорителей.

06.02.2026 [15:18], Владимир Мироненко

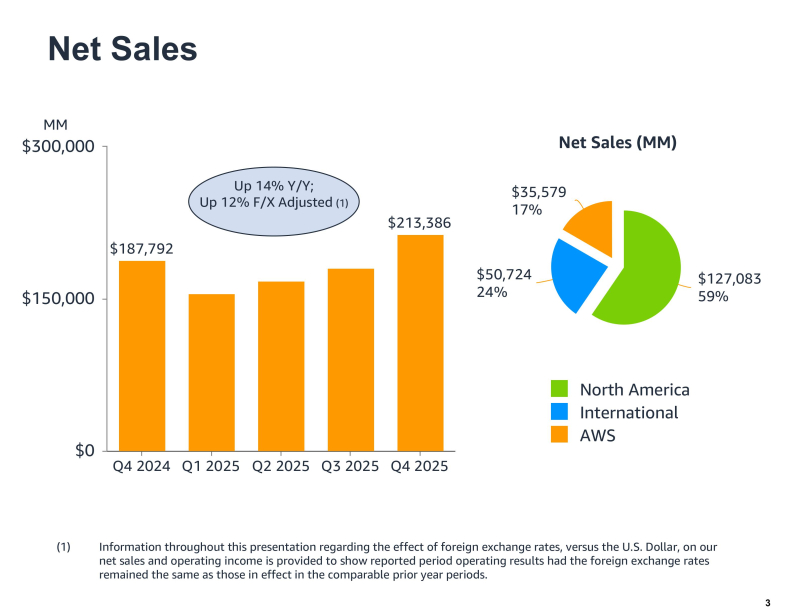

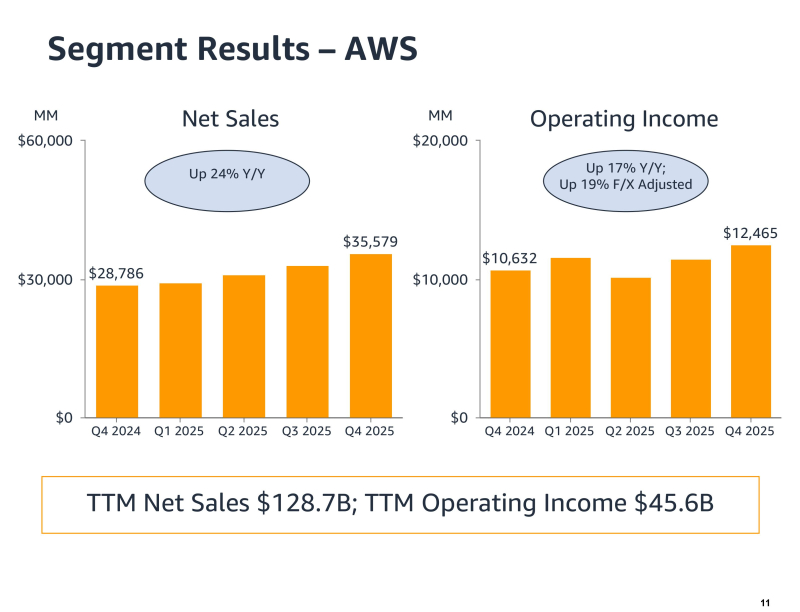

Акции Amazon упали после объявления о $200 млрд капзатрат на 2026 годАкции Amazon рухнули более чем на 10 % на внебиржевых торгах в четверг после объявления финансовых результатов за IV квартал и весь 2025 год и повышения прогноза капитальных затрат на 2026 год до $200 млрд. Выручка Amazon в IV квартале 2025 года, закончившемся 31 декабря, выросла год к году на 14 %, до $213,39 млрд, превысив прогноз аналитиков в $211,33 млрд (согласно опросу LSEG). Скорректированная прибыль на разводнённую акцию составила $1,95, что ниже консенсус-прогноза Уолл-стрит в $1,97. Чистая прибыль выросла до $21,19 млрд с $20,00 млрд годом ранее. В текущем квартале Amazon прогнозирует выручку в диапазоне от $173,5 млрд до $178,5 млрд, что означает рост год к году примерно на 11–15 %. Средняя точка этого диапазона соответствует прогнозу аналитиков в $175,6 млрд. За весь 2025 год выручка Amazon выросла 12 % до $716,92 млрд с $637,96 млрд годом ранее. Чистая прибыль увеличилась до $77,67 млрд или $7,17 на разводнённую акцию с $59,25 млрд или $5,53 на разводнённую акцию в 2024 году. Выручка облачного подразделения Amazon Web Services (AWS) за квартал увеличилась на 24 % до $35,58 млрд, превзойдя ожидания аналитиков, опрошенных StreetAccount, в размере $34,93 млрд. Операционная прибыль сегмента AWS достигла $12,47 млрд по сравнению с $10,63 млрд годом ранее. По словам гендиректора Amazon Энди Джасси (Andy Jassy), это был самый быстрый темп роста AWS за 13 кварталов. Как отметил ресурс SiliconANGLE, облачный бизнес Amazon по-прежнему намного больше, чем у конкурентов, но его рыночная доля постепенно сокращается из-за роста Microsoft Azure и Google Cloud. На прошлой неделе Microsoft сообщила о росте выручки Azure на 39 %, а продажи Google Cloud выросли на 48 %, что представляет собой самый быстрый темп роста с 2021 года. Аналитики сообщили, что Azure и Google Cloud также быстрее растут в сегменте ИИ-сервисов. «Учитывая высокий спрос на наши существующие продукты и перспективные возможности, такие как ИИ, микросхемы, робототехника и LEO-спутники, мы планируем инвестировать около $200 млрд в капитальные вложения в Amazon в 2026 году и ожидаем высокой долгосрочной окупаемости вложенного капитала», — заявил Джасси. В ходе конференции с аналитиками Джасси пояснил, что основная часть капитальных затрат в 2026 году будет направлена в AWS, где, по его словам, «рабочие нагрузки, не связанные с ИИ, растут быстрее, чем мы ожидали». «У нас очень высокий спрос, — добавил Джасси. — Клиенты действительно хотят использовать AWS для основных и ИИ-задач, и мы монетизируем мощности так быстро, как только можем их установить». Объявленная сумма значительно превышает прогноз Уолл-стрит в $146,6 млрд и намного превосходит $131 млрд капзатрат в 2025 году. Ранее на этой неделе материнская компания Google, Alphabet, заявила, что планирует потратить от $175 до $185 млрд на капитальные затраты, а Meta✴ Platforms — от $115 до $135 млрд. Ожидаемые затраты Microsoft составят $145 млрд, а Oracle — $55 млрд. Несмотря на опасения инвесторов по поводу значительных капитальных затрат, некоторые аналитики считают, что позиции Amazon остаются сильными. «Развитие ИИ, безусловно, значительно ускоряет переход компаний в облако, что является основной причиной значительно более высоких, чем прогнозировалось, капитальных затрат, которые мы считаем фундаментально позитивными», — написал аналитик Pivotal Research Group Джефф Влодарчак (Jeff Wlodarczak) в записке для клиентов. Он отметил, что Amazon управляет двумя высокорентабельными быстрорастущими предприятиями и огромным низкорентабельным логистическим бизнесом с беспрецедентным масштабом, который «потенциально может существенно повысить маржу в среднесрочной и долгосрочной перспективе, используя ИИ в сочетании с робототехникой».

29.01.2026 [10:39], Руслан Авдеев

NVIDIA, Microsoft и Amazon ведут переговоры об инвестициях до $60 млрд в OpenAINVIDIA, Microsoft и Amazon ведут переговоры о новых инвестициях в OpenAI. Предполагается, что компании готовы вложить в бизнес партнёра до $60 млрд, сообщает The Information. Как заявляет The Information со ссылкой на «лицо, знакомое с ситуацией», NVIDIA — действующий инвестор, чьи чипы активно используются для работы с ИИ-моделями OpenAI, ведёт переговоры о том, чтобы вложить до $30 млрд. Microsoft, давно поддерживающая OpenAI, также ведёт переговоры, но готова потратить лишь менее $10 млрд. При этом Amazon (AWS), готовая стать новым инвестором, обсуждает о вложении значительно больше $10 млрд, потенциально — даже более $20 млрд. Сообщается, что OpenAI близка к тому, чтобы получить юридически не обязывающие меморандумы о договорённостях (term sheets) или инвестиционные обязательства от названных компаний. NVIDIA, Microsoft, Amazon и OpenAI пока новости не комментируют. Ранее сообщалось, что SoftBank Group ведёт переговоры об инвестициях дополнительных $30 млрд в OpenAI. Масштаб инвестиций Amazon может зависеть от отдельных переговоров, предусматривающих возможное расширение сделки по аренде облачных серверов у Amazon компанией OpenAI и заключение коммерческого соглашения о продаже OpenAI своих продуктов — Amazon может оформить корпоративные подписки на ChatGPT. Сейчас OpenAI пытается бороться с ростом цен на обучение и эксплуатацию своих ИИ-моделей на фоне ужесточающейся конкуренцией с компанией Google и более мелкими игроками. Впрочем, плохо контролируемые инвестиции могут быть весьма опасными. Так, американские банки уже крайне неохотно дают деньги Oracle, из-за уже имеющихся обязательств последней перед OpenAI. На днях сообщалось, что OpenAI готовит крупнейший в своей истории раунд финансирования на $50 млрд при участии инвесторов Ближнего Востока.

21.01.2026 [09:45], Руслан Авдеев

Amazon приобрела 1,2-ГВт проект солнечной электростанции и энергохранилища для питания своих ЦОДAmazon приобрела за $83 млн у обанкротившейся Pine Gate Renewables перспективный объект Sunstone в округе Морроу (Morrow, Орегон). Это один из крупнейших в мире комплексов зелёной энергетики, который включает солнечную электростанцию мощностью 1,2 ГВт и аккумуляторное энергохранилище, тоже мощностью 1,2 ГВт (ёмкость не уточняется), сообщает Datacenter Dynamics. Предыдущий владелец сделал все необходимые приготовления, но собственно строительство не начал из-за финансовых проблем. Реализация запланирована в шесть этапов по 200 МВт. Уже заключены поэтапные соглашения с местным энергетическим кооперативом о подключении к сети для каждой фазы и имеется несколько заявок на резервирование магистральных сетей для транспортировки электроэнергии потребителям. Строительство начнётся в 2026 году, а первая фаза должна заработать в ноябре 2027 года. С учётом масштаба проекта на достижение полной проектной мощности должно уйти довольно много времени. Связано ли банкротство с новой политикой администрации США, не уточняется. Соглашение не вполне характерно для Amazon, обычно заключающей договоры на поставку энергии (PPA). Это чуть ли не первый случай, когда гиперскейлер становится владельцем крупного проекта возобновляемой энергетики. Впрочем, сделка отражает общие тенденции сектора ЦОД — операторы стремятся самостоятельно обеспечить питание своих дата-центров, и солнечная энергия остаётся для них очень привлекательной. Так, Google объявила о покупке за $4,75 млрд Intersect Power, у которой есть 2,2 ГВт солнечных панелей и 2,4 ГВт аккумуляторных энергохранилищ, строящихся или уже готовых. Сделка Amazon несколько отличается, поскольку гиперскейлер покупает проект, а не саму компанию. Для неё это вынужденный шаг, поскольку местная коммунальная компания PacifiCorp так и не смогла предоставить ЦОД AWS (регион US West 2) обещанные мощности, а власти запретили Amazon построить газовую электростанцию на топливных ячейках Bloom Energy. В результате гиперскейлер обратился к местному регулятору Oregon Public Utilities Commission, чтобы тот заставил коммунальную компанию поставить электричество в обещанных объёмах или разрешить Amazon закупать электричество у любого поставщика по её выбору.

19.01.2026 [16:26], Руслан Авдеев

AWS запустила своё первое действительно суверенное облако European Sovereign Cloud в ЕвросоюзеНа фоне торговых и геополитических трений между Евросоюзом и США, Amazon Web Services (AWS) объявила о запуске суверенного облака European Sovereign Cloud в Европе. Новое, независимое облако полностью базируется в Евросоюзе и физически и логически отделено от прочих облачных регионов AWS. Как заявляют в компании, уникальный подход AWS European Sovereign Cloud обеспечивает полнофункциональные сервисы под строгим техническим контролем, с суверенными гарантиями и правовой защитой для удовлетворения запросов европейских правительств и бизнесов на защиту конфиденциальных данных. Также AWS анонсировала планы расширения European Sovereign Cloud за пределы Германии (Бранденбурга), где находится его первый регион (eusc-de-east-1), в другие страны и регионы ЕС для поддержки изоляции данных от внешних игроков и доступа с низкой задержкой для местных клиентов. Дополнительно будут созданы новые суверенные зоны доступности WS Local Zones в Бельгии, Нидерландах и Португалии. Услугами нового региона могут воспользоваться все желающие, а не только резиденты ЕС. Открытие AWS European Sovereign Cloud и новых зон доступности в трёх странах обеспечит организации дополнительными возможностями для размещения рабочих нагрузок в «местных» облаках с высочайшим уровнем операционной независимости. В то же время компания пообещает сохранить доступ ко всему спектру сервисов AWS. Клиенты, которым нужна более строгая изоляция данных, смогут использовать AWS Dedicated Local Zone, AWS AI Factorу или AWS Outposts, в том числе в собственных ЦОД. AWS European Sovereign Cloud опирается на местные кадры, инфраструктуру и топ-менеджмент. Операционный контроль из-за пределов Евросоюза, как утверждается, не предусмотрен. Операционная автономность является ключевой функцией облака. Физически и логически AWS European Sovereign Cloud отделено от других регионов AWS, управляется только резидентами Евросоюза, не имеет критических зависимостей от находящейся за пределами ЕС инфраструктуры — даже если связь со всем остальным миром будет потеряна, облако продолжит работу. В исключительных случаях кадры из числа резидентов Евросоюза смогут получить доступ к копии исходного кода, необходимого для поддержки суверенных сервисов. AWS обеспечивает клиентам полный контроль над тем, где именно будут храниться их данные. Кроме того, клиенты сохранят контроль над создаваемыми метаданными (роли, разрешения, конфигурации и др.), которые останутся в Евросоюзе, в том числе речь идёт о системах IAM, биллинге и метриках использования. Как и в других регионах AWS, European Sovereign Cloud защищено с помощью системы AWS Nitro, благодаря которой все вычисления на платформе EC2 имеют строгий барьер для доступа извне, включая доступ со стороны сотрудников AWS без прямой авторизации со стороны клиента. Доступны управление шифрования и ключами (AWS Key Management Service) и аппаратные модули безопасности AWS CloudHSM. AWS создала специальную структуру управления в Европе, с новой «материнской» компанией и тремя дочерними подразделениями в Германии. Руководство осуществляется гражданами Евросоюза. Компания обязана соблюдать европейские законы и действовать в интересах AWS European Sovereign Cloud, а не сторонних игроков. Структура включает консультационный совет, который обеспечит поддержку в вопросах, связанных с обеспечением суверенитета — он состоит из двух топ-менеджеров Amazon и двух независимых участников, все — граждане и резиденты Евросоюза. Стефан Исраэль (Stéphane Israël) возглавит AWS European Sovereign Cloud, управляющим директором назначен Штефан Хохбауэр (Stefan Hoechbauer) — вице-президент AWS Global Sales Germany and Europe Central. Изначально пользователи AWS European Sovereign Cloud получат доступ к более 90 сервисам в разных категориях, включая ИИ, вычисления, базы данных, сервисы безопасности, хранения и др. Партнёры AWS пообещали предоставлять свои решения и для нового облака: Accenture, adesso, Adobe, Arvato Systems, Atos, Capgemini, Dedalus, Deloitte, Genysys, Kyndryl, Mistral AI, msg group, NVIDIA, SAP, SoftwareOne и многие другие. В долгосрочной перспективе Amazon намерена инвестировать более €7,8 млрд в инфраструкту в Германии. Это должно добавить ВВП Германии приблизительно €17,2 млрд. Расширение облака в Бельгию, Нидерланды и Португалию потребует дополнительных инвестиций и поможет развитию местных экономик. Как сообщает CNBC, в последнее время европейские политики и регуляторы всё больше обеспокоены доминированием американских техногигантов, в том числе в сфере критически важной IT-инфраструктуры. Несмотря на то, что Европа стимулирует развитие бизнеса региональными компаниями, по данным Synergy Research Group на долю AWS, Microsoft и Google приходится около 70 % облачного рынка в регионе. При этом не так давно Microsoft признала, что не способна обеспечить европейским данным настоящий суверенитет и будет вынуждена пойти навстречу американским властям, если те будут делать запросы в соответствии с законами США, хотя несколько ранее компания, как и Google, предложили собственные «суверенные» решения для европейского рынка.

19.12.2025 [09:57], Руслан Авдеев

Amazon купила за €225 млн заброшенную британскую угольную электростанцию Didcot A, чтобы переделать её в дата-центрDeutsche Bank сообщил о сделке немецкой RWE AG (Rheinisch-Westfälisches Elektrizitätswerk) с Amazon. Гиперскейлер приобрёл у энергокомпании неработающую угольную электростанцию Didcot A в Великобритании, сообщает Bloomberg. Как заявили в Deutsche Bank AG, в будущем RWE может хорошо заработать на подобных сделках. В ноябре RWE объявила, что выручила €225 млн ($265 млн) от продажи простаивающего в Великобритании крупного энергетического объекта, но имя покупателя не раскрыла. В Deutsche Bank также не пожелали сообщать, откуда получили информацию. Угольно-нефтяная электростанция Didcot A мощностью 1,44 ГВт заработала в 1970 году, но была фактически разобрана в 2014–2020 гг. Год назад стало известно, что оператор ЦОД CloudHQ намерен построить в интересах AWS 84-МВт кампус за £1,9 млрд ($2,48 млрд), расположенный по соседству с электростанцией Didcot. Разрешение на строительство кампуса общей площадью до 55 тыс. м2 было получено ещё в 2021 году. Впрочем, тогда AWS действовала под «псевдонимом» Willow Developments LLC. Сейчас речь идёт о сносе существующего строения и прочих конструкций на площадке, очистка площадки и постройка одного здания ЦОД. Окончательно решение по проекту должно быть принято в марте 2026 года. Также Amazon подала заявку на получение разрешения на строительство кампуса ЦОД в Ивере (Iver, Баингемшир) на территории распределительного центра Ridgeway Distribution Centre в октябре 2025 года. Пока компания имеет в Великобритании облачный регион в рауоне Бристоля (хотя называется он London), запущенный в 2016 году. Он связан с другими проектами — в Бедфордшире, Мидлсексе, Уилтшире и Беркшире. Акции RWE почти достигли максимума стоимости, зарегистрированного 14 лет назад, поскольку эксперты рынка и инвесторы ожидают больше сделок такого рода. В ходе финансового отчёта RWE объявила, что уже работает над десятком аналогичных сделок в Великобритании, Германии и Нидерландах. Операторам дата-центров в последнее время всё интереснее подобные объекты и даже действующие электростанции, поскольку так проще масштабировать свою деятельность с ростом спроса на вычисления. Дополнительным преимуществом является то, что даже заброшенные площадки нередко по-прежнему подключены к электросетям, так что тратиться на присоединение или постройку энергетической инфраструктуры не надо. По расчётам экспертов Deutsche Bank, каждая из планируемых новых сделок RWE составит 200 МВт, это возможность для компании получить €1,6 млрд, если опираться на характер сделки с Amazon. К 2030 году RWE, возможно, заключит соглашения на €900 млн. В 2024 году RWE уже продала Microsoft земельный участок в районе добычи бурого угля в Рейнской области, сумма не раскрывается. Там IT-гигант намерен построить крупный дата-центр. Сектор бывших и действующих энергообъектов осваивают и другие компании. В США изучается возможность строительства на подобных площадках АЭС для долгосрочного обеспечения ЦОД энергией, а Министерство энергетики США (DoE) выделило свои земли для ускоренного строительства ЦОД и электростанций. А у AWS уже есть собственный кампус непосредственно на терртории АЭС Susquehanna. Британская Drax Group намерена развернуть на своём объекте в северной Англии 1 ГВт мощностей ЦОД, первые объекты должны заработать к 2027 году. Испанская энергокомпания Iberdrola SA предлагает свои земли и энергию в обмен на долю в новых проектах ЦОД. Французская государственная энергокомпания EDF (Électricité de France) также готова предложить дата-центрам и землю, и энергию своих АЭС и переделать старые ТЭС в ЦОД.

17.12.2025 [16:41], Владимир Мироненко

Amazon не прочь инвестировать $10 млрд в OpenAI и дать стартапу фирменные ИИ-ускорители TrainiumAmazon ведет переговоры с OpenAI о возможных инвестициях более $10 млрд в стартап, предоставлении ему ускорителей серии Trainium и сдаче в аренду дополнительных вычислительных мощностей, сообщила газета The Financial Times. По словам её источников, знакомых с ситуацией, в случае заключения сделки капитализация OpenAI может превысить $500 млрд. Впрочем, переговоры находятся на ранней стадии и говорить об этом пока рано. Переговоры проходят после пересмотра первоначальной сделки стартапа с его ранним инвестором Microsoft. Компании реструктурировали свои отношения, что позволило OpenAI заключить соглашения об использовании вычислительных мощностей конкурирующих с Microsoft облачных провайдеров. В частности, стартап подписал сделку с Amazon, обязавшись потратить $38 млрд на аренду ИИ-ускорителей NVIDIA в течение семи лет. Обсуждаемое сейчас соглашение об инвестициях и облачных сервисах будет заключено в дополнение к этому соглашению. Ранее OpenAI обязался использовать сервисы Azure на $250 млрд. Microsoft сохраняет эксклюзивные права на передовые модели OpenAI до 2032 года. На данный момент стартапом заключены соглашения на сумму $1,5 трлн с NVIDIA, Oracle, AMD и Broadcom на поставку чипов и услуги вычислительной инфраструктуры. Циклический характер заключённых OpenAI сделок, а также отсутствие понятных механизмов коммерциализации ИИ и обоснованных расчётов стартапа по обеспечению окупаемости инвестиций, вызывает обеспокоенность некоторых инвесторов, считающих, что ИИ-индустрия находится на пути к формированию пузыря. OpenAI не единственная, кто заключает сделки с поставщиками. Например, разработчик ИИ-моделей Anthropic, привлёк в общей сложности около $26 млрд инвестиций от Amazon, Google, Microsoft и NVIDIA, используя их оборудование и сервисы. Amazon является одним из крупнейших инвесторов Anthropic. С 2023 года она вложила в стартап около $8 млрд. Обсуждаемая с Amazon сделка также знаменует собой еще один шаг в попытках OpenAI диверсифицировать чипы, используемые для обучения и запуска своих моделей. Источники сообщили, что Amazon и OpenAI также обсуждают коммерческое сотрудничество, связанное с маркетплейсом технологического гиганта. Стартап стремится закрепиться в сфере электронной коммерции и уже заключил сделки с Etsy, Shopify и Instacart с целью создания новых источников дохода. |

|