Материалы по тегу: aws

|

04.12.2025 [09:48], Владимир Мироненко

Частное ИИ-облако под ключ: Amazon представила AWS AI Factory для развёртывания в собственных ЦОД заказчиковAmazon представила AWS AI Factory — выделенную ИИ-инфраструктуру, включающую ускорители NVIDIA, чипы Trainium, а также сетевые решения, хранилища и базы данных AWS, которую можно развернуть в собственных ЦОД клиентов, обеспечивая их потребность в реализации суверенитета и соблюдении нормативных требований. «Клиенты могут использовать пространство своего существующего ЦОД, сетевое подключение и электроэнергию, в то время как AWS берет на себя все сложности развёртывания и управления интегрированной инфраструктурой», — пояснила компания. AWS отметила, что организации в регулируемых отраслях и государственном секторе при развёртывании своих масштабных проектов в сфере ИИ сталкиваются с проблемой их размещения в соответствующей требованиям инфраструктуре. Создание собственной ИИ-инфраструктуры требует значительных капиталовложений в покупку ускорителей, (до-)оснащение ЦОД и электроэнергию, а также сложных циклов закупок, выбора ИИ-модели для конкретного сценария использования и лицензирования моделей у разных поставщиков ИИ-технологий. Это требует много времени и усложняет эксплуатацию, отвлекая клиентов от основных бизнес-целей. AWS AI Factory позволяет решить эту проблему путём развёртывания готовой к использованию выделенной ИИ-инфраструктуры AWS в собственных дата-центрах клиентов. AWS AI Factory функционирует как частный облачный регион AWS, предоставляя безопасный доступ с низкой задержкой к вычислительным ресурсам, хранилищу данных, базам данных и ИИ-сервисам AWS для обучения и инференса ИИ-моделей. Кроме того, предоставляются управляемые сервисы, обеспечивающие доступ к ведущим базовым моделям без необходимости заключения отдельных контрактов с их поставщиками. Всё это помогает организациям соблюдать требования безопасности, суверенитета данных и нормам обработки и хранения данных, экономя усилия по развёртыванию и управлению инфраструктурой. Компания отметила, что AWS AI Factory разработаны в соответствии со строгими стандартами безопасности AWS, обеспечивая выполнение самых важных рабочих нагрузок на всех уровнях секретности: «Несекретно», «Конфиденциально», «Секретно» и «Совершенно секретно». AWS AI Factory — совместный проект AWS и NVIDIA, благодаря чему клиенты получат доступ к ПО NVIDIA и множеству приложений с ускорением на базе GPU. AWS Nitro и EC2 UltraClasters поддерживают платформы Grace Blackwell и Vera Rubin. AWS и NVIDIA также сотрудничают в рамках стратегического партнёрства с HUMAIN из Саудовской Аравии. AWS создаёт в Саудовской Аравии первую в своём роде «Зону искусственного интеллекта» (AI Zone) в кампусе HUMAIN, включающую до 150 тыс. ИИ-чипов, в том числе ускорители NVIDIA GB300 и Amazon Trainium, выделенную ИИ-инфраструктуру и ИИ-сервисы AWS.

03.12.2025 [13:25], Сергей Карасёв

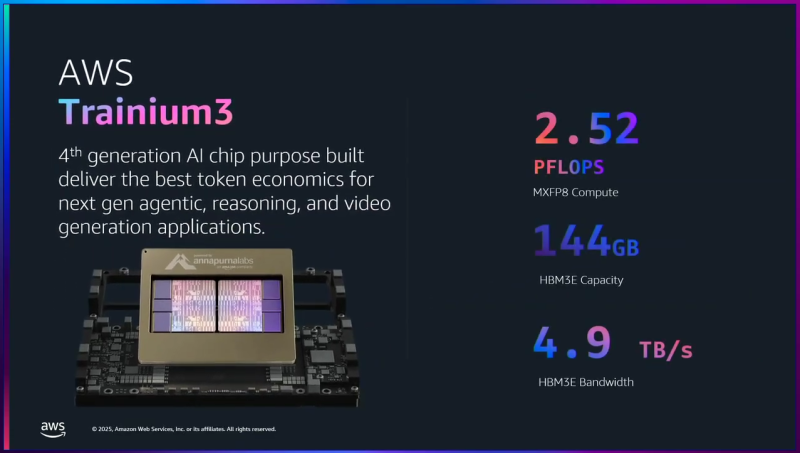

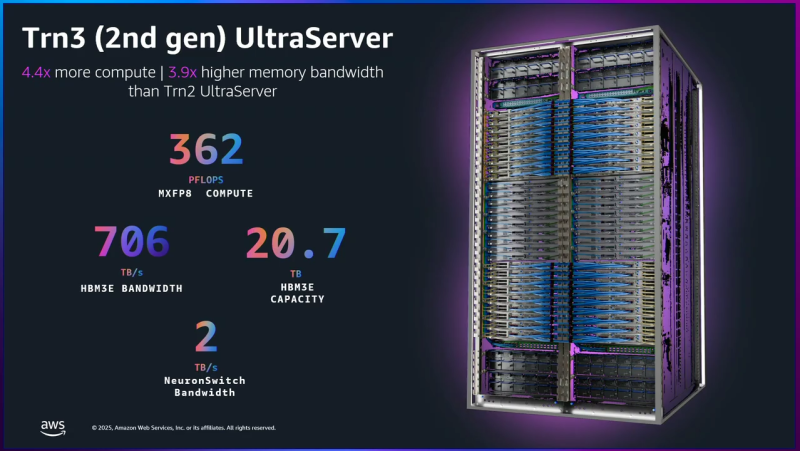

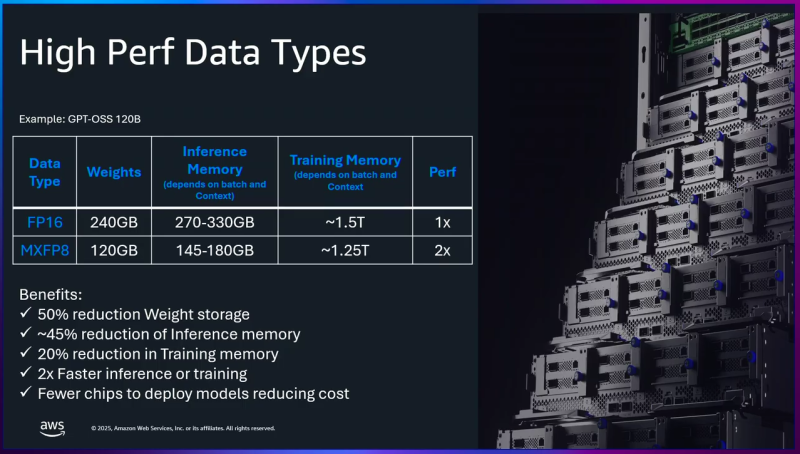

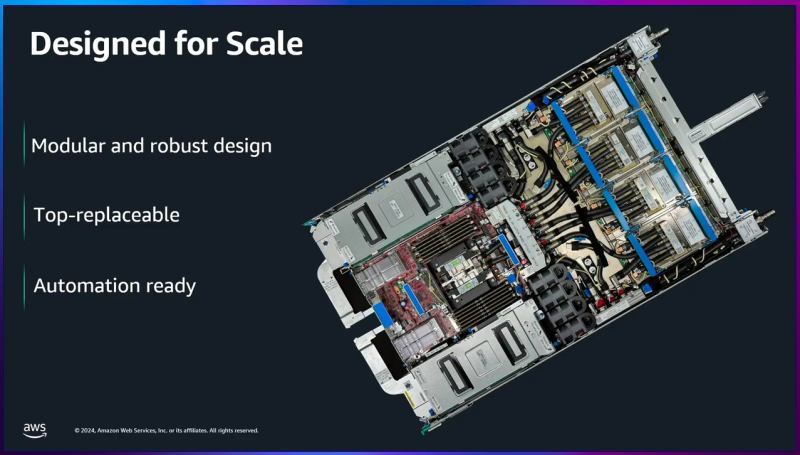

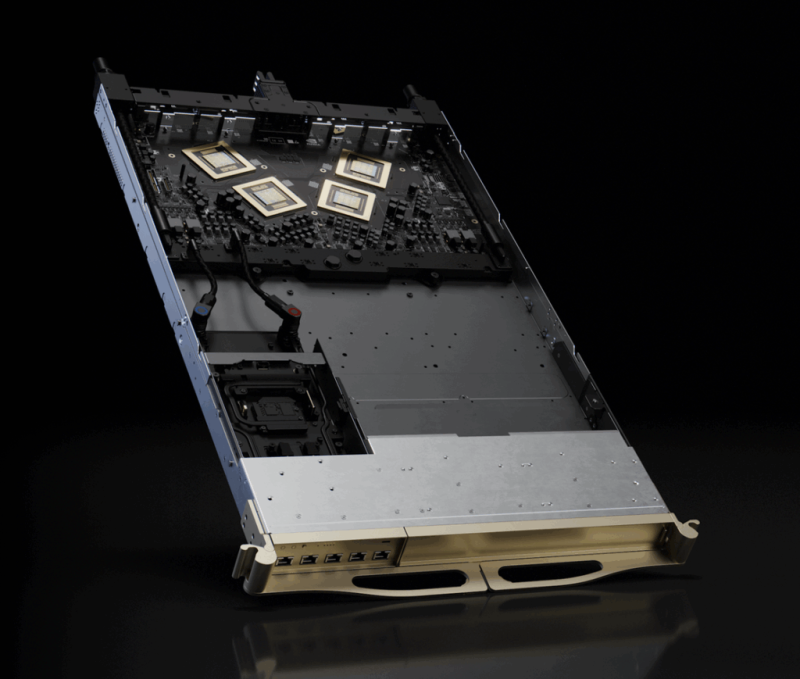

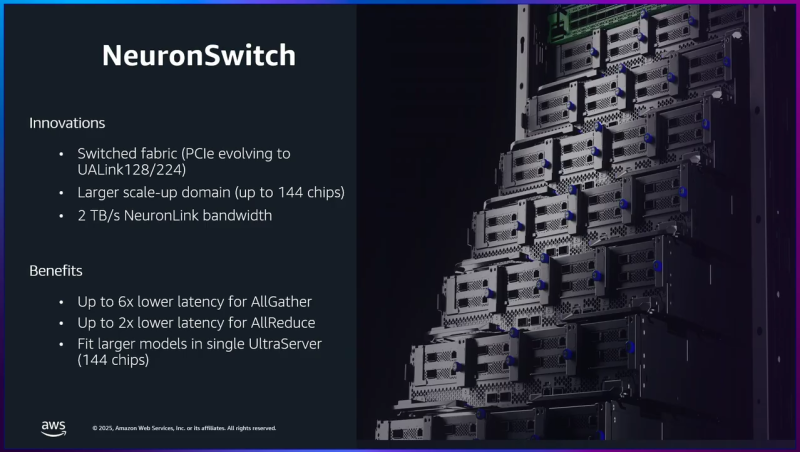

AWS представила ИИ-ускорители Trainium3: 144 Гбайт памяти HBM3E и 2,52 Пфлопс в режиме FP8Облачная платформа Amazon Web Services (AWS) анонсировала ускорители Trainium3 для задач ИИ, а также серверы Trainium3 UltraServer (Trn3 UltraServer). Эти машины, как утверждается, превосходят решения предыдущего поколения — Trainium2 UltraServer — в 4,4 раза по производительности, в 4 раза по энергоэффективности и почти в 4 раза по пропускной способности памяти. Чипы Trainium3 изготавливаются по 3-нм технологии TSMC. Они оснащены 144 Гбайт памяти HBM3E с пропускной способностью до 4,9 Тбайт/с. По сравнению с Trainium2 объём памяти увеличился в 1,5 раза, её пропускная способность — в 1,7 раза. Ранее сообщалось, что энергопотребление новых ускорителей может достигать 1 кВт. Изделие Trainium3 предназначено для высокоплотных и сложных параллельных рабочих нагрузок с использованием расширенных типов данных (MXFP8 и MXFP4). По утверждениям AWS, на операциях FP8 быстродействие достигает 2,52 Пфлопс. Для сравнения, AMD Instinct MI355X показывает результат в 10,1 Пфлопс, а чип поколения NVIDIA Blackwell — 9 Пфлопс. Как уточняет The Register, ускорители Trainium3 используют структурированную разрежённость (structured sparsity) формата 16:4, что фактически поднимает производительность в четыре раза — до 10 Пфлопс — на таких задачах, как обучение ИИ-моделей. Системы Trainium3 UltraServer объединяют 144 ускорителя Trainium3, которые соединены посредством интерконнекта NeuronSwitch-v1: эта технология, по оценкам AWS, увеличивает пропускную способность в два раза по сравнению с машинами UltraServer предыдущего поколения. Усовершенствованная сетевая архитектура Neuron Fabric сокращает задержки при передаче данных между чипами до менее чем 10 мкс. Каждая система Trainium3 UltraServer оперирует 20,7 Тбайт памяти HBM3E с общей пропускной способностью 706 Тбайт/с. Заявленная производительность достигает 362 Пфлопс в режиме FP8. Применённые в Trainium3 технологии, как заявляет AWS, дают возможность создавать приложения ИИ с практически мгновенным откликом. Платформа EC2 UltraClusters 3.0 позволяет объединять тысячи систем UltraServer, содержащих до 1 млн ускорителей Trainium, что в 10 раз больше, чем в случае изделий предыдущего поколения. При этом следующее поколение ускорителей Trainium4 получит интерконнект NVLink Fusion шестого поколения.

03.12.2025 [01:28], Владимир Мироненко

AWS «сдалась на милость» NVIDIA: анонсированы ИИ-ускорители Trainium4 с шиной NVLink FusionAWS готовит Arm-процессоры Graviton5, которые составят компанию ИИ-ускорителям Trainium4 с интерконнектом NVLink Fusion, фирменными EFA-адаптерам и DPU Nitro 6 с движком Nitro Isolation Engine. Но что более важно, все они будут «упакованы» в стойки стандарта NVIDIA MGX. Amazon и NVIDIA объявили о долгосрочном партнёрстве, в рамках которого ИИ-ускорители Trainium4 получит шину NVIDIA NVLink Fusion шестого поколения (по-видимому, 3,6 Тбайт/с в дуплексе), которая позволит создать стоечную платформу нового поколения, причём, что интересно, на базе архитектуры NVIDIA MGX, которая передана в OCP. Пикантность ситуации в том, что AWS годами практически игнорировала OCP, самостоятельно создавая стойки, их компоненты, включая СЖО, и архитектуру ИИ ЦОД в целом. Даже в нынешнем поколении стоек с GB300 NVL72 отказалась от референсного дизайна NVIDIA. NVIDIA же напирает на то, что для гиперскейлерам крайне трудно заниматься кастомными решениями — циклы разработки стоечной архитектуры занимают много времени, поскольку помимо проектирования специализированного ИИ-чипа, гиперскейлеры должны озаботиться вертикальным и горизонтальным масштабированием, интерконнектами, хранилищем, а также самой конструкцией стойки, включая лотки, охлаждение, питание и ПО.

Источник изображения: NVIDIA Вместе с тем управление цепочкой поставок отличается высокой сложностью, так как требуется обеспечить согласованную работу десятков поставщиков, ответственных за десятки тысяч компонентов. И даже одна задержка поставки или замена одного компонента может поставить под угрозу весь проект. Платформа NVIDIA если не устраняет целиком, то хотя бы смягчает эти проблемы, предлагая готовые стандартизированные решения, которые могут поставлять множество игроков рынка. По словам NVIDIA, в отличие от других подходов к масштабированию сетей, NVLink — проверенная и широко распространённая технология. В сочетании с фирменным ПО NVLink Switch обеспечивает увеличение производительности и дохода от ИИ-инференса до трёх раз, объединяя 72 ускорителя в одном домене. Пользователи, внедрившие NVLink Fusion, могут использовать любую часть платформы — каждый компонент может помочь им быстро масштабироваться для удовлетворения требований интенсивного инференса и обучения моделей агентного ИИ, говорит NVIDIA. Что касается самих ускорителей Trainium4, то в сравнении с Trainium3 они будут вшестеро быстрее в FP4-расчётах, втрое быстрее в FP8-вычислениях, а пропускная способность памяти будет увеличена вчетверо. Впрочем, пока собственные ускорители Amazon не всегда могут составить конкуренцию чипам NVIDIA. Любопытно и то, что в рассказе о Trainium3 компания отметила о переходе от PCIe к UALink в коммутаторах NeuronSwitch для фирменного интерконнекта NeuronLink, объединяющего до 144 чипов Trainium. Однако после крупных инвестиций NVIDIA в Synopsys развитие UALink как открытой альтернативы NVLink теперь под вопросом.

02.12.2025 [09:15], Владимир Мироненко

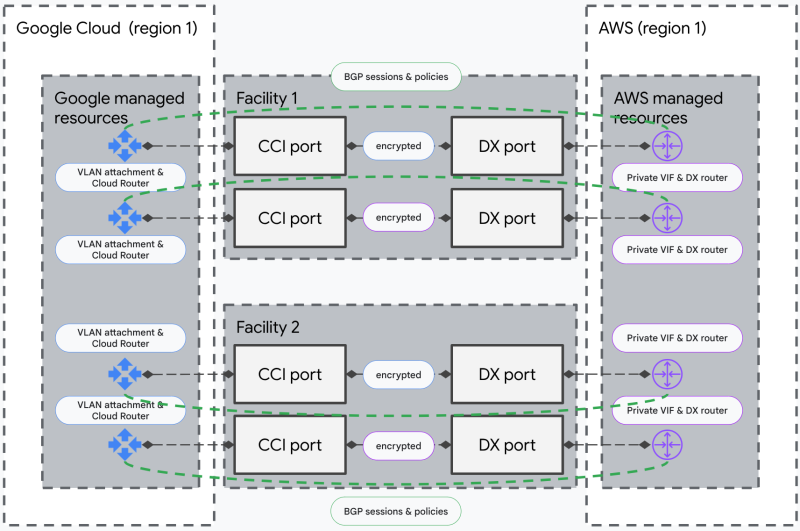

AWS и Google Cloud подружили свои облачные сети, чтобы интернет падал пореже и не у всех сразуAmazon и Google представили мультиоблачный сетевой сервис, разработанный совместными усилиями и призванный удовлетворить растущий спрос на надёжное подключение, в то время как даже кратковременные перебои в работе интернета могут привести к серьезным сбоям в работе сервисов. Новый сервис объединяет AWS Interconnect – multicloud и Google Cross-Cloud Interconnect, предлагая организациям возможность установления защищённых частных высокоскоростных сетевых соединений между Google Cloud и AWS, что обеспечивает онлайн-бизнесу подстраховку в случае сбоя в работе одного из провайдеров. Кроме того, сервис упрощает одновременное использование облачных услуг обоих провайдеров в рамках одного приложения. Теперь компании смогут за считанные минуты установить соединение между вычислительными платформами через выбранную облачную консоль или API. Как отметила Google Cloud, ранее для подключения провайдеров облачных услуг клиентам приходилось вручную настраивать сложные сетевые компоненты, включая физические соединения и оборудование. Это требовало длительного времени на подготовку и координации с несколькими внутренними и внешними командами, и могло занять недели или даже месяцы. Сервис предлагает подключение выбранной ёмкости между двумя облачными регионами обоих провайдеров с четырёхкратным резервированием на уровне ЦОД, пограничных маршрутизаторов и т.д. Оба поставщика осуществляют непрерывный мониторинг для проактивного выявления и устранения проблем, а также совместно управляют резервированием и занимаются эксплуатационной поддержкой. Шифрование MACsec защищает соединения между периферийными маршрутизаторами AWS и Google Cloud. Партнёры также выпустили унифицированный API и открытую спецификацию, предложив другим поставщикам облачных и сетевых услуг фреймворк для интеграции аналогичных мультиоблачных подключений. Благодаря новому сервису клиенты, использующие в работе несколько облаков, получают стандартизированный подход к гибридному перемещению данных, рабочих ИИ-нагрузок и кросс-облачной аналитике.  Salesforce в числе первых внедрила эту технологию. В компании отметили, что интеграция Salesforce Data 360 с более широким ИТ-ландшафтом требует надёжного частного подключения. AWS Interconnect – multicloud позволяет наводить критически важные мосты с Google Cloud с той же лёгкостью, что и развёртывание внутренних ресурсов AWS. В октябре в AWS произошел крупный сбой, который вывел из строя ряд сервисов, включая Fortnite, Alexa и Snapchat. В последующие недели сбои наблюдались и в Microsoft Azure, и в Cloudflare, что вызвало опасения по поводу рисков, связанных с использованием лишь нескольких крупных поставщиков интернет-инфраструктуры. AWS планирует развернуть аналогичный сервис с Microsoft Azure в следующем году. Ранее AWS, Google Cloud и Microsoft Azure уже сделали шаг навстречу другу другу, отказавшись от платы за выгрузку данных при переезде в другое облако.

26.11.2025 [17:49], Руслан Авдеев

AWS вложит $26 млрд в ИИ-инфраструктуру в Индиане, покрыв расходы на новые ЛЭП и электростанции для своих ЦОДКомпания Amazon (AWS) намерена вложить $15 млрд в ИИ-инфраструктуру в Индиане в дополнение к $11 млрд, выделенным на ЦОД в округе Сен-Жозеф (St. Joseph County). Компания намерена нарастить мощности ЦОД в регионе на 2,4 ГВт, открыв в штате новые кампусы. Подробности не разглашаются, но известно, что в 2023 году компания хотела построить новый кампус в Портидже (Portage, округ Портер), и даже получила небольшие налоговые льготы. Строительство кампуса стоимостью $11 млрд в Нью-Карлайле (New Carlisle, округ Сен-Жозеф) началось в октябре. Кампус, вероятно, будет состоять из 22 зданий, причём минимум треть достанется ИИ-суперкластеру Project Rainier. В Amazon подчёркивают, что все новые объекты в штате изначально проектировались с учётом возможного масштабирования и оптимизированы для ИИ, ML и облачных приложений нового поколения с поддержкой отраслевых стандартов устойчивого развития. В данном случае интересно и то, что AWS договорилась с местной коммунальной компанией NIPSCO о защите жителей и малого бизнеса от повышения тарифов на электричество. Они, как утверждается, смогут сэкономить около $1 млрд за 15 лет. AWS будет платить за использование ЛЭП и покрывать расходы на любые новые электростанции, новые линии и оборудование, необходимые для питания очередных ЦОД компании. Общий объём введённых мощностей может достигнуть 3 ГВт, из которых 2,4 ГВт достанутся дата-центрам Amazon. С 2010 года Amazon инвестировала в Индиану более $31,3 млрд, увеличив местный ВВП на более чем $29,9 млрд и поддержав создание 24,5 тыс. рабочих мест разного характера, а также 27,5 тыс. «косвенных» рабочих мест на разных объектах. Собственные ЦОД в штате строят Meta✴, Microsoft и Google.

26.11.2025 [09:50], Руслан Авдеев

У Amazon насчитали более 900 ЦОД в полусотне стран, но компании всё равно этого малоИнфраструктура ЦОД Amazon, вероятно, гораздо масштабнее, чем принято считать. Выяснилось, что более 50 стран стали прибежищем для свыше 900 дата-центров компании, включая совсем небольшие объекты для периферийных сервисов, сообщает Bloomberg со ссылкой на данные SourceMaterial. Крупнейшие кампусы AWS находятся в США, в Вирджинии и Орегоне. Однако у компании есть множество как собственных ЦОД, так и арендованных на долгий срок объектов. Компания размещает стойки в сотнях колокейшн-ЦОД, при этом на них приходится лишь приблизительно 20 % всех вычислительных мощностей AWS. Где-то AWS размещает всего несколько стоек, а где-то, как во Франкфурте и Токио, арендует крупные ЦОД целиком. Согласно документам об энергопотреблении, крупнейшие арендуемые AWS ЦОД, вероятно, расположены во Франкфурте, Монреале, Мумбаи, Сеуле, Сингапуре и Токио или окрестностях этих мегаполисов. Точное местоположение дата-центров не раскрывается, но документы дают некоторое представление о возможностях компании. Они же свидетельствуют о том, что AWS является одним из крупнейших в мире арендаторов колокейшн-площадей. По словам New Relic, помогающей бизнесам управлять технологической инфраструктурой, помимо крупных ЦОД у гиперскейлеров обычно есть и более мелкие облачные объекты, но провайдеры не любят раскрывать их локации. Всего на начало 2024 года AWS пользовалась услугами более 440 колокейшн-ЦОД. Ещё более 220 дополнительных объектов относятся к периферийным, так что полноценными дата-центрами их назвать сложно. Они часто размещаются рядом с мегаполисами и на территории телеком-хабов. Как сообщают в AWS, хотя компания владеет и управляет большинством своих ЦОД, используются и возможности сторонних организаций, чтобы быстро реагировать на меняющиеся требования клиентов. При выходе на новые рынки или изменении спроса AWS опирается на сторонние компании, наращивая мощности для новых клиентов и ИИ-проектов. А, к примеру, в Китае, компания и вовсе обязана работать через местных партнёров. В конце 2023 года Amazon заявила, что имеет втрое больше дата-центров, чем ближайший конкурент. Речь шла о Microsoft, которая в то время имела портфолио из 300 объектов. Baxtel говорит о присутствии Amazon в 449 ЦОД на 49 рынках. DC Byte оценивает парк AWS в 364 объекта в 33 странах. Впрочем, точно установить количество невозможно, поскольку соглашения об аренде обычно носят конфиденциальный характер. В целом, судя по документам, Amazon имеет соглашения, как минимум, со 180 организациями в рамках колокейшн-договоров. По имеющимся данным, компания владеет зданиями общей площадью более 2,4 млн м2 и ещё примерно столько же арендует. Несмотря на огромный парк ЦОД, дела у компании не всегда идут гладко. Не всегда она успевает за спросом и не всегда может обеспечить необходимое качество услуг. Так, согласно Business Insider, нехватка ИИ-мощностей AWS и проблемы с производительностью заставили многих клиентов обратиться к соперникам. Тем не менее, в III квартале облако Amazon принесло $33 млрд и остаётся самым прибыльным в компании, т.ч. только в этом году объём капитальных затрат составит $125 млрд. Масштабы бизнеса стали очевидны в октябре, когда сбой AWS вывел из строя онлайн-сервисы по всему миру.

25.11.2025 [16:24], Руслан Авдеев

Нехватка ИИ-мощностей и проблемы с производительностью вынудили многих клиентов AWS обратиться к конкурентамЛетом 2025 года облачный бизнес Amazon (AWS) с трудом справлялся с растущим спросом на ИИ и упустил часть доходов. Сервис Bedrock занимает ключевое место в развитии ИИ-проектов компании. Однако летом Bedrock столкнулся с нехваткой мощностей, из-за чего некоторые клиенты ушли к конкурентам, в том числе к Google, сообщает Business Insider. Это привело к потерям десятков миллионов долларов и отложенной выручки. Например, проект Fortnite стоимостью $10 млн достался Google Cloud после того, как AWS не смогла выделить ей необходимые квоты (лимит на токены или вызовы API). Согласно внутреннему документу AWS, попавшему в распоряжение журналистов, нефтетрейдер Vitol также перенёс проекты из AWS, а некоторые крупные клиенты, включая Atlassian и GovTech Singapore, летом были вынуждены ожидать увеличения квот, что привело к «отсроченным продажам» минимум на $52,6 млн. Более того, задержки с одобрением выделения мощностей и отказ в обработке нерегулярных, вынудили Stripe, Robinhood и Vanguard отказаться от переноса нагрузок в Bedrock. Подчёркивается, что проблемы Bedrock потенциально ведут к потерям выручки и проблемам с клиентами. Это объясняет, почему облачные компании стремятся построить как можно больше ИИ ЦОД. Высокий спрос хорош только тогда, когда можно его удовлетворить и удержать клиентов от перехода к конкурентам. Бывшие и действующие сотрудники AWS отмечают, что проблемы с вычислительными мощностями были одними из наиболее значимых для компании в сентябре. AWS и раньше испытывала проблемы с нехваткой мощностей даже для собственных нужд, но сейчас ситуация обострилась. Тем временем в Amazon утверждают, что Bedrock быстро растёт, а AWS стремительно наращивает мощности для удовлетворения спроса, за 12 месяцев добавив 3,8 ГВт. Это больше, чем смогу получить любой другой облачный провайдер. AWS удвоила мощность с 2022 года и намерена сделать то же самое к 2027 году. Компания и далее намерена быть «очень агрессивной» в деле масштабирования вычислительных мощностей, причём AWS может монетизировать новые мощности «практически незамедлительно», а Bedrock имеет не меньший потенциал роста, чем EC2. Частично проблемы с Bedrock могут быть связаны с тем, что компания отдаёт предпочтение крупным клиентам. В октябре заявлялось, что большинство задач Bedrock выполняется с помощью «доморощенных» ИИ-чипов Trainium, но в основном нагрузки приходятся на нескольких очень крупных клиентов, которые, по-видимому, готовы вкладываться в развитие инструментов на не самой популярной платформе. Ожидается, что компании среднего размера в ближайшие месяцы тоже начнут использовать Trainium нового поколения. Впрочем, последние иногда всё ещё не могут конкурировать с чипами NVIDIA. Впрочем, помешала Bedrock не только нехватка мощностей. Так, Figma, Intercom и Wealthsimple предпочли использовать LLM Claude в Google Cloud или на платформе самой Anthropic из-за недостатка функций и высокой задержки в Bedrock. Британская госслужба Government Digital Service рассматривала переход в Microsoft Azure только потому, что Claude 3.7 Sonnet работала медленнее на платформе Bedrock. Thomson Reuters также выбрала Google Cloud для своего ИИ-продукта CoCounsel, поскольку сервис AWS оказался на 15–30 % медленнее и не имел ключевых правительственных сертификатов. В документе AWS отмечается, что платформа Bedrock уступает Google. Для моделей Gemini квоты в пять-шесть раз выше, а Gemini Pro побеждает Claude в Bedrock во многих бенчмарках. Хуже того, Gemini Flash обеспечивает сравнимое качество при кратно меньших затратах. Некоторые стартапы буквально «сбежали» по этой причине. TainAI перенесла 40 % задач на Gemini Flash, отказавшись от Claude в Bedrock и экономя тем самым $85 тыс./день, а Hotel Planner намеревалась перейти в Google Cloud или к OpenAI. Всё это было ещё до запуска Gemini 3. Ещё более важная проблема, согласно документу, заключается в том, что у AWS нет целостного видения ИИ-инференса, хотя это ключевой сервис Bedrock. Это сыграло на руку не только гиперскейлерам, но и компаниями поменьше. Без чёткой стратегии AWS рискует упустить одну из самых привлекательных возможностей на рынке ИИ. Но этим проблемы не ограничиваются. Октябрьский сбой AWS продемонстрировал зависимость мировой Сети от лидера облачного рынка, так что многие задумались о переносе хотя бы части нагрузок на другие платформы, а Евросоюз рассматривает необходимость ограничения возможностей американских облачных гигантов. В последние недели инвесторы обеспокоены расходами на ИИ, опасаясь возникновения очередного пузыря на рынке IT. В этом контексте дефицит мощностей для Amazon играет двоякую роль. Это свидетельствует, что спрос со стороны клиентов до сих пор высок. С другой стороны, дефицит — ещё одна причина тратить больше денег в развитие инфраструктуры, что повышает риск возникновения пузыря. Amazon утверждает, что намерена выделить $125 млрд на капитальные затраты в текущем году, и ещё больше — в 2026-м.

25.11.2025 [14:05], Владимир Мироненко

AWS потратит $50 млрд на расширение облачных мощностей для правительства США: +1,3 ГВт на ИИ и HPCAmazon объявила о планах инвестировать до $50 млрд в расширение инфраструктуры ИИ и HPC для правительства США. Компания начнёт реализацию проектов в 2026 году и планирует добавить почти 1,3 ГВт вычислительной мощности в регионах AWS Top Secret, AWS Secret и AWS GovCloud (US) на всех уровнях секретности путём строительства новых ЦОД. Федеральные агентства получат расширенный доступ к комплексным ИИ-сервисам AWS, включая SageMaker, Bedrock, Nova и Anthropic Claude. Также в их распоряжение будут предоставлены ведущие модели класса open-weight foundation, ИИ-ускорители Trainium и ИИ-инфраструктура NVIDIA, что позволит им разрабатывать индивидуальные решения в области ИИ, оптимизировать большие наборы данных и повышать производительность труда, сообщила Amazon. Ранее AWS, Google, Oracle, Microsoft, xAI и др. IT-гиганты предоставили госслужбам США существенные скидки на облачные услуги в рамках программы OneGov. Это позволит государственным агентствам ускорить обработку информации и принятие решений. Интеграция ИИ с моделированием и имитацией позволит им решать за считанные часы самые сложные задачи, на которые раньше уходили недели или месяцы, а также «автоматически обнаруживать угрозы и разрабатывать планы реагирования», обрабатывая спутниковые снимки, данные датчиков и исторические закономерности в «беспрецедентном масштабе». «Наши инвестиции в специализированную правительственную инфраструктуру ИИ и облачные технологии коренным образом изменят подход федеральных агентств к использованию суперкомпьютинга, — заявил генеральный директор AWS Мэтт Гарман. — Мы предоставляем агентствам расширенный доступ к передовым возможностям ИИ, которые позволят им ускорить выполнение критически важных задач — от кибербезопасности до разработки лекарств. Эти инвестиции устраняют технологические барьеры, сдерживавшие развитие правительства, и укрепляют лидирующие позиции Америки в эпоху ИИ». Компания отметила, что этот шаг подчёркивает позицию AWS как лидера в области государственных облачных вычислений, поддерживающего более 11 тыс. государственных учреждений. AWS уже давно предоставляет правительству США выделенные облачные регионы. В 2011 году она запустила AWS GovCloud (US-West), AWS Top Secret-East — изолированное облако для секретных рабочих нагрузок — в 2014 году, AWS Secret Region — в 2017 году, с 2018 года добавила второй регион GovCloud (US-East), AWS Top Secret-West, а в октябре 2025 года — AWS Secret-West. Компания не раскрывает точное местоположение ЦОД и регионов. Как пишет Data Center Dynamics, другие страны также доверяют AWS свою самую секретную информацию. В Великобритании в 2021 году сообщили, что три британских разведывательных агентства использовали AWS для хранения совершенно секретных данных. В 2024 году AWS получила контракт стоимостью $1,3 млрд правительства Австралии на строительство ЦОД для совершенно секретной информации — спецслужбы получат возможность работы без использования открытого интернета.

21.11.2025 [14:14], Руслан Авдеев

AWS и Humain построят в Эр-Рияде кампус AI Zone, где развернут до 150 тыс. ИИ-ускорителей NVIDIA GB300 и Amazon TrainiumAWS и инвестиционная компания Humain из Саудовской Аравии объявили о планах развёртывания в кампусе AI Zone в Эр-Рияде до 150 тыс. ИИ-ускорителей. В рамках расширенного партнёрства компании намерены предоставлять вычислительные мощности и ИИ-сервисы из Саудовской Аравии клиентам со всего мира. Первый в своём роде в Саудовской Аравии кампус AI Zone будет применяться для обучения ИИ и инференса, с доступом к новейшей ИИ-инфраструктуре на основе ускорителей NVIDIA GB300 и Amazon Trainium. Клиенты смогут быстро переходить от стадии концепции к непосредственно работам, а «железо» и ПО NVIDIA будут бесшовно интегрированы с инфраструктурой и сервисами AWS. Поддержка Amazon Bedrock, AgentCore и SageMaker обеспечит клиентам немедленный доступ к базовым моделям в рамках единой платформы без необходимости управления базовой инфраструктурой. Для расширения возможностей AI Zone компания Humain присоединится к программе AWS Solution Provider Program. Это поможет реализации совместного плана, анонсированного в мае 2025 года и предусматривающего инвестиции более $5 млрд в ИИ-инфраструктуру, сервисы AWS, обучение и развитие ИИ-специалистов в Саудовской Аравии. Представитель AWS в регионе EMEA заявил, что объединяя локальный опыт и инвестиции Humain с решениями AWS в сфере ИИ, а также аппаратные решения NVIDIA, инновационную платформу Amazon Bedrock и решения для бизнес-пользователей, включая Amazon Quick Suite, партнёры создают инновационный центр мирового уровня, способный обслуживать клиентов по всему миру. AWS и Humain также ускорят внедрение ИИ в государственном и частном секторах, в том числе развитие LLM с поддержкой арабского языка, включая ALLAM, и создание единого маркетплейса ИИ-агентов для правительственных сервисов.

Истчоник изображения: backer Sha/unsplash.com Для подготовки квалифицированных кадров AWS обучит 100 тыс. граждан Саудовской Аравии работе с облачными технологиями и специфике генеративного ИИ в рамках программы Amazon Academy, отдельно планируется поддержать программу повышения квалификации для 10 тыс. женщин. Усилия направлены на подготовку кадров для «ИИ-центричной» экономики, которая, по прогнозам, к 2030 году внесёт в ВВП страны вклад в объёме $130 млрд. Подобные проекты стали возможны во многом благодаря визиту в США наследного принца Саудовской Аравии Мохаммеда бин Салмана (Mohammed bin Salman). Визит способствовал ряду соглашений американских компаний с саудовским бизнесом и Humain в частности — с участием AMD, xAI, NVIDIA и др., а также открыл дорогу для поставок в королевство передовых ИИ-чипов.

18.11.2025 [17:07], Руслан Авдеев

Евросоюз рассматривает необходимость ограничения возможностей американских облачных гигантовЕвросоюз рассматривает возможность ужесточения контроля за деятельностью облачных гигантов AWS, Microsoft Azure и Google Cloud, передаёт Bloomberg. Анитимонополные регуляторы намерены принять решение, следует ли ввести дополнительные ограничения для кого-либо из этих гиперскейлеров в соответствии с действующим в ЕС законом Digital Markets Act (DMA), сообщает издание со ссылкой на источники, «знакомые с ситуацией». План расследования разработан после ряда крупных сбоев в облачном секторе — они привели к хаосу в работе глобальных служб и стали дополнительным свидетельством того, что не стоит опираться лишь на нескольких крупных игроков. Речь о крупных сбоях AWS и Microsoft Azure. Пока облачные гиперскейлеры не подпадали под действие DMA, поскольку большая часть их деятельности связана с корпоративными контрактами, что затрудняет подсчёт индивидуальных пользователей их сервисов. Именно их количество может послужить для ЕС одним из главных оснований для введения дополнительного надзора за облачными сервисами из США.

Источник изображения: Jon Del Rivero/unspalsh.com В рамках расследования регуляторы оценят, стоит ли заставлять ведущих операторов брать на себя новые обязательства, включая повышение уровня совместимости с конкурирующим ПО (что особенно актуально для Microsoft) и упрощение переноса данных пользователей от одного облачного провайдера к другому. Кроме того, не исключены запреты на обязательную продажу пакетов услуг или ПО без возможности купить их по отдельности, а также ограничения на стимулирование подобных «пакетных» продаж. Еврокомиссия и представители гиперскейлеров ситуацию пока не комментируют. Закон DMA, принятый ЕС в 2023 году, призван ограничить деятельность крупнейших IT-гигантов, устанавливая ряд правил и запретов. Пока они не применялись против крупных облачных провайдеров, контролирующих значительную долю рынка. Если облачные сервисы в итоге будут признаны подпадающими под правила DMA, штрафы за их нарушения могут быть весьма чувствительными даже для гиперскейлеров. Например, Apple и Meta✴ уже почувствовали жёсткость закона на себе, заплатив штрафы €500 млн ($579 млн) и €200 млн ($231 млн) соответственно. |

|