Материалы по тегу: anthropic

|

12.02.2026 [16:47], Руслан Авдеев

Anthropic пообещала, что её ИИ ЦОД не повлияют на счета за электричество обычных граждан, но есть один нюансИИ-стартап Anthropic обязался компенсировать любые повышения цен на электричество для обычных потребителей, связанные с высокой энергоёмкостью её дата-центров, сообщает The Register. Как заявляет компания, ответственное развитие ИИ не должно ограничиваться только совершенствованием технологий, оно должно касаться и инфраструктуры, лежащей в основе новых решений. Расходы на обеспечение работы ИИ-моделей Anthropic должны лечь на саму компанию, хотя США остро нуждается в инфраструктуре ИИ ЦОД. По словам главы стартапа Дарио Амодеи (Dario Amodei), это не должно сказываться на рядовых американцах. Anthropic обещает полностью компенсировать расходы на модернизацию электросетей, обязательную для подключения её дата-центров — она будет осуществляться за счёт повышения платы за потребляемое электричество. Строительство и обслуживание электростанций, подстанций, ЛЭП и другой инфраструктуры обходится весьма дорого, а активы коммунальных предприятий со временем подвержены износу. Это не может не влиять на цену электроэнергии, на счета влияет и система гибкого ценообразования в зависимости от спроса в конкретные день или время. Дополнительно Anthropic рассматривает возможное внедрение «систем ограничения потребления электроэнергии» для снижения нагрузки на электросети в периоды пиковых нагрузок, а также внедряет СЖО для уменьшения энергозатрат.

Источник изображения: Jon Moore/unsplash.com Впрочем, такие меры вряд ли повлияют на сложившуюся ситуацию существенно, поскольку Anthropic готова нести ответственность только за принадлежащие ей самой ЦОД, которых в масштабах США очень мало. В аренде у Anthropic находятся значительные мощности и ИИ-ускорители, принадлежащие, в частности, Amazon, Google и Microsoft. Одна только сделка с Microsoft предполагает развёртывание дополнительного гигаватта мощностей. В ноябре 2025 года компания объявила об инвестициях $50 млрд в американскую инфраструктуру вычислений совместно с занимающейся строительством дата-центров FluidStack. В частности, речь идёт о ЦОД в Техасе, Нью-Йорке и др., уже имеется дата-центр на юго-востоке Луизианы. На арендованные мощности обязательства стартапа не распространяются, хотя в таких случаях тот исследует возможности решить проблему влияния нагрузки на цены. Anthropic попросила помощи у Вашингтона, заявив, что действий на уровне отдельных компаний недостаточно и для обеспечения доступности электричества нужны системные изменения. Компания подчеркнула, что поддерживает федеральную политику, в т.ч. реформу системы выдачи разрешений и меры, принимаемые для ускорения развития передающих сетей и межсетевых подключений. Это позволяет быстрее и дешевле вводить в эксплуатацию новые источники энергии. На фоне растущего противодействия массовому строительству дата-центров администрация президента США Дональда Трампа (Donald Trump) оказывает системное давление на гиперскейлеров, предлагая добровольно принять меры, предотвращающие резкое увеличение счетов за электричество и воду для жителей, если это связано с деятельностью самих IT-компаний. Например, Microsoft уже обязалась обеспечить формат работы, при котором работа её ЦОД не приведёт к увеличению коммунальных платежей для обычных потребителей, а Трамп заявил, что американцы не должны оплачивать модернизацию инфраструктуры для ИИ ЦОД.

12.02.2026 [15:29], Руслан Авдеев

MGX из ОАЭ готова вложить сотни миллионов долларов в Anthropic, которой потребовались ещё $20 млрд инвестицийГосударственный группа MGX Fund Management Limited (MGX) из ОАЭ ведёт переговоры о том, чтобы присоединиться к новейшему раунду инвестиций в американскую ИИ-компанию Anthropic, сообщает Bloomberg. Компания рассматривает возможность вложить сотни миллионов долларов в Anthropic в рамках раунда финансирования, в ходе которого планируется привлечь $20 млрд, об этом сообщили изданию источники, знакомые с вопросом на условиях сохранения анонимности. Информация о предложении инвестиций, вероятно, официально появится в ближайшие дни. Впрочем, окончательное решение пока не принято, а масштаб и структура инвестиций ещё могут измениться. Представители MGX и Anthropic слухи пока не комментируют. Anthropic, в меру сил конкурирующая с OpenAI, изначально рассчитывала привлечь $10 млрд, но теперь намерена получить больше средств и довести оценку капитализации до $350 млрд, отчасти благодаря «избыточному» интересу инвесторов. В ходе последнего раунда финансирования компания получила по $1 млрд от Coatue Management, сингапурской GIC Pte и Iconiq Capital. С тех пор компания считается весьма успешным бизнесом, более чем удвоив темпы роста годовой выручки. Недавно она представила новую версию своей наиболее мощной модели, предназначенной для проведения финансовых исследований, вскоре после её экспансии в сферу юридических услуг произошёл обвал акций традиционных разработчиков профильного ПО.

Источник изображения: Centre for Ageing Better/unsplash.com MGX преуспела в качестве активного инвестора в ИИ и смежные технологии. MGX является одной из компанией, поддерживающих проект Stargate компании OpenAI, а также планы строительства ЦОД французской Mistral AI. В прошлом году MGX и BlackRock приобрели Aligned Data Centers за $40 млрд, это крупнейшая сделка подобного рода на рынке ИИ в 2025 году. В январе 2026 года BlackRock сообщила, что привлекла $12,5 млрд для инвестиционного ИИ-партнёрства, поддерживаемого MGX, Microsoft, NVIDIA и xAI. В том же месяце MGX приобрела 15 % в американской, недавно сформированной части TikTok. Также компания тесно связана с ещё одним инвестором из ОАЭ — ИИ-компанией G42, участвующей в проекте строительства кампуса Stargate в стране и заключившей крупную сделку с Cerebras. Последний раунд финансирования даст возможность почти удвоить капитализацию Anthropic. Он пройдёт всего через пять месяцев после того, как компания уже привлекла $13 млрд при значительном участии катарского фонда Qatar Investment Authority. Этот раунд стал поворотным моментом для Anthropic. Глава компании Дарио Амодеи (Dario Amodei) попытался объяснить, почему компания оправдывает привлечение ближневосточных денег несмотря на риск обвинения в лицемерии, назвав это необходимым компромиссом. В ходе тура по ближневосточным странам в октябре 2025 года, Амодеи встретился с представителями MGX, чтобы обсудить привлечение дополнительных средств.

21.01.2026 [17:07], Руслан Авдеев

Глава Anthropic: продажа H200 в Китай равнозначна поставкам ядерного оружия Северной КорееГенеральный директор Anthropic Дарио Амодеи (Dario Amodei) недоволен тем, что США разрешили NVIDIA продавать китайским компаниям передовые ИИ-ускорители. Он сравнил это решение с раздачей ядерного оружия противникам, сообщает The Register. По словам Амодея, выступившего на Международном экономическом форуме в Давосе, руководители китайских компаний заявляют, что эмбарго на поставку американских чипов сдерживает их развитие. Он заявил, что продавать эти чипы — большая ошибка. Ранее США разрешили поставки ускорителей NVIDIA H200 китайским покупателям с пошлиной 25 %. Теперь слово за китайскими властями, которым ещё предстоит разрешить такие сделки. Anthropic желает, чтобы экспорт ИИ-технологий, наоборот, ужесточился — это заметно контрастирует с позициями NVIDIA и AMD, которые предупреждают, что запреты на экспорт только способствуют развитию ИИ-технологий в КНР. При этом на Китай приходится около половины исследователей в области искусственного интеллекта. Ранее Anthropic утверждала, что США и так лидируют в сфере ИИ-полупроводников, а экспортный контроль, на фоне того, что вычислительные мощности чипов удваиваются каждые два года, замедляет развитие Китая и укрепляет лидерство США. Компания уверена, что США на годы опережают Китай в способности выпускать передовые чипы. Доступ к американским разработкам позволит китайским создателям ПО вроде DeepSeek оказаться в лучшей позиции для конкуренции с Западом. При этом, как сообщает The Register, многие из наиболее производительных китайских LLM относятся к open source, поэтому их может использовать любой желающий, не опасаясь того, что данные его компании попадут в обучающий датасет, тогда как LLM американских компаний в основном «скрыты» за API, а сами компании расплывчато обещают не использовать пользовательские данные для обучения своих ИИ. При этом суды полны исков пользователей, связанных с нарушением прав на интеллектуальную собственность.

Источник изображения: CDC/unspalsh.com Слова Амодеи о том, что китайские разработчики LLM угрожают американскому бизнесу, слегка сгущают краски, но всё может действительно измениться, если китайские компании смогут импортировать передовые ускорители из США. Пока же, по словам бизнесмена, ИИ из КНР производителен только «на бумаге», а системы якобы специально оптимизируют для бенчмарков. Так или иначе, корпоративные пользователи действительно имеют немного вариантов, если желают получить доступ к хорошим открытым моделям — они в основном из Китая. Сама Anthropic называет главными конкурентами не стартапы из КНР, а OpenAI, Google и, чуть реже, другие американские компании. Anthropic пока не выкладывала ни одну из своих флагманских моделей в открытый доступ, но участвовала в нескольких совместных проектах с избранными клиентами, самым значимым из которых является AWS. Амодеи подчеркнул, что его продукты почти ни разу не проиграли в борьбе за контракт ИИ-модели из Поднебесной. Ключевое слово — «почти». Это означает, что китайским разработчикам всё-таки удавалось одержать верх несмотря на сложную ситуацию, в которой они находятся из-за экспортных ограничений. Компания последовательно критикует инициативы, способные обеспечить сотрудничество Запада с Китаем и даже не приветствует взаимодействие с другими мировыми игроками. Так, летом 2025 года сообщалось, что она намерена привлечь инвестиции с Ближнего Востока, но только потому, что избежать работы с регионом не удастся. В 2024 году Anthropic даже отказалась от инвестиций из Саудовской Аравии по соображениям «национальной безопасности».

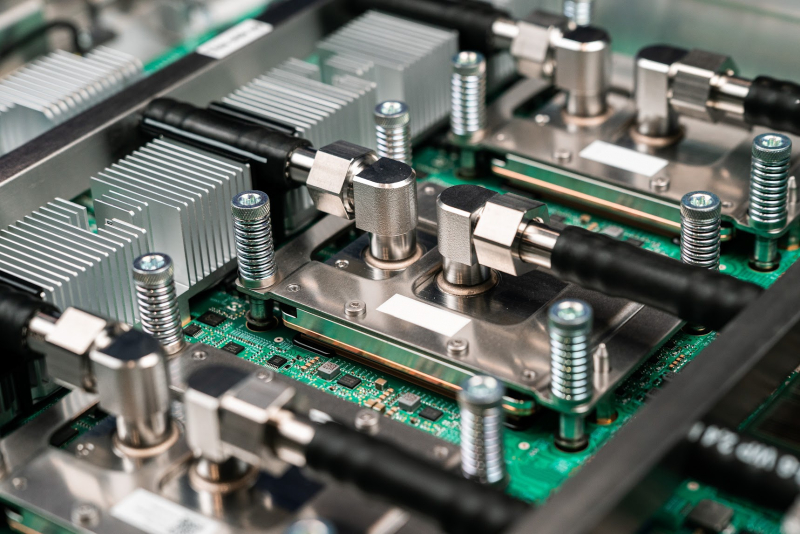

05.01.2026 [18:25], Владимир Мироненко

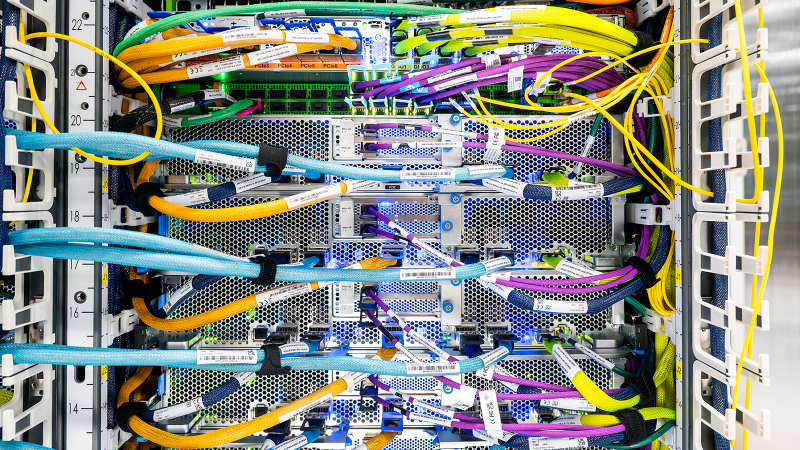

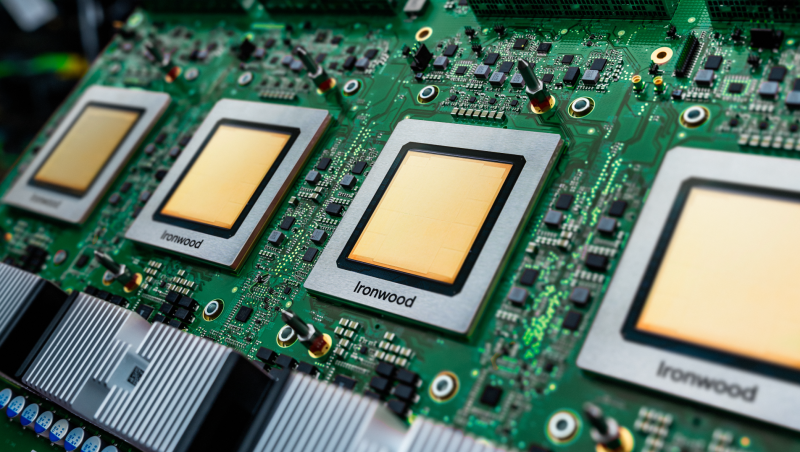

Anthropic купит сотни тысяч ИИ-ускорителей Google TPU напрямую у BroadcomAnthropic приобретёт около 1 млн Google TPU v7 (Ironwood) с тем, чтобы запустить их на контролируемых ею объектах, сообщил в соцсети Х ресурс SemiAnalysis. Ранее сообщалось, что примерно 400 тыс. компания купит напрямую у Broadcom в стойках за примерно $10 млрд, а остальные 600 тыс. единиц TPU v7 будут доступны посредством Google Cloud Platform (GCP) в рамках сделки на сумму около $42 млрд, что составляет большую часть увеличения портфеля заказов GCP на $49 млрд или на 46 %, о котором сообщалось в отчёте за III квартал 2025 года. В случае с закупаемыми напрямую ускорителями TeraWulf и Cipher Mining будут ответственны за инфраструктуру ЦОД, а европейское неооблако Fluidstack будет заниматься настройкой оборудования на месте, прокладкой кабелей, первичным тестированием, испытаниями при приёмке и удалённым обслуживанием, освободив Anthropic от бремени управления физическими серверами. По слухам, эти системы получат упрощённую топологию интерконнекта. Сделки Fluidstack с обоими операторами ЦОД, ранее ориентированными на криптомайнинг, финансово застрахованы Google, которая к тому же является совладельцем TeraWulf и может получить долю в Cipher Mining. Любопытно, что оба оператора частично связаны и с AWS. Хотя Google закупает TPU через Broadcom, которая тоже хочет свою маржу, это всё равно лучше, чем та маржа, что требует NVIDIA не только за продаваемые ускорители, но и за всю систему целиком, включая процессоры, коммутаторы, сетевые карты, системную память, кабели, разъёмы и т.п. По оценкам, SemiAnalysis, совокупная стоимость владения (TCO) на один чип Ironwood для полной конфигурации с топологией 3D-тор примерно на 44 % ниже, чем у серверов GB200, что с лихвой компенсирует примерно 10-% отставание TPU от GB200 по пиковым производительности и пропускной способности памяти. При этом реальная, а не теоретическая производительность (Model FLOP Utilization, MFU) у TPU, по мнению SemiAnalysis, может быть выше, чем у конкурентов. Основная причина заключается в том, что заявляемые NVIDIA и AMD показатели производительности (Флопс) значительно завышены. Даже в синтетических тестах, значительно отличающиеся от реальных рабочих нагрузок, Hopper достиг лишь около 80 % пиковой производительности, Blackwell — около 70 %, а серия MI300 от AMD — 50–60 %. Как полагают в SemiAnalysis, даже сдача ускорителей на сторону выгодна Google за счёт того, что TCO в пересчёте на час аренды может быть примерно на 30 % ниже, чем у GB200, и примерно на 41 % ниже, чем у GB300. Несмотря на высокий спрос, Google не может поставлять TPU в желаемом темпе, отметил SemiAnalysis, полагая, что основная проблема заключается в бюрократии Google — от первоначальных обсуждений до подписания генерального соглашения об оказании услуг (Master Services Agreement) проходит до трёх лет. Неооблака, включая Fluidstack, отличаются гибкостью и оперативностью, что облегчает им взаимодействие с новыми поставщиками услуг дата-центров, например, с реорганизованными криптомайнерами. Однако у неооблаков, среди инвесторов которых числится NVIDIA, таких как CoreWeave, Nebius, Crusoe, Together, Lambda, Firmus и Nscale, есть существенный стимул не внедрять конкурирующие технологии в своих дата-центрах: TPU, ускорители AMD и даже коммутаторы Arista — всё это под запретом. Это оставляет огромную нишу на рынке хостинга TPU, которая в настоящее время заполняется комбинацией майнеров криптовалют и Fluidstack, сообщил SemiAnalysis. По мнению SemiAnalysis, в ближайшие месяцы всё большему числу компаний-неооблаков предстоит принимать непростое решение между развитием возможностей хостинга TPU и получением квот на новейшие и лучшие системы NVIDIA Rubin.

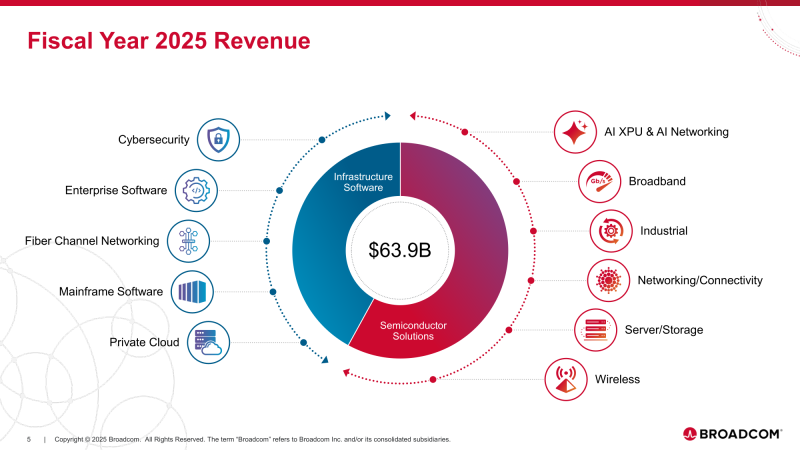

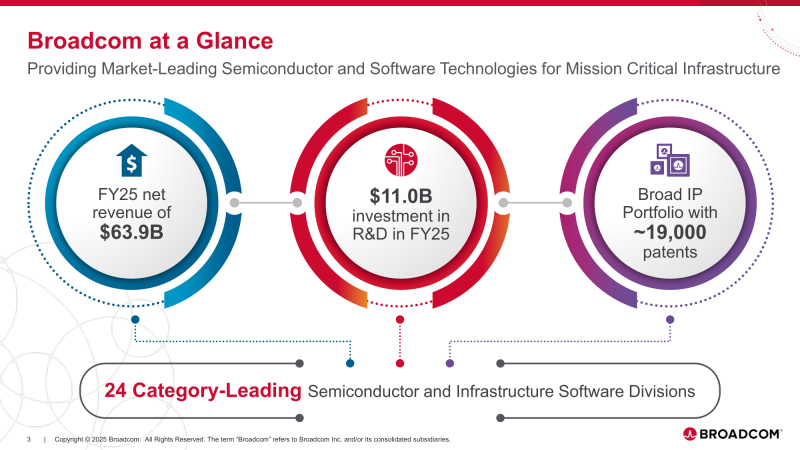

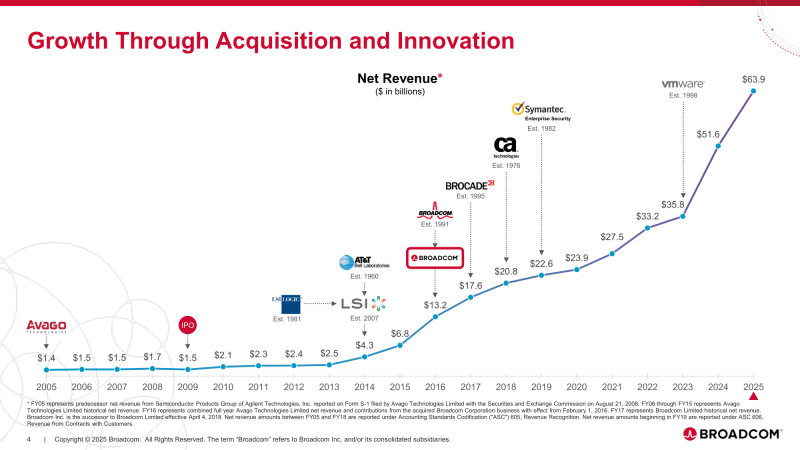

14.12.2025 [00:39], Владимир Мироненко

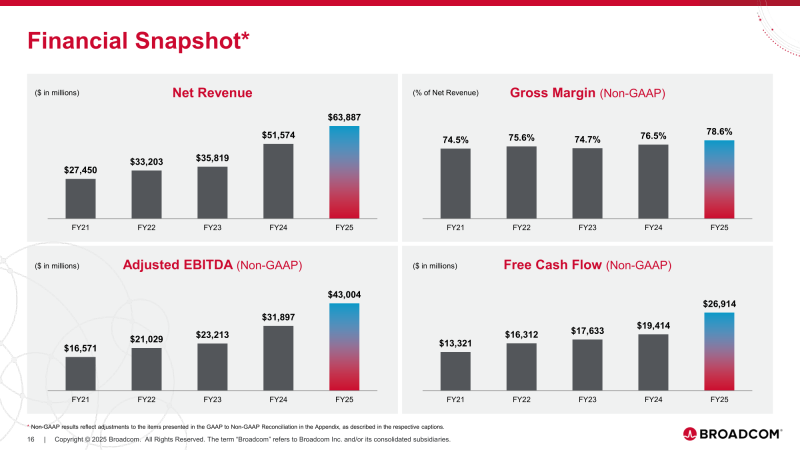

Контракт с Anthropic на $11 млрд не помог — акции Broadcom рухнули из-за слабого прогнозаBroadcom после публикации результатов за IV квартал и 2025 финансовый год в целом, завершившийся 2 ноября, столкнулась с самым значительным падением своих акций за последние 10 месяцев в связи с тем, что её прогноз продаж не оправдал ожиданий инвесторов. Сообщение генерального директора Broadcom Хока Тана (Hock Tan) об имеющемся портфеле заказов на продукцию для ИИ-инфраструктур на сумму $73 млрд, которая будет отгружена в течение следующих шести кварталов, явно разочаровало некоторых инвесторов, хотя Тан уточнил, что эти цифры являются «минимальными». «Мы ожидаем гораздо большего по мере поступления новых заказов на отгрузку в течение следующих шести кварталов, — сказал он. — Таким образом, наш срок выполнения заказа, в зависимости от конкретного продукта, может составлять от шести месяцев до года». Несмотря на то, что результаты за квартал и прогнозы Broadcom превзошли оценки Уолл-стрит, акции компании упали на торгах в Нью-Йорке в пятницу на 12 %, что стало самым большим падением в течение дня с конца января, пишет Bloomberg. Но даже с учётом этого падения её акции выросли более чем на 57 % за год (по данным Reuters). Акции ещё одного участника ИИ-рынка, Oracle, упали в пятницу на 4 % на фоне новостей о переносе сроков завершения строительства некоторых ЦОД, предназначенных для сервисов OpenAI. Это произошло вслед за обвалом на 11 % после публикации отчёта о результатах за последний финансовый квартал. ИИ стал движущей силой фондового рынка и экономики в целом в этом году, поэтому любые негативные настроения на ИИ-рынке могут иметь далеко идущие последствия, отметил CNBC. В минувшую пятницу индекс Nasdaq упал примерно на 1,4 %, а S&P 500 снизился почти на 1 %, причём сильнее всего пострадали компании, тесно связанные с ИИ-инфраструктурой. Тан раскрыл имя нового клиента, о котором он сообщил в ходе отчёта за предыдущий квартал. Им оказался стартап Anthropic, от которого в IV квартале поступил заказ на $11 млрд на разработку кастомного ИИ-чипа после сделки на $10 млрд в III квартале. Тан также рассказал о подписании Broadcom ещё одного контракта на разработку XPU на $1 млрд, снова сразу не назвав имя заказчика. Broadcom сообщила о росте выручки год к году на 28 % за отчётный квартал, до $18,02 млрд в основном за счёт увеличения продаж ИИ-чипов на 74 %, что превысило среднюю оценку аналитиков, опрошенных LSEG, в $17,49 млрд. Скорректированная прибыль (Non-GAAP) на разводнённую акцию составила $1,95, что тоже превысило среднюю оценку экспертов в $1,86. Чистая прибыль (GAAP) равняется $8,52 млрд или $1,74 на разводнённую акцию. Тан сообщил, что выручка от продаж ИИ-полупроводников удвоится в I финансовом квартале по сравнению с прошлым годом и составит $8,2 млрд, благодаря кастомным ИИ-ускорителям и коммутаторам Ethernet для ИИ-инфраструктуры. Кирстен Спирс (Kirsten Spears), финансовый директор Broadcom, указала в пресс-релизе, что в 2025 финансовом году скорректированная EBITDA выросла на 35 % год к году, до рекордных $43,0 млрд, а свободный денежный поток составил $26,9 млрд. Она предупредила, что «валовая маржа будет ниже» для некоторых ИИ-систем Broadcom, поскольку компании придётся закупать больше комплектующих для производства. Следует отметить, что снижение рентабельности, по крайней мере в краткосрочной перспективе, является одним из главных поводов для беспокойства инвесторов. «Сейчас планы многих по расходам кажутся настолько масштабными, что паниковать преждевременно», — считает, в свою очередь, Бен Рейтцес (Ben Reitzes), аналитик Melius Research. Выручка группы полупроводниковых решений Semiconductor Solutions достигла $11,07 млрд, увеличившись на 35 % по сравнению с аналогичным периодом прошлого года. $6,7 млрд из этой суммы пришлись на ИИ-продукты. Менее чем за три года выручка Broadcom от аппаратного обеспечения для ИИ-инфраструктуры выросла в 10 раз. Бизнес по разработке инфраструктурного ПО принёс компании $6,94 млрд (рост год к году на 19 %). Тан сообщил, что большая часть этого роста связана с продажами решений VMware, которые, по его словам, обеспечат двузначный рост до 2026 года. Это является замедлением по сравнению с 26-% ростом в годовом исчислении, зафиксированным в 2025 финансовом году, отметил The Register. Однако рентабельность подразделения ПО выросла на 6 п.п. до 78 %, что отражает завершение процесса интеграции VMware в Broadcom. Что касается итогов за весь 2025 финансовый год, то выручка Broadcom составила $63,89 млрд (рост год к году на 24 %), чистая прибыль (GAAP) — $23,13 млрд (рост — 292 %), чистая прибыль на акцию — $4,77 (рост — 288 %). Тан прогнозирует, что полупроводниковый бизнес обеспечит Broadcom быстрый рост, и сообщил, что в I квартале 2026 финансового года компания ожидает получить выручку $19,1 млрд, что на 28 % больше, чем в предыдущем году. Хотя многие рассчитывали на сделку с OpenAI после объявления в октябре о новом клиенте, Тан развеял эти надежды, заявив инвесторам: «Мы не ожидаем многого в 2026 году». Broadcom также воздержалась от предоставления годового прогноза выручки от ИИ-продукции — Тан заявил, что это «постоянно меняющаяся цель». «Мне сложно точно определить, как будет выглядеть 2026 год», — сказал он. — Поэтому я бы предпочёл не давать вам никаких прогнозов». Вместе с тем он отметил, что прогнозы охлаждения спроса на ИИ-оборудования не сбудутся, сославшись на продолжающееся поступление заказов. «Мы никогда не видели таких объёмов заказов, как за последние три месяца», — сказал Тан инвесторам, добавив, что портфель заказов компании может вырасти ещё больше. Он отмахнулся от предупреждений инвесторов о возможных ограничениях в цепочке поставок, заявив, что Broadcom может получить необходимые мощности TSMC, уклонившись также от вопроса о влиянии стоимости оперативной памяти и указав на новый завод в Сингапуре как на источник необходимых мощностей по упаковке и сборке для удовлетворения спроса. Также гендиректор Broadcom выразил мнение, что время кремниевой фотоники ещё не наступило. Он заявил, что прежде, чем эта технология станет необходимой, должны пройти две волны инноваций. Первая — масштабирование интерконнектов на основе меди для стоечных систем. Вторая — подключаемая оптика — технология, объединяющая электронные и фотонные устройства.

19.11.2025 [01:11], Владимир Мироненко

$30 млрд и 1 ГВт: Microsoft, NVIDIA и Anthropic договорились о сотрудничествеMicrosoft, NVIDIA и Anthropic объявили о стратегическом партнёрстве, которое включает ряд новых инициатив. Как сообщается, Anthropic взяла на себя обязательство приобрести вычислительные мощности Azure стоимостью $30 млрд и заключить контракт на поставку дополнительных вычислительных мощностей объёмом до 1 ГВт для обеспечения будущих потребностей в масштабировании. В рамках партнёрства NVIDIA и Microsoft также обязуются инвестировать в Anthropic до $10 и $5 млрд соответственно. Компании также расширят существующее партнёрство, чтобы обеспечить предприятиям более широкий доступ к ИИ-модели Claude. Клиенты Microsoft Azure AI Foundry смогут получить доступ к продвинутым (frontier) версиям модели Claude, включая Claude Sonnet 4.5, Claude Opus 4.1 и Claude Haiku 4.5. Это партнёрство делает Claude единственной frontier-моделью LLM, доступной во всех трёх самых известных облачных сервисах мира. Также Claude будет интегрирована в пакет Copilot, включающий GitHub Copilot, Microsoft 365 Copilot и Copilot Studio. Генеральный директор Anthropic Дарио Амодеи (Dario Amodei) отметил, что акцент Microsoft на корпоративные платформы естественным образом подходит Claude, которая часто используется в бизнес-приложениях, пишет The Wall Street Journal. В рамках стратегического партнёрства Anthropic и NVIDIA будут сотрудничать в области проектирования и инжиниринга с целью обеспечения наилучшей производительности, экономичности и общей стоимости владения для моделей Anthropic, а также оптимизации будущих архитектур NVIDIA для рабочих нагрузок Anthropic. Первоначально Anthropic будет использовать вычислительные системы NVIDIA Grace Blackwell и Vera Rubin мощностью до 1 ГВт. Аналитики Bank of America утверждают, что эти, на первый взгляд, цикличные сделки являются для лидеров отрасли способом расширить свой потенциальный целевой рынок, что «может многократно увеличить будущие выгоды». Как отметил ресурс Converge! Network Digest, с учётом нынешнего объявления портфель обязательств Microsoft в области ИИ теперь превышает $100 млрд, включая контракты с OpenAI, Inflection и Anthropic. Эти долгосрочные соглашения помогают Microsoft обосновать ускоренное строительство ИИ ЦОД, закупки электроэнергии и развёртывание ИИ-систем. Сделка также укрепляет позиции Azure по сравнению с AWS, запустившей для Anthropic ИИ-кластер Project Rainier, и Google Cloud, TPU которой также пользуется Anthropic.

13.11.2025 [12:12], Руслан Авдеев

Anthropic инвестирует $50 млрд в американскую ИИ-инфраструктуруИИ-стартап Anthropic объявил о намерении инвестировать $50 млрд в вычислительную инфраструктуру в США. Компания создаст ЦОД совместно с Fluidstack в Техасе, Нью-Йорке и других. местах. Объекты проектируются с учётом запросов Anthropic для обеспечения максимальной эффективности рабочих нагрузок. Fluidstack выбрана в качестве партнёра стартапа за «исключительную гибкость», позволяющую быстро получить гигаватты мощностей. Первые объекты должны ввести в эксплуатацию в 2026 году. ЦОД позволят создать 800 постоянных рабочих мест. План поможет выполнению инициативы администрации Дональда Трампа в области ИИ (AI Action Plan) — она направлена на сохранение лидерства США в сфере искусственного интеллекта. В компании заявляют, что приближаются к созданию ИИ, способного ускорить научные открытия и решать сложные задачи невозможными ранее способами. Для этого необходима инфраструктура, способная поддерживать непрерывное развитие — новые площадки помогут создавать более эффективные ИИ-системы, способные обеспечить новые исследовательские прорывы и создавать рабочие места для американцев. Anthropic с её ИИ-моделями Claude обслуживает более 300 тыс. корпоративных клиентов, а число клиентов, приносящих более $100 тыс. ежегодно, за последний год выросло почти в семь раз. Огромный масштаб инвестиций необходим для удовлетворения растущего спроса на Claude среди сотен тысяч компаний с сохранением передовых позиций в сфере исследований ИИ-технологий. В компании обещают отдавать приоритет «экономически эффективным» и «капиталоэффективным» подходам для достижения своих целей. По данным Datacenter Dynamics, в случае с техасским ЦОД, возможно, речь идёт о ранее анонсированном объекте Fluidstack и TeraWulf на 168 МВт в Абернати (Abernathy) или о совместном c Cipher Mining проекте на 244 МВт. В случае с Нью-Йоркским ЦОД, речь, возможно, идёт о кампусе Lake Mariner — совместном проекте Fluidstack и TeraWulf. Google, имеющая долю 14 % в Anthropic, поддержала оба проекта с участием TeraWulf. Ранее в этом году компания обеспечила гарантии по её кредитам, а также предоставила гарантии по арендным обязательствам Fluidstack на сумму $1,4 млрд для сделки с Cipher, получив в TeraWulf долю 5,4 %, а в бизнесе Fluidstack — 14 %. В октябре Anthropic анонсировала сделку с Google Cloud объёмом более 1 ГВт, которая даст ей доступ к миллиону ускорителей Google TPU. Предстоит уточнить, идёт ли в новом анонсе Anthropic речь о том же самом контракте с участием Fluidstack в качестве посредника — или речь идёт о новой сделке. AWS тоже владеет долей в Anthropic. В октябре она запустила для Anthropic кластер Project Rainier на основе собственных ИИ-ускорителей Tranium2. На площадку потратят $11 млрд (при полной загрузке). Стоимость вычислений Anthropic растёт, но The Information располагает информацией, что ИИ-стартап надеется использовать более эффективные модели, требующие меньших вычислительных мощностей в пересчёте на каждого пользователя. Это снизит затраты и позволит скорее добиться прибыльности бизнеса. По оценкам, $50 млрд инвестиций дадут компании доступ к примерно 5 ГВт ЦОД.

30.10.2025 [16:18], Руслан Авдеев

Полмиллиона ускорителей Trainium2: AWS развернула для Anthropic один из крупнейших в мире ИИ-кластеров Project RainierAWS объявила о запуске одного из крупнейших в мире ИИ-кластеров Project Rainier. Фактически амбициозный проект представляет собой распределённый между несколькими ЦОД ИИ-суперкомпьютер — это важная веха в стремлении AWS к развитию ИИ-инфраструктуры, сообщает пресс-служба Amazon. Платформа создавалась под нужды Anthropic, которая буквально на днях подписала многомиллиардный контракт на использование Google TPU. В рамках Project Rainier компания AWS сотрудничала со стартапом Anthropic. В проекте задействовано около 500 тыс. чипов Trainium2, а вычислительная мощность в пять раз выше той, что Anthropic использовала для обучения предыдущих ИИ-моделей. Project Rainier применяется Anthropic для создания и внедрения моделей семейства Claude. К концу 2025 года предполагается использование более миллиона чипов Trainium2 для обучения и инференса. В рамках Project Rainier в AWS уже создали инфраструктуру на основе Tranium2, на 70 % превосходящую любую другую вычислительную ИИ-платформу в истории AWS. Проект охватывает несколько дата-центров в США и не имеет аналогов среди инициатив AWS. Он задуман как гигантский кластер EC2 UltraCluster из серверов Trainium2 UltraServer. UltraServer объединяет четыре физических сервера, каждый из которых имеет 16 чипов Trainium2. Они взаимодействуют через фирменный интерконнект NeuronLink, обеспечивающий быстрые соединения внутри системы, что значительно ускоряет вычисления на всех 64 чипах. Десятки тысяч UltraServer объединяются в UltraCluster посредством фабрики EFA. Эксплуатация такого ЦОД требует повышенной надёжности. В отличие от большинства облачных провайдеров, AWS создаёт собственное оборудование и может контролировать каждый компонент, от чипов до систем охлаждения и архитектуру дата-центров в целом. Управляющие ЦОД команды уделяют повышенное внимание энергоэффективности, от компоновки стоек до распределения энергии и выбора методов охлаждения. Кроме того, в 2023 году вся энергия, потребляемая Amazon, полностью компенсировалась электричеством из возобновляемых источников. В Amazon утверждают, что в последние пять лет компания является крупнейшим покупателем возобновляемой энергии и стремится к достижению нулевых выбросов к 2040 году.

Источник изображения: AWS Миллиарды долларов инвестируются в ядерную энергетику и АКБ, а также крупные проекты в области возобновляемой энергетики для ЦОД. В 2024 году компания объявила о внедрении новых компонентов для ЦОД, сочетающих технологии электропитания, охлаждения и аппаратного обеспечения, причём не только для строящихся, но и уже для имеющихся объектов. Новые компоненты, предположительно, позволят снизить энергопотребление некоторых компонентов до -46 % и сократить углеродный след используемого бетона на 35 %.

Источник изображения: AWS Для новых объектов, строящихся в рамках Project Rainier и за его пределами, предусмотрено использование целого ряда новых технологий для повышения энергоэффективности и экоустойчивости. Некоторые технологии связаны с рациональным использованием водных ресурсов. AWS проектирует объекты так, чтобы использовать минимум воды, или вовсе не использовать её. Один из способов — отказ от её применения в системах охлаждения на многих объектах большую часть года, с переходом на охлаждение наружным воздухом.

Источник изображения: AWS Так, один из объектов Project Rainier в Индиане будет максимально использовать именно уличный воздух, а с октября по март дата-центры вовсе не станут использовать воду для охлаждения, с апреля по сентябрь в среднем вода будет применяться по несколько часов в день. Согласно отчёту Национальной лаборатории им. Лоуренса в Беркли (LBNL), стандартный показатель WUE для ЦОД 0,375 л/кВт·ч. В AWS этот показатель равен 0,15 л/кВт·ч, что на 40 % лучше, чем в 2021 году.

26.10.2025 [23:55], Владимир Мироненко

Amazon проморгала рынок и теперь её клиенты бегут за ИИ в облака конкурентовAmazon, стоящая у истоков облачного бизнеса, уже не первый год отстаёт от конкурентов по темпам его роста. И на ИИ-рынке, по общему мнению, она оказалась в роли догоняющей на фоне стремительного роста конкурентов, пишет агентство Bloomberg. На прошлой неделе стало известно, что Google Cloud предоставит Anthropic до 1 млн своих ИИ-чипов TPU, что свидетельствует об углублении партнёрства Google с быстрорастущим ИИ-стартапом и наносит удар по Amazon, инвестировавшей в Anthropic миллиарды долларов. AWS по-прежнему лидирует на облачном рынке, но Microsoft наращивает объём корпоративных продаж быстрее, чем Amazon. В прошлом году, по оценке Gartner, облачное AWS заняла 38 % корпоративных расходов на услуги облачной инфраструктуры, тогда как ещё в 2018 году, по данным компании, у «дочки» Amazon было почти 50 % этого рынка. Чтобы выяснить причины сложившейся ситуации, агентство Bloomberg провело опрос аналитиков в области облачных вычислений и финансов, а также у компаний, которые используют или перепродают облачные решения Amazon, и среди 23 нынешних и бывших сотрудника AWS, работающих в сфере разработки, управления продуктами, маркетинга, продаж и поддержки. Одной из главных причин, тормозящих работу AWS, а также влияющих на гибкость, они назвали внутреннюю бюрократию. Респонденты отметили слабый старт компании в области ИИ, а также то, что она стала менее привлекательной для стартапов. Вместе с тем AWS верна своей давней стратегии на фоне быстро меняющегося рынка. Участники опроса признают, что AWS сохраняет значительные преимущества и лояльность клиентов, но опасаются, что компания теряет свои позиции в погоне за конкурентами, которых когда-то опережала. На следующей неделе Amazon объявит квартальные финансовые результаты, которые, как ожидается, покажут рост облачного бизнеса на 18 % до $32 млрд, что уступает показателю роста годом ранее (19 %). Сказался и серьёзный рост конкуренции на облачном рынке в последние пару лет. Oracle, которую когда-то считали аутсайдером в облачной индустрии, теперь заключает многомиллиардные контракты в области ИИ, хотя и не все верят в её успех. Также наращивают мощности Google и неооблака. Дэйв Маккарти (Dave McCarthy), консультант IDC, отметил, что выбор облачных предложений, ранее ограничивавшийся сервисами Amazon и Microsoft, стал гораздо больше, и это не сулит ничего хорошего Amazon. «Это создаёт новое конкурентное давление, которого раньше не было», — подчеркнул он. Стремясь вернуть себе инициативу, AWS реорганизовала команды по инжинирингу и продажам, провела кадровые перестановки в руководстве, а также отказалась от некоторых собственных правил разработки ради ускорения вывода продуктов на рынок и попыталась сократить бюрократию, возникшую после масштабного набора сотрудников во время пандемии. Кроме того, в этом месяце AWS выпустила Quick Suite, призванный заменить её предыдущий основной ИИ-инструмент для корпоративных клиентов, и в декабре ожидается запуск ряда новых и обновлённых ИИ-сервисов. Представитель Amazon Селена Шен (Selena Shen) сообщила в электронном письме Bloomberg, что AWS по-прежнему лидирует на рынке облачных технологиях с большим отрывом, а её ИИ-сервисы, такие как Amazon Bedrock, SageMaker и Kiro, пользуются спросом у клиентов, в том числе из-за выгодного соотношении цены и производительности фирменных ИИ-ускорителей Trainium2. Amazon заключила за последнее время крупные сделки с широким кругом клиентов, включая Delta Air Lines, Volkswagen, Управление общих служб США (GSA) и State Farm, отметила Шен. «Если вы посмотрите на любой список самых инновационных или быстрорастущих стартапов мира, вы обнаружите, что подавляющее большинство из них в значительной степени разворачивают рабочие нагрузки в AWS», — добавила она, ссылаясь, среди прочего, на списки Forbes и CNBC. Тем не менее, по общему мнению, оставаясь лидером в области облачной инфраструктуры, AWS отстаёт от своих конкурентов в плане привлечения бизнеса, создающего или использующего ИИ-модели. В частности, AWS не поверила в то, что Anthropic сможет монетизировать свои разработки, поэтому стартап в поисках необходимых вычислительных мощностей обратился к Google Cloud. Когда стартап привлёк инвестиции в начале 2023 года, среди инвесторов была и Google. Лишь в сентябре Amazon спохватилась и инвестировала в Anthropic первый из двух запланированных траншей в размере $4 млрд, обязав Anthropic использовать AWS и собственные чипы Amazon, а также предлагать клиентам Amazon модели Claude. Объём инвестиций шокировал ветеранов Amazon, знавших, что компания крайне не любит платить за что-либо по рыночным ценам. Некоторые посчитали это отчаянием, пишет Bloomberg. Amazon долгое время гордилась тем, что работает в режиме стартапа, предоставляя свободу независимым командам. Но этот принцип оказался неэффективным при разработке ИИ-моделей, поскольку научные и инженерные подразделения AWS, розничный отдел Amazon и группы Alexa и устройств занимались схожей, иногда дублирующей работой по обучению собственных ИИ-моделей. На конференции AWS re:Invent в ноябре 2023 года компания сделала упор на ИИ, а чуть позже развернула собственного ИИ-ассистента Amazon Q, который, по словам аналитиков, не принёс ничего революционного рынку, уже переполненному чат-ботами. Amazon провела реорганизацию и централизовала большинство работ по разработке передовых моделей, однако развитие AWS замедлилось. В том числе из-за усложнения иерархии после всплеска найма в результате пандемии. В условиях растущей бюрократии принятие решений происходило не так быстро, как раньше. Кроме того, поскольку ПО AWS стало критически важным для крупных корпоративных и государственных клиентов, в компании установили процедуры, призванные снизить риск того, что невнимательный или недовольный сотрудник может сломать что-то важное — это тоже замедляет работу. В некоторых случах часть сотрудников даже заставили получать разрешения на отправку писем высшему руководству. Шен сообщила, что с 2024 года AWS наняла множество новых руководителей и продвигает по службе тех, кто «демонстрирует производительность и готовность к следующему уровню», и что культура AWS остаётся сильной. Сменивший Адама Селипски (Adam Selipsky) на посту гендиректора AWS Мэтт Гарман (Matt Garman), пользующийся большим доверием разработчиков, частично вернул культуру прошлого. От руководителей продуктов требуется открытое признание ошибок и извлечённых уроков, идеи сотрудников принимаются в виде коротких питчей, а сами разработчики ПО работают посменно, обрабатывая запросы поддержки и инциденты по своим продуктам, чтобы понять потребности клиентов. Кроме того, Гарман завершил или прекратила разработку около трёх десятков устаревших и непопулярных продуктов, перенаправив силы на разработку ИИ-инструментов. Тем не менее, сотрудники выражают обеспокоенность тем, что Amazon теряет привлекательность для стартапов. AWS, как известно, помогла зарождению Netflix, но в последние годы порой отдавала приоритет корпорациям с большими расходами, не желая тратить силы на стартапы, которые могут и не стать долгосрочными богатыми клиентами. По словам аналитиков и стартап-консультантов, Google, используя свою известность, инженеров и навыки в передовых ИИ-инструментах, смогла привлечь многих ведущих стартапов в этой сфере. «Если вы сегодня не привлекаете местные стартапы в сфере ИИ, которые в ближайшие пару лет вырастут в пять-десять раз, это может стать реальной проблемой для бизнеса», — сказал Джош Бек (Josh Beck), аналитик Raymond James. Шен же назвала AWS «лучшим выбором для стартапов», приведя в пример Perplexity и Cursor. Но, к примеру, Пит Шваб (Pete Schwab), основатель стартапа Stronghold Labs в области ИИ-анализа видео, выбрал для своего детища площадку Google из-за её ориентации на небольших разработчиков и качества внутренних ИИ-моделей, хотя сам до этого 10 лет проработал в Amazon. AWS «раньше гораздо лучше привлекала таких людей, как мы», — сказал Шваб. Существующие клиенты AWS сейчас также обращаются к услугам её конкурентов, особенно в ИИ-сфере. Например, Grammarly, пользуется AWS, но для ИИ-решений использует модели OpenAI, в том числе в Microsoft Azure, а также Meta✴ Llama, поскольку AWS Bedrock не отвечает ценовым и другим потребностям компании, заявил технический директор стартапа. В начале этого месяца компания представила Quick Suite — чат-бот и набор ИИ-агентов, предназначенных для анализа данных, создания отчётов или резюмирования веб-контента, которые ориентированы на офисных сотрудников. В этой области компания не добилась особого успеха. Руководители в частном порядке признают, что, в отличие от Google и Microsoft, которые могут демонстрировать свои ИИ-инструменты миллиардам клиентов поисковой системы или пользователей ПК, естественный охват AWS ограничен гораздо более узким сообществом разработчиков. Для этой аудитории AWS продолжает расширять возможности Bedrock. Bedrock считается самым успешным ИИ-продуктом компании, число пользователей которого исчисляется десятками тысяч. По словам клиентов и партнёров, отделы продаж сделали увеличение их количества приоритетом. Однако Amazon может преуспеть в эпоху ИИ, просто выступая в качестве поставщика инфраструктуры для других компаний и управляя ею экономически эффективно. По мнению аналитиков, большая часть корпоративных проектов в области ИИ носит экспериментальный характер. Если проект получит более широкую поддержку, экономия средств и надёжная инфраструктура (если не учитывать недавний сбой) — два основных преимущества AWS — станут ещё важнее, утверждают руководители компании.

24.10.2025 [13:15], Руслан Авдеев

1 млн TPU и 1 ГВт: Anthropic расширит использование ИИ-ускорителей и сервисов Google CloudКомпания Anthropic объявила о знаковом расширении использования чипов TPU Google Cloud. Это обеспечит компании доступ к вычислительным ресурсам, необходимым для обучения и обслуживания ИИ-моделей Claude новых поколений. В 2026 году Anthropic рассчитывает получить доступ к мощностям, превышающим 1 ГВт, сообщает пресс-служба Google Cloud. Речь идёт о крупнейшем увеличении использования TPU компанией Anthropic за всё время использования ей тензорных ускорителей Google. Она получит доступ к 1 млн чипов, а также дополнительным сервисам Google Cloud. По оценкам некоторых экспертов, это примерная пятая часть всех TPU Google, но в 2026 году компания намерена развернуть ещё 2,5 млн TPU. Предполагается, что сделка обеспечит R&D-группы Anthropic передовой инфраструктурой, оптимизированной для ИИ-проектов, на годы вперёд. Как сообщают в Google, Anthropic выбрала TPU из-за привлекательного соотношения цены и производительности, а также благодаря имеющемуся опыту обучения и эксплуатации ИИ-моделей именно с помощью TPU. О стратегическом партнёрстве Anthropic и Google Cloud объявили в 2023 году. На сегодняшний день моделями семейства Claude компании Anthropic в Google Cloud активно пользуются тысячи компаний, включая Figma, Palo Alto Networks, Cursor и др. В Anthropic подчеркнули, что с Google компания давно сотрудничает, а последнее расширение поможет и дальше наращивать вычислительные мощности, необходимые для наращивания возможностей ИИ-систем. В числе клиентов — как компании из списка Fortune 500, так и ИИ-стартапы, которые полагаются на Claude. Расширение вычислительных возможностей гарантирует, что компания сможет удовлетворить стремительно растущий спрос, сохраняя актуальность ИИ-продуктов. В Google Cloud отметили, что Anthropic использует TPU уже несколько лет с оптимальным для неё соотношением цены и производительности, в Google продолжают инновации, опираясь на «зрелое» портфолио ИИ-ускорителей, включая TPU седьмого поколения — Ironwood. |

|