Материалы по тегу: inferentia2

|

10.11.2025 [15:00], Владимир Мироненко

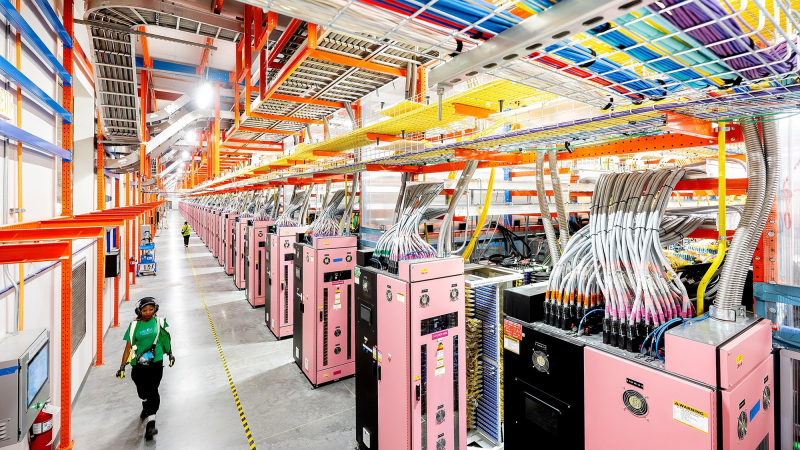

Фирменные ИИ-ускорители Amazon всё ещё не могут конкурировать с чипами NVIDIA, считают некоторые стартапыНекоторые стартапы считают, что ИИ-чипы Trainium и Inferenetia собственной разработки Amazon менее конкурентоспособны, чем ускорители NVIDIA, сообщил ресурс Business Insider со ссылкой на внутреннюю документацию AWS. Согласно июльскому «конфиденциальному» внутреннему документу Amazon, ИИ-стартап Cohere обнаружил, что чипы Amazon Trainium 1 и 2 «уступают по производительности» ускорителям NVIDIA H100. Стартап отметил, что доступ к Trainium2 был «крайне ограничен», а в работе наблюдались частые перебои. Amazon и её подразделение Annapurna Labs всё еще изучают возникшие у Cohere «проблемы с производительностью», но прогресс в решении этих проблем был «ограниченным», отмечено в официальном документе. Также в нём упоминается стартап Stability AI, разработавший, в том числе, ИИ-генератор изображений Stable Diffusion, который высказывал схожие претензии. В частности, говорится, что чипы Amazon Trainium2 уступают NVIDIA H100 по задержке, что делает их «менее конкурентоспособными» с точки зрения скорости и стоимости. Ставка Amazon на чипы собственной разработки является частью её усилий по обеспечению конкурентоспособности в ИИ-гонке. Её прибыльность основана в том числе на использовании собственных процессоров Graviton вместо дорогостоящих чипов Intel. И сейчас Amazon тоже стремится задействовать собственные чипы для обработки ИИ-нагрузок. Если некоторые клиенты AWS не захотят использовать Trainium и будут настаивать на том, чтобы AWS запускала свои облачные ИИ-системы с использованием чипов NVIDIA, которые гораздо дороже её собственных решений, это отразится на её прибыли от облачных вычислений, отметил Business Insider. Рынок стартапов давно является важным для AWS, поэтому их претензии имеют большое значение для компании. Представитель Amazon заявил, что компания «благодарна» клиентам за отзывы, которые помогают сделать её чипы «еще лучше и более широко используемыми». Он добавил, что кейс с Cohere «не является актуальным», отметив, что её чипы Trainium и Inferentia «достигли отличных результатов» с такими клиентами, как Ricoh, Datadog и Metagenomi. «Мы очень довольны ростом и внедрением Trainium2, который на данном этапе в основном используется небольшим числом очень крупных клиентов, таких как Anthropic», — написал представитель в электронном письме ресурсу Business Insider. AWS утверждает, что ее собственные ИИ-ускорители предлагают на 30-40 % лучшие ценовые характеристики, чем нынешнее поколение GPU. Компания обладает «невероятными талантами» в области проектирования чипов и работает над новыми поколениями ускорителей. «Мы рассчитываем привлечь больше клиентов, начиная с Trainium 3, превью которого ожидается позже в этом году», — сказал представитель Amazon. Генеральный директор Amazon Энди Джасси (Andy Jassy) заявил во время отчёта о доходах компании, что чипы Trainium2 «полностью распределены по подписке» и теперь являются «многомиллиардным» бизнесом, который последовательно увеличивается на 150 % от квартала к кварталу. Жалобы клиентов Amazon на её чипы поступали и раньше. Согласно июльскому документу, стартап Typhoon обнаружил, что устаревшие ускорители NVIDIA A100 в три раза экономичнее для определённых рабочих нагрузок, чем чипы Inferentia2 от AWS, ориентированные на инференс. В свою очередь, исследовательская группа AI Singapore установила, что серверы AWS G6, оснащённые ускорителями NVIDIA, более экономичны по сравнению с Inferentia2 при различных вариантах использования. В прошлом году клиенты облака Amazon также отмечали «проблемы при внедрении» её пользовательских ИИ-чипов, которые создают «проблемные области», что ведёт к снижению их использования. Эти проблемы нашли отражение в доле рынка Amazon. По данным исследовательской компании Omdia, NVIDIA доминирует на рынке ИИ-чипов с долей более 78 %. За ней следуют Google и AMD, владеющие по чуть более 4 %. AWS занимает лишь шестое место с 2 % рынка. Наглядно иллюстрирует проблемы Amazon в этом отношении соглашение AWS и OpenAI стоимостью $38 млрд. Сделка предполагает использование облачных ИИ-серверов на базе ускорителей NVIDIA, без упоминания чипов Trainium. Ускорители NVIDIA не только обеспечивают высокую производительность, но подкрепляются широко распространённой платформой CUDA. Это качество особенно ценно при разработке крупных проектов в области ИИ с высоким уровнем риска, когда надёжность и имеющийся опыт могут сыграть решающую роль. В июльском документе сотрудники Amazon отметили, что технические ограничения и другие проблемы, связанные со сравнением пользовательских ИИ-чипов компании и ускорителей NVIDIA, стали «критическим препятствием» для клиентов, задумывающихся о переходе на чипы AWS. До публикации отчёта о доходах Amazon на прошлой неделе аналитики Bank of America соблюдали осторожность в оценке прогресса Tranium. В аналитической заметке, опубликованной в конце октября, они предупредили, что инвесторы «скептически» относятся к возможностям Trainium, и что «неясно», проявится ли высокий спрос на них «за пределами Anthropic». Недавно AWS запустила проект Project Rainier — ИИ-кластер из полумиллиона чипов Trainium2, которые будут использоваться для обучения LLM следующего поколения Anthropic. Ожидается, что к концу года Anthropic получит более 1 млн чипов Trainium2, но решение по этому вопросу ещё не принято. Если реализация проекта будет успешной, это станет огромным подспорьем для Amazon. Вместе с тем в прошлом месяце Anthropic подписала многомиллиардный контракт на использование Google TPU, отметив, что продолжит использовать Trainium. Хотя Anthropic публично признала сложность использования архитектур с разными чипами, представитель Amazon сообщил Business Insider, что Anthropic продолжает расширять использование Trainium и подчеркнул стремление компании предлагать клиентам широкий спектр аппаратных опций в рамках своих облачных сервисов. В ходе общения с аналитиками на прошлой неделе Джасси подчеркнул, что AWS сосредоточена на предоставлении «нескольких вариантов чипов». Он отметил, что цель состоит не в том, чтобы заменить чипы NVIDIA, а в том, чтобы предоставить клиентам больше выбора. Этой стратегии AWS придерживается и в других областях облачных вычислений, сказал он. «В истории AWS никогда не было случая, чтобы какой-то один игрок в течение длительного периода времени владел всем сегментом рынка, а затем мог удовлетворить потребности всех во всех аспектах», — сказал Джасси. В долгосрочной перспективе не слишком удачные продажи собственных ускорителей не лучшим образом скажутся на AWS. Компания понимает, что её решения могут быть менее производительны и удобны, поэтому и предлагает их по меньшей цене, чем ускорители NVIDIA. Однако стоимость их производства сравнима со стоимостью производства чипов такого же класса, и со временем она будет только расти. Проще говоря, Amazon меньше зарабатывает на своих чипах, а в худшем случае может терять на них деньги. |

|