Материалы по тегу: xeon

|

19.02.2026 [12:26], Сергей Карасёв

«НВБС» представила российские серверы «Необайт» на платформах Intel и AMDКомпания «НВБС», российский системный интегратор и производитель технологических решений, анонсировала собственные серверы семейства «Необайт». Дебютировали модели NeoByte NBR220 и NeoByte NBR680 на аппаратной платформе Intel, а также NeoByte NBR685 с процессорами AMD. По словам компании, новинки «сопоставимы с решениями ведущих компаний на рынке, но при этом в среднем стоят на 10–15 % дешевле за счёт широкого пула поставщиков и оптимизированной логистики». Система NeoByte NBR220 типоразмера 2U может нести на борту два чипа Intel Xeon Sapphire Rapids или Emerald Rapids с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5-4800. В зависимости от конфигурации во фронтальной части возможна установка 12 накопителей LFF/SFF или 24 устройств SFF с интерфейсом SATA/SAS/NVMe. В тыльной зоне корпуса расположены посадочные места ещё для четырёх накопителей LFF/SFF (SATA/SAS/NVMe), тогда как внутри есть два коннектора для SSD формата M.2 (SATA/NVMe). Реализована поддержка до 10 стандартных слотов PCIe и одного слота OCP 3.0. В оснащение входят контроллер AST2600, два сетевых порта 1GbE, выделенный сетевой порт управления 1GbE, четыре порта USB 3.0 (по два спереди и сзади), два интерфейса D-Sub (по одному спереди и сзади) и последовательный порт. Питание обеспечивают два блока с резервированием мощностью 800/1300/1600/2000 Вт. Сервер оптимизирован для ИИ-задач, виртуализации, баз данных и файловых хранилищ. Платформа практически идентична представленным ранее серверам «Аквариус» AQserv T50 D224RS и T50 D212RS. Модель NeoByte NBR680 стандарта 6U имеет аналогичные характеристики подсистем CPU, ОЗУ, хранения данных и интерфейсов ввода/вывода. При этом возможна установка до восьми GPU-ускорителей двойной ширины. Есть пять стандартных слотов PCIe и один слот OCP; передняя панель поддерживает до трёх стандартных слотов PCIe и один слот OCP. Мощность каждого из двух блоков питания — 2700 или 3200 Вт. Машина предназначена для научных исследований и крупных ИИ-проектов. В свою очередь, GPU-сервер NeoByte NBR685 формата 6U рассчитан на два процессора AMD EPYC 9005 Turin или EPYC 9004 Genoa с показателем TDP до 500 Вт. Предусмотрены 24 слота для модулей оперативной памяти DDR5-4800. Прочие характеристики идентичны версии NeoByte NBR680, включая поддержку восьми GPU-ускорителей двойной ширины. Система подходит для анализа больших данных в реальном времени, криптографии и блокчейна. Все новинки могут быть опционально укомплектованы контроллером SAS RAID/HBA. Заявлена совместимость с Windows Server 2022 SLES 12.5 и выше, RHEL7.8 и выше, Ubuntu18.04 и выше, CentOS7.6 и выше, Vmware ESXi 7.0 GA и выше. Гарантия производителя достигает пяти лет. Также «НВБС» говорит, что «не зависит от санкций, что снижает риски ограничения поставок».

16.02.2026 [10:11], Сергей Карасёв

Китайская Montage Technology выпустила серверные процессоры Jintide на базе Intel Xeon 6Китайская компания Montage Technology, на днях осуществившая первичное публичное размещение акций (IPO) на Гонконгской фондовой бирже, выпустила серверные процессоры Jintide следующего поколения, в основу которых положена архитектура Intel Xeon 6, доработанная под требования заказчиков в КНР. В частности, вышли изделия Jintide C6P, которые фактически представляют собой процессоры Intel Xeon 6 семейства Granite Rapids-SP на базе производительных ядер P-core. Их количество в китайских чипах достигает 86 с возможностью одновременной обработки до 172 потоков инструкций, а максимальный объем кеша L3 составляет 336 Мбайт. Реализована 8-канальная подсистема памяти DDR5 с поддержкой модулей RDIMM-6400 и MRDIMM-8000. Процессоры Jintide C6P могут применяться в одно- и двухсокетных конфигурациях. Говорится о поддержке 88 линий PCIe 5.0 и протокола CXL 2.0. Пропускная способность шины UPI достигает 24 ГТ/с. Обеспечивается полная совместимость с набором инструкций x86. Чипы ориентированы на дата-центры и облачные инфраструктуры с высокой вычислительной нагрузкой. Кроме того, дебютировали решения Jintide C6E — это модифицированные изделия Intel Xeon 6 Sierra Forest-SP с энергоэффективными ядрами E-core: их количество достигает 144. Размер кеша L3 составляет до 108 Мбайт. Процессоры имеют восемь каналов памяти DDR5-6400 и до 88 линий PCIe 5.0. Упомянута поддержка CXL 2.0 и шины UPI с пропускной способностью до 24 ГТ/с. Решения Jintide C6E могут устанавливаться в одно-и двухсокетные системы. Компания также анонсировала чип Jintide M88STAR5(N), на основе которого реализуются различные функции безопасности. Изделие, использующее технологию Mont-TSSE (Trust & Security System Extension), отвечает за аппаратное шифрование/дешифрование данных в соответствии с местными стандартами и доверенные вычисления. На кристалле присутствуют нескольких генераторов случайных чисел, а общая пропускная способность достигает 160 Гбит/с через PCIe 5.0 х8. Упомянута поддержка стандартов TPM, TCM и TPCM, а также интерфейсов SMBus, I3C, UART, SPI и GPIO. Наконец, Montage Technology представила чип Jintide M88IO3032 IOH (I/O Hub), предназначенный для использования с CPU нового поколения. Изделие обеспечивает поддержку PCIe 3.0, SATA 3.2 (до 20 портов; RAID 0/1/5/10), USB 3.2/2.0 и пр.

07.02.2026 [17:23], Руслан Авдеев

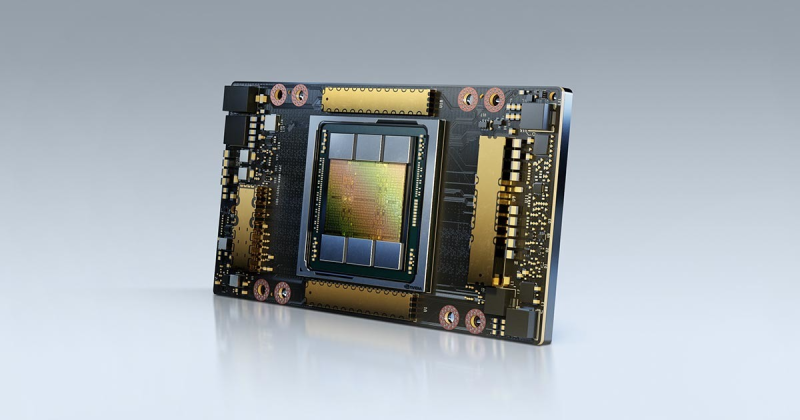

AWS: ни один сервер с NVIDIA A100 не выведен из эксплуатации, а некоторые клиенты всё ещё используют Intel Haswell — не всем нужен ИИПо словам главы AWS Мэтта Гармана (Matt Garman), клиенты до сих пор использует серверы на основе ИИ-ускорителей NVIDIA A100, представленных в 2020 году. Отчасти это происходит потому, что спрос на вычислительные ресурсы превышает предложение, так что устаревшие чипы по-прежнему востребованы, передаёт Datacenter Dynamics. По словам Гармана, все ресурсы фактически распроданы, а серверы с A100 из эксплуатации никогда не выводились. Комментарии Гармана перекликаются с прошлогодним заявлением Амина Вахдата (Amin Vahdat), отвечающего в Google за ИИ и инфраструктуру. По его словам, в Google одновременно работают семь поколений тензорных ускорителей (TPU). Ускорители возрастом семь-восемь лет загружены на 100 %, а спрос на TPU так высок, что Google вынуждена отказывать некоторым клиентам. Впрочем, оба топ-менеджера, возможно, несколько кривят душой и пытаются развеять опасения инвесторов относительно того, что ИИ-ускорители, на которые тратятся огромные деньги, через два-три года придётся выкинуть, чтобы купить более современные, энергоэффективные и, конечно же, дорогие. И что за это время они не успеют окупиться. Хотя Гарман назвал главной причиной сохранения работы серверов на A100 высокий спрос, он признал, что есть и другие причины. В частности, современные ИИ-чипы снижают точность вычислений с плавающей запятой. В результате некоторые клиенты попросту не могут перейти на Blackwell или вовсе вынуждены использовать Intel Xeon Haswell десятилетней давности для HPC-подобных вычислений, поскольку точности у современных ИИ-ускорителей недостаточно. В июне 2025 года AWS заявила о снижении цены доступа к устаревшим NVIDIA H100, H200 и A100 на своей платформе, причём для A100 стоимость снизилась на треть.

Источник изображения: NVIDIA Стоит отметить, что «устаревшие» ускорители долго остаются востребованными, поскольку всё равно обладают большой производительностью. Наиболее яркий пример — разрешение на поставку в Китай чипов NVIDIA H200. Хотя США и их союзники готовятся к внедрению ускорителей поколения Vera Rubin, китайский бизнес готов покупать H200, поскольку те значительно производительнее, экономически выгоднее и удобнее отечественных ускорителей.

04.02.2026 [18:37], Сергей Карасёв

«Рикор» выпустил российские 2U-серверы на базе Intel Xeon Emerald RapidsКомпания «Рикор» анонсировала российские серверы Rikor 7212DSP5 и Rikor 7225DSP5, построенные на аппаратной платформе Intel Xeon Emerald Rapids. Устройства, как утверждается, подходят для решения широко спектра задач, включая виртуализацию, гиперконвергентную инфраструктуру, облачные сервисы, анализ данных, машинное обучение и приложения ИИ. Новинки выполнены в форм-факторе 2U. Допускается установка двух процессоров Xeon и 32 модулей оперативной памяти DDR5 суммарным объёмом до 8 Тбайт. Реализована поддержка интерфейса PCIe 5.0. Серверы различаются конфигурацией подсистемы хранения данных: модель Rikor 7212DSP5 рассчитана на 12 накопителей с доступом через фронтальную панель, а модификация Rikor 7225DSP5 — на 25. Прочие технические характеристики пока не раскрываются. Одним из ключевых преимуществ решений производитель называет использование корпусов собственной разработки. Это, как утверждается, обеспечивает контроль качества металла и сборки, а также ускоряет процесс выпуска систем. Кроме того, «Рикор» может предлагать заказчикам уникальные решения по оптимизации внутреннего пространства. В результате, клиенты получают «более гибкие, технологичные и экономически выгодные серверы, наиболее полно соответствующие требованиям по локализации и технологической независимости». Производство серверов осуществляется на роботизированном заводе. «Рикор» уже принимает заказы на новые модели, а их отгрузки начнутся в ближайшее время. Компания гарантирует стабильность поставок.

03.02.2026 [11:33], Сергей Карасёв

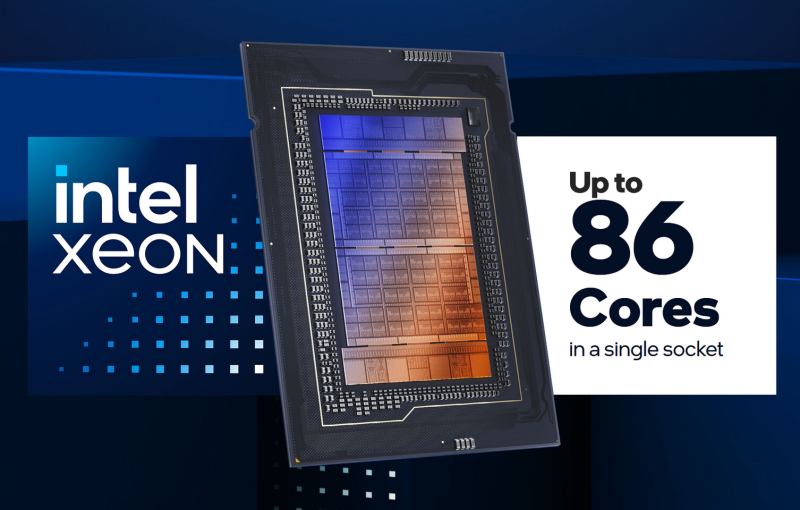

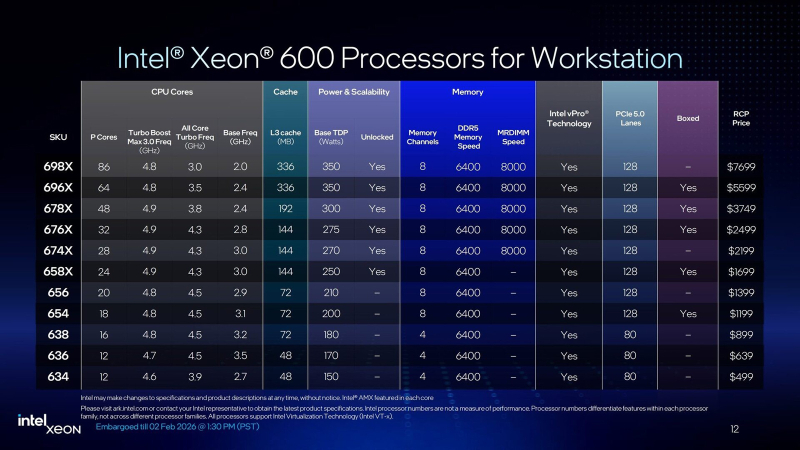

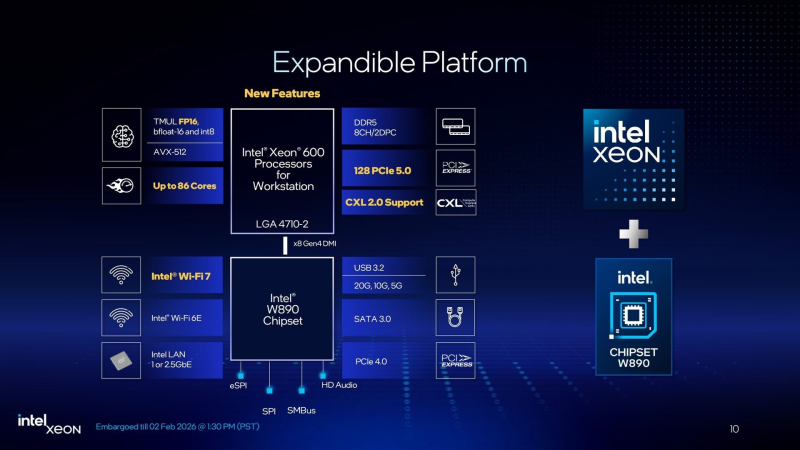

86 P-ядер, 128 линий PCIe 5.0 и 8 каналов DDR5-6400/8800: Intel представила чипы Xeon 600 для рабочих станцийКорпорация Intel представила процессоры семейства Xeon 600 для рабочих станций. В основу чипов положена архитектура Xeon 6700P Granite Rapids. Изделия приходят на смену Xeon W-2500/W-3500 (Sapphire/Emerald Rapids), которые дебютировали летом 2024 года. Процессоры Xeon 600 содержат вычислительные ядра Redwood Cove, количество которых варьируется от 12 до 86. Для сравнения, решения Xeon W-3500 насчитывают максимум 60 ядер. Важно отметить, что задействованы исключительно производительные Р-ядра (энергоэффективные Е-ядра в конструкцию не входят). Благодаря технологии многопоточности возможна обработка одновременно до 172 потоков инструкций. Базовая тактовая частота у новых CPU варьируется от 2,0 ГГц до 3,5 ГГц, а частота в турбо-режиме — от 4,6 до 4,9 ГГц. Объём кеша третьего уровня составляет от 48 до 336 Мбайт, показатель TDP — от 150 до 350 Вт. В серию вошли модели с разблокированным множителем для разгона («Х» в обозначении). Чипы Xeon 630 начального уровня предлагает четыре канала памяти DDR5 и 80 линий PCIe 5.0, в то время как более мощные процессоры Xeon 650/670/690 содержат восемь каналов памяти и 128 линий PCIe 5.0. Говорится о возможности использования модулей RDIMM-6400 и MRDIMM-8000 (только Xeon 670/690). Максимально допустимый объём ОЗУ составляет 4 Тбайт. Реализована поддержка CXL 2.0, что позволяет формировать дополнительны пулы памяти. По заявлениям Intel, по сравнению с процессорами для рабочих станций предыдущего поколения прирост производительности в однопоточном режиме у Xeon 600 составляет до 9 %, в многопоточном режиме — до 61 %. Улучшения затронули встроенный аппаратный ускоритель Intel AMX (Advanced Matrix Extensions), предназначенный для повышения производительности в задачах ИИ, глубокого обучения и анализа данных. Если ранее он поддерживал операции INT8 и BFloat16, то теперь добавлен режим FP16. Среди прочего упомянуты технологии Intel vPro Enterprise и Intel Deep Learning Boost.

В паре с процессорами Xeon 600 будет использоваться новый набор логики Intel W890. Для подключения к CPU служит канал DMI 4.0 x8, обеспечивающий пропускную способность немногим менее 16 Гбайт/с. Чипсет предусматривает поддержку интерфейса USB 3.2 Gen 2×2 (20 Гбит/с), портов SATA-3, дополнительных линий PCIe 4.0, сетевых интерфейсов 1GbE и 2,5GbE, а также Wi-Fi 7. При заказе процессоров Xeon 600 корпорация Intel призывают клиентов убедиться, что новая платформа подходит для их рабочих нагрузок. Чипы поступят в продажу в конце марта по цене от $499 до $7699. Некоторые модели будут доступны в коробочной версии: это изделия Xeon 654 (18 ядер), Xeon 658X (24 ядра), Xeon 676X (32 ядра), Xeon 678X (48 ядер) и Xeon 696X (64 ядра). Материнские платы на чипсете W890 готовят такие компании, как ASUS, Supermicro и Gigabyte. Готовые системы на основе Xeon 600 предложат Dell, HP, Supermicro, Boxx, Pudget Systems и другие поставщики. Вместе с тем, как отмечает The Register, время для анонса Xeon 600 выбрано не совсем удачно. Чипы выходят на рынок на фоне проблем с цепочками поставок, из-за которых резко подскочили цены на память. Так, комплект из восьми модулей DDR5 RDIMM на 32 Гбайт каждый обойдётся более чем в $4000: это примерно на $1500 больше, чем шестью месяцами ранее. Сформировавшаяся ситуация может негативно отразиться на спросе на Xeon 600 среди потребителей.

23.01.2026 [23:54], Владимир Мироненко

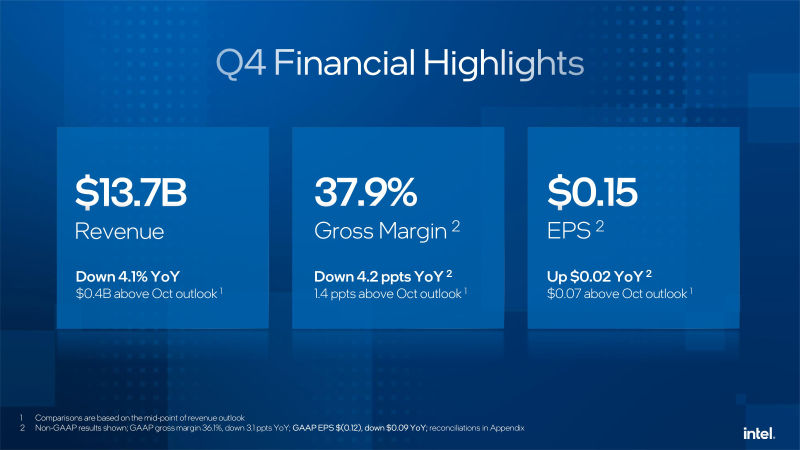

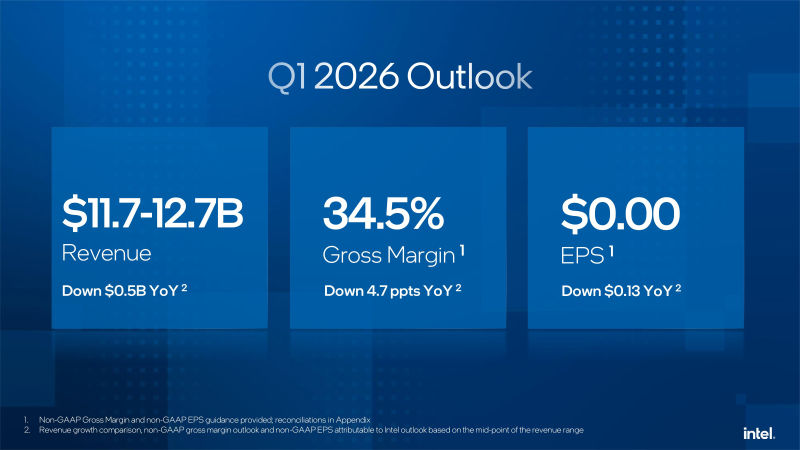

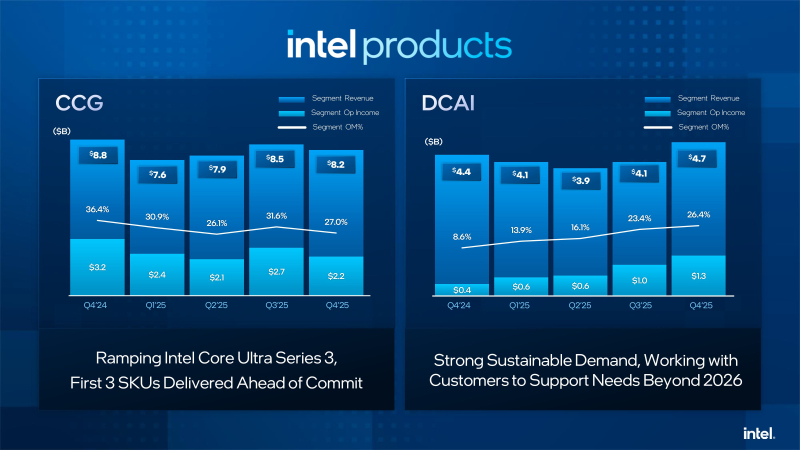

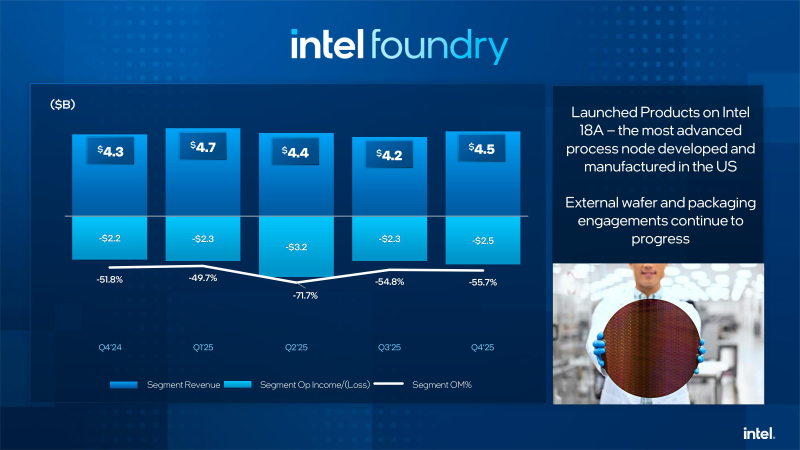

Слабый прогноз из-за дефицита компонентов уронил акции Intel, которая решила сосредоточиться на серверных продуктахКомпания Intel объявила результаты за IV квартал и 2025 финансовый год, завершившийся 27 декабря 2025 года. Хотя результаты за квартал превзошли ожидания Уолл-стрит, из-за слабого прогноза на текущий квартал, а также предупреждения о дефиците поставок, акции компании упали в пятницу на 15 %, сообщил ресурс CNBC. Впрочем, несмотря на падение акций после квартального отчёта, компания по-прежнему демонстрирует уверенный старт в 2026 году и с начала года её ценные бумаги выросли в цене на 47 %. Выручка Intel за IV квартал составила $13,7 млрд, что на 4 % меньше год к году, но выше консенсус-прогноза аналитиков, опрошенных LSEG, в размере $13,4 млрд. Скорректированная прибыль на акцию (non-GAAP) равняется 15¢ при прогнозе аналитиков от LSEG в 8¢. Компания сообщила о чистом убытке (GAAP) за отчётный квартал в размере $591 млн, или 12¢ на разводнённую акцию. Годом ранее у неё тоже был чистый убыток, но меньше — $126 млн, или 3¢ на акцию. Intel объявила, что в текущем квартале рассчитывает на безубыточность по скорректированной прибыли на акцию и выручку в диапазоне от $11,7 до $12,7 млрд. Оба показателя оказались ниже прогноза аналитиков, опрошенных LSEG, ожидающих прибыль в размере 5¢ на акцию при выручке в $12,51 млрд. Как сообщает ресурс SiliconANGLE, финансовый директор Intel Дэвид Зинснер (David Zinsner) объяснил снижение прогноза проблемами с поставками компонентов, которых не хватает для удовлетворения сезонного спроса. По его словам, компания пытается решить эту проблему, повышая эффективность производства или выход годной продукции, чтобы увеличить поставки. «Наша производительность соответствует нашим внутренним планам», — сказал генеральный директор Intel Лип-Бу Тан (Lip-Bu Tan), отметив, что она по-прежнему ниже того уровня, которого ему хотелось бы достичь. Выручка подразделения Datacenter and AI Group (DCAI), которое специализируется на продуктах для ЦОД и ИИ, выросла год к году на 9 % до $4,74 млрд. Операционная прибыль подразделения составила $1,25 млрд. Выручка потребительской группы Client Computing Group (CCG) упала на 7 % до $8,19 млрд. Подразделение Intel Foundry, которое занимается производством чипов, получило выручку в размере $4,51 млрд, что выше год к году на 4 %. При этом его операционный убыток составил $2,51 млрд. Годом ранее подразделение тоже сработало с убытком, составившим $2,25 млрд при выручке $4,34 млрд. Как отметил The Register, по сравнению с катастрофой, которой стал для Intel 2024 финансовый год, прошедший год был значительно лучше. В 2025 году компания понесла убытки всего в $267 млн при выручке в $52,9 млрд. Это значительно лучше рекордных убытков в $18,8 млрд годом ранее. В ходе общения с аналитиками Зинснер признал, что компания оказалась в затруднительном положении после того, как неправильно оценила спрос на свою продукцию для ЦОД, что привело к дефициту мощностей в течение квартала. Дело в том, что полгода назад почти все гипескейлеры говорили о планах заказать меньшее количество чипов с большим количеством ядер, но затем их позиция изменились, и спрос на продукты Intel Xeon значительно вырос в III и IV кварталах. Платформа Intel Xeon 6 широко используется в ИИ-системах, таких как NVIDIA DGX B200 и B300, а также во многих системах с AMD Instinct. Чтобы удовлетворить этот спрос, компания «перенаправляет как можно больше ресурсов в ЦОД», отметил Зинснер. При этом он заверил, что компания не откажется от своего клиентского бизнеса «полностью» в погоне за доходами от ИИ в ЦОД. «В клиентском сегменте мы фокусируемся на среднем и высоком сегментах, а на низком — не так сильно. В той мере, в какой у нас есть избыточные мощности, мы направляем их производство для ЦОД», — сказал финансовый директор. Ранее в этом месяце Тан заявил, что технология производства 18A, конкурирующая с 2-нм техпроцессом TSMC, «превзошла ожидания» в 2025 году. Он указал в годовом отчёте, что Intel «активно работает» над увеличением поставок продукции, изготовленной по техпроцессу 18A, для удовлетворения «высокого спроса со стороны клиентов». Зинснер сообщил ресурсу CNBC, что клиенты для следующего техпроцесса 14A от Intel появятся во II половине года. При этом компания не собирается публично об этом объявлять. «Как только мы их получим, нам нужно будет вкладывать значительные средства в развитие 14A, и тогда вы поймёте, что происходит», — сказал он. Вместе с тем аналитики RBC Capital Markets предупредили, что «значительный вклад в выручку» от клиентов продуктов согласно техпроцессу 14A может появиться не раньше конца 2028 года.

21.01.2026 [13:03], Сергей Карасёв

Dell представила All-Flash СХД PowerStore 5200Q для QLC SSDКомпания Dell расширила ассортимент СХД серии PowerStore, анонсировав модель 5200Q типа All-Flash. Новинка позволяет сформировать интеллектуальное хранилище, обеспечивающее ускорение работы с блочными, файловыми и виртуальными томами. Устройство выполнено на аппаратной платформе Intel. Применены два контроллера, функционирующие в режиме «активный — активный». В общей сложности задействованы четыре неназванных процессора Xeon с 96 вычислительными ядрами, работающими на частоте 2,2 ГГц. Объём оперативной памяти составляет 1152 Гбайт. СХД имеет типоразмер 2U. Во фронтальной части расположены 25 отсеков для SFF-накопителей NVMe. Могут применяться SSD на основе чипов памяти QLC вместимостью 15,36 и 30,72 Тбайт. Питание обеспечивают два блока с резервированием. В общей сложности могут быть использованы до 24 сетевых Front-end-портов в следующей конфигурации: 16 × FC16/32, 24 × 10GbE, 24 × 10/25GbE или 8 × 100GbE. Секция Back-end включает порты 100GbE QSFP. Кроме того, предусмотрен выделенный сетевой порт управления 1GbE. Говорится о поддержке протоколов FC, NVMe/FC, iSCSI, NVMe/TCP, NFSv3/4/4.1/4.2; CIFS SMB 2/3.0/3.02/3.1.1, FTP и SFTP. В связке с СХД могут функционировать до трёх модулей расширения формата 2U, рассчитанных на 24 накопителя SFF (NVMe) каждый. Таким образом, в общей сложности система с учётом устройств расширения может содержать до 93 накопителей SFF и четыре изделия NVRAM. В составе кластера количество SSD может достигать 372 штук при суммарной вместимости 23,6 Пбайт с учётом компрессии. В качестве программной платформы применяется PowerStore OS.

20.01.2026 [12:12], Сергей Карасёв

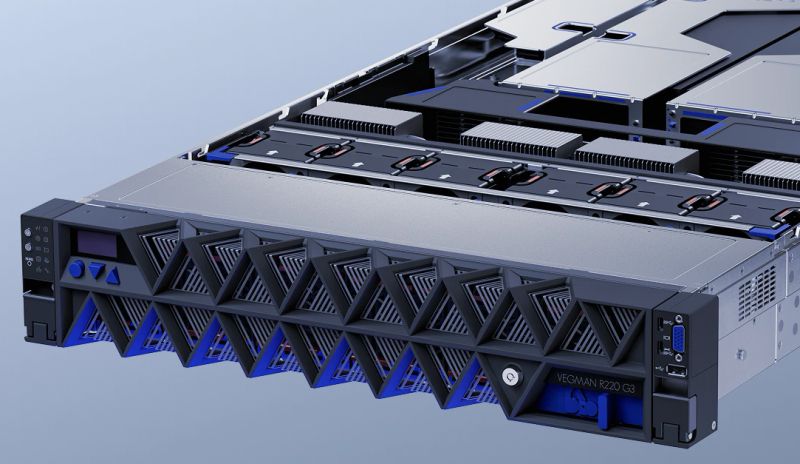

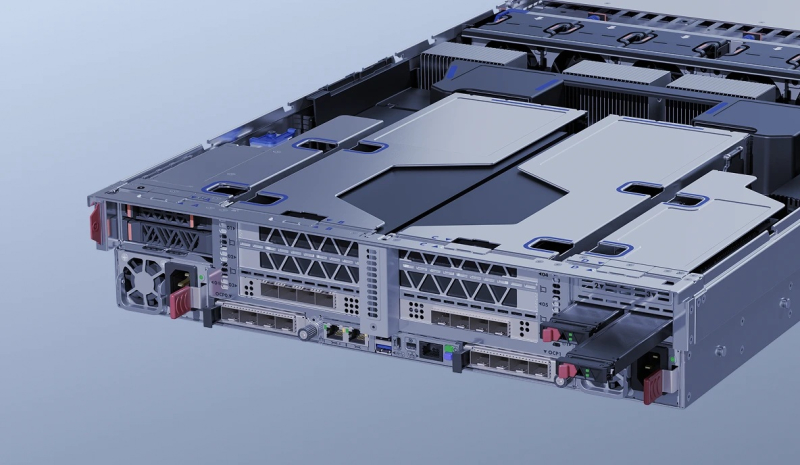

YADRO выпустила отечественные серверы Vegman R220 G3 на базе Intel Xeon Emerald RapidsКомпания YADRO, входящая в «ИКС Холдинг», объявила о доступности универсальных серверов Vegman R220 G3 на аппаратной платформе Intel. Устройства подходят для широкого спектра задач — от хранения и аналитики данных до НРС-приложений и нагрузок ИИ, говорит компания. Новинки выполнены в форм-факторе 2U. Допускается установка двух процессоров Xeon Sapphire Rapids или Xeon Emerald Rapids с показателем TDP до 350 Вт. Возможно использование до 8 Тбайт оперативной памяти DDR5-4400/5600 RDIMM в конфигурации 32 × 256 Гбайт. Во фронтальной части в зависимости от модификации могут быть установлены до 12 накопителей LFF (SAS/SATA/NVMe) или до 24 накопителей SFF (SAS/SATA плюс 16 × NVMe). Сзади предусмотрены посадочные места для четырёх изделий SFF (или 2 × SFF и 2 × M.2/E1.S). Допускается формирование массивов RAID 0/1/10/5/50/6/60. Реализована поддержка CXL 1.1. Есть два сетевых порта 1GbE и выделенный сетевой порт управления 1GbE (все с разъёмами RJ45). Доступны до 11 слотов PCIe 5.0 с учетом OCP 3.0 SFF и гнезда под контроллер RAID/HBA. Спереди находятся два порта USB 3.1 Type-C, по одному разъёму USB 2.0 Type-A и D-Sub, сзади — два порта USB 3.1 Type-A, последовательный интерфейс (разъём USB Type-C) и коннектор Mini DisplayPort (BMC). Питание обеспечивают два блока мощностью до 2700 Вт с сертификатом 80 PLUS Platinum. Применено воздушное охлаждение с шестью вентиляторами диаметром 60 мм с возможностью горячей замены. Диапазон рабочих температур — от +10 до +35 °C при относительной влажности от 20 % до 80 %. Заявлена совместимость с Astra Linux, ALT Linux, RED OS, zVirt и пр. С серверами поставляется ПО управления «YADRO Суприм» и набор инструментов Vegman Satellites. Реализована поддержка доступа через IPMI 2.0, WebUI, CLI, SNMP, Redfish. Устройства Vegman R220 G3 включены в Единый реестр российской радиоэлектронной продукции Минпромторга, что подтверждает соблюдение требований локализации.

13.01.2026 [09:03], Руслан Авдеев

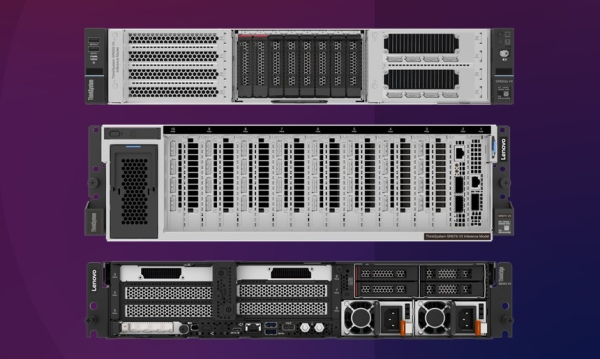

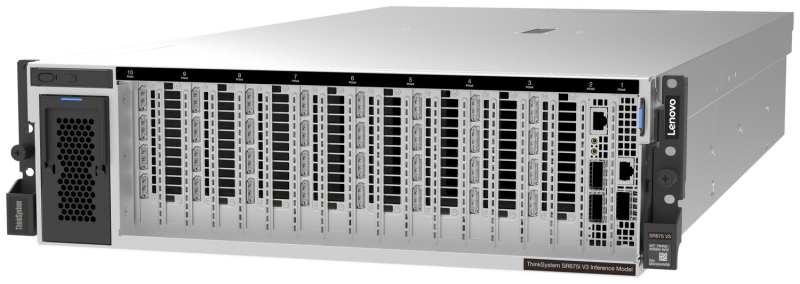

Lenovo представила серверы для ИИ-инференса: ThinkSystem SR675i V3/SR650i V4 и ThinkEdge ThinkEdge SE455i V4Lenovo представила новые серверные системы серии Lenovo Hybrid AI Advantage, оптимизированные для ИИ-инференса: ThinkSystem SR675i V3, ThinkSystem SR650i V4 и ThinkEdge SE455i V4. Если ранее акцент делался на решениях для обучения всё более производительных ИИ-моделей, то теперь бизнес обращает всё больше внимания на продукты для инференса. Новинки предлагаются параллельно с ПО для оптимизации инференса — для унификации и получения данных из разных источников для использования ИИ-моделями. Флагманской версией серии является ThinkSystem SR675i V3 в исполнении 3U на платформе AMD EPYC Turin 9535 (64C/128T, 2,4 ГГц, TDP 300 Вт). Сервер получил 1,5 Тбайт DDR5-6400 (24 × 64 Гбайт). За хранение данных отвечают до двух E3.S NVMe SSD по 3,84 Тбайт (PCIe 5.0 x4) и до двух M.2 NVMe SSD по 960 Гбайт (PCIe 4.0 x4). Возможна установка восьми ускорителей NVIDIA RTX PRO 6000 Blackwell Server Edition, а также пяти DPU NVIDIA BlueField-3 (4 × 400G, 1 × 200G). IPMI в данной модели не доступен. Для карт расширения доступно до шести слотов PCIe 5.0 х16 и один слот OCP 3.0 x8/x16. За питание отвечают четыре блока Titanium второго поколения (по 2300 Вт), а за охлаждение — пять вентиляторов. ThinkSystem SR650i V4 позиционируется в качестве системы для инференса и корпоративных рабочих нагрузок. Этот 2U-сервер получил два Intel Xeon Granite Rapids-SP 6530P (32C/64T, 2,3 ГГц, TDP 225 Вт), 512 Гбайт DDR5-6400 (8 × 64 Гбайт), два ускорителя RTX PRO 6000 Blackwell Server Edition. За хранение отвечают два 3,84-Тбайт U.2 NVMe SSD (PCIe 5.0 x4), хотя всего таких слотов восемь, а также RAID1-массив из пары 960-Гбайт M.2 SATA SSD. Всего доступно шесть слотов расширения PCIe 5.0 x16 и два слота OCP 3.0 x8/x16. Имеется двухпортовый 25GbE-адаптер Broadcom 57414 (SFP28). За питание отвечают два Titanium-блока мощностью 2700 Вт каждый, а за охлаждение шесть вентиляторов, но есть и опция установки фирменной СЖО Neptune. Наконец, Lenovo ThinkEdge SE455i V3 (2U) глубиной всего 440 мм представляет собой компактную модель, предназначенную для периферийного инференса — в ретейле, телекоммуникациях и промышленности. Сервер имеет защищённую конструкцию и может работать при температурах от -5 до +40 °C. Сервер построен на базе одного процессора AMD EPYC Embedded 8534P (64C/128T, 2,3 ГГц, TDP 200 Вт), дополненного 576 Гбайт DDR5-4800 (6 × 96 Гбайт) и двумя ускорителями NVIDIA L4 24 Гбайт (PCIe 4.0 x16). В комплекте идёт один 3,84-Тбайт NVMe SSD и один 960-Гбайт SATA SSD. Имеется два блока питания Platinum второго поколения с возможностью горячей замены. Для карт расширения есть до двух слотов PCIe 5.0 x16 и до четырёх слотов PCIe 4.0 x8, а также один слот OCP 3.0 (PCIe 5.0 x16). Установлен двухпортовый OCP-адаптер Broadcom 57416 (10GbE). IPMI отключён. Фактически компания предлагает готовые конфигурации, которые можно переконфигурировать лишь слегка, чаще всего добавив накопители и/или сетевые адаптеры. Платформы будут доступны в рамках подписки TruScale. Также компания анонсировала новые сервисы Hybrid AI Factory Services, в том числе консультации по инференсу, которые помогают развёртывать оборудование и управлять им для оптимизации ИИ-производительности.

12.01.2026 [13:16], Сергей Карасёв

Supermicro представила SuperBlade-сервер на базе Intel Xeon 6900 с СЖОКомпания Supermicro анонсировала сервер SBI-622BA-1NE12-LCC семейства SuperBlade, предназначенный для построения вычислительных платформ высокой плотности. Устройство будет предлагаться в вариантах с воздушным и прямым жидкостным охлаждением: в первом случае в шасси типоразмера 6U могут быть размещены пять узлов, во втором — десять. Каждый узел SuperBlade поддерживает установку двух процессоров Intel Xeon 6900 поколения Granite Rapids, насчитывающих до 128 производительных P-ядер. Показатель TDP может достигать 500 Вт. Доступны 24 слота для модулей оперативной памяти DDR5-6400/8800 суммарным объёмом до 3 Тбайт. Предусмотрены два посадочных места для накопителей E1.S. Опционально могут быть также установлены два NVMe SSD формата M.2 2280 или M.2 22110. Реализованы три слота PCIe 5.0 x16 для карт формата FHHL, HHHL/LP и OCP 3.0. В оснащение входят контроллер Aspeed AST2600 и адаптер Intel E810-XXVAM2, на базе которого реализованы два сетевых порта 25GbE. Шасси, в которое монтируются серверные узлы SBI-622BA-1NE12-LCC, оснащено модулями управления и Ethernet-коммутаторами с резервированием. Питание обеспечивают восемь блоков с сертификатом 80 Plus Titanium. Диапазон рабочих температур — от +10 до +35 °C. По заявлениям Supermicro, передовой дизайн шасси 6U обеспечивает сокращение количества кабелей на 93 % и экономию пространства на 50 % по сравнению с серверами в форм-факторе 1U с сопоставимой конфигурацией. Новинка ориентирована на решение НРС-задач в таких областях, как производство, финансы, научные исследования, энергетика, моделирование климата и пр. |

|