Материалы по тегу: gpu

|

28.01.2026 [13:43], Сергей Карасёв

Китайский стартап Iluvatar CoreX обещает GPU-ускорители, превосходящие по возможностям NVIDIA RubinСтартап Iluvatar CoreX из Китая, по сообщению DigiTimes, раскрыл планы по выпуску ускорителей на основе GPU для ИИ-задач. Речь идёт об изделиях четырёх поколений, которые, как предполагается, смогут составить конкуренцию продукции NVIDIA. В частности, Iluvatar CoreX создаёт решения на архитектуре с кодовым названием Tianshu. Такие устройства, по утверждениям разработчика, по производительности превзойдут ускорители NVIDIA поколения Hopper, включая H200. На 2026 год компания Iluvatar CoreX запланировала анонс ускорителей на архитектуре Tianxuan, которым предстоит конкурировать с решениями семейства NVIDIA Blackwell, в том числе с B200. Кроме того, позднее в текущем году Iluvatar CoreX намерена представить изделия на архитектуре следующего поколения Tianji: по быстродействию такие чипы, предположительно, будут опережать Blackwell. Наконец, на 2027-й китайский стартап запланировал выпуск GPU с архитектурой Tianquan, которая по производительности призвана превзойти платформу NVIDIA Rubin. После этого Iluvatar CoreX рассчитывает сфокусировать внимание на разработке «прорывных вычислительных архитектур». По состоянию на 30 июня 2025 года Iluvatar CoreX отгрузила более 52 тыс. GPU примерно 290 корпоративным клиентам, в том числе из финансовой сферы и сектора здравоохранения. Компания позиционирует себя в качестве поставщика высокопроизводительных GPU общего назначения и крупномасштабных вычислительных систем. Вместе с тем, как и другие китайские разработчики ИИ-чипов, Iluvatar CoreX сталкивается с проблемами, связанными со сбоями в цепочках поставок и доступом к передовым производственным мощностям. Дальнейшее развитие продуктового семейства компании будет зависеть от внедрения современных технологических процессов и методов корпусировки. Помимо GPU-продуктов, Iluvatar CoreX также разрабатывает изделия Tongyang для периферийных вычислений. По заявлениям стартапа, один из подобных чипов — TY1000 — продемонстрировал превосходство над NVIDIA Jetson AGX Orin в реальных задачах, включая компьютерное зрение, обработку естественного языка и ИИ-инференс с использованием таких больших языковых моделей, как DeepSeek 32B.

26.01.2026 [14:04], Сергей Карасёв

Расходы на аренду GPU-серверов в России достигли 17 млрд руб.В 2025 году объём российского рынка аренды выделенных GPU-серверов (bare-metal) составил приблизительно 17 млрд руб. В 2026-м ожидается двукратный рост с итоговым результатом на уровне 34 млрд руб. Такую оценку, как сообщает газета «Коммерсантъ», приводит отечественный облачный провайдер и поставщик комплексной IT-инфраструктуры «Рег.облако». Отмечается, что около 60 % спроса в сегменте аренды GPU-серверов в РФ приходится на задачи ИИ и машинного обучения. Ещё 30 % выручки обеспечивают сервисы VDI, оставшиеся 10 % — нагрузки, связанные с рендерингом. Спрос на аренду GPU-серверов устойчиво растёт, поскольку такая модель позволяет выполнять НРС-задачи без необходимости формирования собственной дорогостоящей инфраструктуры. Кроме того, компании могут наращивать или сокращать вычислительные мощности в зависимости от меняющихся потребностей, оплачивая только фактически используемые ресурсы. По данным «Рег.Облака», стоимость аренды GPU-систем начинается примерно с 51 тыс. руб. и может превышать 1,5 млн руб. в месяц за сервер (в зависимости от конфигурации). Около половины от суммарной выручки провайдеров обеспечивают клиенты из сферы IT. Приблизительно 17 % поступлений приходится на заказчиков в сегменте торговли, 11 % — на организации из сферы услуг. Представитель ITPOD подчёркивает, что ИИ-технологии в реальном бизнесе в России пока развиваются через пилотные проекты и тесты гипотез. А поэтому аренда GPU-серверов является наиболее рациональным решением, поскольку избавляет от капитальных затрат и позволяет прогнозировать расходы. Представитель «СКБ Контур» добавляет, что в аренде GPU-ресурсов заинтересованы средние и крупные компании, у которых нет собственной ИИ-инфраструктуры. Вместе с тем, по оценкам MWS Cloud, суммарный объём рынка решений на базе GPU для локального развёртывания (on-premises) с учётом аренды и приобретения оборудования в собственность в 2025 году вырос на четверть, превысив 112 млрд руб.

19.12.2025 [18:35], Сергей Карасёв

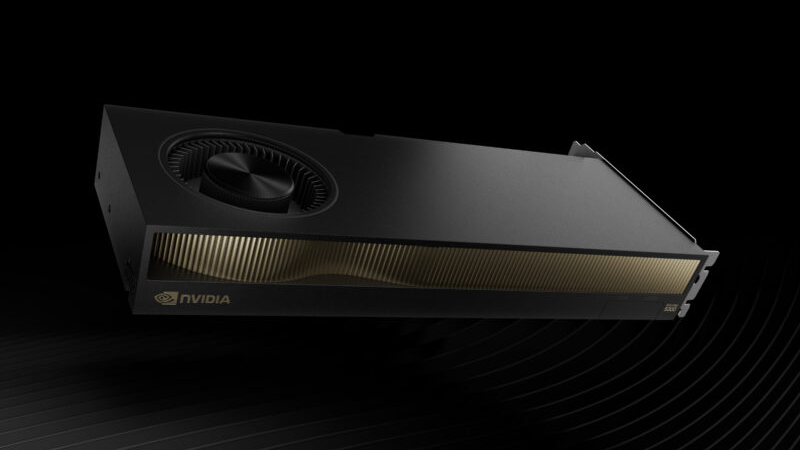

NVIDIA выпустила ускоритель RTX Pro 5000 Blackwell с 72 Гбайт памяти для рабочих станцийКомпания NVIDIA сообщила о доступности ускорителя RTX Pro 5000 Blackwell с 72 Гбайт памяти GDDR7 (ECC) для мощных рабочих станций, ориентированных на ИИ-задачи, включая «тонкую» настройку больших языковых моделей (LLM). Новинка является собратом ранее выпущенной версии RTX Pro 5000 Blackwell с 48 Гбайт GDDR7, по сравнению с которой объём памяти увеличился в полтора раза. Оба ускорителя построены на чипе Blackwell с 14 080 ядрами CUDA. Задействованы тензорные ядра пятого поколения и RT-ядра четвёртого поколения. Говорится об использовании 512-бит шины памяти; пропускная способность — 1344 Гбайт/с. Новинка выполнена в виде двухслотовой карты расширения полной высоты с интерфейсом PCIe 5.0 x16.

Источник изображения: NVIDIA Выпущенный ускоритель располагает четырьмя разъёмами DisplayPort 2.1b. Возможен одновременный вывод изображения на несколько мониторов в следующих конфигурациях: четыре с разрешением до 4096 × 2160 пикселей и частотой обновления 120 Гц, четыре с разрешением 5120 × 2880 точек и частотой 60 Гц или два с разрешением 7680 × 4320 пикселей и частотой 60 Гц. Заявлена поддержка DirectX 12, Shader Model 6.6, OpenGL 4.63, Vulkan 1.33, а также CUDA 12.8, OpenCL 3.0 и DirectCompute. Заявленная ИИ-производительность достигает 2142 TOPS. Карта оборудована 16-контактным разъёмом дополнительного питания. Энергопотребление находится на уровне 300 Вт. Применено активное охлаждение с вентилятором. Ускоритель RTX Pro 5000 Blackwell с 72 Гбайт памяти предлагается через партнёрские каналы, включая Ingram Micro, Leadtek, Unisplendour и xFusion.

11.12.2025 [17:40], Сергей Карасёв

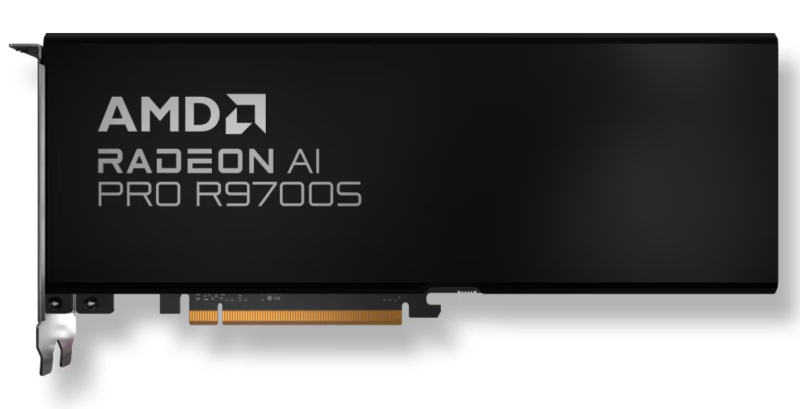

32 Гбайт GDDR6 и до 4096 потоковых процессоров: AMD представила ускорители Radeon AI Pro R9700S и R9600D для рабочих станцийAMD пополнила семейство профессиональных видеокарт Radeon AI Pro R9000 моделями Radeon AI Pro R9700S и Radeon AI Pro R9600D, выполненными на архитектуре RDNA 4 с графическим чипом Navi 48. Ускорители рассчитаны на использование в рабочих станциях. Модель Radeon AI Pro R9700S получила 64 исполнительных блока, 4096 потоковых процессоров и 128 ИИ-блоков. Изделие насчитывает 53,9 млрд транзисторов. Игровая частота (Game Frequency) достигает 2350 МГц, частота с ускорением (Boost Frequency) — 2920 МГц. Пиковая ИИ-производительность в режиме FP32 достигает 47,8 Тфлопс, на векторных операциях FP16 — 95,7 Тфлопс, в режиме INT8 (Structured Sparsity) — 766 TOPS. Энергопотребление составляет 300 Вт. В свою очередь, версия Radeon AI Pro R9600D располагает 48 исполнительными блоками, 3072 потоковыми процессорами и 96 ИИ-блоками. Игровая частота — 1080 МГц, частота с ускорением — 2020 МГц. Показатели быстродействия в режимах FP32, FP16 Vector и INT8 Structured Sparsity указаны на отметках 24,8 Тфлопс, 49,6 Тфлопс и 397 TOPS соответственно. Энергопотребления равно 150 Вт. Обе новинки используют интерфейс PCIe 5.0 x16, несут на борту 32 Гбайт памяти GDDR6 с 256-бит шиной и пропускной способностью до 640 Гбайт/с. Объём кеша AMD Infinity Cache равен 64 Мбайт. Ускорители получили двухслотовое исполнение и по четыре интерфейса DisplayPort 2.1a. Задействовано пассивное охлаждение. Заявлена совместимость с Windows 10/11 и Linux. Среди поддерживаемых технологий упомянуты AMD Fluid Motion Frames, Radeon Super Resolution, Smart Access Memory, Smart Access Video, Radeon Anti-Lag, Radeon Image Sharpening 2, Enhanced Sync, FreeSync, Radeon Chill, Virtual Super Resolution, FSR и др. Также поддерживается работа с ROCm.

04.12.2025 [15:49], Сергей Карасёв

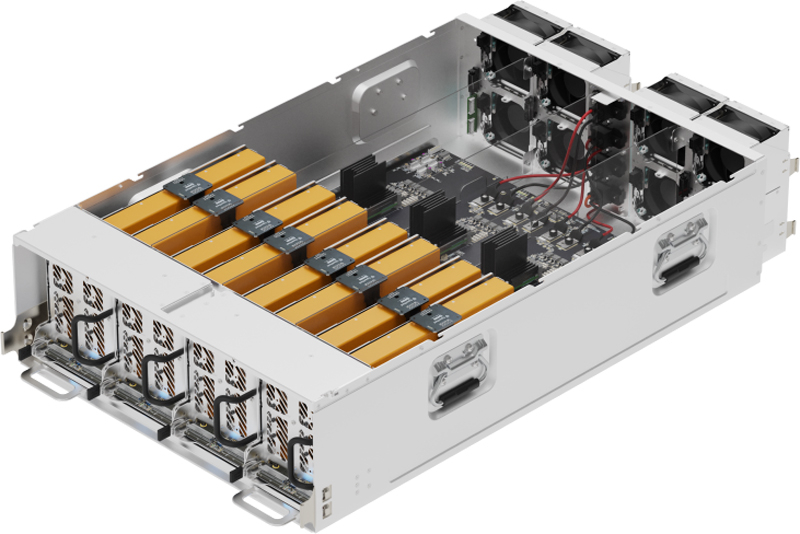

Лаборатория МФТИ получила российский JBOG-массив RSC ScaleStream-C для решения сложных ИИ-задачЛаборатория машинного обучения в науках о Земле Московского физико-технического института (МФТИ) взяла на вооружение внешний массив PCIe-коммутации RSC ScaleStream-C, разработанный российской группой компаний РСК. Это решение предназначено для выполнения ресурсоёмких задач, связанных с ИИ. RSC ScaleStream-C представляет собой JBOG-платформу в форм-факторе 3U, допускающую установку до десяти карт с интерфейсом PCIe 4.0 x16 (могут применяться карты разной ширины), которая может быть подключена к четырём серверам. Мощности ускорителей могут динамически перераспределяться между серверами. По заявлениям РСК, такой подход позволяет значительно увеличить утилизацию GPU (в некоторых случаях на десятки процентов) по сравнению со стандартными конфигурациями, когда карты устанавливаются непосредственно в серверы. Лаборатория получила массив RSC ScaleStream-C с четырьмя GPU (модель не уточняется). В перспективе могут быть добавлены дополнительные карты. Предполагается, что система поможет ускорить выполнение задач, связанных с базовыми высокоразрешающими ИИ-моделями атмосферы, океана и климата. Ожидается, что применение RSC ScaleStream-C позволит Лаборатории машинного обучения в науках о Земле существенно расширить возможности уже имеющегося оборудования при работе с ИИ-моделями. Основным направлением деятельности Лаборатории является создание ИИ-методов для моделирования атмосферы, океана и климата, а также для обработки данных в фундаментальных и прикладных задачах морской геологии, морской биологии, экологии моря, метеорологии, в области взаимодействия океана и атмосферы, городской микрометеорологии и пр. Специалисты лаборатории занимаются обработкой данных натурных наблюдений и измерений в метеорологии и океанологии, экологическим мониторингом, моделированием природных процессов и другими задачами, для которых требуются значительные вычислительные ресурсы.

02.12.2025 [18:20], Сергей Карасёв

Российская ИИ-система Delta Sprut XL поддерживает до 25 GPU

delta computers

gpu

granite rapids

h200

hardware

intel

nvidia

ocp

rtx

sierra forest

xeon

ии

сделано в россии

сервер

Российская компания Delta Computers представила OCP-систему Delta Sprut XL, предназначенную для ресурсоёмких нагрузок, таких как обучение ИИ-моделей, инференс, научное моделирование и задачи HPC. В основу новинки положена аппаратная платформа Intel Xeon 6. CPU-секция допускает установку двух процессоров Sierra Forest-SP или Granite Rapids-SP с показателем TDP до 330 и 350 Вт соответственно: в первом случае могут быть задействованы в общей сложности до 288 E-ядер, во втором — до 172 P-ядер. Доступны 32 слота для модулей оперативной памяти DDR5-6400 RDIMM или DDR5-8000 MRDIMM суммарным объёмом до 8 Тбайт. Могут быть установлены четыре SFF-накопителя U.2 толщиной 15 мм с интерфейсом PCIe 5.0 (NVMe) или восемь таких SSD толщиной 7 мм. Кроме того, есть два коннектора M2.2280 (PCIe). Реализованы четыре слота PCIe 5.0 x16 для карт типоразмера HHHL и слот OCP 3.0 (PCIe 5.0). Присутствуют разъёмы USB 3.0 Type-A и miniDP, а также выделенный сетевой порт управления 1GbE. В системе Delta Sprut XL ускорители на базе GPU устанавливаются в отдельные модули. В общей сложности могут использоваться до 20 карт NVIDIA H200 или до 25 экземпляров NVIDIA RTX Pro 6000 Blackwell Server Edition. Каждый квартет NVIDIA H200 объединён при помощи NVLink. «Delta Computers представляет GPGPU-платформу, способную консолидировать до 20 ускорителей NVIDIA H200 в одном кластере. При этом необходимость использования InfiniBand или 400GbE появляется лишь в случае потребности у заказчика в ещё большем количестве ускорителей — при таком сценарии предусмотрены отдельные слоты расширения для объединения нескольких платформ Delta Sprut XL в единый кластер», — отмечает компания. Питание обеспечивается посредством централизованного шинопровода OCP на 12 или 48 В. Применено встроенное ПО Delta BMC, предназначенное для мониторинга (сбор телеметрии, отслеживание состояния платформы, её модулей и компонентов) и удалённого администрирования серверного оборудования. Эта прошивка включена в реестр Минцифры РФ и сертифицирована ФСТЭК.

29.11.2025 [14:58], Сергей Карасёв

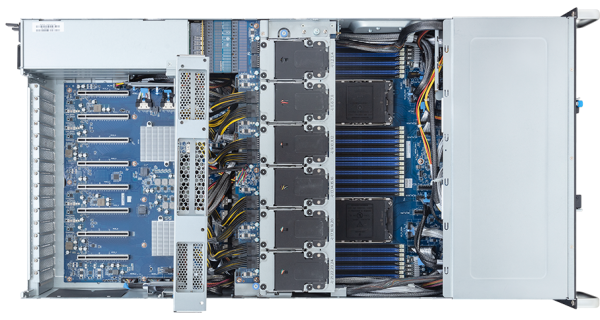

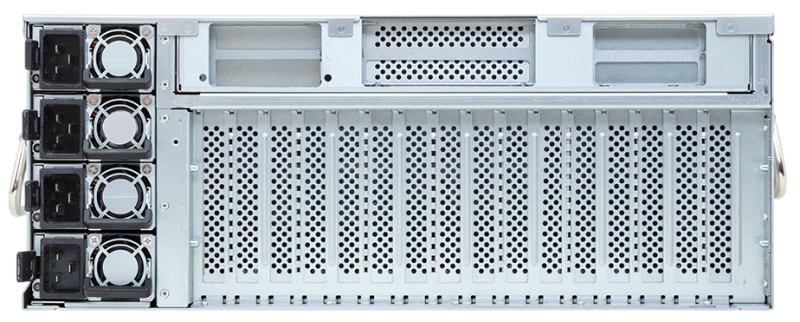

MGX-сервер MSI CG480-S6053 получил чипы AMD EPYC Turin и восемь слотов PCIe 5.0 x16 для FHFL-карт двойной шириныКомпания MSI анонсировала сервер CG480-S6053, предназначенный для ресурсоёмких задач ИИ и НРС. Устройство выполнено в форм-факторе 4U на архитектуре NVIDIA MGX. Возможна установка двух процессоров AMD EPYC 9005 Turin в исполнении Socket SP5 с показателем TDP до 500 Вт. Доступны 24 слота для модулей оперативной памяти DDR5-6400 RDIMM/RIMM-3DS суммарным объёмом до 6 Тбайт (в конфигурации 24 × 256 Гбайт). Во фронтальной части расположены восемь отсеков для SFF-накопителей U.2 с интерфейсом PCIe 5.0 x4 (NVMe); допускается горячая замена. Есть два внутренних коннектор М.2 для SSD типоразмера 2280/22110 с интерфейсом PCIe 3.0 x2 (NVMe). Сервер оснащён восемью слотами PCIe 5.0 x16 для карт FHFL двойной ширины. Могут устанавливаться, в частности, ИИ-ускорители NVIDIA H200 NVL и RTX Pro 6000 Blackwell Server Edition. Кроме того, есть пять слотов PCIe 5.0 x16 для карт FHFL одинарной ширины. Сервер располагает контроллером ASPEED AST2600, двумя сетевыми портами 10GbE (RJ45) на основе Intel X710-AT2, выделенным сетевым портом управления 1GbE, разъёмами USB 3.0/2.0 Type-A и Mini-DisplayPort. Модификация системы с обозначением CG481-S6053 получила восемь портом 400GbE на базе NVIDIA ConnectX-8 SuperNIC. Предусмотрен модуль TPM 2.0. Новинка имеет размеры 438,5 × 175 × 800 мм. Питание обеспечивают четыре блока с резервированием мощностью 3200 Вт (80 PLUS Titanium). Применено воздушное охлаждение с десятью системными вентиляторами диаметром 80 мм с возможностью горячей замены. Диапазон рабочих температур — от +10 до +35 °C.

25.11.2025 [17:23], Сергей Карасёв

JBOG-массив OpenYard HG402 допускает установку восьми GPUРоссийский разработчик и производитель серверного оборудования OpenYard анонсировал JBOG-массив HG402, предназначенный для решения ресурсоёмких вычислительных задач, связанных в том числе с машинным обучением и приложениями ИИ. Новинка выполнена в форм-факторе 4OU в соответствии со стандартом OpenRack v2.2. Доступны восемь слотов для установки карт с интерфейсом PCIe 4.0 x16. Производитель говорит о совместимости с такими картами, как NVIDIA GeForce RTX 4080 и RTX 5090 (с собственными радиаторами OpenYard), а также NVIDIA A100 и H100. Для подключения массивов к хосту используются кабели MCIO (PCIe 4.0). При этом один хост может задействовать до четырёх GPU. Таким образом, ресурсы массива могут использоваться одновременно двумя серверами.

Источник изображения: OpenYard Среди преимуществ решения OpenYard HG402 разработчик называет возможность применения ускорителей потребительского уровня для инференса, оптимизированное охлаждение, а также управление через систему OYBMC. Обеспечивается быстрая замена GPU и вентиляторов; при этом для обслуживания массива не требуются инструменты. Ранее компания OpenYard представила GPU-сервер HN203I, построенный на аппаратной платформе Intel. Устройство допускает установку двух процессоров Xeon 6700E (Sierra Forest-SP) или Xeon 6500P/6700P (Granite Rapids-SP), до 8 Тбайт оперативной памяти DDR5, десяти SFF-накопителей (NVMe) с возможностью горячей замены и четырёх LFF-устройств с интерфейсом SATA/SAS. Есть восемь слотов PCIe 5.0 x16 MCIO и три слота PCIe 5.0 x4 MCIO, а также разъём OCP 3.0 (PCIe 5.0 x16).

21.11.2025 [11:14], Сергей Карасёв

Supermicro представила ИИ-сервер 10U на базе AMD Instinct MI355X с воздушным охлаждениемКомпания Supermicro анонсировала высокопроизводительный GPU-сервер AS-A126GS-TNMR, построенный на аппаратной платформе AMD. Система, выполненная в форм-факторе 10U, ориентирована на НРС-нагрузки и решение ресурсоёмких задач в сфере ИИ. Сервер может нести на борту два процессора AMD EPYC 9005 Turin или EPYC 9004 Genoa со 192 ядрами каждый (показатель TDP до 500 Вт). Доступны 24 слота для модулей оперативной памяти DDR5-6400 суммарным объёмом до 6 Тбайт. Во фронтальной части расположены десять отсеков для SFF-накопителей в конфигурации 8 × NVMe (PCIe 5.0 x4) и 2 × SATA с возможностью горячей замены. Кроме того, есть два лицевых слота для SSD формата M.2 (NVMe). В оснащение входят восемь ускорителей AMD Instinct MI355X, оборудованных 288 Гбайт памяти HBM3E с пропускной способностью до 8 Тбайт/с. Применяется интерконнект AMD Infinity Fabric. Реализовано воздушное охлаждение: спереди размещены пять вентиляторных блоков, сзади — десять (все они допускают горячую замену). Диапазон рабочих температур простирается от +10 до +35 °C.

Источник изображения: Supermicro Сервер располагает двумя сетевыми портами 10GbE RJ45 на базе контроллера Intel X710, выделенным сетевым портом управления 1GbE, двумя портами USB 3.0 Type-A, аналоговым разъёмом D-Sub, модулем TPM 2.0, восемью слотами PCIe 5.0 x16 для низкопрофильных (LP) карт расширения и двумя слотами PCIe 5.0 x16 для карт FHHL. Габариты составляют 438,8 × 449 × 843,28 мм, масса — 133 кг. Питание обеспечивают шесть блоков мощностью 5250 Вт с резервированием (3 + 3), которые имеют сертификацию 80 Plus Titanium. Поставки системы AS-A126GS-TNMR уже начались.

18.11.2025 [13:36], Сергей Карасёв

ИИ-сервер с турбонаддувом: Giga Computing G494-SB4 вмещает восемь двухслотовых ускорителей и предлагает дополнительный модуль охлажденияКомпания Giga Computing, подразделение Gigabyte, пополнила ассортимент ИИ-серверов моделью G494-SB4-AAP2, построенной на аппаратной платформе Intel. Система может нести на борту до восьми PCIe-ускорителей — например, NVIDIA RTX Pro 6000 Blackwell Server Edition, Intel Gaudi3 или NVIDIA H200 NVL. Сервер выполнен в форм-факторе 4U. Допускается установка двух процессоров Intel Xeon 6500P и 6700P поколения Granite Rapids-SP с показателем TDP до 350 Вт. Доступны 32 слота для модулей DDR5 (RDIMM-6400 или MRDIMM-8000). Во фронтальной части расположены 12 отсеков для SFF-накопителей с интерфейсом PCIe 5.0 (NVMe), SATA-3 или SAS-4; допускается горячая замена. Сервер располагает восемью слотами для ИИ-ускорителей FHFL PCIe 5.0 x16, четырьмя разъёмами для карт расширения типоразмера FHHL с интерфейсом PCIe 5.0 x16 (по два спереди и сзади) и тремя слотами для низкопрофильных (LP) карт, также оснащённых интерфейсом PCIe 5.0 x16. Присутствуют сетевой адаптер Intel X710-AT2 с двумя портами 10GbE (разъёмы RJ45 на лицевой панели), выделенный сетевой порт управления 1GbE (RJ45) и контроллер ASPEED AST2600. Предусмотрены два порта USB 3.2 Gen1 Type-A и аналоговый коннектор D-Sub. За питание отвечают четыре блока мощностью 3000 Вт с сертификатом 80 PLUS Titanium. Реализовано воздушное охлаждение с двумя системными вентиляторами диаметром 40 мм и 12 вентиляторами диаметром 60 мм. Дополнительно доступен блок из четырёх 80-мм вентиляторов. Он добавляет около 120 мм к глубине сервера, но зато позволяет использовать восемь 600-Вт ускорителей. Диапазон рабочих температур — от +10 до +35 °C (до +25 °C при использовании H200 NVL). Габариты составляют 448 × 176 × 880 мм, масса — 66,8 кг. Гарантирована совместимость с Red Hat Enterprise Linux 10.0 и выше, а также с Windows Server 2025. |

|