Компания LG AI Research (ИИ-подразделение LG Group) из Южной Кореи заключила соглашение с южнокорейским стартапом FuriosaAI о выпуске серверов с ИИ-ускорителями RNGD для работы с собственным семейством LLM Exaone, сообщил The Register. Как сообщил генеральный директор FuriosaAI Джун Пайк (June Paik) изданию EE Times, серверы LG с чипами RNGD будут ориентированы на предприятия, использующие модели ExaOne в сфере электроники, финансов, телекоммуникаций и биотехнологий. Серверы поступят в продажу в конце этого года.

«После тщательного тестирования широкого спектра опций мы пришли к выводу, что RNGD — высокоэффективное решение для развёртывания моделей Exaone», — заявил Киджонг Чон (Kijeong Jeon), руководитель подразделения продуктов LG AI Research. «RNGD обеспечивает убедительное сочетание преимуществ: превосходную производительность в реальных условиях, значительное снижение совокупной стоимости владения и удивительно простую интеграцию», — добавил он.

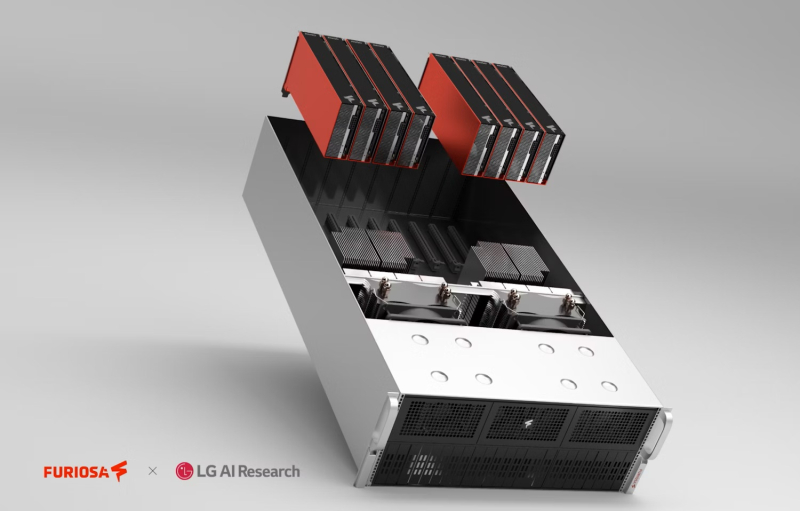

Подобно системам на базе NVIDIA RTX Pro Blackwell, серверы LG RNGD будут включить до восьми ускорителей с интерфейсом PCIe 5.0. Эти системы будут работать на базе того, что FuriosaAI описывает как высокоразвитый программный стек, включающий библиотеку vLLM. LG также предложит собственную платформу агентского ИИ ChatExaone, которая адаптирована для корпоративных сценариев использования. Она объединяет ряд фреймворков для анализа документов, глубоких исследований, анализа данных и RAG.

LG AI Research протестировала работу модели ExaOne-32B на восьмичиповом 4U-сервере c воздушным охлаждением, который был разработан совместно с Supermicro. В 15-кВт стойке можно разместить пять таких серверов. По словам Пайка, LG AI Research протестировала оборудование от нескольких поставщиков оборудования из Южной Кореи и других стран, взяв за основу ускорители NVIDIA A100. «LG AI Research также тестировала облачные решения, но, по их словам, наше решение на данный момент оказалось единственным, отвечающим их требованиям», — сказал Пайк.

Как полагает The Register, выбор для сравнения ускорителя NVIDIA A100, дебютировавшего в 2020 году, а не более свежих моделей, вызван тем, что LG AI Research больше интересует энергоэффективность оборудования, чем производительность. И, как отметил Джун Пайк, хотя за пять лет с момента появления A100 ускорители NVIDIA, безусловно, стали мощнее, но произошло это за счёт увеличения энергопотребления и площади кристалла.

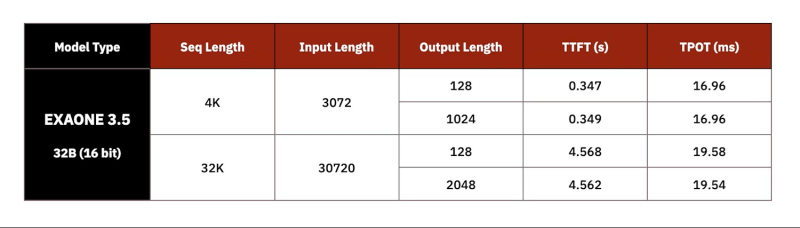

Сообщается, что LG AI фактически использовала четыре PCIe-ускорителя RNGD, задействовав тензорный параллелизм для запуска модели Exaone 32B с 16-бит точностью. По словам Пайка, у LG были очень чёткие целевые показатели производительности, которые она стремилась достичь при валидации чипа. В частности, ограничения включали время до отдачи первого токена (TTFT) — примерно 0,3 с для небольших запросов на 3 тыс. токенов или 4,5 с для более крупных запросов на 30 тыс. токенов. Результат в 60 токенов/с достигается для контекстного окна размером 4 тыс. токенов или 50 токенов/с для контекстного окна размером 32 тыс. токенов.

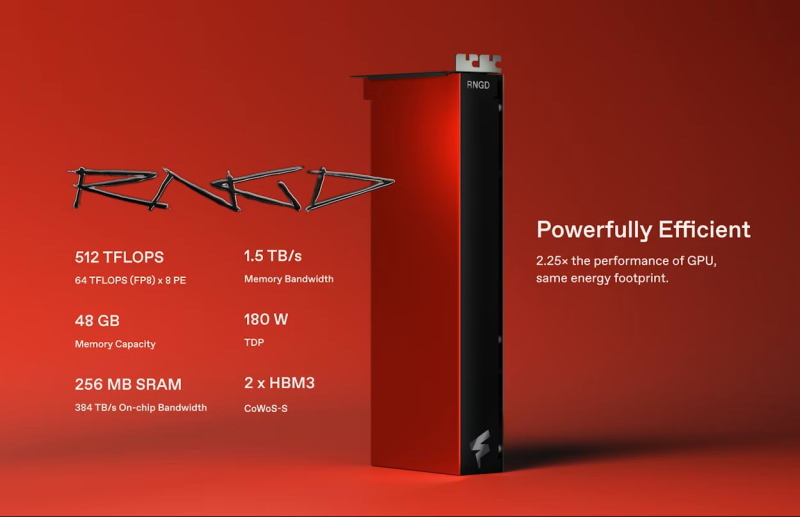

По словам Пайка, тесты проводились в режиме BF16, поскольку сравниваемые A100 не имеет встроенной поддержки FP8, так что использование RNGD в FP8-режиме позволит удвоить эффективность инференса и снизить TTFT. Кроме того, сервер продемонстрировал в 2,25 раза более высокую производительность инференса LLM на Ватт по сравнению с A100, а полная стойка сможет генерировать в 3,75 раза больше токенов, чем стойка с A100 при том же энергопотреблении. Чип FuriosaAI RNGD обеспечивает производительность 512 Тфлопс (FP8) при TDP 180 Вт.

В отличие от ускорителей NVIDIA, оснащённых высокоскоростным интерконнектом NVLink (600 Гбайт/с), FuriosaAI использует интерфейс PCIe 5.0 (128 Гбайт/с). По словам FuriosaAI, чтобы избежать узких мест и накладных расходов, связанных с интерконнектом, компилятор компании помогает оптимизировать процесс обмена данными и собственно вычисления.

Источники: