Лента новостей

|

27.04.2024 [12:47], Сергей Карасёв

Google построит в Индиане кампус ЦОД стоимостью $2 млрдКомпания Google, по сообщению Datacenter Dynamics, развернёт новый кампус ЦОД в Форт-Уэйне на территории Индианы (США). Стоимость проекта с кодовым названием Zodiac, технические подробности о котором пока не раскрываются, оценивается в $2 млрд. Инициатива предусматривает строительство 12 объектов на площади приблизительно 283 га. В рамках проекта Google будет сотрудничать с компанией Indiana Michigan Power Company (I&M) по направлению чистой энергии, которую планируется поставлять в локальную энеросеть. Детали партнёрства с I&M не разглашаются. Форт-Уэйн расположен к северо-востоку от Индианаполиса, к востоку от Чикаго и к западу от Колумбуса. Как отметила мэр Форт-Уэйна Шэрон Такер (Sharon Tucker), инвестиции Google не только помогут в расширении IT-инфраструктуры и экономическом развитии региона, но и «обеспечат более устойчивое будущее». Google на сегодняшний день оперирует более чем десятью кампусами дата-центров в США, а ряд дополнительных площадок находятся на этапе строительства. В частности, летом 2023 года компания начала создание ЦОД в Месе, пригороде Финикса (штат Аризона). Стоимость этого проекта составляет около $1 млрд. Нужно отметить, что объекты в Индиане есть у многих других операторов дата-центров и облачных провайдеров. В их число входят Meta✴, US Signals, DataBank, Netrality и Digital Crossroads. А буквально на днях о строительстве в Индиане кампуса ЦОД стоимостью $11 млрд объявила Amazon Web Services (AWS).

27.04.2024 [12:46], Сергей Карасёв

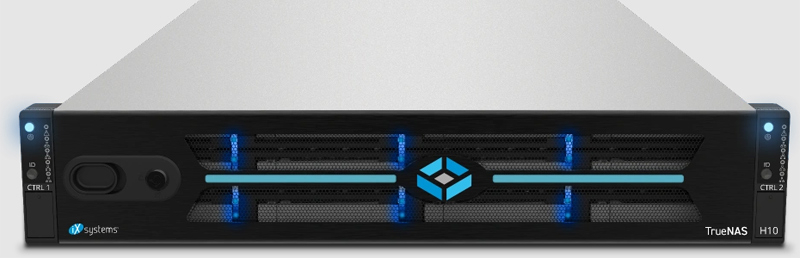

iXsystems представила СХД TrueNAS H-Series вместимостью до 2,5 ПбайтКомпания iXsystems анонсировала СХД TrueNAS Enterprise H-Series, которые доступны в гибридной версии на основе HDD и SSD, а также в модификации All-Flash. Устройства оснащены двумя контроллерами с возможностью горячей замены, благодаря чему обеспечивают доступность на уровне 99,999 %. Семейство включает модели Н10 и H20 в форм-факторе 2U с поддержкой соответственно 72 и 114 накопителей. Могут применяться Nearline-диски вместимостью до 22 Тбайт (7200 RPM) или SSD ёмкостью до 15,36 Тбайт. Интерфейс подключения в обоих случаях — SAS-3. Версия Н10 несёт на борту 64 или 128 Гбайт памяти DRAM в расчёте на контроллер. В гибридной конфигурации максимальная вместимость составляет 1,5 Пбайт, а эффективная вместимость со сжатием и дедупликацией — 3 Пбайт. В варианте All-Flash чистая и эффективная ёмкость — 1,1 и 2,2 Пбайт соответственно. Есть четыре сетевых порта 1GbE, а в качестве опции предлагаются четыре порта 10/25GbE (SFP28). Возможно использование полок расширения ES24 и ES60. Заявленная пропускная способность — до 2 Гбайт/с.

Источник изображений: iXsystems В свою очередь, модель H20 комплектуется 128 или 256 Гбайт памяти DRAM на контроллер. Вместимость в гибридной конфигурации достигает 2,5 Пбайт (эффективная — 5 Пбайт), в варианте All-Flash — 1,7 Пбайт (3,5 Пбайт). Возможно исполнение с четырьмя портами 1GbE, четырьмя разъёмами 10/25GbE (SFP28) или двумя портами 10/25GbE (SFP28) и двумя портами 40/100GbE (QSFP28). Поддерживаются полки расширения ES24, ES60 и ES102. Пропускная способность — до 5 Гбайт/с.  СХД поддерживают протоколы SMB v1/v2/v3, NFS v3/v4, AFP, FTP, WebDAV, iSCSI, OpenStack Cinder, S3 и пр. Применены два блока питания стандарта 80 Plus Platinum с возможностью горячей замены. Диапазон рабочих температур простирается от 0 до +40 °C. Возможно шифрование данных по алгоритму AES-NI. Стоимость систем TrueNAS Enterprise H-Series начинается с $10 тыс. с двумя контроллерами.

27.04.2024 [12:08], Сергей Карасёв

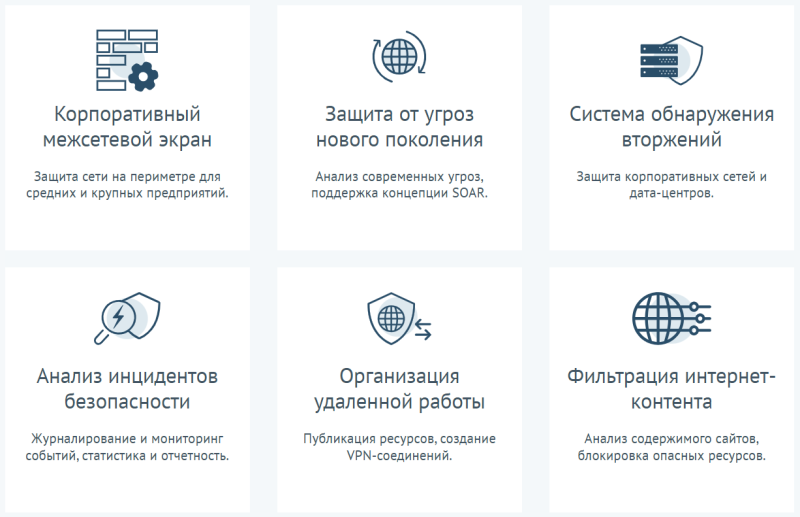

UserGate развернула облачный центр ИБ-мониторинга и анализа инцидентовКомпания UserGate объявила о запуске собственного центра мониторинга информационной безопасности (ИБ) — облачной системы Security Operations Center (SOC). Сервис предназначен для оперативного выявления киберинцидентов, их локализации и устранения до наступления критических последствий. Новая платформа работает по модели SOCaaS — SOC как услуга. Клиенты получат доступ к классическим ИБ-инструментам, а также смогут снизить нагрузку на внутренние команды. Кроме того, заказчики смогут сэкономить значительные средства, избежав необходимости создания своих служб реагирования на угрозы. На базе центра осуществляются мониторинг событий, анализ инцидентов и ИБ-аналитика. Кроме того, предоставляются дополнительные услуги, связанные с анализом защищённости систем, киберкриминалистикой и постинцидентным анализом, повышением осведомлённости сотрудников организаций в области информационной безопасности, ИБ-консалтингом, разработкой архитектуры и процессов для обеспечения защиты в киберпространстве. «Мы создавали SOC для того, чтобы сделать мониторинг информационной безопасности и реагирование на инциденты простыми и доступными для компаний, которые осознали эту необходимость. Сегодня у нас есть для этого всё необходимое: широкие компетенции в ИБ, штат высококлассных специалистов и аппаратная база для организации процесса мониторинга», — отмечает руководитель нового центра. В команду SOC вошли специалисты, имеющие богатый опыт создания и развития крупнейших российских ИБ-проектов. Они разделены на несколько групп, которые занимаются мониторингом безопасности, разработкой контента (правил для SIEM-системы, плейбуков в IRP-платформе), а также ведут проактивный поиск угроз в защищаемых инфраструктурах. Ещё одна группа — SRE (Site Reliability Engineering) — отвечает за внедрение, настройку и поддержку всех технических решений SOC. Возможности центра в перспективе будут расширяться. В частности, в I квартале 2025 года появится личный кабинет клиента, который будет содержать всю необходимую информацию — от инфографики, демонстрирующей работу инфраструктуры, и карточек инцидентов до SIEM-правил и базы знаний. Кроме того, в 2025-м планируется внедрение средств реагирования на киберинциденты: для получения этой услуги клиентам необходимо будет обеспечить более глубокую интеграцию технической базы SOC со своими инфраструктурами. Услуги по мониторингу безопасности и оповещению обеспечиваются системами сбора информации, которые размещаются на площадках заказчиков и отправляют данные по защищённым каналам связи в SOC для их обработки в автоматизированном, а при необходимости и в ручном режиме. Сервисы SOC станут доступны заказчикам в мае 2024 года.

27.04.2024 [12:05], Сергей Карасёв

Key Point открыла первую очередь крупнейшего в Сибирском регионе коммерческого ЦОДГруппа компаний Key Point объявила об открытии первой очереди дата-центра в Промышленно-логистическом парке Новосибирской области. Это, как утверждается, самый крупный коммерческий ЦОД в Сибирском регионе и один из крупнейших за пределами Москвы и Санкт-Петербурга. Общая проектная ёмкость площадки составляет 880 стоек для оборудования мощностью 7 кВт каждая. В рамках первой фазы развёрнуты 440 стоек. Генеральным проектировщиком и подрядчиком объекта является компания «Свободные Технологии Инжиниринг», а технический консалтинг осуществляла «Ди Си Квадрат». Отмечается, что строительство первой очереди завершено в рекордные сроки: оно стартовало 11 апреля 2023 года, а в феврале 2024-го осуществлён запуск дата-центра в техническую эксплуатацию. Применяемое в ЦОД оборудование на 90 % имеет российское происхождение. Площадка соответствует международным стандартам по обеспечению стабильной работы вычислительных систем любого поколения и успешно прошла двухступенчатую процедуру сертификации Uptime Institute по уровню надёжности Tier III. Проектная мощность дата-центра составляет 11 МВт, IT-мощность — 6,1 МВт. На текущий момент объект получает электропитание через уже существующую энергетическую инфраструктуру. Вместе с тем ведётся строительство подстанции на 49 МВт с возможностью дальнейшего увеличения мощности. Это станция будет запущена в декабре 2024 года.

«Наличие такого крупного IT-хаба в Новосибирской области обеспечит более комфортное и безопасное использование информационных ресурсов местными жителями, организациями и предприятиями, а также будет способствовать прогрессивному развитию цифровых сервисов в регионе», — говорится в сообщении Key Point. Суммарный объём частных инвестиций в строительство двух очередей ЦОД оценивается в 2,92 млрд руб., из которых уже вложено 1,8 млрд руб. Услугами дата-центра начали пользоваться как региональные компании различных отраслей, так и крупнейшие телекоммуникационные операторы страны, развивающие сервисы в Новосибирской области. Поддерживать работу площадки будут 45 высококвалифицированных специалистов.

27.04.2024 [10:25], Андрей Крупин

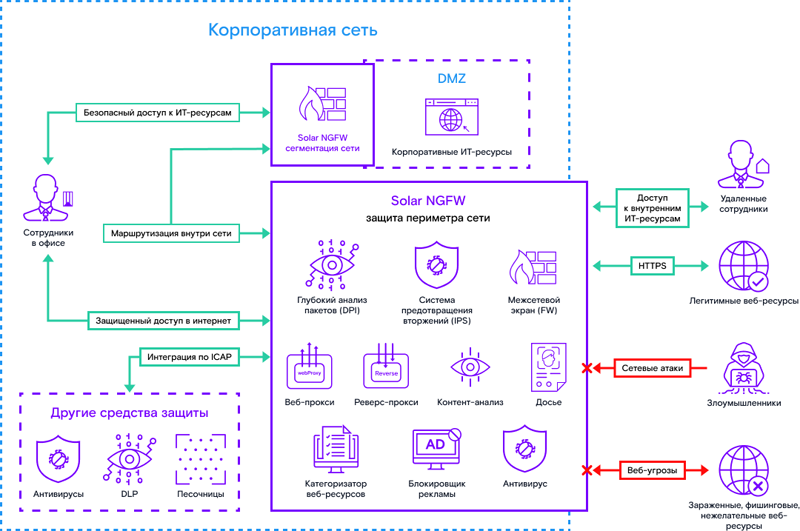

Межсетевой экран Solar NGFW получил ряд архитектурных доработок и расширенные настройкиКомпания «Солар» (дочернее предприятие «Ростелекома», работающее в сфере информационной безопасности) выпустила новую версию брандмауэра Solar Next Generation Firewall 1.2. Представленное российским разработчиком решение относится к классу межсетевых экранов нового поколения (NGFW). Программный комплекс обеспечивает защиту корпоративной сети от сетевых атак и вредоносного ПО, а также управление доступом к веб‑ресурсам. Продукт устанавливается в разрыв трафика и проверяет все проходящие через него пакеты данных. При этом механизмы защиты Solar NGFW работают параллельно, но каждый по своим базам сигнатур и правил. Это обеспечивает комплексную проверку трафика на соответствие политике безопасности.

Принцип работы Solar NGFW (источник изображения: rt-solar.ru) В Solar NGFW 1.2 реализованы возможности детальной настройки сетевых интерфейсов через графический веб-интерфейс. В частности, в рабочее окружение IT-администратора был добавлен раздел «Сетевые интерфейсы», в котором отображаются как Ethernet-интерфейсы, которые добавляются автоматически, так и VLAN-интерфейсы, требующие ручной настройки. Предусмотрены отображение статусов «подключен», «не подключен», «промежуточный», оповещающий об отсутствии подтверждения перехода в другой режим, а также вызов подробной информации по каждому интерфейсу, обновляющейся каждую минуту. Ранее такие настройки были возможны только через командную строку.

Место Solar NGFW в IT-инфраструктуре (источник изображения: rt-solar.ru) Меню системы предотвращения вторжений было дополнено вкладкой «Наборы сигнатур», позволяющей своевременно загружать сведения об актуальных угрозах безопасности. Система предлагает два вида действий: добавление нового набора или обновление уже имеющегося в системе. Поддерживается редактирование информации о категориях киберугроз, а также работа как с собственными сигнатурами, так и с экспертизой центра исследования киберугроз Solar 4RAYS. «В этом релизе мы сделали упор на внутренние архитектурные доработки, которые закладывают фундамент для серьёзных улучшений в течение года. Мы провели ряд работ по оптимизации архитектуры системы и её отдельных компонентов, что повысило общую скорость и стабильность работы. Помимо этого, заметным внутренним изменением стало добавление возможности настройки отказоустойчивой пары, что сделало конфигурирование обоих устройств кластера удобнее», — отмечают разработчики продукта.

26.04.2024 [18:25], Руслан Авдеев

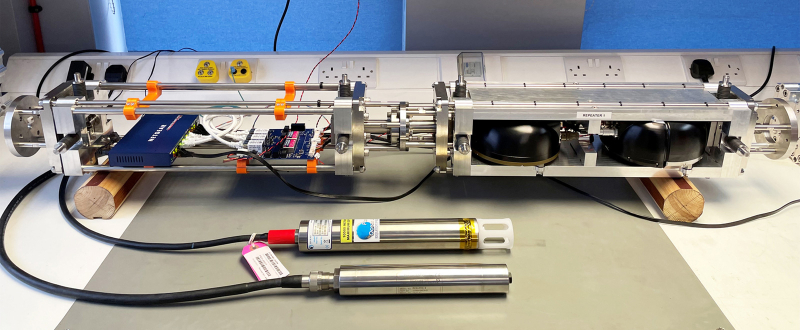

Великобритания и Новая Зеландия задействуют подводные оптические кабели для распознавания землетрясений и цунамиНациональная физическая лаборатория Великобритании (National Physical Laboratory, NPL) совместно с новозеландской Лабораторией стандартов измерения (Measurement Standards Laboratory, MSL) заключили соглашение, в рамках которого подводный интернет-кабель будет применяться для регистрации признаков землетрясений и цунами в Тихом океане и сбора данных об океанских течениях. По данным Datacenter Dynamics, новая система не требует дополнительного оборудования или инфраструктуры. Благодаря сверхточным оптическим измерениям учёные смогут использовать существующую ВОЛС для сбора данных об окружающей среде в режиме реального времени. Она даже поможет предупреждать население тихоокеанского бассейна о приближении цунами. Испытания пройдут в 2024 году на участке кабеля Southern Cross NEXT протяжённостью 3876 км на дне Тасманского моря между Новой Зеландией и Австралией. Общая протяжённость кабеля Southern Cross NEXT составляет 13,7 тыс. км, посадочные станции имеются на Фиджи, в Австралии, Новой Зеландии, Калифорнии, в Кирибати и Токелау. По словам учёных, Тихий океан представляет собой зону с высокой сейсмической активностью, идеальную для тестирования подобных технологий. В будущем аналогичные решения можно будет применять по всему миру. Потенциально они также могут использоваться для изучения геологии океанского дна и климатических изменений. Технология на основе квантовых разработок впервые была подготовлена NPL в 2021 году и тогда же испытана в Атлантическом океане на участке кабеля между Канадой и Великобританией протяжённостью 5960 км. Проект стал частью более масштабного соглашения о сотрудничестве между Великобританией и Новой Зеландией (Research, Science, and Innovation Agreement), подписанного в июле 2022 года. Это не первый проект, предусматривающий распознавание землетрясений с помощью оптоволоконных кабелей. Ещё одной технологией являются ретрансляторы SMART, поддерживающие сбор и трансляцию данных для учёных и правительств. Как сообщают власти Португалии, система CAM2, которая заработает в 2024 году, будет оснащена сенсорами SMART. В 2023 году Subsea Data Systems завершила создание прототипа SMART для производителя кабелей ASN — они тоже позволяют предупреждать о землетрясениях и цунами. Ранее в этом году кабель с поддержкой SMART-технологий внедрила в Ионическом море Güralp Systems. В феврале 2024 года появилась информация о намерении Prima и Alcatel Submarine Networks проложить передовой многоцелевой кабель SMART от островов Новой Каледонии до Вануату в рамках проекта TAM TAM. В 2021 году сейсмологи Калифорнийского технологического института совместно с Google разработали метод распознавания землетрясений с помощью подводных кабелей с помощью анализа путешествующий сквозь волокна свет, который не требует дополнительного оборудования. Ещё во время предварительных тестов с декабря 2019 по сентябрь 2020 года исследователи университета зарегистрировали около 20 умеренных и сильных землетрясений вдоль соединяющего США с Чили кабеля Curie — включая мощное землетрясения у Ямайки в январе 2020 года.

26.04.2024 [18:25], Сергей Карасёв

Объём российского IoT-рынка превысил 35 млрд руб.Количество устройств Интернета вещей (IoT) в России достигло приблизительно 60 млн единиц. Объём рынка в денежном выражении превысил 35 млрд рублей. Такие данные обнародовал вице-премьер России Дмитрий Чернышенко в рамках II Национальной премии за вклад в развитие городского хозяйства «Умный город». По его словам, IoT-технологии и средства ИИ помогают эффективно управлять городской инфраструктурой. С 2018 года в России реализуется проект цифровизации населённых пунктов. На сегодняшний день различные цифровые решения и платформы успешно применяются более чем в 200 городах.

Источник изображения: pixabay.com Статистику по российскому рынку IoT на днях также обнародовало АО «Русатом Инфраструктурные решения» (РИР), входящее в госкорпорацию «Росатом». По оценкам, в 2023 году технологии IoT использовали как минимум 36 тыс. российских организаций, из которых почти треть (около 30 %) сосредоточены в Центральном федеральном округе. В среднем, одна компания в 2022–2023 годах тратила от 1,3 млн до 12 млн руб. на программные IoТ-решения. Чаще всего такие продукты применяются в сферах торговли, безопасности, недвижимости, строительных и инженерных услуг. По итогам 2022 года аналитики РИР оценивают рынок IoT в России с учётом ПО в 165 млрд руб. Прогнозируется, что к 2032-му затраты вырастут более чем в два раза, достигнув 350 млрд руб. В сегменте ПО показатель составит до 84,5 млрд руб., или примерно 27 % от общих расходов на IoT-продукты. Говорится, что наиболее популярными технологиями являются Bluetooth Low Energy, Long Range WAN, IPv4, ТСР MODBUS, DDS и HTTP. Менее распространёнными технологиями названы SigFox, IPv6, UDP, AMQP и COAP.

26.04.2024 [14:52], Владимир Мироненко

UserGate объявила о расширении портфеля услуг и продуктов, а также запуске центра мониторинга ИБРоссийский разработчик решений в сфере информационной безопасности UserGate объявил о расширении спектра услуг и продуктов. Портфель компании теперь включает не только решения для обеспечения безопасность сети и конечных устройств, но и средства обнаружения вторжений, услуги аудита и консалтинга, расследований кибер-инцидентов, а также центр мониторинга информационной безопасности. Новые решения были представлены компанией на V Ежегодной конференции UserGate. Также компания рассказала об обновлённой технологической стратегии и структуре корпоративного управления. Компании поделилась опытом модернизации технологических и бизнес-процессов, процедур разработки и промышленного дизайна, а также представило расширенную команду, отвечающую за новые направления развития бизнеса UserGate. Особое внимание компания уделила образовательным инициативам, направленным на ликвидацию кадрового голода в сфере ИБ и деятельности Академии UserGate, обеспечивающей обучение технических специалистов навыкам работы на оборудовании компании. Также компания объявила об открытии Технологической лаборатории UserGate, которая будет заниматься разработкой и развитием перспективных технологий. UserGate отметила, что ей удалось создать продукты, обладающие максимально возможной технологической независимостью и оптимальным сочетанием потребительских качеств, что обеспечило их коммерческий успех и возможность дальнейшего инвестирования в собственное развитие. «Мы постоянно модернизируем существующие решения, расширяем продуктовую линейку и сферу наших компетенций, чтобы обеспечить наиболее полную защиту цифровой инфраструктуры наших заказчиков от всех возможных видов угроз», — сообщил глава компании. В прошлом году UserGate выпустила два крупных обновления своей системы UGOS до версий 7.0 и 7.1, пополнила портфолио решениями UserGate SIEM и UserGate Client, представила технологию UserID, новый проприетарный движок системы обнаружения вторжений (IPS/СОВ), повысила уровень работы Центра мониторинга и реагирования (Monitoring and Response Center, MRC), включив в состав представляемых услуг аудит и консалтинг, а также расследование инцидентов. Также был значительно расширен штат инженеров, разработчиков, аналитиков, специалистов по информационной безопасности и технической поддержке. Кроме того, компания запустила собственный центр мониторинга информационной безопасности – SOC (Security Operations Center), услуги которого будут представляться по облачной модели SOC-as-a-Service.

26.04.2024 [14:10], Сергей Карасёв

IBM представила СХД FlashSystem 5300 и подписку Storage AssuranceКорпорация IBM анонсировала систему хранения начального уровня FlashSystem 5300 типа All-Flash, выполненную в форм-факторе 1U. В основу новинки положен процессор Intel Xeon Ice Lake-SP с 12 вычислительными ядрами и тактовой частотой 2,0 ГГц. Возможна установка 12 NVMe-накопителей (PCIe 4.0). Присутствуют порты 10/25 GbE, но могут быть добавлены два адаптера Fibre Channel с четырьмя портами FC32 или двумя портами FC64. Система рассчитана на работу с вычислительными накопителями FlashCore Modules (FCM) четвёртого поколения. Это проприетарные изделия IBM, построенные на 176-слойных чипах TLC NAND. Вместимость составляет 4,8, 9,6, 19,2 или 38,4 Тбайт. При этом поддерживается компрессия 3:1, благодаря чему эффективная ёмкость достигает 115,2 Тбайт. В результате, СХД с 12 накопителями может вмещать более 1 Пбайт информации. Накопители FCM четвёртого поколения поддерживают технологию защиты от вредоносного ПО, работающую на уровне прошивки. Устройства анализируют I/O-операции с помощью ИИ-алгоритмов, что позволяет выявлять проникновение программ-вымогателей и других зловредов. Для FlashSystem 5300 заявлена пропускная способность до 28,6 Гбайт/с. Показатель IOPS (операций ввода/вывода в секунду) достигает 400 тыс. Клиенты могут использовать прогнозную аналитику на основе ИИ с помощью IBM Storage Insights и IBM Spectrum Virtualize. Цена СХД составляет $67 тыс. с 12 накопителями FCM вместимостью 9,6 Тбайт каждый. Вместе с FlashSystem 5300 IBM анонсировала программу Storage Assurance, которая помогает управлять жизненным циклом платформ хранения данных и максимизировать отдачу от инвестиций в соответствующее оборудование. Новая модель подписки предполагает регулярные обновления аппаратного и программного обеспечения, а также поддержку Expert Care премиум-уровня, чем напоминает предложение Pure Storage Evergreen. Программа также доступна для FlashSystem 7300 и 9500. Storage Assurance помогает поддерживать инфраструктуру хранения в актуальном состоянии, одновременно устраняя проблемы с простоями, миграцией данных и дублированием закупок. При этом IBM гарантирует высокое качество обслуживания. Благодаря средствам мониторинга и аналитики клиенты смогут точнее прогнозировать использование ёмкости. Заказчики также получат возможность объединять устройства IBM FlashSystem и управлять ими как единой масштабируемой платформой хранения, спроектированной для обеспечения высокой доступности, репликации и миграции без прерывания работы.

26.04.2024 [11:56], Руслан Авдеев

Газировка с Copilot: Microsoft получила миллиардный контракт на обеспечение Coca-Cola облачными и ИИ-сервисамиCoca-Cola заключила контракт стоимостью $1,1 млрд на использование облачных и ИИ-сервисов Microsoft. По данным Datacenter Dynamics, речь идёт о соглашении сроком на пять лет, в рамках которого последняя будет отвечать за ключевые информационные технологии производителя напитков. В результате Microsoft станет «предпочтительным» облачным и ИИ-провайдером Coca-Cola. Приложения компании перенесут в облако Microsoft Azure — в прошлом году она уже использовала генеративные ИИ-системы и уже применяет Azure OpenAI в маркетинге, производстве и управлении цепочками поставок. Компании продолжат эксперименты с сервисом Azure OpenAI, включая оценку того, как Microsoft Copilot может способствовать повышению производительности сотрудников, улучшению клиентского опыта и оптимизации деятельности в целом. По словам представителей Coca-Cola, новое соглашение демонстрирует приверженность бизнеса к цифровой трансформации — партнёрство с Microsoft растёт экспоненциально, с соглашения на $250 млн, анонсированного в 2020 году, до $1,1 млрд сегодня. В компании заявляют, что возможности Microsoft помогают внедрению ИИ для повышения прибавочной стоимости. Ранее Coca-Cola располагала дата-центром в Атланте, где расположена штаб-квартира бизнеса. В 2009 году она обсуждала с HP передачу связанных с ЦОД операций на аутсорс, а в 2017 году продала свой центр компании Rackhouse в рамках плана по миграции в облако. На тот момент компания пользовалась сервисами AWS и Google Cloud. Coca-Cola косвенно причастна к индустрии ЦОД и в другом аспекте. В 2022 году появилась информация о том, что бывший завод компании в Мадриде превратится в крупнейший дата-центр с проектной мощностью до 100 МВт. |

|