Ice Lake-SP относятся к третьему поколению процессоров Intel Xeon Scalable. Первое, Skylake-SP (платформа Purley), вышло летом 2017 года. Весной 2019-го вышло второе поколение — Cascade Lake-SP в рамках платформы Purley Refresh, которое во многом можно считать работой над ошибками первого. А потом… Потом, летом того же года, появились AMD EPYC Rome, которые по ряду параметров — числу ядер, объёму кешей, числу каналов памяти и её скорости, числу линий PCIe 4.0 — оказались на голову выше Cascade Lake-SP. Intel оперативно (по корпоративным меркам, конечно) снизила цены на CPU c суффиксом L (4,5 Тбайт памяти на сокет) и упростила модельный ряд, отказавшись от процессоров с суффиксом M (2 Тбайт).

А уже в 2020-м компания анонсировала новое семейство Cascade Lake-SP Refresh, но это во многом был маркетинговый ход. Да, значительная часть процессоров, поменяв имя, сохранила характеристики и получила значительное более низкую (иногда в разы) цену. Однако, к примеру, старшая на момент анонса модель Gold 6258R не является полным аналогом старшей же Platinum 8280, так как при прочих равных у неё 2 линии UPI, а не 3, что закрывает ей путь к использованию в многосокетных системах. Тем не менее эти два с половиной поколения сохраняют совместимость на уровне сокета и являются развитием микроархитектуры Skylake.

А вот дальше началась небольшая чехарда. Первыми процессорами Intel Xeon Scalable третьего поколения стали 14-нм Cooper Lake-SP (платформа Cedar Island), тоже наследники Skylake, анонс которых летом 2020 года прошёл очень тихо, потому что на массовый рынок эти CPU не очень-то ориентированы. Они получили новый сокет LGA4189, поддержку памяти DDR4-3200 и Optane PMem 200 (Barlow Pass), 6 линий UPI и поддержку формата bfloat16.

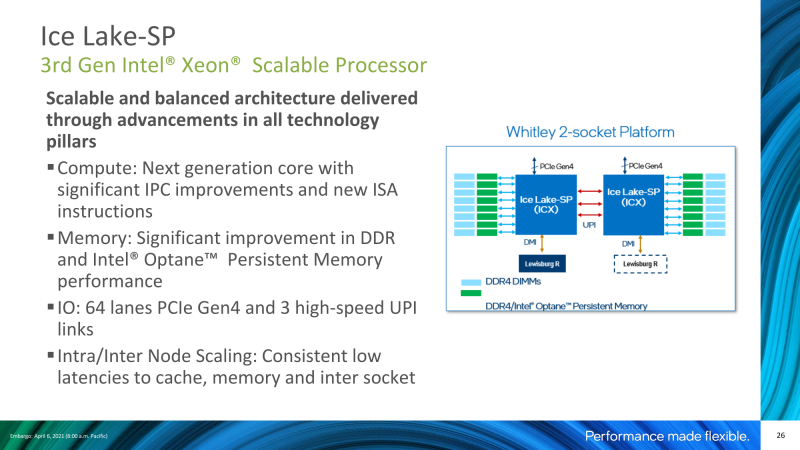

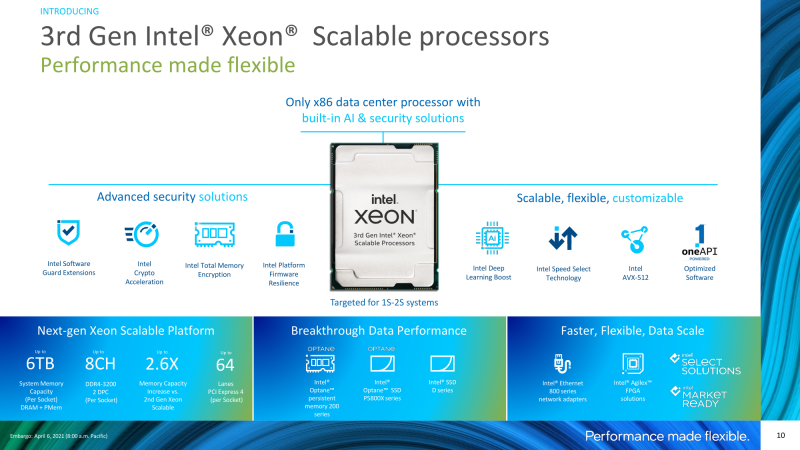

Это делает их, с одной стороны, идеальными для построения 4- или 8-сокетных систем для работы с действительно большими объёмами данных, а с другой — полезными для ряда ИИ-задач, причём даже в односокетном варианте (как у Facebook✴, например). При этом максимальное число ядер всё же осталось равным 28, как и у первых Skylake-SP, если не считать двухчиповых монстров Cascade Lake-AP. Вот с таким багажом Intel подошла к запуску AMD EPYC Milan, которые всё равно выигрывают в ряде аспектов, и к запуску 10-нм Ice Lake-SP, второго семейства Xeon Scalabale третьего поколения, и платформы Whitley.

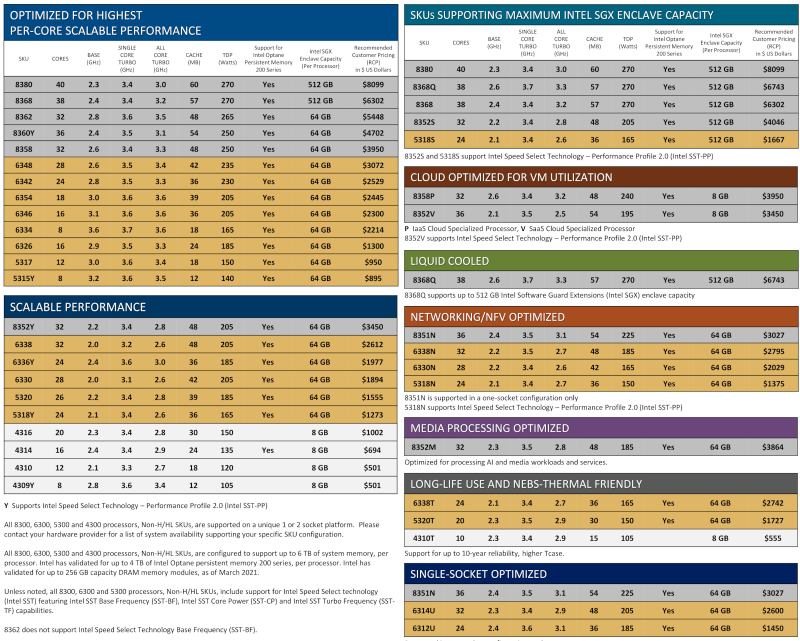

Модельный ряд Intel Xeon Ice Lake-SP

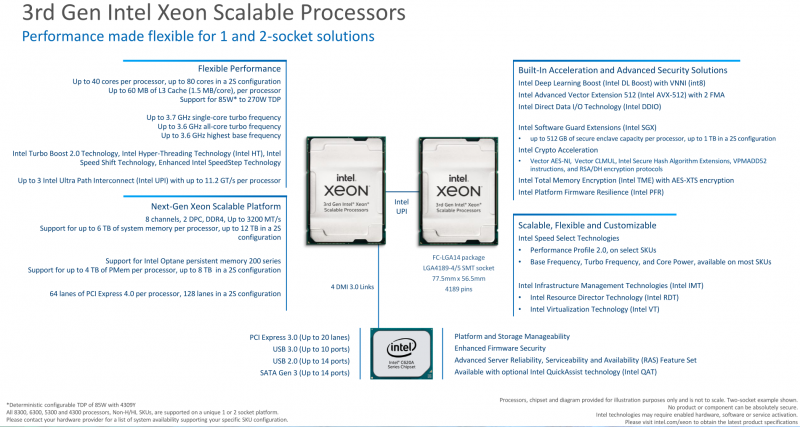

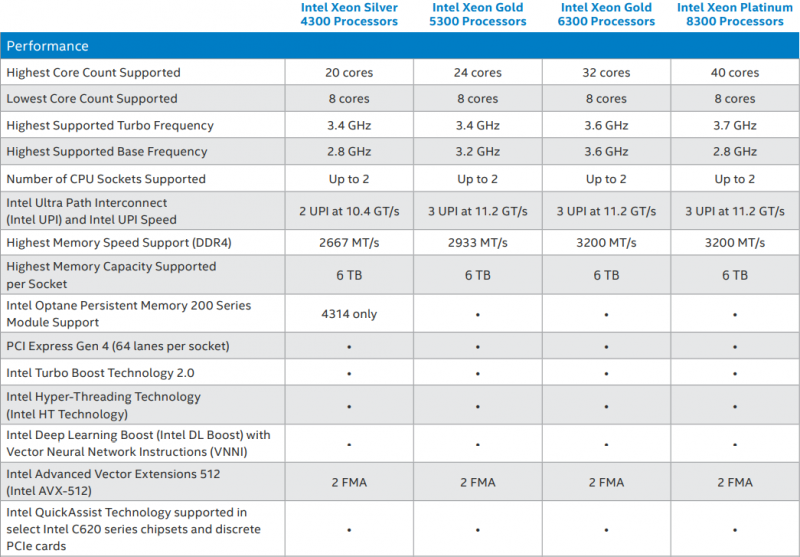

Ice Lake-SP делят с Cooper Lake-SP сокет LGA4189, но их платформы не совместимы между собой. Ice Lake-SP ориентирован на массовый рынок 1- и 2-сокетных серверов и включает модели серий Silver, а не только Gold и Platinum, как Cooper Lake-SP. Серии Bronze в этом поколении на старте нет. При этом в сравнении с Cascade Lake-SP (Refresh) различий между оставшимися сериями стало меньше, но до «плоской» модели AMD для EPYC, где чипы отличаются только частотой, числом ядер и объёмом кеша, пока далеко.

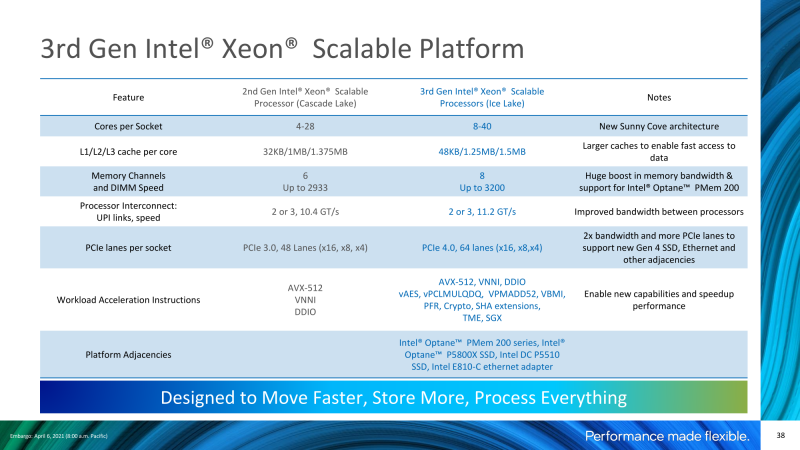

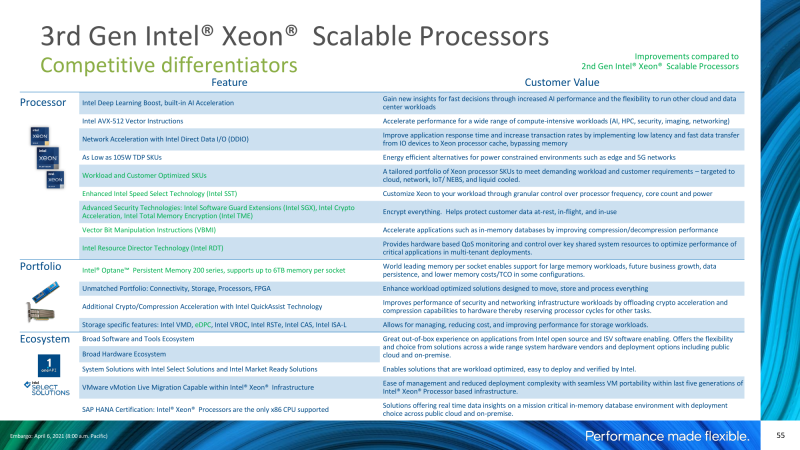

Все процессоры Ice Lake-SP без дополнительных суффиксов в названии поддерживают 2-сокетные системы, имеют 2 FMA-порта AVX-512, включают SGX и TME, предлагают 64 линии PCIe 4.0 (бифуркация x16, x8, x4) и 8 каналов памяти DDR4, которые позволяют установить до 4 Тбайт DRAM (с 256-Гбайт модулями) или до 4 Тбайт Optane PMem 200. Суммарный объём памяти при одновременной установке DRAM и PMem достигает рекордных 6 Тбайт на сокет. Все прочие технологии, что были в Cascade Lake-SP, никуда не делись.

«Исключительной», как обычно, является младшая серия Silver, которая дешевле всех остальных. В ней есть только один CPU с поддержкой Optane PMem 200, урезаны скорости памяти (DDR4-2667 для 1DPC/2PC) и UPI (10,4 ГТ/с, причём линий только две), максимальный объём SGX-анклавов ограничен 8 Гбайт, а также отсутствуют Speed Select и некоторые второстепенные функции. Ограничение серии Gold 53xx по частоте памяти в сравнении (DDR4-2933 для 1DPC/2PC) с 63xx выглядит несколько искусственным. К тому же стартовый набор 53xx совсем маленький.

Самой многочисленной является серия 63xx. Её отличительные особенности: поддержка SGX-анклавов от 64 Гбайт и DDR4-3200 (1DPC) или DDR4-2933 (2DPC). У Platinum такие же анклавы, но для них работа в режиме DDR4-3200 официально поддерживается и для 2DPC (2 модуля на канал), хотя неофициально EPYC Milan, как мы ранее убедились, так тоже могут. К Platinum традиционно относятся модели с максимумом возможностей, и это касается не только числа ядер, частот и объёма кеша.

Всего в стартовой линейке представлено 19 базовых моделей. Но есть и ещё процессоры с дополнительными суффиксами в названии, которые по характеристикам могут заметно отличаться от моделей с тем же индексом, но без суффикса:

- H/HL — просто напомним, что это семейство Cooper Lake-SP, а не Ice Lake-SP;

- T — расширенный температурный режим, работа в течение 10 лет, «дружественность» к стандарту NEBS для работы в экстремальных условиях;

- Q — предлагаются более высокие базовые и Turbo-частоты, что актуально для HPC, но требуется СЖО, причём возможна работа с горячей водой (до +40 °C на входе);

- U — поддержка работы только в составе односокетных систем;

- S — поддержка SGX-анклавов объёмом до 512 Гбайт;

- Y — так как Speed Select (SST-BF, SST-CP, SST-TF) в том или ином виде есть в большинстве новых CPU, теперь этот суффикс указывает на поддержку Performance Profile 2.0. SST-PP 2.0, в отличие от первой версии, позволяет задавать не только гарантированную минимальную базовую частоту для выбранной группы ядер и привязанным к ним нагрузкам, но и Turbo-частоту, в том числе для SSE с AVX-2 Light, AVX2 Heavy и AVX-512, а также позволяет динамически менять эти диапазоны.

- M — теперь этот суффикс означает не поддержку большего объёма памяти, а наличие оптимизаций частот AVX-инструкций для работы с медиаконтентом и ИИ-задачами;

- N — оптимизации для работы в сетевых решениях;

- V и P — ориентированы на виртуализацию и облачные системы SaaS и IaaS соответственно, предполагают типовой уровень нагрузки на CPU 70% и оптимизации со стороны SST-PP.

Так как двойные суффиксы не предусмотрены, то единичные модели, подпадающие сразу под несколько категорий, отнесены только к одной из них. Число специализированных моделей сравнимо с числом базовых. При этом на практике из всего модельного ряда действительно массовым станет небольшое число процессоров, а значительная часть поставок, надо полагать, как обычно, придётся и вовсе на кастомные решения.

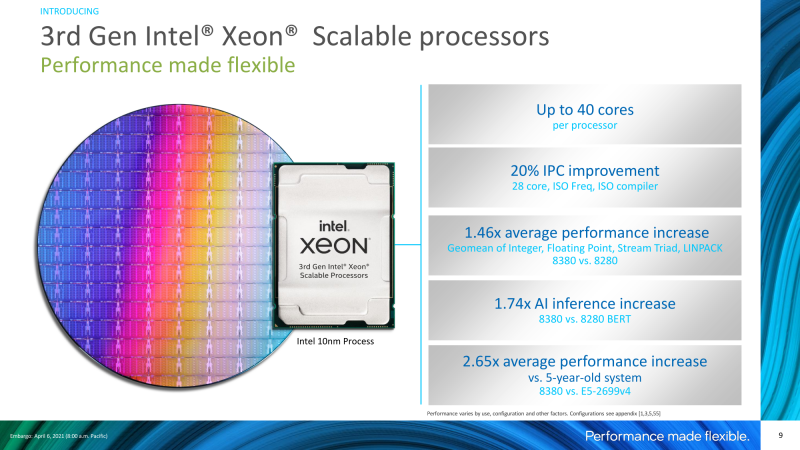

Если сравнивать Ice Lake-SP с Cascade Lake-SP (Refresh) в целом, то минимальное число ядер поднялось с 6 до 8, TDP вырос с 70 до 105 Вт, а стартовая цена увеличилась с $213 до $501, так как Bronze больше нет. С максимумами ядер и TDP всё просто — они выросли с 28 до 40 и с 205 до 270 соответственно. Общая производительность благодаря приросту IPC и числа ядер от поколения к поколению, по данным Intel для старших Xeon Platinum 8280 и 8380, увеличилась примерно в 1,5 раза в обычных задачах, а в случае инференса для ИИ — в 1,74 раза, в том числе благодаря оптимизациям ПО.

А вот с ценами уже не так просто. Прямого аналога Gold 6258R в новой серии нет, но ближайший кандидат Platinum 8358 с той же ценой в $3 950 предлагает 32 ядра вместо 28, но с меньшими частотами. Если же сравнивать Platinum 8280 с 8380, то последний на $1 900 дешевле при более привлекательных характеристиках. Однако при сравнении «голых» характеристик Intel Xeon и AMD EPYC за последние полтора года ситуация не поменялась — Ice Lake-SP отстают от Milan по числу ядер, объёму кешей, частотам, TDP в пересчёте на ядра и по цене. По последнему пункту снова сделаем важную оговорку, актуальную для обоих вендоров: цена CPU далеко не единственная и не всегда доминирующая часть в стоимости конечного проекта или решения.

Платформа Whitley

Оба вендора могут предложить 128 линий PCIe 4.0 в 2S-системах, а 4S/8S Ice Lake-SP и EPYC недоступны. Но в односокетных решениях по этому параметру однозначно лидирует AMD — все 128 линий доступны, так как не надо тратиться на шину Infinity Fabric. Для связи же двух Xeon между собой используется до 3 линий шины UPI, у которых слегка подросла скорость — с 10,4 ГТ/с до 11,2 ГТ/с (22,4 Гбайт/с в одну сторону).

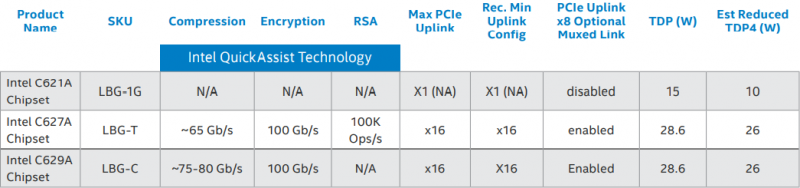

Основным чипсетом для новых Xeon остался Lewisburg Refresh С62xA, который предлагает ещё 20 линий PCI 3.0, по 14 портов SATA3 и USB 2.0 и до 10 портов USB 3.0. Со времён Skylake-SP серия лишилась встроенного контроллера 4×10GbE, сохранив лишь один 1GbE-порт управления, и ужалась всего до трёх моделей, две из которых поддерживают Intel QuickAssist Technology (QAT) и опциональное подключение к CPU не только по DMI, но и по 16 линиям PCIe. В 2S-системах при желании можно подключить два чипсета.

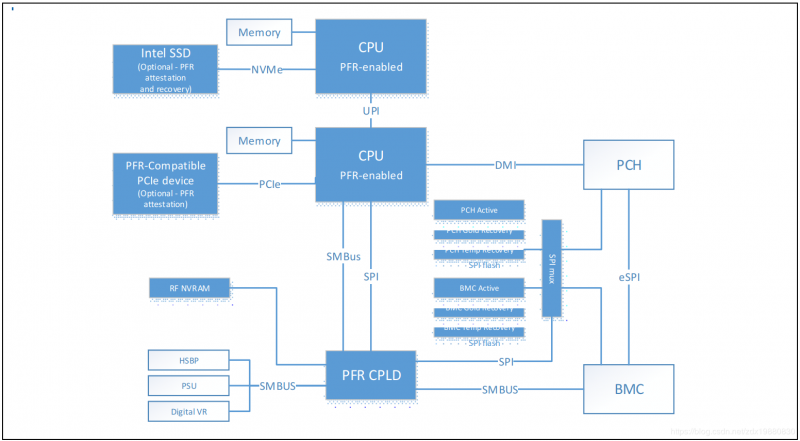

Для EPYC наличие чипсета не является обязательным, так как это SoC, которая в том числе включает и аппаратный Root of Trust (RoT) на базе встроенной в сам процессор ещё одной SoC. У Intel в случае Whitley подход несколько иной. В этом поколении компания расширила технологию Platform Firmware Resilience (PFR), которая задействует сразу два аппаратных компонента: сам процессор и CPLD MAX 10 (по сути FPGA). При активации PFR после подачи питания контроль над всей системой остаётся в руках первого CPU и CPLD. Перед загрузкой проверяется целостность и корректность прошивок и параметров BIOS/UEFI, BMC, Intel ME, сетевых контроллеров, PCIe-устройств и так далее. И если что-то не совпадает, то заливаются заводские образы ПО, хранящиеся отдельно.

Похожим образом происходит и обновление прошивок. Во время загрузки и после неё CPLD фактически контролирует ряд шин, включая SPI и SMBus, анализируя и фильтруя при необходимости их трафик. Таким образом можно избежать вмешательства в работу других компонентов: VRM, БП, бэкплейнов и т. д. А программируемость CPLD обеспечивает гибкость возможностей защиты для вендоров. Типичный и актуальный пример — контроль цепочки поставок, когда на заводе блокируется конфигурация железа и ПО, а разблокировка возможна только при вводе ключа, который передаётся уже конечному заказчику.

Прошивка CPLD и прочее ПО будут выложены в открытый доступ на GitHub под лицензией MIT, так что вендоры смогут свободно использовать её и подгонять под свои нужды. Правда, есть у этой медали и обратная сторона — PFR можно использовать не только для защиты платформы, но и для более жёсткой привязки конечного пользователя к решениям одного производителя. Хотя на первый взгляд это всё же более мягкий вариант, чем AMD PSB, где дозволено навсегда привязать CPU к железу конкретного вендора.

Архитектура Ice Lake-SP

Intel настолько долго выводила в производство и на рынок Ice Lake-SP, что мы уже не раз рассказывали об особенностях новых процессоров. Наиболее полно о них компания поведала ещё в прошлом году. Так что здесь выделим некоторые ключевые нововведения, которые являются важной частью платформы и с помощью которых компания будет дистанцировать новинки и от прошлого поколения Xeon, и от EPYC.

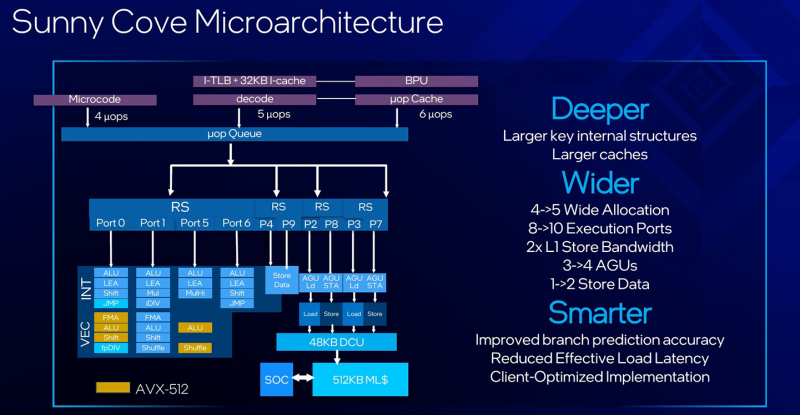

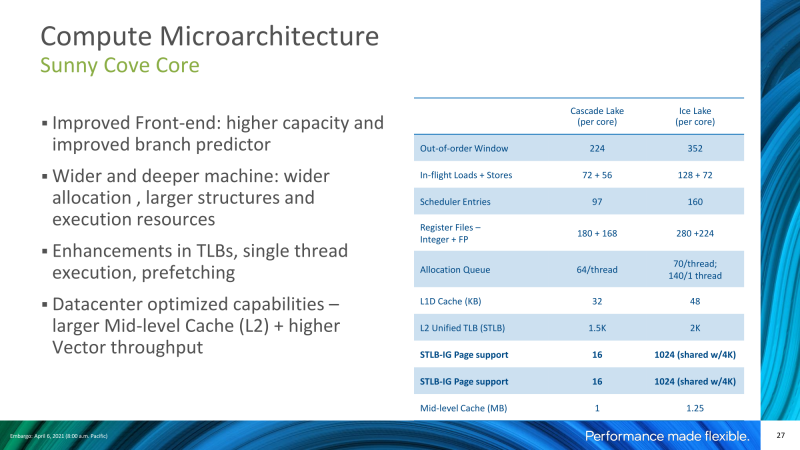

Микроархитектура Sunny Cove, анонсированная в конце 2018 года, успела дважды «засветиться» в мобильных решениях и даже добралась до десктопа, перебравшись с 10-нм FinFET техпроцесса обратно на 14 нм. Никаких дополнений к строению ядер, которое описано по двум предыдущим ссылкам, в серверном варианте не предусмотрено. Они действительно стали «шире» и «глубже» за счёт увеличения практически всех кешей/буферов/регистров, а также входной и исполнительной частей конвейера и имеют более высокую степень параллелизма. Но в целом это очередная итерация Skylake, хотя и получившая итоговый прирост IPC на уровне 20% в сравнении с Cascade Lake-SP.

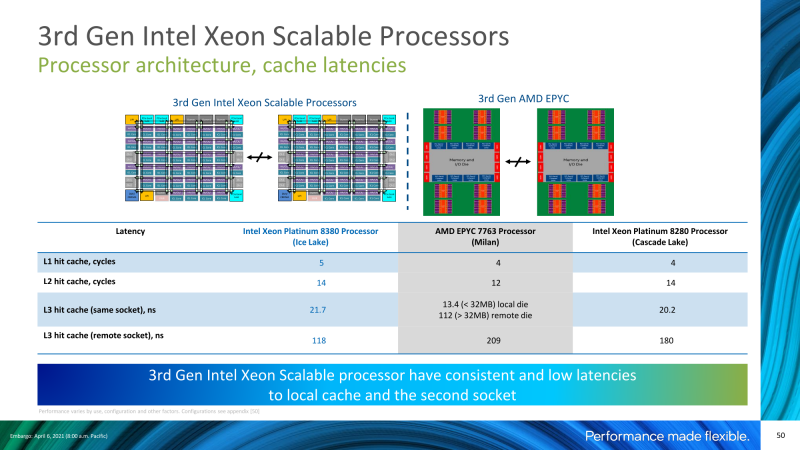

Внутренняя структура процессора не поменялась — это монолитный кристалл, в котором ядра и дополнительные агенты соединены mesh-сетью. Он стал больше и плотнее, но это не позволяет, к примеру, свободно наращивать размер L3-кешей и число ядер. Что, в свою очередь, отчасти компенсируется тем, что в кеш к соседу ходить быстрее и проще, и даже при межпроцессорном взаимодействии можно выиграть в задержках. В чиплетном дизайне, очевидно, будет неравномерность доступа при обращении к данным внутри одного чиплета или между ними. Интересно, как это будет подавать сама Intel в следующем поколении Xeon, Sapphire Rapids?

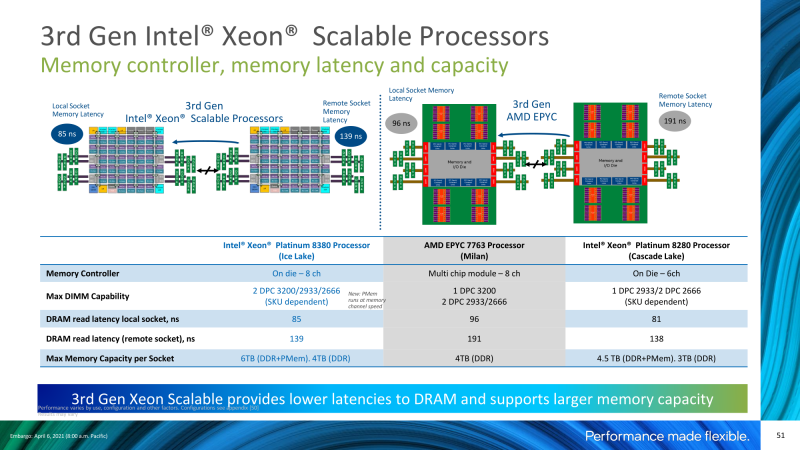

Новый контроллер памяти (КП) предлагает восемь каналов DDR4-3200, что существенно лучше, чем шесть каналов DDR4-2933 в Cascade Lake-SP, да и агентов для mesh-сети у него теперь четыре, то есть вдвое больше, чем раньше. Процессор всё так же можно разбить на два NUMA-домена (SNC2). Из нового — аппаратная поддержка полного прозрачного шифрования памяти Total Memory Encryption (TME) ключом 128-бит AES-XTS, который генерируется и хранится внутри CPU. Это аналог технологии AMD SME.

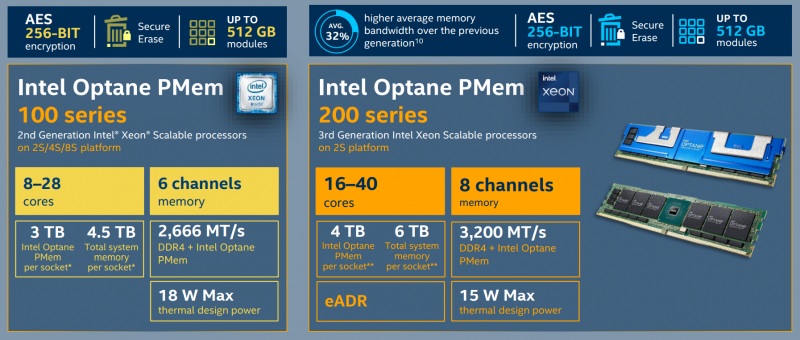

Основным же преимуществом нового КП остаётся поддержка памяти Intel Optane PMem 200 второго поколения, которая практически на треть быстрее, чем предыдущее, может работать в режиме 3200 MT/s на Ice Lake-SP и имеет ряд других оптимизаций. Но главное, конечно, то, что PMem дешевле обычной DRAM, а быстродействие такой памяти вполне достаточно для целого класса задач (но не для всех, конечно). Как уже отмечалось выше, суммарно на сокет сочетанием двух типов памяти можно набрать до 6 Тбайт: 8 × 512 Гбайт Optane PMem + 8 × 256 Гбайт DDR4. Однако PMem 200 несовместим с TME и SGX.

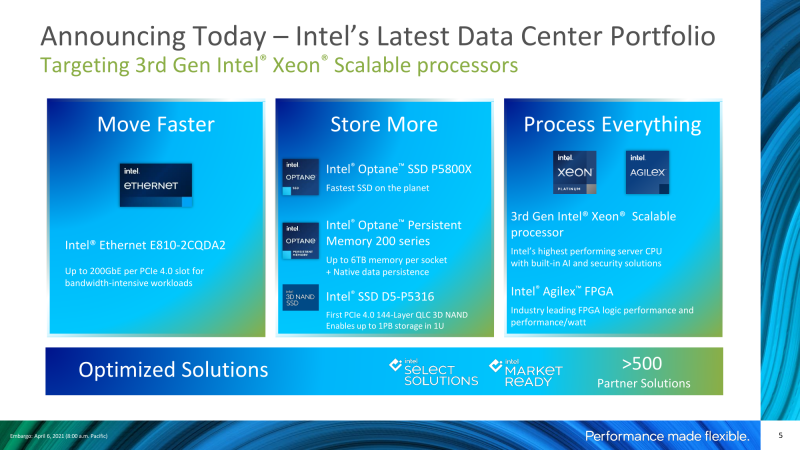

И так как Intel теперь стала единственным производителем 3D XPoint, память Optane останется эксклюзивом для её платформ. Как в виде DIMM, так и в виде SSD. И да, поддержка PCIe 4.0, с одной стороны, позволит, наконец, компании в полной мере воспользоваться преимуществами собственных Optane (P5800X) и SSD-накопителей (TLC и QLC, пока они окончательно не перешли к SK Hynix), включая высокоплотные EDSFF E1.L, а также свежих двухпортовых 100GbE-адаптеров E810 и FPGA Agilex. А с другой — ещё больше подстегнёт развитие экосистемы PCIe 4.0.

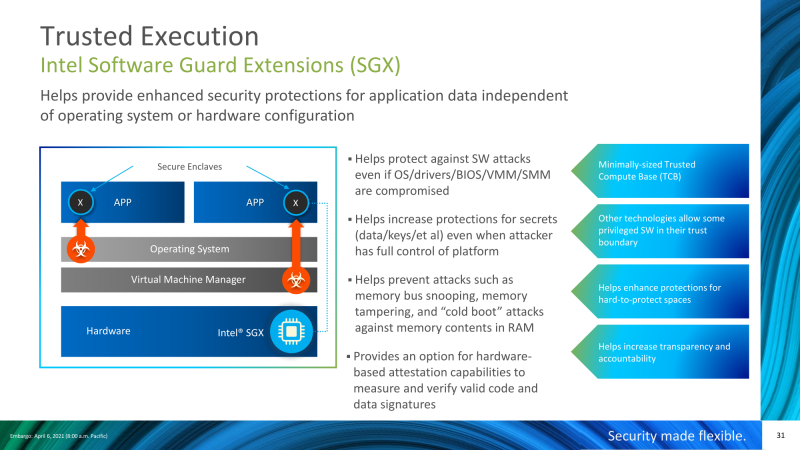

Следующее важное нововведение, которое на самом деле не такое уж новое, — это расширение поддержки технологии SGX (Software Guard Extensions), которая позволяет создавать в памяти анклавы, защищённые от вмешательства ОС, гипервизора и периферии (по DMA). Собственно, расширения SGX появились в составе Skylake, но были представлены лишь в некоторых CPU (Xeon E) и имели ограничение по размеру анклава (до 64 Мбайт). Фактически с их помощью можно было обрабатывать лишь малые объёмы каких-то критических данных.

Тем не менее вокруг технологии сложилась небольшая экосистема: её поддержка есть в популярных гипервизорах, существует сразу несколько SDK, она реализована в Microsoft Azure и IBM Cloud и так далее. Ice Lake-SP значительно расширяет возможности использования SGX, так как максимальный размер анклава составляет от 8 до 512 Гбайт, но для большинства SKU этот показатель равен 64 Гбайт. Intel SGX отличается от AMD SEV, но тоже подходит для реализации полноценных конфиденциальных вычислений, федеративного обучения или обработки данных. А вот про что в своём докладе Intel не говорила, так это про аппаратные заплатки от последних уязвимостей. Видимо, считается, что всё в порядке.

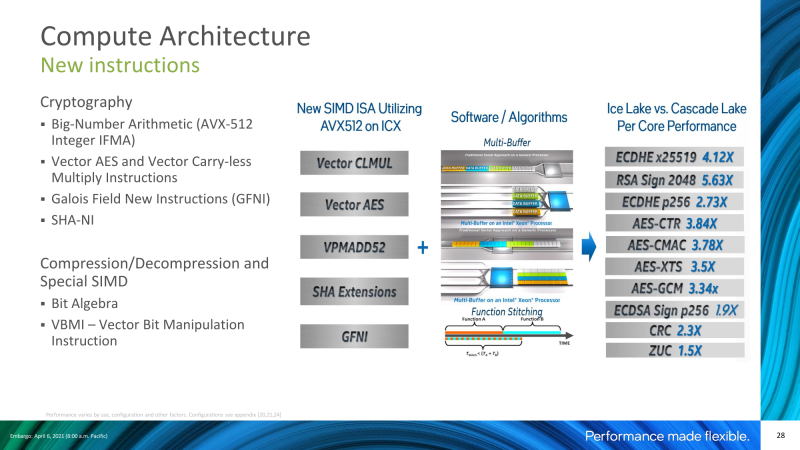

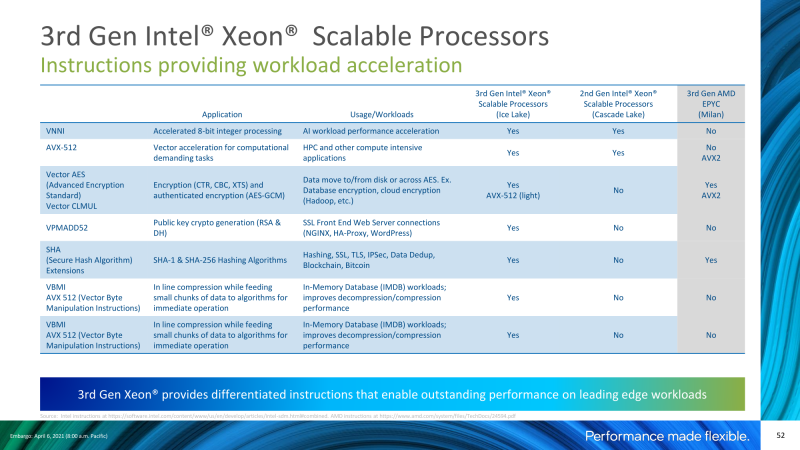

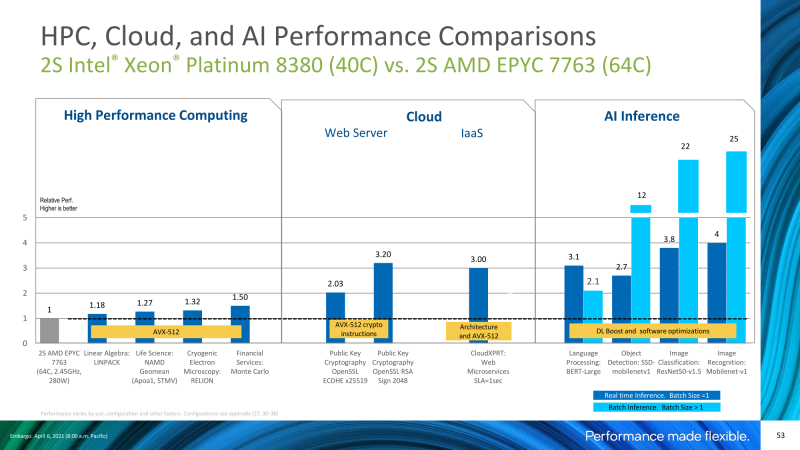

Наконец, ещё один «конёк» Xeon, инструкции AVX-512, получил новые расширения, которые касаются работы с СУБД, (де-)компрессией и шифрованием. Опять-таки, не для всякого софта они полезны, но именно благодаря им Xeon может обгонять другие CPU по чистой производительности во многих аспектах. Расширения DL Boost для работы с ИИ тоже никуда не делись, а прирост в числе ядер вообще позволяет Intel говорить, что в некоторых задачах инференса Ice Lake-SP быстрее не только EPYC, что ожидаемо, но и GPU.

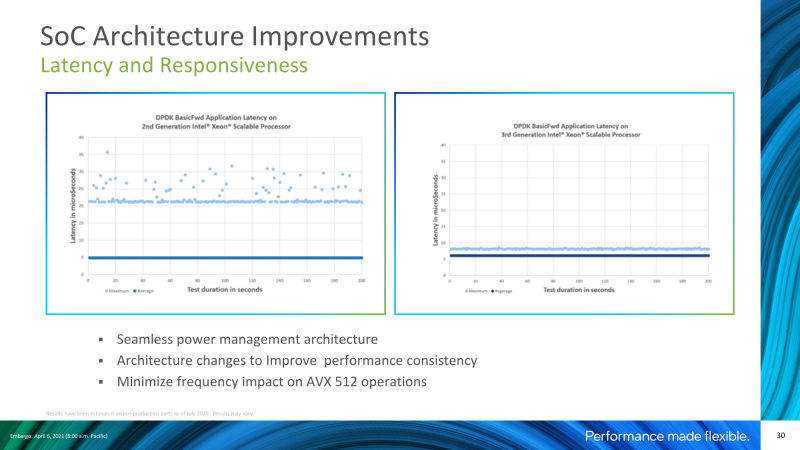

Что ещё более важно, инструкции SSE, AVX2 и AVX-512 разделены на лёгкие и тяжёлые, и для них принята разная политика управления частотами — лёгкие инструкции могут дольше работать на более высокой частоте. А переработка внутренней системы питания теперь позволяет ядрам, агентам, mesh-сети и процессору в целом быстрее переключаться между частотами и состояниями. Кроме того, RDT теперь позволяет динамически менять приоритизацию запущенных потоков и пропускной способности кеша и памяти.

Производительность

По данным Intel, производительность платформы в целом от поколения к поколению в итоге выросла в 1,46 раза. По отдельным направлениям этот показатель ещё выше: 1,74 для ИИ-инференса, 1,48 для шифрования, 1,58 для облачных микросервисов, 1,72 для виртуализации, 1,64 для транзакций СУБД, 1,53 для HPC. Достигается это благодаря и росту числа ядер, и новым инструкциям, и оптимизациям как железа, так и ПО. Последний пункт вообще очень важен для Intel — компания активно вкладывается в развитие и своего софта, и open source-решений, и решений партнёров. И в принципе стала несколько более открытой, особенно после запуска oneAPI.

В этом отношении AMD пока отстаёт, но у компании сейчас есть все возможности нагнать конкурента, и она активно работает над этим. Если же смотреть не только на CPU, а на экосистему в целом, то тут Intel готова предложить ещё больше интеграции как с собственным железом и ПО, так и с другими продуктами. Компания регулярно напоминает о синергии своих решений (и скидках), которая и даёт повышение производительности в различных задачах, но относиться к этому можно по-разному. Привязка к одному вендору упрощает обновление и миграцию, но может и лишить некоторых важных возможностей, как это было с PCIe 4.0.

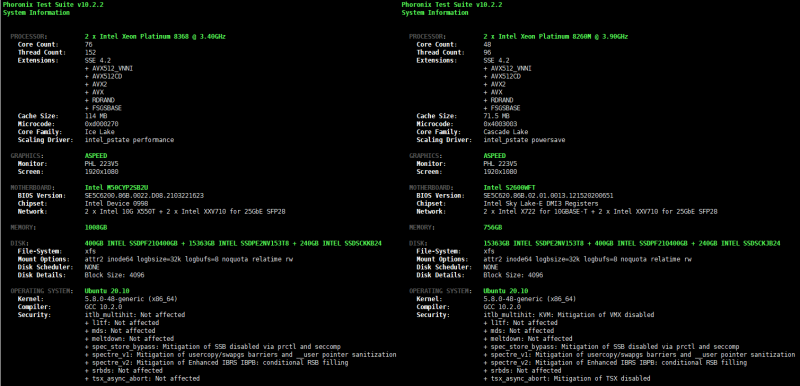

Но мы на этот раз в силу ограниченности времени и ресурсов остановимся на знакомстве с новыми CPU. Intel предоставила удалённый доступ к двум системам на базе Xeon Cascade Lake-SP (CLX) и Ice Lake-SP (ICX), чьи характеристики приведены в таблице ниже. Отдельно стоит отметить, что система с ICX фактически является SDP (Software Development Platform) и несколько отличается от тестовых и конечных платформ, причём не всегда в лучшую сторону. Ещё один важный момент — для тестов использовался процессор степпинга D2, а не D1 из первых партий.

| Тестовые стенды Intel | ||

| Поколение | Ice Lake-SP | Cascade Lake-SP |

| Платформа | M50CYP | S2600WF |

| ОС | Ubuntu Server 20.10, Linux 5.8.0-48-generic | |

| Процессор × 2 | ||

| Модель | Xeon Platinum 8368 | Xeon Platinum 8260M |

| Ядра/Потоки | 38/76 | 24/48 |

| Частота Base/Turbo/All-Turbo, ГГц | 2,4/3,4/3,2 | 2,4/3,9/- |

| L3-кеш, Мбайт | 57 | 35,75 |

| TDP, Вт | 270 | 165 |

| Память | ||

| Модель | SK Hynix HMAA8GR7AJR4N-XN | |

| Тип | DDR4-3200 ECC RDIMM 2Rx4 | |

| Объём | 16 × 64 Гбайт (1DPC) | 12 × 64 Гбайт (1DPC) |

| Режим | DDR4-3200 | DDR4-2933 |

| Хранилище | ||

| /, ext4 | Intel SSD Pro 2500, SATA3, 240 Гбайт | |

| /var, xfs | Intel SSD D5-P4326, PCIe 3.1 x4, 15,36 Тбайт | |

| /data, xfs | Intel SSD Optane DC P5800X, PCIe 4.0 x4, 400 Гбайт | |

В остальном системы по возможности приведены к единообразию. Память в режиме 1DPC с максимальной для каждой платформы частотой, профили питания/охлаждения и cpu governor переведены в Performance, Turbo-Boost и SMT включены (если не оговорено иное), SNC отключен, а основной накопитель — NVMe SSD PCIe 3.0 x4 с xfs. Тестовый пакет — Phoronix Test Suite 10.2.2 в Ubuntu Server 20.10 с GCC 10.2.0. За прошедшее с момента тестирования EPYC Milan время успели обновиться некоторые компоненты ОС, и нельзя не отметить, что ядро и компилятор уже давным-давно «познакомили» с Ice Lake-SP.

Но для начала, как обычно, индивидуальные, выполненные в ручном, а не автоматическом режиме тесты HPL (High-Performance Linpack) 2.3 и Stream 5.10, в которых SDP и проявила свой характер, не позволив отключить HT, хотя это могло бы несколько улучшить результаты. Для этих тестов понадобились бесплатные наборы oneAPI Base и HPC версии 2021.2.0, включающие целый ряд оптимизированных библиотек и компилятор icc, которые пригодились для сборки stream, и уже готовый исполняемый файл для HPL. Для stream отдельно был включён SNC2, а для HPL — контроль над питанием и производительностью (EPB) в случае ICX был передан BIOS и переведён в режим Performance. Для CLX же был отключен HT.

| Stream 5.1, Мбайт/с | ||||

| CPU | AMD | Intel | ||

| 2 × 7763 | 2 × 7543 | 2 × 8368 | 2 × 8260M | |

| Copy | 339627,3 | 319521,6 | 311682,2 | 194747,9 |

| Scale | 335561,8 | 318395,5 | 317250,6 | 194553,5 |

| Add | 337742,8 | 322929,4 | 318898,7 | 206539,6 |

| Triad | 332141,0 | 317128,1 | 321387,2 | 206608,2 |

Естественно, оба бенчмарка активно используют AVX-512, так что технически Ice Lake-SP с меньшим числом ядер способны обгонять более многоядерные EPYC Milan и в избранных HPC-задачах действительно могут успешно с ними конкурировать:

- 2 × AMD EPYC 7763 — 3,1840 Тфлопс;

- 2 × AMD EPYC 7543 — 2,2044 Тфлопс;

- 2 × Intel Xeon Platinum 8368 — 4,4048 Тфлопс;

- 2 × Intel Xeon Platinum 8260M — 2,45226 Тфлопс.

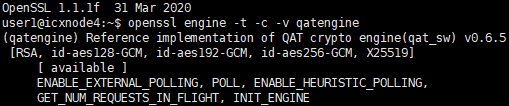

Библиотеки oneAPI с icc пригодились и для сборки Intel QAT Engine, движка для OpenSSL, который использует аппаратные возможности ускорения работы криптографических функций с помощью QAT в чипсетах Lewisburg. Но теперь он также «знает» и про новые инструкции AVX-512 для тех же задач в Ice Lake-SP. В данном случае использовался OpenSSL 1.1.1f из репозиториев Ubuntu c этим движком и без него.

| OpenSSL 1.1.1f + Intel QAT Engine (sw_qat), Мбайт/с | |||||||||

| Алгоритм | AES-128-GCM | AES-192-GCM | AES-256-GCM | ||||||

| Размер блока, байт | - | QAT Engine | Ускорение × | - | QAT Engine | Ускорение × | - | QAT Engine | Ускорение × |

| 16 | 700,49 | 570,57 | 0,81 | 676,77 | 547,28 | 0,81 | 643,76 | 524,27 | 0,81 |

| 64 | 1675,43 | 2126,15 | 1,27 | 1648,86 | 2083,68 | 1,26 | 1585,82 | 2000,09 | 1,26 |

| 256 | 3676,44 | 6013,64 | 1,64 | 3521,96 | 5887,49 | 1,67 | 3310,25 | 5148,68 | 1,56 |

| 1024 | 5067,43 | 9702,21 | 1,91 | 4799,75 | 8986,31 | 1,87 | 4476,46 | 8193,21 | 1,83 |

| 8192 | 6091,54 | 13101,39 | 2,15 | 5740,12 | 12119,64 | 2,11 | 5285,55 | 11547,17 | 2,18 |

| 16384 | 6268,08 | 13466,74 | 2,15 | 5835,48 | 12451,03 | 2,13 | 5371,57 | 11902,09 | 2,22 |

| OpenSSL 1.1.1f + Intel QAT Engine (sw_qat) | |||

| Алгоритм | - | QAT Engine | Ускорение × |

| RSA-2048, подп./с | 1606,1 | 9431,2 | 5,9 |

| ECDSA-256, подп./с | 44825,6 | 97312,0 | 2,2 |

| ECDSA-384, подп./с | 1002,2 | 38010,4 | 37,9 |

| ECDH-253, оп./с | 28480,3 | 135555,2 | 4,8 |

| ECDH-256, оп./с | 19074,6 | 56904,8 | 3,0 |

| ECDH-384, оп./с | 1052,9 | 16748,8 | 15,9 |

Ещё один небольшой тест, сделанный вручную, — это HammerDB 4.0 поверх MySQL 8.0.23. Это единственный тест, для которого в качестве основного диска использовался SSD Intel Optane DC серии P5800X. В данном тесте сервер с Ice Lake-SP оказался в 1,93 раза быстрее сервера прошлого поколения:

- 2 × Intel Xeon Platinum 8368 — 1590759 NOPM/4820904 MySQL TPM;

- 2 × Intel Xeon Platinum 8260M — 823890 NOPM/2497567 MySQL TPM.

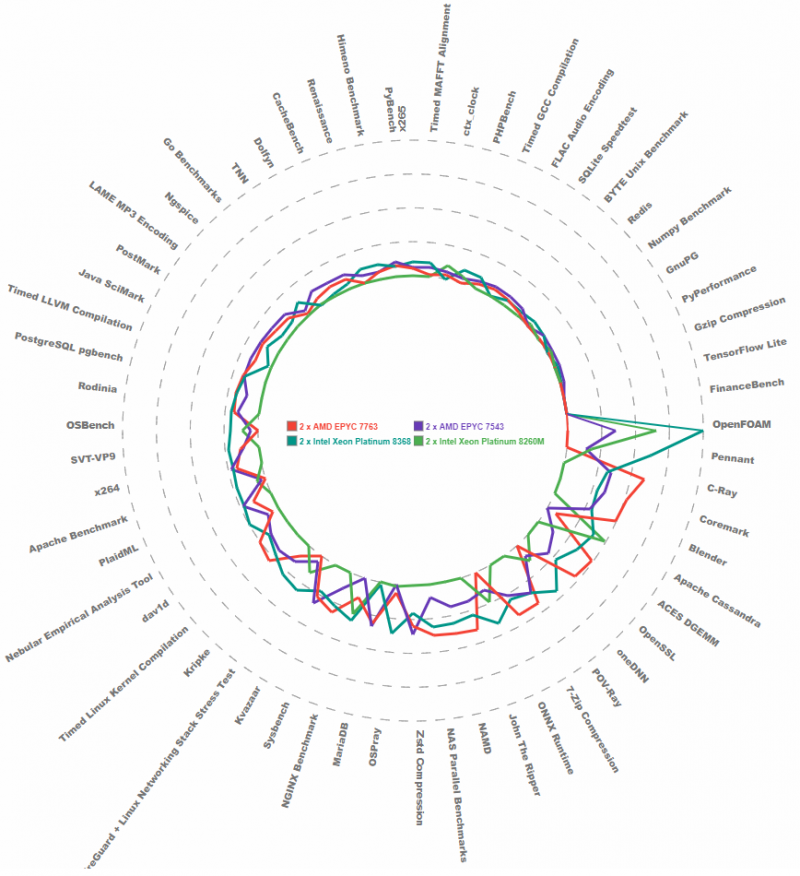

Для PTS был использован тот же набор тестов и результатов из обзора AMD EPYC Milan. Увы, не все тесты автоматически корректно сработали на обеих машинах Intel (HPCG, Quantum ESPRESSO, Go HTTP). И в прошлый раз было отмечено совсем уж «неприличное» поведение LAMMPS на одной из AMD-машин и слишком «шумный» Cpuminer-Opt. Поэтому разделим результаты на «грязные», со всеми данными, и условно-«чистые», без неполных и проблемных тестов. И отдельно приведём результаты сравнения только для Xeon.

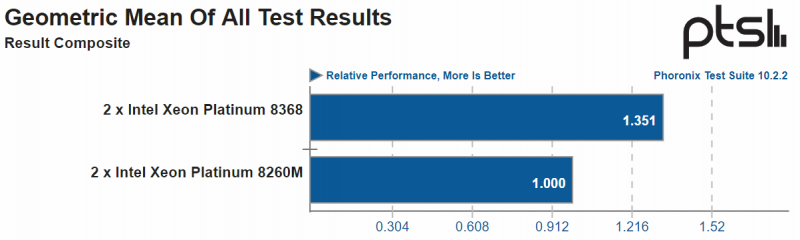

В целом новые процессоры Ice Lake-SP хорошо смотрятся на фоне AMD EPYC. Последние в среднем выигрывают, например, в компиляции, компрессии, рендере, а их оппоненты — в ИИ-задачах, трассировке, HPC. Впрочем, всё это касается только данного конкретного набора ПО. Если же сравнивать два поколения Xeon Scalable, то новое, опять-таки в среднем, оказывается в 1,35 раза быстрее прошлого.

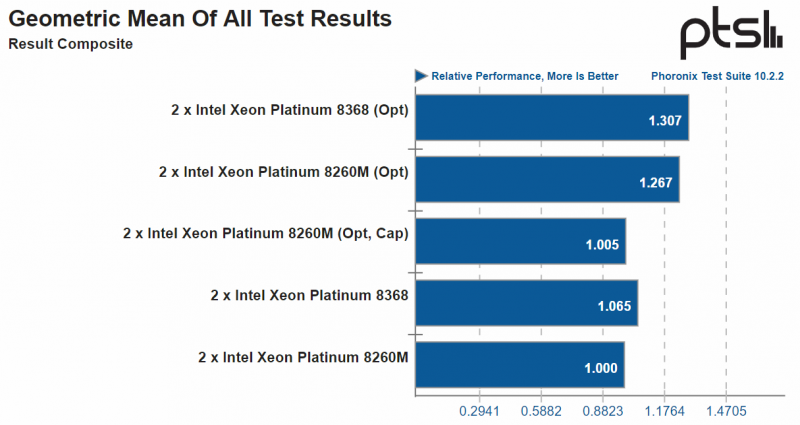

Отдельно можно посмотреть прирост за счёт небольших оптимизаций в однопоточной нагрузке на примере Redis в рамках PTS. За основу взяты данные и бинарные файлы, полученные в автоматизированном тесте, но слегка изменён скрипт запуска. Такие результаты помечены как Opt. Дополнительный прогон на Cascade Lake-SP с ограничением максимальной частоты до той же, что у Ice Lake-SP, помечен как Cap.

Заключение

Intel в текущей ситуации противостоять «грубой силе» AMD может только так (и что она и делает) — предлагать клиентам комплексные, оптимизированные, готовые к быстрому развёртыванию решения для конкретных областей и нужд заказчика. И процессоры лишь малая часть экосистемы, которая включает Optane (PMem и SSD), NAND SSD, Ethernet-адаптеры и коммутаторы, FPGA, Xeon D, ИИ-ускорители Habana, грядущие Xe и огромное количество технологий, программных и аппаратных. Ведь целое всегда есть нечто большее, чем простая сумма его частей? Да, но проблема в том, что Ice Lake-SP, которые и должны стать ядром экосистемы, появились очень поздно, догнав AMD по памяти и PCIe через полтора года и достигнув какого-то паритета в двухсокетных, но не односокетных системах.

По сравнению с прошлым поколением новые Xeon Scalabale очевидно лучше. Во всяком случае, на примере старших SKU, но вот про гораздо более интересные и массовые средний и нижний сегменты пока нечего сказать — всё же увеличение числа ядер в монолитном кристалле быстрее нивелируется понижением частоты. По сравнению с EPYC всё уже не так однозначно. Если обобщать, то на стороне Xeon — AVX-512 и новые расширения, которое ПО должно уметь использовать. На стороне AMD — больше ядер и больше кеша. Память Optane PMem интересна, но массовой её не назовёшь. И для неё опять же нужна адаптация ПО.

Но, возможно, такое положение дел Intel вполне устраивает? Она всё ещё лидер на рынке, и вендоры с заказчиками всё равно будут переходить на Ice Lake-SP, хотя, надо полагать, не такими темпами, как ранее. В ближайшем будущем AMD половину рынка не отъест, так как она теперь тоже зависит от производственных проблем, хотя и совершенно другого характера. А так и до следующего поколения можно дотянуть. Собственно говоря, нынешние Xeon и EPYC знаменуют конец эпохи. Следующие процессоры появятся уже скоро, и они не только принесут поддержку DDR5 и PCIe 5.0, но и поменяют подход к архитектуре и чипов, и систем. Да и Arm пусть медленно, но набирает силу.

Чтобы не пропустить новые материалы, подписывайтесь на нас в Я.Дзен, Telegram, Twitter и LinkedIn.