Материалы по тегу: gpu

|

12.11.2025 [10:28], Владимир Мироненко

YADRO выводит на рынок высокопроизводительный ИИ-сервер для компаний, внедряющих искусственный интеллектYADRO (входит в «ИКС Холдинг») объявляет о коммерческом запуске ИИ-сервера YADRO G4208P G3 — решения для компаний, которые рассматривают искусственный интеллект как стратегический драйвер роста. В условиях перехода рынка от отдельных пилотных проектов к широкому внедрению прикладных сценариев использования искусственного интеллекта новый сервер призван удовлетворить растущий спрос бизнеса на масштабируемую инфраструктуру с предсказуемой эффективностью. Многолетний опыт YADRO в построении ИИ-систем для российских заказчиков лёг в основу архитектуры нового сервера G4208P G3. Платформа спроектирована под реальные задачи бизнеса: дообучение корпоративных моделей и обучение компактных моделей, высокопроизводительный инференс в промышленной среде, а также задачи, где требуется GPU-ускорители, включая видеоаналитику и обработку изображений. YADRO G4208P G3 поддерживает установку до восьми GPU-ускорителей и конфигурации на основе двух процессоров Intel Xeon Scalable 4-го/5-го поколений с интерфейсами PCIe 5.0 и памятью DDR5-5600. Сочетание производительности и масштабируемости такого уровня выводит сервер в число самых сильных предложений на российском рынке. Сервер прошел серию испытаний и сравнений с публичными бенчмарками, включая MLCommons и прикладные тесты для генеративных моделей (LLM). Результаты подтвердили уровень производительности и эффективности, сопоставимый с решениями ведущих мировых вендоров. Для российских компаний это означает, что инфраструктура на базе YADRO G4208P G3 позволит запускать крупные современные ИИ- модели, включая DeepSeek-R1 685B, и обеспечить их стабильную работу в продуктивной среде с соблюдением целевых SLO/SLA, снижением времени отклика сервисов и контролируемыми затратами на развитие инфраструктуры. Параллельно идёт широкая программа испытаний совместно с технологическими партнёрами — разработчиками отечественных программных решений. Ряд сценариев уже успешно протестирован, подтверждены совместимость и ключевые показатели производительности. ИИ-стеки, валидированные на базе серверов YADRO, формируют инфраструктурную основу для развития отечественных технологий искусственного интеллекта. YADRO сопровождает заказчиков на всем пути внедрения своих продуктов. Команда помогает определить оптимальную конфигурацию под конкретные задачи — от картирования рабочих нагрузок и выбора архитектуры до пилотирования и настройки производительности. Полный цикл сервиса включает консультирование, инсталляцию, сопровождение и поддержку на всём жизненном цикле решения. В результате заказчики получают устойчивую ИИ-инфраструктуру, которая работает надёжно и развивается вместе с бизнесом. «Компании переходят к практической интеграции ИИ в ключевые процессы, и мы уверены, что сейчас самый подходящий момент для выхода сервера YADRO G4208P G3. Платформа создана на основе нашего опыта реальных внедрений и ориентирована на быстрый путь от идеи к промышленной эксплуатации. Мы предлагаем оборудование и экспертную поддержку — от выбора конфигурации и внедрения до последующего обслуживания — чтобы заказчики могли эффективно управлять развитием своих ИИ- инициатив», — резюмирует Павел Егоров, директор по продуктам YADRO. Сервер YADRO G4208P G3 внесён в Единый реестр российской радиоэлектронной продукции Минпромторга, что подтверждает его соответствие требованиям импортозамещения и открывает возможность применения в государственных и корпоративных проектах с требованиями по локализации. Подробнее ознакомиться с конфигурациями, результатами тестов и сценариями применения, а также получить рекомендации экспертов и оставить заявку на пилотное тестирование сервера можно на сайте.

05.11.2025 [09:59], Сергей Карасёв

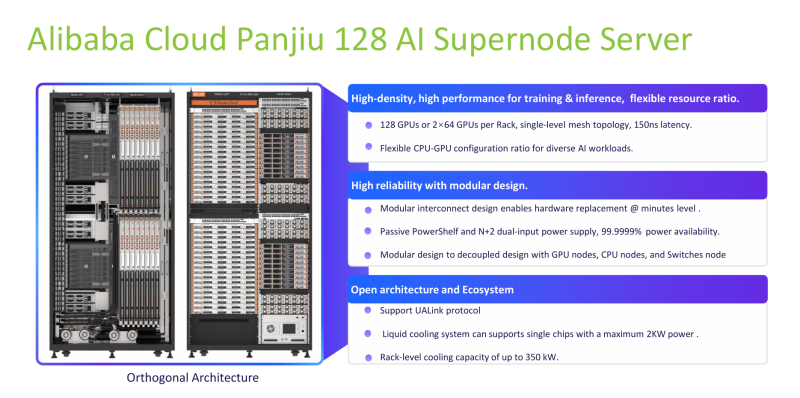

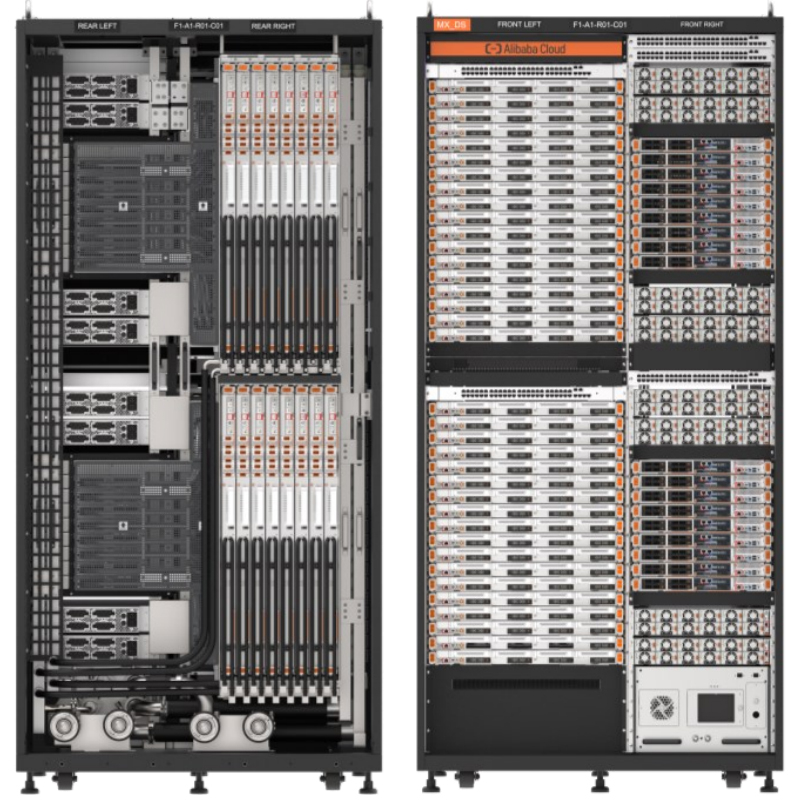

350-кВт ИИ-суперускоритель Alibaba Panjiu 128 Supernode объединяет 128 GPU мощностью до 2 кВтОблачная платформа Alibaba Cloud в ходе мероприятия 2025 OCP Global Summit анонсировала систему Panjiu 128 Supernode, предназначенную для решения наиболее ресурсоёмких задач в сфере ИИ. Новинка представляет собой стойку высокой плотности мощностью до 350 кВт. Решение имеет «ортогональную архитектуру» с возможностью размещения определённых компонентов перпендикулярно друг к другу. Говорится о поддержке до 128 ускорителей на базе GPU и о гибких возможностях в плане конфигурации CPU — GPU. Задействованы фирменные DPU-решения Cloud Infrastructure Processing Unit (CIPU) 2.0 и высокопроизводительные сетевые адаптеры. Кроме того, реализована поддержка протокола UALink, который разрабатывается в качестве альтернативы NVIDIA NVLink.

Источник изображения: Alibaba / OCP Благодаря модульной конструкции упрощаются обслуживание и замена узлов. Стойка оборудована высокоэффективной системой жидкостного охлаждения, которая позволяет использовать ускорители мощностью до 2000 Вт. В состав Panjiu 128 Supernode входят пассивные полки питания. При этом реализована схема энергоснабжения с резервированием N+2, что, по заявлениям Alibaba Cloud, помогает добиться доступности на уровне 99,9999 %. В целом, реализованная архитектура обеспечивает задержки на уровне 150 нс внутри одноуровневой mesh-фабрики. По сравнению с традиционными решениями сопоставимого класса ИИ-система на базе Panjiu 128 Supernode теоретически позволяет повысить производительность инференса на 50 %, говорит компания. Нужно отметить, что спрос на оборудование для ИИ-инфраструктур стремительно растёт. По оценкам IDC, во II квартале текущего года продажи серверов и СХД для ИИ-платформ в денежном выражении достигли $82 млрд, что на 166 % больше по сравнению с аналогичным периодом 2024-го ($30,8 млрд). Причем серверы с ИИ-ускорителями принесли 91,8 % от суммарной выручки.

16.10.2025 [16:44], Сергей Карасёв

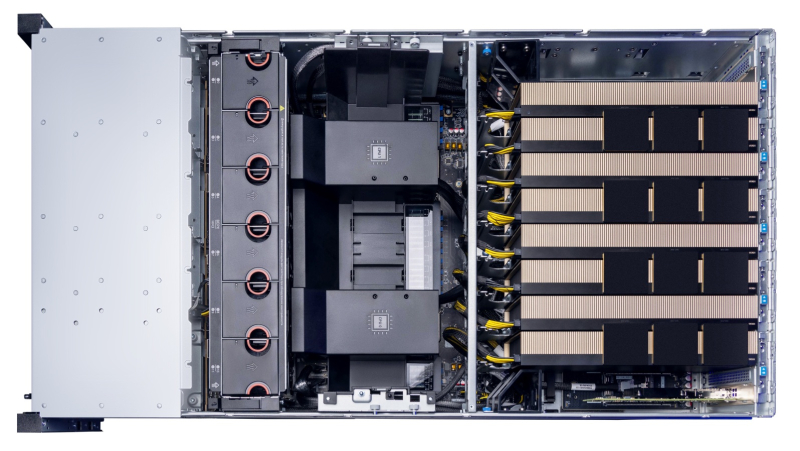

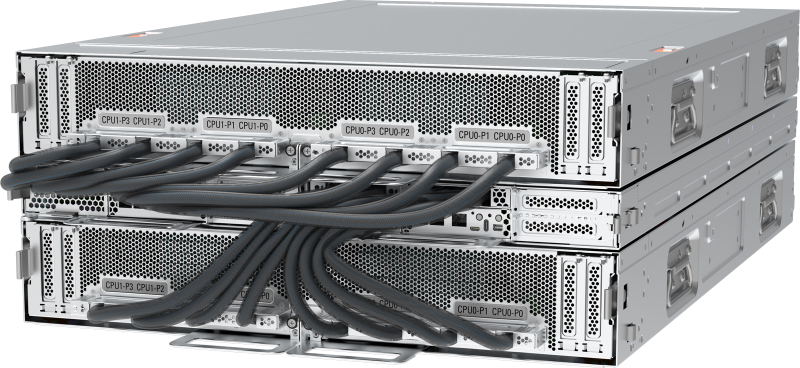

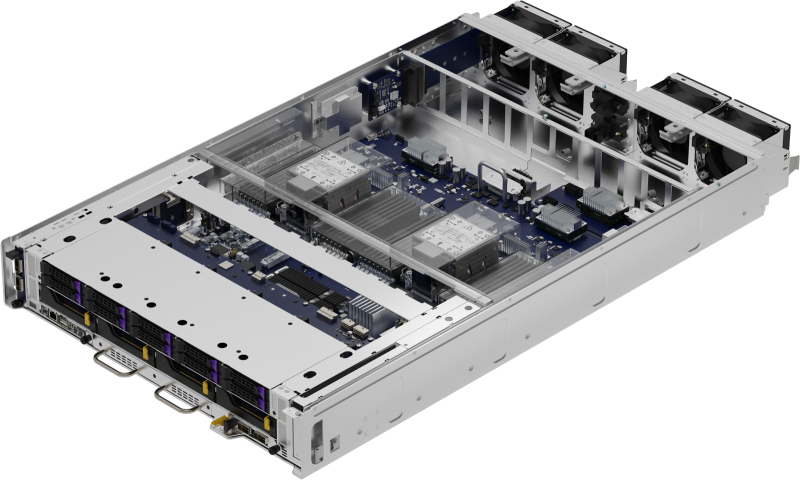

Pegatron представила ИИ-сервер AS501-4A1-16I1 с СЖО и 16 ускорителями AMD Instinct MI355XPegatron анонсировала высокопроизводительный сервер AS501-4A1-16I1 с СЖО для задач НРС, а также ресурсоёмких приложений ИИ, включая инференс и обучение больших языковых моделей. Устройство выполнено в форм-факторе 5OU на аппаратной платформе AMD. До восьми серверов AS501-4A1-16I1 могут быть установлены в стойку RA5100-128I1. Это позволяет сформировать ИИ-систему высокой плотности, насчитывающую до 32 процессоров EPYC 9005 и до 128 ускорителей Instinct MI355X. Конструкция системы включает два CPU-узла и два лотка GPU. Каждая из CPU-секций допускает установку двух процессоров AMD EPYC 9005 Turin с показателем TDP до 500 Вт и 24 модулей оперативной памяти DDR5-6400 RDIMM. Таким образом, в общей сложности могут быть задействованы четыре чипа EPYC и 48 модулей ОЗУ. В свою очередь, каждый из GPU-лотков оснащается восемью ускорителями AMD Instinct MI355X, которые несут на борту 288 Гбайт памяти HBM3E с пропускной способностью до 8 Тбайт/с. В общей сложности реализованы 12 слотов PCIe 5.0 x16 FHHL, в которые установлены десять однопортовых сетевых адаптеров 400GbE и два двухпортовых адаптера 10GbE В оснащение входят контроллер Aspeed AST2600, два сетевых порта 1GbE (RJ45), выделенный сетевой порт управления (RJ45), последовательный порт (разъём Micro-USB), интерфейсы USB 2.0 Type-C и Mini-DP. В дополнение к СЖО имеются десять вентиляторов охлаждения. Применяется шина питания ORv3 на 48 В DC.

16.10.2025 [16:20], Андрей Крупин

VK Tech запустил сервис виртуальных карт GPUРоссийский разработчик корпоративного программного обеспечения VK Tech (входит в экосистему VK) сообщил о включении в состав облачной платформы VK Cloud виртуальных GPU-карт. Виртуальные GPU реализованы на базе аппаратных решений компании Nvidia и доступны в VDI-сервисе Cloud Desktop, предназначенном для доставки пользователям рабочих столов, развёрнутых на удалённом сервере и функционирующих в виртуализированном окружении. Поддержка GPU может быть актуальна для проектирования, анимации, редактирования видео, 3D-моделирования, рендеринга, тяжёлых вычислений, машинного обучения и других ресурсоёмких задач.

Источник изображения: Christina @ wocintechchat.com / unsplash.com «Мы стремимся сделать технологии более доступными для наших пользователей. Облачные вычисления на базе GPU помогут повысить производительность решений, сократить время на обработку данных и снизить расходы. Новый сервис позволяет быстро получить готовую к работе видеокарту и оплатить только необходимый объем её мощностей», — отмечает VK Tech. Инфраструктура VK Cloud соответствует 152-ФЗ на высшем уровне защищённости (УЗ-1), а также стандартам ГОСТ Р 57580 и PCI DSS.

15.10.2025 [09:13], Сергей Карасёв

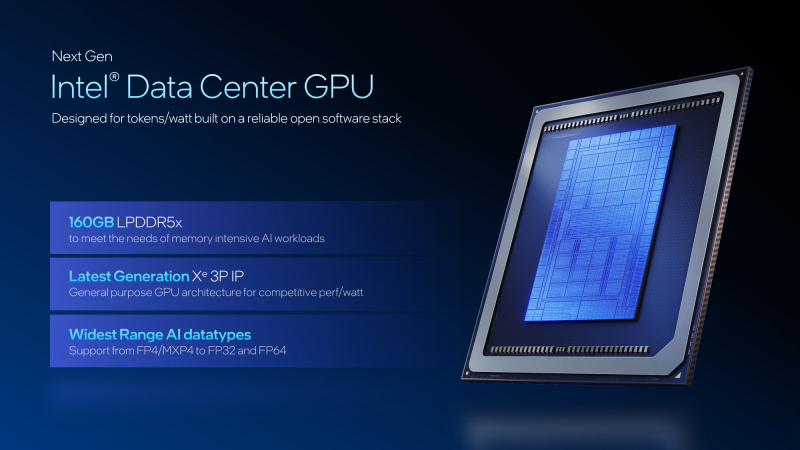

Intel представила GPU-ускоритель Crescent Island для ИИ-инференсаКорпорация Intel, как и ожидалось, представила на мероприятии OCP Global Summit в Сан-Хосе (Калифорния, США) графический процессор нового поколения для дата-центров. Изделие с кодовым названием Crescent Island специально оптимизировано для задач ИИ-инференса. В основу GPU положена архитектура Xe3P. Она представляет собой усовершенствованную версию Xe3, которая используется в процессорах Core Ultra 300 семейства Panther Lake для ноутбуков и компактных настольных ПК. Говорится об улучшенном показателе производительности в расчёте на 1 Вт затрачиваемой энергии. Ускоритель на базе Crescent Island получит 160 Гбайт памяти LPDDR5X. Как отмечает ресурс Tom's Hardware, максимальный объём чипов LPDDR5X составляет 8 Гбайт. При этом используются два 16-бит канала памяти, что в сумме даёт 32 бита. Таким образом, для обеспечения 160 Гбайт памяти требуются 20 чипов LPDDR5X. Это означает, что ускоритель получит либо один массивный GPU с 640-бит интерфейсом памяти для подключения всех 20 чипов LPDDR5X, либо два менее крупных процессора с 320-бит интерфейсом, каждый из которых будет обслуживать 10 чипов LPDDR5X. Прочие технические детали не раскрываются. При этом Intel отмечает, что изделие Crescent Island предназначено для использования в серверах с воздушным охлаждением. GPU поддерживает работу с широким спектром типов данных, благодаря чему может применяться в составе облачных платформ «токен как услуга» (tokens-as-a-service). Пробные поставки новинки планируется начать во II половине 2026 года, тогда как широкая доступность ожидается не ранее 2027-го. Решениям на основе Crescent Island предстоит конкурировать с ИИ-ускорителями AMD и NVIDIA следующего поколения, такими как Rubin CPX.

13.10.2025 [13:20], Сергей Карасёв

«Инферит» представил российские 2U-серверы для ИИ на базе Intel Xeon Emerald RapidsРоссийский поставщик IT-решений «Инферит» (ГК Softline) анонсировал серверы на аппаратной платформе Intel. Дебютировали модели UR2X2G4V1-D24, GR2X2G4V1-D24, UR2X2G4V1-D12 и GR2X2G4V1-D12 для решения различных задач. Все новинки выполнены в форм-факторе 2U. Они могут нести на борту два процессора Intel Xeon Sapphire Rapids или Xeon Emerald Rapids с TDP до 350 Вт. Поддерживается до 8 Тбайт оперативной памяти DDR5-4400/4800 в виде 32 модулей. Модель Inferit UR2X2G4V1-D24 предназначена для комплексных вычислений, виртуализации, облачных сервисов и работы с большими данными. Во фронтальной части расположены 24 отсека для SFF-накопителей SAS/SATA/NVME с поддержкой горячей замены. Доступны два слота PCIe 5.0 x16 и четыре слота PCIe 5.0 x8 для карт полной высоты, а также два разъёма OCP 3.0 (PCIe 5.0 x8). Предусмотрены выделенный сетевой порт управления 1GbE (RJ45), последовательный порт, разъёмы USB 3.0 и D-Sub. Установлены два блока питания мощностью 1300 Вт с сертификатом 80 Plus Platinum. Вариант Inferit GR2X2G4V1-D24 имеет аналогичные технические характеристики, но оснащается двумя ИИ-ускорителями на базе GPU суммарной мощностью до 600 Вт. Система ориентирована на развёртывание языковых моделей, обучение ИИ, 3D-визуализацию и 3D-рендеринг, работу с большими данными, комплексные научные вычисления, виртуализацию и облачные сервисы. Задействованы два блока питания на 2000 Вт с сертификатом 80 Plus Platinum. Сервер Inferit UR2X2G4V1-D12, в свою очередь, подходит для комплексных вычислений, виртуализации и облачных сервисов. Он оборудован 12 лицевыми отсеками для LFF/SFF-накопителей SAS/SATA/NVMe с поддержкой горячей замены. Прочие характеристики аналогичны версии Inferit UR2X2G4V1-D24. Наконец, модификация Inferit GR2X2G4V1-D12 схожа с версией GR2X2G4V1-D24, но при этом оснащена 12 посадочными местами для накопителей LFF/SFF. На все серверы опционально предустанавливается фирменная ОС «МСВСфера». Базовая гарантия составляет три года с возможностью продления до пяти лет. «Мы укрепляем свои позиции на рынке ИТ, развивая линейки собственных продуктов для бизнеса и госсектора. Новая серия серверов — это топовое решение в нашей продуктовой линейке для крупного бизнеса, науки и госучреждений. Конструируя их, мы ориентировались не только на производительность — надёжность, масштабируемость и минимум отказов были не меньшими приоритетами», — говорит «Инферит Техника».

10.10.2025 [10:11], Сергей Карасёв

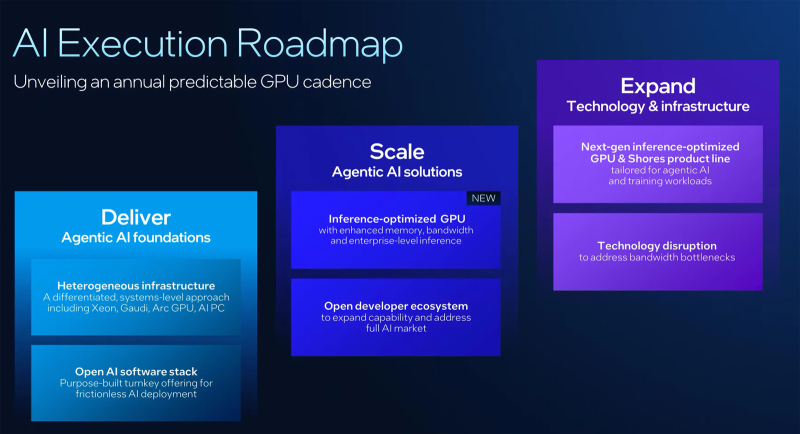

Intel готовит новый GPU-ускоритель, оптимизированный для инференсаКорпорация Intel в ходе мероприятия Intel Tech Tour Arizona сообщила о подготовке новых ИИ-ускорителей на базе GPU. Речь идёт об изделиях, специально оптимизированных для задач инференса. Кроме того, компания поделилась планами по развитию ИИ-продуктов в целом. Ранее предполагалось, что в 2025 году Intel выведет на рынок ускорители Falcon Shores. Изначально планировалось, что это будут гибридные решения, содержащие блоки CPU и GPU. Однако впоследствии Intel сделала выбор в пользу конфигурации исключительно на основе GPU. А затем корпорация и вовсе заявила, что на коммерческом рынке изделия Falcon Shores не появятся. Вместо этого Intel решила сфокусировать внимание на выпуске ускорителей Jaguar Shores. Войдёт ли готовящийся к выпуску GPU для инференса в семейство Jaguar Shores, пока не ясно. Подробности о новинке Intel обещает раскрыть в ходе предстоящего мероприятия 2025 OCP Global Summit, которое пройдёт с 13 по 16 октября в Сан-Хосе (Калифорния, США). На сегодняшний день известно, что устройство получит улучшенную память с высокой пропускной способностью. Изделие будет ориентировано на корпоративный сектор. «Мы активно работаем над оптимизированным для инференса GPU, о котором подробнее расскажем на конференции OCP», — сообщил технический директор Intel Сачин Катти (Sachin Katti). Кроме того, Intel объявила о намерении перейти на ежегодный график выпуска ИИ-продуктов следующего поколения. Предполагается, что это поможет укрепить позиции на глобальном рынке ИИ, на котором корпорация уступила позиции NVIDIA. При этом Intel подчёркивает, что на ближайшую перспективу Jaguar Shores является основным приоритетом в области развития высокопроизводительных решений для ИИ-инфраструктуры.

07.10.2025 [15:52], Сергей Карасёв

Китайские компании укрепляют позиции на местном рынке ИИ-ускорителей — часть основана выходцами из AMD и NVIDIAРазработчики из Китая, как сообщает TrendForce, добились существенных успехов в создании ускорителей. Речь идёт о решениях на основе ASIC и GPU, призванных составить конкуренцию картам NVIDIA, поставки которых в КНР ограничены в связи с американскими санкциями. Разработкой ИИ-ускорителей в КНР, помимо Huawei HiSilicon с её решениями Ascend, занимаются несколько других крупных игроков, быстро укрепляющих позиции. В их число входят Moore Threads, MetaX и Cambricon. Генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) недавно отметил значительные достижения Китая в плане разработки и производства микросхем, заявив, что страна отстаёт от США на «наносекунды». По его словам, доля NVIDIA на китайском рынке ИИ-ускорителей за последние годы сократилась с 95 % до 50 %. Хуан отмечает, что более половины мировых ИИ-исследователей сосредоточены в Китае, что говорит о большом потенциале страны в соответствующей области. Moore Threads заявляет, что является единственной в Китае компанией, которая в настоящее время серийно производит полнофункциональные GPU. Эта фирма уже представила четыре продуктовых семейства, включая Sudi (2021 год), Chunxiao (2022), Quyuan (2023) и Pinghu (2024). Решения первых двух серий применяются в настольных системах и рабочих станциях, двух других — в составе ИИ-платформ. Отмечается, что основатель и генеральный директор Moore Threads Джеймс Чжан Цзяньчжун (James Zhang Jianzhong) в течение 14 лет работал в NVIDIA, в частности, занимал должность вице-президента и генерального менеджера этой компании по операциям в Китае. В MetaX трудятся выходцы из AMD. Так, основатель MetaX Чэнь Вэйлян (Chen Weiliang) с 2007 года работал в качестве старшего директора в шанхайском представительстве AMD, откуда ушел в 2020-м. Технические директора MetaX Пэн Ли (Peng Li) и Ян Цзянь (Yang Jian) также имеют опыт работы в AMD. Компания MetaX предлагает ускорители для обучения ИИ-моделей и инференса, а также GPU-серверы. В 2024 году на эти продукты пришлось соответственно 68,99 % и 28,29 % от общей выручки компании. Однако, ни MetaX, ни Moore Threads пока не вышли на уровень прибыльности. В свою очередь, фирма Cambricon, основанная в 2016 году братьями Чэнь Юньцзи (Chen Yunji) и Чэнь Тяньши (Chen Tianshi), в I половине 2025 года показала чистую прибыль в размере примерно ¥1 млрд ($140 млн) против ¥530 млн убытков годом ранее. В сентябре Cambricon получила одобрение со стороны регулирующих органов КНР на размещение акций на сумму ¥3,99 млрд (около $559,6 млн). Компания прогнозирует, что её выручка в текущем году увеличится на 317–483 % и составит от ¥5 до ¥7 млрд. Компания проектирует свой флагманский ИИ-ускоритель Siyuan 690, который, как ожидается, по производительности будет сопоставим с NVIDIA H100.

02.10.2025 [10:56], Сергей Карасёв

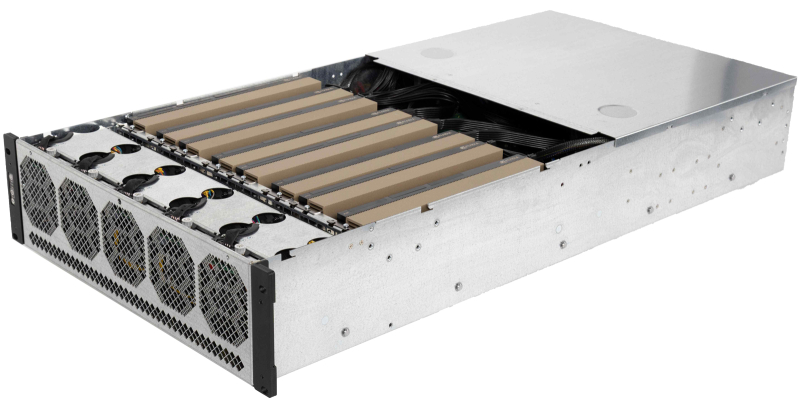

РСК представила внешний JBOG-массив RSC ScaleStream-CГруппа компаний РСК представила на международной конференции «Суперкомпьютерные дни в России», прошедшей в МГУ имени Ломоносова, внешний массив PCIe-коммутации RSC ScaleStream-C (JBOG). Это решение предназначено для установки ускорителей GPU/TPU с целью повышения производительности серверов при работе с различными ресурсоёмкими приложениями, включая задачи ИИ и НРС. Решение RSC ScaleStream-C выполнено в форм-факторе 3U. Допускается установка до десяти карт с интерфейсом PCIe x16 (до 600 Вт), связанных интерконнектом NVLink. При использовании ускорителей на базе GPU применяется гибридное охлаждение, при работе с TPU — воздушное. Питание обеспечивают четыре блока мощностью 2200 Вт каждый. Массив может монтироваться в стандартную 19″ серверную стойку. Задействованы средства управления и мониторинга на базе Redfish, RESTful API, GUI разработки РСК. К системе RSC ScaleStream-C могут быть подсоединены до четырёх серверов посредством внешних кабелей на базе стандарта PCIe 4.0 x16. Ресурсы GPU/TPU могут динамически перераспределяться между подключенными серверами, что, как утверждается, обеспечивает уникальные возможности по созданию оптимальных конфигураций под конкретную нагрузку. Благодаря этому достигается наиболее эффективное использование вычислительных мощностей ИИ-ускорителей, используемых в составе массива. РСК заявляет, что утилизация GPU в некоторых случаях повышается на десятки процентов по сравнению с применением ускорителей в составе традиционных серверных платформах. В целом, RSC ScaleStream-C обеспечивает производительность до 300 ТФлопс (FP64) на массив в случае применения десяти ускорителей NVIDIA H200. При установке карт LinQ HPQ, разработанных российской компании «ХайТэк», быстродействие достигает 960 TOPS на операциях INT8. Среди ключевых сфер применения новинки названы: машинное обучение и ИИ (инференс и работа с большими языковыми моделями), НРС-нагрузки (научные исследования и моделирование), анализ больших данных, виртуализация, криптография и блокчейн (майнинг криптовалют и задачи распределенных реестров).

22.09.2025 [16:44], Сергей Карасёв

OpenYard представила российский GPU-сервер HN203I на базе Intel Xeon 6Российский разработчик и производитель серверного оборудования OpenYard сообщил о создании флагманской системы HN203I на аппаратной платформе Intel Xeon 6. Сервер выполнен в формате 2OU в соответствии со стандартом Open Rack v3.0 (опционально Open Rack v2.2). «HN203I — это технологический скачок для российской серверной индустрии. Мы создаём флагманскую платформу, которая сочетает в себе максимальную производительность, энергоэффективность и простоту эксплуатации», — говорит компания. Возможна установка двух процессоров Intel Xeon 6700E (Sierra Forest-SP) или Xeon 6500P/6700P (Granite Rapids-SP) с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 с поддержкой изделий RDIMM ёмкостью до 128 Гбайт и 3DS RDIMM ёмкостью до 256 Гбайт. Таким образом, максимальный объём ОЗУ составляет 8 Тбайт. В оснащение входят восемь слотов PCIe 5.0 x16 MCIO и три слота PCIe 5.0 x4 MCIO, разъём OCP 3.0 (PCIe 5.0 x16), два коннектора M.2 M-Key (PCIe 5.0 x2 и PCIe 5.0 x4), а также разъём M.2 Key E (PCIe 5.0 x1). Допускается монтаж десяти SFF-накопителей (NVMe) с возможностью горячей замены и четырёх LFF-устройств с интерфейсом SATA/SAS. Кроме того, могут быть установлены до четырёх PCIe-ускорителей NVIDIA H100/L40/L40S/L4. Модель HN203I располагает контролером ASPEED AST2600, двумя сетевыми портами управления RJ45 (по одному спереди и сзади), двумя портами USB 3.0 Type-A, интерфейсом mini-DP. Применено воздушное охлаждение, а диапазон рабочих температур простирается от +10 до +40 °C. Максимальная мощность блоков питания — 5500 Вт. Габариты составляют 537 × 801,6 × 93 мм. Управление осуществляется через BIOS OpenYard и систему OYBMC. Сервер подходит для ИИ-нагрузок, облачных сервисов, телеком-задач и гиперскейл-инфраструктуры. |

|