Материалы по тегу: epyc

|

02.02.2026 [11:02], Сергей Карасёв

Giga Computing выпустила вычислительные узлы TO25-ZU4 и TO25-ZU5 на базе AMD EPYC TurinКомпания Giga Computing, подразделение Gigabyte, анонсировала серверные узлы TO25-ZU4 и TO25-ZU5 стандарта OCP ORV3, ориентированные на гиперскейлеров и облачных провайдеров. Решения формата 2OU (двухузловая конфигурация) выполнены на аппаратной платформе AMD. Устройства получили системную плату MZU3-MG0. Допускается установка одного процессора EPYC 9005 Turin или EPYC 9004 Genoa с показателем TDP до 500 Вт (до 192 вычислительных ядер). Доступны 12 слотов для модулей оперативной памяти DDR5-6400/4800. В оснащение входят контроллер ASPEED AST2600, двухпортовый сетевой адаптер 10GbE (Intel X710-AT2) и выделенный сетевой порт управления 1GbE. Модель TO25-ZU4 поддерживает два накопителя типоразмера E1.S (PCIe 5.0; NVMe) толщиной 9,5 мм и четыре SFF-накопителя (NVMe/SATA/SAS-4). Кроме того, есть по два слота для карт FHFL (PCIe 5.0 x16) и OCP NIC 3.0 (PCIe 5.0 x16). В свою очередь, модификация TO25-ZU5 оборудована посадочными местами для двух накопителей E1.S (PCIe 5.0; NVMe) и восьми изделий SFF (NVMe/SATA/SAS-4). При этом доступны два разъёма PCIe 5.0 x16 для низкопрофильных карт расширения.

Источник изображений: Giga Computing Во фронтальной части обоих узлов расположены интерфейсы USB 3.0 Type-C, Micro-USB и Mini-DP, а также три гнезда RJ45 для сетевых кабелей. Диапазон рабочих температур простирается от +10 до +30 °C. За безопасность отвечает опциональный модуль TPM 2.0. При необходимости может быть также добавлен RAID-адаптер. Габариты решений составляют 258 × 86 × 771 мм.

27.01.2026 [17:10], Владимир Мироненко

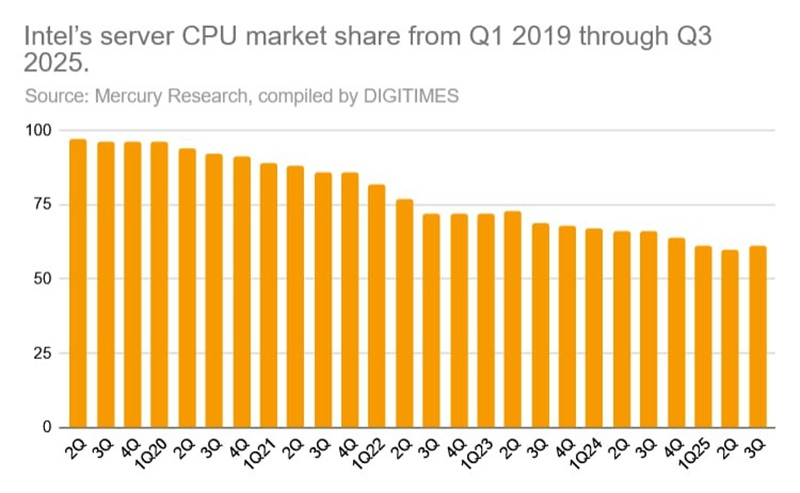

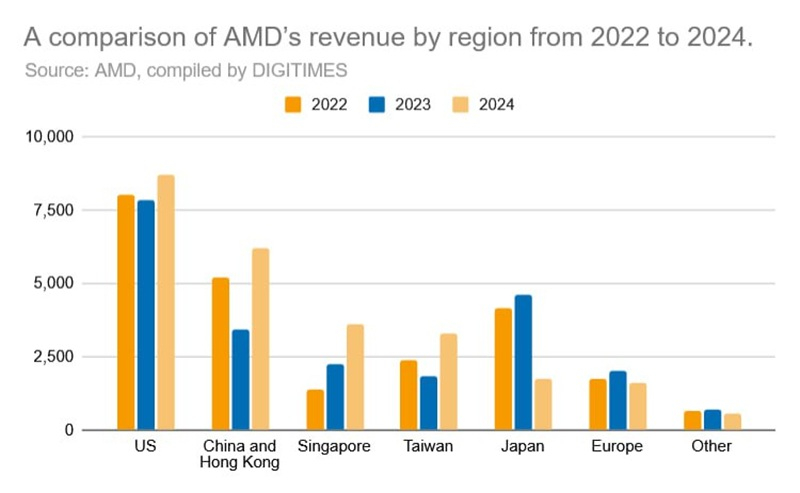

Дисциплина и чиплеты: Лиза Су раскрыла секрет успеха AMD на рынке серверных процессоровС момента внедрения архитектуры Zen в 2017 году компания AMD совершила впечатляющий рывок на рынке CPU, бросив вызов своему давнему конкуренту Intel, сообщила генеральный директор AMD Лиза Су (Lisa Su) в интервью в подкасте A Bit Personal, передаёт DigiTimes. Су подчеркнула трансформацию компании, отметив, что бизнес AMD в сфере решений для ЦОД, находившийся «на грани краха», теперь оказывает конкуренцию Intel на рынке серверных процессоров. Доля рынка AMD EPYC неуклонно растёт, увеличившись с 1 % до примерно 40 % на текущий момент. Слова Су подтверждаются данными Mercury Research, согласно которым за последние семь лет доля Intel на рынках процессоров для клиентских и серверных компьютеров снизилась, достигнув исторически низких показателей, в то время как рыночная доля AMD стабильно росла каждый квартал. Это значительно затруднило Intel поддержание общего доминирования, даже несмотря на сохранение лидерства в абсолютном выражении. По состоянию на III квартал 2025 года, по поставкам серверных процессоров Intel занимала 72 % рынка, но по выручке — всего 61 %, что значительно меньше по сравнению с долей рынка в 97 % в 2019 году. Когда Лиза Су возглавила AMD в 2014 году, отраслевые наблюдатели сомневались в том, что бывшему руководителю подразделения полупроводников IBM удастся вывести компанию из кризиса в условиях острой конкуренции. Однако Су рассматривала эту должность как личную и профессиональную веху — возможность для полной самореализации в полупроводниковой индустрии. Под руководством Су компания AMD совершила практически безупречный разворот, стратегически позиционируя себя для эры генеративного ИИ, отметил ресурс DigiTimes.

Источник изображения: DigiTimes В то время как NVIDIA остаётся главным игроком в сфере ИИ, AMD извлекла выгоду из экспоненциального роста на мировом ИИ-рынке, подкреплённого тесным сотрудничеством с TSMC. Сама Су была избрана в конце 2025 года председателем совета директоров Ассоциации полупроводниковой промышленности (SIA), что отражает признание её авторитета и растущее влияние в отрасли. Су объяснила успех AMD тремя ключевыми стратегическими решениями, поддержанными техническим директором Марком Пейпермастером (Mark Papermaster), который присоединился к компании тремя месяцами ранее. Первое касалось демонтажа существующей линейки продуктов для ЦОД. По словам Су, одним из самых сложных моментов в начале её работы было признать то, что планы AMD по развитию серверного сегмента больше не конкурентоспособны. Продолжение движения по этому пути только ускорило бы потерю компанией доли рынка. В конечном итоге было решено начать всё с «чистого листа». Вторым поворотным моментом стал смелый технологический сдвиг, отметила Су. Её команда отказалась от традиционного подхода к созданию всё более крупных монолитных процессоров в пользу чиплетной архитектуры в сочетании с передовой упаковкой. Это новаторское на тот момент решение несло значительный риск, когда парадигма проектирования Intel доминировала на рынке. Оглядываясь назад, можно сказать, что эта ставка AMD оправдалась. Intel в конечном итоге последовала её примеру, внедрив чиплетную архитектуру и передав часть производства на аутсорсинг TSMC, что позволило ей решить проблемы с выходом годных изделий.

Источник изображения: DigiTimes Третье стратегически важное решение касалось выбора партнёра по производству микросхем. Вместо GlobalFoundries, которая в конечном итоге отказалась от планов по использованию техпроцессов тоньше 7 нм, AMD обратилась к TSMC, хотя у неё в 2017–2019 гг. был ограниченный опыт работы с высокопроизводительными x86-процессорами, несмотря на лидерство в передовых технологических процессах. Тем не менее, использование передовых техпроцессов TSMC сыграло решающую роль, и AMD стала одним из ведущих клиентов компании. По мере роста спроса на чипы для ИИ-технологий ожидается дальнейшее увеличение объёмов производства AMD. Как отметила Су, эти решения демонстрируют сочетание стратегического видения, технической смелости и дисциплины в реализации выбранного пути, которые позволили AMD выйти из почти полной безвестности и стать одним из ключевых игроков на мировом рынке полупроводников и ИИ.

13.01.2026 [09:03], Руслан Авдеев

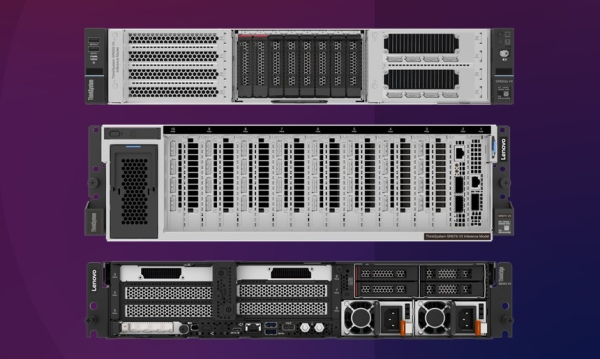

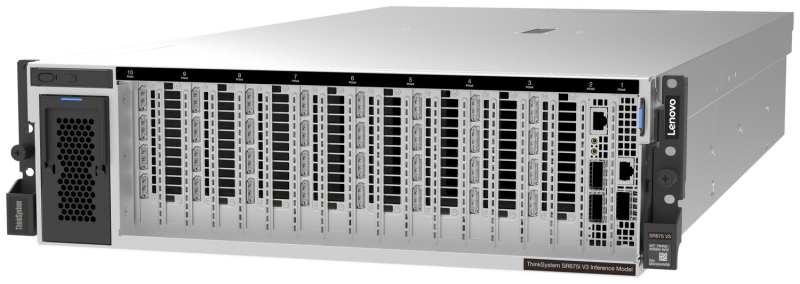

Lenovo представила серверы для ИИ-инференса: ThinkSystem SR675i V3/SR650i V4 и ThinkEdge ThinkEdge SE455i V4Lenovo представила новые серверные системы серии Lenovo Hybrid AI Advantage, оптимизированные для ИИ-инференса: ThinkSystem SR675i V3, ThinkSystem SR650i V4 и ThinkEdge SE455i V4. Если ранее акцент делался на решениях для обучения всё более производительных ИИ-моделей, то теперь бизнес обращает всё больше внимания на продукты для инференса. Новинки предлагаются параллельно с ПО для оптимизации инференса — для унификации и получения данных из разных источников для использования ИИ-моделями. Флагманской версией серии является ThinkSystem SR675i V3 в исполнении 3U на платформе AMD EPYC Turin 9535 (64C/128T, 2,4 ГГц, TDP 300 Вт). Сервер получил 1,5 Тбайт DDR5-6400 (24 × 64 Гбайт). За хранение данных отвечают до двух E3.S NVMe SSD по 3,84 Тбайт (PCIe 5.0 x4) и до двух M.2 NVMe SSD по 960 Гбайт (PCIe 4.0 x4). Возможна установка восьми ускорителей NVIDIA RTX PRO 6000 Blackwell Server Edition, а также пяти DPU NVIDIA BlueField-3 (4 × 400G, 1 × 200G). IPMI в данной модели не доступен. Для карт расширения доступно до шести слотов PCIe 5.0 х16 и один слот OCP 3.0 x8/x16. За питание отвечают четыре блока Titanium второго поколения (по 2300 Вт), а за охлаждение — пять вентиляторов. ThinkSystem SR650i V4 позиционируется в качестве системы для инференса и корпоративных рабочих нагрузок. Этот 2U-сервер получил два Intel Xeon Granite Rapids-SP 6530P (32C/64T, 2,3 ГГц, TDP 225 Вт), 512 Гбайт DDR5-6400 (8 × 64 Гбайт), два ускорителя RTX PRO 6000 Blackwell Server Edition. За хранение отвечают два 3,84-Тбайт U.2 NVMe SSD (PCIe 5.0 x4), хотя всего таких слотов восемь, а также RAID1-массив из пары 960-Гбайт M.2 SATA SSD. Всего доступно шесть слотов расширения PCIe 5.0 x16 и два слота OCP 3.0 x8/x16. Имеется двухпортовый 25GbE-адаптер Broadcom 57414 (SFP28). За питание отвечают два Titanium-блока мощностью 2700 Вт каждый, а за охлаждение шесть вентиляторов, но есть и опция установки фирменной СЖО Neptune. Наконец, Lenovo ThinkEdge SE455i V3 (2U) глубиной всего 440 мм представляет собой компактную модель, предназначенную для периферийного инференса — в ретейле, телекоммуникациях и промышленности. Сервер имеет защищённую конструкцию и может работать при температурах от -5 до +40 °C. Сервер построен на базе одного процессора AMD EPYC Embedded 8534P (64C/128T, 2,3 ГГц, TDP 200 Вт), дополненного 576 Гбайт DDR5-4800 (6 × 96 Гбайт) и двумя ускорителями NVIDIA L4 24 Гбайт (PCIe 4.0 x16). В комплекте идёт один 3,84-Тбайт NVMe SSD и один 960-Гбайт SATA SSD. Имеется два блока питания Platinum второго поколения с возможностью горячей замены. Для карт расширения есть до двух слотов PCIe 5.0 x16 и до четырёх слотов PCIe 4.0 x8, а также один слот OCP 3.0 (PCIe 5.0 x16). Установлен двухпортовый OCP-адаптер Broadcom 57416 (10GbE). IPMI отключён. Фактически компания предлагает готовые конфигурации, которые можно переконфигурировать лишь слегка, чаще всего добавив накопители и/или сетевые адаптеры. Платформы будут доступны в рамках подписки TruScale. Также компания анонсировала новые сервисы Hybrid AI Factory Services, в том числе консультации по инференсу, которые помогают развёртывать оборудование и управлять им для оптимизации ИИ-производительности.

08.01.2026 [13:35], Руслан Авдеев

«Дата-центр в чемодане»: Odinn представила переносной нано-ЦОД Omnia с четырьмя NVIDIA H200Громоздкость оборудования для дата-центров не позволяет легко переносить его с места на место, но у стартапа Odinn своё видение этой проблемы. Компания представила на днях своеобразный «нано-ЦОД» с четырьмя ИИ-ускорителями NVIDIA H200 (NVL), сообщает The Register. По данным компании, 35-кг платформа Odinn Omnia помимом ускорителей включает до двух CPU AMD EPYC 9965 (Turin), до 6 Тбайт DDR5 ECC, 1 Пбайт NVMe SSD, 400GbE-адаптер, встроенный 23,8″ 4K-дисплей и откидную клавиатуру. Шасси снабжено рукоятками для переноски. Фактически речь идёт об устройстве размером с чемодан, хотя Omnia не позиционируется как портативный ПК или даже мобильная рабочая станция. «Чемоданный» ЦОД предлагается в нескольких конфигурациях, включая AI, Creator, Search и X. Использовать их можно для критически важных периферийных вычислений, военных миссий, симуляций корпоративного уровня, работы с киноматериалами буквально в любой локации. Кроме того, Omnia могут использоваться как модули для создания более масштабных структур, объединённых в кластеры Infinity Racks.

Источник изображения: Odinn Конечно, всё это обойдётся недёшево — один NVIDIA H200 стоит около $32 тыс. Можно предположить, что немногие компании позволят сотрудникам разгуливать с такими дорогими «чемоданами», которые довольно легко похитить. Впрочем, Odinn пока ничего не сообщает о цене устройств. Внешне, со встроенным дисплеем и откидной клавиатурой, Omnia отчасти напоминает портативные ПК далёкого прошлого. Если же встроенные дисплей и клавиатура не нужны, то есть решения попроще и в буквально смысле полегче. Так, 25-кг модульная платформа GigaIO Gryf объединяет в одном шасси-чемодане до пяти узлов различной конфигурации (плюс один обязательный модуль питания), в том числе с H200 NVL. Gryf тоже можно объединять в мини-кластеры.

05.12.2025 [13:41], Сергей Карасёв

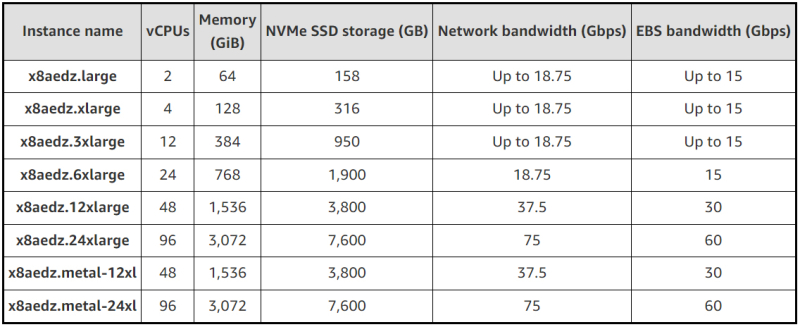

Пять облачных гигагерц: AWS запустила инстансы EC2 X8aedz на базе AMD EPYC Turin для требовательных к памяти нагрузокОблачная платформа AWS анонсировала инстансы EC2 X8aedz, оптимизированные для нагрузок, которым требуется большой объём памяти. Это могут быть задачи, связанные с автоматизацией проектирования электроники (EDA), реляционные базы данных и пр. В основу инстансов положены процессоры AMD EPYC Turin, тактовая частота которых достигает 5 ГГц: утверждается, что это самый высокий показатель в облаке AWS. Новые экземпляры обеспечивают до двух раз более высокую вычислительную производительность по сравнению с инстансами EC2 X2iezn предыдущего поколения. В случае EC2 X8aedz количество vCPU варьируется от 2 до 96, а объём оперативной памяти — от 64 до 3072 ГиБ. Инстансы предлагают локальное NVMe-хранилище ёмкостью от 158 до 7600 Гбайт. Пропускная способность сетевого подключения составляет от 18,75 до 75 Гбит/с, пропускная способность EBS — от 15 до 60 Гбит/с. Задействованы карты AWS Nitro шестого поколения, которые отвечают за виртуализацию, разгрузку сетевых функций и функций хранения. В обозначении X8aedz, как отмечает Amazon, суффикс «a» указывает на аппаратную платформу AMD, «e» — на расширенную память, «d» — на локальные NVMe SSD, физически подключённые к хост-серверу, а «z» — на высокую частоту процессоров. Соотношение памяти к виртуальным CPU у всех новых экземпляров составляет 32:1. Инстансы Amazon EC2 X8aedz уже доступны в регионах US West (Орегон) и Asia Pacific (Токио). В дальнейшем география охвата будет расширяться. Заказчики могут выбирать между различными конфигурациями, включая два варианта Bare Metal.

03.12.2025 [20:51], Владимир Мироненко

HPE одной из первых начнёт выпускать интегрированные стоечные ИИ-платформы AMD Helios AI

amd

broadcom

epyc

hardware

hpc

hpe

instinct

juniper networks

mi400

ocp

ualink

venice

германия

ии

суперкомпьютер

AMD объявила о расширении сотрудничества с HPE, в рамках которого HPE станет одним из первых поставщиков стоечных систем AMD Helios AI, которые получат коммутаторы Juniper Networking (компания с недавних пор принадлежит HPE), разработанные совместно с Broadcom, и ПО для бесперебойного высокоскоростного подключения по Ethernet. AMD Helios AI — открытая полнофункциональная ИИ-платформа на базе архитектуры OCP Open Rack Wide (ORW), разработанная для крупномасштабных рабочих нагрузок и обеспечивающая FP4-производительность до 2,9 Эфлопс на стойку благодаря ускорителям AMD Instinct MI455X, процессорам EPYC Venice шестого поколения и DPU Pensando Vulcano, работающими под управлением открытой программной экосистемы ROCm для нагрузок ИИ и HPC. Как отметил The Register, сетевая архитектура этой системы будет представлять собой масштабируемую реализацию UALink over Ethernet (UALoE) и специализированным коммутатором Juniper Networks на базе сетевого чипа Broadcom Tomahawk 6 (102,4 Тбит/с). Система разработана для упрощения развёртывания крупномасштабных ИИ-кластеров, что позволяет сократить время разработки решений и повысить гибкость инфраструктуры. В отличие от NVIDIA, AMD не выпускает коммутаторы, предлагая открытую экосистему, так что HPE и другие компании могут интегрировать собственные сетевые решения. The Register полагает, что HPE и Broadcom решили не гнаться за отдельной аппаратной реализацией UALink, если данные можно передавать поверх Ethernet. «Это первое в отрасли масштабируемое решение, использующее Ethernet, стандартный Ethernet. Это означает, что оно полностью соответствует открытому стандарту и позволяет избежать привязки к проприетарному поставщику, использует проверенную сетевую технологию HPE Juniper для обеспечения масштабируемости и оптимальной производительности для рабочих нагрузок ИИ», — заявила HPE. HPE заявила, что это позволит её стоечной системе поддерживать трафик, необходимый для обучения модели с триллионами параметров, а также обеспечить высокую пропускную способность инференса. Стоечная система HPE будет включать 72 ускорителя AMD Instinct MI455X с 31 Тбайт HBM4 с агрегиированной пропускной способностью 1,4 Пбайт/с. Агрегированная скорость интерконнекта составит 260 Тбайт/с. Новинка будет доступна в 2026 году. AMD также сообщила, что Herder, новый суперкомпьютер для Центра высокопроизводительных вычислений в Штутгарте (HLRS) (Германия), получит Instinct MI430X и EPYC Venice. Он будет построена на платформе HPE Cray Supercomputing GX5000. Поставка Herder запланирована на II половину 2027 года, а ввод в эксплуатацию — к концу 2027 года. Herder заменит используемый центром суперкомпьютер Hunter.

02.12.2025 [11:28], Сергей Карасёв

MiTAC выпустила двухузловой сервер M2810Z5 на базе AMD EPYC TurinКомпания MiTAC анонсировала 2U2N-сервер M2810Z5, ориентированный на современные дата-центры и облачные платформы. Новинка может использоваться для решения таких задач, как CDN, виртуализация, хостинг, ресурсоёмкие вычисления на базе CPU и поддержка приложений с интенсивным обменом данными. Устройство, выполненное в форм-факторе 2U, имеет двухузловую конструкцию. Каждый узел допускает установку одного процессора AMD EPYC 9005 Turin в исполнении Socket SP5 с показателем TDP до 500 Вт и 12 модулей DDR5-5600/6000/6400 RDIMM или RDIMM-3DS суммарным объёмом до 3 Тбайт. Доступен один слот OCP 3.0 (PCIe 5.0 x16). Каждый из узлов располагает четырьмя отсеками для накопителей формата E1.S (NVMe) с поддержкой горячей замены. MiTAC говорит о возможности установки SSD семейства Kioxia XD8 с интерфейсом PCIe 5.0. Эти изделия обеспечивают скорость чтения информации до 12,5 Гбайт/с и скорость записи до 5,8 Гбайт/с. Вместимость достигает 7,68 Тбайт. Кроме того, есть два коннектора M.2 (в расчёте на узел) для SSD типоразмера 22110/2280 с интерфейсом PCIe 4.0. Узлы наделены контроллером Aspeed AST2600, сетевым портом 1GbE на базе Intel I210-AT, выделенным сетевым портом управления 1GbE (Realtek RTL8211FD-CG), аналоговым разъёмом D-Sub, а также двумя портами USB 2.0. Сервер M2810Z5 оборудован двумя блоками питания с резервированием мощностью 2000 Вт (80 Plus Titanium). Опционально может быть установлен модуль TPM. Применяется воздушное охлаждение с четырьмя вентиляторами диаметром 80 мм с возможностью горячей замены. Диапазон рабочих температур — от +10 до +35 °C. Габариты системы составляют 760 × 448 × 86 мм.

01.12.2025 [12:28], Сергей Карасёв

MiTAC представила ИИ-сервер G4826Z5 с ускорителями AMD Instinct MI355X и СЖОКомпания MiTAC анонсировала высокопроизводительный GPU-сервер G4826Z5 на аппаратной платформе AMD, предназначенный для ресурсоёмких задач ИИ и НРС. Кроме того, представлены стойки и вычислительные кластеры на его основе. Сервер G4826Z5U2BC-355X-755 выполнен в форм-факторе 4U. Нижняя 2U-секция содержит два процессора AMD EPYC 9005 Turin и 24 слота для модулей оперативной памяти DDR5-6400. Во фронтальной части расположены восемь отсеков для SFF-накопителей; кроме того, есть два внутренних коннектора M.2 для SSD (NVMe). Верхний 2U-модуль несёт на борту восемь ускорителей AMD Instinct MI355X, оборудованных 288 Гбайт памяти HBM3E с пропускной способностью до 8 Тбайт/с. Машина G4826Z5 получила систему жидкостного охлаждения, которая охватывает CPU- и GPU-секции. Предусмотрена функция обнаружения утечек. Подсистема питания с резервированием выполнена по схеме: 1+1 мощностью 3200 Вт и 3+3 мощностью 15 600 Вт. Все блоки питания имеют сертификат 80 Plus Titanium и допускают горячую замену. На основе G4826Z5 формируется стоечная система (MR1100L-64355X-01): она содержит восемь GPU-серверов, что в сумме даёт 64 ускорителя и 18,4 Тбайт памяти HBM3E. Стойка также укомплектована коммутаторами 400GbE на 64 и 32 порта, двумя коммутаторами 1GbE на 48 портов, сервером управления B8056G68CE12HR-2T-TU, сервером хранения B8056T70AE26HR-2T-HE-TU и блоком распределения охлаждающей жидкости (CDU) в формате 4U. В свою очередь, стойки объединяются в кластеры из четырёх и восьми штук. Это в сумме обеспечивает 32 и 64 сервера GPU и 256 и 512 ускорителей Instinct MI355X соответственно. Таким образом, максимальная конфигурация включает приблизительно 147 Тбайт памяти HBM3E.

29.11.2025 [14:58], Сергей Карасёв

MGX-сервер MSI CG480-S6053 получил чипы AMD EPYC Turin и восемь слотов PCIe 5.0 x16 для FHFL-карт двойной шириныКомпания MSI анонсировала сервер CG480-S6053, предназначенный для ресурсоёмких задач ИИ и НРС. Устройство выполнено в форм-факторе 4U на архитектуре NVIDIA MGX. Возможна установка двух процессоров AMD EPYC 9005 Turin в исполнении Socket SP5 с показателем TDP до 500 Вт. Доступны 24 слота для модулей оперативной памяти DDR5-6400 RDIMM/RIMM-3DS суммарным объёмом до 6 Тбайт (в конфигурации 24 × 256 Гбайт). Во фронтальной части расположены восемь отсеков для SFF-накопителей U.2 с интерфейсом PCIe 5.0 x4 (NVMe); допускается горячая замена. Есть два внутренних коннектор М.2 для SSD типоразмера 2280/22110 с интерфейсом PCIe 3.0 x2 (NVMe). Сервер оснащён восемью слотами PCIe 5.0 x16 для карт FHFL двойной ширины. Могут устанавливаться, в частности, ИИ-ускорители NVIDIA H200 NVL и RTX Pro 6000 Blackwell Server Edition. Кроме того, есть пять слотов PCIe 5.0 x16 для карт FHFL одинарной ширины. Сервер располагает контроллером ASPEED AST2600, двумя сетевыми портами 10GbE (RJ45) на основе Intel X710-AT2, выделенным сетевым портом управления 1GbE, разъёмами USB 3.0/2.0 Type-A и Mini-DisplayPort. Модификация системы с обозначением CG481-S6053 получила восемь портом 400GbE на базе NVIDIA ConnectX-8 SuperNIC. Предусмотрен модуль TPM 2.0. Новинка имеет размеры 438,5 × 175 × 800 мм. Питание обеспечивают четыре блока с резервированием мощностью 3200 Вт (80 PLUS Titanium). Применено воздушное охлаждение с десятью системными вентиляторами диаметром 80 мм с возможностью горячей замены. Диапазон рабочих температур — от +10 до +35 °C.

26.11.2025 [12:50], Сергей Карасёв

Сервер Giga Computing G4L3-ZX1 с поддержкой AMD EPYC 9005 Turin и Instinct MI355X оснащён СЖОКомпания Giga Computing, подразделение Gigabyte, анонсировала сервер G4L3-ZX1-LAT4, предназначенный для задачи ИИ и НРС. Эта мощная машина на аппаратной платформе AMD оснащена системой прямого жидкостного охлаждения (DLC), отводящей тепло и от CPU, и от GPU. Сервер выполнен в форм-факторе 4U. Он может нести на борту два процессора EPYC 9004 Genoa или EPYC 9005 Turin (до 192 вычислительных ядер) в исполнении Socket SP5 с показателем TDP до 500 Вт. Доступны 24 слота для модулей оперативной памяти DDR5-6400. Во фронтальной части находятся восемь отсеков для SFF-накопителей NVMe; кроме того, есть два внутренних коннектора M.2 2280/22110 для SSD с интерфейсом PCIe 3.0 x4 и x1. Новинка располагает восемью ускорителями AMD Instinct MI355X OAM. Предусмотрены восемь разъёмов для однослотовых карт FHHL с интерфейсом PCIe 5.0 x16 и четыре разъёма для двухслотовых карт FHHL (также PCIe 5.0 x16). Питание обеспечивают шесть блоков с резервирование мощностью 5200 Вт (сертификат 80 PLUS Titanium). Помимо СЖО, задействован ряд системных вентиляторов: 4 × 60 мм в зоне материнской платы, 4 × 80 мм в области слотов PCIe и 4 × 60 мм в лотке GPU. Диапазон рабочих температур — от +10 до +30 °C.

Источник изображения: Giga Computing Сервер оснащён двумя сетевыми портами 10GbE на основе адаптера Intel X710-AT2, выделенными сетевыми портами 1GbE во фронтальной и тыльной частях, контроллером Aspeed AST2600, двумя портами USB 3.2 Gen1 Type-A и аналоговым разъёмом D-Sub. Опционально может быть добавлен модуль TPM 2.0. Габариты сервера составляют 447 × 175,5 × 901 мм. |

|