Материалы по тегу: b200

|

27.01.2026 [12:53], Сергей Карасёв

Giga Computing представила ИИ-сервер на базе NVIDIA GB200 NVL4 с СЖОКомпания Giga Computing, подразделение Gigabyte Group, пополнила ассортимент серверов моделью XN24-VC0-LA61, ориентированной на ИИ-задачи и другие ресурсоёмкие нагрузки. Устройство выполнено в форм-факторе 2U на аппаратной платформе NVIDIA GB200 NVL4. В общей сложности задействованы четыре GPU поколения Blackwell со 186 Гбайт памяти HBM3E каждый (пропускная способность до 8 Тбайт/с) и два CPU Grace с 480 Гбайт памяти LPDDR5X (пропускная способность до 512 Гбайт/с). Применяется GPU — GPU интерконнект NVIDIA NVLink и CPU — GPU интерконнект NVIDIA NVLink-C2C. Реализована система прямого жидкостного охлаждения. Доступны четыре сетевых порта OSFP InfiniBand XDR на 800 Гбит/с или два порта Ethernet на 400 Гбит/с на базе NVIDIA ConnectX-8 SuperNIC. Кроме того, имеется порт 1GbE на основе Intel I210-AT и выделенный сетевой порт управления 1GbE. В оснащение входит контроллер ASPEED AST2600. Во фронтальной части расположены восемь посадочных мест для SFF-накопителей с интерфейсом PCIe 5.0 (NVMe) с жидкостным охлаждением. Опционально может быть установлен DPU NVIDIA BlueField-3. Есть внутренний разъём для SSD типоразмера M.2 2242/2260/2280/22110 с интерфейсом PCIe 5.0 x4, слот PCIe 5.0 х16 для карты FHHL с СЖО и ещё один разъём PCIe 5.0 х16 FHHL. Предусмотерны коннекторы USB 3.2 Gen1 Type-A, Micro-USB, Mini-DP и RJ45. Сервер имеет габариты 438 × 87 × 900 мм и массу 42,8 кг. За питание отвечают четыре блока мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур простирается от +10 до +35 °C.

22.12.2025 [14:36], Руслан Авдеев

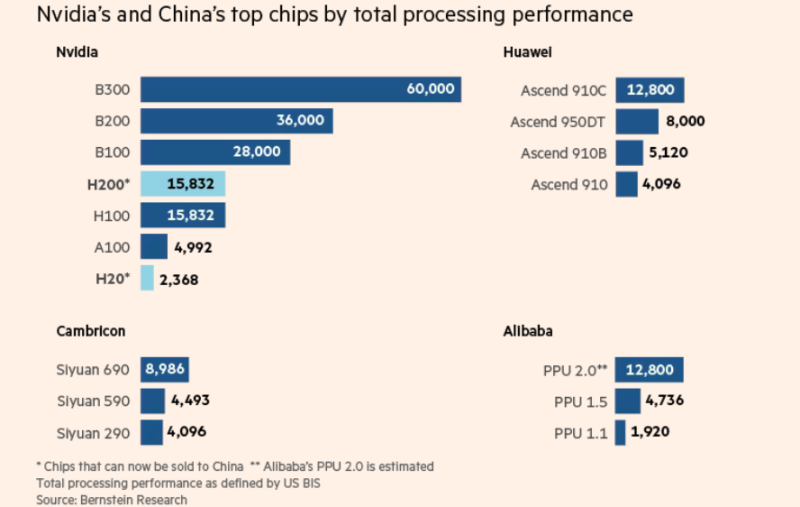

Японское неооблако Datasection предоставит китайской Tencent десятки тысяч подсанкционных чипов NVIDIA B200/B300Хотя некоторые международные игроки стремятся ограничить доступ Китая к передовым американским чипам, в дата-центре близ Осаки (Япония) современные ИИ-ускорители используются единственным клиентом — китайской Tencent, сообщает The Financial Times. Чипы NVIDIA B200 принадлежат японской Datasection, недавно переключившейся с маркетинговых решений на управление ИИ ЦОД. С тех пор компания заключила соглашение с клиентом на сумму $1 млрд, а тот получил доступ к значительной части из 15 тыс. ИИ-ускорителей NVIDIA Blackwell. По словам источников издания, этим клиентом и является Tencent. Сделка позволяет китайскому техногиганту использовать довольно сложную, но вполне легальную стратегию для доступа к передовым ИИ-чипам на фоне санкций США. В результате сделки Datasection превратилась в одну из крупнейших «неооблачных» компаний в Азии. По словам представителя компании, менее полугода назад для обеспечения работы ИИ-моделей было достаточно 5 тыс. чипов B200, а теперь требуется минимум 10 тыс. Правила, которые вводили при прошлом президенте США, должны были закрыть юридическую лазейку, позволяющую китайским компаниями получать доступ к передовым ИИ-ускорителями в ЦОД и облаках за пределами КНР, но в мае новый президент отменил их. Теперь же одобрена поставка в Китай чипов NVIDIA H200, поэтому компании вроде Tencent, возможно, снова смогут строить собственные ИИ ЦОД на более современных ускорителях. Однако по словам Bernstein Research, использование зарубежных облаков вместо покупки чипов может оказаться для китайских технологических групп даже более привлекательным вариантом.

Источник изображения: The Financial Times Datasection намерена создать ИИ ЦОД с более 100 тыс. ускорителей NVIDIA. По некоторым данным, первые 15 тыс. чипов в основном зарезервированы для Tencent на три года. Впрочем, в самой Datasection вероятную сделку не комментируют, упоминая лишь о «крупном клиенте». По данным The Financial Times, в июле Datasection заключила контракт с «одним из крупнейших в мире поставщиков облачных услугу» на $406 млн, согласившись заплатить $272 млн за 5 тыс. B200 для объекта в Осаке, а уже в августе оборудование прибыло в Японию. Вскоре партнёры заключили ещё одну сделку, на этот раз на $800 млн с расчётом на второй ИИ ЦОД в Сиднее, где будут развёрнуты десятки тысяч B300. В декабре Datasection объявила, что первые 10 тыс. ускорителей B300 для сиднейского дата-центра обойдутся в $521 млн. В компании утверждают, что речь идёт о первом в мире ИИ-кластере гиперскейл-уровня на базе B300. По данным источников, мощности австралийского ЦОД тоже будут использоваться преимущественно Tencent. Контракт с «крупным клиентом» заключён на пять лет, с возможным продлением на два года. По сведениям источников, посредником (для защиты данных) выступает токийская NowNaw. Datasection может расторгнуть соглашения, если США вновь изменят правила работы с КНР.

Источник изображения: Datasection Все участники сделки уверяют, что соблюдают все применимые законы, в том числе относительно использования зарубежных облачных сервисов. По словам Datasection, Министерство торговли Соединённых Штатов и NVIDIA одобрили использование ей ИИ-ускорителей. Кроме того, принимаются меры, чтобы компания не попадала под действие некоторых японских законов, в том числе о валютном контроле. В будущем Datasection рассчитывает выйти на рынок высокодоходных облачных сервисов, в частности, она нацелена на экспансию в Европу. В прошлом году она привлекла в совет директоров испанского и американского политиков. В Datasection уверены, что даже если ограничения США на экспорт ослабят, дав китайскому бизнесу доступ к самым передовым чипам NVIDIA, ей это не помешает. Как считают представители неооблачной компании, спрос на вычислительные мощности так высок, что новых клиентов найти будет несложно. В худшем случае деятельность придётся остановить «скажем, на неделю». В 2025 году акции Datasection выросли почти на 185 %, хотя и успели упасть с лета на фоне опасений по поводу избыточных инвестиций в ИИ и торговых атак на ценные бумаги со стороны участников фондового рынка.

05.12.2025 [17:29], Руслан Авдеев

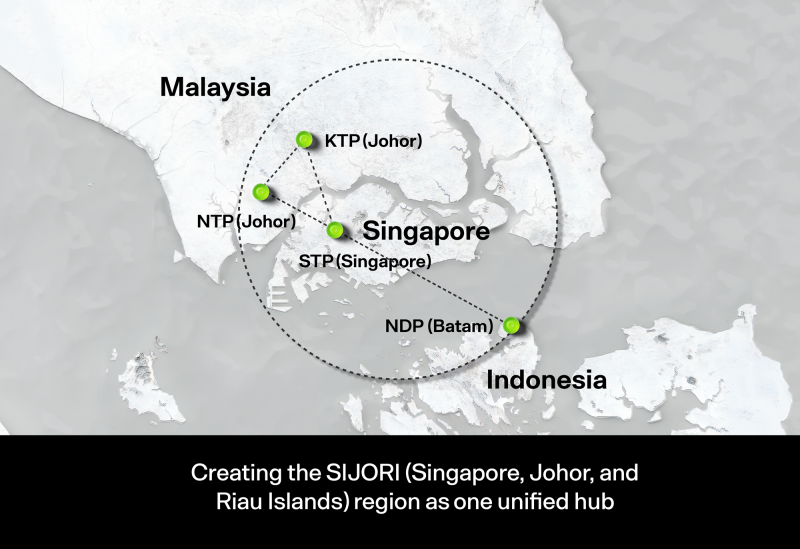

Малайзия стала на шаг ближе к ИИ-суверенитету — запущен 600-МВт дата-центр с суперускорителями NVIDIAМалайзия сделала очередной важный шаг на пути достижения суверенитета в области технологий искусственного интеллекта. В Кулае (Kulai, штат Джохор) введена в эксплуатацию первая очередь дата-центра на основе технологий NVIDIA мощностью 600 МВт, сообщает Converge! Digest. Это позволит существенно снизить зависимость от иностранной ИИ-инфраструктуры. Построенный совместно с NVIDIA и YTL Power International (YTLP) центр находится на территории принадлежащего последней технопарка Green Data Center Park. Объект оснастили ИИ-системами NVIDIA GB200 NVL72 для обучения крупных ИИ-моделей и корпоративного инференса. Запуск последовал за дебютом малайзийской ИИ-модели ILMU — первого национального варианта LLM, разработанного в самой стране. Это свидетельствует о желании малайзийского правительства развивать собственные ИИ-компетенции, а не полагаться исключительно на сторонних поставщиков облачных услуг. При этом под давлением США выбор был сделан в пользу американских, а не китайских технологий.

Источник изображения: Ven Jiun (Greg) Chee/unsplash.com Дата-центр укрепляет долгосрочные амбиции страны по превращению в ведущий ИИ-хаб АСЕАН к 2030 году. Власти подчёркивали стратегическую важность суверенных вычислений в ходе недавних переговоров с главой NVIDIA Дженсеном Хуангом (Jensen Huang). В бюджете на 2026 год выделено RM5,9 млрд (более $1,4 млрд) на расширение ИИ-инфраструктуры, масштабирование внедрения ИИ в промышленности и повышение цифровой конкурентоспособности в производстве, телеком-секторе и сфере услуг. Развитие инфраструктуры соответствует общей динамике развития региона, в т.ч. речь про крупные инвестиции в Джохоре и его окрестностях. В настоящее время регион является одним из самых быстрорастущих хабов ЦОД в Юго-Восточной Азии. Всё новые и новые проекты ЦОД указывают на устойчивый спрос на мощности, близость к IT-экосистеме Сингапура и выгодные условия в области энергетики. Конкуренцию Малайзии пытается составить Индонезия. Малайзия определяет создание суверенных вычислительных мощностей и государственно-частное партнёрство как основные принципы стратегии развития цифровой индустрии. Как считают в Converge! Digest, действия Малайзии отражает аналогичные инвестиции в ИИ-вычисления, основанные на принципах суверенитета, осуществляющиеся в Сингапуре, Индонезии, Южной Корее, Японии и на Ближнем Востоке. Повсеместно страны создают специальные кластеры ускорителей для поддержки ИИ-индустрии. Укрепление партнёрства NVIDIA с поддерживаемыми государствами игроками в области ИИ от Сингапура до Саудовской Аравии отражает и растущий спрос на локализованные мощности и специализированные стоечные архитектуры. По мере развития ИИ-проектов в Джохоре Малайзия становится крупным ИИ-хабом с конкурентоспособными ценами в региональной гонке за развитие инфраструктуры. В августе сообщалось, что во II квартале 2025 года штат Джохор (Малайзия) одобрил 42 проекта строительства ЦОД.

18.11.2025 [10:54], Сергей Карасёв

Начался монтаж крупнейшего в США академического суперкомпьютера Horizon с ИИ-быстродействием до 80 ЭфлопсНациональный научный фонд США (NSF) объявил о начале монтажа вычислительно комплекса Horizon — крупнейшего в стране академического суперкомпьютера. Система расположится в Техасском центре передовых вычислений (TACC) при Техасском университете в Остине (UT Austin). Проект реализуется в сотрудничестве с Dell, NVIDIA, VAST Data, Spectra Logic, Versity и Sabey Data Centers. Суперкомпьютер будет развёрнут в новом дата-центре мощностью 15–20 МВт с передовым жидкостным охлаждением в Раунд-Роке (штат Техас). В основу системы лягут серверы Dell PowerEdge. Говорится об использовании процессоров NVIDIA Vera и суперчипов NVIDIA Grace Blackwell. В общей сложности будут задействованы около 1 млн CPU-ядер и примерно 4 тыс. GPU. Архитектура предусматривает использование интерконнекта NVIDIA Quantum-2 InfiniBand. Вместимость локального хранилища данных, выполненного исключительно на основе SSD, составит 400 Пбайт. Оно обеспечит пропускную способность при чтении/записи более 10 Тбайт/с. Заявленная производительность Horizon — 300 Пфлопс: это примерно в 10 раз больше по сравнению с системой Frontera, которая в настоящее время является самым мощным академическим суперкомпьютером в США. При выполнении ИИ-задач новый вычислительный комплекс обеспечит быстродействие до 20 Эфлопс на операциях BF16/FP16 и до 80 Эфлопс в режиме FP4 — более чем 100-кратный прирост по сравнению с нынешними машинами, которые эксплуатируются в американских академических кругах. При этом говорится о повышении энергетической эффективности до шести раз. Запуск Horizon запланирован на весну 2026 года. Суперкомпьютер будет использоваться для решения сложных и ресурсоёмких задач в таких областях, как биомедицина, физика, энергетика, экология и пр. В частности, система будет применяться для моделирования климата.

14.11.2025 [09:38], Сергей Карасёв

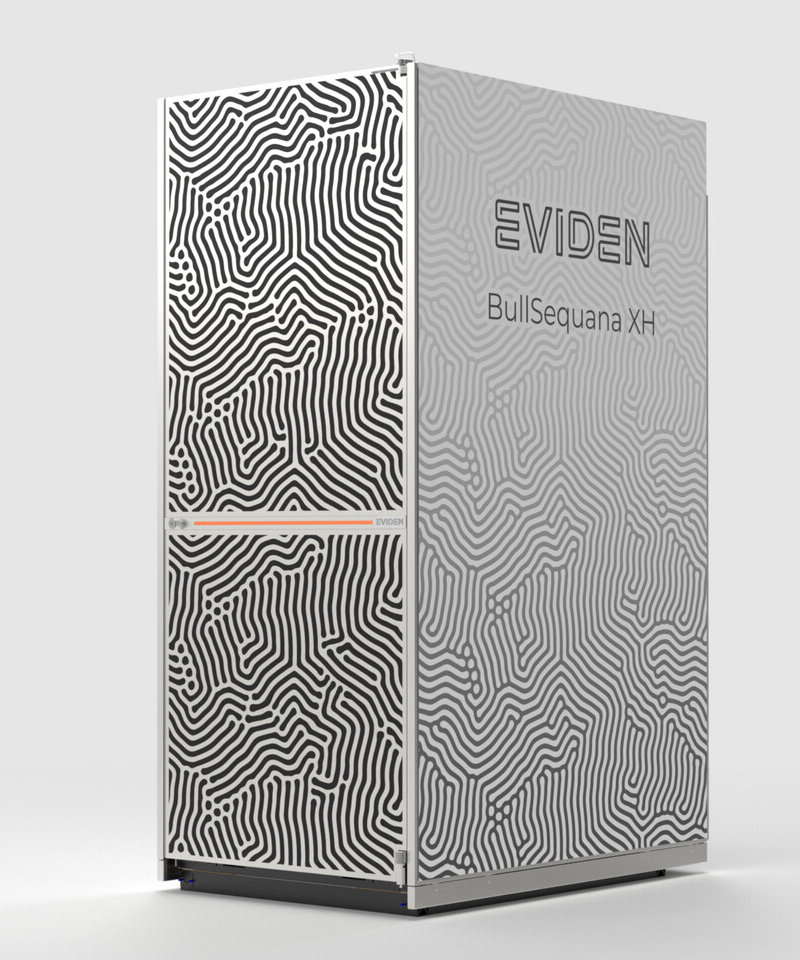

«За пределы экзафлопсного уровня»: Eviden представила суперкомпьютерную платформу BullSequana XH3500Компания Eviden, входящая в Atos Group, анонсировала конвергентную суперкомпьютерную платформу BullSequana XH3500 для ресурсоёмких нагрузок ИИ и HPC. Новинка сочетает передовые аппаратные решения с комплексной экосистемой ПО, обеспечивая возможность масштабирования «за пределы экзафлопсного уровня». BullSequana XH3500 использует открытую модульную конструкцию. Такой подход позволяет свободно комбинировать блоки CPU, GPU и сетевые компоненты от различных производителей, адаптируя конфигурации под определённые потребности. При этом устраняется зависимость от какого-либо конкретного поставщика оборудования, что обеспечивает полную технологическую свободу. По заявлениям Eviden, платформа BullSequana XH3500 по сравнению с системой предыдущего поколения позволяет добиться повышения электрической мощности более чем на 80 % в расчёте на 1 м2 и увеличения эффективности охлаждения на 30 % в расчёт на 1 кВт. Это даёт возможность удовлетворить растущие потребности в вычислительных ресурсах без необходимости расширения площадей в дата-центрах. Габариты стойки BullSequana XH3500 без модуля ультраконденсатора составляют 2270 × 900 × 1457 мм. Мощность AC достигает 284 кВт (с одной помпой). Задействовано на 100 % безвентиляторное прямое жидкостное охлаждение (DLC) пятого поколения с возможностью использования горячей воды с температурой до 40 °C. Подсистемы питания и охлаждения выполнены по схеме с резервированием N+1. Доступны 38 универсальных слотов 1U.

Источник изображения: Eviden Для платформы BullSequana XH3500 разработаны узлы BullSequana XH3515B и BullSequana AI1242. Первый соответствует типоразмеру 1U: это одноузловое изделие оборудовано двумя чипами NVIDIA Grace CPU и четырьмя ускорителями NVIDIA Blackwell B200. Возможна установка до девяти NVMe SSD в форм-факторе E1.S. Говорится о поддержке четырёх сетевых устройств Eviden BXI V3 или InfiniBand NDR/XDR. В свою очередь, сервер BullSequana AI1242 имеет исполнение 2U. Данное решение несёт на борту два процессора AMD EPYC Turin и GPU-ускоритель AMD Instinct MI355X. Реализована поддержка восьми устройств Eviden BXI V3 или InfiniBand NDR/XDR, а также четырёх накопителей E1.S NVMe SSD.

05.11.2025 [10:16], Владимир Мироненко

NVIDIA и Deutsche Telekom строят в Германии ИИ-фабрику стоимостью €1 млрд

b200

deutsche telekom

dgx

hardware

nvidia

omniverse

германия

ии

конфиденциальность

промышленность

цод

NVIDIA и Deutsche Telekom представили первое в мире промышленное ИИ-облако (Industrial AI Cloud) — суверенную корпоративную платформу, запуск которой запланирован на начало 2026 года в рамках совместного проекта стоимостью €1 млрд. Платформа использует передовое оборудование NVIDIA, включая системы DGX B200 и серверы RTX PRO, а также ПО, в том числе NVIDIA AI Enterprise, CUDA-X и Omniverse, полностью интегрированное в облачную и сетевую экосистему Deutsche Telekom. Deutsche Telekom сообщила, что NVIDIA поставит более тысячи систем NVIDIA DGX B200 и серверов NVIDIA RTX PRO с 10 тыс. ускорителей NVIDIA Blackwell. Оборудование уже устанавливается в модернизированном дата-центре в Мюнхене. Объект начнёт работу в I квартале 2026 года, ИИ-производительность его систем составит 500 Пфлопс (точность вычислений не указана). Сообщается, что благодаря запуску этой ИИ-фабрики вычислительная мощность ИИ-решений в Германии увеличится сразу на 50 %. Управление объектом площадью в несколько тысяч квадратных метров будет осуществлять Deutsche Telecom, а компания SAP, занимающаяся разработкой корпоративного программного обеспечения, предоставит свою платформу SAP Business Technology Platform и соответствующие приложения. Европейская компания Polarise, занимающаяся разработкой ЦОД, также будет участвовать в проекте, пишет DataCenter Dynamics. «Благодаря этим вычислительным мощностям Германия станет ведущей в Европе суверенной точкой ИИ-доступа, созданной в рамках исключительно частной инициативы», — отметила Deutsche Telekom. Сообщается, что Industrial AI Cloud — один из первых флагманских проектов инициативы Made for Germany («Сделано для Германии»), в которой участвуют более 100 компаний. Цель инициативы — укрепить позиции Германии как бизнес-площадки и ускорить цифровизацию экономики и управления страны. Компании смогут резервировать вычислительные мощности для разработки промышленных приложений ИИ. Облако также будет обслуживать государственные службы и оборонный сектор, пишет Reuters. Deutsche Telekom сообщила, что среди первых партнёров проекта — Agile Robots, чьи роботы, по слухам, будут использоваться для установки серверных стоек на объекте. Благодаря использованию NVIDIA Omniverse она расширит свои возможности по обучению, тестированию и валидации базовых моделей робототехники для целых парков роботов. Также в числе первых партнёров компания Perplexity, которая будет использовать новый ИИ ЦОД для предоставления услуг ИИ-инференса немецким пользователям и компаниям. Siemens сообщила, что будет использовать облачную платформу для ускорения внедрения промышленного ИИ, в том числе для собственных сервисов и для предложения решений на базе ИИ клиентам и партнёрам. По данным Siemens, такие автопроизводители, как Mercedes-Benz и BMW, будут использовать Industrial AI Cloud для проведения сложных симуляций с использованием цифровых двойников на базе ИИ, что значительно ускорит разработку автомобилей.

04.11.2025 [01:00], Владимир Мироненко

OpenAI потратит $38 млрд на аренду ускорителей NVIDIA у AWS, а AWS за $5,5 млрд арендует мощности у Cipher MiningAWS и OpenAI объявили о многолетнем стратегическом партнёрстве, в рамках которого AWS предоставит OpenAI ИИ-инфраструктуру. В рамках соглашения стоимостью $38 млрд OpenAI на семь лет получает доступ к вычислительным ресурсам AWS, включающим сотни тысяч ускорителей NVIDIA GB200/GB300 NVL72 в составе EC2 UltraServer, с возможностью расширения до десятков миллионов чипов для быстрого масштабирования агентных рабочих нагрузок. Согласно пресс-релизу, OpenAI сразу же начнёт использовать вычислительные ресурсы AWS. На первом этапе сделки будут использоваться существующие дата-центры AWS, а Amazon в конечном итоге развернёт дополнительную инфраструктуру для OpenAI. Развёртывание вычислительных мощностей планируется завершить до конца 2026 года. В 2027 году и далее возможно их расширение. В интервью ресурсу CNBC Дэйв Браун (Dave Brown), вице-президент по вычислительным сервисам и сервисам машинного обучения AWS, отметил, что OpenAI достанутся отдельные мощности, часть из которых уже доступна и используется. «Масштабирование передовых ИИ-технологий требует мощных и надёжных вычислений, — заявил генеральный директор OpenAI Сэм Альтман (Sam Altman). — Наше партнёрство с AWS укрепляет обширную вычислительную экосистему, которая станет движущей силой новой эры и сделает передовой ИИ доступным каждому». Примечательно, что для OpenAI будут развёрнуты узлы с преимущественно NVIDIA Connect-X, а не EFA, ради которых AWS переработала стойки GB300 NVL72, передаёт SemiAnalysis. Также OpenAI не будет использовать фирменные инструменты вроде SageMaker HyperPod, а задействует собственные решения для управления инфраструктурой. Т.е. речь идёт скорее о сдаче в аренду серверов, а не облачных сервисах. По-видимому, Project Ceiba также не относится к сделке. Вместе с тем OpenAI продолжит активно сотрудничать с Microsoft, обязавшись приобрести сервисы Azure на $250 млрд. Сделка была заключена после завершения реструктуризации OpenAI, в связи с чем ей уже нет необходимости получать одобрение Microsoft на покупку вычислительных сервисов у других компаний. В 2019–2023 гг. OpenAI использовала только вычислительные мощности Microsoft, являвшейся её основным инвестором. За последние 18 месяцев, несмотря на жалобы OpenAI на то, что ей не удалось получить от Microsoft всю необходимую вычислительную мощность, технологический гигант позволил стартапу заключить отдельные соглашения с двумя другими облачными провайдерами, пишет The New York Times. В последнее время OpenAI активно заключает сделки, в том числе, с такими компаниями, как AMD, CoreWeave, NVIDIA, Broadcom, Oracle и Google. Общая сумма сделок составила около $1,4 трлн, что побудило некоторых экспертов заявить о грядущем пузыре в сфере ИИ. Они также высказывают сомнения в наличии у США необходимых ресурсов и возможностей для воплощения этих амбициозных обещаний в реальность. Попутно стало известно о заключении AWS договора с оператором майнинговых дата-центров Cipher Mining на сумму около $5,5 млрд, согласно которому ей будут предоставлены в аренду на 15 лет площади и электропитание в ЦОД последней. Как сообщает Data Center Dynamics, согласно условиям договора, Cipher Mining предоставит AWS в 2026 году 300 МВт с поддержкой воздушного и жидкостного охлаждения стоек. Ранее Cipher Mining заключила сделку с Google и Fluidstack.

21.10.2025 [21:50], Владимир Мироненко

Nebius запустила первый в Израиле ИИ ЦОД с NVIDIA HGX B200Компания Nebius объявила о доступности платформы Nebius AI Cloud в своем новом ЦОД в Израиле, запущенном на площадке в Модиине (Modiin). Сообщается, что это один из крупнейших в стране ИИ-кластеров и первый на архитектуре NVIDIA Blackwell. Кластер включает 4 тыс. ускорителей в составе HGX B200, объединённых интерконнектом NVIDIA Quantum InfiniBand, и предоставляет доступ к стеку NVIDIA AI Enterprise, в том числе к микросервисам NVIDIA NIM и инструментам управления ИИ-агентами NeMo. Запуск в Израиле последовал за аналогичными развёртываниями Nebius в Европе и США. Новая площадка объединяет передовую аппаратную и программную инфраструктуру, включая усовершенствованные системы охлаждения, системы управления энергопотреблением и механизмы управления данными, разработанные для интенсивных рабочих ИИ-нагрузок. Nebius — партнёр NVIDIA по облачным технологиям (NCP). «Запуск Nebius крупнейшего в Израиле облака ИИ на базе Blackwell знаменует собой начало развития инфраструктуры ИИ в стране», — сообщил директор представительства NVIDIA в Израиле, отметив, что благодаря суверенному доступу к передовым вычислительным, сетевым технологиям и ПО, израильские компании и разработчики смогут внедрять инновации, развёртывать и масштабировать следующее поколение агентного и физического ИИ. Nebius входит в число первых партнёров NCP, получивших сертификат Exemplar Cloud для учебных рабочих нагрузок на базе NVIDIA H100, продемонстрировав производительность в пределах 95 % от референсной архитектуры NVIDIA. Платформа Nebius AI Cloud получила сертификацию SOC2 Type II, включая HIPAA, и обеспечивает сквозное шифрование, а также полное соответствие стандартам защиты данных GDPR и CCPA.

20.10.2025 [16:00], Сергей Карасёв

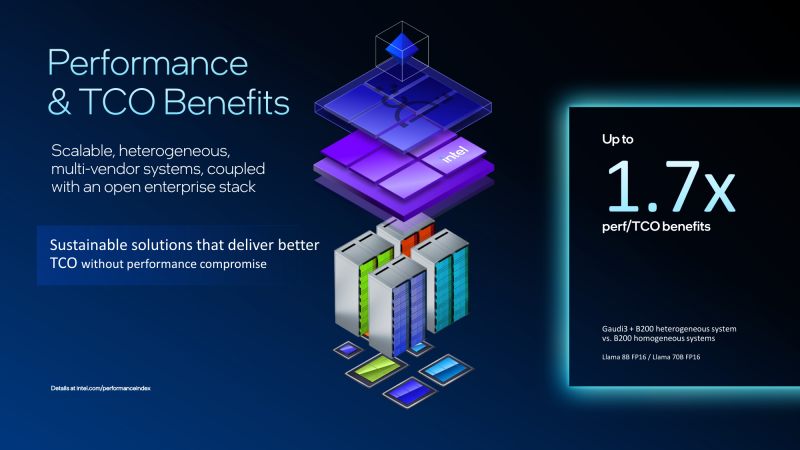

Экономичный гибрид: Intel объединила ускорители Gaudi 3 и NVIDIA B200 в одной ИИ-платформеКорпорация Intel показала гибридную стоечную систему Устройство объединяет посредством Ethernet массивы ускорителей Gaudi3 и NVIDIA B200. Платформа Gaudi3 Rack Scale 64 содержит до 16 вычислительных узлов. Каждый из них оснащён двумя неназванными процессорами Intel Xeon, четырьмя OAM-ускорителями Intel Gaudi 3 (64 в одном домене), четырьмя 400GbE-адаптерами NVIDIA ConnectX-7 и одним DPU NVIDIA BlueField-3, отмечает SemiAnalysis. Суммарно доступно 8,2 Тбайт HBM2e, а агрегированная пропускная способность составляет 76,8 Тбайт/с. Мощность суперускорителя составляет 120 кВт. Кроме того, задействованы 12 коммутаторов на чипах Broadcom Tomahawk 5 (51,2 Тбит/с). Для масштабирования и связи с другими узлами, в том числе NVIDIA, используется именно Ethernet. В составе гибридной системы ускорители Intel Gaudi 3 используются на decode-стадии, т.е. для генерации токенов, где важен объём и пропускная способность памяти, тогда как чипы NVIDIA B200 отвечают за prefill-задачи инференса, т.е. за обработку контекста и заполнение KVCache, где важна скорость вычислений. NVIDIA сама стремится к этому же подходу и уже анонсировала соускорители Rubin CPX, которые как раз будут заниматься работой с контекстом в сверхбольших моделях и созданием KV-кеша. Intel утверждает, что гибридная конфигурация из Gaudi3 и B200 позволяет достичь 1,7-кратного прироста производительности в расчёте на доллар совокупной стоимости владения (TCO) по сравнению с платформами, использующими только B200. Однако, как отмечается, эти заявления пока не подтверждены независимыми тестами. К тому же, программная платформа Gaudi3 отстаёт от платформы NVIDIA и является закрытой. Кроме того, нынешняя архитектура Gaudi приближается к концу своего существования, что ставит под сомнение жизнеспособность предложенной платформы в долгосрочной перспективе. Для Intel это, возможно, один из немногих шансов продать остатки Gaudi3. Между тем Intel недавно анонсировала GPU-ускоритель Crescent Island, разработанный специально для ИИ-инференса. Решение, в основу которого положена архитектура Xe3P, получит 160 Гбайт памяти LPDDR5X. Массовые поставки будет организованы не ранее 2027 года. Ранее компания отказалась от планов по выпуску Falcon Shores, сосредоточившись на Jaguar Shores. Сейчас же компания начала сворачивать поддержку ускорителей Ponte Vecchio (Intel Max) и Arctic Sound (Flex).

15.10.2025 [15:25], Руслан Авдеев

OpenAI и Oracle развернут 450 тыс. ускорителей NVIDIA в техасском дата-центре StargateПо словам председателя Oracle Ларри Эллисона (Larry Ellison), дата-центр проекта Stargate а Абилине (Abilene, Техас) вместит более 450 тыс. ускорителей на базе NVIDIA GB200, сообщает Datacenter Dynamics. Дата-центр Stargate получит 1,2 ГВт энергии — по словам Эллисона, энергии достаточно, чтобы обеспечить миллион домохозяйств в США. Как заявил миллиардер, «это довольно большой город». Питаться кампус будет как от энергосети штата, так и от газовых турбин. Информация подтверждает данные о том, что OpenAI и Oracle освоят всю ёмкость кампуса, застраиваемого Crusoe. Первые два строения уже функционируют, они введены в эксплуатацию в сентябре 2025 года. Строительство оставшихся шести зданий должны быть завершены к середине 2026 года. В марте 2025 года заявлялось, что площадка получит 64 тыс. ускорителей NVIDIA к концу 2026 года. С тех пор OpenAI подписала не имеющее обязательной силы письмо о намерении арендовать оборудование NVIDIA на 10 ГВт, которая в ответ пообещала инвестировать в OpenAI $100 млрд.

Источник изображения: OpenAI О росте числа используемых Stargate ускорителей можно было догадаться после анонса Oracle облачного ИИ-суперкомпьютера Zettascale10, который должен заработать во II половине 2026 года. Он объединит до 800 тыс. ускорителей в нескольких близко расположенных ЦОД. В Oracle отмечали, что суперкомпьютер станет основой флагманского суперкластера, создаваемого при участии OpenAI в Абилине в рамках проекта Stargate. |

|