Материалы по тегу: кластер

|

22.12.2025 [12:28], Сергей Карасёв

Китайская Sugon представила ИИ-платформу ScaleX с 10 тыс. ускорителейКитайский разработчик суперкомпьютеров Sugon (Dawning Information Industry), по сообщению газеты South China Morning Post, анонсировал платформу ScaleX для решения ресурсоёмких задач в области ИИ. Система призвана составить конкуренцию продуктам NVIDIA и Huawei. По заявлениям Sugon, ScaleX представляет собой первый в КНР суперкластер, объединяющий около 10 тыс. ускорителей. ИИ-производительность превышает 5 Эфлопс (точность вычислений не называется). Платформа может применяться для работы с ИИ-моделями, насчитывающими триллионы параметров. В основу суперкластера положены 16 стоек Sugon ScaleX640, каждая из которых может нести на борту до 640 ускорителей. Таким образом, общее количество ИИ-карт в составе платформы достигает 10 240. Конструкция стоек предполагает использование иммерсионного жидкостного охлаждения с фазовым переходом и высоковольтных источников питания постоянного тока (DC). Стойки связаны друг с другом высокоскоростным интерконнектом ScaleFabric. Sugon отмечает, что для моделей ИИ с триллионами параметров ScaleX640 обеспечивает повышение производительности на 30–40 % на задачах обучения и инференса по сравнению с традиционными НРС-системами. Предполагается, что ScaleX будет соперничать с будущими решениями Huawei, в частности, с суперкластерами Atlas 950 и Atlas 960. В их основу лягут ИИ-ускорители Ascend нового поколения, о подготовке которых стало известно в сентябре уходящего года. Система Atlas 950 SuperCluster, выход которой ожидается к концу 2026 года, будет содержать в общей сложности более 500 тыс. NPU, а Atlas 960 SuperCluster — свыше 1 млн. Сейчас у Huawei есть платформа CloudMatrix 384, которая объединяет 384 ускорителя Huawei Ascend 910C.

04.12.2025 [12:21], Руслан Авдеев

Скромно, но со вкусом: Vultr при поддержке AMD построит за $1 млрд ИИ-кластер с 24 тыс. Instinct MI355XОблачный провайдер Vultr строит кластер мощностью 50 МВт из ИИ-ускорителей AMD в дата-центре в Огайо. Новый проект призван обеспечить дополнительные вычислительные мощности по сниженным ценам, сообщает Bloomberg. Поддерживаемая AMD компания намерена инвестировать в объект более $1 млрд, клиенты смогут обучать и эксплуатировать ИИ-модели. Ввод в эксплуатацию запланирован на I квартал 2026 года. Vultr входит в группу облачных провайдеров, желающих заработать на ажиотажном спросе на ИИ. Новый кластер гораздо меньше гигантских объектов Microsoft, Meta✴ и Google. При этом вычислительные мощности, по словам компании, будут предлагаться по более доступным тарифам. Облако Vultr, как правило, вдвое дешевле, чем предложения гиперскейлеров, сообщают в компании. Утверждается, что её 50-МВт ЦОД с 24 тыс. AMD Instinct MI355X сопоставим с некоторыми гигаваттными проектами по эффективности. Vultr одной из первых получила MI355X, а вскоре перейдёт на MI450. Кластер называют «беспрецедентным» для облачной компании такого масштаба, но для него пока нет готовых к подписанию соглашений клиентов, хотя активные переговоры уже ведутся. По имеющимся данным, действующие клиенты вроде Clarifai Inc. и LiquidMetal AI, а также биотехнологическая MindWalk Holdings уже пользуются сервисами Vultr на базе решений AMD. В общей сложности компания обслуживает «сотни тысяч» клиентов в 185 странах. Vultr была основана в 2014 году и многие годы предлагала доступ к решениям на базе CPU. В 2021 году Vultr начала закупать GPU. В последние пару лет ИИ-инфраструктура стала самой быстрорастущей частью бизнеса компании, т.ч. теперь она обеспечивает большую часть выручки. В 2026 году бизнес намерен уделять ИИ ещё больше внимания. В прошлом году компания привлекла $333 млн, в ходе раунда, возглавленного LuminArx Capital Management и AMD, её капитализация составила $3,5 млрд. В июне 2025 года дополнительно получены $329 млн кредитного финансирования, преимущественно от JPMorgan Chase, Bank of America и Wells Fargo. В эту сумму вошли $74 млн, обеспеченных активами компании, в т.ч. ИИ-ускорителями. Vultr значительно расширила кредитную линию для финансирования кластера AMD. Разрабатывающие ИИ-инфраструктуру компании всё чаще опасаются, что отрасль ожидает формирование пузыря. Также не исключается, что ИИ-ускорителя быстро обесценятся, что тоже способно привести рынок к кризису. В Vultr уверены, что ИИ-инфраструктура всё ещё остаётся «крайне неразвитой», даже если некоторые, чрезвычайно разросшиеся на этом рынке IT-гиганты, вероятно, потерпят неудачу. Что касается времени «обесценивания» технологий, Vultr уверена, что срок службы в шесть лет для ИИ-ускорителей — «разумная, консервативная оценка».

14.11.2025 [08:56], Руслан Авдеев

Microsoft запустила второй «самый передовой» ИИ ЦОД в мире по проекту Fairwater в рамках создания ИИ-суперфабрикиMicrosoft запустила в Атланте (Джорджия) второй ИИ ЦОД по проекту Fairwater, подключенный к первому ИИ ЦОД такого типа в Висконсине для создания вычислительного суперкластера. Связь ЦОД осуществляется с помощью выделенной оптоволоконной сети AI Wide Area Network (AI WAN), специально предназначенной для выполнения ИИ-задач. Размеры и мощность нового ЦОД пока не раскрываются, но дата-центры этой серии станут крупнейшими объектами за всю историю Microsoft, а, возможно, и в мире. В дата-центре используется замкнутая система жидкостного охлаждения, которую обслуживает одна из крупнейших в мире система чиллеров. Объект поддерживает стойки мощностью порядка 140 кВт (1360 кВт на ряд). В целом он использует сотни тысяч новейших ИИ-ускорителей NVIDIA GB200/GB300 NVL72, объединённых двухуровневой 800GbE-сетью с коммутаторами под управлением SONiC. Дата-центр в Атланте имеет два этажа, чтобы сократить расстояние между стойками во всех трёх измерениях. Для AI WAN компания совместно с OpenAI, NVIDIA и другими партнёрами создала и внедрила протокол Multi-Path Reliable Connected (MRC) для оптимальной связи между несколькими дата-центрами класса Fairwater во время обучения сверхкрупных моделей, которые «не помещаются» в один ЦОД. Общая протяжённость каналов AI WAN составляет более 193 тыс. км. В Microsoft отметили, что благодаря надёжной электросети Атланты удалось отказаться от проектов локальной генерации электроэнергии, специальных ИБП и двух линий питания, что сократило время запуска ЦОД и стоимость его эксплуатации. По словам компании, им удалось добиться доступности 99,99 % по цене 99,9 %. Дополнительно разработаны уникальные программные и аппаратные решения для управления энергопотреблением, сглаживающие колебания нагрузок на сеть, вызванные работой ИИ, в том числе за счёт введения вспомогательных заданий во время простоя, самоограничения мощности GPU и использования накопителей энергии на площадке. Microsoft вводит в эксплуатацию всё больше дата-центров проекта Fairwater и намерена объединить их в целую сеть, превратив дата-центры в распределённый виртуальный суперкомпьютер, способный решать проблемы способами, недоступные отдельны объектам. Как считают в компании, если традиционный дата-центр предназначен для запуска миллионов приложений для многочисленных клиентов, то «ИИ-суперфабрика» выполняет одну сложную задачу в миллионах ускорителей. У Microsoft стремительно растут капитальные затраты на ЦОД и ускорители. При этом топ-менеджеры Microsoft признают, что «на самом деле никто не хочет иметь дата-центр у себя на заднем дворе». Жители большинства регионов опасаются роста стоимость коммунальных услуг, ущерба экологии и др.

30.10.2025 [16:18], Руслан Авдеев

Полмиллиона ускорителей Trainium2: AWS развернула для Anthropic один из крупнейших в мире ИИ-кластеров Project RainierAWS объявила о запуске одного из крупнейших в мире ИИ-кластеров Project Rainier. Фактически амбициозный проект представляет собой распределённый между несколькими ЦОД ИИ-суперкомпьютер — это важная веха в стремлении AWS к развитию ИИ-инфраструктуры, сообщает пресс-служба Amazon. Платформа создавалась под нужды Anthropic, которая буквально на днях подписала многомиллиардный контракт на использование Google TPU. В рамках Project Rainier компания AWS сотрудничала со стартапом Anthropic. В проекте задействовано около 500 тыс. чипов Trainium2, а вычислительная мощность в пять раз выше той, что Anthropic использовала для обучения предыдущих ИИ-моделей. Project Rainier применяется Anthropic для создания и внедрения моделей семейства Claude. К концу 2025 года предполагается использование более миллиона чипов Trainium2 для обучения и инференса. В рамках Project Rainier в AWS уже создали инфраструктуру на основе Tranium2, на 70 % превосходящую любую другую вычислительную ИИ-платформу в истории AWS. Проект охватывает несколько дата-центров в США и не имеет аналогов среди инициатив AWS. Он задуман как гигантский кластер EC2 UltraCluster из серверов Trainium2 UltraServer. UltraServer объединяет четыре физических сервера, каждый из которых имеет 16 чипов Trainium2. Они взаимодействуют через фирменный интерконнект NeuronLink, обеспечивающий быстрые соединения внутри системы, что значительно ускоряет вычисления на всех 64 чипах. Десятки тысяч UltraServer объединяются в UltraCluster посредством фабрики EFA. Эксплуатация такого ЦОД требует повышенной надёжности. В отличие от большинства облачных провайдеров, AWS создаёт собственное оборудование и может контролировать каждый компонент, от чипов до систем охлаждения и архитектуру дата-центров в целом. Управляющие ЦОД команды уделяют повышенное внимание энергоэффективности, от компоновки стоек до распределения энергии и выбора методов охлаждения. Кроме того, в 2023 году вся энергия, потребляемая Amazon, полностью компенсировалась электричеством из возобновляемых источников. В Amazon утверждают, что в последние пять лет компания является крупнейшим покупателем возобновляемой энергии и стремится к достижению нулевых выбросов к 2040 году.

Источник изображения: AWS Миллиарды долларов инвестируются в ядерную энергетику и АКБ, а также крупные проекты в области возобновляемой энергетики для ЦОД. В 2024 году компания объявила о внедрении новых компонентов для ЦОД, сочетающих технологии электропитания, охлаждения и аппаратного обеспечения, причём не только для строящихся, но и уже для имеющихся объектов. Новые компоненты, предположительно, позволят снизить энергопотребление некоторых компонентов до -46 % и сократить углеродный след используемого бетона на 35 %.

Источник изображения: AWS Для новых объектов, строящихся в рамках Project Rainier и за его пределами, предусмотрено использование целого ряда новых технологий для повышения энергоэффективности и экоустойчивости. Некоторые технологии связаны с рациональным использованием водных ресурсов. AWS проектирует объекты так, чтобы использовать минимум воды, или вовсе не использовать её. Один из способов — отказ от её применения в системах охлаждения на многих объектах большую часть года, с переходом на охлаждение наружным воздухом.

Источник изображения: AWS Так, один из объектов Project Rainier в Индиане будет максимально использовать именно уличный воздух, а с октября по март дата-центры вовсе не станут использовать воду для охлаждения, с апреля по сентябрь в среднем вода будет применяться по несколько часов в день. Согласно отчёту Национальной лаборатории им. Лоуренса в Беркли (LBNL), стандартный показатель WUE для ЦОД 0,375 л/кВт·ч. В AWS этот показатель равен 0,15 л/кВт·ч, что на 40 % лучше, чем в 2021 году.

21.10.2025 [21:50], Владимир Мироненко

Nebius запустила первый в Израиле ИИ ЦОД с NVIDIA HGX B200Компания Nebius объявила о доступности платформы Nebius AI Cloud в своем новом ЦОД в Израиле, запущенном на площадке в Модиине (Modiin). Сообщается, что это один из крупнейших в стране ИИ-кластеров и первый на архитектуре NVIDIA Blackwell. Кластер включает 4 тыс. ускорителей в составе HGX B200, объединённых интерконнектом NVIDIA Quantum InfiniBand, и предоставляет доступ к стеку NVIDIA AI Enterprise, в том числе к микросервисам NVIDIA NIM и инструментам управления ИИ-агентами NeMo. Запуск в Израиле последовал за аналогичными развёртываниями Nebius в Европе и США. Новая площадка объединяет передовую аппаратную и программную инфраструктуру, включая усовершенствованные системы охлаждения, системы управления энергопотреблением и механизмы управления данными, разработанные для интенсивных рабочих ИИ-нагрузок. Nebius — партнёр NVIDIA по облачным технологиям (NCP). «Запуск Nebius крупнейшего в Израиле облака ИИ на базе Blackwell знаменует собой начало развития инфраструктуры ИИ в стране», — сообщил директор представительства NVIDIA в Израиле, отметив, что благодаря суверенному доступу к передовым вычислительным, сетевым технологиям и ПО, израильские компании и разработчики смогут внедрять инновации, развёртывать и масштабировать следующее поколение агентного и физического ИИ. Nebius входит в число первых партнёров NCP, получивших сертификат Exemplar Cloud для учебных рабочих нагрузок на базе NVIDIA H100, продемонстрировав производительность в пределах 95 % от референсной архитектуры NVIDIA. Платформа Nebius AI Cloud получила сертификацию SOC2 Type II, включая HIPAA, и обеспечивает сквозное шифрование, а также полное соответствие стандартам защиты данных GDPR и CCPA.

14.10.2025 [20:58], Владимир Мироненко

Oracle анонсировала крупнейший в мире зеттафлопсный ИИ-кластер OCI Zettascale10: до 800 тыс. ускорителей NVIDIA в нескольких ЦОД

800gbe

ethernet

hardware

hpc

nvidia

oracle

oracle cloud infrastructure

stargate

ии

интерконнект

кластер

сша

цод

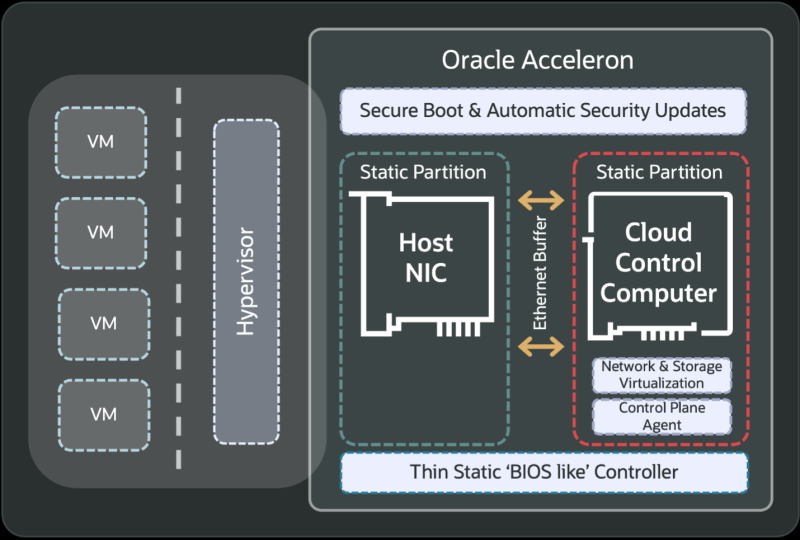

Oracle анонсировала облачный ИИ-кластер OCI Zettascale10 на базе сотен тысяч ускорителей NVIDIA, размещённых в нескольких ЦОД, который имеет пиковую ИИ-производительность 16 Зфлопс (точность вычислений не указана). OCI Zettascale10 — это инфраструктура, на которой базируется флагманский ИИ-суперкластер, созданный совместно с OpenAI в техасском Абилине (Abilene) в рамках проекта Stargate и основанный на сетевой архитектуре Oracle Acceleron RoCE нового поколения. OCI Zettascale10 использует NVIDIA Spectrum-X Ethernet — первую, по словам NVIDIA, Ethernet-платформу, которая обеспечивает высокую масштабируемость, чрезвычайно низкую задержку между ускорителями в кластере, лидирующее в отрасли соотношение цены и производительности, улучшенное использование кластера и надежность, необходимую для крупномасштабных ИИ-задач. Как отметила Oracle, OCI Zettascale10 является «мощным развитием» первого облачного ИИ-кластера Zettascale, который был представлен в сентябре 2024 года. Кластеры OCI Zettascale10 будут располагаться в больших кампусах ЦОД мощностью в гигаватты с высокоплотным размещением в радиусе двух километров, чтобы обеспечить наилучшую задержку между ускорителями для крупномасштабных задач ИИ-обучения. Именно такой подход выбран для кампуса Stargate в Техасе. Oracle отметила, что помимо возможности создавать, обучать и развёртывать крупнейшие ИИ-модели, потребляя меньше энергии на единицу производительности и обеспечивая высокую надёжность, клиенты получат свободу работы в распределённом облаке Oracle со строгим контролем над данными и суверенитетом ИИ. Изначально кластеры OCI Zettascale10 будут рассчитаны на развёртывание до 800 тыс. ускорителей NVIDIA, обеспечивая предсказуемую производительность и высокую экономическую эффективность, а также высокую пропускную способность между ними благодаря RoCEv2-интерконнекту Oracle Acceleron со сверхнизкой задержкой. Acceleron предлагает 400G/800G-подключение со сверхнизкой задержкой, двухуровневую топологию, множественное подключение одного NIC к нескольким коммутатором с физической и логической изоляцией сетевых потоков, поддержку LPO/LRO и гибкость конфигурации. DPU Pensando от AMD в Acceleron место тоже нашлось. OCI уже принимает заказы на OCI Zettascale10, который поступит в продажу во II половине следующего календарного года. В августе NVIDIA анонсировала решение Spectrum-XGS Ethernet для объединения нескольких ЦОД в одну ИИ-суперфабрику, которым, по-видимому, воспользуется не только Oracle, но и Meta✴.

03.10.2025 [17:24], Руслан Авдеев

UKPN начнёт отапливать дома британских малоимущих кластерами из сотен Raspberry Pi

hardware

raspberry pi

великобритания

кластер

микро-цод

облако

отопление

периферийные вычисления

погружное охлаждение

сжо

экология

Британская UK Power Networks (UKPN) в рамках программы SHIELD (Smart Heat and Intelligent Energy in Low-income Districts) начала устанавливать микро-ЦОД на базе одноплатных компьютеров Raspberry Pi — для отопления домохозяйств, нуждающихся в деньгах для оплаты коммунальных услуг, сообщает The Register. Выбранные домохозяйства оснастят солнечными элементами питания и аккумуляторными системами, треть из них получит и систему HeatHub — сверхкомпактный ЦОД размером с большой тепловой насос, который заменит традиционные газовые котлы. Полученные в рамках пробного развёртывания данные используют для масштабирования SHIELD, к 2030 году UKPN намерена ежегодно развёртывать 100 тыс. систем. Платформа HeatHub разработана компанией Thermify. Она предназначена для запуска облачных контейнеризированных нагрузок. Каждый HeatHub включает до 500 модулей Raspberry Pi CM4 или CM5, погружённых в масло. Полученное тепло передаётся в системы отопления и горячего водоснабжения, а сам HeatHub легко установить вместо бойлера. HeatHub имеет собственное выделенное интернет-подключение. Над внедрением «низкоуглеродных» технологий SHIELD компания UKPN сотрудничает с Power Circle Projects, жилищной ассоциацией Eastlight Community Homes и Essex Community Energy. Также она участвует над установлением нового социального тарифа на отопление на востоке и юго-востоке Англии. Малоимущие клиенты будут платить фиксированную ставку в £5,60 ($7,52) ежемесячно, а SHIELD поможет им сократить счета за электричество на 20–40 %. Куратор SHIELD со стороны Eastlight Community Homes заявил, что результаты пилотного проекта обнадёживают, его планируют опробовать ещё в сотнях домов. Это поможет семьям поддерживать комфортные условия проживания, не беспокоясь о росте цен на энергию. Для обычных пользователей у Thermify иные условия — модуль для типового дома с тремя спальнями обойдётся в £2500 ($3365), ещё £500 ($673) возьмут за установку, а за отопление будут брать £50/мес. ($67/мес.). В особых случаях плата может быть снижена вдвое, а в экстремальных ситуациях тепло будет предоставляться бесплатно. Это уже не первый проект подобного рода. Так, Heata — изначально принадлежавшая British Gas, предлагает использовать серверы в качестве домашних водонагревателей, что позволяет сократить расходы на электричество для домовладельцев. Тепло вырабатывается за счёт рабочих нагрузок облачного оператора Civo. Также пару лет назад начала работать британская Deep Green — она обеспечивает теплом предприятия и бассейны с помощью мини-ЦОД, размещаемых на их территории.

29.09.2025 [14:00], Руслан Авдеев

315 млн ИИ-ядер и 1,4 квадрлн транзисторов: Cerebras открыла в США 10-МВт ЦОД на царь-чипах WSE-3Разработчик ИИ-ускорителей Cerebras Systems развернул новый дата-центр в Оклахома-Сити — столице штата Оклахома (США). Объект мощностью 10 МВт создан совместно со Scale Datacenters, сообщает Datacenter Dynamics. На объекте применяются замкнутые системы прямого жидкостного охлаждения. По данным компании, каждый потреблённый киловатт-час компенсируется покупкой энергии из возобновляемых источников. По словам представителя Cerebras, в 2023 году компания построила свой первый ИИ-суперкомпьютер Andromeda с 13,5 млн ИИ-ядер, на тот момент — крупнейший в своём роде. Новый кластер в Оклахома-Сити на базе систем CS-3 с царь-чипами WSE-3 обеспечивает ИИ-производительность 44 Эфлопс (точность вычислений не указана) и поддерживает крупнейшие из когда-либо созданных ИИ-моделей. Кластер включает 315 млн ИИ-ядер и 1,4 квадрлн транзисторов. Scale Datacenter подготовила для Cerebras саму площадку и сопутствующую инфраструктуру. В Scale подчеркнули, что рады сотрудничеству с Cerebras, оно позволит создать в Оклахома-Сити ИИ-инфраструктуру мирового класса. В мае 2025 года появилась информация о покупке Scale Datacenter ЦОД площадью 7,6 тыс. м2 в Оклахома-Сити у компании Expand Energy. Ранее Cerebras объявила о намерении запустить шесть новых ИИ ЦОД в Северной Америке и Европе, в том числе с использованием более 300 систем CS-3 на объекте в Оклахома-Сити. У Cerebras есть кластеры для инференса в Санта-Кларе (Santa Clara) и Стоктоне (Stockton) в Калифорнии, последний расположен на барже-ЦОД Nautilus. Также имеется объект в Далласе (Dallas, Техас). Компания занимается созданием собственных кластеров в Миннеаполисе (Minneapolis, Миннесота), Монреале (Montreal, Канада — на объекте Bit Digital), а также в некоторых локациях на Среднем Западе США и в Европе. Cerebras уже разместила оборудование в Эдинбургском университете, Сандийских национальных лабораториях (США), лабораториях Лос-Аламоса, мощностях G42/Core42, и др.

26.09.2025 [10:33], Руслан Авдеев

Media Stream AI построит в Манчестере 2-МВт ИИ ЦОД с охлаждением водой из местного каналаБританская медиакомпания Media Stream AI (MSAI) намерена открыть в Солфорде (Salford, Большой Манчестер) дата-центр в популярном «творческом» районе Media City. Объект мощностью 2 МВт будет использовать для охлаждения воду из канала Рочдейл (Rochdale), сообщает Datacenter Dynamics. Система охлаждения будет состоять из замкнутого контура с теплообменниками и драйкулеров. При поддержке Lenovo объект стоимостью £50 млн ($67,3 млн) сможет обеспечить плотность стоек на уровне 30–60 кВт при PUE менее 1,2. На площадке планируется разместить 1,1 тыс. ускорителей NVIDIA H200 в составе серверов Lenovo ThinkSystem с СЖО Neptune. В будущем возможно расширение до 2,3 тыс. ускорителей. Объект должен заработать в I квартале 2026 года. Компания намерена создать там же собственную виртуальную продакшн-студию и робототехническую лабораторию. Media Stream AI рассчитывает предоставлять ИИ-сервисы медиакомпаниям и работникам творческих профессий. На сайте стартапа объявлено, что он намерен предоставить доступ к ускорителям NVIDIA L4, A10G, A4000, A5000, A100, H100 и L40. Также компания намерена развернуть к концу 2026 года площадки в Германии и Франции. Более того, MSAI заключила соглашение с властями Ямайки о строительстве и эксплуатации первого на острове ИИ ЦОД. Прецеденты использования похожих систем охлаждения есть. Например, Digital Realty использует для охлаждения ЦОД во Франции и Великобритании проточную речную воду. Green Mountain намерена развернуть систему охлаждения речной водой на своём новом объекте в Германии. Речное охлаждение также используют Denv-R во Франции и Nautilus в Калифорнии. Наконец, сеть европейских супермаркетов Lidl объявила, что один из её ЦОД в Германии тоже использует охлаждение речной водой, а норвежский оператор дата-центров Polar утверждает, что для охлаждения одного из своих ЦОД намерен использовать близлежащую реку. Участвуют в подобных проектах и гиперскейлеры. Площадка Google в Финляндии использует для охлаждения и морскую воду.

19.09.2025 [14:44], Руслан Авдеев

Meta✴ свернула работу пяти действующих ЦОД, чтобы сделать из них один крупный ИИ-кластерКомпания Meta✴ создала крупный ИИ-кластер из 129 тыс. ускорителей NVIDIA H100, использующий пять расположенных близко к друг другу ЦОД. Для его создания она переместила из дата-центров имевшиеся стойки, сообщает Datacenter Dynamics. По словам компании, сворачивать работу действующих ЦОД невероятно дорого, поскольку речь идёт об уже сделанных крупных инвестициях. Кроме того, эти дата-центры обслуживали актуальные рабочие нагрузки, так что пришлось отключать их настолько быстро, насколько это возможно, при этом стараясь не вызывать заметных пользователям сбоев. Для того, чтобы проделать все работы быстро, пришлось переделать погрузочные платформы в дата-центрах. Более того, построили новых роботов для перемещения стоек массой более 400 кг и даже переделала упаковку для самих стоек, чтобы ускорить перемещения. Сеть в ЦОД разрослась вчетверо, для чего пришлось даже прорыть новые коммуникационные траншеи, чтобы связать пять зданий в единую высокоскоростную сеть. Все эти работы были выполнены всего за несколько месяцев. Объясняется, что решение о создании суперкластера на основе действующих ЦОД было принято, поскольку у существующих площадок было достаточно энергетических мощностей для столь большого проекта. Компания не раскрыла местоположения нового ИИ-кластера и признала, что её знания и многолетний опыт создания крупных IT-систем, в том числе дата-центров, из-за стремительного прогресса ИИ устарели. Теперь Meta✴ готова инвестировать «сотни миллиардов долларов в вычисления. Гигаваттный кластер Prometheus должен заработать в следующем году, а Hyperion на 5 ГВт должны ввести в эксплуатацию до конца десятилетия. |

|