Материалы по тегу: кластер

|

06.08.2025 [10:10], Сергей Карасёв

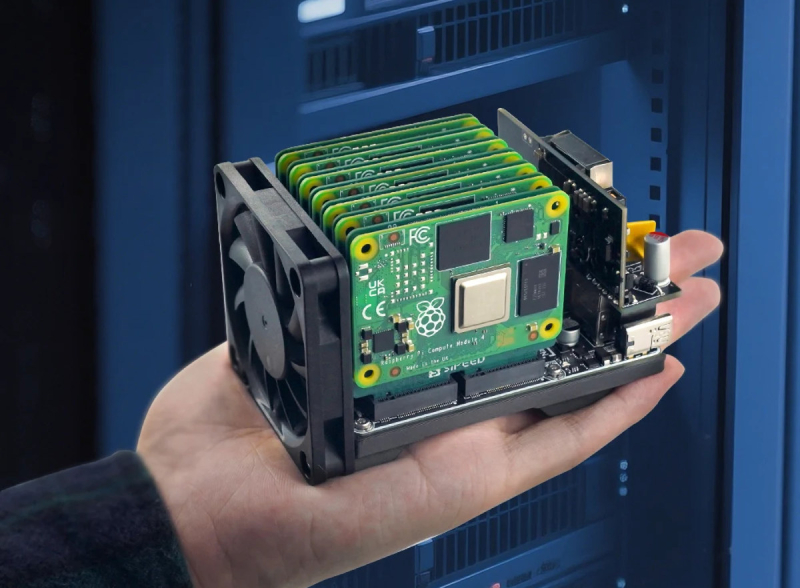

Кластер на ладони: Sipeed NanoCluster позволяет объединять до семи модулей Raspberry Pi CM4/CM5Компания Sipeed, по сообщению CNX-Software, начала продажи изделия NanoCluster — специализированной платы, которая позволяет формировать мини-кластеры на основе таких вычислительных модулей (SoM), как Raspberry Pi CM4, Raspberry Pi CM5, Sipeed LM3H, Sipeed M4N и др. Новинка оснащена семью сдвоенными коннекторами M.2 M-Key для подключения SoM. В случае CM4, CM5 и M4N установка осуществляется через специальные адаптеры, на обратной стороне которых имеется слот для SSD в форм-факторе M.2 с интерфейсом PCIe. Таким образом, в максимальной конфигурации могут быть объединены до семи вычислительных модулей и до семи твердотельных накопителей. NanoCluster располагает интерфейсом HDMI (подключён к слоту №1), сетевым портом 1GbE (RJ45), двумя портами USB 2.0 Type-A, а также разъёмом USB Type-C PD (до 60 Вт). За обмен данными между вычислительными модулями отвечает 8-портовый коммутатор JL6108 Gigabit Ethernet на базе RISC-V. Опционально может быть реализована поддержка PoE с бюджетом мощности 60 Вт. Предусмотрен 2-контактный коннектор для вентилятора охлаждения диаметром 60 мм. Размеры платы NanoCluster составляют 88 × 57 мм, а полная сборка с установленными SoM и кулером имеет габариты 100 × 60 × 60 мм. Несмотря на наличие семи слотов, при работе с Raspberry Pi CM5 рекомендуется использовать только четыре–пять модулей из-за проблем с питанием и охлаждением, особенно при подключении M.2 SSD. В частности, может наблюдаться троттлинг. Мини-кластер подходит для обучения и экспериментов с распределёнными и периферийными вычислениями, Kubernetes, Docker и пр. Цена собственно платы NanoCluster составляет около $50, а, например, комплект с четырьмя модулями Sipeed M4N обойдётся в $700.

28.07.2025 [13:35], Сергей Карасёв

Huawei представила ИИ-систему CloudMatrix 384 — конкурента NVIDIA GB200 NVL72Компания Huawei, по сообщению Reuters, представила на Всемирной конференции по искусственному интеллекту (WAIC) в Шанхае (Китай) систему CloudMatrix 384 для ресурсоёмких ИИ-нагрузок. Участники ранка рассматривают эту платформу в качестве прямого конкурента NVIDIA GB200 NVL72. Информация о характеристиках CloudMatrix 384 появилась в апреле нынешнего года: система объединяет 384 ускорителя Huawei Ascend 910C. Для сравнения: NVIDIA GB200 NVL72 содержит в одной стойке 18 узлов 1U, каждый из которых включает два ускорителя GB200 — в сумме это даёт 72 чипа B200 и 36 процессоров Grace. Быстродействие CloudMatrix 384 достигает 300 Пфлопс (BF16) против 180 Пфлопс у NVIDIA GB200 NVL72. Кроме того, решение Huawei в 3,6 раза превосходит конкурирующую платформу по объёму памяти HBM и в 2,1 раза по пропускной способности памяти. Однако для достижения таких показателей потребовалось в пять с лишним раз больше ускорителей. Таким образом, по производительности и энергоэффективности отдельные карты Ascend 910C существенно уступают изделиям NVIDIA GB200. По данным сетевых источников, на коммерческий рынок система CloudMatrix 384 может поступить под именем Atlas 900 A3 SuperPoD. Компания Huawei, не вдаваясь в подробности, отмечает, что машина использует архитектуру «суперузлов», которая позволяет ИИ-ускорителям взаимодействовать на сверхвысоких скоростях. Обещаны ультранизкие задержки. Выход системы призван укрепить позиции Китая в сфере ИИ на фоне американских санкций. Власти США наложили запрет на поставки в КНР передовых решений в сфере ИИ. Тем не менее, за три месяца действия новых правил по ужесточению контроля над экспортом таких ускорителей в Китай всё равно попали изделия NVIDIA на сумму не менее $1 млрд. А сама компания NVIDIA между тем рассчитывает возобновить отгрузки ИИ-ускорителей H20 китайским заказчикам.

25.07.2025 [17:41], Сергей Карасёв

SoftBank развернула крупнейшую в мире ИИ-платформу на базе NVIDIA DGX B200Японский холдинг SoftBank объявил о расширении вычислительной ИИ-инфраструктуры на платформе NVIDIA DGX SuperPOD: развёрнуты системы DGX B200, насчитывающие в общей сложности 4 тыс. ускорителей поколения Blackwell. О планах SoftBank по созданию первого в мире ИИ-суперкомпьютер на базе NVIDIA DGX B200 стало известно в конце прошлого года. Вычислительная система использует интерконнект Quantum-2 InfiniBand и поддерживается программной платформой NVIDIA AI Enterprise. Холдинг SoftBank изначально внедрил DGX SuperPOD с более чем 2 тыс. ускорителями поколения NVIDIA Ampere в сентябре 2023 года: на тот момент производительность достигала 0,7 Эфлопс на операциях ИИ (точность вычислений не раскрывается). В октябре 2024 года завершился первый этап модернизации, в ходе которого были добавлены 4000 ускорителей семейства NVIDIA Hopper. В результате, суммарное быстродействие поднялось до 4,7 Эфлопс. После установки DGX B200 показатель вырос до 13,7 Эфлопс. Отмечается, что на сегодняшний день новая вычислительная инфраструктура SoftBank является крупнейшей в мире ИИ-платформой на основе DGX B200. При этом в общей сложности задействованы свыше 10 тыс. ускорителей. Изначально систему будет использовать SB Intuitions Corp. — дочерняя структура SoftBank, которая специализируется на разработке собственных больших языковых моделей (LLM), адаптированных для Японии. SB Intuitions уже создала LLM с примерно 460 млрд параметров, а в текущем 2025 финансовом году, который заканчивается 31 марта 2026-го, компания планирует представить коммерческую ИИ-модель Sarashina mini с 70 млрд параметров. Нужно отметить, что ранее SoftBank и OpenAI объявили о формировании совместного предприятия SB OpenAI для развития корпоративных ИИ-сервисов в Японии. Кроме того, SoftBank участвует в мегапроект Stargate — это совместное предприятие с OpenAI и Oracle по развитию ИИ-инфраструктуры в США. Предполагается, что суммарные затраты на реализацию Stargate достигнут $500 млрд. Впрочем, пока проект продвигается с большим трудом.

22.06.2025 [23:30], Руслан Авдеев

Meta✴ ведёт переговоры о покупке венчурного фонда NFDG, у которого есть собственный ИИ-кластер AndromedaMeta✴ Platforms решила обновить свои компетенции в сфере ИИ, наняв ведущих отраслевых игроков — Ната Фридмана (Nat Friedman) и Дэниэла Гросса (Daniel Gross). Также компания намерена выкупить их венчурный фонд NFDG, сообщает The Information. Марк Цукерберг (Mark Zuckerberg) сначала пытался купить ИИ-стартап Safe Superintelligence (SSI) бывшего «главным учёным» OpenAI Ильи Суцкевера (Ilya Sutskever). После отказа Цукерберг попросту собрался нанять генерального директора SSI — Гросса. Ранее тот руководил ИИ-разработками в Apple и был партнёром Y Combinator. Фридман был главой GitHub и советником Midjourney. Гросс и Фридман были соучредителями инвестиционного фонда NFDG. NFDG имеет доли в в известных ИИ-компаниях, включая SSI, Perplexity и Character.ai. Ранее компания инвестировала в Weights & Biases, которую приобрела CoreWeave. NFDG занимается не только финансированием компаний, но и предлагает программу грантов, в рамках которой стартапам предоставляется финансирование на $250 тыс., а также $250 тыс. в виде облачных кредитов Microsoft Azure. В период дефицита ИИ-ускорителей NFDG построил собственный суперкомпьютер. Кластер Andromeda изначально включал 2512 ускорителей NVIDIA H100. С тех пор он вырос до 3 200 H100 в 400 узлах и ещё 432 H100 в 54 узлах, связанных 400G-интерконнектом InfiniBand, а также 768 A100 с 200G InfiniBand. Теперь Andromeda могут арендовать и компании, которые не относятся к NFDG, за $2,4–$3 за ускоритель в час. Сейчас можно арендовать до 2 тыс. H100 и получить доступ к ним в течение нескольких часов.

Источник изображения: Amina Atar/unspalsh.com Помимо возможного найма Гросса и Фридмана, Meta✴ ведёт переговоры, конечной целью которых является выкуп значительной части активов NFDG и вывод из него партнёров за сумму более $1 млрд. При этом сделка не даст Meta✴ контроля над фондом или информации о бизнесе. Кому достанется Andromeda, не уточняется. Если сделка будет завершена, она войдёт в число более масштабных реформ в Meta✴, связанных с ИИ. Цукерберг планирует сформировать новую лабораторию по разработке «суперинтеллекта» и пересмотреть стратегию выкупа продуктов. В этом месяце Meta✴ уже подтвердила, что намерена потратить порядка $14 млрд на долю в Scale AI, специализирующейся на разметке данных для обучения ИИ.

17.04.2025 [00:10], Владимир Мироненко

Суперускоритель Huawei CloudMatrix 384 оказалася быстрее NVIDIA GB200 NVL72, но значительно прожорливееHuawei анонсировала на конференции Huawei Cloud Ecosystem Conference 2025 собственный суперускоритель CloudMatrix 384, который позиционируется в качестве отечественной альтернативы системы NVIDIA GB200 NVL72. Решение Huawei отличается более высокой общей производительностью — 300 Пфлопс против 180 Пфлопс. Но в то же время оно уступает решению NVIDIA по производительности на чип и имеет значительно более высокое энергопотребление, пишет SemiAnalysis. Система Huawei CloudMatrix 384 использует 384 ускорителя Huawei Ascend 910C, в то время как в GB200 NVL72 задействовано 36 процессоров Grace в сочетании с 72 ускорителями B200 (Blackwell). То есть, чтобы вдвое превзойти по производительности GB200 NVL72, потребовалось примерно в пять раз больше ускорителей Ascend 910C, что не очень хорошо с точки зрения использования самих ускорителей, но отлично на уровне развёртывания системы, отметил ресурс SemiAnalysis. Как утверждает SemiAnalysis, Huawei отстает от NVIDIA на поколение по производительности чипов, но опережает в проектировании и развёртывании масштабируемых систем. Если сравнивать отдельные ускорители, то NVIDIA GB200 явно превосходит Huawei Ascend 910C, обеспечивая более чем в три раза большую производительность в вычислениях в формате BF16 (2500 против 780 Тфлопс) и больший HBM на чипе (192 против 128 Гбайт) с более высокой пропускной способностью памяти (ПСП, 8 против 3,2 Тбайт/с). Другими словами, у NVIDIA есть преимущество в чистой мощности и на уровне чипа. Но на уровне системы эффективность CloudMatrix CM384 выходит вперёд. Он выдаёт в 1,7 раза больше Пфлопс, имеет в 3,6 раз больше HBM, обеспечивает в 2,1 раза большую ПСП и объединяет более чем в пять раз больше ускорителей, чем GB200 NVL72. Однако эта масштабируемость имеет обратную сторону, поскольку система Huawei потребляет почти в четыре раза больше энергии — 145 кВт против ~560 кВт. Для Huawei CloudMatrix 384 требуется в 3,9 раза больше энергии, чем для GB200 NVL72: в 2,3 раза больше энергии на 1 флопс, в 1,8 раза — на 1 Тбайт/с ПСП и в 1,1 раза — на 1 Тбайт HBM. SCMP со ссылкой на данные самой Huawei сообщает, что CloudMatrix CM384 показал производительность на уровне 800 Пфлопс в BF16-вычислениях без разреженности или 1920 токенов/с на модели DeepSeek-R1. Суперускоритель размещается в 16 стойках, из которых четыре отведено только под интерконнект — всего 6912 400G-порта. Остальные стойки содержат по 32 ускорителя Ascend 910C в четырёх узлах (8×4) и ToR-коммутатор. Как отметил SemiAnalysis, было бы заблуждением говорить, что Ascend 910C и CloudMatrix 384 производятся в Китае: HBM в них от Samsung, пластины от TSMC, а само оборудование из США, Нидерландов и Японии. Хотя у китайской SMIC уже есть 7-нм техпроцесс, подавляющее большинство Ascend 910B/910C было втайне сделано по 7-нм технологии TSMC. Предполагается, что Huawei смогла обойти санкции США, заказав чипы на $500 млн при посредничестве Sophgo. Сама TSMC прекратила поставки Huawei в 2020 году.

10.04.2025 [15:01], Руслан Авдеев

В Эдинбургском университете заработал ИИ-кластер на базе Cerebras CS-3Эдинбургский университет и Cerebras Systems развернули в суперкомпьютерным центре EPCC кластера из четырёх ИИ-систем CS-3 на базе царь-ускорителей WSE-3. Новые мощности являются частью Edinburgh International Data Facility. По словам EPCC, это крупнейший кластер CS-3 в Европе. EPCC уже имеет опыт работы с системами CS-1 и CS-2. В Cerebras заявили, что гордятся расширением сотрудничества с EPCC, которое поможет стать Великобритании одним из ключевых мировых ИИ-хабов. Как заявляют в EPCC, ИИ сегодня изменяет все сферы жизни, поэтому новые системы помогут университетам, государственным организациям и компаниям обучать и использовать ИИ-модели на скоростях и с лёгкостью, недоступной другим ИИ-решениям. Платформы Cerebras оптимизированы не только для масштабного обучения моделей, но и для сверхбыстрого инференса — пользователям кластера теперь доступна платформа-рекордсмен Cerebras AI Inference. Системы CS-3 способны выдавать до 2000 токенов/с для популярных ИИ-моделей.

Источник изображения: Nadia Ramella/unsplash.com С новыми кластерами на основе Cerebras CS-3, EPCC сможет обучать модели от 240 млрд до 1 трлн параметров, а также ежедневно тюнинговать модели с 70 млрд параметров. Лёгкость использования технологий Cerebras позволяет использовать ИИ-модели и в дисциплинах, не относящихся к компьютерным наукам. Технологии Cerebras обеспечивают линейную масштабируемость, что ускоряет инновации и повышает продуктивность команды EPCC, говорится в сообщении. Эдинбургский университет считается одним из лидеров в разработке ИИ-систем в последние 60 лет. Системы CS-2 в распоряжении EPCC уже позволили исследователям разработать высокоэффективное ПО для инференса для больших языковых моделей (LLM) — как для местного применения, так и для помощи исследователям из Индии в разработке ИИ-моделей для материаловедения и из Швейцарии — для адаптации LLM к местному диалекту немецкого языка. Кроме того, платформы CS-3 с миллионами вычислительных ядер позволят продолжить исследования EPCC в областипараллельных вычислений и энергоэффективности.

25.03.2025 [12:52], Сергей Карасёв

«Скала^р» представила Машину для искусственного интеллекта — отечественный аналог NVIDIA DGX SuperPODКомпания «Скала^р» анонсировала специализированный программно-аппаратный комплекс (ПАК) для работы с ИИ-моделями — Машину Скала^р МБД.ИИ. Эта система, как утверждается, представляет собой функциональный аналог платформ NVIDIA DGX SuperPOD и Huawei Atlas 900 PoD. Полностью технические характеристики новинки пока не раскрываются. Известно, что Машина Скала^р МБД.ИИ использует интерконнект NVLink с возможностью объединения двух, четырёх или восьми ускорителей. Задействованы технологии GPUDirect и NVMe-oF для обработки и передачи данных, а также система прямого доступа к ресурсам RDMA. Заявлена поддержка всех популярных фреймворков для машинного обучения: TensorFlow, PyTorch, Keras и др. Вычислительный комплекс будет предлагаться в конфигурациях с ускорителями NVIDIA и в вариантах с альтернативными ИИ-картами, в том числе на основе неназванных тензорных процессоров. Кроме того, в разработке находятся решения с поддержкой отечественных ускорителей. Возможно развёртывание системы как в дата-центре заказчика, так и в составе частных и гетерогенных облачных систем. Машина может интегрироваться с другими ПАК семейства Скала^р, предназначенными для работы с большими данными. Для нового комплекса подтверждена совместимость с различными платформами машинного обучения и моделями ИИ, в том числе MTS AI Cotype Pro, T1 Сайбокс, Red_Mad_Robot Neuraldeep.tech, WaveAccess ValueAI, DeepSeek и LLaMA. По заявлениям разработчика, система имеет гибкую унифицированную архитектуру, соответствующую отраслевым стандартам, что позволяет использовать её с YandexGPT, GigaChat и др. Развёртывание приложений ИИ в контейнерной среде обеспечивает эффективное использование аппаратных ресурсов, а реализация интерконнекта с применением топологий Fat-tree, HyperCube, DragonFly или классической архитектуры Leaf-Spine даёт возможность более гибко масштабировать вычислительный кластер. Среди преимуществ Машины Скала^р МБД.ИИ названы:

«Машина Скала^р МБД.ИИ позволяет создать надёжную и производительную инфраструктуру для работы с искусственным интеллектом, используя проверенные технологии и компоненты из реестра Минпромторга и Минцифры РФ с подтверждённой производительностью до 1,5 Пфлопс на вычислительный кластер. Мы видим большой потенциал применения комплекса в различных отраслях экономики, включая промышленность и финансы, где использование ИИ помогает существенно повысить эффективность бизнес-процессов», — говорит директор по технологическим инновациям Скала^р.

17.02.2025 [17:42], Руслан Авдеев

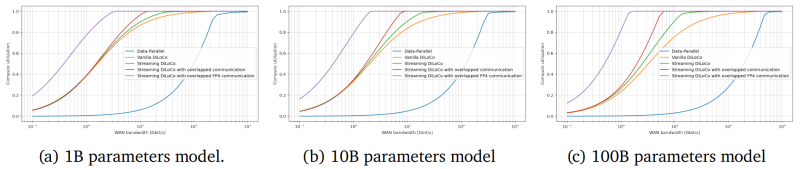

Исследователи DeepMind предложили распределённое обучение больших ИИ-моделей, которое может изменить всю индустриюПосле того, как ИИ-индустрия немного отошла от шока, вызванного неожиданным триумфом китайской DeepSeek, эксперты пришли к выводу, что отрасли, возможно, придётся пересмотреть методики обучения моделей. Так, исследователи DeepMind заявили о модернизации распределённого обучения, сообщает The Register. Недавно представившая передовые ИИ-модели DeepSeek вызвала некоторую панику в США — компания утверждает, что способна обучать модели с гораздо меньшими затратами, чем, например, OpenAI (что оспаривается), и использованием относительно небольшого числа ускорителей NVIDIA. Хотя заявления компании оспариваются многими экспертами, индустрии пришлось задуматься — насколько эффективно тратить десятки миллиардов долларов на всё более масштабные модели, если сопоставимых результатов можно добиться в разы дешевле, с использованием меньшего числа энергоёмких ЦОД. Дочерняя структура Google — компания DeepMind опубликовала результаты исследования, в котором описывается методика распределённого обучения ИИ-моделей с миллиардами параметров с помощью удалённых друг от друга кластеров при сохранении необходимого уровня качества обучения. В статье «Потоковое обучение DiLoCo с перекрывающейся коммуникацией» (Streaming DiLoCo with overlapping communication) исследователи развивают идеи DiLoCo (Distributed Low-Communication Training или «распределённое обучение с низким уровнем коммуникации»). Благодаря этому модели можно будет обучать на «островках» относительно плохо связанных устройств.

Источник изображения: Igor Omilaev/unsplash.com Сегодня для обучения больших языковых моделей могут потребоваться десятки тысяч ускорителей и эффективный интерконнект с большой пропускной способностью и низкой задержкой. При этом расходы на сетевую часть стремительно растут с увеличением числа ускорителей. Поэтому гиперскейлеры вместо одного большого кластера создают «острова», скорость сетевой коммуникации и связность внутри которых значительно выше, чем между ними. DeepMind же предлагает использовать распределённые кластеры с относительно редкой синхронизацией — потребуется намного меньшая пропускная способность каналов связи, но при этом без ущерба качеству обучения. Технология Streaming DiLoCo представляет собой усовершенствованную версию методики с синхронизацией подмножеств параметров по расписанию и сокращением объёма подлежащих обмену данных без потери производительности. Новый подход, по словам исследователей, требует в 400 раз меньшей пропускной способности сети. Важность и потенциальную перспективность DiLoCo отмечают, например, и в Anthropic. В компании сообщают, что Streaming DiLoCo намного эффективнее обычного варианта DiLoCo, причём преимущества растут по мере масштабирования модели. В результате допускается, что обучение моделей в перспективе сможет непрерывно осуществляться с использованием тысяч разнесённых достаточно далеко друг от друга систем, что существенно снизит порог входа для мелких ИИ-компаний, не имеющих ресурсов на крупные ЦОД. В Gartner утверждают, что методы, уже применяемые DeepSeek и DeepMind, уже становятся нормой. В конечном счёте ресурсы ЦОД будут использоваться всё более эффективно. Впрочем, в самой DeepMind рассматривают Streaming DiLoCo лишь как первый шаг на пути совершенствования технологий, требуется дополнительная разработка и тестирование. Сообщается, что возможность объединения многих ЦОД в единый виртуальный мегакластер сейчас рассматривает NVIDIA, часть HPC-систем которой уже работает по схожей схеме.

03.02.2025 [15:21], Сергей Карасёв

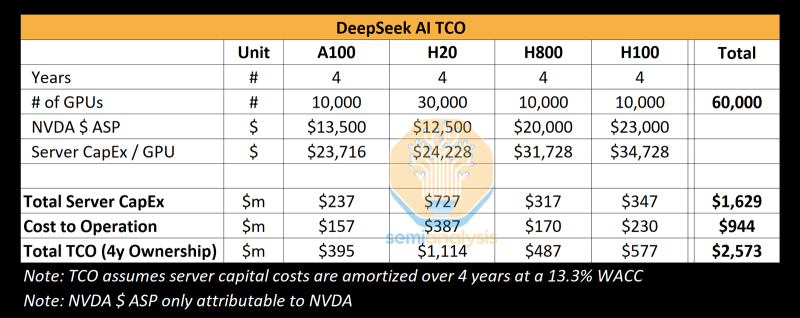

Реальные затраты DeepSeek на создание ИИ-моделей на порядки выше заявленных, но достижений компании это не умаляетКитайский стартап DeepSeek наделал много шума в Кремниевой долине, анонсировав «рассуждающую» ИИ-модель DeepSeek R1 c 671 млрд параметров. Утверждается, что при её обучении были задействованы только 2048 ИИ-ускорителей NVIDIA H800, а затраты на данные работы составили около $6 млн. Это бросило вызов многим западным конкурентам, таким как OpenAI, а акции ряда крупных ИИ-компаний начали падать в цене. Однако, как сообщает ресурс SemiAnalysis, фактические расходы DeepSeek на создание ИИ-инфраструктуры и обучение нейросетей могут быть гораздо выше. Стартап DeepSeek берёт начало от китайского хедж-фонда High-Flyer. В 2021 году, ещё до введения каких-либо экспортных ограничений, эта структура приобрела 10 тыс. ускорителей NVIDIA A100. В мае 2023 года с целью дальнейшего развития направления ИИ из High-Flyer была выделена компания DeepSeek. После этого стартап начал более активное расширение вычислительной ИИ-инфраструктуры. По данным SemiAnalysis, на сегодняшний день DeepSeek имеет доступ примерно к 10 тыс. изделий NVIDIA H800 и 10 тыс. NVIDIA H100. Кроме того, говорится о наличии около 30 тыс. ускорителей NVIDIA H20, которые совместно используются High-Flyer и DeepSeek для обучения ИИ, научных исследований и финансового моделирования. Таким образом, в общей сложности DeepSeek может использовать до 50 тыс. ускорителей NVIDIA при работе с ИИ, что в разы больше заявленной цифры в 2048 ускорителей. Кроме того, SemiAnalysis сообщает, что общие капитальные затраты на ИИ-серверы для DeepSeek составили около $1,6 млрд, тогда как операционные расходы могут достигать $944 млн. Это подрывает заявления о том, что DeepSeek заново изобрела процесс обучения ИИ и инференса с существенно меньшими инвестициями, чем лидеры отрасли. Цифра в $6 млн не учитывает затраты на исследования, тюнинг модели, обработку данных и пр. На самом деле, как подчёркивается, DeepSeek потратила более $500 млн на разработки с момента своего создания. И всё же DeepSeek имеет ряд преимуществ перед другими участниками глобального ИИ-рынка. В то время как многие ИИ-стартапы полагаются на внешних поставщиков облачных услуг, DeepSeek эксплуатирует собственные дата-центры, что позволяет быстрее внедрять инновации и полностью контролировать разработку, оптимизируя расходы. Кроме того, DeepSeek остаётся самофинансируемой компанией, что обеспечивает гибкость и позволяет более оперативно принимать решения. Плюс к этому DeepSeek нанимает специалистов исключительно из Китая, уделяя особое внимание не формальным записям в аттестатах, а практическим навыкам работы и способностям эффективно выполнять поставленные задачи. Некоторые ИИ-исследователи в DeepSeek зарабатывают более $1,3 млн в год, что говорит об их высочайшей квалификации.

30.12.2024 [12:56], Сергей Карасёв

Firefly представила серверы CSB1-N10 для создания ИИ-кластеров из одноплатных компьютеровКомпания Firefly Technology, по сообщению ресурса CNX-Software, выпустила серверы серии CSB1-N10 для построения ИИ-кластеров. Устройства, выполненные в форм-факторе 1U, подходят для дата-центров, периферийных развёртываний и локальных площадок. В семейство вошли пять моделей: CSB1-N10S1688, CSB1-N10R3588, CSB1-N10R3576, CSB1-N10NOrinNano и CSB1-N10NOrinNX. Узлы систем оснащены соответственно процессором Sophgo Sophon BM1688 (8 ядер, до 1,6 ГГц), Rockchip RK3588 (8 ядер, до 2,4 ГГц), Rockchip RK3576 (8 ядер, до 2,2 ГГц), NVIDIA Jetson Orin Nano (6 ядер, до 1,5 ГГц) и Jetson Orin NX (8 ядер, до 2,0 ГГц). Первые три из перечисленных узлов комплектуются оперативной памятью LPDDR4 объёмом 8, 16 и 8 Гбайт соответственно, а также флеш-модулем eMMC вместимостью 32, 256 и 64 Гбайт. Варианты Orin оборудованы 8 и 16 Гбайт памяти LPDDR5 и накопителем NVMe SSD на 256 Гбайт. Все серверы содержат десять вычислительных узлов и дополнительный управляющий узел на чипе RK3588. Присутствует слот для SSD с интерфейсом SATA-3. В оснащение входят по два сетевых порта 10GbE (SFP+) и 1GbE (RJ45), выделенный сетевой порт управления 1GbE, аналоговый разъём D-Sub (1080p60), два порта USB 3.0, а также последовательный порт. Применяется воздушное охлаждение. За питание отвечает блок мощностью 550 Вт. Диапазон рабочих температур — от 0 до +45 °C. Кластер на базе CSB1-N10S1688 обеспечивает ИИ-производительность до 160 TOPS на операциях INT8. В случае CSB1-N10R3588 и CSB1-N10R3576 это показатель составляет 60 TOPS. Эти три системы поддерживают работу с большими языковыми моделями (LLM), а также фреймворками TensorFlow, PyTorch, PaddlePaddle, ONNX, Caffe. В случае CSB1-N10NOrinNano и CSB1-N10NOrinNX быстродействие достигает 400 и 1000 TOPS. Говорится о поддержке LLaMa3 и Phi-3 Mini, фреймворков TensorFlow, PyTorch, Matlab и др. Цена варьируется от $2059 до $14 709. |

|