Материалы по тегу: cerebras

|

21.02.2026 [15:03], Сергей Карасёв

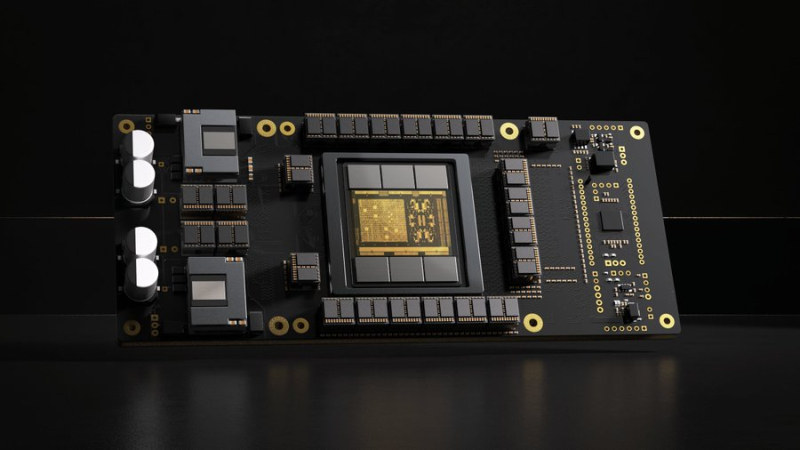

G42 из ОАЭ и Cerebras построят в Индии национальный ИИ-суперкомпьютер с царь-ускорителями WSE-3Холдинг G42 из Абу-Даби (ОАЭ) и компания Cerebras в партнёрстве с Университетом искусственного интеллекта им. Мохаммеда бин Зайеда (MBZUAI) и Индийским центром развития передовых вычислительных технологий (C-DAC) развернут в Индии национальный ИИ-суперкомпьютер. Технические подробности проекта не раскрываются. Отмечается лишь, что система обеспечит ИИ-производительность на уровне 8 Эфлопс (точность вычислений не указана). Комплекс, размещённый на территории Индии, будет эксплуатироваться в соответствии с местными требованиями к безопасности, а все обрабатываемые данные останутся в национальной юрисдикции. Иными словами, речь идёт о формировании суверенной вычислительной платформы. Как отмечает The Register, в основу суперкомпьютера лягут ускорители Cerebras WSE-3. Эти изделия содержат 4 трлн транзисторов, 900 тыс. ядер и 44 Гбайт SRAM. Суммарная пропускная способность встроенной памяти достигает 21 Пбайт/с. Производительность составляет до 125 Пфлопс на операциях FP16. Таким образом, в составе НРС-системы могут быть задействованы 64 экземпляра Cerebras WSE-3.

Источник изображения: G42 После ввода в эксплуатацию новый суперкомпьютер станет доступен широкому кругу пользователей в Индии — от ведущих научных организаций, институтов и государственных структур до стартапов, малых и средних предприятий. Ожидается, что появление системы позволит ускорить инновации в области ИИ. «Суверенная инфраструктура ИИ становится важнейшим компонентом национальной конкурентоспособности. Новый проект предоставит Индии такую платформу, позволив местным исследователям и предприятиям внедрять ИИ, обеспечивая при этом полную безопасность данных», — заявил Ману Джайн (Manu Jain), генеральный директор G42 India. Нужно отметить, что в Индии активно развивается инфраструктуры для ИИ-вычислений. В частности, индийские Tata Group, Tata Consultancy Services (TCS) и OpenAI намерены развернуть в стране ИИ ЦОД мощностью до 1 ГВт. Вместе с тем индийский конгломерат Adani вложит $100 млрд в создание ЦОД общей мощностью 5 ГВт, снабжаемых возобновляемой энергией.

06.02.2026 [11:04], Руслан Авдеев

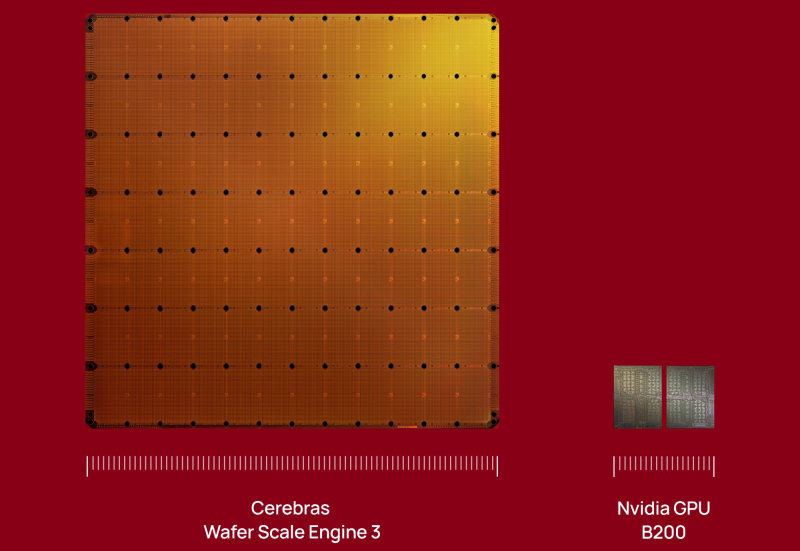

Cerebras привлекла ещё $1 млрд инвестиций после сделки с OpenAIЧерез четыре месяца после завершения раунда финансирования в объёме $1,1 млрд Cerebras Systems заявила о привлечении ещё $1 млрд, во многом от прежних инвесторов, сообщает Datacenter Dynamics. Сделку серии H возглавила Tiger Global, к ней присоединились AMD, Fidelity Management, Atreides Management, Alpha Wave Global, Altimeter, Coatue, 1789 Capital и другие компании. Сегодня оценка рыночной капитализации Cerebras составляет $23 млрд. Новый раунд привлечения средств объявлен через несколько недель после того, как компания заключила с OpenAI сделку на $10 млрд. Cerebras сегодня предлагает суперчип WSE-3 с 4 трлн транзисторов, это в 19 раз больше, чем может обеспечить NVIDIA Blackwell B200. Чип включает 44 Гбайт SRAM, что, как считается, позволяет добиться большей скорости инференса и меньше зависеть от поставок всё более дефицитных HBM и DDR.

Источник изображения: Cerebras В сентябре 2024 года Cerebras подала заявку на IPO. Тогда компания сообщала, что в I полугодии 2024 года её выручка составила $136,4 млн, это более чем в 10 раз выше год к году. Убытки за тот же период сократились с $77,8 млн до $66,6 млн. В 2025 году компания отозвала заявку на IPO, посчитав, что документ более не отражает состояние бизнеса. В частности, в 2025 году значительно выросла выручка и теперь компания рассчитывает повторно подать документы для выхода на биржу уже во II квартале 2026 года.

03.02.2026 [17:15], Руслан Авдеев

OpenAI не устроили чипы NVIDIA для инференса, теперь она ищет альтернативыПо данным многочисленных отраслевых источников, компания OpenAI недовольна некоторыми ИИ-чипами NVIDIA и с прошлого года ищет им альтернативы. Потенциально это усложнит отношения между крупнейшими игроками рынка на фоне бума ИИ, сообщает Reuters. Изменения стратегии OpenAI связаны с усилением акцента на инференсе. NVIDIA доминирует в нише ускорителей для обучения ИИ-моделей, но теперь инференс стал отдельным рынком с сильной конкуренцией. Решение OpenAI — вызов доминированию NVIDIA в сфере ИИ и препятствие $100-млрд сделки между компаниями, обеспечивающей разработчику чипов долю в ИИ-стартапе в обмен на доступ к передовым ускорителям. Предполагалось, что сделка будет закрыта за недели, но вместо этого переговоры ведутся месяцами. В то же время OpenAI заключила соглашение с AMD и Cerebras (её в своё время даже хотели купить) для получения «альтернативных» чипов, а также разрабатывает собственный ИИ-ускоритель при участии Broadcom. Amazon тоже не прочь предоставить OpenAI собственные ускорители, равно как и Google. Изменение планов OpenAI изменило и потребности в вычислительных мощностях и замедлило переговоры с NVIDIA. В минувшую субботу глава NVIDIA Дженсен Хуанг (Jensen Huang) опроверг слухи о проблемах с OpenAI, назвав их «чепухой» и подчеркнув, что клиенты продолжают выбирать NVIDIA для инференса, поскольку компания обеспечивает наилучшее соотношение производительности и совокупной стоимости владения, причём в больших масштабах. Отдельно представитель OpenAI заявлял, что компания полагается на NVIDIA для поставок большинства чипов для инференса, причём именно NVIDIA обеспечивает наилучшую производительность на каждый вложенный доллар. Глава OpenAI Сэм Альтман (Sam Altman) отметил, что NVIDIA выпускает «лучшие чипы в мире» и есть надежда, что OpenAI останется её «гигантским» клиентом очень долгое время. При этом, как сообщает Reuters со ссылкой на семь источников, OpenAI не удовлетворена производительностью инференса, на которую способны чипы NVIDIA. В частности, речь идёт о специализированных задачах вроде разработки ПО с помощью ИИ и коммуникаций ИИ с другим ПО. По данным одного из источников, компании понадобится новое аппаратное обеспечение, которое в конечном счёте обеспечит в будущем порядка 10 % вычислительных мощностей для инференса. OpenAI обсуждала возможности работы с ИИ-стартапами, включая Cerebras и Groq для обеспечения чипов с более быстрым инференсом, но NVIDIA фактически поглотила Groq на $20 млрд, что привело к прекращению переговоров с компанией. Хотя формально речь идёт неэксклюзивном лицензировании технологий Groq, что в теории позволяет сторонним компаниям получить доступ к решениям Groq, фактически все разработчики перешли в NVIDIA, а оставшаяся небольшая команда отвечает за выполнение облачных контрактов с имеющимися заказчиками. Чипы NVIDIA хорошо подходят для обработки больших объёмов данных при обучении больших ИИ-моделей вроде тех, что стоят за ChatGPT. Тем не менее прогресс требует массового использования уже обученных моделей для дальнейшего инференса и ИИ-рассуждений. Как сообщается, OpenAI с 2025 года ищет альтернативы ускорителям NVIDIA с упором на компании, создающие чипы с большими объёмами интегрированной SRAM. Maia 200 от Microsoft, по-видимому, компании не очень подходит. Инференс моделей более требователен к памяти, чем обучение, а вычислительная нагрузка, наоборот, не так велика. В тоге нередко на доступ к данным уходит больше времени, чем на расчёты. NVIDIA и AMD полагаются на внешнюю память, что замедляет соответствующие процессы общения с чат-ботами. В OpenAI проблемы отметили при эксплуатации системы Codex, активно продвигаемой компанией для создания кода. В компании считают, что некоторые слабости системы связаны именно с оборудованием NVIDIA. Конкуренты OpenAI полагаются на альтернативное оборудование. Anthropic активно использует AWS Trainium и Google TPU, а Google уже много лет использует свои TPU, которые с недавних пор готова отдавать на сторону. TPU оптимизированы в том числе для инференса и в некоторых отношениях более производительны, чем GPU общего назначения AMD и NVIDIA. Когда OpenAI недвусмысленно выразила отношение к технологиям NVIDIA, та предложила компаниям, создающим ускорители с упором на SRAM, включая Cerebras и Groq, купить их бизнес. Cerebras отказалась и заключила прямую сделку с OpenAI. Groq вела переговоры с OpenAI о предоставлении вычислительных мощностей, что вызвало интерес у инвесторов, оценивших капитализацию компании на уровне $14 млрд.

15.01.2026 [09:09], Владимир Мироненко

Инвесторы вкладывают сотни миллионов долларов в Etched и Cerebras в надежде, что они потеснят NVIDIA на рынке ИИЛидирующие позиции NVIDIA на рынке ИИ-ускорителей кажутся незыблемыми на долгие годы, но, как полагает ресурс SiliconANGLE, ей следует присмотреться к ближайшим конкурентам, которые пока не «дышат в спину», но стремительно наращивают свои возможности, получая солидную финансовую поддержку для роста. Согласно данным источников Bloomberg (официального сообщения пока не поступало), стартап Etched, занимающийся разработкой ИИ-чипов, привлёк около $500 млн в новом раунде финансирования, благодаря чему оценка его рыночной стоимости составила $5 млрд. Ещё более крупный конкурент NVIDIA, компания Cerebras Systems, по данным The Information, ведёт переговоры о привлечении $1 млрд инвестиций в рамках очередного раунда финансирования при оценке капитализации в $22 млрд. Всего лишь три месяца назад она уже получила $1,1 млрд при оценке в $8,1 млрд, в очередной раз перенеся IPO. По данным источников The Information, компания всё же выйдет на биржу в ближайшие месяцы. Сделка с OpenAI снизит её зависимость от базирующейся в ОАЭ компании G42. Как сообщают источники, нынешний раунд финансирования Etched возглавила компания Stripes при участии миллиардера Питера Тиля (Peter Thiel), а также компаний Positive Sum и Ribbit Capital. Ранее в инвестировании стартапа принимали участие Primary Venture Partners и известные бизнес-ангелы, такие как генеральный директор GitHub Томас Домке (Thomas Dohmke) и бывший руководитель Coinbase Баладжи Сринивасан (Balaji Srinivasan). По словам источников, с учётом этого раунда общая сумма привлечённых средств Etched приблизилась к $1 млрд. Это довольно внушительный финансовый резерв для стартапа, существующего всего два года. Etched создал Sohu — узкоспециализированный ASIC разработанный специально для инференса ИИ-моделями на архитектуре трансформеров. При разработке чипа Etched сотрудничала с группой Emerging Businesses компании TSMC, что свидетельствует как о технических амбициях, так и о производственной надёжности. Также к участию в проекте привлекли специалистов, ранее работавших в таких компаниях, как Cypress Semiconductor и Broadcom. В свою очередь, Cerebras Systems получила известность благодаря своим царь-чипам WSE, которые, по словам компании, значительно быстрее и энергоэффективнее решений NVDIA в ИИ-задачах. В отличие от Etched, Cerebras активно наращивает клиентскую базу, не только развёртывая оборудование, но и предоставляя услуги облачных ИИ-вычислений. Среди её клиентов — Meta✴, IBM и Mistral AI.

15.01.2026 [01:05], Игорь Осколков

$10 млрд за 750 МВт ИИ-мощностей: OpenAI подписала сделку с CerebrasOpenAI подписала многолетнее соглашение с разработчиком царь-ускорителей Cerebras, который до 2028 поставит 750 МВт вычислительных мощностей. По данным CNBC, сумма сделки превышает $10 млрд. Идёт ли речь о продаже ИИ-ускорителей или предоставлении сервисов инференса, пока не уточняется. «Вычислительная стратегия OpenAI заключается в создании отказоустойчивого портфеля, в рамках которого для различных рабочих нагрузок подбираются подходящие системы», — сообщила OpenAI, отметив высокую скорость инференса решений Cerebras, что ускорит генерацию ответов, обеспечит более естественное взаимодействие и позволит масштабировать использование ИИ в реальном времени для гораздо большего числа людей. OpenAI использует комбинацию ускорителей AMD и NVIDIA, а также строит гигантские ЦОД на базе решений последней в рамках проекта Stargate. Кроме того, OpenAI сотрудничает с Google, у которой есть ускорители TPU, а также разрабатывает собственные ИИ-чипы в партнёрстве с Broadcom. Наконец, компания может повлиять на разработку нового поколения фирменных ускорителей Microsoft Maia. AWS тоже не прочь дать OpenAI свои ИИ-ускорители Trainium, но пока компании договорились лишь о масштабной аренде чипов NVIDIA. Примечательно, что OpenAI ещё в 2017 году раздумывала, не купить ли Cerebras при участии Tesla, глава которой Илон Маск (Elon Musk) тогда всё ещё работал в OpenAI. На тот момент Cerebras было всего два года, а свой первый ускоритель WSE она представила только в 2019 году. Серьёзную поддержку компании оказала G42 из ОАЭ, но в итоге Cerebras оказалась от неё слишком зависима, так что сделка с OpenAI сыграет компании на руку в преддверии всё откладывающегося выхода на биржу.

06.10.2025 [14:41], Руслан Авдеев

Разработчик царь-ускорителей Cerebras Systems отозвал заявку на IPOCerebras Systems решила отозвать заявку о выходе на публичные торги — информация об IPO компании впервые появилась около года назад. Оператор ЦОД и разработчик ИИ-чипов сообщил, что документы об IPO ещё не были одобрены регуляторами, сообщает Bloomberg. Всего несколько дней назад компания закрыла раунд финансирования G на $1,1 млрд, что подняло её стоимость до $8,1 млрд. На тот момент руководство заявляло, что привлечённые средства никак не скажутся на планах выхода на публичные торги. Сообщалось, что они будет потрачены на расширение технологического портфолио, включая разработку ИИ-ускорителей, упаковку, создание ИИ-суперкомпьютеров и др. Раунд финансирования Cerebras стал последним в череде инвестиций в технологическую индустрию, которая тратит миллиарды на новую ИИ-инфраструктуру, призванную преобразить мировую экономику. В последние недели на рынке IPO в США наблюдается оживление. В частности, успешно дебютировали технологические компании Netskope и Figure Technology Solutions, акции которых выросли более чем на 20 % от цены размещения.

Источник изображения: Cerebras Cerebras подала заявку о выходе на IPO в сентябре 2024 года, но выход на биржу так и не состоялся. Это связывается с позицией американских регуляторов, занявшихся расследованием инвестиций G42 из Абу-Даби на $335 млн. 87 % выручки Cerebras за первые шесть месяцев 2024 года поступили от G42, а строящиеся в США дата-центры предназначены для использования именно компанией из ОАЭ, имеющей связи с Китаем. Впрочем, в марте Cerebras объявила, что разрешила все спорные вопросы с регулятором CFIUS. Последний раунд финансирования возглавили Fidelity Management & Research и Atreides Management. В числе инвесторов — Tiger Global, Valor Equity Partners и венчурный капиталист 1789 Capital, также приняли участие и прежние инвесторы, включая Altimeter Capital Management and Benchmark. На днях Cerebras запустила новый ЦОД в Оклахома-Сити (Oklahoma City, Оклахома) при сотрудничестве со Scale Datacenters. Также компания имеет действующие кластеры для инференса в Санта-Кларе (Santa Clara) и Стоктоне (Stockton) в Калифорнии (последний в плавучем ЦОД Nautilus), а также в Далласе (Dallas, Техса). Также компания создаёт кластеры в Миннеаполисе (Миннесота), Монреале (Канада) на объекте Bit Digital, а также в некоторых локациях на Среднем Западе США и в Европе. Компания внедрила оборудование в Эдинбургском университете (University of Edinburgh), Сандийскийх национальных лабораториях (Sandia National Labs), в лабораториях Лос-Аламоса (Los Alamos Labs), на мощностях G42/Core42 и др.

02.10.2025 [09:22], Владимир Мироненко

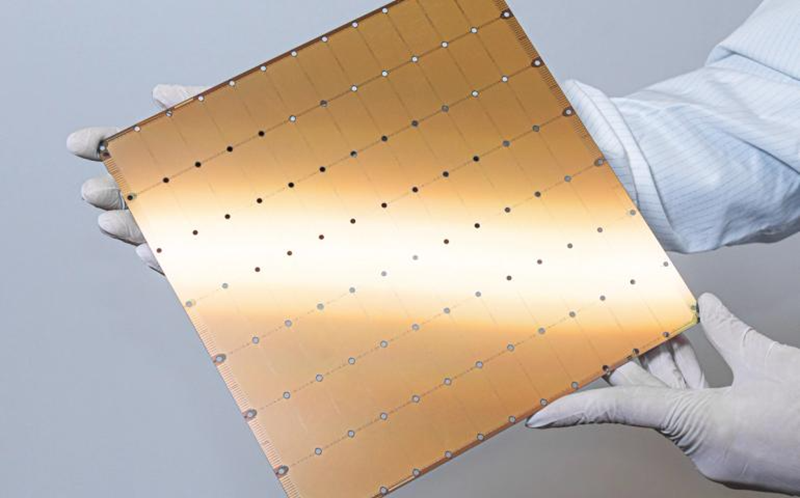

Cerebras привлекла $1,1 млрд инвестиций, получив оценку более $8 млрдАмериканский разработчик ИИ-ускорителей Cerebras Systems сообщил о привлечении $1,1 млрд инвестиций в рамках раунда финансирования серии G, в результате чего его оценка достигла $8,1 млрд, сообщил SiliconANGLE. Компания утверждает, что её ИИ-ускорители в несколько раз быстрее чипов NVIDIA. В числе клиентов Cerebras такие компании, как Meta✴, IBM и Mistral AI. Раунд возглавили Fidelity Management & Research и Atreides Management, к которым присоединились известные венчурные компании, включая Tiger Global, Valor Equity Partners и 1789 Capital. В раунде также приняли участие существующие инвесторы Altimeter, Alpha Wave и Benchmark. Генеральный директор Эндрю Фельдман (Andrew Feldman) сообщил, что привлечённые инвестиции будут направлены в расширение сети ЦОД и дальнейшую разработку «железа» и ПО. Он добавил, что это не повлияет на планы компании по выходу на биржу, пишет Bloomberg. Как считает ресурс The Next Platform, теперь у Cerebras благодаря новому финансированию гораздо больше времени для расширения и диверсификации клиентской базы, чтобы сделать IPO более привлекательным. Согласно прогнозу The Next Platform, компания выйдет на биржу в следующем году. В сентябре прошлого года Cerebras подала заявку на первичное публичное размещение акций (IPO) в Комиссию по ценным бумагам и биржам США (SEC), но столкнулась с проблемами в получении разрешения Комитета по иностранным инвестициям Министерства финансов США (CFIUS) на его проведение из-за чрезмерной зависимости от одного клиента — компании G42 из Абу-Даби (ОАЭ), которую подозревали в связях с КНР. В марте Cerebras сообщила, что урегулировала с CFIUS все вопросы, а позже Фельдман заявил, что Cerebras по-прежнему нацелена на IPO. В то время как поставщики GPU, включая NVIDIA и AMD, соревнуются в гонке за то, сколько чипов с ограниченной матрицей площадью около 800 мм² они могут разместить на сокет вычислительного устройства, Cerebras со старта ограничена размерами кремниевых пластин. Отрасль остановилась на выпуске пластин диаметром 300 мм, т.к. задача по выпуску 450-мм пластин оказалась экономически нецелесообразной. Если бы Cerebras могла использовать 450-мм пластины, производительность её царь-ускорителей Wafer Scale Engines выросла бы в 2,25 раза без какого-либо изменения технологического процесса. Аналитики ресурса The Next Platform считают, что Cerebras, необходимо обнародовать планы до 2032 года, прежде чем она станет публичной. Это позволит укрепить доверие инвесторов. NVIDIA опубликовала планы до 2028 года, и все инвесторы знают, чего ожидать от неё в ближайшем будущем. В дальнейшем Cerebras сможет адаптировать планы с учётом сложившейся ситуации, как это сделала NVIDIA с выпуском чипа Rubin CPX, которого изначально в её планах не было. UPD 04.10.2025: Cerebras отказалась от IPO и отозвала заявку в Комиссию по ценным бумагам и биржам США (SEC).

29.09.2025 [14:00], Руслан Авдеев

315 млн ИИ-ядер и 1,4 квадрлн транзисторов: Cerebras открыла в США 10-МВт ЦОД на царь-чипах WSE-3Разработчик ИИ-ускорителей Cerebras Systems развернул новый дата-центр в Оклахома-Сити — столице штата Оклахома (США). Объект мощностью 10 МВт создан совместно со Scale Datacenters, сообщает Datacenter Dynamics. На объекте применяются замкнутые системы прямого жидкостного охлаждения. По данным компании, каждый потреблённый киловатт-час компенсируется покупкой энергии из возобновляемых источников. По словам представителя Cerebras, в 2023 году компания построила свой первый ИИ-суперкомпьютер Andromeda с 13,5 млн ИИ-ядер, на тот момент — крупнейший в своём роде. Новый кластер в Оклахома-Сити на базе систем CS-3 с царь-чипами WSE-3 обеспечивает ИИ-производительность 44 Эфлопс (точность вычислений не указана) и поддерживает крупнейшие из когда-либо созданных ИИ-моделей. Кластер включает 315 млн ИИ-ядер и 1,4 квадрлн транзисторов. Scale Datacenter подготовила для Cerebras саму площадку и сопутствующую инфраструктуру. В Scale подчеркнули, что рады сотрудничеству с Cerebras, оно позволит создать в Оклахома-Сити ИИ-инфраструктуру мирового класса. В мае 2025 года появилась информация о покупке Scale Datacenter ЦОД площадью 7,6 тыс. м2 в Оклахома-Сити у компании Expand Energy. Ранее Cerebras объявила о намерении запустить шесть новых ИИ ЦОД в Северной Америке и Европе, в том числе с использованием более 300 систем CS-3 на объекте в Оклахома-Сити. У Cerebras есть кластеры для инференса в Санта-Кларе (Santa Clara) и Стоктоне (Stockton) в Калифорнии, последний расположен на барже-ЦОД Nautilus. Также имеется объект в Далласе (Dallas, Техас). Компания занимается созданием собственных кластеров в Миннеаполисе (Minneapolis, Миннесота), Монреале (Montreal, Канада — на объекте Bit Digital), а также в некоторых локациях на Среднем Западе США и в Европе. Cerebras уже разместила оборудование в Эдинбургском университете, Сандийских национальных лабораториях (США), лабораториях Лос-Аламоса, мощностях G42/Core42, и др.

06.08.2025 [16:30], Руслан Авдеев

Cerebras Systems может привлечь частное финансирование на $1 млрд, это способно привести к задержке IPOРазрабатывающая гигантские микросхемы компания Cerebras Systems намерена привлечь до $1 млрд частных инвестиций. Это может привести к отсрочке ранее запланированного выхода компании на IPO, сообщает The Information. По сведениям издания, обсуждение дополнительного финансирования продолжается. Если новые меры по привлечению средств будут реализованы, это, вероятно, отсрочит публичное размещение акций Cerebras, которое изначально было запланировано на конец года. В 2024 году компания подала заявку на IPO в Комиссию по ценным бумагам и биржам США (SEC). Цена акций и ожидаемая рыночная капитализация не раскрывались. Тем не менее, компания до сих пор не вышла на биржу, поскольку оказалась под пристальным вниманием регуляторов и спецслужб из-за своих клиентов. На момент подачи заявки 87 % выручки компании за I полугодие 2024 года приходились на компанию G42 из ОАЭ, со штаб-квартирой в Абу-Даби (Abu Dhabi).

Источник изображения: UX Indonesia/unspalsh.com Отмечалось, что соотношение выручки с 2023 года не изменилось. В июле того же года компании анонсировали инвестиции G42 на $900 млн в ИИ-платформу в США на базе суперчипов Cerebras. Кроме того, в марте G42 планировала приобрести более 22 млн акций Cerebras в ходе IPO, однако по запросу регулятора компания изменила условия соглашения: теперь G42 может купить только неголосующие акции. При этом Cerebras и G42 уже открыли дата-центры в Калифорнии, Техасе и Миннесоте. Со временем появилась информация, что выход Cerebras на IPO откладывается из-за нехватки чиновников и подозрениях в тайных связях G42 с Китаем. Ещё в конце 2024 года сообщалось, что США опасаются, что Китай получит доступ к ИИ-суперчипам при посредничестве ОАЭ.

06.05.2025 [21:12], Руслан Авдеев

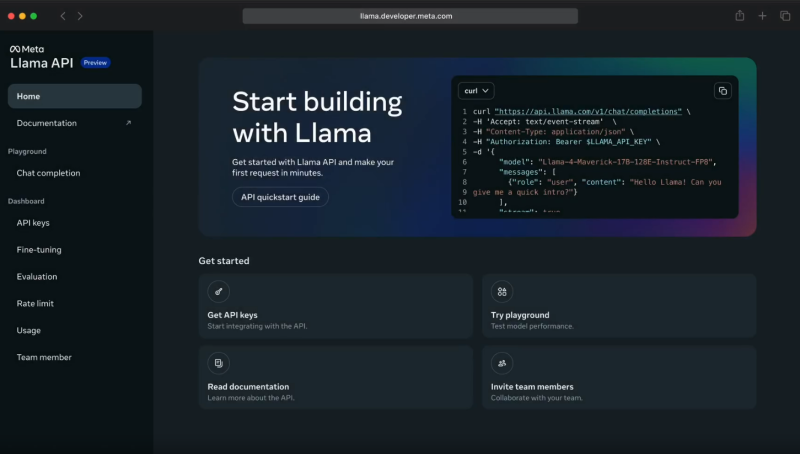

Meta✴ Llama API задействует ИИ-ускорители Cerebras и GroqMeta✴ объединила усилия с Cerebras и Groq для инференс-сервиса с применением API Llama. Открыв API-доступ к собственным моделям, Meta✴ становится чуть более похожа на облачных провайдеров. Как утверждают в Cerebras, разработчики, применяющие API для работы с моделями Llama 4 Cerebras, могут получить скорость инференса до 18 раз выше, чем у традиционных решений на базе GPU. В компании объявили, что такое ускорение позволит использовать новейшее поколение приложений, которые невозможно построить на других ИИ-технологиях. Речь, например, идёт о «голосовых» решениях с низкой задержкой, интерактивной генерации кода, мгновенном многоэтапном рассуждении и т. п. — многие задачи можно решать за секунды, а не минуты. После запуска инференс-платформы в 2024 году Cerebras обеспечила для Llama самый быстрый инференс, обрабатывая миллиарды токенов через собственную ИИ-инфраструктуру. Теперь прямой доступ к альтернативам решений OpenAI получит широкое сообщество разработчиков. По словам компании, партнёрство Cerebras и Meta✴ позволит создавать ИИ-системы, «принципиально недосягаемые для ведущих облаков». Согласно замерам Artificial Analysis, Cerebras действительно предлагает самые быстрые решения для ИИ-инференса, более 2600 токенов/с для Llama 4 Scout.

Источник изображения: Meta✴ При этом Cerebras не единственный партнёр Meta✴. Она также договорилась с Groq об использовании ускорителей Language Processing Units (LPU), которые обеспечивают высокую скорость (до 625 токенов/с), низкую задержку и хорошую масштабируемость при довольно низких издержках. Groq использует собственную вертикально интегрированную архитектуру, полностью контролируя и железо, и софт. Это позволяет добиться эффективности, недоступной в облаках на базе универсальных ИИ-чипов. Партнёрство с Meta✴ усиливает позиции Groq и Cerebras в борьбе с NVIDIA. Для Meta✴ новое сотрудничество — очередной шаг в деле выпуска готовых open source ИИ-моделей, которые позволят сосредоточиться на исследованиях и разработке, фактически передав инференс надёжному партнёру. Разработчики могут легко перейти на новый стек без необходимости дообучения моделей или перенастройки ускорителей — API Llama совместимы с API OpenAI. Пока что доступ к новым API ограничен. Цены Meta✴ также не сообщает. Meta✴ активно работает над продвижением своих ИИ-моделей. Так, она даже выступила с довольно необычной инициативой, предложив «коллегам-конкурентам» в лице Microsoft и Amazon, а также другим компаниям, поделиться ресурсами для развития и обучения моделей Llama. |

|