Материалы по тегу: cerebras

|

10.04.2025 [15:01], Руслан Авдеев

В Эдинбургском университете заработал ИИ-кластер на базе Cerebras CS-3Эдинбургский университет и Cerebras Systems развернули в суперкомпьютерным центре EPCC кластера из четырёх ИИ-систем CS-3 на базе царь-ускорителей WSE-3. Новые мощности являются частью Edinburgh International Data Facility. По словам EPCC, это крупнейший кластер CS-3 в Европе. EPCC уже имеет опыт работы с системами CS-1 и CS-2. В Cerebras заявили, что гордятся расширением сотрудничества с EPCC, которое поможет стать Великобритании одним из ключевых мировых ИИ-хабов. Как заявляют в EPCC, ИИ сегодня изменяет все сферы жизни, поэтому новые системы помогут университетам, государственным организациям и компаниям обучать и использовать ИИ-модели на скоростях и с лёгкостью, недоступной другим ИИ-решениям. Платформы Cerebras оптимизированы не только для масштабного обучения моделей, но и для сверхбыстрого инференса — пользователям кластера теперь доступна платформа-рекордсмен Cerebras AI Inference. Системы CS-3 способны выдавать до 2000 токенов/с для популярных ИИ-моделей.

Источник изображения: Nadia Ramella/unsplash.com С новыми кластерами на основе Cerebras CS-3, EPCC сможет обучать модели от 240 млрд до 1 трлн параметров, а также ежедневно тюнинговать модели с 70 млрд параметров. Лёгкость использования технологий Cerebras позволяет использовать ИИ-модели и в дисциплинах, не относящихся к компьютерным наукам. Технологии Cerebras обеспечивают линейную масштабируемость, что ускоряет инновации и повышает продуктивность команды EPCC, говорится в сообщении. Эдинбургский университет считается одним из лидеров в разработке ИИ-систем в последние 60 лет. Системы CS-2 в распоряжении EPCC уже позволили исследователям разработать высокоэффективное ПО для инференса для больших языковых моделей (LLM) — как для местного применения, так и для помощи исследователям из Индии в разработке ИИ-моделей для материаловедения и из Швейцарии — для адаптации LLM к местному диалекту немецкого языка. Кроме того, платформы CS-3 с миллионами вычислительных ядер позволят продолжить исследования EPCC в областипараллельных вычислений и энергоэффективности.

03.04.2025 [12:50], Руслан Авдеев

Ближневосточный след: Cerebras Systems развеяла сомнения регулятора CFIUS в благонадёжности перед выходом на IPOCerebras Systems, разрабатывающая ИИ-ускорители, объявила о решении основных проблем с Комитетом США по иностранным инвестициям (CFIUS) перед выходом на IPO. Главным предметом беспокойства CFIUS стала связь американского стартапа с компанией G42 из ОАЭ, сообщает The Register. На G42, согласно поданным данным о доходах, пришлось более 87 % выручки Cerebras в I половине 2024 года. При этом с середины 2023 года экспорт ИИ-ускорителей в страны Ближнего Востока строго регулируется США. От разработчиков чипов из США требуется получение экспортных лицензий для продажи товаров в регионе. В результате G42 финансировала строительство ИИ-суперкомпьютеров на основе чипов Cerebras на территории США, а общая сумма проектов составила порядка $900 млн. Компания планировала получать к ним удалённый доступ. В рамках IPO G42 также собиралась купить 22 млн акций Cerebras, что, вероятно, вызвало настороженность CFIUS. Ранее G42 уже привлекала внимание американских властей, опасающихся, что закупающая большие объёмы ускорителей на Ближнем Востоке компания может работать на Китай. В результате G42 была вынуждена разорвать связи с рядом партнёров, включая Huawei, рассчитывая «умиротворить» американских регуляторов и устранить препятствия для сотрудничества с Cerebras и Microsoft.

Источник изображения: Nimisha Mekala/unsplash.com В Cerebras заявили, что компания развеяла опасения CFIUS, внеся поправки в соглашение с G42 — последняя сможет приобретать только «неголосующие» акции, поэтому дальнейшая проверка, вероятно, не потребуется. Впрочем, стороны пока не дают дополнительных комментариев. Тем не менее, руководство Cerebras отметило в одной из социальных сетей, что при тесном сотрудничестве с G42 удалось достичь урегулирования с CFIUS. Новости появились менее чем через неделю после того, как ведущие СМИ сообщили, что дебют Cerebras на фондовом рынке был отложен из-за ожидания новых ключевых назначений в администрации США. Условия IPO пока не разглашаются, но ранее сообщалось, что компания намерена привлечь до $1 млрд, а её капитализация составит $7–8 млрд. G42 останется одним из ключевых клиентов Cerebras, но стартап очевидно ориентирован на диверсификацию клиентской базы благодаря платформе «инференс как сервис» и создание масштабной инфраструктуры в США, Канаде и Франции. К концу 2025 года стартап пообещал развернуть более тысячи ускорителей в шести новых ЦОД. Хотя на первый взгляд это не так много в сравнении сотнями тысяч ускорителей, внедряемых xAI и другими компаниями, стоит отметить, что чипы Cerebras размером с целую кремниевую пластину способны обеспечивать производительность до 125 Пфлопс (FP16) — приблизительно в 62 раза выше, чем у моделей серии NVIDIA H100, применяемых для создания суперкомпьютера Colossus с Мемфисе (Теннесси).

02.04.2025 [11:50], Руслан Авдеев

Царь-чипы с интегрированной фотоникой: Cerebras Systems и Ranovus выбраны DARPA для создания вычислительной платформы нового поколенияИИ-стартап Cerebras Systems выбран американским военно-техническим управлением DARPA для разработки высокопроизводительной вычислительной системы нового поколения. Cerebras объединит собственные ИИ-ускорители и фотонные CPO-интерконнекты Ranovus для обеспечения высокой производительности при малом энергопотреблении, сообщает пресс-центр Cerebras. Комбинация технологий двух компаний позволит обеспечить в реальном времени моделирование сложных физических процессов и выполнение масштабных ИИ-задач. С учётом успеха программы DARPA Digital RF Battlespace Emulator (DRBE), в рамках которой Cerebras уже разрабатывает передовой суперкомпьютер для радиочастотной эмуляции, именно Cerebras и Ranovus были выбраны для новой инициативы, позволяющей объединить вычислительные продукты Cerebras с первыми в отрасли фотонными интерконнектами Ranovus. Решение крайне актуальное, поскольку двумя ключевыми вопросами для современных вычислительных систем являются проблемы с памятью и обменом данных между ускорителями и иной серверной инфраструктурой — вычислительные потребности растут быстрее, чем возможности памяти или IO-систем ввода-вывода. Как утверждают в Cerebras, её WSE-чипы имеют в 7 тыс. раз большую пропускную способность, чем классические ускорители, что даёт самый быстрый в мире инференс и самое быстрое моделирование молекулярных процессов.

Источник изображения: Cerebras В рамках нового плана DARPA стартап Cerebras будет использовать интерконнект Ranovus, что позволит получить производительность, недоступную даже для крупнейших суперкомпьютерных кластеров современности. При этом энергопотребление будет значительно ниже, чем у самых современных решений с использованием коммутаторов. Последние являются одними из самых энергоёмких компонентов в современных ИИ-системах или суперкомпьютерах. Утверждается, что комбинация новых технологий двух компаний позволит искать решения самых сложных задач в реальном времени, будь то ИИ или сложное моделирование физических процессов, на недостижимом сегодня уровне. Подчёркивается, что оставаться впереди конкурентов — насущная необходимость для обороны США, а также местного коммерческого сектора. В частности, это открывает огромные возможности для работы ИИ в режиме реального времени — от обработки данных с сенсоров до симуляции боевых действий и управления боевыми или коммерческими роботами. В Ranovus заявили, что платформа Wafer-Scale Co-Packaged Optics в 100 раз производительнее аналогичных современных решений, что позволяет значительно повысить эффективность ИИ-кластеров, и значительно энергоэффективнее продуктов конкурентов. Партнёрство компаний позволит задать новый стандарт для суперкомпьютерной и ИИ-инфраструктуры, решая задачи роста спроса на передачу и обработку данных и давая возможность реализовать военное и коммерческое моделирование нового поколения. Помимо использования в целях американских военных, гигантские ИИ-чипы Cerebras применяются и оборонными ведомствами других стран. Так, весной 2024 года сообщалось, что продукты компании помогут натренировать ИИ для военных Германии.

26.03.2025 [12:22], Руслан Авдеев

Выход Cerebras на IPO откладывается из-за нехватки чиновников и подозрениях в тайных связях с Китаем ключевого инвестора компанииАмериканский производитель ИИ-ускорителей Cerebras Systems вынужден отложить выход на биржу. IPO задерживается, поскольку компания пока не получила одобрение со стороны одного из американских регуляторов — Комитета по иностранным инвестициям в США (CFIUS), сообщает Reuters. По информации издания, ссылающегося на пять независимых анонимных источников, руководство Cerebras ждёт завершения рассмотрения заявки, а также назначения новых ключевых чиновников. Без разрешения регулятора IPO невозможно, поскольку среди инвесторов — компания G42 из Абу-Даби (ОАЭ), специализирующаяся на облачных технологиях и ИИ. Ранее американские власти уже уделяли внимание этому инвестору из-за его предполагаемых связей с китайским бизнесом. Cerebras неоднократно заявляла, что её решения не просто превосходят по многим характеристикам ускорители NVIDIA, но и являются более экономически эффективными. Впрочем, именно это сыграло против неё. Технологии Cerebras и их значение для национальной безопасности США стали причиной того, что процесс IPO оказался под вопросом или, как минимум, в центре пристального внимания регуляторов. Главной причиной задержки называется отсутствие действующего помощника министра финансов США по вопросам инвестиционной безопасности, который обычно курирует работу CFIUS. Хотя у сотрудников организации есть определённые полномочия для принятия решений, сделку с G42 сочли «политически рискованной». Источники Reuters предполагают, что чиновники решили не торопиться, дожидаясь назначения человека, готового взять на себя ответственность за окончательное решение. Ранее ожидалось, что инвестициям G42 дадут зелёный свет ещё до конца 2024 года, хотя IPO было решено отложить.

Источник изображения: Cerebras В преддверии возможных сложностей Cerebras и G42 заранее внесли поправки в документы для CFIUS, подчеркнув, что G42 получит лишь акции без права голоса. В теории это должно было упростить одобрение сделки. Однако проблема не решилась: в сентябре 2024 года стороны запросили отмену рассмотрения заявки, но окончательное решение в CFIUS пока так и не вынесли. Как сообщает Silicon Angle, ситуацию усугубляет инициатива администрации нового президента США Дональда Трампа (Donald Trump), активно поддерживаемая Илоном Маском (Elon Musk), по сокращению государственных расходов. В рамках нового плана численность сотрудников различных ведомств, включая CFIUS, уменьшится, что замедлит процесс рассмотрения заявок на сделки. Однако, хотя нынешняя оппозиция пытается возложить ответственность на новую администрацию, G42 стала «проблемным» партнёром намного. Так, в апреле 2024 года Microsoft вложила в G42 средства в объёме $1,5 млрд, из-за чего у властей возник ряд вопросов, касающихся возможных связей арабской компании с Китаем. Пока неизвестно, сколько времени потребуется для урегулирования ситуации, но в Cerebras уверены, что сделку в конечном счёте одобрят и компания возобновит подготовку к выходу на IPO.

13.03.2025 [08:50], Руслан Авдеев

Cerebras развернёт царь-ускорители WSE-3 ещё в шести ЦОД во Франции, США и КанадеКомпания Cerebras начала установку более тысячи ИИ-систем CS-3 на базе гигантских ускорителей WSE-3 по всей Северной Америке и во Франции. Компания стремится зарекомендовать себя как поставщика одной из крупнейших и быстрейших облачных инференс-платформ, сообщает The Register. Кроме того, компания объявила о расширении сотрудничества с Hugging Face. К концу 2025 года развернёт свои ускорители в дата-центрах в Техасе, Миннесоте, Оклахоме и Джорджии, а также в Канаде и во Франции. Cerebras будет целиком владеть площадками в Оклахома-Сити (Оклахома) и Монреале (Канада), а оставшиеся объекты будут эксплуатироваться в рамках соглашения с G42 из ОАЭ. Крупнейший в США новый кластер CS-3 разместится в Миннеаполисе (Миннесота), его оснастят 512 CS-3 с общим быстродействием 64 Эфлопс (FP16). Он заработает уже во II квартале 2025 года. Cerebras давно сотрудничает с фондом G42, который активно спонсирует ИИ-стартап и является его якорным заказчиком — на G42 пришлось 83 % от всей выручки Cerebras за 2023 календарный год. Однако именно это сотрудничество привело к тому, что Cerebras вынужденно отложила IPO — власти США опасаются, что Китай получит доступ к ИИ-суперчипам Cerebras при посредничестве ОАЭ. По слухам, G42 заключила сделку с США, отказавшись от работы с Китаем в обмен на инвестиции.

Источник изображения: SNL В ближайшее время Cerebras также намерена расширить API-доступ к своим ускорителям для разработчиков, договорившись с репозиторием моделей Hugging Face. Также Cerebras выиграла контракты с Mistral AI и Perplexity. Недавно объявлено о намерении аналитической платформы AlphaSense заменить трёх поставщиков моделей с закрытым кодом на модель open source, работающую на CS-3. Летом прошлого года было объявлено о партнёрстве с Dell.

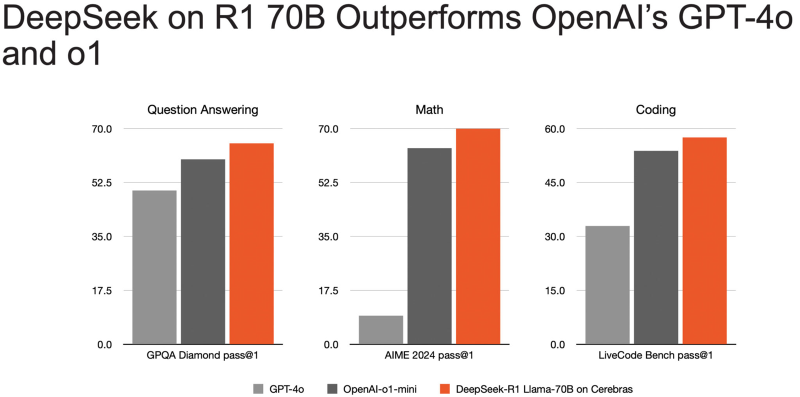

01.02.2025 [15:23], Сергей Карасёв

Самый быстрый инференс DeepSeek R1 в мире: ИИ-платформа Cerebras снова поставила рекорд производительностиАмериканский стартап Cerebras Systems объявил о том, что его инференс-платформа позволила установить мировой рекорд производительности при использовании «рассуждающей» ИИ-модели DeepSeek R1 в модификации с 70 млрд параметров (DeepSeek-R1-Distill-Llama-70B). DeepSeek R1 может содержать до 671 млрд параметров. Однако, как отмечает Cerebras, развёртывание модели со способностью к рассуждению столь большого масштаба представляет значительные проблемы. Версия с 70 млрд параметров позволяет совместить возможности рассуждений более крупной модели с MoE с широко поддерживаемой архитектурой Meta✴ Llama. Основой платформы Cerebras являются царь-ускорители собственной разработки WSE (Wafer Scale Engine). Производительность DeepSeek R1 при работе на инфраструктуре Cerebras достигает 1508 токенов в секунду — это значительно быстрее по сравнению с конкурирующими решениями. В частности, в случае Groq показатель составляет 252 токена в секунду. Стандартный запрос на генерацию кода, который, как утверждает компания, занимает 22 секунды на конкурирующих платформах, в случае Cerebras завершается всего за 1,5 секунды, что соответствует 15-кратному повышению производительности. Cerebras подчёркивает, что DeepSeek-R1-Distill-Llama-70B превосходит как GPT-4o, так и o1-mini в сложных математических задачах и генерации кода. Cerebras также отмечает, что все вычисления осуществляются на базе ИИ-инфраструктуры в США, развёрнутой в собственных дата-центрах компании. При этом никакие данные не сохраняются, что гарантирует полную безопасность для клиентов. Кроме того, модель DeepSeek R1 может быть развёрнута локально в ЦОД заказчика для обеспечения максимального контроля.

12.12.2024 [23:59], Руслан Авдеев

Царь-ускоритель Cerebras WSE-3 в одиночку обучил ИИ-модель с 1 трлн параметровCerebras Systems совместно с Сандийскими национальными лабораториями (SNL) Министерства энергетики США (DOE) провели успешный эксперимент по обучению ИИ-модели с 1 трлн параметров с использованием единственной системы CS-3 с царь-ускорителем WSE-3 и 55 Тбайт внешней памяти MemoryX. Обучение моделей такого масштаба обычно требует тысяч ускорителей на базе GPU, потребляющих мегаватты энергии, участия десятков экспертов и недель на наладку аппаратного и программного обеспечения, говорит Cerebras. Однако учёным SNL удалось добиться обучения модели на единственной системе без внесения изменений как в модель, так и в инфраструктурное ПО. Более того, они смогли добиться и практически линейного масштабирования — 16 систем CS-3 показали 15,3-кратный прирост скорости обучения. Модель такого масштаба требует терабайты памяти, что в тысячи раз больше, чем доступно отдельному GPU. Другими словами, классические кластеры из тысяч ускорителей необходимо корректно подключить друг к другу ещё до начала обучения. Системы Cerebras для хранения весов используют внешнюю память MemoryX на базе 1U-узлов с самой обычной DDR5, благодаря чему модель на триллион параметров обучать так же легко, как и малую модель на единственном ускорителе, говорит компания. Ранее SNL и Cerebras развернули кластер Kingfisher на базе систем CS-3, который будет использоваться в качестве испытательной платформы при разработке ИИ-технологий для обеспечения национальной безопасности.

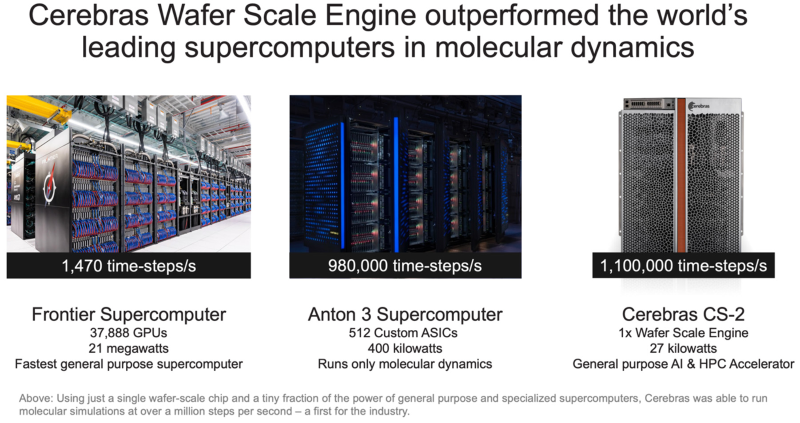

29.11.2024 [10:15], Сергей Карасёв

Система Cerebras с ускорителями WSE установила рекорд в молекулярной динамике, превзойдя суперкомпьютер FrontierАмериканский стартап Cerebras Systems, специализирующийся на создании чипов для систем машинного обучения и других ресурсоёмких задач, объявил об установлении нового мирового рекорда производительности в области молекулярной динамики. В эксперименте приняли участие Сандийские национальные лаборатории (SNL), Ливерморская национальная лаборатория имени Лоуренса (LLNL) и Лос-Аламосская национальная лаборатория (LANL) в составе Министерства энергетики США (DOE). Вычисления выполнялись на системе, оснащённой фирменными ускорителями Cerebras Wafer Scale Engine (WSE). Говорится, что впервые в истории молекулярной динамики исследователи достигли результата более 1 млн шагов моделирования в секунду (timesteps per second, TPS). В частности, показано значение на уровне 1,1 млн TPS на платформе Cerebras CS-2, оборудованной чипами WSE-2, которые насчитывают 850 тыс. тензорных ядер и несут на борту 40 Гбайт памяти SRAM. Для сравнения: в случае суперкомпьютера экзафлопсного класса Frontier, который в нынешнем рейтинге TOP500 занимает второе место, результат составляет 1470 TPS. Таким образом, система Cerebras обеспечивает 748-кратный выигрыш в быстродействии на задачах молекулярной динамики. При этом энергопотребление комплекса Cerebras составляет 27 кВт против 21 МВт у Frontier. Кроме того, комплекс Cerebras превзошел Anton 3 — самый мощный в мире специализированный суперкомпьютер для молекулярной динамики. Anton 3 использует 512 кастомных ASIC, а его энергопотребление находится на уровне 400 кВт. Показатель быстродействия Anton 3 достигает 980 тыс. TPS. То есть, система Cerebras показывает выигрыш примерно в 20 %. Предполагается, что ускорители Cerebras предоставят качественно новые возможности для исследований в различных областях, включая разработку материалов следующего поколения, перспективных лекарственных препаратов и решений в сфере возобновляемой энергетики. Нужно отметить, что ранее Сандийские национальные лаборатории запустили ИИ-систему Kingfisher на чипах Cerebras WSE-3. А сама компания Cerebras развернула «самую мощную в мире» ИИ-платформу для инференса.

18.11.2024 [10:59], Сергей Карасёв

OpenAI раздумывала, не купить ли разработчика ИИ-ускорителей Cerebras при участии TeslaКомпания OpenAI, по информации ресурса TechCrunch, изучала возможность приобретения американского стартапа Cerebras Systems, специализирующегося на разработке ИИ-ускорителей. Такие сведения вскрылись в рамках судебного процесса по иску Илона Маска (Elon Musk) против OpenAI. Маск является одним из основателей OpenAI — он покинул эту компанию в 2018 году. В начале августа нынешнего года Маск подал в суд на OpenAI и её генерального директора Сэма Альтмана (Sam Altman), обвинив их в нарушении прав и интересов, а также во введении в заблуждение. Как теперь сообщается, в электронном письме, адресованном Альтману и Маску, Илья Суцкевер (Ilya Sutskever), один из соучредителей OpenAI и бывший главный научный сотрудник компании, обсуждал идею покупки Cerebras через Tesla. В другом письме от июля 2017 года Суцкевер затрагивает ряд вопросов, связанных с Cerebras, таких как переговоры об условиях слияния и проверка благонадёжности финансового состояния Cerebras. «Если мы решим купить Cerebras, я твердо уверен, что это будет сделано через Tesla. Но зачем делать это таким образом, если мы могли бы провести сделку изнутри OpenAI? В частности, вызывает беспокойство то, что Tesla имеет обязательство перед акционерами максимизировать их доход, что не соответствует миссии OpenAI», — написал Суцкевер. Cerebras создаёт ИИ-суперускорители размером с целую кремниевую пластину. Флагманским продуктом стартапа является решение Wafer Scale Engine третьего поколения (WSE-3). Это гигантское изделие содержит 4 трлн транзисторов, 900 тыс. ядер и 44 Гбайт памяти SRAM. Предполагалось, что слияние с OpenAI будет выгодно обеим сторонам. В частности, Cerebras избежала бы сложного пути, связанного с IPO, тогда как OpenAI смогла бы получить в своё распоряжение мощные аппаратные ускорители для ресурсоёмких ИИ-задач. Однако сделка в итоге провалилась, хотя причины сворачивания переговоров не раскрываются.

16.11.2024 [20:49], Сергей Карасёв

Сандийские национальные лаборатории запустили ИИ-систему Kingfisher на огромных чипах Cerebras WSE-3Сандийские национальные лаборатории (SNL) Министерства энергетики США (DOE) в рамках партнёрства с компанией Cerebras Systems объявили о запуске кластера Kingfisher, который будет использоваться в качестве испытательной платформы при разработке ИИ-технологий для обеспечения национальной безопасности. Основой Kingfisher служат узлы Cerebras CS-3, которые выполнены на фирменных ускорителях Wafer Scale Engine третьего поколения (WSE-3). Эти гигантские изделия содержат 4 трлн транзисторов, 900 тыс. ядер и 44 Гбайт памяти SRAM. Суммарная пропускная способность встроенной памяти достигает 21 Пбайт/с, внутреннего интерконнекта — 214 Пбит/с. На сегодняшний день платформа Kingfisher объединяет четыре узла Cerebras CS-3, а конечная конфигурация предусматривает использование восьми таких блоков. Узлы Cerebras CS-3 мощностью 23 кВт каждый содержат СЖО, подсистемы питания, сетевой интерконнект Ethernet и другие компоненты.

Источник изображения: SNL Развёртывание кластера Cerebras CS-3 является частью программы Advanced Simulation and Computing (ASC), которая реализуется Национальным управлением по ядерной безопасности США (NNSA). Речь идёт, в частности, об инициативе ASC Artificial Intelligence for Nuclear Deterrence (AI4ND) — искусственный интеллект для ядерного сдерживания. Предполагается, что Kingfisher позволит разрабатывать крупномасштабные и надёжные модели ИИ с использованием защищённых внутренних ресурсов Tri-lab — группы, в которую входят Сандийские национальные лаборатории, Ливерморская национальная лаборатория имени Лоуренса (LLNL) и Лос-Аламосская национальная лаборатория (LANL) в составе (DOE). |

|