Материалы по тегу: cerebras

|

28.10.2024 [11:48], Сергей Карасёв

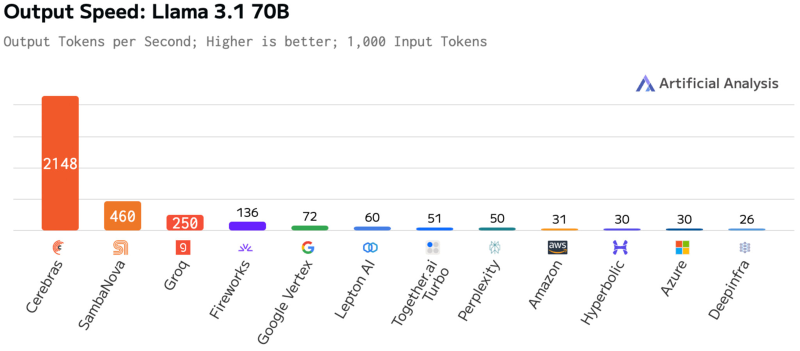

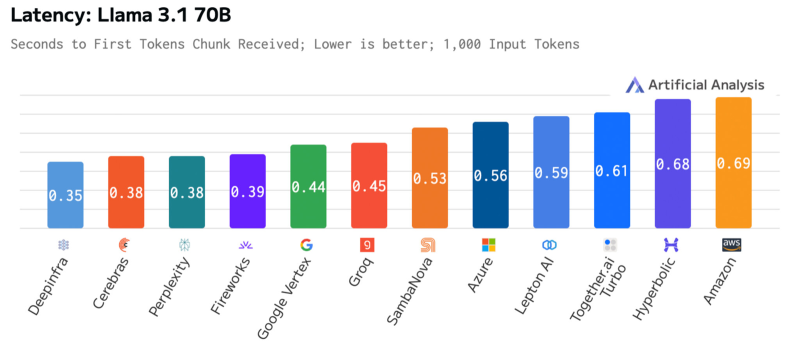

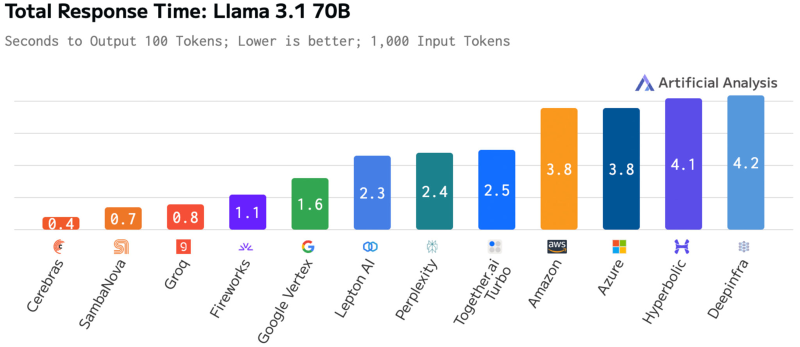

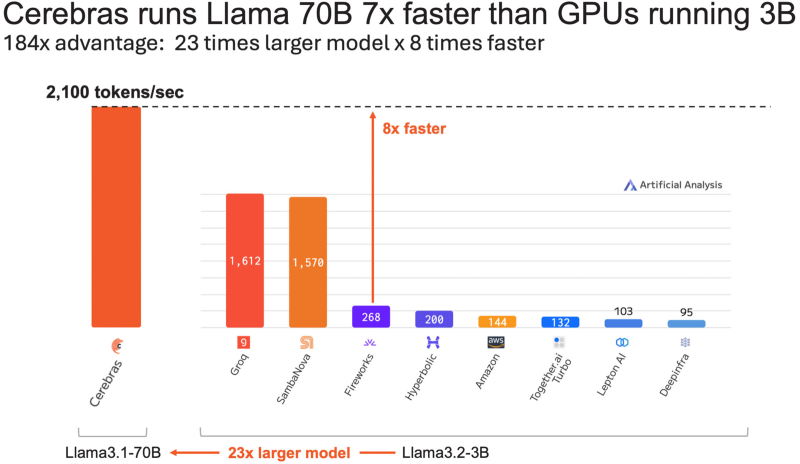

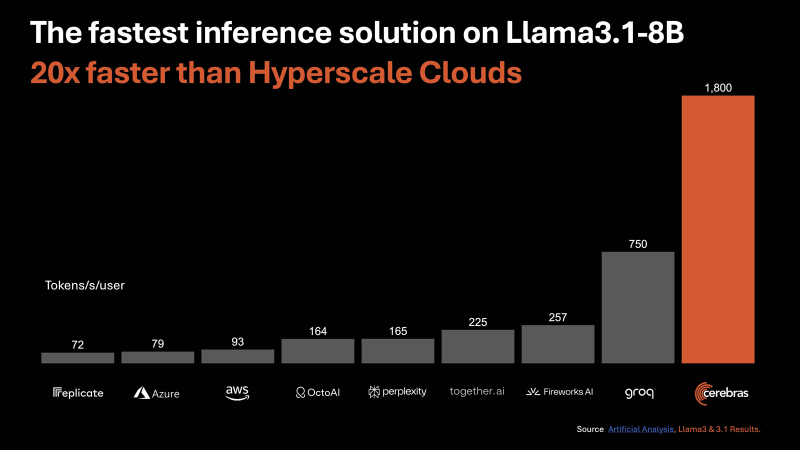

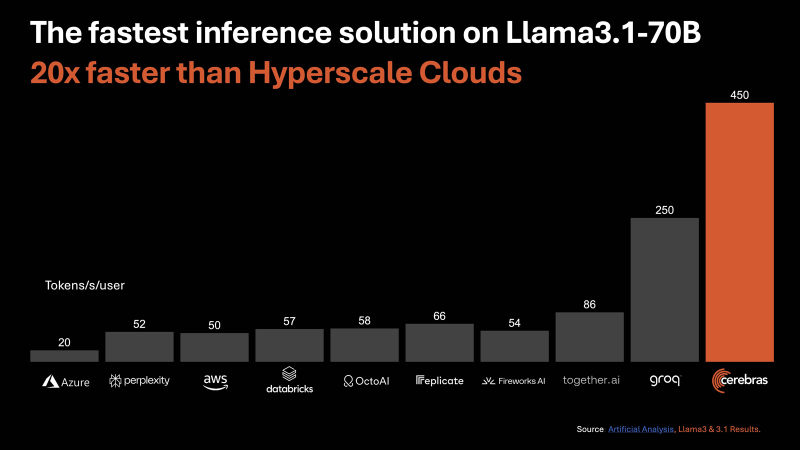

Cerebras втрое повысила производительность своей инференс-платформыАмериканский стартап Cerebras Systems, специализирующийся на разработке ИИ-ускорителей, объявил о самом масштабном обновлении ИИ-платформы Cerebras Inference с момента её запуска. Производительность системы поднялась примерно в три раза. Первый релиз Cerebras Inference состоялся в августе 2024 года. Основой облачной платформы являются ускорители собственной разработки WSE-3. На момент запуска быстродействие составляло до 1800 токенов в секунду на пользователя для ИИ-модели Llama3.1 8B и до 450 токенов в секунду для Llama3.1 70B (FP16). Разработчик заявлял, что Cerebras Inference — это «самая мощная в мире» ИИ-платформа для инференса. Однако в сентябре нынешнего года у Cerebras Inference появился серьёзный конкурент. Компания SambaNova Systems запустила облачный сервис SambaNova Cloud, также назвав его «самой быстрой в мире платформой для ИИ-инференса». Система на основе чипов собственной разработки SN40L демонстрирует быстродействие до 461 токена в секунду при использовании Llama 3.1 70B. В ответ Cerebras Systems усовершенствовала своё решение путём «многочисленных улучшений программного обеспечения, оборудования и алгоритмов». Утверждается, что обновлённая платформа Cerebras Inference при обслуживании Llama3.1 70B обеспечивает быстродействие 2148 токенов в секунду. Для сравнения: у AWS — лидера мирового облачного рынка — этот показатель равен 31 токену в секунду. А у Groq значение находится на уровне 250 токенов в секунду. Данные получены по результатам тестов Artificial Analysis. Время до получения первого токена имеет решающее значение для приложений реального времени. Cerebras находится на втором месте с показателем 0,38 с, уступая только Deep Infra (0,35 с). Вместе с тем Cerebras лидирует по общему времени отклика для 100 токенов на выходе с показателем 0,4 с против 0,7 с у SambaNova, которая находится на втором месте. В целом, как отмечается, платформа Cerebras Inference при работе с Llama3.1 70B опережает сервисы конкурентов на основе GPU, обрабатывающие модель Llama3.1 3B, которая в 23 раза меньше.

09.10.2024 [23:09], Руслан Авдеев

Cerebras отложит IPO: США опасаются, что Китай получит доступ к ИИ-суперчипам при посредничестве ОАЭПроизводитель ИИ-суперчипов Cerebras Systems, вероятнее всего, вынужден будет отложить IPO из-за задержки, связанной с проверкой иностранных инвестиций в компанию. По данным Reuters, миноритарным инвестором выступил конгломерат G42 (Core42) из ОАЭ, что и привлекло внимание регуляторов. Как сообщают источники издания, Cerebras, являющаяся молодым и перспективными конкурентом NVIDIA, наверное, отменит презентацию, запланированную на начало следующей недели и предваряющую IPO. Ведущими андеррайтерами запланированного IPO в Cerebras выбрали Citigroup и Barclays. Инвестиции G42 в Cerebras рассматривает Комитет по иностранным инвестициям в США (Committee on Foreign Investment in the United States, CFIUS). Он оценивает наличие угроз национальной безопасности в иностранных капиталовложениях в американский бизнес. В Cerebras ожидают, что CFIUS даст инвестициям G42 зелёный свет ещё до конца 2024 года. Производитель ускорителей будет стремиться выйти на IPO сразу после получения необходимых разрешений от регулятора, но планы компании могут измениться. В Министерстве финансов США комментировать IPO отказались, но сообщили, что регулятор примет все меры для защиты национальной безопасности США в пределах своей компетенции. Проблема в том, что G42, являющаяся инвестором и крупнейшим клиентом Cerebras, уже привлекала внимание сторонников суровых мер в отношении Китая. Считается, что компании с Ближнего Востока могут использоваться КНР для обхода американских санкций, ограничивающих экспорт полупроводников в Поднебесную. Кроме того, G42 ранее уличили в ведении дел с Пекином.

Источник изображения: Cerebras По имеющимся данным на закупки G42 приходится $65,1 млн или 83 % от всей выручки Cerebras за 2023 календарный год. В I полугодии 2024 года компания зарегистрировала $136,4 млн, тогда как в прошлом году за аналогичный период выручка составила $8,7 млн. Иными словами, G42 является ключевым покупателем продуктов компании. Кроме того, к апрелю G42 обязалась выкупить акции Cerbras на $335 млн, доведя долю до более чем 5 %. Сначала Cerebras и G42 подали в CFIUS заявку о продаже акций, но позже скорректировали её объявив, что продаваемые акции не голосующие, поэтому их проверка регулятором не нужна. В сентябре было подано заявление на отзыв уведомления. Сегодня калифорнийская Cerebras, оценивавшаяся приблизительно в $4 млрд в 2021 году, строит серию ИИ-суперкомпьютеров в интересах G42, в том числе в США. Разработанная Cerebras технология уже использовалась для обучения большой языковой модели (LLM) для арабского языка. Разработанные Cerebras ускорители конкурируют с решениями NVIDIA. По мнению экспертов, ИИ-чипы огромного размера, предлагаемые стартапом, имеются ряд преимуществ в сравнении с ускорителями NVIDIA и другими решениями. Примечательно, что инвестиции Microsoft в G42 были одобрены после того, как последняя, по слухам, заключила тайное соглашение с администрацией США, которое как раз оговаривало взаимодействие с Китаем.

01.10.2024 [15:39], Руслан Авдеев

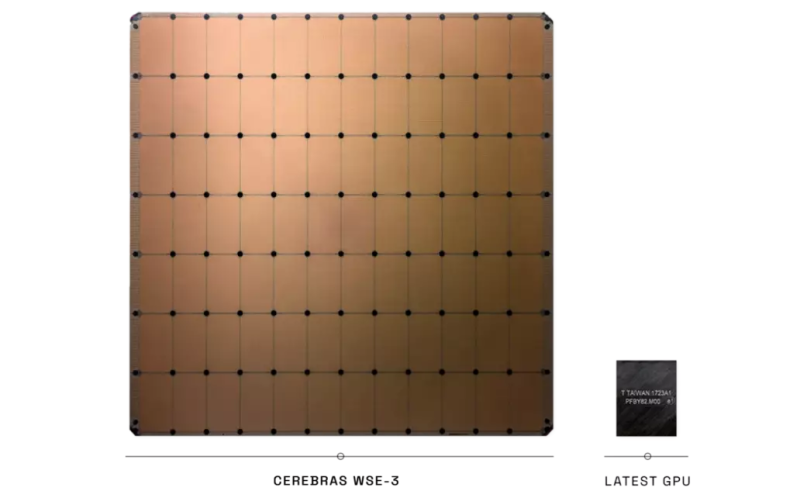

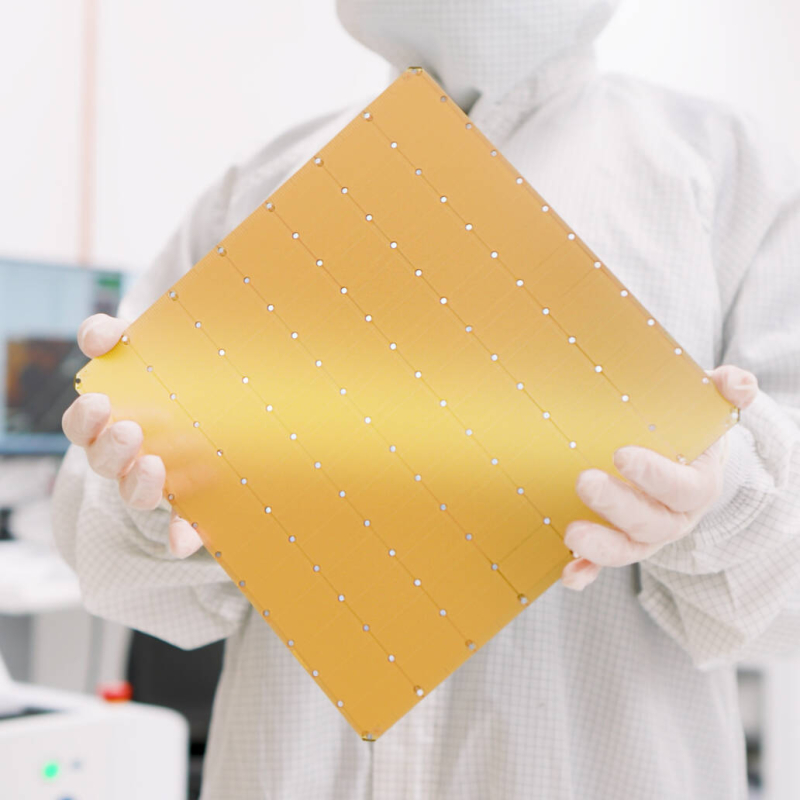

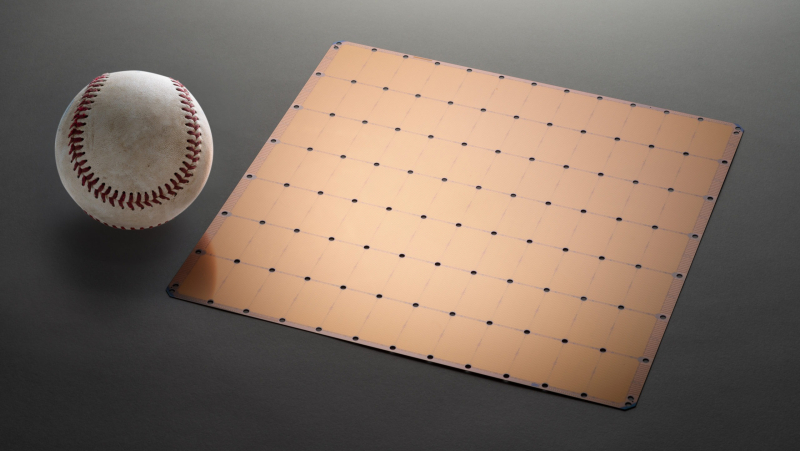

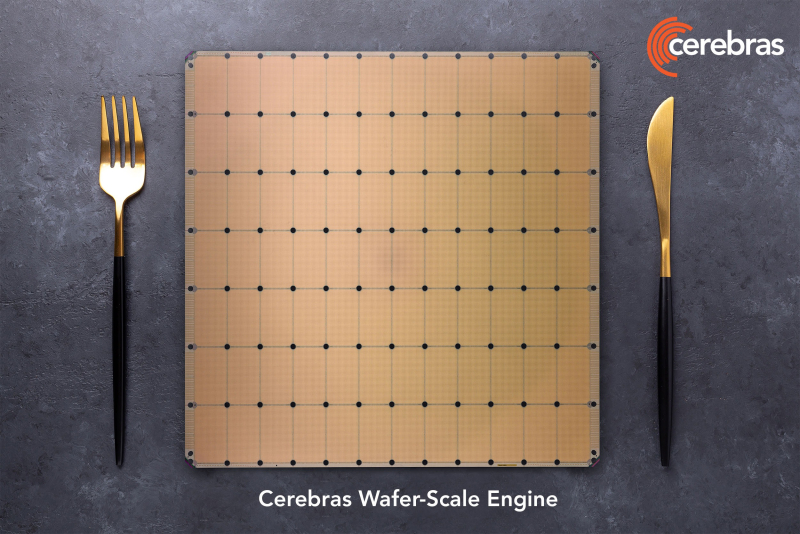

Конкурент NVIDIA — Cerebras Systems выходит на IPO на биржу NasdaqСтартап Cerebras Systems Inc., разрабатывающий ИИ-суперускорители размером с целую кремниевую пластину, подал заявку для выхода на публичные торги. По данным Silicon Angle, шаг вполне ожидаемый — компания подала проект документации в Комиссию по ценным бумагам и биржам США (SEC) ещё летом текущего года. На прошлой неделе сообщалось, что компания надеется привлечь в ходе IPO от $750 млн до $1 млрд, а оценочная стоимость компании составит до $8 млрд. На Nasdaq компания намерена выйти под тикером CBRS. Флагманским продуктом компании является суперчип WSE-3 с 4 трлн транзисторов, формирующих 900 тыс. ядер и 44 Гбайт SRAM. Компания утверждает, что WSE-3 может обучать ИИ-модели значительно быстрее, чем традиционные чипы. При этом энергоэффективность WSE-3 значительно лучше, поскольку один большой чип просто эффективнее во всех отношениях множества более компактных. Компания поставляет WSE-3 в составе модуля CS-3 размером с небольшой холодильник, также вмещающего и охлаждающее оборудование, модули питания и прочие компоненты. Клиенты могут использовать до 2048 CS-3 в одном ИИ-кластере.

Источник изображения: Cerebras Cerebras пока не приносит прибыли, но рассчитывает на быстрый рост выручки. С 2022 по 2023 годы продажи компании выросли более чем втрое с $24,62 млн до $78,7 млн. Чистый убыток за те же периоды составил $177,72 млн и $127,16 млн соответственно. В 2024 году за первые шесть месяцев выручка составит $136,4 млн при убытке $66,6 млн. Однако отмечается очень большая концентрация продаж — 87 % продукции в I полугодии предназначалось компании G42 (ныне Core42) из ОАЭ. Более того, этот же заказчик до середины следующего года закупит ускорителей на почти $1,5 млрд. При этом у G42 есть 5 % акций Cerebras, столько же имеется только у основателя компании Эндрю Фельдмана (Andrew Feldman). Среди других известных инвесторов есть глава OpenAI Сэм Альтман (Sam Altman) также является акционером Cerebras, как и сооснователь Sun Microsystems Энди Бехтольшайм (Andy Bechtolsheim). Впрочем, Cerebras уже готовится сотрудничать с Aramco и другими компаниями. В документах, посвящённых выходу на IPO, Cerebras заявила, что намерена сохранить рост выручки, привлекая больше клиентов и расширяя технологическое портфолио, создавая новые продукты и форм-факторы. Ещё одним потенциальным источникам роста стал недавний запуск облачного сервиса для инференса. При этом Reuters сообщает, что ранее в этом году некоторые инвесторы ушли с рынка акций ИИ-компаний из-за опасений того, что тот слишком раздут. Попытка Cerebras выйти на IPO покажет, сохранился ли в должной мере интерес к отрасли. Компанию поддерживает ряд крупных инвесторов, включая Abu Dhabi Growth Fund и Coatue Management. Андеррайтерами предложения, помимо прочих, являются Citigroup, Barclays, UBS Investment, Wells Fargo Securities и Mizuho.

16.09.2024 [10:51], Руслан Авдеев

Aramco Digital объявила о партнёрстве с Cerebras, Groq и Qualcomm для развития ИИ и 5G IoT в Саудовской АравииПодразделение нефтегазовой саудовской Aramco — Aramco Digital анонсировало серию соглашений с компаниями, действующими в сфере ИИ и беспроводных технологий. По информации Datacenter Dynamics, компания подписала меморандумы о взаимопонимании с Cerebras Systems, развитии передовой ИИ-модели Norous совместно с Groq и сотрудничестве в сфере 5G-технологий совместно с Qualcomm. Aramco принадлежит государству и является крупнейшим в мире добытчиком нефти и газа, располагая вторыми по величине разведанными запасами сырой нефти в мире. Её подразделение Aramco Digital — попытка диверсифицировать бизнес, уделив внимание освоению информационных технологий. Сотрудничество с Cerebras Systems позволит обеспечить высокопроизводительными ИИ-решениями промышленность, университеты и коммерческие предприятия Саудовской Аравии. В рамках соглашения компания будет применять вычислительные системы Cerebras CS-3 на сусперускорителях WSE-3 в облачном бизнесе, чтобы ускорить создание, обучение и внедрение больших языковых моделей и ИИ-приложений. Тем временем партнёрство с Groq поможет Aramco Digital вывести на рынок управляемую голосом ИИ-модель Norous.

Источник изображения: M Zaedm/unsplash.com В будущем планируется создать систему управления цепочками поставок, способную генерировать миллиарды токенов в секунду. Как сообщают арабские СМИ, пока Aramco Digital планирует обеспечивать до 25 млн токенов к концу I квартала 2025 года, а в этом году будет обеспечено 20 % от заявленных показателей. В Groq заявляют, что компания намерена стать экспортёром вычислительных мощностей для приблизительно 4 млрд человек, этого будет достаточно для «близлежащих континентов» и позволит обеспечивать части Европы, Африки и, возможно, даже часть Индии. Также совместно с Qualcomm компания Aramco Digital задействует 5G-чипы для частотного диапазона 450 МГц. IoT-решения Qualcomm QCS8550/QCS6490 будут поддерживать умные устройства с возможностью периферийных вычислений. Решение включает ряд компонентов, от модема до собственно передатчика, усилителя и систем фильтрации сигнала, а также другие элементы. Эксперты утверждают, что этот диапазон можно эффективно использовать как в помещениях, так и вне их, поэтому новое решение станет одним из важнейших элементов цифровой трансформации Саудовской Аравии. Партнёры также работают над «инкубатором стартапов» совместно с саудовским Управлением по вопросам исследований, развития и инноваций (RDIA). Программа Design in Saudi Arabia (DISA) будет поддерживать стартапы, занимающиеся разработкой и внедрением ИИ, беспроводных технологий и Интернета вещей, обеспечив им техническую помощь, бизнес-коучинг и прочую помощь. Резиденты инкубатора также получат доступ к технологическим платформам Qualcomm и Aramco Saudi Accelerated Innovation Lab. Предполагается, что это простимулирует новую волну технологических инноваций в Саудовской Аравии и коммерциализацию разработок стартапов.

13.09.2024 [14:05], Руслан Авдеев

Cerebras и Aramco займутся развитием ИИ-инноваций в Саудовской АравииАмериканская компания Cerebras Systems объявила о подписании меморандума о взаимопонимании с саудовской нефтяной компанией Aramco. В рамках соглашения компании предоставят промышленности, университетам и коммерческим организациям Саудовской Аравии современные ИИ-решения. По данным HPC Wire, Aramco намерена создавать, обучать и внедрять большие языковые модели (LLM) мирового класса с использованием систем Cerebras CS-3. Ранее Aramco заключила похожее соглашение с другим американским производителем ИИ-ускорителей — Groq. Новая высокопроизводительная инфраструктура Aramco будет концентрировать усилия на обеспечении местных коммерческих, научных и иных структур доступом к ИИ-системам CS-3. Предполагается, что организации будут использовать передовые аппаратные решения Cerebras для разработки современных LLM, масштабируя и настраивая их для получения оптимальной для того или иного сектора производительности. Как объявили в Cerebras, вместе компании планируют расширить возможности ИИ-систем, создав благоприятные условия для развития креативности, раскрытия ценности технологий и продвижения концепции экоустойчивости. В свою очередь, представитель Aramco заявил, что сотрудничество ускорит создание цифровой инновационной экономики в Саудовской Аравии, драйвером которой станет ИИ. Этого можно будет добиться, интегрируя передовые ИИ-решения и учитывая региональные особенности. Aramco рассчитывает оснастить свой облачный бизнес новыми системами CS-3. В основе систем Cerebras CS-3 лежат суперускорители WSE-3 размером с целую кремниевую пластину. Уже сегодня продукцией Cerebras пользуются крупные корпорации, исследовательские институты и даже государственные органы для разработки собственных моделей. Также они применяются для обучения open source LLM. Решения Cerebras доступны как «во плоти», так и в облаке. В конце августа 2024 года Cerebras Systems запустила «самую мощную в мире» ИИ-платформу для инференса. В целом Cerebras активно осваивает рынок ЦОД в регионе. Так, холдинг G42 (Core42) из ОАЭ финансово поддержал создание целой серии ИИ-суперкомпьютеров Condor Galaxy, одних из крупнейших в мире. Сейчас Cerebras готовится к IPO и намерена составить конкуренцию NVIDIA. При этом США, как выяснилось, разрешили NVIDIA поставлять современные ускорители G42.

31.08.2024 [14:12], Сергей Карасёв

Cerebras Systems запустила «самую мощную в мире» ИИ-платформу для инференсаАмериканский стартап Cerebras Systems, занимающийся разработкой чипов для систем машинного обучения и других ресурсоёмких задач, объявил о запуске, как утверждается, самой производительной в мире ИИ-платформы для инференса — Cerebras Inference. Ожидается, что она составит серьёзную конкуренцию решениям на основе ускорителей NVIDIA. В основу облачной системы Cerebras Inference положены ускорители WSE-3. Эти гигантские изделия, выполненные с применением 5-нм техпроцесса TSMC, содержат 4 трлн транзисторов, 900 тыс. ядер и 44 Гбайт SRAM. Суммарная пропускная способность встроенной памяти достигает 21 Пбайт/с, а внутреннего интерконнекта — 214 Пбит/с. Для сравнения: один чип HBM3e в составе NVIDIA H200 может похвастаться пропускной способностью «только» 4,8 Тбайт/с. По заявлениям Cerebras, новая инференс-платформа обеспечивает до 20 раз более высокую производительность по сравнению с сопоставимыми по классу решениями на чипах NVIDIA в сервисах гиперскейлеров. В частности, быстродействие составляет до 1800 токенов в секунду на пользователя для ИИ-модели Llama3.1 8B и до 450 токенов в секунду для Llama3.1 70B. Для сравнения, у AWS эти значения равны соответственно 93 и 50. Речь идёт об FP16-операциях. Cerebras заявляет, что лучший результат для кластеров на основе NVIDIA H100 в случае Llama3.1 70B составляет 128 токенов в секунду. «В отличие от альтернативных подходов, которые жертвуют точностью ради быстродействия, Cerebras предлагает самую высокую производительность, сохраняя при этом точность на уровне 16 бит для всего процесса инференса», — заявляет компания. При этом услуги Cerebras Inference стоят в несколько раз меньше по сравнению с конкурирующими предложениями: $0,1 за 1 млн токенов для Llama 3.1 8B и $0,6 за 1 млн токенов для Llama 3.1 70B. Оплата взимается по мере использования. Cerebras планирует предоставлять инференс-услуги через API, совместимый с OpenAI. Преимущество такого подхода заключается в том, что разработчикам, которые уже создали приложения на основе GPT-4, Claude, Mistral или других облачных ИИ-моделей, не придётся полностью менять код для переноса нагрузок на платформу Cerebras Inference. Для крупных предприятий предлагается план обслуживания Enterprise Tier, который предусматривает тонко настроенные модели, индивидуальные условия и специализированную поддержку. Стандартный пакет Developer Tier предполагает подписку по цене от $0,1 за 1 млн токенов. Кроме того, имеется бесплатный доступ начального уровня Free Tier с ограничениями. Cerebras говорит, что запуск платформы откроет качественно новые возможности для внедрения генеративного ИИ в различных сферах.

21.06.2024 [16:09], Руслан Авдеев

Производитель гигантских ИИ-суперчипов Cerebras Systems готовится к IPOСтартап Cerebras Systems Inc., выпускающий передовые ИИ-чипы и конкурирующий с NVIDIA, по слухам, подал регуляторам США документы для выхода на биржу Nasdaq. По данным Silicon Angle, IPO должно состояться позже в 2024 году. Компания выпускает специализированные и весьма производительные ИИ-чипы размером с кремниевую пластину. У NVIDIA немного конкурентов на мировом рынке, но Cerebras — как раз из их числа. Новейший флагманский чип компании WSE-3 был анонсирован в марте, ему предшествовала модель WSE-2, дебютировавшая в 2021 году. Ожидается, что WSE-3 станет доступен до конца текущего года. Cerebras говоит, что WSE-3 имеет в 52 раза больше ИИ-ядер, чем ускоритель NVIDIA H100. Чип будет доступен в составе модуля CS-3 размером с небольшой холодильник с интегрированной системой охлаждения и блоком питания. WSE-3 имеет пиковое быстродействие 125 Пфлопс в разреженных FP16-вычислениях. В компании утверждают, что таких характеристик более чем достаточно для конкуренции с лучшими ускорителями NVIDIA, а её чипы не только быстрее, но и энергоэффективнее. Статус компании, похоже, действительно способной конкурировать NVIDIA, должен привлечь внимание инвесторов. Например, с началом эры ИИ акции NVIDIA выросли почти на порядок, поэтому не исключено, что и Cerebras ожидает впечатляющий успех. По имеющимся данным, Cerebras уведомила регуляторов в Делавэре, где компания официально зарегистрирована, о намерении предложить в ходе ожидающегося раунда инвестиций привилегированные акции с большой скидкой. Хотя в самой Cerebras не комментируют слухи об IPO, Bloomberg сообщил, что компания выбрала Citigroup в качестве ведущего банка для первичного листинга. В Bloomberg отмечают, что IPO состоится не раньше II половины 2024 года, а руководство рассчитывает на оценку не менее $4 млрд, которую компания получила после последнего раунда финансирования серии F, позволившего привлечь $250 млн в 2021 году.

17.06.2024 [08:53], Руслан Авдеев

Cerebras и Dell предложат заказчикам современные ИИ-платформыРазработчик ИИ-суперчипов Cerebras Systems анонсировал сотрудничество с Dell. Вместе компании займутся созданием передовых вычислительных инфраструктур для генеративного ИИ. В рамках сотрудничества будут создаваться масштабируемые решения для ИИ-суперкомпьютеров Cerebras с платформами Dell на базе процессоров AMD EPYC Genoa. По словам участников проекта, новые технологические решения дадут возможность обучать модели, на порядки более крупные, чем те, что есть на данный момент. В частности, будут задействованы системы Dell PowerEdge R6615 на базе AMD EPYC 9354P, которые предоставят потоковый доступ к 82 Тбайт памяти — для обучения моделей практически любого размера. Совместные платформы Cerebras и Dell будут включать ИИ-системы и суперкомпьютеры. Также будет предложена тренировка ИИ-моделей и иные сервисы поддержки машинного обучения. Как утверждают в самой Cerebras, сотрудничество с Dell станет поворотной точкой, открывающие каналы глобальной дистрибуции. Компании предоставят ИИ-оборудование, ПО и экспертизу, что позволит заказчикам упростить и ускорить внедрении современных ИИ-технологий, попутно снизив TCO. В марте Cerebras представила новейшие суперчипы Cerebras WSE-3, а в мае появилась новость, что совместно с Core42 из ОАЭ компания создаст суперкомпьютер Condor Galaxy 3 (CG-3) со 172,8 млн ИИ-ядер.

23.05.2024 [09:57], Александр Бенедичук

Гигантские суперчипы Cerebras натренируют ИИ для армии ГерманииCerebras Systems и Aleph Alpha объединятся для разработки суверенных ИИ-решений в интересах армии Германии, сообщает Datacenter Dynamics. Работы альянса будут вестись совместно с компанией BWI GmbH, государственным поставщиком ИТ-услуг, принадлежащим Министерству обороны Германии. Aleph Alpha развернет первый в Европе ИИ-суперкомпьютер Cerebras CS-3 в своем дата-центре Alpha ONE. «Мы считаем, что партнёрство [с Aleph Alpha] позволит создать совершенно новые архитектуры ИИ-моделей, которые могут быть полезны правительствам и предприятиям по всему миру», — сказал глава Cerebras, отметив, что работа с новыми моделями будет безопасной и защищённой, но не уточнив, что именно под этим подразумевается. Aleph Alpha основана в 2019 году для создания моделей генеративного ИИ в рамках концепции «суверенитета данных». ЦОД Alpha ONE был запущен в 2022 году в кампусе GovTech в Германии и используется для исследований и разработки ИИ-приложений как предприятиями государственного сектора, так и частными. Здесь Cerebras и Aleph Alpha будут вместе создавать базовые и мультимодальные модели, а также и новые архитектуры ИИ-моделей с использованием CS-3. В основе Cerebras CS-3 лежит ИИ-ускоритель WSE-3 размером с целую кремниевую пластину. Он содержит 4 трлн транзисторов, 900 тыс. ядер и 44 Гбайт SRAM, а его производительность составляет 125 Пфлопс в разреженных FP16-вычислениях.

21.05.2024 [16:36], Руслан Авдеев

Core42 и Cerebras построят в Техасе ИИ-суперкомпьютер с 173 млн ядерБазирующаяся в ОАЭ компания Core42 занялась строительством ИИ-суперкомпьютера, в эксплуатацию объект должны ввести до конца текущего года. HPC Wire сообщает, что компьютер Condor Galaxy 3 (CG-3) получит 192 узла с 5-нм мегачипами Cerebras WSE-3 и 172,8 млн ИИ-ядер. WSE-3 в 50 раз крупнее актуальных ИИ-ускорителей NVIDIA и, конечно, гораздо производительнее. По данным Core42, развёртывание CG-3 в Далласе (Техас) начнётся в июне и завершится в сентябре–октябре. Core42 уже считается значимым игроком на рынке ЦОД, HPC- и ИИ-систем. Машины G42 уже попадали в TOP500 — это системы Artemis (NVIDIA) и POD3 (Huawei). Последняя покинула рейтинг в 2023 году. Суперкомпьютер CG-3, как теперь сообщается, получит 192 узла CS-3. Каждый узел с чипом WSE-3 обеспечивает до 125 Пфлопс (FP16 с разрежением), так что общая производительность Condor Galaxy 3 составит 24 Эфлопс. Всего же Cerebras намеревается построить девять суперкомпьютеров семейства Condor Galaxy. Машины GC-1 и GC-2 на базе чипов WSE-2 также созданы при участии G42. Core42 появилась в 2023 году в результате слияния G42 Cloud и G42 Inception AI. Родительская компания G42, основанная в 2018 году, также сотрудничает с NVIDIA, AMD, OpenAI и другими компаниями. G42 не так давно попала под пристальное внимание американских властей. Её подозревали в том, что она помогала Китаю получать доступ к новейшим ускорителям NVIDIA и другому ИИ-оборудованию американских компаний. В результате, как считается, она была вынуждена отказать от сотрудничества с Huawei. Также сообщалось, что G42 заключила с американским правительством взаимовыгодное секретное соглашение — компания обязалась лишить КНР доступа к ускорителям, а в ответ ей самой разрешали сохранить доступ к продукции NVIDIA. Не исключено, что были оговорены и иные пункты. По некоторым данным, именно в то же время, когда было заключено соглашение с руководством США, Microsoft инвестировала в G42 около $1,5 млрд. |

|