Meta✴ объединила усилия с Cerebras и Groq для инференс-сервиса с применением API Llama. Открыв API-доступ к собственным моделям, Meta✴ становится чуть более похожа на облачных провайдеров.

Как утверждают в Cerebras, разработчики, применяющие API для работы с моделями Llama 4 Cerebras, могут получить скорость инференса до 18 раз выше, чем у традиционных решений на базе GPU. В компании объявили, что такое ускорение позволит использовать новейшее поколение приложений, которые невозможно построить на других ИИ-технологиях. Речь, например, идёт о «голосовых» решениях с низкой задержкой, интерактивной генерации кода, мгновенном многоэтапном рассуждении и т. п. — многие задачи можно решать за секунды, а не минуты.

После запуска инференс-платформы в 2024 году Cerebras обеспечила для Llama самый быстрый инференс, обрабатывая миллиарды токенов через собственную ИИ-инфраструктуру. Теперь прямой доступ к альтернативам решений OpenAI получит широкое сообщество разработчиков. По словам компании, партнёрство Cerebras и Meta✴ позволит создавать ИИ-системы, «принципиально недосягаемые для ведущих облаков». Согласно замерам Artificial Analysis, Cerebras действительно предлагает самые быстрые решения для ИИ-инференса, более 2600 токенов/с для Llama 4 Scout.

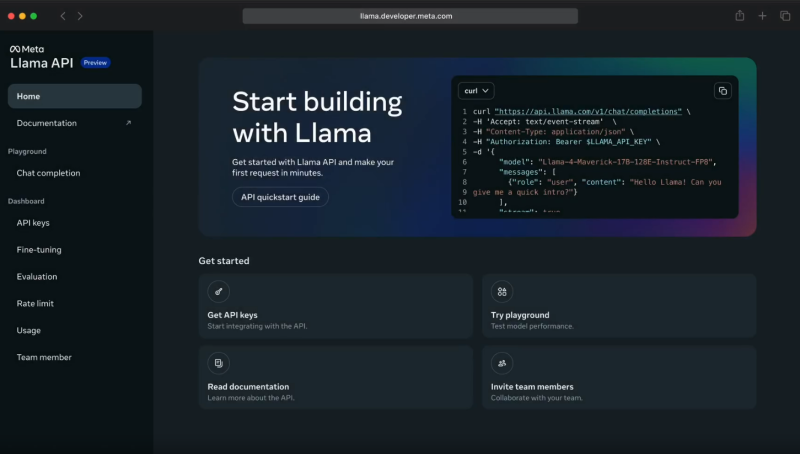

Источник изображения: Meta✴

При этом Cerebras не единственный партнёр Meta✴. Она также договорилась с Groq об использовании ускорителей Language Processing Units (LPU), которые обеспечивают высокую скорость (до 625 токенов/с), низкую задержку и хорошую масштабируемость при довольно низких издержках. Groq использует собственную вертикально интегрированную архитектуру, полностью контролируя и железо, и софт. Это позволяет добиться эффективности, недоступной в облаках на базе универсальных ИИ-чипов.

Партнёрство с Meta✴ усиливает позиции Groq и Cerebras в борьбе с NVIDIA. Для Meta✴ новое сотрудничество — очередной шаг в деле выпуска готовых open source ИИ-моделей, которые позволят сосредоточиться на исследованиях и разработке, фактически передав инференс надёжному партнёру. Разработчики могут легко перейти на новый стек без необходимости дообучения моделей или перенастройки ускорителей — API Llama совместимы с API OpenAI. Пока что доступ к новым API ограничен. Цены Meta✴ также не сообщает.

Meta✴ активно работает над продвижением своих ИИ-моделей. Так, она даже выступила с довольно необычной инициативой, предложив «коллегам-конкурентам» в лице Microsoft и Amazon, а также другим компаниям, поделиться ресурсами для развития и обучения моделей Llama.

Источники: