Материалы по тегу: ff

|

29.01.2026 [23:55], Владимир Мироненко

Непоколебимая вера в ИИ: Meta✴ удвоит капзатраты в 2026 годуMeta✴ Platforms сообщила финансовые результаты IV квартала и всего 2025 года, завершившегося 31 декабря 2025 года. Выручка компании за квартал составила $59,89 млрд, что больше год к году на 24% при консенсус-прогнозе аналитиков, опрошенных LSEG, в размере $58,59 млрд (по данным CNBC). При этом чистая прибыль выросла год к году на 9% до $22,77 млрд. Прибыль на разводнённую акцию составила $8,88 (+11%), что выше прогноза от LSEG в размере $8,23 на разводнённую акцию. За 2025 год выручка Meta✴ достигла $200,97 млрд, увеличившись год к году на 22%. Чистая прибыль составила $60,46 млрд (падение на 3%) или $23,49 на разводнённую акцию. В I квартале 2026 года компания прогнозирует выручку в пределах от $53,5 до $56,5 млрд, что немного меньше результата IV квартала, но выше прогноза аналитиков, опрошенных LSEG, в размере $51,41 млрд. На фоне этого прогноза выручки, превзошедшего ожидания экспертов, акции Meta✴ подскочили на 10%. Meta✴ заявила, что общие расходы в 2026 году составят от $162 до $169 млрд. При этом капитальные затраты, связанные с ИИ, в 2026 году, как ожидается, составят от $115 до $135 млрд, что превышает прогнозы аналитиков в $110,7 млрд. Это почти вдвое больше, чем капитальные затраты компании в 2025 году, которые составили $72,2 млрд. Роста затрат направлен на поддержку подразделения Meta✴ Superintelligence Labs (MSL), а также основной повседневной деятельности компании, заявила финансовый директор Сьюзан Ли (Susan Li). Ранее компания пообещала потратить $600 млрд на ИИ ЦОД, инфраструктуру и кадры. В начале этого месяца компания Meta✴ представила новую инициативу под названием Meta✴ Compute, направленную на расширение ИИ-инфраструктуры и улучшение управления своей растущей сетью ИИ ЦОД, заявив о планах построить десятки гигаватт мощностей в течение этого десятилетия и сотни гигаватт в будущем. Meta✴ считает, что эта ставка на развитие ИИ окупится с лихвой. «Несмотря на значительное увеличение инвестиций в инфраструктуру, в 2026 году мы ожидаем получить операционную прибыль, превышающую прибыль 2025 года», — сказала Ли. Глава компании Марк Цукерберг (Mark Zuckerberg) считает значительные затраты оправданными, отметив, что Meta✴ сейчас наблюдает значительное ускорение развития ИИ: «Я ожидаю, что 2026 год станет годом, когда эта волна ещё больше ускорится по нескольким направлениям. Мы начинаем видеть, как агенты действительно работают. Это откроет возможности для создания совершенно новых продуктов и трансформирует наш подход к работе». «Мы начинаем видеть потенциал ИИ, который понимает наш личный контекст, включая нашу историю, наши интересы, наш контент и наши отношения. Ценность агентов во многом обусловлена уникальным контекстом, который они могут видеть», — отметил глава Meta✴. По его словам, Meta✴ также работает над объединением больших языковых моделей (LLM) с системами рекомендаций, которые лежат в основе Facebook✴, Instagram✴, Threads и ёе рекламных систем, что, как ожидается, позволит увеличить доходы от рекламы. Т.е. рост вложений в инфраструктуру связан и с увеличением сложности и размера своих ИИ-моделей, которые должны помочь в подборе рекламных объявлений для пользователей. В IV квартале компания уже удвоила количество ускорителей, используемых для обучения генеративной модели ранжирования рекламы GEM (Generative Ads Recommendation Model), позволяющей в реальном времени определять, какие объявления будут максимально уместными для конкретного пользователя. «Сегодня наши системы помогают людям оставаться на связи с друзьями, понимать мир и находить интересный и развлекательный контент. Но вскоре мы сможем понимать уникальные личные цели людей и персонализировать ленты, чтобы показывать каждому человеку контент, который помогает ему улучшить свою жизнь так, как он этого хочет», — заявил Цукерберг.

28.01.2026 [00:15], Владимир Мироненко

Corning построит крупнейшее в мире производство оптоволоконного кабеля для ЦОД в рамках сделки с Meta✴ на $6 млрдКомпания Meta✴ объявила о заключении соглашения с Corning, в рамках которого та поставит ей до 2030 года оптоволоконные кабели для инфраструктуры ИИ ЦОД на сумму до $6 млрд. Corning будет поставлять Meta✴ передовые кабели для ВОЛС и иную продукцию для обеспечения связи, одновременно расширяя свои производственные мощности в Северной Каролине, в том числе на своем кабельном заводе в Хикори (Hickory), для которого Meta✴ станет основным заказчиком. Corning расширяет предприятие, чтобы удовлетворить растущий спрос со стороны Meta✴ и других крупных игроков, таких как NVIDIA, OpenAI, Google, Amazon и Microsoft. По словам Corning, после завершения проекта это будет крупнейший в мире завод по производству оптоволоконного кабеля. Как сообщается, это соглашение также позволит компании Corning увеличить количество рабочих мест на предприятиях в штате на 15–20 %. Продукты Corning для оптической связи входят в число ключевых компонентов, необходимых для поддержки потребностей ЦОД. «Инвестиции расширят наше производственное присутствие в Северной Каролине <…> и помогут сохранить высококвалифицированные кадры численностью более 5 тыс. человек, включая учёных, инженеров и производственные команды на двух крупнейших в мире предприятиях по производству оптоволокна и кабеля», — сообщил председатель и главный исполнительный директор Corning. На фоне растущего спроса со стороны крупных технологических компаний, акции Corning выросли более чем на 84 % в 2025 году. После объявления о сделке её акции подскочили примерно на 7 % на предрыночных торгах, пишет Reuters. Meta✴ обязалась потратить $600 млрд на технологическую инфраструктуру и создание рабочих мест в США в течение следующих трёх лет. Только в США у Meta✴ есть 26 дата-центров на стадии строительства или эксплуатации. Также ранее в этом месяце Meta✴ объявила об инициативе Meta✴ Compute, направленной на расширение ИИ-инфраструктуры и управление глобальным парком ЦОД и партнёрскими отношениями с поставщиками. В настоящее время идёт стрительство трёх крупнейших дата-центров Meta✴: гигаваттного Prometheus в Нью-Олбани (шт. Огайо), 5-ГВт Hyperion в Ричленде (шт. Луизиана), а также гигаваттного кампуса в Эль-Пасо (шт. Техас) В рамках нового соглашения в обоих ЦОД будет использоваться оптоволоконный кабель Corning, сообщил ресурс CNBC. Ранее о стратегическом производственном сотрудничестве с Corning объявила Microsoft.

13.01.2026 [14:14], Руслан Авдеев

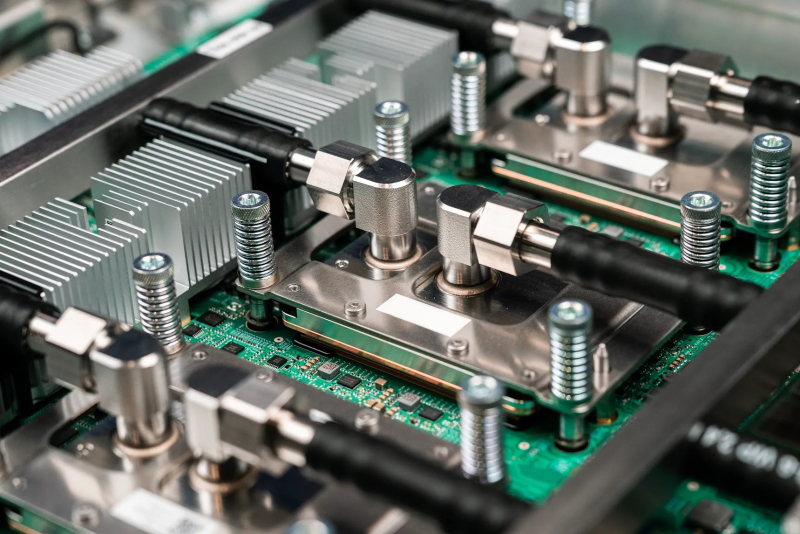

Meta✴ создаёт подразделение Meta✴ Compute для строительства ИИ ЦОД на десятки гигаваттКомпания Meta✴ Platforms запускает новое подразделение Meta✴ Compute, задачей которого станет надзор за проектами строительства ИИ ЦОД, активно реализуемыми IT-гигантом в последнее время. Meta✴ имеет масштабные планы расширения инфраструктуры, сообщает Silicon Angle. Курировать соответствующие проекты будет глава глобальных инфраструктурных проектов компании Сантош Джанардхан (Santosh Janardhan) совместно с одним из основателем Safe Superintelligence Дэниелем Гроссом (Daniel Gross). По словам главы Meta✴ Марка Цукерберга (Mark Zuckerberg), компания намерена ввести в эксплуатацию новую инфраструктуру ЦОД, потребляющую десятки гигаватт ещё в этом десятилетии и сотни гигаватт — в долгосрочной перспективе. Главной целью Meta✴ Compute является систематическое расширение ИИ-инфраструктуры в масштабе, выходящем далеко за пределы традиционного масштабирования ЦОД. Хотя Meta✴ уже управляет глобальной сетью гигантских дата-центров, речь идёт о беспрецедентных нововведениях.

Источник изображения: Adeolu Eletu/unspalsh.com ИИ-модели потребуют десятки гигаватт вычислительных мощностей, поэтому компания нуждается в покупке всё больших объёмов передового оборудования и строительства сотен зданий для его размещения. Создавая специальную организацию для решения соответствующих задач, компания рассчитывает заранее обеспечить доступ к земле, оборудованию и энергии, а не пытаться решать проблемы «на лету». Джанардхан сконцентрируется на технических аспектах строек Meta✴, включая стратегию развития, архитектуру систем компании, создание собственных чипов, ПО и инструментов разработки. Он же будет отвечать за повседневную работу ЦОД. Гросс возглавит новую группу, отвечающую за долгосрочное планирование создания новых мощностей и выстраивание цепочек поставок для обеспечения компании чипами, серверами и сетевым оборудованием для оснащения новых дата-центров. В частности, в сферу его ответственности входит упреждающее определение будущих вычислительных потребностей Meta✴, управление стратегическими отношениями с поставщиками, разработка и планирование новых бизнес-моделей, поддержка экспансии компании на многогигаваттном уровне и др. По словам Цукерберга, новая инициатива также позволит централизовать управление технологическим стеком компании — от программного обеспечения и архитектуры систем до чипов, сетей и ЦОД, что обеспечит максимально эффективное принятие любых инвестиционных решений. Кроме того, Meta✴ сможет отделить тактические задачи от долгосрочного стратегического планирования мощностей и создания цепочек поставок. Джанардхан и Гросс будут совместно работать с Диной Пауэлл МакКормик (Dina Powell McCormick) — новым президентом и вице-председателем компании. Одна из её задач — обеспечить соответствие многомиллиардных инвестиций в инфраструктуру стратегическим целям и добиться ощутимых экономических выгод в регионах присутствия. Также новый топ-менеджер отвечает за укрепление новых стратегических капитальных альянсов для усиления долгосрочной инвестиционной способности Meta✴. Создание Meta✴ Compute также может улучшить контроль отчётности в связи с её масштабными строительными проектами. В финансовом 2025 году капитальные расходы компании составили $72 млрд, большая часть средств ушла на ИИ ЦОД. Эти инвестиции ещё должны окупиться, поскольку самая передовая ИИ-модель компании — Llama 4 получила весьма сдержанные отклики. Хотя Meta✴ во многом сделала себе имя на рынке ИИ благодаря open source моделям, Llama 4 считается многими экспертами менее «сообразительной», чем ведущие базовые модели компаний уровня Google и OpenAI.

10.01.2026 [00:55], Владимир Мироненко

Meta✴ забронировала 6,6 ГВт атомных мощностей для своих ИИ ЦОД в СШАКомпания Meta✴ объявила о заключении сделок с тремя компаниями в сфере атомной энергетики — Vistra, TerraPower и Oklo — с целью обеспечения энергией своей расширяющейся ИИ-инфраструктуры, включая будущий суперкластер Prometheus. Суммарно компания получит до 6,6 ГВт новых и существующих «чистых» энергетических мощностей чистой энергии к 2035 году. Ранее Meta✴ объявила о 20-летнем соглашении на поставку электроэнергии с АЭС Clinton Clean Energy Center (CCEC) с Constellation Energy. С ней же есть соглашение и у Microsoft (АЭС Three Miles Island). «Наши соглашения с Vistra, TerraPower и Oklo, а также соглашение, подписанное нами с Constellation Energy в прошлом году, делают Meta✴ одним из крупнейших корпоративных покупателей атомной энергии в истории Америки», — заявила Meta✴. Сделка Meta✴ с TerraPower обеспечит финансирование двух ядерных проектов, которые находятся в стадии разработки. Два будущих малых реактора TerraPower, способных генерировать до 690 МВт электроэнергии, начнут работу, как ожидается, в 2032 году. Meta✴ также получила права на дополнительную энергию от шести других будущих проектов TerraPower общей мощностью 2,1 ГВт, ввод в эксплуатацию которых запланирован на 2035 год. Энергия будет вырабатываться реакторами TerraPower Natrium, в которых в качестве теплоносителя используется натрий вместо воды. Meta✴ отметила, что использование в общей сложности восьми потенциальных энергоблоков с базовой мощностью 2,8 ГВт и дополнительных 1,2 ГВт хранилища делают это соглашение крупнейшей на сегодняшний день сделкой по поддержке компанией Meta✴ передовых ядерных технологий. В соответствии с дополнительным соглашением с Vistra, Meta✴ будет закупать более 2,1 ГВт энергии с двух действующих АЭС Davis-Besse и Perry в Огайо. Компания также планирует получить дополнительно 433 МВт путём модернизации этих двух АЭС, а также АЭС Beaver Valley в Пенсильвании. Все три АЭС расположены в регионе энергосистемы PJM и будут продолжать поставлять для неё электроэнергию, а их расширения станут крупнейшими проектами модернизации атомных электростанций, поддерживаемыми корпоративным клиентом в США, отметила компания. Партнёрство Meta✴ с Oklo позволит ввести в эксплуатацию в Огайо малые модульные реакторы (SMR) мощностью до 1,2 ГВт в 2030 году в округе Пайк (штат Огайо). Это соглашение закладывает основу для строительства нескольких реакторов Oklo Aurora Powerhouse, что, как ожидается, создаст тысячи рабочих мест на этапе строительства и долгосрочной эксплуатации, сообщила Meta✴. По словам компании, соглашение с Oklo позволит поддержать работу ИИ-суперкластера в Нью-Олбани (Огайо). Однако общая сумма инвестиций Meta✴ в Oklo не разглашается, отметил ресурс investors.com. Одним из крупнейших инвесторов Oklo является генеральный директор OpenAI Сэм Альтман (Sam Altman), владеющий 4,3 % акций стоимостью около $650 млн. Крупнейшие конкуренты Meta✴ также рассматривают атомную энергетику как средство для обеспечения работы своих вычислительных мощностей в области ИИ. Meta✴, Amazon (АЭС Susquehanna, SMR X-Energy) и Google (АЭС DAEC, SMR Kairos) подписали в марте 2025 года обязательство в поддержку утроения мирового производства атомной энергии к 2050 году.

25.12.2025 [22:52], Сергей Карасёв

Это вам не игрушки: Linux-планировщик, разработанный для Valve Steam Deck, оказался хорош и для серверов Meta✴Компания Meta✴, по сообщению ресурса Phoronix, использует на своих серверах планировщик задач Linux, который изначально был разработан для портативной игровой консоли Valve Steam Deck. Об этом инженеры гиперскейлера рассказали на мероприятии Linux Plumbers Conference в Токио. Речь идёт о решении SCX-LAVD, созданием которого по контракту с Valve занималась фирма Igalia, специализирующейся на Linux. Ранее планировщик SCX-LAVD уже применялся в различных проектах по разработке игрового софта для Linux, включая CachyOS Handheld Edition, Bazzite и др. Оказалось, что SCX-LAVD эффективно работает не только на портативных устройствах, но и на полноценных серверах. В Meta✴ рассматривали это решение в качестве «планировщика по умолчанию» для Linux-серверов с различным аппаратным оснащением и в разных сценариях использования, при которых не требуется специализированный планировщик. Специалисты Meta✴ пришли к выводу, что SCX-LAVD хорошо функционирует на серверах при наращивании ресурсов CPU и RAM. При этом обеспечивается необходимая балансировка нагрузки.

Источник изображения: Meta✴ В целом, как подчеркивается, SCX-LAVD демонстрирует производительность, аналогичную или даже превосходящую показатели EEVDF (Earliest Eligible Virtual Deadline First) — нового алгоритма планирования задач в ядре Linux, который заменяет старый планировщик CFS (Completely Fair Scheduler).

25.12.2025 [00:50], Владимир Мироненко

С глаз — долой, с баланса — вон: гиперскейлеры переложили на плечи инвесторов $120 млрд займовВ последнее время сформировался тренд на вывод технологическими компаниями за пределы своих балансов кредитования проектов по развитию ИИ-инфраструктуры. По данным The Financial Times, ряд IT-гигантов обошелся без учёта в своих балансах более $120 млрд, связанных с расходами на ЦОД, благодаря созданию компаний специального назначения — SPV (special-purpose vehicle), финансируемых большей частью инвесторами с Уолл-стрит, что усиливает опасения по поводу финансовых рисков их огромной ставки на ИИ. Речь идёт о Meta✴, xAI, Oracle и CoreWeave, которые лидируют по суммам заключённых сложных финансовых сделок, к которым они прибегли с целью защиты от рисков крупных заимствований, необходимых для строительства ИИ ЦОД. Указанную сумму им предоставили финансовые институты, включая Pimco, BlackRock, Apollo, Blue Owl Capital и американские банки, такие как JPMorgan, в виде заёмных и собственных средств. В октябре компания Meta✴ заключила крупнейшую сделку по привлечению частного кредита для строительства ЦОД Hyperion в Луизиане (США), в рамках которой была создана специализированная компания Beignet Investor совместно с нью-йоркской финансовой фирмой Blue Owl Capital. Beignet Investor привлекла $30 млрд, включая около $27 млрд кредитов от Pimco, BlackRock, Apollo и других, а также $3 млрд акционерного капитала от Blue Owl. Эта сделка не была отражена на балансе Meta✴, что упростило ей привлечение ещё $30 млрд на рынке корпоративных облигаций спустя несколько недель. Привлечение частного капитала через внебалансовые структуры защищает кредитные рейтинги компаний и улучшает их финансовые показатели, отметил The Financial Times. В данном случае Meta✴ получила во владение 20 % SPV и предоставила «гарантию остаточной стоимости» другим инвесторам. Это означает, что она должна будет вернуть средства инвесторам SPV, если стоимость ЦОД упадет ниже определённого уровня к концу срока аренды, а Meta✴ не станет продлевать договор аренды. Oracle стала лидером в структурировании крупных долгов через третьих лиц для оплаты своих огромных обязательств по сдаче в аренду вычислительных мощностей компании OpenAI. Она заключила партнёрские соглашения с застройщиками и финансистами, такими как Crusoe, Blue Owl Capital, Vantage и Related Digital, для строительства целого ряда ЦОД, каждый из которых будет принадлежать SPV. В частности, Blue Owl и JPMorgan инвестировали $13 млрд, включая $10 млрд заёмных средств, в SPV, владеющую ЦОД OpenAI в Абилине (штат Техас). Также упоминается пакет долговых обязательств на сумму $38 млрд для оплаты строительства двух ЦОД в Техасе и Висконсине, и кредит на сумму $18 млрд на строительство ЦОД в Нью-Мексико. При этом Oracle будет арендовать эти объекты у SPV. В случае дефолта кредиторы будут иметь право на активы — ЦОД, земельный участок, на котором он расположен, и оборудование, но не на компании, управляющие объектами. При этом Blue Owl стала более осторожно подходить к сделкам с Oracle. xAI использовала аналогичную стратегию для привлечения $20 млрд, включая до $12,5 млрд заёмных средств. Созданное SPV будет использовать эти деньги для покупки ускорителей NVIDIA с последующей сдачей их в аренду xAI. В марте CoreWeave заявила о создании SPV для выполнения контрактов на сумму $22,4 млрд на поставку вычислительных мощностей компании OpenAI, что «потребует привлечения заемных средств для финансирования своих обязательств». В июле компания заняла ещё $2,6 млрд для финансирования реализации контрактов с OpenAI. Традиционно технологические компании обладали значительными средствами и имели небольшую задолженность, что обеспечивало им отличные кредитные рейтинги и высокую уверенность со стороны инвесторов. Поскольку объём капитала, необходимого для финансирования роста ИИ-инфраструктуры, резко возрос, это истощило денежные резервы технологических компаний. По оценкам Morgan Stanley, для финансирования планов технологических компаний в области ИИ требуется $1,5 трлн внешнего финансирования. При этом частные инвесторы тоже стремятся заработать на буме ИИ, что повышает спрос на подобные сделки. По данным UBS, к началу 2025 года технологические компании привлекли у частных фондов около $450 млрд, что на $100 млрд больше, чем за предыдущие 12 месяцев. В этом году, по данным UBS, около $125 млрд было направлено на сделки по «проектному финансированию» — долгосрочному финансированию инфраструктурных проектов, таких как сделки Meta✴ и Blue Owl. Следует отметить, что не все гиперскейлеры следуют этому тренду. Google, Microsoft и Amazon — у которых до бума ИИ были крупные, хорошо зарекомендовавшие себя дата-центры — продолжают финансировать строительство за счёт собственных средств. Хотя Google и Amazon недавно привлекли инвесторов в облигации для прямого увеличения заёмных средств, эти три компании пока не сообщали о каком-либо значительном финансировании через SPV. Уолл-стрит также использует другие виды сделок на рынке ЦОД. По словам банкиров, в последние месяцы наблюдались сделки по секьюритизации долга в сфере ИИ, когда кредиторы объединяют непогашенные кредиты и продают инвесторам их доли в виде обеспеченных активами ценных бумаг. Два банкира оценили эти сделки в несколько миллиардов долларов. Такого рода сделки позволяют распределить риск кредитования провайдеров ЦОД между гораздо более широким кругом инвесторов, включая управляющих активами и пенсионные фонды. При этом множество сделок так или иначе связано с NVIDIA.

23.12.2025 [12:28], Сергей Карасёв

Goodram представила 122,88-Тбайт SSD для ЦОД с иммерсионным охлаждениемКомпания Goodram Industrial, принадлежащая Wilk Elektronik SA, без громких анонсов представила свой первый SSD вместимостью 122,88 Тбайт, предназначенный для использования в системах с иммерсионным (погружным) жидкостным охлаждением. Устройство рассчитано на дата-центры и площадки гиперскейлеров. Накопитель относится к семейству DC25F. В его основу положены чипы флеш-памяти QLC NAND. Доступны модификации в форм-факторах E3.S и E3.L: в обоих случаях для подключения служит интерфейс PCIe 5.0 x4. Заявленная скорость последовательного чтения информации достигает 14 600 Мбайт/с, скорость последовательной записи — 3200 Мбайт/с. Показатель IOPS составляет до 3 млн при произвольном чтении данных 4K-блоками и до 35 тыс. при произвольной записи. Накопители способны выдерживать 0,3 полных перезаписи в сутки (0,3 DWPD) на протяжении пяти лет. Это ставит их в один ряд с другими QLC-устройствами корпоративного класса, предназначенными для «теплого» и «холодного» хранения данных.

Источник изображения: Goodram Goodram отмечает, что накопители прошли всестороннее тестирование с использованием различных диэлектрических жидкостей для иммерсионного охлаждения, включая составы Shell и Chevron. Утверждается, что эти SSD рассчитаны на длительную эксплуатацию без деградации. Помимо модели вместимостью 122,88 Тбайт, Goodram предлагает широкий выбор других SSD для систем с иммерсионным охлаждением. Это устройства ёмкостью от 1,92 Тбайт и выше на основе чипов TLC NAND и QLC NAND с интерфейсами SATA, PCIe 4.0 и PCIe 5.0. Они доступны в форм-факторах SFF U.2 и U.3, E3.S и E1.S, M.2 2280 и M.2 22110.

11.12.2025 [09:03], Руслан Авдеев

Мы вам — ИИ, вы нам — энергию: Google и NextEra Energy совместно займутся постройкий ЦОД и развитием энергетикиЭнергетическая компания NextEra Energy заключила с Google Cloud соглашение о строительстве трёх кампусов ЦОД гигаваттного уровня с попутным созданием генерирующей и другой инфраструктуры, сообщает Datacenter Dynamics. Параллельно NextEra заключила с Meta✴ контракты на поставку 2,5 ГВт «чистой» энергии. В целом компании намерены совместно строить крупномасштабные ЦОД и энергетическую инфраструктуру, развивать передовые технологии и пересмотреть сами принципы работы энергетических компаний. В рамках партнёрства Google Cloud интегрирует генеративный ИИ и ИИ-агентов в инфраструктуру NextEra, чтобы помочь последней прогнозировать проблемы с оборудованием и выявлять прочие «узкие места» Партнёрство также обеспечит NextEra доступ к модели прогнозирования временных рядов TimesFM 2.5, метеомодели WeatherNext 2 и решению для моделирования перетоков мощности с учётом ограничений безопасности. За счёт этих технологий планируется получить более точные данные для оптимизации работы энергосети, что позволит улучшить планирование и качество управление сетью, снизить затраты и повысить надёжность электроснабжения клиентов NextEra Energy.

Источник изображения: NextEra Как считают в Google, интеграция компетенций NextEra с облачной ИИ-инфраструктурой Google Cloud, платформами и моделями компании поможет обеспечить «цифровое будущее» энергетической инфраструктуры. Первый коммерческий продукт для этой индустрии должен появиться на площадке Google Cloud Marketplace к середине 2026 года. Ранее Google и NextEra подписали 25-летнее соглашение на поставку электроэнергии (PPA), которое позволит перезапустить АЭС Duane Arnold Energy Center (DAEC), рядом с которой Google хочет построить до шесть ЦОД. С 2029 года практически вся энергия DAEC будет отправляться именно им. В результате Google получает стабильный и «чистый» источник энергии для своих ИИ-нагрузок, а NextEra — ресурсы для модернизации активов и передовые цифровые инструменты для повышения эффективности энергосети. Отдельно NextEra заключила соглашение с Meta✴ о поставках 2,5 ГВт «чистой» энергии в США. Речь идёт об 11 соглашениях о покупке энергии (PPA), и двух соглашениях о хранении энергии (Energy Storage Agreements, ESA). Соответствующие энергетические проекты должны заработать в 2026–2028 гг..

05.12.2025 [15:51], Руслан Авдеев

Meta✴ «одолжила» у Intel 250 МВт для своего ЦОД, пока та достраивает свою фабрикуПостроенная для будущей фабрики Intel электрическая подстанция компании AEP Ohio в округе Ликинг (Licking, Огайо) так и не была сдана заказчику, поэтому Meta✴ решила воспользоваться простаивающими мощностями, чтобы запитать свой ЦОД поблизости, сообщает Datacenter Dynamics. Подстанция может обеспечить ЦОД до 250 МВт. Сначала дата-центр Meta✴ получит 120 МВт, а к апрелю 2026 года, как ожидается, все доступные ему 250 МВт. Вся запланированная мощность 500 МВт будет передана исходному заказчику — Intel в начале 2029 года. AEP Ohio и Meta✴ обратились к регулятору штата Public Utilities Commission of Ohio с просьбой одобрить такой своеобразный «займ». Задержки в строительстве фабрики Intel в Нью-Олбани (New Albany) стоимостью $28 млрд привели к тому, что подстанция оказалась невостребованной. AEP Ohio сделку называет выигрышной для всех, компания гарантирует, что клиенты не понесут дополнительных расходов, связанных с подстанцией. Intel также поддержала соглашение, назвав его «продуктивным решением», приносящим пользу местному сообществу и обеспечивающим компании достаточно электроэнергии для удовлетворения производственных потребностей в Огайо. Intel начала строительство объекта в 2022 году, планируя ввести в эксплуатацию первые два здания в 2025-м. Тем не менее, задержки разного характера привели к тому, что ввод объекта в эксплуатацию отложен до 2030–2031 гг. Представители штата по-прежнему утверждают, что проект в конечном итоге будет реализован. Meta✴ ведёт деятельность в Нью-Олбани с 2017 года, первый кампус ЦОД был открыт там в 2020 году. В апреле 2022 года компания объявила, что намерена расширить свои площадки за счёт строительства двух зданий общей площадью около 92–93 тыс. м2. В июне 2025 года было объявлено о реализации энергетической генерирующей инициативы South Power Generation Project на 200 МВт, предусматривающей подачу электричества в ЦОД в Нью-Олбани в обход общих энергосетей. В Нью-Олбани находятся и несколько других крупных ЦОД, в проектах участвуют Microsoft, AWS и Google.

03.12.2025 [09:33], Владимир Мироненко

Foxconn поможет Google c TPU-серверами, а Google поможет Foxconn с «умными» роботамиFoxconn получила крупный заказ Google на поставку TPU-узлов, сообщил ресурс Taiwan Economic Daily со ссылкой на информированные источники. С учётом того, что Meta✴ планирует использовать ИИ-ускорители TPU в своих ИИ ЦОД в 2027 году, у Foxconn появилась возможность укрепить партнёрство с обоими гиперскейлерами. Да и самой Google уже сейчас катастрофически не хватает TPU для собственного облака. Foxconn уже является ключевым поставщиком платформ NVIDIA, хотя последняя всё больше ужесточает контроль над производством. По данным источников, ИИ-серверы для Google в основном поставляются в виде стоек с TPU. В этом году Google анонсировала тензорный ускоритель седьмого поколения TPU v7 Ironwood, первый чип компании, специально созданный для инференса, хотя область его применения также включает обучение крупномасштабных моделей и сложное обучение с подкреплением (RL). На его базе можно создавать кластеры (Pod) с объединением в единый вычислительный комплекс до 9216 чипов. По собственным данным Foxconn, он уже способна выпускать более 1000 ИИ-стоек в неделю. К концу 2026 года компания планирует увеличить этот показатель до более 2000 ед./нед. Также планы Foxconn включают расширение присутствия в США, где компания намерена не только осуществлять сборку серверов, но и наладить производство ключевых компонентов, таких как кабели, сетевое оборудование, системы теплоотвода и электропитания. Помимо выпуска ASIC-серверов, сотрудничество Foxconn и Google включает создание роботов, управляемых ИИ. Foxconn заключила партнерство с Intrinsic, робототехнической компанией, входящей в состав Alphabet, материнской компании Google, с целью создания совместного предприятия в США для строительства завода по выпуску роботов с поддержкой ИИ. Партнёры планируют интегрировать ИИ-платформу Intrinsic и интеллектуальную производственную платформу Foxconn для создания адаптивных интеллектуальных робототехнических решений, что ещё больше повысит эффективность производственных объектов Foxconn и всей её экосистемы. В прошлом месяце Google выпустила большую языковую модель Gemini 3, которая, как утверждается, превзошла OpenAI GPT-5 по нескольким ключевым показателям и ИИ-модели других конкурентов, что также способствовало росту популярности TPU. Согласно данным инсайдеров, Google призвала цепочку поставок ускориться в связи с предстоящим поступлением новых крупных заказов на TPU. |

|