Материалы по тегу: b300

|

18.02.2026 [18:50], Владимир Мироненко

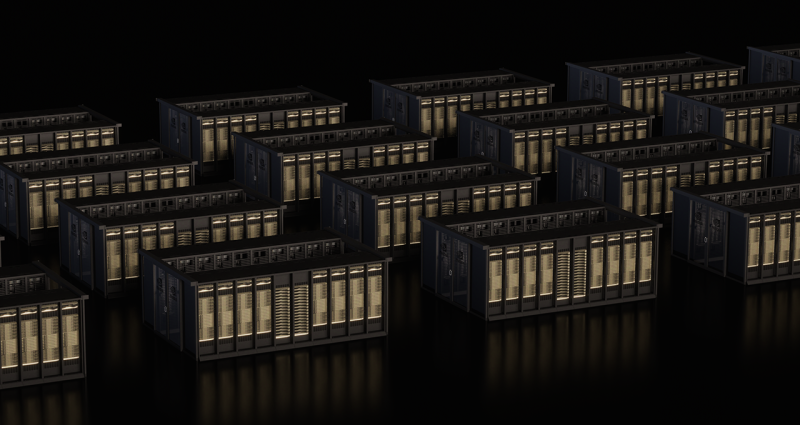

Власти Индии закупят ещё 20 тыс. ускорителей NVIDIA для ускорения развития ИИ в странеНа проходящем в Нью-Дели саммите India AI Impact Summit министр электроники и информационных технологий Индии Ашвини Вайшнау (Ashwini Vaishnaw) заявил, что Индия расширит свои вычислительные мощности для ИИ-нагрузок свыше имеющихся 38 тыс. ускорители, добавив еще 20 тыс. еди. в ближайшее время в рамках программы «Миссия ИИ 2.0». Вайшнау сообщил ресурсу EE Times, что заказы на новые GPU будут размещены в течение недели, и ожидается, что они будут развёрнуты в течение следующих шести месяцев. Расширение вычислительных мощностей происходит в ходе реализации рамочного соглашения между Индией и США на 2026 год, в соответствии с которым две страны договорились значительно увеличить торговлю технологическими продуктами, включая ускорители и другие компоненты для ЦОД. Соглашение предусматривает намерение Индии закупить в течение пяти лет американские энергоносители, самолёты, технологические товары и критически важные материалы на сумму $500 млрд, расширяя при этом совместное технологическое сотрудничество. Заявление Вайшнау говорит о дальнейшем развитии программы IndiaAI Mission, утверждённой в марте 2024 года с бюджетом около $1,14 млрд на пять лет. Первоначально программой планировалось развёртывание 10 тыс. GPU, но их количество уже достигло 38 тыс. Ускорители предоставляются местным компаниям по субсидированной ставке ₹65/час (около $0,72/час). С момента запуска в рамках программы IndiaAI Mission разрабатывались семь основных направлений, включая субсидированные вычислительные ресурсы, разработку базовых моделей, финансирование стартапов и безопасное управление ИИ. Двенадцать стартапов уже были отобраны для разработки отечественных многомодальных базовых моделей с использованием специфических для Индии наборов данных. NVIDIA сообщила о поддержке приоритетов IndiaAI Mission, включая, расширение вычислительных мощностей благодаря поставке ускорителей NVIDIA, разработку передовых ИИ-моделей и исследования и инновации в области ИИ. В рамках программы IndiaAI Mission компания сотрудничает с поставщиками облачных услуг Yotta, L&T и E2E Networks для создания передовых ИИ-фабрик. Yotta — поставщик облачных услуг, создающий крупномасштабную суверенную ИИ-инфраструктуру для Индии под брендом Shakti Cloud, работающую на базе более чем 20 тыс. ускорителей NVIDIA Blackwell Ultra. Его кампусы в Нави Мумбаи (Navi Mumbai) и Большой Нойде (Greater Noida) предоставляют индийским предприятиям и госсектору услуги облачных ИИ-сервисов с высокой пропускной способностью и большим количеством GPU с оплатой по мере использования. В свою очередь, компания E2E Networks создаёт кластер ускорителей NVIDIA Blackwell на своей платформе TIR, размещённый в ЦОД L&T Vyoma в Ченнаи (Chennai). Облачная платформа TIR будет включать системы NVIDIA HGX B200 и корпоративное ПО NVIDIA, а также открытые модели NVIDIA Nemotron для ускорения развития ИИ в таких областях, как агентный ИИ, здравоохранение, финансы, производство и сельское хозяйство. Третий индийский партнёр NVIDIA на ИИ-рынке — компания Netweb Technologies, которая запускает суперкомпьютерные системы Tyrone Camarero AI, построенные на узлах NVIDIA GB200 NVL4, произведённых в рамках государственной программы «Сделано в Индии». Сообщается, что облачная ИИ-инфраструктура в Индии будет размещать рабочие нагрузки, а также обеспечивать интеллектуальные возможности для обучения моделей, тонкой настройки и масштабного инференса. Мощности в этих ЦОД будут зарезервированы для разработчиков моделей, стартапов, исследователей и предприятий для создания, тонкой настройки и развёртывания ИИ в Индии. Ранее глава OpenAI Сэм Альтман (Sam Altman) заявил, что Индия способна стать одним из мировых ИИ-лидеров, особенно в создании малых рассуждающих моделей (SLM).

18.02.2026 [09:19], Сергей Карасёв

Meta✴ развернёт ИИ-инфраструктуру на «миллионах ускорителей NVIDIA Blackwell и Rubin», а также Arm-чипах GraceКомпании NVIDIA и Meta✴ объявили о многолетнем стратегическом партнёрстве, охватывающем локальную, облачную и ИИ-инфраструктуры. В частности, Meta✴ будет использовать в своих дата-центрах решения NVIDIA как для обучения больших языковых моделей (LLM), так и для инференса. Сообщается, что Meta✴ возьмёт на вооружение чипы NVIDIA Grace, которые будут использоваться в серверах, основанных исключительно на CPU-архитектуре (без ускорителей на основе GPU). Изделия Grace, напомним, объединяют 72 вычислительных ядра Armv9 Neoverse V2 (Demeter) с тактовой частотой до 3,35 ГГц и до 480 Гбайт памяти LPDDR5x. Доступна также сборка Grace Superchip, которая состоит из двух кристаллов Grace и чипов памяти LPDDR5x общим объёмом до 960 Гбайт. Meta✴ намерена применять изделия Grace для решения общих задач, а также поддержания работы ИИ-агентов, которым не требуются ИИ-ускорители. Вице-президент NVIDIA Иэн Бак (Ian Buck) отмечает, что решения Grace способны обеспечить вдвое большую производительность на 1 Вт при выполнении операций общего назначения по сравнению с альтернативными платформами. В дальнейшем Meta✴ планирует использовать Arm-процессоры NVIDIA следующего поколения — решения Vera. Крупномасштабные развёртывания систем на базе Vera намечены на 2027 год, что поможет Meta✴ в развитии энергоэффективных вычислений и формировании широкой экосистемы Arm.

Источник изображения: Meta✴ Кроме того, в рамках партнёрства Meta✴ будет использовать «миллионы ускорителей NVIDIA Blackwell и Rubin». Так, на основе изделий NVIDIA GB300 компании создадут единую среду, охватывающую локальные дата-центры и облачные ресурсы, что позволит упростить операции при одновременном улучшении производительности и масштабируемости. Среди прочего Meta✴ будет применять сетевую платформу NVIDIA Spectrum-X Ethernet и технологию NVIDIA Confidential Computing для защиты данных. «Мы рады расширить партнёрство с NVIDIA с целью создания передовых кластеров на основе платформы Vera Rubin — это позволит предоставить персональный суперинтеллект каждому человеку в мире», — говорит Марк Цукерберг (Mark Zuckerberg), основатель и генеральный директор Meta✴. Нужно отметить, что среди гиперскейлеров только Meta✴ и Oracle используют в своих инфраструктурах сторонние чипы с архитектурой Arm. В то же время AWS, Google и Microsoft развивают собственные Arm-проекты — изделия Graviton, Axion и Cobalt соответственно.

11.02.2026 [13:38], Руслан Авдеев

Армения получит ещё 41 тыс. NVIDIA GB300 для ИИ ЦОД Firebird за $4 млрдАмериканская компания Firebird, специализирующаяся на облачных и инфраструктурных решениях для ИИ, объявила о реализации второго этапа суперкомпьютерного мегапроекта в Армении. Она получила экспортные лицензии США и разрешения регуляторов на поставку в страну ещё 41 тыс. ускорителей NVIDIA GB300, сообщает HPC Wire. Расширение вычислительного кластера в Армении знаменует собой важную веху. Предполагается, что страна войдёт в пятёрку мест размещения крупнейших кластеров ИИ-ускорителей. Проект стоимостью $4 млрд — одно из крупнейших капиталовложений в технологическую сферу в истории страны. Подробности в ходе визита в Ереван раскрыл вице-президент США Джей Ди Вэнс (JD Vance) при участии вице-президента NVIDIA. По словам Вэнса, США «с гордостью» одобрили замечательное техническое соглашение с NVIDIA. Речь идёт об открытии новых рынков и новых рабочих мест как для американских работников, так и для армянских. 8 августа прошлого года Армения и США подписали меморандум в сфере ИИ и полупроводников. Выданная США экспортная лицензия свидетельствует о том, что проект полностью соответствует американским требованиям. Второй этап — продолжение реализации плана Firebird, выделившей $500 млн на создание в Армении первого ИИ-кластера. Реализация двух этапов обеспечит качественный скачок в технологической инфраструктуре страны. Он позволит проводить исследования в биологии, робототехнике, космической сфере и в сфере ИИ нового поколения. По словам представителей Firebird, новый кластер превращает Армению в глобальный центр суперкомпьютерных вычислений.

12.01.2026 [14:41], Сергей Карасёв

ASRock Rack показала ИИ-сервер на базе NVIDIA HGX B300 с СЖО ZutaCore HyperCoolКомпания ASRock Rack на выставке CES 2026 продемонстрировала ИИ-сервер 4U16X-GNR2/ZC, первая информация о котором была раскрыта в октябре прошлого года. Новинка создана в партнёрстве с разработчиком систем жидкостного охлаждения ZutaCore. Устройство выполнено в форм-факторе 4U. Возможна установка двух процессоров Intel Xeon 6700E (Sierra Forest-SP) или Xeon 6500P/6700P (Granite Rapids-SP). Доступны 32 слота для модулей оперативной памяти DDR5, три разъёма PCIe 5.0 x16 для карт FHHL и два сетевых порта 1GbE на базе контроллера Intel I350-AM2. Задействована аппаратная платформа NVIDIA HGX B300. Для отвода тепла используется система прямого жидкостного охлаждения ZutaCore HyperCool. Это двухфазное решение основано на применении специальной диэлектрической жидкости, которая не вызывает коррозии. Утверждается, что конструкция HyperCool безопасна для IT-оборудования и гарантирует сохранение работоспособности даже в случае утечки. СЖО поставляется в полностью собранном виде, что сокращает время монтажа в стойку. Сервер 4U16X-GNR2/ZC оборудован 12 фронтальными отсеками для SFF-накопителей с интерфейсом PCIe 5.0 x4 (NVMe); допускается горячая замена. Кроме того, есть внутренний разъём для одного SSD типоразмера М.2 (PCIe 5.0 x2). За питание отвечают десять блоков мощностью 3000 Вт с сертификатом 80 Plus Titanium. Габариты машины составляют 900 × 448 × 175 мм. Отмечается, что в стандартной стойке 42U могут быть размещены до восьми подобных серверов, что обеспечивает высокую плотность вычислительной мощности для наиболее ресурсоёмких нагрузок ИИ.

22.12.2025 [14:36], Руслан Авдеев

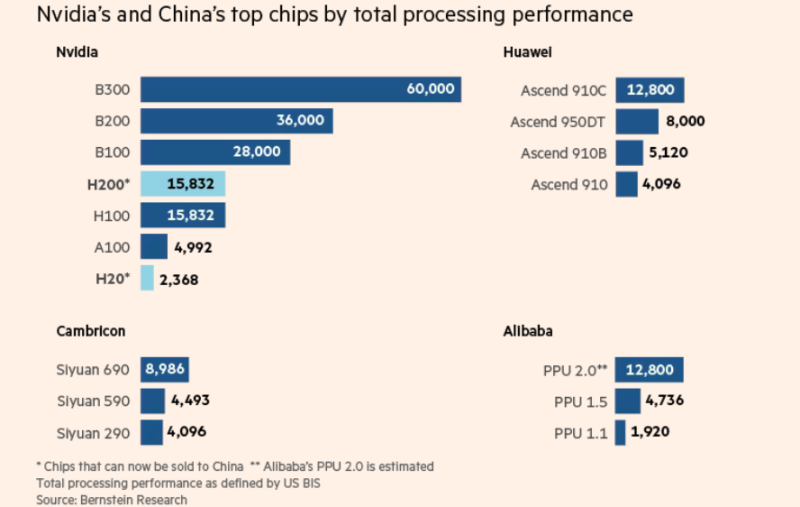

Японское неооблако Datasection предоставит китайской Tencent десятки тысяч подсанкционных чипов NVIDIA B200/B300Хотя некоторые международные игроки стремятся ограничить доступ Китая к передовым американским чипам, в дата-центре близ Осаки (Япония) современные ИИ-ускорители используются единственным клиентом — китайской Tencent, сообщает The Financial Times. Чипы NVIDIA B200 принадлежат японской Datasection, недавно переключившейся с маркетинговых решений на управление ИИ ЦОД. С тех пор компания заключила соглашение с клиентом на сумму $1 млрд, а тот получил доступ к значительной части из 15 тыс. ИИ-ускорителей NVIDIA Blackwell. По словам источников издания, этим клиентом и является Tencent. Сделка позволяет китайскому техногиганту использовать довольно сложную, но вполне легальную стратегию для доступа к передовым ИИ-чипам на фоне санкций США. В результате сделки Datasection превратилась в одну из крупнейших «неооблачных» компаний в Азии. По словам представителя компании, менее полугода назад для обеспечения работы ИИ-моделей было достаточно 5 тыс. чипов B200, а теперь требуется минимум 10 тыс. Правила, которые вводили при прошлом президенте США, должны были закрыть юридическую лазейку, позволяющую китайским компаниями получать доступ к передовым ИИ-ускорителями в ЦОД и облаках за пределами КНР, но в мае новый президент отменил их. Теперь же одобрена поставка в Китай чипов NVIDIA H200, поэтому компании вроде Tencent, возможно, снова смогут строить собственные ИИ ЦОД на более современных ускорителях. Однако по словам Bernstein Research, использование зарубежных облаков вместо покупки чипов может оказаться для китайских технологических групп даже более привлекательным вариантом.

Источник изображения: The Financial Times Datasection намерена создать ИИ ЦОД с более 100 тыс. ускорителей NVIDIA. По некоторым данным, первые 15 тыс. чипов в основном зарезервированы для Tencent на три года. Впрочем, в самой Datasection вероятную сделку не комментируют, упоминая лишь о «крупном клиенте». По данным The Financial Times, в июле Datasection заключила контракт с «одним из крупнейших в мире поставщиков облачных услугу» на $406 млн, согласившись заплатить $272 млн за 5 тыс. B200 для объекта в Осаке, а уже в августе оборудование прибыло в Японию. Вскоре партнёры заключили ещё одну сделку, на этот раз на $800 млн с расчётом на второй ИИ ЦОД в Сиднее, где будут развёрнуты десятки тысяч B300. В декабре Datasection объявила, что первые 10 тыс. ускорителей B300 для сиднейского дата-центра обойдутся в $521 млн. В компании утверждают, что речь идёт о первом в мире ИИ-кластере гиперскейл-уровня на базе B300. По данным источников, мощности австралийского ЦОД тоже будут использоваться преимущественно Tencent. Контракт с «крупным клиентом» заключён на пять лет, с возможным продлением на два года. По сведениям источников, посредником (для защиты данных) выступает токийская NowNaw. Datasection может расторгнуть соглашения, если США вновь изменят правила работы с КНР.

Источник изображения: Datasection Все участники сделки уверяют, что соблюдают все применимые законы, в том числе относительно использования зарубежных облачных сервисов. По словам Datasection, Министерство торговли Соединённых Штатов и NVIDIA одобрили использование ей ИИ-ускорителей. Кроме того, принимаются меры, чтобы компания не попадала под действие некоторых японских законов, в том числе о валютном контроле. В будущем Datasection рассчитывает выйти на рынок высокодоходных облачных сервисов, в частности, она нацелена на экспансию в Европу. В прошлом году она привлекла в совет директоров испанского и американского политиков. В Datasection уверены, что даже если ограничения США на экспорт ослабят, дав китайскому бизнесу доступ к самым передовым чипам NVIDIA, ей это не помешает. Как считают представители неооблачной компании, спрос на вычислительные мощности так высок, что новых клиентов найти будет несложно. В худшем случае деятельность придётся остановить «скажем, на неделю». В 2025 году акции Datasection выросли почти на 185 %, хотя и успели упасть с лета на фоне опасений по поводу избыточных инвестиций в ИИ и торговых атак на ценные бумаги со стороны участников фондового рынка.

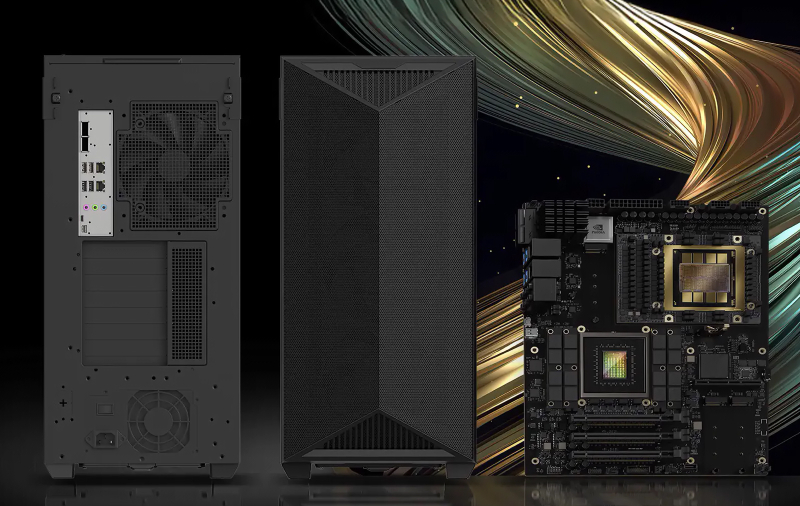

26.11.2025 [13:48], Сергей Карасёв

MSI представила рабочую станцию CT60-S8060 на базе NVIDIA GB300Компания MSI анонсировала мощную рабочую станцию CT60-S8060, ориентированную на ресурсоёмкие задачи в сфере ИИ, такие как обучение больших языковых моделей и инференс, а также на анализ крупных массивов данных и пр. Новинка построена на аппаратной платформе NVIDIA. В основу системы положен «персональный ИИ-суперкомпьютер» DGX Station. Используется суперчип GB300: объединены ускоритель B300 с 288 Гбайт памяти HBM3E (до 8 Тбайт/с) и процессор Grace с 72 Arm-ядрами. Присутствуют 496 Гбайт памяти LPDDR5X с пропускной способностью до 396 Гбайт/с. Блоки CPU и GPU связаны интерконнектом NVLink-C2C, который обеспечивает скорость передачи данных до 900 Гбайт/с. Рабочая станция заключена в корпус с габаритами 245 × 528,4 × 595 мм. Доступны два слота PCIe 5.0 x16 (на уровне сигналов x8 каждый) для карт расширения одинарной ширины и слот PCIe 5.0 x16 для карты двойной ширины. Кроме того, есть по два разъёма М.2 2280 с интерфейсом PCIe 5.0 x2 (NVMe) и M.2 2280 с интерфейсом PCIe 6.0 x4 (NVMe) для SSD, а также коннектор М.2 2232 (PCIe x1) для комбинированного адаптера Wi-Fi/Bluetooth. Система располагает контроллером Aspeed AST2600 BMC, сетевым адаптером NVIDIA ConnectX-8 с двумя портами 400GbE QSFP и контроллером Marvel AQC113, на основе которого реализован порт 10GbE RJ45. В тыльной части сосредоточены аудиогнёзда, порты USB Type-A и USB Type-C. Питание обеспечивает блок формата ATX мощностью 1600 Вт с сертификатом 80 PLUS Titanium.

21.11.2025 [14:14], Руслан Авдеев

AWS и Humain построят в Эр-Рияде кампус AI Zone, где развернут до 150 тыс. ИИ-ускорителей NVIDIA GB300 и Amazon TrainiumAWS и инвестиционная компания Humain из Саудовской Аравии объявили о планах развёртывания в кампусе AI Zone в Эр-Рияде до 150 тыс. ИИ-ускорителей. В рамках расширенного партнёрства компании намерены предоставлять вычислительные мощности и ИИ-сервисы из Саудовской Аравии клиентам со всего мира. Первый в своём роде в Саудовской Аравии кампус AI Zone будет применяться для обучения ИИ и инференса, с доступом к новейшей ИИ-инфраструктуре на основе ускорителей NVIDIA GB300 и Amazon Trainium. Клиенты смогут быстро переходить от стадии концепции к непосредственно работам, а «железо» и ПО NVIDIA будут бесшовно интегрированы с инфраструктурой и сервисами AWS. Поддержка Amazon Bedrock, AgentCore и SageMaker обеспечит клиентам немедленный доступ к базовым моделям в рамках единой платформы без необходимости управления базовой инфраструктурой. Для расширения возможностей AI Zone компания Humain присоединится к программе AWS Solution Provider Program. Это поможет реализации совместного плана, анонсированного в мае 2025 года и предусматривающего инвестиции более $5 млрд в ИИ-инфраструктуру, сервисы AWS, обучение и развитие ИИ-специалистов в Саудовской Аравии. Представитель AWS в регионе EMEA заявил, что объединяя локальный опыт и инвестиции Humain с решениями AWS в сфере ИИ, а также аппаратные решения NVIDIA, инновационную платформу Amazon Bedrock и решения для бизнес-пользователей, включая Amazon Quick Suite, партнёры создают инновационный центр мирового уровня, способный обслуживать клиентов по всему миру. AWS и Humain также ускорят внедрение ИИ в государственном и частном секторах, в том числе развитие LLM с поддержкой арабского языка, включая ALLAM, и создание единого маркетплейса ИИ-агентов для правительственных сервисов.

Истчоник изображения: backer Sha/unsplash.com Для подготовки квалифицированных кадров AWS обучит 100 тыс. граждан Саудовской Аравии работе с облачными технологиями и специфике генеративного ИИ в рамках программы Amazon Academy, отдельно планируется поддержать программу повышения квалификации для 10 тыс. женщин. Усилия направлены на подготовку кадров для «ИИ-центричной» экономики, которая, по прогнозам, к 2030 году внесёт в ВВП страны вклад в объёме $130 млрд. Подобные проекты стали возможны во многом благодаря визиту в США наследного принца Саудовской Аравии Мохаммеда бин Салмана (Mohammed bin Salman). Визит способствовал ряду соглашений американских компаний с саудовским бизнесом и Humain в частности — с участием AMD, xAI, NVIDIA и др., а также открыл дорогу для поставок в королевство передовых ИИ-чипов.

14.11.2025 [01:55], Владимир Мироненко

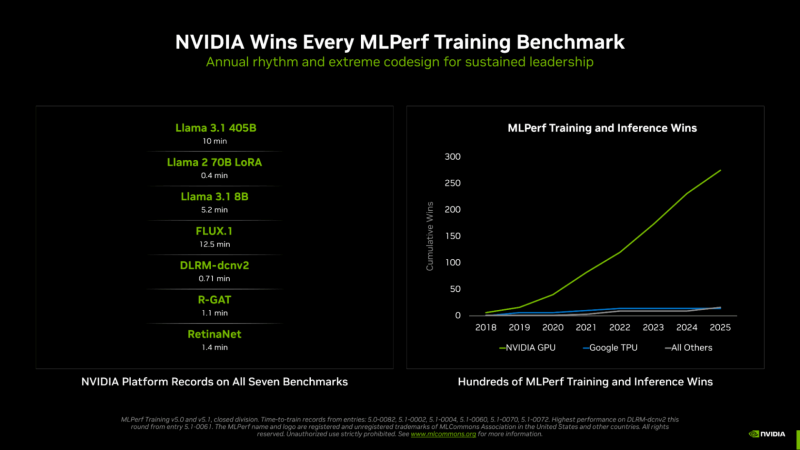

NVIDIA вновь впереди всех в новом раунде MLPerf Training v5.1Консорциум MLCommons опубликовал результаты тестирования различных аппаратных решений в бенчмарке MLPerf Training v5.1. На этот раз был установлен новый рекорд по разнообразию представленных систем. Участники этого раунда тестирования представили 65 уникальных систем, оснащённых 12 различными аппаратными ускорителями и различными программными платформами. Почти половина заявок была для многоузловых систем, что на 86 % больше, чем в раунде MLPerf Training 4.1 год назад, причём они так же отличались разнообразием сетевых архитектур. Раунд MLPerf Training v5.1 включает в себя результаты 20 компаний, подавших заявки: AMD, ASUS, Cisco, Dell, Giga Computing, HPE, Krai, Lambda, Lenovo, MangoBoost, MiTAC, Nebius, NVIDIA, Oracle, Quanta Cloud Technology (QCT), Supermicro, Supermicro + MangoBoost, Университет Флориды, Verda (DataCrunch), Wiwynn. Также сообщается, что структура заявок свидетельствует о растущем внимании к тестам, ориентированным на задачи генеративного ИИ: количество заявок на тест Llama 2 70B LoRa увеличилось на 24 %, а на новый тест Llama 3.1 8B — на 15 % по сравнению с тестом, который он заменил (BERT). NVIDIA объявила, что её чипы на архитектуре NVIDIA Blackwell заняли первые позиции во всех семи тестах MLPerf Training v5.1, обеспечив максимально быстрое обучение в работе с большими языковыми моделями (LLM), генерацией изображений, рекомендательными системами, компьютерным зрением и графическими нейронными сетями. NVIDIA подчеркнула, что была единственной платформой, которая предоставила результаты по всем тестам — это, по словам компании, «подчёркивает широкие возможности программирования ускорителей NVIDIA, а также зрелость и универсальность программного стека CUDA». Компания сообщила, что в этом раунде MLPerf Training дебютировала стоечная система GB300 NVL72, работающая на базе ускорителя NVIDIA Blackwell Ultra, показав рекордные результаты и доказав, что является наилучшим выбором для интенсивных рабочих ИИ-нагрузок. При предварительном обучении Llama 3.1 40B ускорители GB300 обеспечивают более чем вчетверо большую производительность по сравнению с H100 и почти вдвое — по сравнению с GB200. Аналогичным образом, при точной настройке Llama 2 70B восемь ускорителей GB300 обеспечили в пять раз большую производительность по сравнению с H100. NVIDIA отметила, что этого удалось достичь благодаря архитектурным усовершенствованиям Blackwell Ultra, включая новые тензорные ядра, которые обеспечивают ИИ-производительность в формате NVFP4 в размере 15 Пфлопс, вдвое большую производительность в работе механизма внимания (attention-layer compute) и 279 Гбайт HBM3e, а также новые методы обучения, которые позволили повысить вычислительную производительность архитектуры NVFP4. В MLPerf также дебютировала 800G-платформа Quantum-X800 InfiniBand, объединяющая несколько систем GB300 NVL72, которая удвоила пропускную способность сети по сравнению с предыдущим поколением. Но по словам компании, «ключом к выдающимся результатам в этом раунде было выполнение вычислений с использованием NVFP4 — впервые в истории MLPerf Training». NVIDIA обеспечила поддержку FP4 для обучения LLM на каждом уровне, что позволило удвоить скорость вычислений по сравнению с FP8. Ускоритель NVIDIA Blackwell может выполнять вычисления в формате FP4 (в т.ч. NVFP4 и др.) с удвоенной скоростью по сравнению с FP8, а Blackwell Ultra — с утроенной. На сегодняшний день NVIDIA является единственной платформой, которая представила результаты MLPerf Training с вычислениями, выполненными с использованием FP4 при соблюдении строгих требований к точности в тесте. Эти результаты были получены с использованием 5120 ускорителей Blackwell GB200, которым потребовалось всего 10 мин. на бенчмарк Llama 3.1 405B, что является новым рекордом. Это в 2,7 раза быстрее, чем лучший результат с использованием архитектуры Blackwell, показанный в предыдущем раунде бенчмарка. NVIDIA также установила рекорды производительности в двух новых тестах: Llama 3.1 8B и FLUX.1. Llama 3.1 8B — компактная, но обладающая высокой производительностью LLM — заменила модель BERT-large, добавив в линейку базовых моделей современную LLM малого размера. NVIDIA представила результаты с использованием до 512 ускорителей Blackwell Ultra, потратив 5,2 мин. на прохождение теста. FLUX.1 — современная модель генерации изображений — заменила Stable Diffusion v2, и только платформа NVIDIA представила результаты этого теста. NVIDIA представила результаты с использованием 1152 ускорителей Blackwell, установив рекорд — 12,5 мин. обучения.

12.11.2025 [15:17], Руслан Авдеев

Microsoft инвестирует $10 млрд в ИИ ЦОД в ПортугалииMicrosoft потратит $10 млрд на ИИ ЦОД на побережье Португалии. Это станет одной из крупнейших инвестиций компании в Европе в 2025 году, сообщает Bloomberg. Речь о проекте кампуса в Синише (Sines) в 150 км от Лиссабона. Строительством парка занимается Microsoft совместно с португальской Start Campus и британским стартапом Nscale. Информацию о проекте и сумме подтвердил президент Microsoft Брэд Смит (Brad Smith). Как отмечает Datacenter Dynamics, в начале года в кампусе введён в эксплуатацию первый из шести планируемых объектов — ЦОД SIN01. $10 млрд покроют расходы на развитие второй фазы проекта. Второй ЦОД SIN02 обеспечит 180 МВт и уже строится. Общая мощность кампуса должна составить 1,2 ГВт. Пока неизвестно, в скольких проектах ЦОД на площадке Microsoft и Nscale будут участвовать совместно. Партнёрство Microsoft, Nscale и Start Campus было анонсировано в октябре 2025 года. Nscale развернёт для Microsoft в Синише 12,6 тыс. ускорителей NVIDIA GB300. Столкнувшись с нехваткой мощностей, компания подписала соглашения с несколькими неооблаками на $60 млрд, в том числе с CoreWeave, Nebius, IREN и Lambda. Только за последний квартал на аренду потрачено $11,1 млрд. Мощности Nscale компания намерена арендовать в Великобритании, США и Норвегии. Всего Microsoft намерена арендовать у Nscale 116 тыс. ускорителей GB300. Хотя большинство ЦОД расположены в районе Лиссабона (присутствуют объекты AtlasEdge, Claranet, Edged, Tata Communications и Equinix), прибрежный город Синиш с населением порядка 15 тыс. человек становится ключевым инвестиционным хабом Португалии. Отсюда проложены и подводные кабели, ещё больше появится в будущем — Medusa, New CAM Ring, Nuvem и Olisipo. В мае китайская CALB Group начала строить в городе фабрику по производству аккумуляторов за €2 млрд ($2,3 млрд). Также Синиш, возможно, станет домом для «ИИ-гигафабрики», поддерживаемой Евросоюзом.

09.11.2025 [13:38], Сергей Карасёв

Nebius Аркадия Воложа развернула в Великобритании платформу AI Cloud на базе NVIDIA HGX B300Компания Nebius (бывшая материнская структура «Яндекса» Yandex N.V.) объявила о своём первом развёртывании ИИ-инфраструктуры в Великобритании. Кластер Nebius AI Cloud расположен в кампусе Longcross Park на площадке Ark Data Centres недалеко от Лондона. Как отмечает основатель и генеральный директор Nebius Аркадий Волож, Великобритания является одним из ведущих ИИ-центров в мире. Поэтому для компании создание кластера на территории этой страны имеет большое значение. Кластер состоит из 126 стоек с оборудованием, размещённых в трёх машинных залах. В рамках первой фазы проекта установлены 4 тыс. ускорителей NVIDIA HGX B300 (Blackwell Ultra) в составе серверов пятого поколения (Gen5) собственной разработки Nebius. Вторая фаза предполагает монтаж ещё 3 тыс. ускорителей B300. Общая мощность системы — 16 МВт. По заявлениям Nebius, британский кластер AI Cloud использует передовые энергоэффективные технологии охлаждения, сетевое подключение NVIDIA Quantum-X800 InfiniBand с низкой задержкой и надёжную локальную систему генерации электроэнергии. Говорится о полной интеграции с программной платформой NVIDIA AI Enterprise, предназначенной для разработки и развёртывания ИИ-приложений. Объединяя нашу облачную инфраструктуру с новейшими технологиями NVIDIA, мы предоставляем организациям по всей Великобритании возможность обучать, развёртывать и масштабировать модели и приложения ИИ быстрее, безопаснее и эффективнее, чем когда-либо», — говорит Волож. Британский кластер использует облачную платформу Nebius AI Cloud 3.0 Aether, которая разработана специально для создания и использования ИИ в таких областях, как здравоохранение, финансы, науки о жизни, корпоративный сектор и государственная сфера. Говорится о поддержке сквозного шифрования и о полном соответствии стандартам защиты данных GDPR и CCPA. Ранее Nebius сообщила о запуске своего первого кластера AI Cloud в Израиле, который расположился на площадке в Модиине (Modiin). У Nebius также имеются дата-центры в Финляндии, Франции и США. |

|