Материалы по тегу: hgx

|

12.01.2026 [14:41], Сергей Карасёв

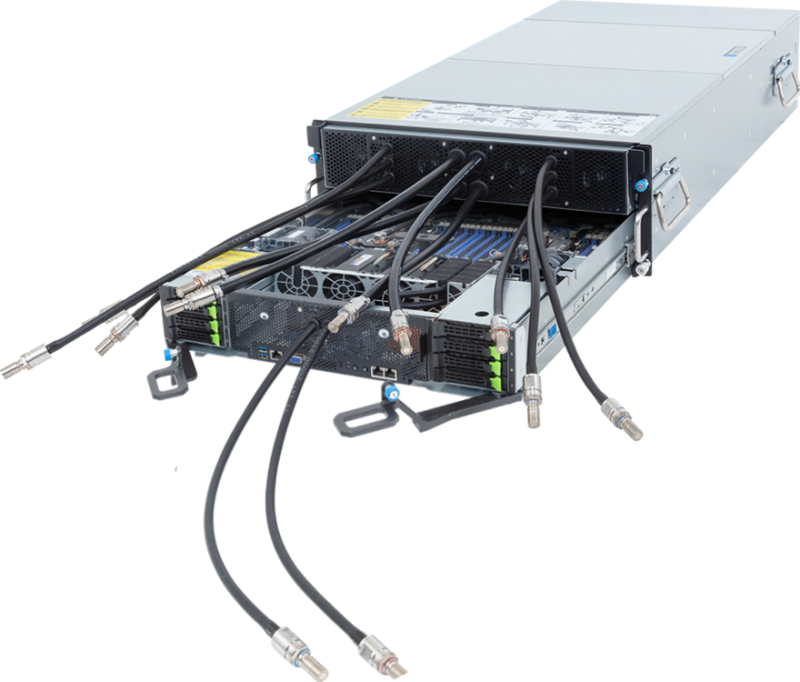

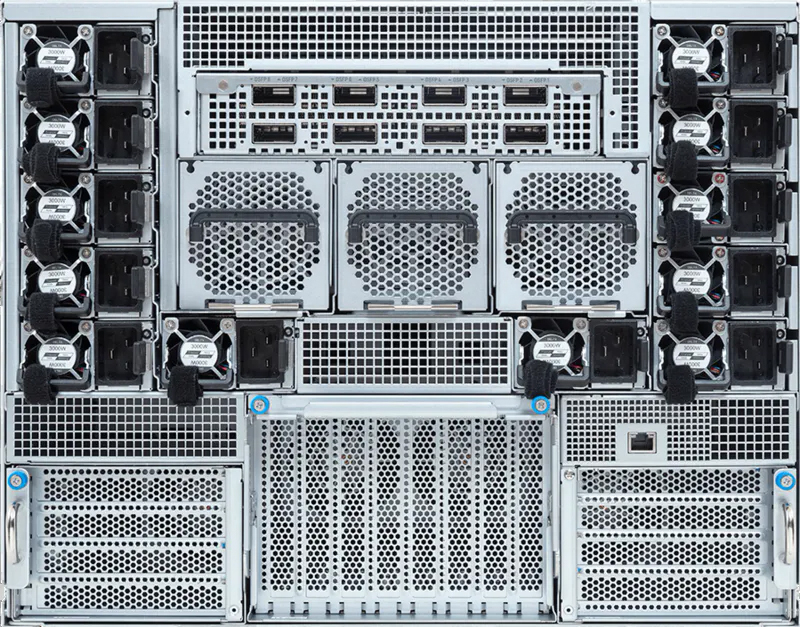

ASRock Rack показала ИИ-сервер на базе NVIDIA HGX B300 с СЖО ZutaCore HyperCoolКомпания ASRock Rack на выставке CES 2026 продемонстрировала ИИ-сервер 4U16X-GNR2/ZC, первая информация о котором была раскрыта в октябре прошлого года. Новинка создана в партнёрстве с разработчиком систем жидкостного охлаждения ZutaCore. Устройство выполнено в форм-факторе 4U. Возможна установка двух процессоров Intel Xeon 6700E (Sierra Forest-SP) или Xeon 6500P/6700P (Granite Rapids-SP). Доступны 32 слота для модулей оперативной памяти DDR5, три разъёма PCIe 5.0 x16 для карт FHHL и два сетевых порта 1GbE на базе контроллера Intel I350-AM2. Задействована аппаратная платформа NVIDIA HGX B300. Для отвода тепла используется система прямого жидкостного охлаждения ZutaCore HyperCool. Это двухфазное решение основано на применении специальной диэлектрической жидкости, которая не вызывает коррозии. Утверждается, что конструкция HyperCool безопасна для IT-оборудования и гарантирует сохранение работоспособности даже в случае утечки. СЖО поставляется в полностью собранном виде, что сокращает время монтажа в стойку. Сервер 4U16X-GNR2/ZC оборудован 12 фронтальными отсеками для SFF-накопителей с интерфейсом PCIe 5.0 x4 (NVMe); допускается горячая замена. Кроме того, есть внутренний разъём для одного SSD типоразмера М.2 (PCIe 5.0 x2). За питание отвечают десять блоков мощностью 3000 Вт с сертификатом 80 Plus Titanium. Габариты машины составляют 900 × 448 × 175 мм. Отмечается, что в стандартной стойке 42U могут быть размещены до восьми подобных серверов, что обеспечивает высокую плотность вычислительной мощности для наиболее ресурсоёмких нагрузок ИИ.

06.01.2026 [14:28], Владимир Мироненко

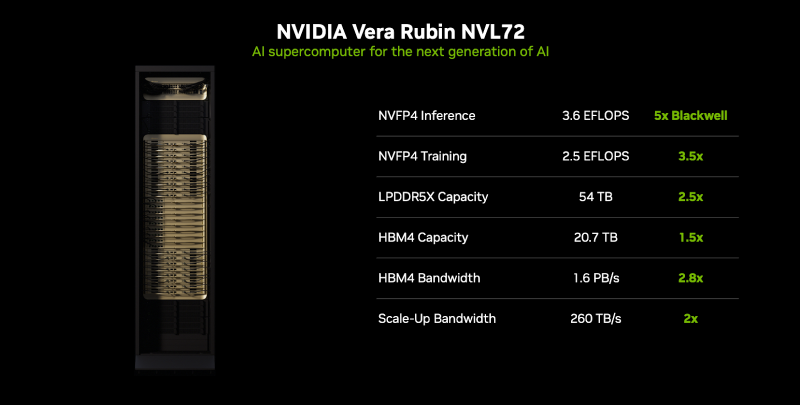

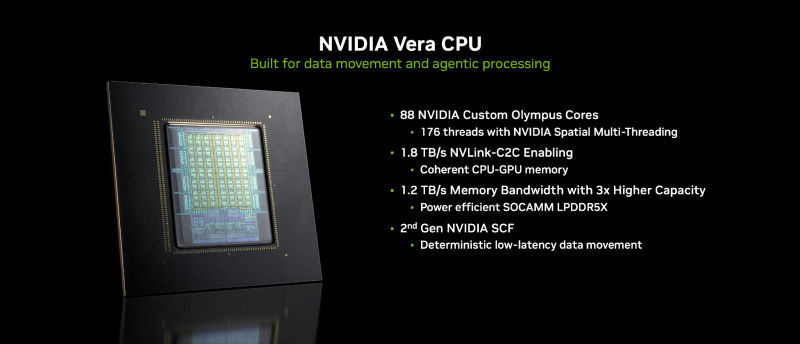

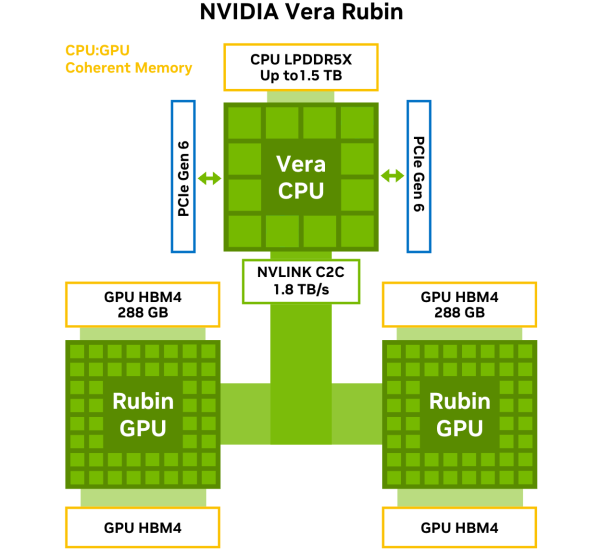

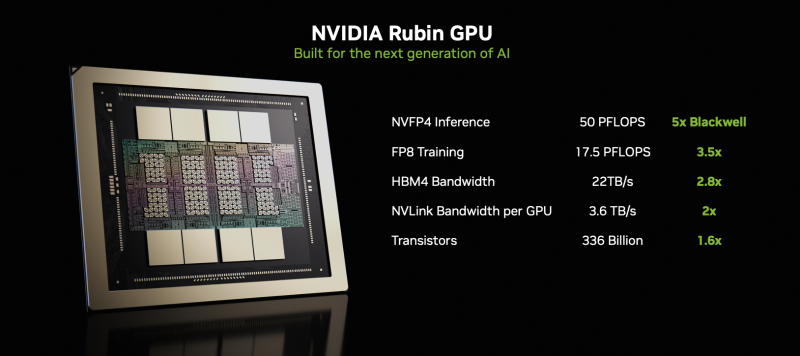

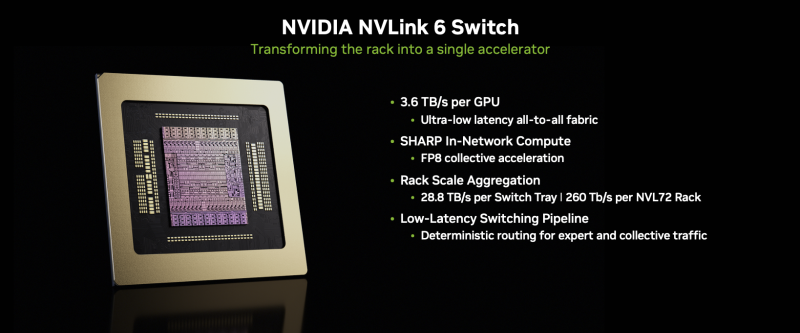

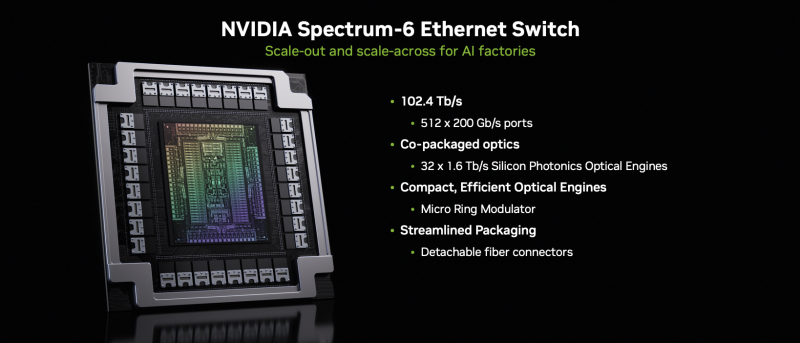

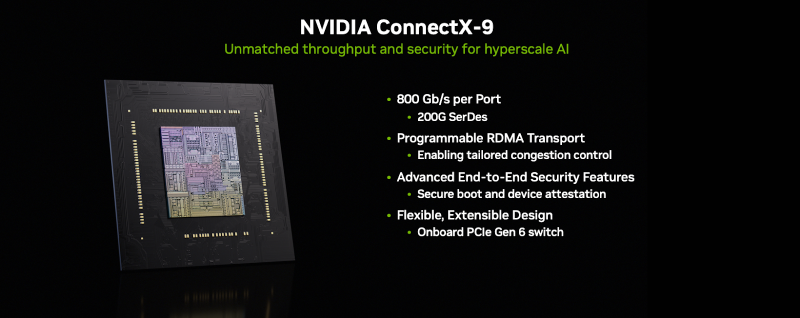

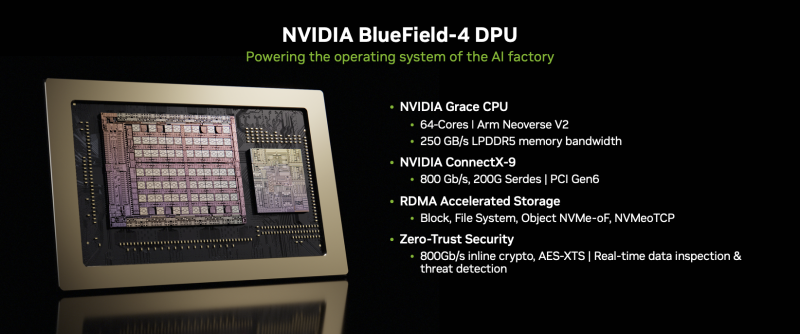

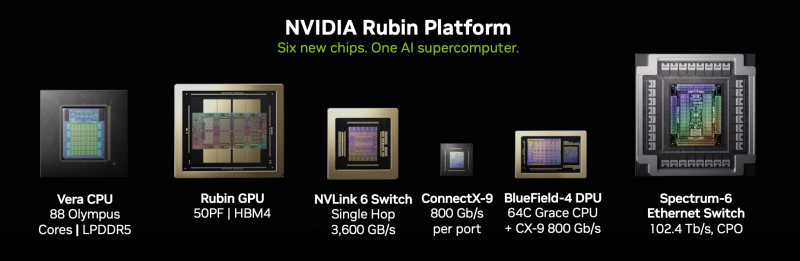

NVIDIA объявила о запуске платформы Vera Rubin NVL72NVIDIA объявила о запуске платформы следующего поколения Rubin, которая приходит на смену Blackwell Ultra. Компания отметила, что платформа Rubin объединяет сразу пять инноваций, включая новейшие поколения интерконнекта NVIDIA NVLink, Transformer Engine, Confidential Computing и RAS Engine, а также процессор NVIDIA Vera. Примечательно, что NVIDIA снова решила вернуться к именованию на основе количества суперчипов (NVL72), а не ускорителей (NVL144), как обещала в прошлом году. Созданная с использованием экстремального совместного проектирования на аппаратном и программном уровнях, NVIDIA Vera Rubin обеспечивает десятикратное снижение стоимости токенов для инференса и четырёхкратное сокращение количества ускорителей для обучения моделей MoE по сравнению с платформой NVIDIA Blackwell. Коммутационные системы NVIDIA Spectrum-X Ethernet Photonics обеспечивают пятикратное повышение энергоэффективности и времени безотказной работы. Платформа Rubin построена на шести чипах — Arm-процессоре Vera, ускорителе Rubin, коммутаторе NVLink 6, адаптере ConnectX-9 SuperNIC, DPU BlueField-4 и Ethernet-коммутаторе NVIDIA Spectrum-6. Ускорители Rubin поначалу будут доступны в двух форматах. В первом случае — в составе стоечной платформы DGX Vera Rubin NVL72, которая объединяет 72 ускорителя Rubin и 36 процессоров Vera, NVLink 6, ConnectX-9 SuperNIC и BlueField-4. Также ускорители Rubin будут доступны в составе платформы DGX/HGX Rubin NVL8 на базе x86-процессоров. Обе платформы будут поддерживаться кластерами NVIDIA DGX SuperPod, сообщил ресурс CRN. Как отметила NVIDIA, разработанный для агентного мышления, процессор NVIDIA Vera является самым энергоэффективным процессором для крупномасштабных ИИ-фабрик. Он оснащён 88 кастомными Armv9.2-ядрами Olympus с 176 потоками с новой технологией пространственной многопоточности NVIDIA, 1,5 Тбайт системной памяти SOCAMM LPDDR5x (1,2 Тбайт/с), возможностями конфиденциальных вычислений и быстрым интерконнектом NVLink-C2C (1,8 Тбайт/с в дуплексе). NVIDIA Rubin с аппаратным адаптивным сжатием данных обеспечивает до 50 Пфлопс (NVFP4) для инференса, что в пять раз быстрее, чем Blackwell. Он также обеспечивает до 35 Пфлопс (NVFP4) в режиме, что в 3,5 раза быстрее, чем его предшественник. Пропускная способность 288 Гбайт HBM4 составляет 22 Тбайт/с, что в 2,8 раза быстрее предшественника, а пропускная способность NVLink на один ускоритель вдвое выше — 3,6 Тбайт/с (в дуплексе). NVIDIA также сообщила, что Vera Rubin NVL72 обладает 54 Тбайт памяти LPDDR5x, что в 2,5 раза больше, чем у Blackwell, и 20,7 Тбайт памяти HBM4, что на 50 % больше, чем у предшественника. Агрегированная пропускная способность HBM4 достигает 1,6 Пбайт/с, что в 2,8 раза больше, а скорость интерконнекта составляет 260 Тбайт/с, что вдвое больше, чем у платформы Blackwell NVL72, и «больше, чем пропускная способность всего интернета». Ожидаемый уровень энергопотребления составит от 190 до 230 кВт на стойку. Компания отметила, что Vera Rubin NVL72 — первая стоечная платформа, обеспечивающая конфиденциальные вычисления, которая поддерживает безопасность данных на уровне доменов CPU, GPU и NVLink. Коммутатор NVLink 6 с жидкостным охлаждением оснащён 400G-блоками SerDes, обеспечивает пропускную способность 3,6 Тбайт/с на каждый GPU для связи между всеми GPU, общую пропускную способность 28,8 Тбайт/с и 14,4 Тфлопс внутрисетевых вычислений в формате FP8. Хотя NVIDIA заявила, что Rubin находится в «полномасштабном производстве», аналогичные продукты от партнёров появятся только во II половине этого года. Среди ведущих мировых ИИ-лабораторий, поставщиков облачных услуг, производителей компьютеров и стартапов, которые, как ожидается, внедрят Rubin, компания назвала Amazon Web Services (AWS), Anthropic, Black Forest Labs, Cisco, Cohere, CoreWeave, Cursor, Dell Technologies, Google, Harvey, HPE, Lambda, Lenovo, Meta✴, Microsoft, Mistral AI, Nebius, Nscale, OpenAI, OpenEvidence, Oracle Cloud Infrastructure (OCI), Perplexity, Runway, Supermicro, Thinking Machines Lab и xAI. ИИ-лаборатории, включая Anthropic, Black Forest, Cohere, Cursor, Harvey, Meta✴, Mistral AI, OpenAI, OpenEvidence, Perplexity, Runway, Thinking Machines Lab и xAI, рассматривают платформу NVIDIA Rubin для обучения более крупных и мощных моделей, а также для обслуживания мультимодальных систем с длинным контекстом с меньшей задержкой и стоимостью по сравнению предыдущими поколениями ускорителей. Партнёры по инфраструктурному ПО и хранению данных AIC, Canonical, Cloudian, DDN, Dell, HPE, Hitachi Vantara, IBM, NetApp, Nutanix, Pure Storage, Supermicro, SUSE, VAST Data и WEKA работают с NVIDIA над разработкой платформ следующего поколения для инфраструктуры Rubin. В связи с тем, что рабочие нагрузки агентного ИИ генерируют огромные объёмы контекстных данных, NVIDIA также представляла новую платформу хранения контекста инференса NVIDIA Inference Context Memory Storage Platform — новый класс инфраструктуры хранения, разработанной для масштабирования контекста инференса. Сообщается, что платформа, работающая на базе BlueField-4, обеспечивает эффективное совместное использование и повторное применение данных KV-кеша в рамках всей ИИ-инфраструктуры, повышая скорость отклика и пропускную способность, а также обеспечивая предсказуемое и энергоэффективное масштабирование агентного ИИ. Дион Харрис (Dion Harris), старший директор NVIDIA по высокопроизводительным вычислениям и решениям для ИИ-инфраструктуры, сообщил, что по сравнению с традиционными сетевыми хранилищами для данных контекста инференса, новая платформа обеспечивает до пяти раз больше токенов в секунду, в пять раз лучшую производительность на доллар и в пять раз лучшую энергоэффективность.

09.11.2025 [13:38], Сергей Карасёв

Nebius Аркадия Воложа развернула в Великобритании платформу AI Cloud на базе NVIDIA HGX B300Компания Nebius (бывшая материнская структура «Яндекса» Yandex N.V.) объявила о своём первом развёртывании ИИ-инфраструктуры в Великобритании. Кластер Nebius AI Cloud расположен в кампусе Longcross Park на площадке Ark Data Centres недалеко от Лондона. Как отмечает основатель и генеральный директор Nebius Аркадий Волож, Великобритания является одним из ведущих ИИ-центров в мире. Поэтому для компании создание кластера на территории этой страны имеет большое значение. Кластер состоит из 126 стоек с оборудованием, размещённых в трёх машинных залах. В рамках первой фазы проекта установлены 4 тыс. ускорителей NVIDIA HGX B300 (Blackwell Ultra) в составе серверов пятого поколения (Gen5) собственной разработки Nebius. Вторая фаза предполагает монтаж ещё 3 тыс. ускорителей B300. Общая мощность системы — 16 МВт. По заявлениям Nebius, британский кластер AI Cloud использует передовые энергоэффективные технологии охлаждения, сетевое подключение NVIDIA Quantum-X800 InfiniBand с низкой задержкой и надёжную локальную систему генерации электроэнергии. Говорится о полной интеграции с программной платформой NVIDIA AI Enterprise, предназначенной для разработки и развёртывания ИИ-приложений. Объединяя нашу облачную инфраструктуру с новейшими технологиями NVIDIA, мы предоставляем организациям по всей Великобритании возможность обучать, развёртывать и масштабировать модели и приложения ИИ быстрее, безопаснее и эффективнее, чем когда-либо», — говорит Волож. Британский кластер использует облачную платформу Nebius AI Cloud 3.0 Aether, которая разработана специально для создания и использования ИИ в таких областях, как здравоохранение, финансы, науки о жизни, корпоративный сектор и государственная сфера. Говорится о поддержке сквозного шифрования и о полном соответствии стандартам защиты данных GDPR и CCPA. Ранее Nebius сообщила о запуске своего первого кластера AI Cloud в Израиле, который расположился на площадке в Модиине (Modiin). У Nebius также имеются дата-центры в Финляндии, Франции и США.

30.10.2025 [12:20], Сергей Карасёв

ASUS представила ИИ-сервер XA NB3I-E12 на базе NVIDIA HGX B300Компания ASUS анонсировала сервер XA NB3I-E12 на аппаратной платформе NVIDIA HGX B300, предназначенный для интенсивных нагрузок ИИ. В качестве потенциальных заказчиков системы названы предприятия, которые работают с большими языковыми моделями (LLM) и НРС-приложениями: это могут быть научно-исследовательские структуры и финансовые организации, компании автомобильного сектора и пр. Сервер выполнен в форм-факторе 9U. Возможна установка двух процессоров Intel Xeon 6700P поколения Granite Rapids с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5-6400 RDIMM / 3DS RDIMM. Во фронтальной части расположены 10 посадочных мест на SFF-накопителей (NVMe). Предусмотрены четыре слота расширения PCIe 5.0 х16 и один слот PCIe 5.0 х8. Система имеет архитектуру 8-GPU (NVIDIA HGX B300 288GB 8-GPU). Задействованы сетевые адаптеры NVIDIA ConnectX-8 и DPU NVIDIA BlueField-3. Реализованы два сетевых порта 10GbE с разъёмами RJ45 на основе контроллера Intel X710-AT2 и выделенный сетевой порт управления (RJ45). Питание обеспечивают 10 блоков мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Применяется воздушное охлаждение; диапазон рабочих температур — от +10 до +35 °C. ASUS отмечает, что сервер имеет модульную конструкцию, благодаря чему минимизируется использование кабелей, упрощается обслуживание и повышается ремонтопригодность. Габариты устройства составляют 945 × 447 × 394,5 мм, масса — примерно 120 кг без установленных накопителей.

21.10.2025 [21:50], Владимир Мироненко

Nebius запустила первый в Израиле ИИ ЦОД с NVIDIA HGX B200Компания Nebius объявила о доступности платформы Nebius AI Cloud в своем новом ЦОД в Израиле, запущенном на площадке в Модиине (Modiin). Сообщается, что это один из крупнейших в стране ИИ-кластеров и первый на архитектуре NVIDIA Blackwell. Кластер включает 4 тыс. ускорителей в составе HGX B200, объединённых интерконнектом NVIDIA Quantum InfiniBand, и предоставляет доступ к стеку NVIDIA AI Enterprise, в том числе к микросервисам NVIDIA NIM и инструментам управления ИИ-агентами NeMo. Запуск в Израиле последовал за аналогичными развёртываниями Nebius в Европе и США. Новая площадка объединяет передовую аппаратную и программную инфраструктуру, включая усовершенствованные системы охлаждения, системы управления энергопотреблением и механизмы управления данными, разработанные для интенсивных рабочих ИИ-нагрузок. Nebius — партнёр NVIDIA по облачным технологиям (NCP). «Запуск Nebius крупнейшего в Израиле облака ИИ на базе Blackwell знаменует собой начало развития инфраструктуры ИИ в стране», — сообщил директор представительства NVIDIA в Израиле, отметив, что благодаря суверенному доступу к передовым вычислительным, сетевым технологиям и ПО, израильские компании и разработчики смогут внедрять инновации, развёртывать и масштабировать следующее поколение агентного и физического ИИ. Nebius входит в число первых партнёров NCP, получивших сертификат Exemplar Cloud для учебных рабочих нагрузок на базе NVIDIA H100, продемонстрировав производительность в пределах 95 % от референсной архитектуры NVIDIA. Платформа Nebius AI Cloud получила сертификацию SOC2 Type II, включая HIPAA, и обеспечивает сквозное шифрование, а также полное соответствие стандартам защиты данных GDPR и CCPA.

14.10.2025 [09:54], Сергей Карасёв

Giga Computing представила ИИ-сервер TO86-SD1 на платформе NVIDIA HGX B200Компания Giga Computing, подразделение Gigabyte, анонсировала высокопроизводительный сервер TO86-SD1 для обучения ИИ-моделей, инференса и ресурсоёмких HPC-задач. Новинка выполнена в форм-факторе 8OU в соответствии со стандартом OCP ORv3. Возможна установка двух процессоров Intel Xeon 6500P/6700P (Granite Rapids-SP) с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 (RDIMM 6400 или MRDIMM 8000). Во фронтальной части предусмотрены отсеки для восьми SFF-накопителей с интерфейсом PCIe 5.0 (NVMe); поддерживается горячая замена. Есть коннектор M.2 2280/22110 для SSD (PCIe 5.0 x4). Упомянута поддержка CXL 2.0. Сервер несёт на борту ИИ-ускорители NVIDIA HGX B200 поколения Blackwell в конфигурации 8 × SXM. Суммарный объём памяти HBM3E составляет 1,4 Тбайт. Доступны 12 слотов PCIe 5.0 x16 для карт расширения FHHL с доступом через лицевую панель корпуса. Говорится о совместимости с NVIDIA BlueField-3 DPU и NVIDIA ConnectX-7 NIC.

Источник изображения: Giga Computing В оснащение входят контроллер ASPEED AST2600, два сетевых порта 10GbE на базе Intel X710-AT2, выделенный сетевой порт управления 1GbE, разъёмы USB 3.2 Gen1 Type-C, Micro-USB и Mini-DP. Применяется система воздушного охлаждения с четырьмя 92-мм вентиляторами в области материнской платы и двенадцатью 92-мм кулерами в GPU-секции. Диапазон рабочих температур — от +10 до +35 °C. Заявлена совместимость с Windows Server, RHEL, Ubuntu, Citrix, VMware ESXi.

18.09.2025 [15:25], Сергей Карасёв

Giga Computing представила флагманский ИИ-сервер на базе NVIDIA HGX B300Компания Giga Computing, подразделение Gigabyte, анонсировала сервер G894-SD3-AAX7 — флагманскую систему, предназначенную для решения сложных HPC-задач, обучения больших языковых моделей (LLM), инференса и других ресурсоёмких ИИ-нагрузок. В основу новинки положены процессорры Intel Xeon Granite Rapids и ускорители NVIDIA Blackwell Ultra. Сервер выполнен в форм-факторе 8U. Возможна установка двух процессоров Xeon 6500P/6700P с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 RDIMM-6400 или MRDIMM-8000. Во фронтальной части расположены восемь посадочных мест для SFF-накопителей с интерфейсом PCIe 5.0 (NVMe) и поддержкой горячей замены. Кроме того, есть два внутренних коннектора для SSD типоразмера M.2 2280/22110 (PCIe 5.0 x4 и PCIe 5.0 x2).  Система, построенная на платформе NVIDIA HGX B300, имеет восемь SXM-ускорителей Blackwell Ultra. Могут быть реализованы восемь портов 800G OSFP InfiniBand или 16 портов 400GbE посредством адаптеров NVIDIA ConnectX-8 SuperNIC. Говорится о поддержке DPU NVIDIA BlueField-3 и о наличии четырёх слотов PCIe 5.0 x16 для карт FHHL.  Сервер оснащён двумя портами 10GbE на базе Intel X710-AT2, выделенным сетевым портом управления 1GbE, контроллером ASPEED AST2600, двумя портами USB 3.2 Gen1 Type-A и интерфейсом D-Sub. Применяется воздушное охлаждение. За питание отвечают 12 блоков мощностью 3000 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур — от +10 до +30 °C.

12.08.2025 [16:32], Сергей Карасёв

Supermicro представила 4U-сервер на базе NVIDIA HGX B200 с СЖОКомпания Supermicro анонсировала GPU-сервер SYS-422GS-NBRT-LCC для ресурсоёмких нагрузок, включая задачи ИИ, построенный на аппаратной платформе Intel Granite Rapids. Устройство оборудовано системой прямого жидкостного охлаждения DLC-2. Новинка выполнена в форм-факторе 4U. Допускается установка двух процессоров Xeon 6700P с TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти: максимальный объём ОЗУ составляет 4 Тбайт в случае DDR5-6400 ECC и 8 Тбайт при использовании DDR5-5200 ECC. Сервер располагает восемью слотами PCIe 5.0 x16 для низкопрофильных карт расширения и двумя разъёмами PCIe 5.0 x16 для карт полной высоты и половинной длины (FHHL). Сервер оснащён ИИ-ускорителями NVIDIA HGX B200 поколения Blackwell в конфигурации 8 × SXM. Предусмотрены восемь фронтальных отсеков для накопителей E1.S с поддержкой горячей замены, а также два отсека для M.2 NVMe SSD. Имеются два сетевых порта 10GbE (RJ45) на основе контроллера Intel X710-AT2. Система может быть укомплектована восемью однопортовыми адаптерами NVIDIA ConnectX-7 NIC или NVIDIA BlueField-3 SuperNIC, а также двумя двухпортовыми DPU NVIDIA BlueField-3. Реализованы интерфейсы Mini-DP и D-Sub. Питание обеспечивают четыре блока мощностью 6600 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур — от +10 до +35 °C. Помимо системы DLC-2, установлены шесть вентиляторов диаметром 80 мм. Габариты сервера составляют 174 × 448 × 991,4 мм, масса — 107 кг.

Источник изображения: Supermicro

06.07.2025 [23:08], Сергей Карасёв

Giga Computing представила ИИ-серверы на базе NVIDIA HGX B200 с воздушным и жидкостным охлаждениемКомпания Giga Computing, подразделение Gigabyte, представила серверы G4L3-SD1-LAX5, G4L3-ZD1-LAX5, G894-AD1-AAX5 и G894-SD1-AAX5 для приложений ИИ, инференса и других ресурсоёмких нагрузок. В основу новинок положена платформа NVIDIA HGX B200 в конфигурации 8 × SXM. Модель G4L3-SD1-LAX5 типоразмера 4U оснащена системой прямого жидкостного охлаждения (DLC) с отдельными зонами CPU и GPU. Допускается установка двух процессоров Intel Xeon Sapphire Rapids или Xeon Emerald Rapids с показателем TDP до 385 Вт. Предусмотрены 32 слота для модулей DDR5-5600, восемь фронтальных отсеков для SFF-накопителей (NVMe/SATA), а также два коннектора для SSD типоразмера M.2 2280/22110 (PCIe 3.0 x2 и PCIe 3.0 x1). Доступны восемь разъёмов для однослотовых карт расширения FHHL PCIe 5.0 x16 и четыре разъёма для карт FHHL PCIe 5.0 x16 двойной ширины. В оснащение входят контроллер ASPEED AST2600, два сетевых порта 10GbE на базе Intel X710-AT2 и выделенный сетевой порт управления 1GbE. Питание обеспечивают восемь блоков мощностью 3000 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур простирается от +10 до +35 °C. Вариант G4L3-ZD1-LAX5 рассчитан на два чипа AMD EPYC 9004 (Genoa) или EPYC 9005 (Turin) с TDP до 500 Вт. Этот сервер также выполнен в формате 4U и оборудован DLC-охлаждением. Есть 24 слота для модулей DDR5-6400, восемь фронтальных отсеков для SFF-накопителей NVMe и два внутренних коннектора для SSD стандартов M.2 2280/22110 (PCIe 3.0 x4 и PCIe 3.0 x1). Прочие характеристики аналогичны предыдущей модели. Двухпроцессорные серверы G894-AD1-AAX5 и G894-SD1-AAX5 типоразмера 8U наделены воздушным охлаждением, включая 15 вентиляторов диаметром 80 мм в зоне GPU. Вариант G894-AD1-AAX5 поддерживает установку чипов Intel Xeon 6900 с показателем TDP до 500 Вт и 24 модулей DDR5 (RDIMM-6400 или MRDIMM-8800). Модификация G894-SD1-AAX5, в свою очередь, рассчитана на процессоры Intel Xeon 6700/6500 с TDP до 350 Вт и 32 модуля DDR5 (RDIMM-6400 или MRDIMM-8000). Оба сервера оборудованы двумя портами 10GbE (Intel X710-AT2), сетевым портом управления 1GbE, контроллером ASPEED AST2600, восемью фронтальными отсеками для SFF-накопителей NVMe, двумя коннекторами M.2 2280/22110 (PCIe 5.0 x4 и PCIe 5.0 x2). Имеются восемь разъёмов для карт расширения FHHL PCIe 5.0 x16 одинарной ширины и четыре разъёма для карт FHHL PCIe 5.0 x16 двойной ширины. Установлены 12 блоков питания мощностью 3000 Вт с сертификатом 80 PLUS Titanium. Серверы могут эксплуатироваться при температурах от +10 до +30 °C.

26.06.2025 [12:05], Сергей Карасёв

HPE представила ИИ-систему Compute XD690 на базе NVIDIA HGX B300Компания HPE анонсировала высокопроизводительный сервер Compute XD690, предназначенный для решения таких ресурсоёмких задач, как обучение ИИ-моделей, инференс и пр. В основу новинки положены процессоры Intel и ускорители NVIDIA на архитектуре Blackwell. Поставки новинки компания планирует организовать в октябре нынешнего года. Система Compute XD690 выполнена в форм-факторе 10U с воздушным охлаждением. Полностью технические характеристики не раскрываются, но известно, что конфигурация включает два чипа Intel Xeon 6. Задействована платформа NVIDIA HGX B300 с восемью модулями Blackwell Ultra SXM. Заявленная производительность на операциях FP64 достигает 10 Тфлопс, на операциях FP4 — 144 Пфлопс. Суммарный объём памяти HBM3e составляет около 2,3 Тбайт. Применяется интерконнект NVLink пятого поколения с общей пропускной способностью 14,4 Тбайт/с. Говорится о поддержке XDR InfiniBand и Spectrum-X Ethernet.

Источник изображения: HPE Как отмечает HPE, ускорители Blackwell Ultra обеспечивают на 50 % более высокую производительность FP4 и удвоенную пропускную способность GPU↔CPU по сравнению с решениями на архитектуре Blackwell предыдущего поколения. Благодаря этому возможна работа со сложными ИИ-моделями, агентами ИИ, рассуждающими системами и пр. Среди других вариантов использования названы генерация фотореалистичных видеоматериалов и симуляция детализированного 3D-окружения для робототехнических сред и самоуправляемых транспортных средств. |

|