Материалы по тегу: sc23

|

23.11.2023 [20:38], Сергей Карасёв

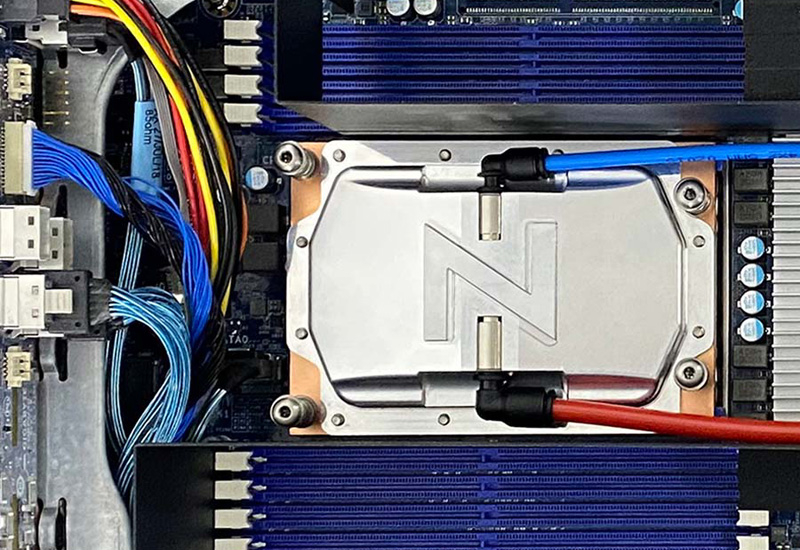

1,5 кВт на чип: ZutaCore показала высокоэффективную систему прямого жидкостного охлаждения HyperCoolКомпания ZutaCore на конференции SC23 сообщила о том, что её система прямого жидкостного охлаждения HyperCool Direct-On-Chip вошла в состав серверов Dell и Pegatron на платформе Intel Xeon Sapphire Rapids. Двухфазная система HyperCool способна эффективно отводить тепло от самых мощных серверных процессоров — с показателем TDP 1500 Вт и более. Это комплексное решение с замкнутым контуром вместо воды использует специальную диэлектрическую жидкость, благодаря чему оборудование защищено от коррозии. Платформа HyperCool обладает хорошей масштабируемостью и может быть развёрнута в новых или модернизированных дата-центрах — cтандартизированный интегрированный 6U-модуль способен отводить 100 кВт и выше. Система обеспечивает коэффициент PUE меньше 1,02. Конструкция HyperCool позволяет повторно использовать выделяемое тепло — например, для обогрева зданий. СЖО подходит для применения в ЦОД, ориентированных на решение задач ИИ и НРС. Система позволяет снизить общее энергопотребление и сократить выбросы вредных газов в атмосферу.

Источник изображения: ZutaCore Отмечается, что недавно технология HyperCool была сертифицирована для высокопроизводительных серверов ASUS. Кроме того, в экосистему ZutaCore входят AMD, Boston Limited, Dell, Equinix, Intel, World Wide Technologies (WWT) и другие. Утверждается, что по сравнению с традиционными системами охлаждения решение HyperCool обеспечивает сокращение совокупной стоимости владения на 50 %.

13.11.2023 [17:00], Игорь Осколков

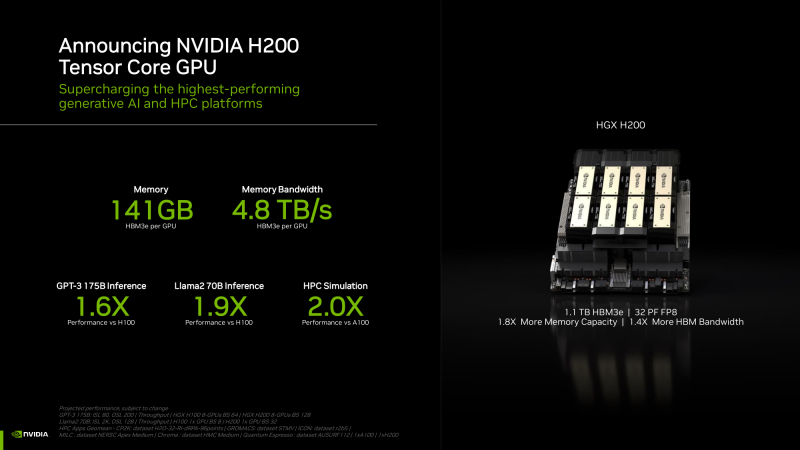

NVIDIA анонсировала ускорители H200 и «фантастическую четвёрку» Quad GH200NVIDIA анонсировала ускорители H200 на базе всё той же архитектуры Hopper, что и их предшественники H100, представленные более полутора лет назад. Новый H200, по словам компании, первый в мире ускоритель, использующий память HBM3e. Вытеснит ли он H100 или останется промежуточным звеном эволюции решений NVIDIA, покажет время — H200 станет доступен во II квартале следующего года, но также в 2024-м должно появиться новое поколение ускорителей B100, которые будут производительнее H100 и H200.

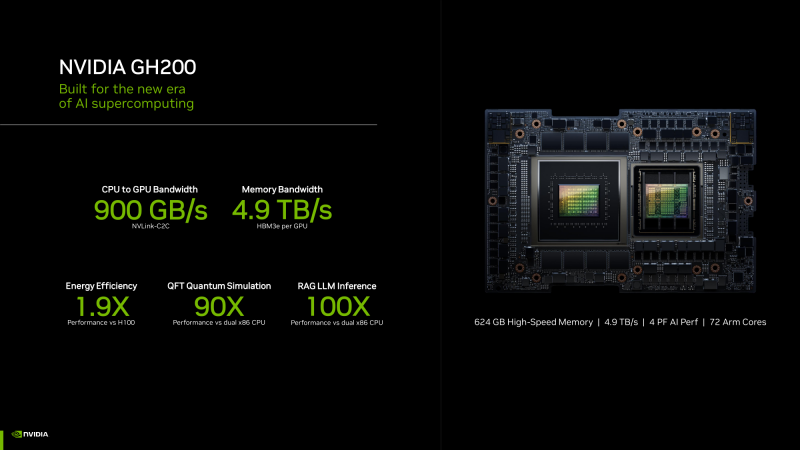

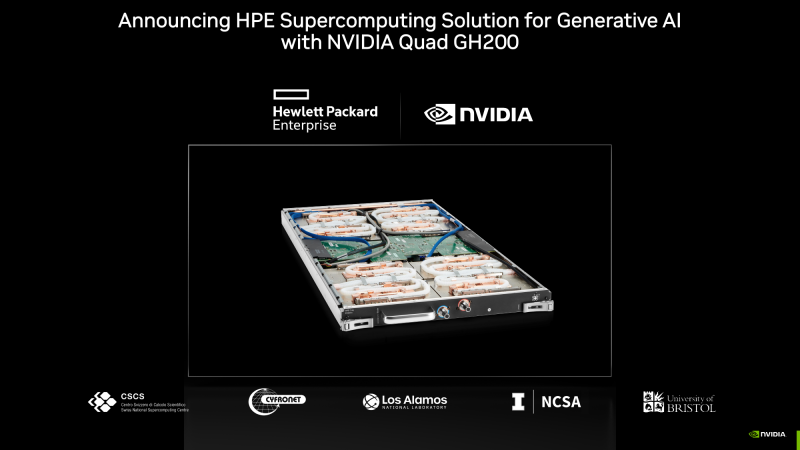

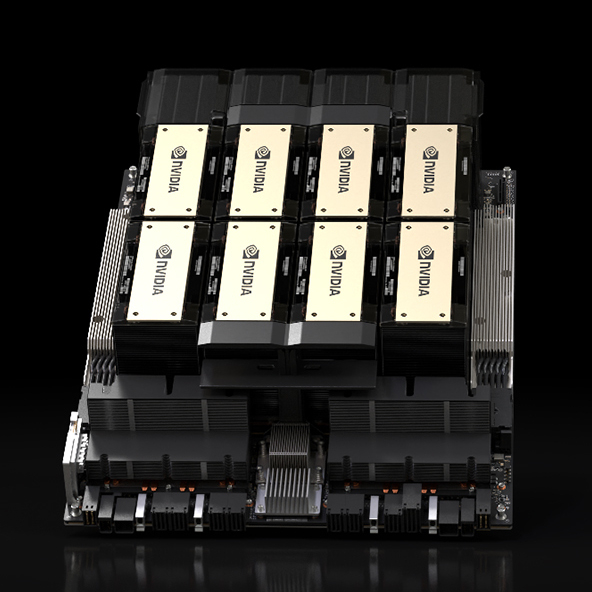

HGX H200 (Источник здесь и далее: NVIDIA) H200 получил 141 Гбайт памяти HBM3e с суммарной пропускной способностью 4,8 Тбайт/с. У H100 было 80 Гбайт HBM3, а ПСП составляла 3,35 Тбайт/с. Гибридные ускорители GH200, в состав которых входит H200, получат до 480 Гбайт LPDDR5x (512 Гбайт/с) и 144 Гбайт HBM3e (4,9 Тбайт/с). Впрочем, с GH200 есть некоторая неразбериха, поскольку в одном месте NVIDIA говорит о 141 Гбайт, а в другом — о 144 Гбайт HBM3e. Обновлённая версия GH200 станет массово доступна после выхода H200, а пока что NVIDIA будет поставлять оригинальный 96-Гбайт вариант с HBM3. Напомним, что грядущие конкурирующие AMD Instinct MI300X получат 192 Гбайт памяти HBM3 с ПСП 5,2 Тбайт/с. На момент написания материала NVIDIA не раскрыла полные характеристики H200, но судя по всему, вычислительная часть H200 осталась такой же или почти такой же, как у H100. NVIDIA приводит FP8-производительность HGX-платформы с восемью ускорителями (есть и вариант с четырьмя), которая составляет 32 Пфлопс. То есть на каждый H200 приходится 4 Пфлопс, ровно столько же выдавал и H100. Тем не менее, польза от более быстрой и ёмкой памяти есть — в задачах инференса можно получить прирост в 1,6–1,9 раза. При этом платы HGX H200 полностью совместимы с уже имеющимися на рынке платформами HGX H100 как механически, так и с точки зрения питания и теплоотвода. Это позволит очень быстро обновить предложения партнёрам компании: ASRock Rack, ASUS, Dell, Eviden, GIGABYTE, HPE, Lenovo, QCT, Supermicro, Wistron и Wiwynn. H200 также станут доступны в облаках. Первыми их получат AWS, Google Cloud Platform, Oracle Cloud, CoreWeave, Lambda и Vultr. Примечательно, что в списке нет Microsoft Azure, которая, похоже, уже страдает от недостатка H100. GH200 уже доступны избранным в облаках Lamba Labs и Vultr, а в начале 2024 года они появятся у CoreWeave. До конца этого года поставки серверов с GH200 начнут ASRock Rack, ASUS, GIGABYTE и Ingrasys. В скором времени эти чипы также появятся в сервисе NVIDIA Launchpad, а вот про доступность там H200 компания пока ничего не говорит. Одновременно NVIDIA представила и базовый «строительный блок» для суперкомпьютеров ближайшего будущего — плату Quad GH200 с четырьмя чипами GH200, где все ускорители связаны друг с другом посредством NVLink по схеме каждый-с-каждым. Суммарно плата несёт более 2 Тбайт памяти, 288 Arm-ядер и имеет FP8-производительность 16 Пфлопс. На базе Quad GH200 созданы узлы HPE Cray EX254n и Eviden Bull Sequana XH3000. До конца 2024 года суммарная ИИ-производительность систем с GH200, по оценкам NVIDIA, достигнет 200 Эфлопс. |

|