Материалы по тегу: контейнеризация

|

10.12.2025 [09:39], Владимир Мироненко

HPE позиционирует стек Morpheus в качестве альтернативы VMwareHPE обновила облачный портфель GreenLake и объединила сетевые решения Aruba и Juniper, чтобы предложить клиентам возможности AIOps для обеих платформ, а также высокоскоростное подключение для обработки ИИ-нагрузок. Президент и генеральный директор HPE Антонио Нери (Antonio Neri) заявил, что одной из самых серьёзных проблем является растущая стоимость виртуализации. Именно эту проблему решает платформа Morpheus, передаёт The Register. Технический директор и исполнительный вице-президент по гибридным облакам Фидельма Руссо (Fidelma Russo) сообщила, что ошибочно полагать, что предприятия стремятся просто заменить гипервизор. Она отметила, что компании ищут современную платформу, способную работать с традиционными виртуальными машинами (ВМ), контейнерами и рабочими нагрузками эпохи ИИ с тем же уровнем отказоустойчивости, безопасности и автоматизации, который они ожидают от облака. По словам Руссо, инструменты управления Morpheus и OpsRamp от HPE, а также ПО для аварийного восстановления Zerto представляют собой «полностью интегрированную альтернативную платформу корпоративного уровня, охватывающую ВМ, контейнеры и физическое оборудование». Фактически HPE предлагает альтернативу платформе VMware от Broadcom, хотя Руссо прямо её не назвала. Платформа Morpheus, приобретённая HPE в позапрошлом году, теперь поддерживает программно-определяемые сети (SDN) с нулевым доверием для виртуальных машин с гипервизором HVM (VM Essential) — на базе технологий Juniper Networks, приобретённой HPE в этом году. Также Morpheus предлагает полную поддержку Kubernetes и контейнерных рабочих нагрузок в рамках HVM для унифицированных операций с виртуальными машинами и контейнерами. Интегрированная с Morpheus система управления данными Apstra Data Center Director от Juniper обеспечивает автоматическую настройку коммутаторов при перемещении или миграции виртуальных машин, а OpsRamp интегрируется с Apstra Data Center Director и Compute Ops Management, объединяя управление и аналитику по всему стеку. «Благодаря этой интеграции… у нас теперь полностью автоматизированный стек, который устраняет проблемы, возникающие между виртуальными машинами и устойчивостью сети, что было ещё одним ключевым требованием, о чём мы говорили клиентам», — сообщила Руссо. Сообщается, что теперь поддерживаются распределённые кластеры с серверами в разных локациях, что позволяет поддерживать рабочие нагрузки даже при полном отключении одной из площадок. Синхронная репликация обеспечивается Alletra Peer Persistence. HPE также сообщила, что Morpheus VM Essentials будет работать с Veeam Data Platform v13 для резервного копирования на уровне гипервизора, что обеспечит быстрое восстановление виртуальных машин в частных облачных средах, включая HPE Private Cloud Business Edition.

31.10.2025 [01:02], Андрей Крупин

Positive Technologies выпустила Runtime Radar — Open Source-решение для защиты контейнеров

kubernetes

open source

positive technologies

software

информационная безопасность

контейнеризация

сделано в россии

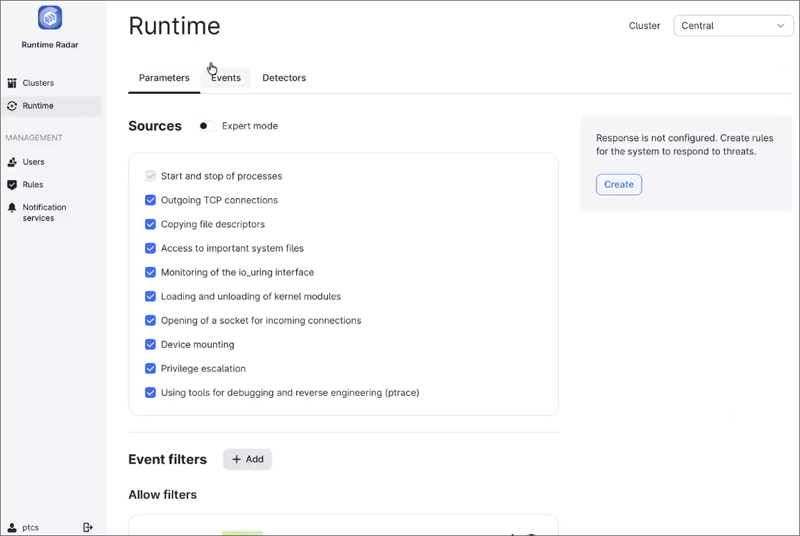

Компания Positive Technologies опубликовала на площадке GitHub открытое решение Runtime Radar, предназначенное для мониторинга безопасности и реагирования на инциденты в контейнерных средах. Продукт предназначен для работы с платформой Kubernetes в среде Linux. В основу Runtime Radar положены технологии eBPF и Tetragon для глубокого анализа событий, связанных с работой контейнеров, — процессов, сетевых соединений и изменений прав доступа, — что позволяет немедленно обнаруживать подозрительную активность. Инструмент предлагает централизованное управление всей инфраструктурой, включая работу с несколькими кластерами, и настраивается с помощью готовых политик безопасности. Для расследования инцидентов предусмотрен графический интерфейс, а для интеграции в существующие процессы мониторинга поддерживаются стандартные протоколы и механизмы, такие как syslog, SMTP и webhook.

Пользовательский интерфейс Runtime Radar (источник изображения: runtimeradar.com) По словам Positive Technologies, контейнерные технологии, в первую очередь платформа Kubernetes, стали отраслевым стандартом для развёртывания приложений и управления ими. Их повсеместное распространение сделало среду выполнения новой целью для атак злоумышленников. Существующие меры защиты часто сосредоточены на стадиях разработки и сборки, и запущенные контейнеры остаются уязвимыми для таких угроз, как несанкционированное использование ресурса, эскалация привилегий и утечка конфиденциальных данных. В результате многие компании сталкиваются с необходимостью мониторинга сложных инфраструктур в реальном времени, но не имеют для этого простых и доступных инструментов. Runtime Radar призван решить эту проблему. Подчёркивается, что запуск Runtime Radar — это ещё один вклад Positive Technologies в развитие отечественного Open Source-сообщества. Компания планирует и дальше активно развивать проект, дополняя его новыми функциями.

23.10.2025 [15:49], Андрей Крупин

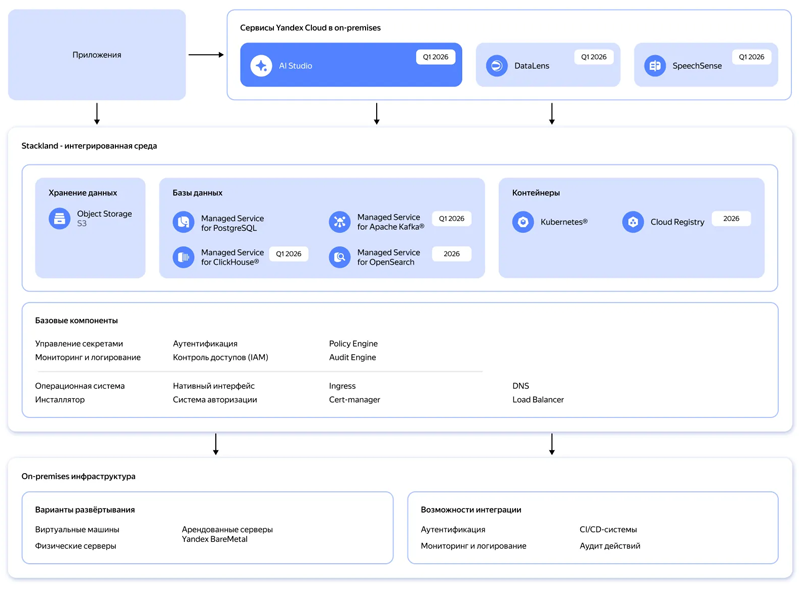

Yandex B2B Tech поможет компаниям быстро разворачивать инфраструктуру для ИИ-сервисов по модели On‑PremiseYandex B2B Tech (бизнес-группа «Яндекса», объединяющая технологии и инструменты компании для корпоративных пользователей, включая продукты Yandex Cloud и «Яндекс 360») сообщила о планах по запуску в первом квартале 2026 года нового инфраструктурного решения Yandex Cloud Stackland, с помощью которого организации смогут оперативно разворачивать инфраструктуру для управления ИИ‑нагрузками в закрытом контуре по модели on‑premise. Yandex Cloud Stackland предложит пользователям следующие компоненты для построения интегрированной ИИ-среды: платформу AI Studio для разработки ИИ-приложений и агентов, модуль речевой аналитики SpeechSense, BI-систему DataLens, контейнерный оркестратор, масштабируемое объектное S3-хранилище, управляемые СУБД PostgreSQL, ClickHouse, Kafka, а также векторные базы данных, которые распространены в RAG-решениях. В дополнение к этому будут представлены инструменты для обеспечения приложений доступом к графическим ускорителям и высокопроизводительным сетям, таким как InfiniBand, для задач распределённого инференса. Отдельное внимание будет уделено безопасности и защите обрабатываемых данных: Stackland получит встроенные средства IAM для гибкого разграничения доступов и инструменты для защищённого хранения паролей, токенов и сертификатов.

Архитектура Yandex Cloud Stackland (источник изображения: yandex.cloud/services/stackland) Stackland базируется на Kubernetes, что позволит компаниям применять привычные подходы и инструменты для управления микросервисными приложениями, а также управлять PaaS-сервисами Yandex Cloud через Kubernetes API. Ожидается, что интерес к Stackland проявят организации из сфер электронной коммерции, финтеха, ритейла и промышленного сектора, которые хотят использовать ИИ-решения на базе облачных технологий, но не могут сделать это из-за внутренних или регуляторных требований. Как передают «Ведомости», по оценке «Яндекса», в 2025 г. объём рынка контейнеризации составит 4–6 млрд руб., а к 2030 г. вырастет до 9–14 млрд руб. С новым решением компания планирует занять полоивину рынка инфраструктурного ПО для ИИ. Лицензирование Yandex Cloud Stackland будет производиться по количеству ядер CPU. Все инфраструктурные компоненты, в частности управляемые базы данных, будут включены в лицензию. Для отдельных сервисов, таких как AI Studio, DataLens и SpeechSense, нужно будет приобретать отдельные лицензии.

29.08.2025 [09:20], Владимир Мироненко

Broadcom расширила инструментарий VCF 9.0, преобразовав её в «унифицированную платформу»Broadcom позиционирует VMware Cloud Foundation (VCF) 9.0 как единую унифицированную платформу, которую можно использовать как для ИИ, так и для других рабочих нагрузок, и с этой целью анонсировала ряд обновлений. Для дальнейшей поддержки ИИ и других ресурсоёмких нагрузок Broadcom объявила о доступности VMware Tanzu Data Intelligence — платформы-хранилища, которая обеспечит унифицированный доступ к разнообразным данным. VMware vSAN получила встроенную поддержку S3-интерфейсов объектного хранилища, что позволит создавать унифицированные политики хранения для блочного, файлового и объектного хранения и снизить сложность инфраструктуры хранения. Компания также интегрировала VCF 9.0 с GitOps, Argo CD и Istio для обеспечения безопасности доставки приложений, используя Git в качестве источника данных для Kubernetes. Теперь разработчики смогут хранить свою инфраструктуру и приложения в виде кода в Git и использовать Argo CD для автоматизации согласованных развёртываний. Кроме того, Istio Service Mesh обеспечивает сетевое взаимодействие с нулевым доверием, управление трафиком и возможность наблюдения для контейнеров. Наряду с VMware Private AI Services платформа VCF 9.0 получила совершенно новый Cyber Compliance Advanced Service — сервис, разработанный для строго регулируемых сред, который обеспечивает улучшенное соответствие кибертребованиям, отказоустойчивость и безопасность платформы для сред VCF. VMware vDefend Security получил новые автоматизированные элементы управления для ускорения внедрения защиты с нулевым доверием, а также расширенные инструменты обнаружения угроз на уровне сети (Network Detection and Response). Также была добавлена функция защиты от бесфайловых атак, использующих PowerShell, VBScript и Jscript. По словам Broadcom, она позволяет проверять и перехватывать вредоносные скрипты до их выполнения, закрывая важнейшую «слепую зону» в кибербезопасности. Avi Load Balancer получил новый инструмент оценки WAF и защиту трафика MCP для агентских рабочих нагрузок. По словам Пола Тернера (Paul Turner), вице-президента по продуктам VMware Cloud Foundation, новые инструменты предоставляют компаниям унифицированный подход к защите инфраструктуры, предотвращению угроз, обеспечению соответствия требованиям и восстановлению после кибератак. Прашант Шеной (Prashanth Shenoy), вице-президент по маркетингу продуктов подразделения VCF, заявил, что ориентация Broadcom на частное облако получила поддержку среди клиентов, особенно среди крупных предприятий и стратегических корпораций. По данным Broadcom, девять из десяти крупнейших компаний из списка Fortune 500 в настоящее время используют VCF. Продажа по всему миру более 100 млн лицензий VCF говорит о значительном доверии к платформе крупных организаций.

29.05.2025 [18:35], Андрей Крупин

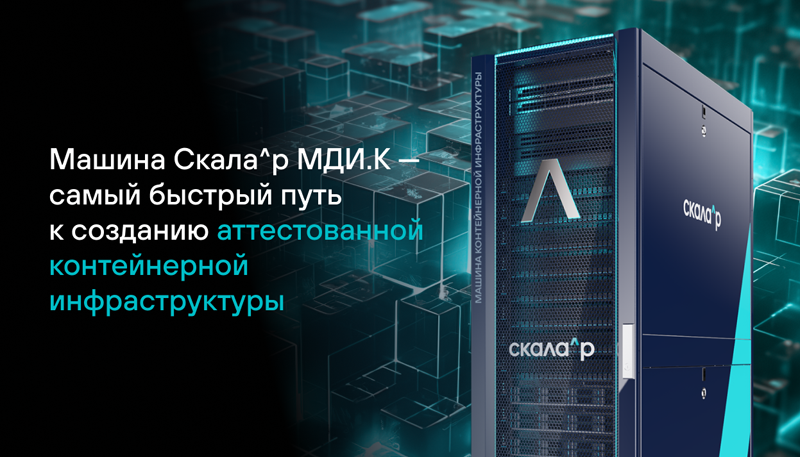

Представлен российский ПАК «Скала^р МДИ.К» для управления контейнерной инфраструктуройКомпания Rubytech сообщила о расширении продуктовой линейки «Скала^p» и выпуске программно-аппаратного комплекса (ПАК) «Скала^р МДИ.К», предназначенного для построения аттестованной контейнерной инфраструктуры с использованием отечественных аппаратных и программных решений. ПАК «Скала^р МДИ.К» построен с использованием компонентов из реестров Минпромторга и Минцифры и представляет готовое решение для развёртывания, запуска и сопровождения жизненного цикла контейнерных нагрузок в соответствии с требованиями регуляторов к значимым объектам критической информационной инфраструктуры. В основе технологического стека продукта — серверное и сетевое оборудование отечественных производителей, российская система хранения данных. В качестве операционной системы задействована «Ред ОС» 7.3 в сертифицированной ФСТЭК редакции, для работы с контейнерами выбрана платформа Deckhouse Kubernetes Platform Certified Security Edition Pro, также имеющая сертификат Федеральной службы по техническому и экспортному контролю.

Источник изображения: skala-r.ru Комплекс предоставляет расширенные возможности по обеспечению отказоустойчивости и высокой доступности инфраструктуры, инструменты для мониторинга, встроенные механизмы для балансировки нагрузки. «Скала^р МДИ.К» допускает запуск как stateless (без сохранения состояния), так и stateful (с сохранением состояния) контейнеров. Для этого в системе могут быть использованы несколько вариантов по организации постоянного хранения, включая внешнюю блочную СХД, подключаемую посредством CSI-драйвера. «Идея ПАК «Скала^р МДИ.К» заключается в том, чтобы качественно и в максимально короткие сроки решить инфраструктурные задачи при переходе от тяжёлых монолитных систем к современной микросервисной архитектуре с использованием контейнерных технологий на базе отечественных продуктов. При самостоятельном покомпонентном построении такой инфраструктуры организации тратят большое количество времени и ресурсов на выбор аппаратных и программных средств, проверку их совместимости, поиск лучших практик по конфигурации, интеграцию, тестирование, подбор подходящих поставщиков и оптимальных цен, проведение закупочных процедур. Мы предлагаем готовое решение, которое может быть поставлено и развёрнуто за два–три месяца», — говорится в сообщении разработчиков комплекса.

12.05.2025 [16:24], Татьяна Золотова

В 2025 году объем рынка коммерческих платформ контейнеризации вырастет на 30 %

kubernetes

open source

software

tadviser

анализ рынка

импортозамещение

контейнеризация

россия

финансы

В 2024 году доступный для монетизации объем рынка (Serviceable Addressable Market, SAM) коммерческих платформ контейнеризации, включающий on-premise решения и облачные сервисы, составил 1,5 млрд руб. (рост на 28 % по сравнению с годом ранее). В 2025 году этот показатель будет равен 2 млрд руб. (рост на 30 %). Об этом говорится в исследовании TAdviser «Объем российского рынка платформ контейнеризации и его лидеры». Общий объем рынка коммерческих платформ контейнеризации, включающий выручку от продаж лицензий и услуг поддержки on-premise-платформ, по итогам 2023 года составил 975 млн руб. С учетом выручки вендоров общий объем рынка оценивается в 3,9–5,7 млрд руб. Среди лидеров аналитики TAdviser называют решения Deckhouse Kubernеtes Platform от компании «Флант» (30 % рынка), Basis Digital Energy от «Базиса» (22 %), «Штурвал» от «Лаборатории числитель» (10 %), «Боцман» от «Платформы Боцман» (10 %) и Nova Container Platform от Orion soft (8 %). Так, в 2024 году Deckhouse Kubernetes Platform показала рост выручки в 170 %. Также на рынке присутствуют около 20 вендоров различного масштаба с малыми долями, которые в будущем могут быть поглощены более крупными игроками. По словам исполнительного директора «Лаборатории числитель», рынок коммерческих платформ контейнеризации только формируется, в ближайшие пару лет ожидаются слияния и поглощения нишевых решений. В структуре потребления лидируют самописные платформы на базе «ванильных» Kubernetes и коммерческие on-premise платформы, им незначительно уступают open-source платформы. На рост рынка контейнеризации закономерно повлияли уход зарубежных вендоров и политика импортозамещения, рост интереса к микросервисным архитектурам и Kubernetes, а также развитие облачных технологий и ML/AI-решений. Исследование проводилось с октября 2024 года по февраль 2025 года. В нем участвовали около 300 представителей заказчиков и более 30 вендоров платформ контейнеризации. Рынок платформ контейнеризации формируется из таких основных частей как компании, использующие коммерческие платформы (on-premise), коммерческие облачные сервисы (CaaS/KaaS), open-source платформы (например, OKD), самостоятельно разрабатывающие платформы контейнеризации на базе «ванильного» Kubernetes, и компании, не использующие платформы контейнеризации (потенциальный объем проектов).

05.05.2025 [10:37], Татьяна Золотова

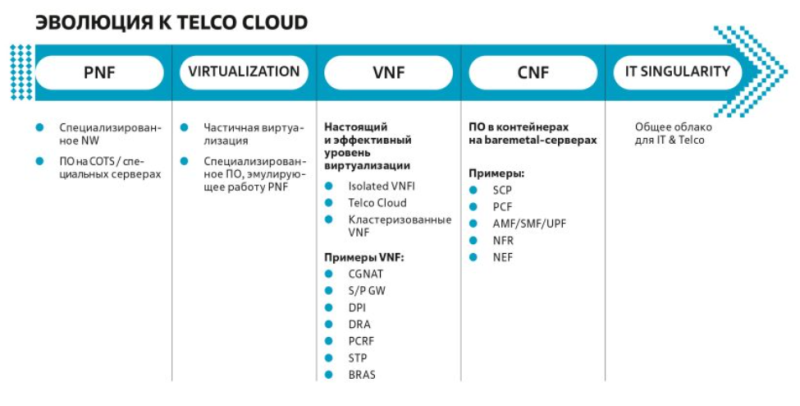

«Билайн» внедрил облачную платформу для виртуализации сетевых функцийСотовый оператор «Вымпелком» (бренд «Билайн») и разработчик ИТ-решений «Инфосистемы джет» разработали единую географически распределенную платформу виртуализации и контейнеризации сетевых функций Telco Cloud. Она представляет собой облачную инфраструктуру для запуска сетевых функций как в виртуализированном (VNF), так и в контейнеризированном исполнении (CNF). ПАК Telco Cloud, разработанный «Инфосистемами джет», — это большое комплексное решение, собранное из отдельных компонентов, в число которых входят: серверное оборудование с унифицированными вариантами конфигурации серверов; аппаратные СХД, аналогичные Huawei Dorado; сетевая фабрика, которая является трехуровневой моделью L2/LЗ-фабрики с поддержкой EVPN-VXLAN, ЕСМР, Multihoming и автоматизированным управлением. Технически это White Вох с открытой NOS на базе SONiC. Решение внедрено на сети «Билайна», в основных дата-центрах, включая ярославский и московский ЦОД, площадки во Владивостоке и Новосибирске. Для части этих ЦОД Telco Cloud внедрен в георезервированном виде для обеспечения надежности и отказоустойчивости. В планах до конца года внедрить георезерирование для всех дата-центров, где уже развернута облачная инфраструктура. Как отмечают в пресс-службе сотового оператора, платформа снижает затраты на инфраструктуру, повышает эффективность и скорость выхода новых продуктов на рынок. В «Билайне» надеются, что облачная инфраструктура Telco Cloud снизит зависимость от конкретных поставщиков, а также позволит в сжатые сроки внедрять альтернативные сетевые функции.

06.12.2024 [14:24], Андрей Крупин

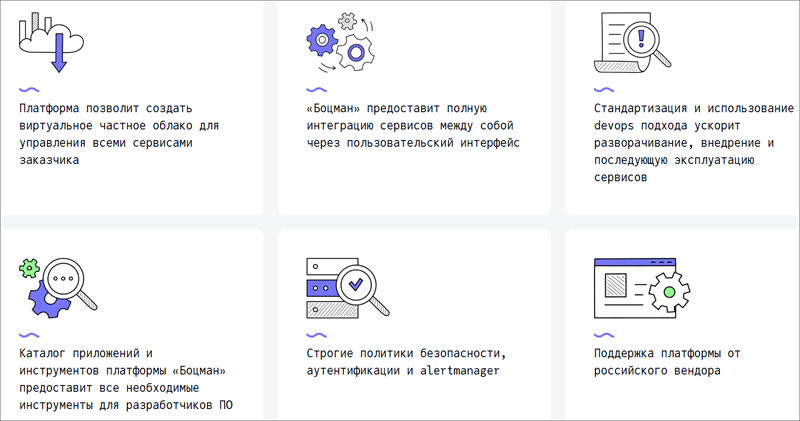

«Группа Астра» купила «Платформу Боцман» — отечественного разработчика ПО для контейнеризации«Группа Астра» объявила о включении в свой контур и приобретении 100 % долей компании «Платформа Боцман», занимающейся разработкой одноимённого решения для управления мультикластерами на базе Kubernetes. Платформа контейнеризации «Боцман» включена в реестр Минцифры России и ориентирована на крупных корпоративных заказчиков. Решение может быть использовано для развёртывания мультитенантных кластеров, обеспечения поддержки оборудования, работы с прикладными сервисами, создания ИБ-решений для Enterprise-сегмента, соответствующих регуляторным требованиям по защите информации. В составе системы представлены инструменты для мониторинга, балансировки и автомасштабирования контейнерных нагрузок, настройки политик безопасности и резервного копирования. Сообщается, что одной из задач «Платформы Боцман» станет интеграция программного комплекса «Боцман» с Nodus — собственной разработкой «Группы Астра» для управления контейнеризацией. Объединённый продукт должен стать комплексным решением для контейнеризации, сочетающим возможности «Боцмана» с глубокой интеграцией с Nodus и встроенными в операционную систему Astra Linux средствами защиты информации. Nodus станет ядром новой платформы, а «Боцман» обеспечит управление, оркестрацию и поддержку прикладных сервисов.

Функциональные возможности платформы «Боцман» (источник изображения: bootsman.pro) Кроме того, «Группа Астра» планирует интегрировать систему «Боцман» с облачными решениями Astra Cloud и Astra Infrastructure Cloud, а также усилить направление разработки ПО. Ожидается, что в результате заказчики и разработчики получат многофункциональный инструментарий для создания софта на базе контейнеров и микросервисов. Также в планах «Группы Астра» и команды компании «Боцман» — разработка программно-аппаратных комплексов под различные задачи и комплексные сценарии, начиная от управления данными и заканчивая приложениями, в основе которых — гибкая, масштабируемая и безопасная контейнеризация.

29.10.2024 [14:42], Владимир Мироненко

ГК «Солар» приобрела 10 % долю в Luntry, специализирующейся на контейнерной безопасности

kubernetes

software

инвестиции

информационная безопасность

контейнеризация

россия

ртк-солар

сделано в россии

сделка

финансы

Группа компаний «Солар» сообщила о завершении сделки по покупке 10 % доли разработчика решений контейнерной безопасности Luntry (ООО «Клаудран»). Сумма сделки не раскрывается. Как предположил один из опрошенных «Ведомостями» экспертов, стоимость Luntry исходя из публичной отчётности может составлять до 500 млн руб., а сумма сделки — порядка 50 млн руб. В ГК «Солар» отметили, что это была первая сделка в рамках недавно созданного фонда Solar Ventures, который нацелен на стимулирование роста отрасли ИБ. Согласно пресс-релизу, сделка позволит «Солару» «усилить компетенции по защите микросервисных архитектур и контейнеризации и сформировать дополнительный пакет сервисов и услуг для защиты таких инфраструктур». Luntry предлагает решение для комплексной защиты на всём жизненном цикле контейнерных приложений и средств оркестрации на базе Kubernetes. В числе клиентов компании, работающей на российском рынке с 2021 года, крупнейшие банки, страховые и ИТ-компании, ретейлеры федерального значения. Luntry обладает командой квалифицированных специалистов с более чем десятилетним опытом и широкой партнёрская сетью. Решение Luntry cлужит источником данных для SOC о Kubernetes и работающих контейнерах, помогает в расследовании инцидентов, обнаружении первопричин инцидентов и сбоев, обеспечивает высокий уровень защищённости в рамках быстрого цикла разработки, эффективное взаимодействие между командами для принятия решений и осведомленность о всех запретах и ограничениях ИБ. В Luntry отметили, что сделка с ГК «Солар» не изменит общей стратегии развития, но при этом позволит совместными усилиями обеспечивать защиту критичных государственных информационных систем, использующих контейнеризацию. В свою очередь, в ГК «Солар» сообщили, что данная сделка выполнена в рамках реализации инвестиционной стратегии, рассчитанной на период до конца 2025 года. Ранее ГК «Солар» приобрела доли в компаниях Digital Security, «Secure-T», «Элвис-Плюс» и «НТБ» и создала СП Солар-ТЗИ. По оценке ГК «Солар», российский рынок безопасности контейнеров составил в 2023 году 1,1 млрд руб., в том числе за счёт функциональности, реализованной на платформах управления контейнерами. К 2027 году его объём может достичь 2,0–2,5 млрд руб. и Luntry может занять до 20 % рынка.

11.09.2024 [09:09], Владимир Мироненко

DevOps в России мигрирует на отечественные ОС, платформы и инструменты

devops

kubernetes

software

импортозамещение

исследование

контейнеризация

миграция

разработка

россия

сделано в россии

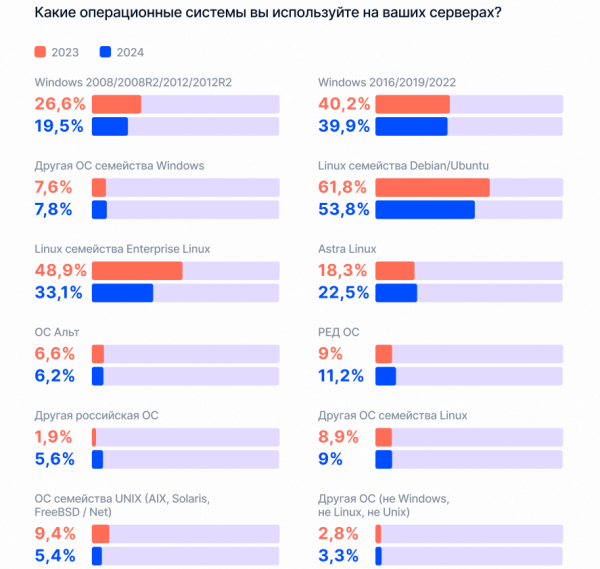

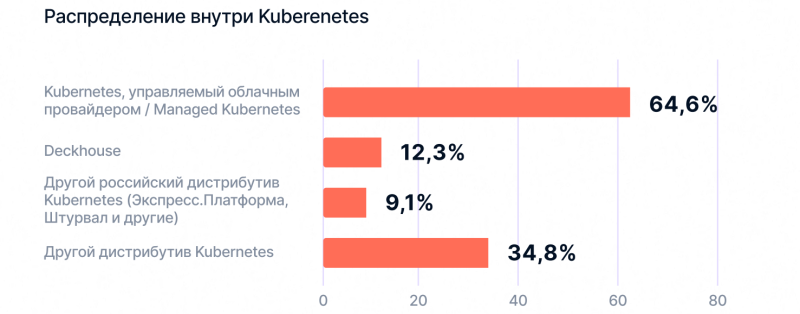

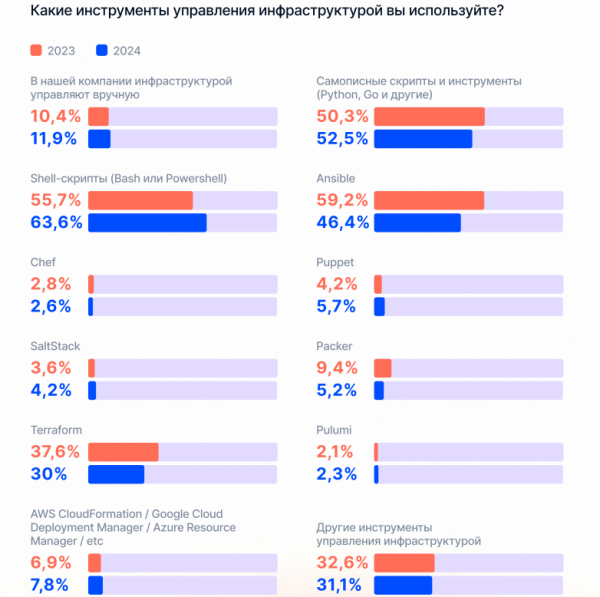

Компания «Экспресс 42» опубликовала результаты ежегодного исследования «Состояние DevOps в России», вышедшего при поддержке Deckhouse, Yandex Cloud, HeadHunter, «OTUS онлайн образование», JUG Ru Group, Avito Tech, «Т-Банк». Благодаря рекордному числу участников — более 4 тыс. человек — в исследовании удалось выявить ключевые закономерности и самые актуальные тренды развития DevOps в России. Исследование подтвердило рост интереса к DevOps, в том числе в новых отраслях. Хотя тройка лидеров сохраняется с 2020 года, доля ИТ уменьшилась с 45,5 до 36,2 %, доля финансового сектора упала на 2,4 % до 12,4 %, у ретейла равна 7,3 %. Суммарная доля отраслей за пределами ИТ-сферы и финтеха выросла с 39,7 % до 51,4 %. По сравнению с прошлым годом среди респондентов выросла доля работающих на российские компании — с 85,8 % до 89,4 %. Также увеличилось количество независимых специалистов — с 2,5 % до 3,8 %. Растущий интерес к DevOps отражает и рынок труда. По востребованности DevOps-специалисты уступают только разработчикам – 27,6 % против 40,6 % соответственно. Далее в рейтинге следуют системные аналитики (13,5 %). Вместе с тем бюджет на наём растёт, как и разрыв между количеством вакансий и резюме. То есть кадровый голод не утолён, но ключевые позиции, похоже, были закрыты, сделали вывод в «Экспресс 42». В числе самых востребованных навыков специалистов в этой сфере работодатели указывают работу с Linux (в 4 5% вакансий), Docker (37 %) и Kubernetes (35 %). Важны также компетенции DevOps (23 %), владение Ansible и Phyton (по 22 %), CI/СD и Bash (по 20 %), PostgreSQL (19 %), Git (17 %). Вместе с тем снизилась доля пользователей Debian/Ubuntu с 61,8 до 53,8 % и RHEL — с 49 до 33,1 %. Попутно растёт доля пользователей российских ОС Astra Linux — с 18,3 до 22,5 %; Ред ОС — с 9,1 до 11,2 %; других российских ОС — с 1,9 до 5,6%. Исключение составила ОС «Альт», доля которой упала с 6,6 до 6,2 %. Исследователи отметили, что большинство российских компаний адаптировалось к изменившимся за последние два года условиям работы. И их фокус смещается с нормализации состояния на развитие. Доля респондентов, выбравших вариант «Сохранить финансовую и операционную стабильность», сократилась с 23 до 19,4 %, в то время как доля выбравших варианты «Продолжить планомерное развитие» и «Воспользоваться появившимися новыми возможностями» увеличилась с 44 до 45,7 % и с 32 до 34,9 % соответственно. В числе первоочередных задач, которые компании ставят перед своими ИТ-департаментами — улучшение качества разрабатываемых продуктов (59,7 % респондентов), повышение скорости реагирования на запросы от бизнеса (43,6 %), создание новых технологий, которые обеспечивают конкурентное преимущество на рынке (42,1 %). Также отмечено увеличение средств, выделяемых на ИТ. 57,2 % опрошенных, которые ознакомлены с распределением, сообщили об увеличении бюджета на ИТ, а у 26,2 % он остался прежним. Исследователи отметили рост количества пользователей managed-решений и российских дистрибутивов Kubernetes. Аналитики расценивают это как начало тренда на переход на управляемые решения и российские дистрибутивы. Также отмечено, что классическими оркестраторами стали пользоваться меньше: доля Kubernetes снизилась с 58,3 до 54,4 %, OpenShift — с 15,1 % до 14,1 %, Rancher — с 9 % до 5,7 %. При этом доля отдельных оркестраторов выросла, больше всего у Docker Swarm — с 14,7 % до 18,6 %. Доля респондентов, которые не используют оркестраторы, увеличилась с 18,7 до 24 %, что объясняется распространением DevOps на новые отрасли, где работают с обычными виртуальными машинами без надобности в решениях уровня Kubernetes, поскольку достаточно Docker Swarm. В числе ключевых функций/компонентов платформ контейнеризации респонденты назвали возможность установки в закрытый контур (49,1 %), централизованное управление множеством кластеров (44,3 %), возможность беспростойных обновлений (41 %), графический интерфейс и удобство и максимальную автоматизацию всех процессов (38,3 %). Наиболее важными аспектами они назвали наличие экосистемы сопутствующего ПО, наличие совместимости с другим ПО и возможность влияния на план развития платформы. При выборе той или иной платформы контейнеризации респонденты руководствуются стоимостью (51,5 %), затратами на обслуживание и эксплуатацию (48,9 %), сложностью внедрения (45, 9%). Основной ценностью использования платформ респонденты считают сокращение вывода решения на рынок (52,4 %), сокращение затрат на поддержку технологических решений (49 %) и на владение инфраструктурой (44,2 %). В исследовании также была зафиксирована тенденция ухудшения ключевых метрик по всем профилям эффективности DevOps: частота релизов ПО, срок поставки, меньшее время восстановления после инцидентов и т.д. Самым популярным инструментом DevOps являются облачные решения. В числе ключевых преимуществ PaaS большинство респондентов назвали ускорение создания и масштабирование приложений (40 %), возможность использование всех сервисов у одного провайдера (37 %), гарантию соблюдения SLA (27 %). Вместе с тем треть респондентов предпочитает размещать данные на собственной инфраструктуре (33 %), чуть меньше трети пользуется гибридной средой (30 %). В основном компании используют управляемые сервисы для администрирования виртуальных машин и систем резервного копирования (4 %), развёртывания серверов (37 %), реже сервисы применяются для помощи с процессом миграции (14 %). В рейтинге популярности PaaS и управляемых сервисы лидируют управляемые SQL (45 %) и оркестраторы (38 %). По-прежнему наименьшее распространение имеют облачные ML-сервисы (8 %) и инструменты для синтеза и распознавания речи (7 %). Ключевые навыки для DevOps-специалиста в облаке включают знание специфики работы в контуре облачного провайдера: управления доступами и безопасностью (57 %), работы с API (62 %), работы с CLI (61 %). Также растёт использование ИИ — 44 % респондентов используют ML/AI-инструменты для решения DevOps-задач и 47 % отмечают их важность в повышении эффективности. |

|