Материалы по тегу: software

|

16.01.2026 [14:24], Сергей Карасёв

Gartner: глобальные расходы на ИИ в 2026 году достигнут $2,5 трлнПо оценкам Gartner, в 2025 году затраты, связанные с ИИ, достигли в мировом масштабе $1,76 трлн. Отрасль стремительно развивается: в 2026-м её объём, как ожидается, увеличится на 44 % в годовом исчислении, достигнув $2,53 трлн. А в 2027 году затраты могут вырасти до $3,34 трлн. Аналитики подсчитали, что в 2025-м наибольшая часть затрат пришлась на ИИ-инфраструктуру — $964,96 млрд. Связано это с активным развитием дата-центров, ориентированных на ресурсоёмкие задачи обучения больших языковых моделей (LLM) и инференса. Ожидается, что в 2026 году расходы в области ИИ-инфраструктуры составят $1,37 трлн, а в 2027-м — $1,75 трлн. Всевозможные ИИ-сервисы в 2025 году принесли $439,44 млрд, софт в области ИИ — $283,14 млрд, средства ИИ-кибербезопасности — $25,92 млрд. В 2026 году эти расходы, по мнению аналитиков Gartner, поднимутся соответственно до $588,65 млрд, $452,46 млрд и $51,35 млрд. В 2027-м ожидается увеличение затрат до $761,04 млрд, $636,15 млрд и $86,0 млрд. Среди других ключевых статей расходов названы ИИ-модели, ИИ-платформы для наук о данных и машинного обучения, платформы разработки ИИ-приложений и данные для ИИ. В 2025 году затраты по указанным направлениям оцениваются в $14,42 млрд, $21,87 млрд, $6,59 млрд и $827 млн соответственно. В 2026 году прогнозируется рост до $26,38 млрд, $31,12 млрд, $8,42 млрд и $3,12 млрд, а в 2027-м — до $43,45 млрд, $44,48 млрд, $10,92 и $6,44 млрд. Аналитики Gartner также говорят о продолжающемся увеличении поставок ИИ-серверов. Их продажи в денежном выражении в 2026 году, как прогнозируется, подскочат на 49 % по сравнению с предыдущим годом. На такие серверы придётся приблизительно 17 % от общих расходов на глобальном рынке ИИ.

15.01.2026 [15:20], Руслан Авдеев

Microsoft прекратила расширенную поддержку Windows Server 2008 — даже за деньгиMicrosoft без лишнего шума закончила поддержку операционной системы, выпущенной 18 лет назад — Windows Server 2008 на платформе Windows Vista теперь официально заброшена, сообщает The Register. 14 января 2020 года прекратилась расширенная поддержка для всех пользователей (Extended Support) системы под кодовым названием Longhorn Server. С 2020 по 2023 гг. действовала программа Extended Security Updates (ESU) — платные обновления безопасности для всех желающих. При переносе сервера в облако Azure бесплатные обновления предоставлялись ещё год, до 9 января 2024 года. Наконец, 13 января 2026 года полностью прекратилась поддержка даже для тех клиентов, кто оплатил действующий контракт Premium Assurance (PA). Стоит отметить, что Extended Security Updates (ESU) предлагалась для того, чтобы заменить Premium Assurance (PA), если та была куплена до 2018 года и была платным дополнением плана Software Assurance со сроком действия шесть лет. В своё время Microsoft пообещала выполнять обязательства, связанные с предоставление обновлений покупателям PA.

Источник изображения: Annie Spratt/unsplash.com Теперь продукты на платформе Windows Vista, анонсированной в 2006 году и ставшей общедоступной в 2007-м, более не поддерживается. Сама Windows Server 2008 увидела свет в 2008 году. Отдельно отмечается общая длительность сопровождения — фактически поддержка для платформы Vista осуществлялась дольше, чем для XP.

15.01.2026 [14:42], Руслан Авдеев

Бирмингем снова отложил перезапуск печально известной ERP-системы Oracle FusionГородской совет Бирмингема отложил повторный запуск печально известной ERP-системы Oracle Fusion, ставшей причиной многомиллионных расходов. В совете заявили, что сотрудникам нужно больше времени, чтобы адаптироваться к стандартным процессам вендора, сообщает The Register. Очередные манипуляции с ПО в крупнейшем муниципалитете Евросоюза последовали за крайне неудачной попыткой внедрить в 2022 году в Бирмингеме Oracle Fusion для управления миллионными поступлениями налогоплательщиков и многомиллионными же расходами, фактически превратившей местные власти в банкротов. Общая стоимость перехода с SAP на Oracle увеличилась с заложенных изначально £19 млн до около £131 млн, а позже до £170 млн. С учётом потерь в результате неудачного внедрения речь идёт уже о £216,5 млн, хотя эксперты в самом начале предрекали крупные проблемы, ведущие к задержке платежей и накоплению долгов В 2020 году муниципалитет запланировал заменить устаревшую систему SAP на стандартный вариант ПО Oracle. Тем не менее, проект подвергся усиленной кастомизации, включая внедрение системы сверки банковских счетов (Bank Reconciliation System), работу которой должным образом так и не смогли наладить. Когда изменения ПО практически парализовали работу системы, власти Бирмингема попытались заново внедрить решение Oracle «из коробки», а для банковских процедур было решено использовать стороннее ПО Income Management.

Источник изображения: Francisco Gomes/unsplash.com Замена должна была состояться в апреле, но недавно двое представителей муниципалитета заявили о переносе процедуры как минимум до лета. По результатам тестирования и оценки готовности ПО совет учёл мнение сотрудников и решил перенести дату ввода системы в эксплуатацию для снижения рисков и для того, чтобы гарантировать точность выплаты зарплат. Подчёркивается, что речь идёт лишь о переносе сроков, а не очередном «перезапуске». Хотя в мае 2024 года обслуживание школ исключили из обновлённого проекта, его стоимость продолжала расти. По данным муниципальных властей, управленческие решения должны быть приняты позже в январе, а независимая экспертиза должна установить, готова ли программа к запуску. Местные политики уже предрекают, что муниципалитет придёт к местным выборам в мае без функционирующей финансовой системы. Сами представители совета утверждают, что необходимо убедиться в успешности повторного внедрения ПО, не стремясь обеспечить его к заданным датам в ущерб стабильности. Влияния на работу действующей системы новая не окажет, а сервисы продолжат функционировать так, как функционируют сейчас. Бюджет на повторное внедрение системы включал резервные средства на случай изменений, поэтому роста расходов не ожидается. Внедрение будет проходить поэтапно, с независимой проверкой на согласованных заранее контрольных точках.

15.01.2026 [14:35], Владимир Мироненко

Акции «Базиса» включили в сектор рынка инноваций и инвестиций, что предоставит льготы при их покупкеС сегодняшнего дня акции «Базиса», российского разработчика ПО управления, включены в сектор рынка инноваций и инвестиций (РИИ) Московской биржи, сообщается на сайте торговой площадки. В настоящее время перечень сектора РИИ Московской биржи насчитывает акции 27 компаний. Сектор РИИ призван содействовать привлечению инвестиций в компании инновационного сегмента российской экономики. Включение в сектор РИИ означает, что обыкновенные акции «Базиса» будут добавлены в перечень ценных бумаг высокотехнологичного сектора экономики. Это представит право физическим лицам, владеющим такими акциями не менее одного года, на освобождение от уплаты налога на доходы от их продажи. Льготы по налогообложению распространяются на доходы в размере до 50 млн руб.

Источник изображения: «Базис» После проведения IPO акции «Базис» были включены во второй уровень котировального списка Московской Биржи. Торги ими начались 10 декабря под тикером BAZA (ISIN RU000A10CTQ0). Также акции компании были включены в индекс IPO Московской Биржи (MIPO), который служит инструментом для отслеживания динамики компаний, недавно вышедших на рынок капитала. Он включает акции эмитентов, которые провели первичное размещение или листинг на бирже не ранее чем за два года до даты формирования базы расчета. В результате IPO компания привлекла 3 млрд руб. при оценке рыночной капитализации в размере 18 млрд руб. «Базис» осуществляет продажи через более 230 дистрибьюторов и партнёров, включая 5 дистрибьюторов, более 200 системных интеграторов и более 30 технологических партнёров. Все её решения включены в Единый реестр российского ПО. Кроме того, ряд продуктов имеет сертификаты ФСТЭК IV уровня доверия.

15.01.2026 [13:06], Владимир Мироненко

Большая часть российских компаний не спешит с переходом на отечественный корпоративный софтБолее 70 % российских компаний продолжают использовать иностранный корпоративный софт, несмотря на объявленный правительством курс на импортозамещение, сообщили «Ведомости» со ссылкой на исследование компании Naumen, проведённое в конце 2025 года на основе опроса более 80 менеджеров из финансового сектора, промышленности, ритейла, IT, телекома, госуправления, энергетики, транспорта и логистики. В Naumen уточнили, что корпоративный софт включает CRM-системы, системы управления проектами, управления IT-службой, документооборот, голосовых и текстовых роботов для автоматизации клиентских обращений, ПО для внутренних коммуникаций, HRTech и т. д. При этом в исследовании не учитывались операционные системы. Согласно опросу, около трети (32 %) респондентов используют зарубежные IT-решения, поскольку нет подходящего решения на российском рынке, а ещё 16 % — из-за того, что отечественные аналоги чересчур дорогие. Ещё 12 % респондентов не начали импортозамещение, столько же ждут возвращения иностранных вендоров. Более четверти (27 %) опрошенных использует не менее пяти иностранных продуктов в разных категориях ПО. В исследовании приняли участие компаниях, на которых не распространяются регуляторные ограничения и требования по обязательному импортозамещению. Они продолжают использовать зарубежный софт и надеются, что он вскоре вновь будет доступен. Что касается регулируемого сегмента, что согласно данным Ассоциации разработчиков программных продуктов (АРПП), к концу 2025 года на отечественное ПО перешли лишь 40–45 % субъектов КИИ. Эксперты подтверждают тот факт, что удельный вес компаний, продолжающих использовать зарубежный софт, достигает 70 %, несмотря на связанные с этим риски, включая зависимость от внешней поддержки, угрозу отключений и технических проблем. К тому же переход на отечественное ПО тормозится его сложностью, поскольку это не только замена одного решения на другое, но ещё и обучение сотрудников или даже перестройка бизнес-процессов. Сказывается и привычка к устоявшимся подходам, приёмам, стандартам и форматам зарубежных вендоров, говорят эксперты. Вместе с тем в некоторых сегментах ситуация совсем другая. Например, в сфере информационной безопасности прошло практически полное импортозамещение, говорят эксперты. По их мнению, импортозамещение осуществляется там, где оно становится неизбежным. Если же использование иностранного ПО будет по-прежнему допустимым, многие компании не будут спешить с переходом на отечественный софт.

14.01.2026 [17:14], Руслан Авдеев

Евросоюз делает ставку open source, чтобы избавиться от зависимости от IT-гигантов из США

open source

software

евросоюз

импортозамещение

информационная безопасность

конфиденциальность

разработка

сша

Еврокомиссия начала новый раунд консультаций, связанный с открытым ПО, которое, как предполагается, это поможет местным разработчикам снизить зависимость от платформ американских IT-гигантов и перейти к созданию собственных open source альтернатив, сообщает The Register. В документе Call for Evidence Брюссель заявляет, что привычка ЕС полагаться на «неевропейских» (фактически американских) техногигантов стала «стратегической обузой», ограничивающей выбор, ослабляющей возможность конкурировать и создающей риски в цепочках поставок во всех сферах, от облачных сервисов до критической инфраструктуры. Консультации, которые продлятся до 3 февраля — первые шаги в рамках разработки официальной стратегии формирования «европейских открытых цифровых экосистем» (European Open Digital Ecosystems), благодаря которым open source будет рассматриваться как ключевой элемент инфраструктуры, а не просто дополнение, которое «неплохо было бы иметь». По данным Еврокомиссии, зависимость от зарубежных вендоров усложняет для Евросоюза контроль собственного цифрового стека, потенциально угрожает безопасности и надёжности в важных секторах. Open source даёт возможность избавиться от зависимости и лежит в основе обширного портфолио высококачественных и безопасных цифровых решений, которые можно использовать как жизнеспособные альтернативы проприетарным платформам.

Источник изображения: Shahadat Rahman/unsplash.com Как заявляют в Еврокомиссии, сильный и развитый сектор open source может внести эффективный вклад в инновации Евросоюза и ускорить стандартизацию, усиливая конкурентоспособность объединения для сохранения его суверенитета. Кроме того, это обеспечит экономическое процветание, надёжность и будет способствовать распространению влияния во всём мире. Отдельные техноэнтузиасты, стартапы, малые и средние бизнесы вносят значительный вклад, выводя продукты open source на рынок. По расчётам самой Еврокомиссии, 70–90 % современного ПО полагается на open source компоненты, т.е. фактически ПО с открытым исходными кодом лежит в основе цифровой экономики всего мира. В Брюсселе считают, что ЕС вносит в этот процесс значительный вклад, хотя коммерческую и стратегическую выгоду нередко в итоге получают крупные технологические компании, расположенные в других регионах. Для того, чтобы избежать этого, Еврокомиссия намерена обозначить новый подход к open source и пересмотреть свою стратегию, в основном сконцентрированную на том, как структуры ЕС используют и обмениваются кодом в рамках объединения. Теперь Евросоюз намерен обращаться с open source как с экономическим и политическим активом, напрямую связанным с суверенитетом, конкурентоспособностью и кибербезопасностью. Во многом вопрос касается решений, связанных с облачными и ИИ-сервисами, безопасностью, открытой аппаратной составляющей и промышленным ПО, в том числе приложений для автомобилей и др. На этот раз Еврокомиссия будет акцентировать внимание на масштабировании и внедрении такого ПО вместо очередных экспериментальных проектов.

Источник изображения: James Harrison/unsplash.com В Брюсселе признают, что только финансовые вливания не способны обеспечить решение проблемы. ЕС поддерживал программные проекты самой разной направленности, но лишь единицы из них смогли пережить стадию грантов и выжить на рынке. Теперь заявляется, что для масштабирования проекта недостаточно поддержки open source только с помощью программ поддержки исследований и инноваций. Критически важно поддерживать развивающиеся сообщества разработчиков и бизнесов в их намерениях масштабировать проекты. Комиссия изложила возможные меры, включая стимулы для публичных и частных пользователей для участия в развитии базовых проектов, поддержку бизнесов ЕС в сфере open source и помощь стартапам, рискующим не преуспеть в период роста. Также открытый код представлен как инструмент оптимизации прозрачности цепочек поставок и упрощения поиска уязвимостей. При этом ПО с открытым кодом тесно связано с могущественными технологическими платформами, поскольку американские техногиганты активно монетизируют общедоступный мировой код. Даже принадлежащая с некоторых пор Microsoft платформа GitHub предупредила, что устойчивость инфраструктуры open source под вопросом — с таким же мнением осенью выступали крупные открытые проекты в рамках Open Source Security Foundation (OpenSSF).

13.01.2026 [22:30], Владимир Мироненко

Veeam приобрела поставщика СХД Object First для расширения возможностей своей экосистемыVeeam приобрела компанию Object First, основанную учредителями Veeam в 2022 году и специализирующуюся на поставке предварительно интегрированных устройств резервного копирования для сред Veeam. Как пишет StorageReview.com, Veeam отметила, что сделка позволит расширить возможности её экосистемы, не меняя стратегию, партнёрские отношения двух компаний или бизнес-модель. Финансовые подробности сделки не расглашаются. В настоящее время неизменяемость (immutability) стала стандартным требованием для решений резервного копирования. Современные программы-вымогатели всё чаще атакуют системы резервного копирования, что делает изолированные, неизменяемые резервные копии критически важными для восстановления, соответствия требованиям и киберстрахования. Компании продолжат работу независимо друг от друга, пока не будет разработана программа интеграции. Veeam сообщила, что и дальше будет ориентироваться на разработку ПО без привязки к конкретному хранилищу, и что клиентам будет и дальше предлагаться наилучшее целевое хранилище резервных копий, исходя из потребностей в безопасности, сложности эксплуатации и требований к настройке. Object First поставляет готовые к использованию локальные СХД для Veeam. Её платформа Ootbi (Out-of-the-Box Immutability), в том числе только что представленный вариант Ootbi Mini, предлагает собственное объектное S3-хранилище с включённой по умолчанию блокировкой объектов. Устройства Object First разработаны для конкретных сценариев использования, обеспечивая быстрое развёртывание и надёжную защиту от программ-вымогателей. Object First придерживается принципов нулевого доверия и обеспечивает неизменяемость данных. Семейство устройств Object First варьируется от небольших решений, предназначенных для использования на периферии малыми и средними предприятиями, до более крупных систем, рассчитанных на резервное копирование сотен терабайт данных. Эти более крупные системы поддерживают масштабирование и хорошо интегрируются с архитектурами Veeam. В устройствах также предусмотрена защита от случайных ошибок администратора. Как сообщает Veeam, облачный сервис хранения данных Veeam Data Cloud Vault, разработанный в сотрудничестве с Microsoft, является самым быстрорастущим продуктом в её истории, завоевавшим популярность среди клиентов, стремящихся к простому, безопасному и единому поставщику. ПО Veeam Software Appliance упрощает безопасное развёртывание, а Object First добавляет ещё один, локальный вариант хранения: предварительно интегрированное устройство резервного копирования. Как полагают аналитики StorageReview, эта сделка меньше всего связана с выходом Veeam на рынок производителей оборудования и больше — с созданием повторяемого и поддерживаемого решения, обеспечивающего киберустойчивость. Вместе с тем Veeam придётся учитывать аспекты, связанные с владением бизнесом по производству оборудования, в частности, избежать потенциальных конфликтов, особенно с поставщиками хранилищ, которые помогли создать процветающую экосистему Veeam. Как отметил StorageReview, Object First берёт на себя одну из наиболее подверженных сбоям частей современной архитектуры резервного копирования — целевое хранилище — и превращает её в специализированный продукт. Ресурс добавил, что Ootbi разработана как наиболее безопасное место для хранения резервных копий, с гарантированной неизменяемостью по умолчанию и меньшим количеством возможностей для неправильной настройки.

12.01.2026 [13:53], Руслан Авдеев

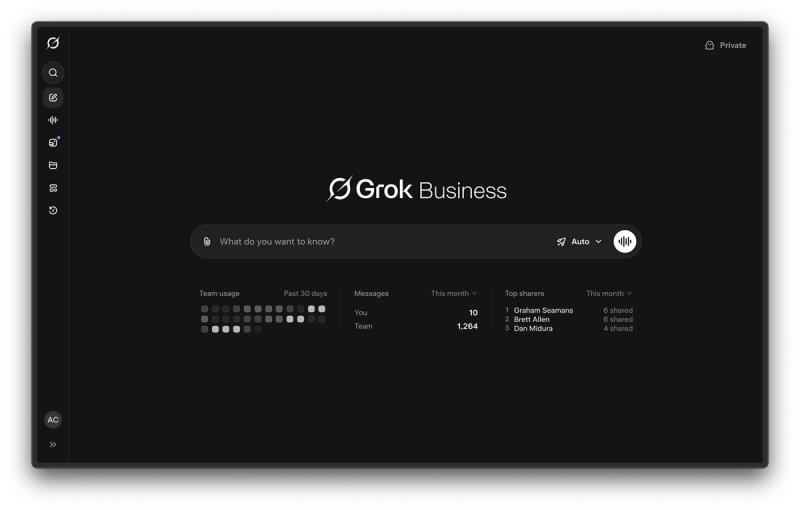

xAI представила тарифы Grok Business и Grok Enterprise для бизнес-пользователейКомпания xAI официально начала освоение рынка ИИ-сервисов для бизнес-пользователей. В самом конце декабря она представила два новых тарифа: Grok Business и Grok Enterprise. Предполагается, что они должны способствовать внедрению ИИ-моделей в компаниях для решения повседневных задач, причём со встроенными возможностями контроля настроек безопасности, конфиденциальности и др., сообщает Channel insider. Таким образом xAI выходит на высококонкурентный рынок корпоративных ИИ-инструментов. Аналогичные предложения уже имеются у OpenAI, Anthropic, Google и др. Для xAI это также означает переход от сервисов для индивидуальных экспериментов к предоставлению возможностей для выполнения совместных задач. Grok Business рассчитан на команды небольших и средних размеров и стоит $30/мес. за каждого пользователя. Предлагаются встроенные инструменты управления командами и организации общения, централизация платежей и контроль использования ПО. Другими словами, команды могут совместно работать в среде Grok, делиться результатами, а также подключать популярные инструменты вроде Google Drive, чтобы ИИ мог работать с информацией, которая уже использовалась. Grok Enterprise имееть расширенную функциональность для более крупных организаций. Цена не разглашается, но основной акцент будет сделан на ужесточении контроля и надзора. В частности, речь идёт о поддержке единой авторизации в масштабах всей компании, автоматизированном управлении профилями пользователей и функциями безопасности, разработанными для более крупных и сложных программных сред. В xAI утверждают, что оба плана построены с учётом необходимости обеспечивать корпоративную безопасность и конфиденциальность. Как подчёркивают в компании, корпоративная защита и конфиденциальность встроены в системы с самого начала — Grok не будет обучаться на предоставляемых клиентками данных.

Источник изображения: xAI Одна из наиболее примечательных функций — способность Grok работать с большими массивами документов. Grok обеспечивает агентный поиск с помощью Collections API. Это позволяет ИИ-модели использовать крупные хранилища документов в качестве первоочередных источников информации. Это может быть полезным, если необходим, например, анализ юридических документов или построение финансовых моделей. В ответы могут включаться цитаты, напрямую ведущие к исходным документам, с возможностью предварительного просмотра и выделения контекста. Для организаций со специальными требованиями к обеспечению безопасности материалов xAI предлагает вариант Enterprise Vault. Это даёт компаниям больше контроля над тем, как обрабатываются их данные, с предоставлением сопутствующей инфраструктуры, дополнительных уровней шифрования, которыми управляет сам пользователь, а не xAI. xAI утверждает, что данные зашифрованы как при передаче, так и при хранении. Тариф Enterprise также обеспечивает соответствие строгим требованиям: обеспечено соответствие инфраструктуры и процессов стандарту безопасности SOC 2 и нормативным актам (включая GDPR и CCPA). Также в его рамках предоставляется доступ к наиболее передовыми ИИ-моделям компании Grok 3, Grok 4 и Grok 4 Heavy. В то же время xAI продолжает наращивать инфраструктуру, необходимую для поддержки соответствующих проектов. Так, речь идёт о строительстве третьего дата-центра в штате Миссисипи (США). На днях появилась информация, что она привлекла $20 млрд на развитие бизнеса.

07.01.2026 [14:17], Руслан Авдеев

Не только баги, но и настоящий бэкдор: британская техподдержка Fujitsu Horizon была набрана из «легализованных хакеров»В скандале с печально известной системой Fujitsu Horizon для Почты Великобритании наметился неожиданный сюжетный поворот. Согласно новым данным, Horizon страдала не только от багов в области бухучёта, из-за которых по обвинению в воровстве были осуждены сотни невиновных сотрудников почтовых отделений — деньги вполне могли украсть сотрудники службы технической поддержки Horizon, причём так, что об этом никто бы никогда не догадался, сообщает Computer Weekly. Ричард Ролл (Richard Roll), работавший на третьей линии службы поддержки Horizon в 2001–2004 гг., дал показания в суде, которые помогли пострадавшим почтовым клеркам. По данным бывшего сотрудника Fujitsu, правила аудита удалённого доступа могли игнорироваться группой «легализованных» хакеров, способных использовать бэкдоры для доступа к счетам почтовых отделений. Ролл был опрошен ещё в 2015 году, но детали были обнародованы на фоне предстоящей встречи главы европейского подразделения Fujitsu с британским Комитетом по вопросам бизнеса и торговли (Business and Trade Committee). В 2015 году, через несколько месяцев после того, как Fujitsu отстранили от расследования инцидентов с Horizon, Ролл показал, что сотрудники японской компании могли обходить аудит удалённого доступа к счетам. По его словам, система была полна «дыр», а сотрудники техподдержки были «легализованными хакерами», которые «могли взломать что угодно». По словам Ролла, специалисты службы поддержки на деле никогда не воровали денег, но вполне могли бы, воспользовавшись бэкдорами. Во всяком случае, во время его работы коллеги в подобном замечены не были.

Источник изображения: Clint Patterson/unsplash.com В 2018–2019 гг. Ролл также давал показания в интересах пострадавших, судившихся с Почтой Великобритании. Около 800 сотрудников почт на основе данных Horizon ошибочно обвинили в финансовых преступлениях в 2000–2015 гг. В результате многие сотрудники лишились средств к существованию, а их привычным жизням пришёл конец после предъявления обвинений. На момент выявления инцидентов Почта Великобритании использовала свои полномочия, чтобы направлять дела управляющих почтовыми отделениями в суд или принуждать к заключению сделок о признании вины. Впоследствии почтовое ведомство, наконец, признало возможность скрытого удалённого доступа. В 2023 году возможность бесконтрольного доступа, в том числе к счетам почтовых отделений, признал и бывший IT-руководитель Fujitsu — фактически сотрудники компании могли скрыть изменения в информационных системах от управляющих, а компании буквально приходилось верить в их добросовестность, без контроля реальной активности. Информация о скандале с британскими почтами появилась более 15 лет назад, с тех пор с переменным успехом ведётся расследование, в ходе которого почта и Fujitsu пытаются переложить вину друг на друга (с точки зрения суда виноваты обе стороны). В конце 2024 года Fujitsu заявляла, что неоднократно предупреждала Почту Великобритании о проблемах с ПО Horizon. Впрочем, в октябре 2025 года появилась информация, что компания влила £280 млн в британское подразделение в преддверии выплат компенсаций жертвам. Сама Fujitsu начала терять контракты с британскими госслужбами и задумалась о сокращении штата ради экономии.

31.12.2025 [10:17], Владимир Мироненко

SoftBank успела завершить рекордные инвестиции в OpenAI на $40 млрд и стать одним из крупнейших акционеровЯпонская холдинговая компания SoftBank Group Corp. объявила в среду, 31 декабря, что полностью выполнила обязательство инвестировать в OpenAI $40 млрд в рамках сделки, заключённой в марте этого года. Структура сделки включает прямые инвестиции SoftBank в сочетании с синдицированными совместными инвестициями от других инвесторов. Согласно заявлению SoftBank, она направила стартапу 26 декабря в рамках второго этапа закрытия инвестиционной сделки сумму в размере $22,5 млрд, в результате чего её доля в OpenAI теперь составляет приблизительно 11 %. На первом этапе японская компания инвестировала в OpenAI в апреле 2025 года $7,5 млрд через свой венчурный фонд SoftBank Vision Fund 2, занимающийся инвестициями в ИИ-компании. SoftBank сообщила, что OpenAI также получил синдицированные соинвестиции от других инвесторов на сумму $11 млрд, в результате чего общая сумма её инвестиций в стартап из Сан-Франциско (США) составила $41 млрд. Как отметило агентство Reuters, после объявления о сделке с SoftBank рыночная стоимость OpenAI составила, по оценкам PitchBook, $300 млрд, а после вторичного размещения акций в октябре его капитализация выросла до $500 млрд. SoftBank на протяжении многих лет активно инвестирует в технологические компании и ИТ-инфраструктуру. Она одной из первых вложилась в производителя ИИ-ускорителей NVIDIA. На этой неделе SoftBank также объявила о покупке инвестиционной компании DigitalBridge, специализирующейся на финансировании строительства центров обработки данных. |

|