Материалы по тегу: облако

|

11.02.2026 [09:28], Андрей Крупин

«Группа Астра» представила Clouden — решение для централизованного управления гибридной и мультиоблачной инфраструктурой«Группа Астра» вывела на рынок Clouden — решение для централизованного управления гибридной и мультиоблачной инфраструктурой. Разработка отвечает на ключевой запрос рынка — потребность в едином инструменте для управления разнородными средами, включая физические серверы, разные платформы виртуализации и публичные облака. Clouden относится к категории продуктов Cloud Management Platform (CMP). Комплекс поддерживает работу с системами VMmanager, DCImanager, VMware vSphere, VMware vCloud Director + NSX-T, OpenStack, ZVirt, OpenNebula, позволяет автоматизировать развёртывание сервисов для заказчиков, включает инструменты инвентаризации и диагностики оборудования, обеспечивает управление географически распределёнными инфраструктурами и в полной мере отвечает задачам импортозамещения программного обеспечения.

Источник изображения: ispsystem.ru/clouden Clouden обеспечивает сквозную автоматизацию, имеет встроенную BI-аналитику для прогнозирования затрат, портал самообслуживания и гибкую систему тарификации. Платформа включена в реестр Минцифры и предназначена для средних и крупных компаний, государственных структур, а также организаций с распределённой филиальной сетью.

09.02.2026 [14:08], Сергей Карасёв

Геопатриация для изоляции: расходы на суверенные IaaS-сервисы в 2026 году превысят $80 млрд

gartner

hardware

iaas

анализ рынка

импортозамещение

конфиденциальность

миграция

облако

прогноз

финансы

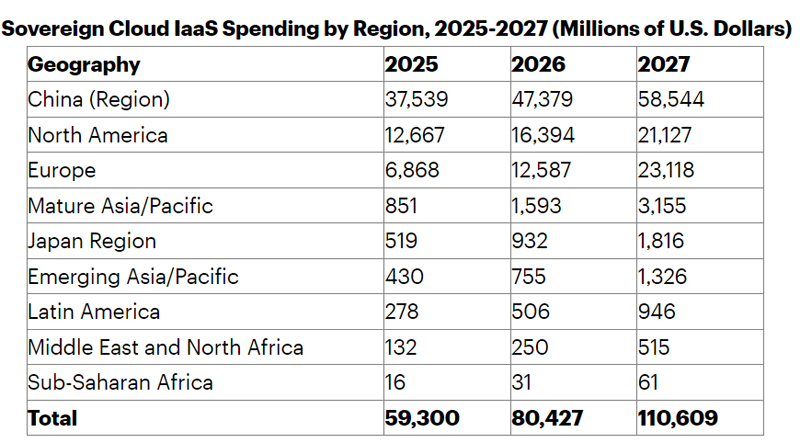

По оценкам Gartner, в 2025 году объём глобального рынка суверенных облачных сервисов IaaS (инфраструктура как услуга) достиг $59,3 млрд. Данный сектор стремительно расширяется, что связано с геополитической напряжённостью: компании и государственные организации по всему миру стремятся к достижению технологической независимости, в связи с чем активно развивают локальные облачные платформы. В целом, по данным Gartner, из-за растущего спроса на проекты по геопатриации около 20 % текущих рабочих нагрузок будут перенесены с глобальных облачных площадок на суверенные платформы. В географическом разрезе наибольшую выручку на рынке суверенных IaaS-сервисов в 2025 году обеспечил Китай — $37,5 млрд. На втором месте находится Северная Америка с $12,7 млрд, а замыкает тройку Европа с $6,9 млрд. Ещё около $851 млн пришлось на развитые страны Азиатско-Тихоокеанского региона, $519 млн — на Японию. В 2026 году, согласно оценкам аналитиков Gartner, объём рынка увеличится на 35,6 %, составив $80,4 млрд. Вклад Китая ожидается в размере $47,4 млрд, Северной Америки — $16,4 млрд, Европы — $12,6 млрд. Самые высокие темпы роста в годовом исчислении прогнозируются на Ближнем Востоке и в Африке (89 %), в развитых государствах Азиатско-Тихоокеанского региона (87 %) и в Европе (83 %).

Источник изображения: Gartner В 2027-м, полагают специалисты Gartner, глобальные расходы на суверенные IaaS-сервисы достигнут $110,6 млрд, что будет соответствовать росту на 37,6 % по отношению к 2026-му. Китай останется лидером с $58,5 млрд, тогда как на второе место выйдет Европа с результатом в $23,1 млрд. В Северной Америке затраты, согласно прогнозам, поднимутся до $21,1 млрд.

08.02.2026 [15:14], Руслан Авдеев

Iren привлекла $3,6 млрд на закупку ИИ-ускорителей для нужд Microsoft — отказ от майнинга продолжаетсяНеооблачная компания Iren опубликовала результаты II квартала 2026 финансового года, закончившиеся в декабре 2025-го. Ключевым событием стало привлечение $3,6 млрд для закупки ИИ-ускорителей, которые нужны для обеспечения долгосрочной сделки с Microsoft, сообщает Converge! Digest. С учётом предоплаты от клиента в размере $1,9 млрд покрывается около 95 % капитальных затрат, связанных с инфраструктурой ИИ-ускорителей. Компания объявила, что закупка 140 тыс. чипов будет идти по плану. К концу календарного 2026 года, как ожидается, годовая повторяющаяся выручка (ARR — Annual Recurring Revenue) достигнет $3,4 млрд. Iren продолжает переход от майнинга биткоинов к созданию облачной ИИ-инфраструктуры. Развитие осуществляется по нескольким векторам. Так, в Британской Колумбии (Канада) расширяется ИИ-платформа AI Cloud. На площадке Prince George уже законтрактованы сервисы на $400 млн, в результате текущих переговоров общий потенциал может превысить $500 млн ARR. В Оклахоме анонсировано строительство нового кампуса мощностью 1,6 ГВт, что увеличивает портфолио компании до более чем 4,5 ГВт. Начало подключений к энергосети на новой площадке начнётся уже в 2028 году. Выручка компании во II квартале 2026 финансового года последовательно снизилась до $184,7 млн. Скорректированная EBITDA — $75,3 млн. Чистый убыток и нескорректированная EBITDA оказались хуже ожидаемых из-за «неденежных» и разовых факторов. Например, отмечены нереализованные убытки из-за переоценки хеджей по конвертируемым облигациям, разовое списание ASIC из-за перехода от майнинга к ИИ-инфраструктуре, а также повышенные расходы на вознаграждение акциям. Часть негативного эффекта компенсирована налоговой выгодой от пересмотра отложенных налоговых обязательств.

Источник изображения: Jakub Żerdzicki/unsplash.com На 31 января 2026 года компания располагала $2,8 млрд денежных средств и их эквивалентов. Всего с начала года привлечено $9,2 млрд с помощью различных финансовых инструментов. В I квартале благодаря быстрому расширению сегмента AI Cloud и заключению серии многолетних контрактов общая выручка Iren выросла на 355 % год к году до $240,3 млн. Показатель скорректированной EBITDA увеличился сразу на 3568 % до $91,7 млн. По данным руководства компании, в прошедшем квартале отмечен значительный прогресс в расширении ИИ-мощностей, работе с клиентами и привлечении капитала. Это отражает её становление как облачной ИИ-платформы. Имея более 4,5 ГВт обеспеченной мощности, можно планировать и реализовать широкий набор проектов и поддерживать следующий этап роста. По мнению Converge! Digest, последняя сделка Iren демонстрирует то, как соглашения с гиперскейлерами преобразуют финансовые модели крупных развёртываний ИИ-инфраструктуры. Предоплаты и финансирование, обеспеченное доступными активами, существенно снижают нагрузку на баланс операторов инфраструктуры, а проект в Оклахоме в целом соответствует общей тенденции создания гигаваттных ИИ ЦОД в Северной Америке, рассчитанных на доступность энергии после 2027 года и устойчивый спрос со стороны облачных провайдеров и разработчиков ИИ-моделей.

07.02.2026 [17:23], Руслан Авдеев

AWS: ни один сервер с NVIDIA A100 не выведен из эксплуатации, а некоторые клиенты всё ещё используют Intel Haswell — не всем нужен ИИПо словам главы AWS Мэтта Гармана (Matt Garman), клиенты до сих пор использует серверы на основе ИИ-ускорителей NVIDIA A100, представленных в 2020 году. Отчасти это происходит потому, что спрос на вычислительные ресурсы превышает предложение, так что устаревшие чипы по-прежнему востребованы, передаёт Datacenter Dynamics. По словам Гармана, все ресурсы фактически распроданы, а серверы с A100 из эксплуатации никогда не выводились. Комментарии Гармана перекликаются с прошлогодним заявлением Амина Вахдата (Amin Vahdat), отвечающего в Google за ИИ и инфраструктуру. По его словам, в Google одновременно работают семь поколений тензорных ускорителей (TPU). Ускорители возрастом семь-восемь лет загружены на 100 %, а спрос на TPU так высок, что Google вынуждена отказывать некоторым клиентам. Впрочем, оба топ-менеджера, возможно, несколько кривят душой и пытаются развеять опасения инвесторов относительно того, что ИИ-ускорители, на которые тратятся огромные деньги, через два-три года придётся выкинуть, чтобы купить более современные, энергоэффективные и, конечно же, дорогие. И что за это время они не успеют окупиться. Хотя Гарман назвал главной причиной сохранения работы серверов на A100 высокий спрос, он признал, что есть и другие причины. В частности, современные ИИ-чипы снижают точность вычислений с плавающей запятой. В результате некоторые клиенты попросту не могут перейти на Blackwell или вовсе вынуждены использовать Intel Xeon Haswell десятилетней давности для HPC-подобных вычислений, поскольку точности у современных ИИ-ускорителей недостаточно. В июне 2025 года AWS заявила о снижении цены доступа к устаревшим NVIDIA H100, H200 и A100 на своей платформе, причём для A100 стоимость снизилась на треть.

Источник изображения: NVIDIA Стоит отметить, что «устаревшие» ускорители долго остаются востребованными, поскольку всё равно обладают большой производительностью. Наиболее яркий пример — разрешение на поставку в Китай чипов NVIDIA H200. Хотя США и их союзники готовятся к внедрению ускорителей поколения Vera Rubin, китайский бизнес готов покупать H200, поскольку те значительно производительнее, экономически выгоднее и удобнее отечественных ускорителей.

03.02.2026 [15:41], Владимир Мироненко

Snowflake теперь будет сотрудничать с OpenAI напрямую, минуя MicrosoftКомпания Snowflake, специализирующаяся на облачных решениях для обработки данных с использованием ИИ, объявила о заключении партнёрского соглашения с OpenAI на сумму $200 млн с целью разработки и внедрения специализированных ИИ-решений для общих корпоративных клиентов. Сделка знаменует переход от прежнего доступа клиентов Snowflake к OpenAI при посредничестве Microsoft к прямым отношениям Snowflake с OpenAI. В рамках партнёрства модели OpenAI будут доступны в управляемом сервисе Snowflake Cortex AI и Snowflake Intelligence, что позволит 12,6 тыс. клиентов Snowflake создавать и развёртывать приложения и ИИ-агентов непосредственно на управляемых корпоративных данных во всех трёх основных публичных облаках. Эта сделка позиционирует OpenAI как одного из основных поставщиков моделей на платформе Snowflake, наряду с Anthropic, Meta✴ и Mistral AI, отметил ресурс SiliconANGLE. Как указано в пресс-релизе, основные преимущества партнёрства включают:

Партнёрство также распространяется на взаимное использование технологий внутри компаний. В Snowflake заявили, что OpenAI использует Snowflake в качестве платформы данных для отслеживания экспериментов и аналитики, а Snowflake задействует ChatGPT Enterprise для повышения производительности труда своих сотрудников и принятия решений. Сообщается, что несколько клиентов, включая платформу для дизайна Canva и производителя фитнес-браслетов WHOOP, уже используют совместное предложение для ускорения исследований, аналитики и принятия внутренних решений. Напомним, что в начале декабря Snowflake объявила о сделке с ИИ-лабораторией Anthropic на сумму $200 млн с целью обеспечения доступа клиентов к агентному ИИ в дополнение к их существующим данным. Объявление о сделке Snowflake и OpenAI сделано на фоне усиления конкуренции на рынке данных и ИИ, отметило агентство Reuters. Конкурент Snowflake — компания Databricks продолжает агрессивно масштабироваться. Недавно она привлекла $4 млрд инвестиций при оценке рыночной стоимости в $134 млрд для финансирования развития своей платформы Agent Bricks и растущего набора продуктов ИИ.

03.02.2026 [12:31], Руслан Авдеев

Индия объявила 20 лет налоговых каникул для гиперскейлеров, использующих местные ЦОД для обслуживания зарубежных облачных клиентовИндия анонсировала 20 лет налоговых льгот для гиперскейлеров, использующих дата-центры, расположенные в стране, для обслуживания клиентов со всего мира, сообщает CNBC. Предполагается, что такое предложение может привлечь связанные с ИИ бизнесы в активно развивающийся регион. Правда, стремление многих стран к цифровому суверенитету может помешать этим планам. По словам экспертов, стоимость инфраструктуры ЦОД в Индии и без того невысока, а в совокупности с налоговыми каникулами использование индийских ЦОД для гиперскейлеров станет ещё привлекательнее в сравнении с хабами в Сингапуре, ОАЭ и Ирландии. По мнению экспертов, это изменит положение Индии — она станет не только «рынком потребления» услуг ЦОД, но и глобальным хабом для облачных и ИИ-вычислений. Пока же гиперскейлеры сталкиваются со значительными рисками, связанными с корпоративными налогами, если имеют в Индии «значительное экономическое присутствие». Сегодня работа ЦОД иностранных гиперскейлеров в Индии рассматриваются как «постоянное представительство», а прибыль от этой деятельности облагается налогом в 35 %, не считая дополнительных сборов. Теперь облачные сервисы, предоставляемые зарубежными гиперскейлерами с использованием дата-центров, принадлежащих местным застройщикам и управляемых ими же, будут пользоваться налоговыми каникулами до 2047 года. Ожидается, что это ускорит инвестиции в ЦОД. Пока роль Индии в мировой гонке ИИ была ограничена, поскольку стране недостаёт ИИ-моделей местного происхождения, производства чипов и больших ЦОД в сравнении с США и Китаем. Предложенные налоговые каникулы и инвестиции, которые они, вероятно, принесут, могут усилить роль Индии в глобальной гонке технологий искусственного интеллекта. Многие техногиганты уровня Microsoft уже анонсировали миллиардные инвестиции в местную ИИ-инфраструктуру. Ещё более крупные инвестиции готовит Amazon. Помимо попыток привлечь гиперскейлеров, Индия имеет большие амбиции в сфере ИИ-полупроводников, поощряя их разработку и производство в стране. Налоговые каникулы должны сыграть на руку местным IT-компаниям и облачным бизнесам вроде Infosys, Wipro, TCS, HCL Tech и Jio, равно как и местным строителям ЦОД. Среди выгодоприобретателей от налоговых каникул, вероятно, будет Google, совместно с местной AdaniConneX намеренная построить дата-центр за $15 млрд на территории нового ИИ-хаба на юге Индии. В последние годы спрос на ЦОД значительно вырос, в основном в связи с масштабированием ИИ-задач, требующих огромных вычислительных мощностей, электроэнергии, охлаждения и сетевой инфраструктуры. В глобальный рынок ЦОД в 2025 году вложили более $61 млрд. Сегодня мощность индийских ЦОД составляет около 1,2 ГВт, но в следующие пять лет рынок должен преодолеть отметку в 3 ГВт. Согласно январскому докладу JLL, мировая мощность ЦОД составила около 100 ГВт и должна удвоиться до 200 ГВт к 2030 году благодаря буму ИИ. В Индии считают, что налоговые каникулы уберут крупнейшее препятствие для выхода зарубежных гиперскейлеров на индийский рынок. По мнению экспертов, поскольку рынки Азиатско-Тихоокеанского региона уровня Японии, Австралии, Китая и Сингапура достигли «зрелости», а Сингапур, ко всему прочему, ещё и страдает от дефицита земли и других ресурсов, Индия может стать новым перспективным местом для развития инфраструктуры ЦОД. В стране много места для крупномасштабных строек ЦОД, а в сравнении с ИИ-хабами в Европе, цены на электричество довольно невысоки. С учётом растущих возможностей развития возобновляемой энергии, критической для питания дата-центров, модель индийского технологического рывка выглядит вполне убедительно. Как заявляют индийские эксперты, налоговые каникулы для зарубежных облачных компаний могут стать катализатором крупных глобальных инвестиций, увеличения экспортной выручки и приведут к созданию долгосрочных рабочих мест и других возможностей.

02.02.2026 [13:25], Руслан Авдеев

Microsoft заключила облачную сделку с Perplexity на $750 млн, но любимым провайдером ИИ-поисковика всё равно останется AWSИИ-стартап Perplexity заключил сделку с Microsoft на сумму $750 млн — компания будет использовать ресурсы облачного сервиса Azure. Тем самым она расширяет свой бизнес и более не полагается на единственного облачного партнёра в лице Amazon (AWS), сообщает Bloomberg. Perplexity основана в 2022 году, а после привлечения $200 млн в сентябре 2025 года её стоимость оценивалась в $20 млрд. Одним из значимых инвесторов компании является NVIDIA. По информации источников издания, соглашение сроком на три года позволит развёртывать ИИ-модели Perplexity с помощью сервиса Microsoft Foundry. Perplexity заявляет, что перенаправлять средства, предназначавшиеся для оплаты услуг AWS, не намерена. AWS останется «предпочтительным поставщиком» облачной инфраструктуры для Perplexity, в ближайшие недели планируется даже расширение этого партнёрства. На сегодня Perpexity является одним из наиболее высоко оцениваемых ИИ-стартапов, но ему приходится жёстко конкурировать с Google и OpenAI в нише поиска информации в интернете. Кроме того, компания привлекла намного меньше капитала, чем OpenAI и Anthropic, в последнее время активно развивающих инфраструктуру. Крупные бизнесы обычно арендуют доступ к облакам у нескольких провайдеров, получая доступ к уникальным услугам и ограничивая зависимость от единственного поставщика. В эру ИИ это особенно актуально, поскольку приходится экспериментировать с новыми инструментами.

Источник изображения: Microsoft/Perplexity Значительная часть бизнеса Perplrexity построена на платформе AWS и сервисе Amazon Bedrock для доступа к ИИ-моделям Perplexity. В 2023 году компания сообщила о полном переходе на облачные решения Amazon, а последняя называет Perplexity одним из ключевых клиентов в сфере ИИ. Однако недавно компании ввязались в судебную тяжбу. Amazon подала иск против Perplexity, давшей возможность делать покупки на маркетплейсе Amazon с помощью своего ИИ-агента Comet, что создаёт конкуренцию продуктам самой Amazon. Perplexity назвала действия Amazon «угрозой выбору пользователей» и подчеркнула, что компания вложила в AWS «сотни миллионов» долларов. Что касается Microsoft, сделка позволит укрепить позиции Azure в качестве платформы для создания ИИ-приложений и развёртывания моделей разных поставщиков. Например, Microsoft долгое время эксклюзивно предлагала доступ к моделям OpenAI, а в ноябре заключила аналогичное соглашение с Anthropic. Microsoft объявила, что клиенты рассчитывают на использование нескольких моделей в рамках любой рабочей нагрузки, а компания предлагает «самый широкий выбор моделей» среди крупных поставщиков соответствующих услуг. Утверждается, что более 1,5 тыс. клиентов Microsoft Foundry прибегают к помощи моделей OpenAI и Anthropic. По данным Microsoft, число клиентов, тратящих в квартал более $1 млн, к концу прошлого года выросло квартал к кварталу на 80 %. Новость о сделке появилась вскоре после публикации квартального финансового отчёта Microsoft. Хотя бизнес растёт и в сегменте облачных вычислений, инвесторы обеспокоены большими капитальными затратами на ИИ-инфраструктуру, а также тем, что значительная часть обязательств компании приходится на единственный бизнес — OpenAI.

02.02.2026 [11:22], Сергей Карасёв

Выручка SAP в сегменте облака в 2025 году выросла на четверть, но акции рухнули из-за слабого прогнозаНемецкий разработчик ПО SAP обнародовал финансовые показатели деятельности в IV квартале и 2025 году в целом. По ключевым показателям зафиксирован рост, однако стоимость акций компании резко упала из-за более слабого, чем ожидалось, прогноза по направлению облачных сервисов. В облако компания стремится переманить своих клиентов уже давно. В период с октября по декабрь включительно облачные услуги принесли SAP около €5,61 млрд. Это на 19 % больше по сравнению с последней четвертью 2024-го, когда показатель составлял €4,71 млрд. При этом в сегменте SaaS/PaaS отмечен рост на 21 % — с €4,59 млрд до €5,53 млрд. Вместе с тем в области IaaS продажи сократились на 37 % год к году — со €123 млн до €78 млн. Суммарная выручка компании в IV квартале 2025-го, рассчитанная в соответствии с международными стандартами финансовой отчётности (МСФО), достигла €9,68 млрд против €9,38 млрд годом ранее, что соответствует росту на 3 %. Прибыль после налогообложения поднялась на 17 %, достигнув €1,9 млрд против €1,62 млрд в последней четверти 2024 года. В 2025 году в целом SAP получила от облачных услуг €21,02 млрд, что примерно на четверть (на 23 % или на 26 % в постоянных ценах) больше по сравнению с предыдущим годом, который принёс €17,14 млрд. В области SaaS/PaaS продажи подскочили на 25 % — с €16,6 млрд до €20,68 млрд, тогда как в сфере IaaS отмечено снижение на 36 % — с €540 млн до €345 млн. Общая годовая выручка увеличилась на 8 %, достигнув €36,8 млрд против €34,18 млрд в 2024-м. Прибыль после налогообложения подскочила более чем в два раза — с €3,15 млрд до €7,49 млрд. SAP ожидает, что в 2026 году выручка от облачных сервисов увеличится на 23 %. Вместе с тем темпы роста текущего портфеля заказов на облачные решения несколько замедлятся после подъёма на 25 % (в постоянных ценах) в 2025-м. На этом фоне в конце января 2026 года стоимость акций SAP снизилась на 15 %, что стало самым резким однодневным падением с октября 2020 года. Как отмечает JPMorgan, объём заказов SAP на облачные услуги и прогноз выручки на 2026 год не оправдали ожиданий, что спровоцировало распродажу ценных бумаг, несмотря на то что показатели компании за весь 2025 год соответствовали прогнозам аналитиков.

30.01.2026 [22:19], Руслан Авдеев

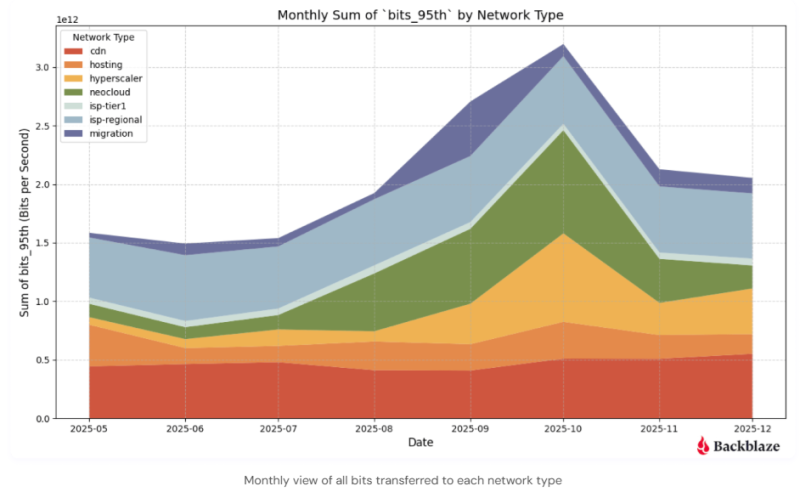

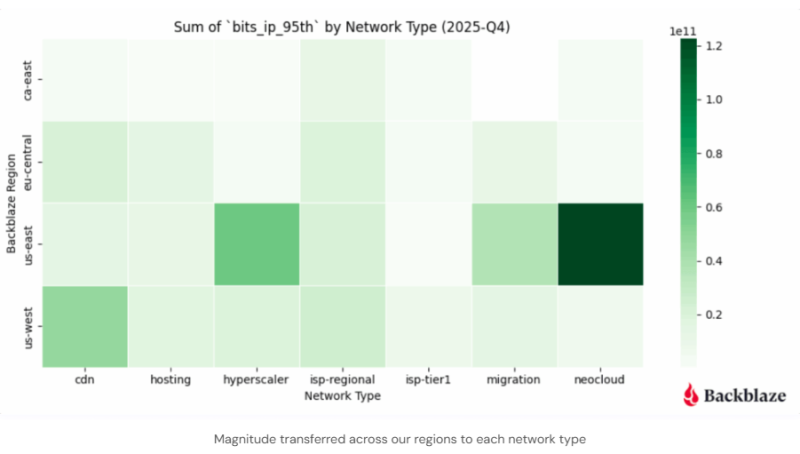

Неооблака «засасывают» ИИ-данные как чёрные дыры, меняя поведение СетиКомпания Backblaze, предоставляющая сервисы облачного хранения, опубликовала доклад Q4 2025 Network Stats, который свидетельствует о росте связанного с искусственным интеллектом трафика в направлении неооблачных провайдеров. Это, как утверждают в компании, свидетельствует о смещении интернет-трендов в сторону оптимизированного для ИИ-задач сетевого поведения, подходящего для масштабного обучения ИИ-моделей и инференса. Данные IV квартала демонстрируют, что массивные датасеты всё чаще передаются короткими, устойчивыми «импульсами» — активность сосредоточена преимущественно в регионе US-East (США). Наблюдается отклонение от привычного, распределённого характера перемещения интернет-трафика, поскольку теперь «гравитация данных» всё сильнее стягивает в единую конфигурацию хранилища, вычисления и сети. Backblaze наблюдала рост связанного с неооблачными провайдерами трафика с июля по ноябрь, пиковых значений он достиг в октябре 2025 года. Вместе отмеченные шаблоны поведения позволяют предположить, что движение больших массивов связанных с ИИ данных остаётся «сконцентрированным» и устойчивым.

Источник изображения: Backblaze Согласно данным Backblaze, ИИ-трафик сконцентрирован в регионе US-East, а связанные с ИИ «транзакции» данных концентрируются близ неооблачных вычислительных хабов в Северной Вирджинии, Нью-Йорке и Атланте, что подчёркивает важность наличия каналов связи с низкой задержкой для задач, связанных с обучением моделей. Нормой становятся потоки информации с «высокой магнитудой» — если раньше трафик передавался, в основном, по принципу «от многих к многим», то теперь речь нередко идёт об устойчивых высокоскоростных соединениях между специализированными системами хранения данных и вычислений. Растут объёмы масштабных миграций данных: трафик, связанный с переносом информации увеличивался с августа по октябрь, что обусловлено передачей больших датасетов по частным ВОЛС.

Источник изображения: Backblaze При этом регион US-West всё ещё имеет критическое значение для пользовательского трафика, пока составляющего большую часть трафика в целом. Там концентрируются точки обмена трафиком, которые позволяют эффективно и с низкой задержкой доставлять контент конечным интернет-пользователям через сети интернет-провайдеров. Как заявляет компания, мало что может изменить сетевое поведение быстрее, чем ИИ. Она и сама предлагает сервис хранения B2 Overdrive, которым пользуются неооблака для работы с LLM. В сентябре 2025 года сообщалось, что среднегодовой темп роста выручки неооблаков за пять лет составил 82 %, а в октябре того же года появились данные, что Квартальная выручка неооблаков выросла на 200 %, а в 2030 году она достигнет $180 млрд.

29.01.2026 [18:20], Руслан Авдеев

ИИ и облака вместо телефонов: Telefónica превратит десятки «медных» АТС в периферийные ЦОДИспанский оператор связи и ЦОД Telefónica ускоряет реализацию стратегии расширения периферийных вычислений. Для этого компания переоборудует ненужные более телефонные АТС с медными компонентами в мини-ЦОД на 1–2 МВт. Среднесрочная цель — развернуть в стране более 100 таких узлов, сообщает Datacenter Dynamics. После полного отключения аналоговой телефонной связи в Испании большое количество АТС с медными кабельными системами осталось без дела, поэтому Telefónica España начала переделывать их в распределённые периферийные ЦОД небольшой мощности. Новые ЦОД ориентированы на предоставление ИИ и облачных сервисов с низкой задержкой — они находятся вблизи от конечных потребителей и призваны укрепить цифровой суверенитет страны. На сегодня уже эксплуатируется 12 подобных узлов, коммерческие услуги компания намерена начать предоставлять после завершения тестовой фазы. На горизонте 5–7 лет планируется развернуть более 100 таких дата-центров. Вторую жизнь получит и сеть связанных электростанций. Новые edge-узлы интегрируют с ВОЛС и 5G-сетями. Новый план — часть общеевропейского проекта развития периферийных вычислений, в его рамках Telefónica выделена субсидия в размере €93 млн ($111 млн). Компания дополнила её собственными средствами, хотя объёмы инвестиций не раскрываются. Также в европейском проекте участвуют телеком-операторы Orange, Deutsche Telekom и Telecom Italia.

Источник изображения: Telefonica К концу 2026 года Telefónica рассчитывает запустить ещё 17 периферийных узлов, дополняя свои лидирующие позиции в сегментах FTTH — на её долю приходится более 31 млн подключенных домохозяйств — и 5G, это способствует цифровой трансформации в стране. Telefónica отмечает, что её т.н. Edge Plan выводит Испанию на передний край инноваций в Европе в контексте обеспечения технологического суверенитета, позволяя создавать местную инфраструктуру без помощи «неевропейских» вендоров. Периферийная архитектура комбинирует эластичность облака с возможностью обработки данных в непосредственной близости от их источника. Это минимизирует задержки и в то же время обеспечивает соответствие сопутствующих процессов европейским правовым нормам. Стремление обрести технологический суверенитет, в первую очередь от США, в последнее время стало ключевым вектором деятельности для многих европейских компаний и политиков. Так, Франция в январе 2025 года объявила, что местных госслужащих переведут с Zoom и Teams на суверенный видеочат Visio. Суверенные решения предлагают европейцам и европейские компании вроде SAP, а вот техногиганты из США не пользуются былой популярностью — не так давно Microsoft признала что не может обеспечить настоящий суверенитет европейских данных, поскольку вынуждена подчиняться в первую очередь законам США. |

|