Материалы по тегу: облако

|

29.01.2026 [16:38], Владимир Мироненко

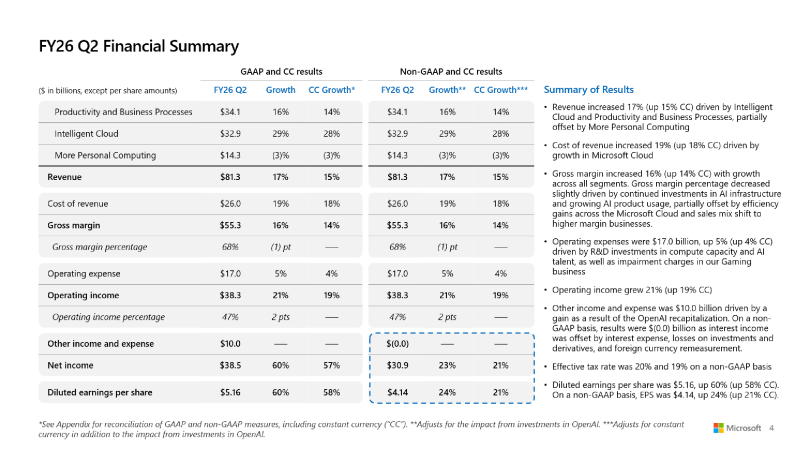

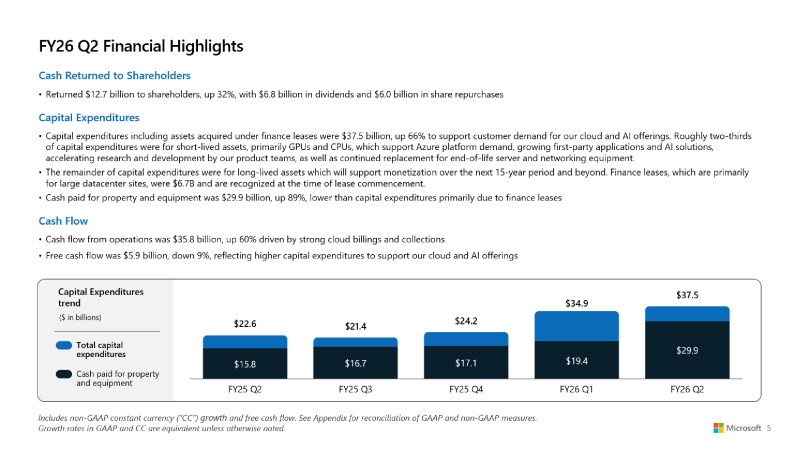

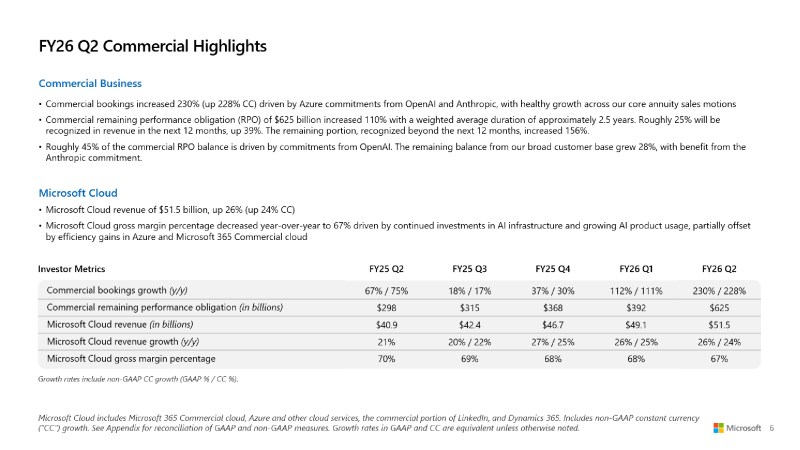

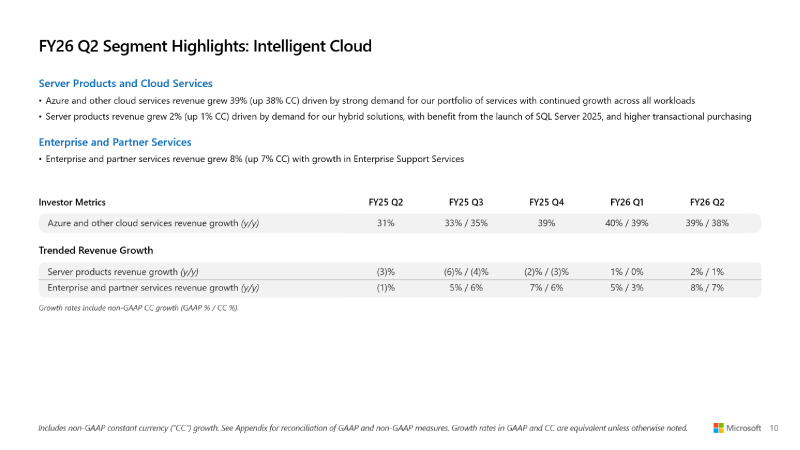

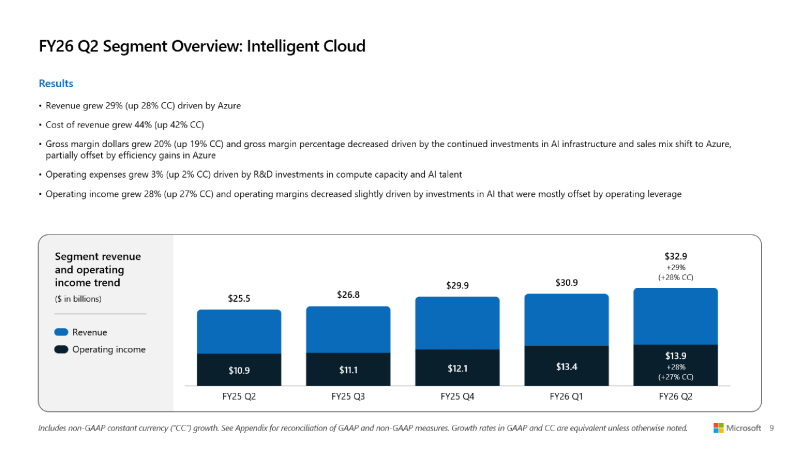

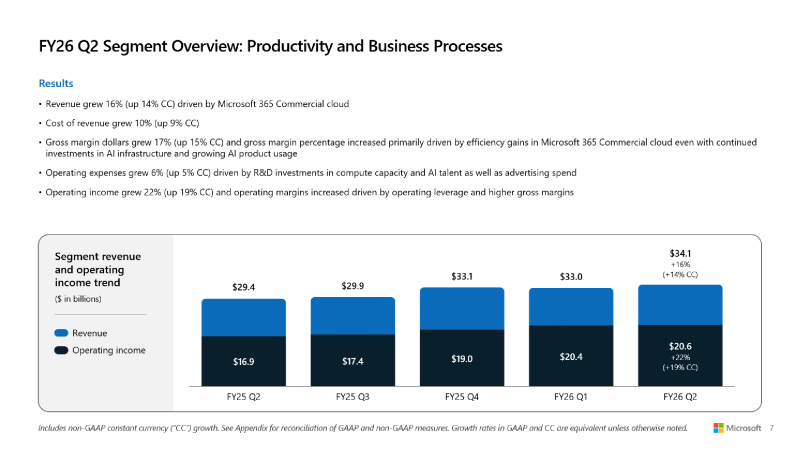

Microsoft превысила прогнозы Уолл-стрит, но её акции упали из-за замедления роста облачных сервисовMicrosoft объявила результаты за II квартал 2026 финансового года, закончившийся 31 декабря 2025 года. Несмотря на то, что результаты компании превысили прогнозы Уолл-стрит, её акции упали на 7 % на внебиржевых торгах в среду после сообщения о замедлении роста облачных сервисов, пишет ресурс CNBC. Скорректированная прибыль (Non-GAAP) Microsoft на разводнённую акцию составила $4,14 при объёме продаж в $81,27 млрд, в то время как аналитики, опрошенные LSEG, ожидали $3,97 скорректированной прибыли при выручке в размере $80,27 млрд. Microsoft уточнила, что скорректированная прибыль не включает влияние инвестиций компании в OpenAI. Согласно отчёту Microsoft, её выручка за второй финансовый квартал выросла на 16,7 % по сравнению с аналогичным периодом предыдущего финансового года. Чистая прибыль (GAAP) составила $38,46 млрд или $5,16 на акцию, что на 60 % выше показателя годом ранее в $24,11 млрд или $3,23 на акцию. Валовая маржа компании была самой низкой за три года, составив чуть более 68 %. «Выручка Microsoft Cloud в этом квартале превысила $50 млрд, что отражает высокий спрос на наш портфель услуг», — сообщила Эми Худ (Amy Hood), исполнительный вице-президент и главный финансовый директор Microsoft, добавив, что компания превзошла ожидания по выручке, операционной прибыли и прибыли на акцию. Выручка Microsoft Cloud выросла на 26 % до $51,5 млрд, а оставшиеся коммерческие обязательства компании по исполнению контрактов, представляющие собой незаработанную выручку и суммы, которые будут признаны в качестве выручки позже, выросли на 110 % до $625 млрд. Это стало возможным благодаря оставшимся коммерческим обязательствам OpenAI перед Microsoft в области облачных сервисов на сумму $250 млрд в течение квартала. Microsoft заявила, что 45 % оставшихся коммерческих обязательств связаны с OpenAI, а оставшаяся часть суммы выросла на 28 %. «Портфель заказов действительно хорош, но информация о том, что OpenAI составляет 45 % от их портфеля, возвращает нас к вопросу: сможет ли OpenAI достичь этих финансовых целей, чтобы расплатиться с Oracle, Microsoft и многими другими поставщиками?» — задался вопросом аналитик Jefferies Брент Тилл (Brent Thill) в программе Closing Bell Overtime на CNBC. Остальная часть оставшихся обязательств по коммерческому выполнению контрактов «больше, чем у большинства конкурентов, более диверсифицирована, чем у большинства конкурентов, и, честно говоря, я думаю, что мы очень уверены в этом», — сказала Эми Худ. Она отметила, что Microsoft остаётся «мастштабным поставщиком» для OpenAI. Microsoft сообщила, что чистые убытки от инвестиций в OpenAI составила $7,58 млрд, или $1,02 на акцию. Компания также отметила, что её прочие доходы во II финансовом квартале составили $9,97 млрд, что обусловлено рекапитализацией OpenAI, пишет ресурс Constellationr. Сегмент Microsoft Intelligent Cloud, включающий облачную инфраструктуру Azure, принес $32,91 млрд выручки (рост 29 %), что больше консенсус-прогноза StreetAccount в размере $32,40 млрд. Рост Azure и других облачных сервисов составил 39 % по сравнению с 40-% ростом в I финансовом квартале. Аналитики, опрошенные StreetAccount и CNBC, ожидали рост на 39,4 и 38,9 % соответственно. Выручка в сегменте «Производительность и бизнес-процессы» (Microsoft Productivity and Business Processes) выросла на 16 % до $34,12 млрд, что выше консенсус-прогноза в $33,48 млрд аналитиков, опрошенных StreetAccount. Доход от облачного сервиса Microsoft 365 увеличился на 17 %, от потребительского облачного сервиса Microsoft 365 — на 29 %, от LinkedIn — на 11 %, от Dynamics 365 — на 19 %. В настоящее время у компании 15 млн коммерческих подписчиков Microsoft 365 Copilot. До этого момента Microsoft не сообщала о количестве пользователей, имеющих доступ к Copilot. У Copilot есть потенциал роста. В настоящее время Microsoft располагает более чем 450 млн платных коммерческих пользователей Microsoft 365. Сегмент More Personal Computing, включающий Windows, Xbox, Surface и Bing, принес $14,25 млрд выручки (падение год к году на 3 %), что ниже консенсус-прогноза аналитиков StreetAccount в $14,38 млрд. В отчётном квартале капитальные затраты и финансовая аренда Microsoft составили $37,5 млрд, что на 66 % больше в годичном исчислении и выше прогноза аналитиков, опрошенных Visible Alpha, в $34,31 млрд. Худ сообщила, что примерно две трети из них приходится на краткосрочные активы, такие как GPU и CPU (согласно MarketBeat). Microsoft активно инвестирует в ЦОД для удовлетворения спроса на ИИ и другие облачные вычислительные услуги. Однако компания ожидает снижения капитальных затрат в третьем финансовом квартале, подчеркнул ресурс Investors. «Мы находимся только на начальных этапах распространения ИИ, и Microsoft уже построила бизнес в сфере ИИ», — заявил генеральный директор Microsoft Сатья Надела (Satya Nadella). «В общей сложности за этот квартал мы добавили почти один гигаватт вычислительных мощностей», — сообщил он во время телефонной конференции. Наделла подчеркнул необходимость создания решений для «гетерогенных и распределённых» рабочих нагрузок ИИ и заявил, что Microsoft оптимизирует свои решения, ориентируясь на «токены на ватт на доллар», что, по его словам, способствует повышению эффективности использования и снижению общей стоимости владения за счет полупроводниковых компонентов, систем и ПО. Он отметил «50-% увеличение пропускной способности» для рабочих нагрузок инференса OpenAI, обеспечивающих работу Copilot, и сказал, что Microsoft соединила площадки ЦОД через AI WAN, создав, по его словам, «первую в своем роде суперфабрику ИИ» для ЦОД Fairwater. В III финансовом квартале Microsoft прогнозирует выручку в размере от $80,65 до $81,75 млрд. Средний показатель составил $81,2 млрд, что соответствует консенсус-прогнозу LSEG в $81,19 млрд. Прогноз компании по квартальному росту облачных сервисов Azure составил от 37 до 38 % при консенсус-прогнозе StreetAccount в размере 37,1 %. Ожидаемая операционная маржа компании в III квартале 2026 финансового года равна 45,1 %, что ниже консенсус-прогноза StreetAccount в 45,5 %. Операционные расходы будут включать инвестиции в вычислительные мощности и персонал для ИИ.

27.01.2026 [13:59], Руслан Авдеев

ИИ-облако в круизе: платформа Oracle RED прокатилась на борту авианосца «Принц Уэльский»Британские ВМС используют периферийную инфраструктуру Oracle Cloud для управления оборонными ИИ-системами на борту авианосца «Принц Уэльский», сообщает The Register. Oracle отметила, что флот применил «суверенные ИИ-возможности» в рамках операции Highmast — миссии, продлившейся восемь месяцев в 2025 году, в рамках которой корабль побывал в Средиземноморье, на Ближнем Востоке и в Индо-Тихоокеанском регионе. Управление ИИ осуществлялось с помощью Oracle Roving Edge Infrastructure (RED) — локальной версии облачной платформы компании, работающей на оборудовании в защищённом корпусе «военного» уровня. Roving Edge представили в 2021 году, заявив, что она позволяет клиентам выполнять различные рабочие задачи, включая машинное обучение и аналитику, в полевых условиях. Собственно ИИ-платформу разработала компания Whitespace из Белфаста, её решение Saga создано для того, чтобы ускорить сбор, управление и использование военными организациями «институциональных» знаний. По данным Whitespace, Saga позволяет экипажам кораблей ВМС закреплять полученные сведения, анализировать данные миссий и получать доступ к ИИ-поддержке.

Источник изображения: Wikimedia Commons По данным Oracle, платформа позволяет авианосцу применять ИИ для поддержки принятия решений и оперативного обучения — получаемые в ходе миссии данные превращаются в практически применимый материал. Использование ИИ-решений в операциях британских ВМС считается в руководстве страны критически важным для её оборонных возможностей. Похожие эксперименты проводятся и другими странами. Так, ещё летом 2024 года ВМС США успешно подключили к облаку авианосец «Авраам Линкольн». Впрочем, как напоминает The Register, на деле нередко выясняется, что на проверку принятых ИИ решений требуется не меньше человеко-часов, чем было сэкономлено за счёт его использования. Более того, ИИ-системы часто страдают «галлюцинациями», что в военных операциях совершенно недопустимо. При этом собственный портал поддержки Oracle после получения интегрированных ИИ-инструментов стал только хуже, говорят клиенты компании. Oracle делает большую ставку на ИИ, тратя миллиарды долларов на инвестиции в дата-центры, чтобы привлечь разработчиков и корпоративных клиентов, в то же время залезая в огромные долги и страдая от судебных разбирательств. Тем временем ПО компании, не только связанное с оборонными проектами, вызывает большие вопросы. Недавно сообщалось, что перезапуск печально известной ERP-системы Oracle Fusion в Бирмингеме вновь отложили.

23.01.2026 [21:58], Андрей Крупин

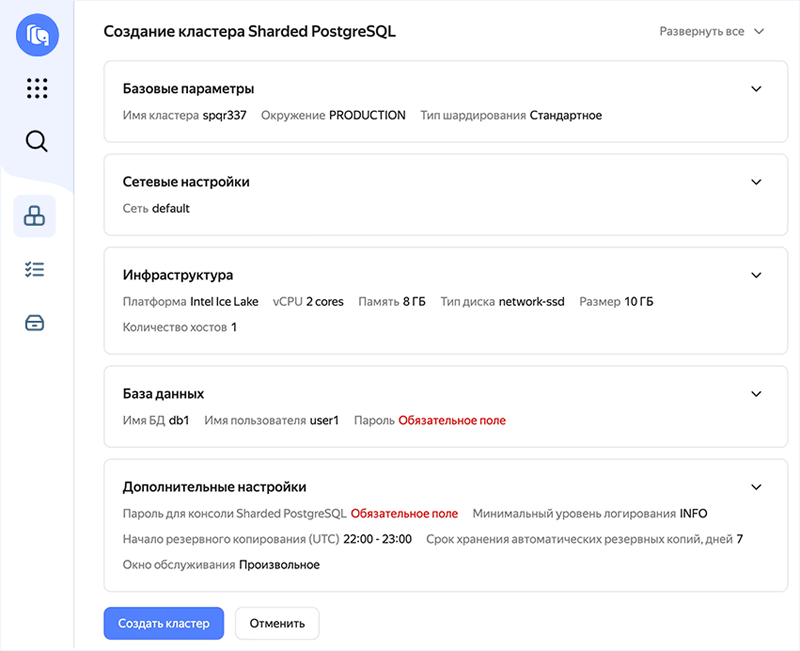

Yandex B2B Tech запустила сервис горизонтального масштабирования PostgreSQLYandex B2B Tech (бизнес-группа «Яндекса», объединяющая технологии и инструменты компании для корпоративных пользователей, включая продукты Yandex Cloud и «Яндекс 360») сообщила о запуске сервиса горизонтального масштабирования СУБД PostgreSQL в облачной инфраструктуре Yandex Cloud. Новый инструмент получил название Yandex Managed Service for Sharded PostgreSQL и построен на базе SPQR (Stateless Postgres Query Router) — системы горизонтального масштабирования PostgreSQL через шардирование, основанной на технологиях Yandex Open Source. Решение позволяет увеличивать производительность баз данных без смены СУБД, распределять нагрузку по шардам и сохранять работу бизнес-приложений без изменений кода благодаря единому PostgreSQL‑совместимому эндпоинту.

Пользовательский интерфейс Yandex Managed Service for Sharded PostgreSQL (источник изображения: yandex.cloud) По умолчанию в PostgreSQL функций горизонтального масштабирования (добавление новых серверов в систему и распределение нагрузки между ними) нет. При этом именно оно позволяет справиться с огромными объемами данных, когда вертикальное масштабирование (увеличение мощности одного сервера) не работает. Yandex Managed Service for Sharded PostgreSQL работает на уровне протокола PostgreSQL. Это предполагает полную совместимость с разными редакциями СУБД. На начало 2026 года это версии 14, 15, 16, 17 и 18. Сервис полностью совместим со стандартными типами данных PostgreSQL, включая JSONB. Платформа Yandex Cloud объединяет 18 сервисов для работы с OLTP- и OLAP-нагрузками. Недавно компания также запустила управляемые сервисы на базе решений с открытым исходным кодом — Yandex Managed Service for Spark и сервис управления распределённым аналитическим массивно‑параллельным движком обработки больших данных Trino.

21.01.2026 [15:28], Руслан Авдеев

ByteDance стремительно завоёвывает рынок облачных ИИ-сервисов КитаяКомпания ByteDance агрессивно осваивает китайский облачный рынок. Владелец популярной социальной сети TikTok пытается использовать свои достижения в сфере ИИ для выхода за пределы рынка пользовательских приложений, обеспечивших в своё время успех компании, сообщает The Financial Times. Компания продвигает облачные решения Volcano Engine для корпоративных клиентов, увеличивая команду продаж и устраивая ценовые войны с конкурентами. Источники сообщают, что ByteDance предлагает корпоративным клиентам собственные обширные данные и вычислительные ресурсы, например, для создания ИИ-агентов с использованием собственных моделей ByteDance. Тем самым она теснит Alibaba, Tencent и Huawei, которые долго доминировали на этом рынке. По данным IDC, Volcano Engine является в Китае вторым по величине провайдером ИИ-инфраструктуры и ПО после Alibaba. На долю ByteDance в I половине 2025 года приходилось около 13 % выручки от китайских облачных ИИ-сервисов ($390 млн), на долю Alibaba — 23 %. При этом на китайском облачном рынке в целом ByteDance имеет долю лишь 3 %. Иными словами, ByteDance стала лидером в сфере ИИ-сервисов, самом быстрорастущем сегменте рынка. По мнению некоторых аналитиков, компания может стать одним из ключевых игроков в Китае в сегменте кастомных ИИ-инструментов благодаря крупным собранным датасетам и развитой аппаратной инфраструктуре, добавив для достижения успеха агрессивное ценообразование и глубокую интеграцию со своей экосистемой пользователей.

Источник изображения: Liren/unsplash.com ByteDance хорошо разбирается в пользовательских технологиях, имея в портфолио социальную сеть TikTok и её китайский вариант Douyin, а также видеоредактор CapCut и новостной агрегатор Toutiao. Именно эти площадки обеспечивают большую часть выручки компании благодаря рекламе, продажам и подпискам. Согласно данным, предоставленным инвесторам, в III квартале выручка составила $50 млрд. Последние попытки выйти на рынок корпоративного ПО, включая премьеру похожего на Slack продукта Lark, не увенчались особенным успехом. Стратегия роста, ориентированная на ИИ, могла бы придать импульс для будущего выхода на IPO, которого инвесторы ожидают годами. ByteDance агрессивно выводит в коммерческую плоскость свои ИИ-возможности благодаря Volcano Engine. Компания акцентирует внимание на продажах флагманского сервиса HiAgent, посредством которого создаются кастомные ИИ-агенты для корпоративных клиентов. Стратегия опирается на массивные инвестиции в вычислительные мощности. ByteDance сегодня — в числе крупнейших покупателей ИИ-оборудования, она же была крупнейшим клиентом NVIDIA в 2024 году. По данным The Financial Times, в этом году значительная часть из ¥85 млрд, выделенных на ИИ-ускорители, будет потрачена на покупку NVIDIA H200, с некоторых пор разрешённых для поставок в КНР — если это одобрят китайские власти. При этом некоторые эксперты отмечают, что ByteDance имеет сильные позиции в разработке ПО и достаточные аппаратные ресурсы для получения значимой доли облачного рынка, но ей не хватает опыта в обслуживании корпоративных клиентов в сравнении с Tencent и Huawei, поэтому приходится навёрстывать упущенное.

Источник изображения: Claudio Schwarz/unsplash.com Крупные китайские игроки сами дают ByteDance такую возможность. Например, Tencent заявляла, что будет тратить ресурсы ИИ-ускорителей для внутренних нужд, не планируя масштабного расширения облачных сервисов для клиентов. Huawei, тем временем, сократила свои облачные ИИ-амбиции за последний год, сфокусировавшись на продаже чипов Ascend напрямую клиентам. По данным IDC, доля обеих компаний на облачном ИИ-рынке КНР слегка уменьшилась в I половине 2025 года. Становление ByteDance в качестве одного из китайских ИИ-гигантов привлекло меньше внимания, чем успехи DeepSeek и Alibaba, которые развивают успешные открытые ИИ-модели и одновременно публикуют исследования о своих методиках обучения ИИ. Напротив, ByteDance сохранила полный контроль над своими самыми передовыми моделями и компании-клиенты имеют к ним доступ только по подписке. К слову, Alibaba, яро выступавшая за open source подход к распространению моделей, в последние месяцы оставила некоторые из передовых вариантов «закрытыми». Другими словами, успехи ByteDance в сфере ИИ-моделей не освещаются слишком широко, поскольку отдача open source продуктов вызывает некоторые сомнения у многих разработчиков. Один из представителей команды ByteDance подчеркнул, что компания концентрирует усилия на создании лучших ИИ-моделей для клиентов, а не на гонке в сегменте open source.

19.01.2026 [16:26], Руслан Авдеев

AWS запустила своё первое действительно суверенное облако European Sovereign Cloud в ЕвросоюзеНа фоне торговых и геополитических трений между Евросоюзом и США, Amazon Web Services (AWS) объявила о запуске суверенного облака European Sovereign Cloud в Европе. Новое, независимое облако полностью базируется в Евросоюзе и физически и логически отделено от прочих облачных регионов AWS. Как заявляют в компании, уникальный подход AWS European Sovereign Cloud обеспечивает полнофункциональные сервисы под строгим техническим контролем, с суверенными гарантиями и правовой защитой для удовлетворения запросов европейских правительств и бизнесов на защиту конфиденциальных данных. Также AWS анонсировала планы расширения European Sovereign Cloud за пределы Германии (Бранденбурга), где находится его первый регион (eusc-de-east-1), в другие страны и регионы ЕС для поддержки изоляции данных от внешних игроков и доступа с низкой задержкой для местных клиентов. Дополнительно будут созданы новые суверенные зоны доступности WS Local Zones в Бельгии, Нидерландах и Португалии. Услугами нового региона могут воспользоваться все желающие, а не только резиденты ЕС. Открытие AWS European Sovereign Cloud и новых зон доступности в трёх странах обеспечит организации дополнительными возможностями для размещения рабочих нагрузок в «местных» облаках с высочайшим уровнем операционной независимости. В то же время компания пообещает сохранить доступ ко всему спектру сервисов AWS. Клиенты, которым нужна более строгая изоляция данных, смогут использовать AWS Dedicated Local Zone, AWS AI Factorу или AWS Outposts, в том числе в собственных ЦОД. AWS European Sovereign Cloud опирается на местные кадры, инфраструктуру и топ-менеджмент. Операционный контроль из-за пределов Евросоюза, как утверждается, не предусмотрен. Операционная автономность является ключевой функцией облака. Физически и логически AWS European Sovereign Cloud отделено от других регионов AWS, управляется только резидентами Евросоюза, не имеет критических зависимостей от находящейся за пределами ЕС инфраструктуры — даже если связь со всем остальным миром будет потеряна, облако продолжит работу. В исключительных случаях кадры из числа резидентов Евросоюза смогут получить доступ к копии исходного кода, необходимого для поддержки суверенных сервисов. AWS обеспечивает клиентам полный контроль над тем, где именно будут храниться их данные. Кроме того, клиенты сохранят контроль над создаваемыми метаданными (роли, разрешения, конфигурации и др.), которые останутся в Евросоюзе, в том числе речь идёт о системах IAM, биллинге и метриках использования. Как и в других регионах AWS, European Sovereign Cloud защищено с помощью системы AWS Nitro, благодаря которой все вычисления на платформе EC2 имеют строгий барьер для доступа извне, включая доступ со стороны сотрудников AWS без прямой авторизации со стороны клиента. Доступны управление шифрования и ключами (AWS Key Management Service) и аппаратные модули безопасности AWS CloudHSM. AWS создала специальную структуру управления в Европе, с новой «материнской» компанией и тремя дочерними подразделениями в Германии. Руководство осуществляется гражданами Евросоюза. Компания обязана соблюдать европейские законы и действовать в интересах AWS European Sovereign Cloud, а не сторонних игроков. Структура включает консультационный совет, который обеспечит поддержку в вопросах, связанных с обеспечением суверенитета — он состоит из двух топ-менеджеров Amazon и двух независимых участников, все — граждане и резиденты Евросоюза. Стефан Исраэль (Stéphane Israël) возглавит AWS European Sovereign Cloud, управляющим директором назначен Штефан Хохбауэр (Stefan Hoechbauer) — вице-президент AWS Global Sales Germany and Europe Central. Изначально пользователи AWS European Sovereign Cloud получат доступ к более 90 сервисам в разных категориях, включая ИИ, вычисления, базы данных, сервисы безопасности, хранения и др. Партнёры AWS пообещали предоставлять свои решения и для нового облака: Accenture, adesso, Adobe, Arvato Systems, Atos, Capgemini, Dedalus, Deloitte, Genysys, Kyndryl, Mistral AI, msg group, NVIDIA, SAP, SoftwareOne и многие другие. В долгосрочной перспективе Amazon намерена инвестировать более €7,8 млрд в инфраструкту в Германии. Это должно добавить ВВП Германии приблизительно €17,2 млрд. Расширение облака в Бельгию, Нидерланды и Португалию потребует дополнительных инвестиций и поможет развитию местных экономик. Как сообщает CNBC, в последнее время европейские политики и регуляторы всё больше обеспокоены доминированием американских техногигантов, в том числе в сфере критически важной IT-инфраструктуры. Несмотря на то, что Европа стимулирует развитие бизнеса региональными компаниями, по данным Synergy Research Group на долю AWS, Microsoft и Google приходится около 70 % облачного рынка в регионе. При этом не так давно Microsoft признала, что не способна обеспечить европейским данным настоящий суверенитет и будет вынуждена пойти навстречу американским властям, если те будут делать запросы в соответствии с законами США, хотя несколько ранее компания, как и Google, предложили собственные «суверенные» решения для европейского рынка.

16.01.2026 [16:26], Владимир Мироненко

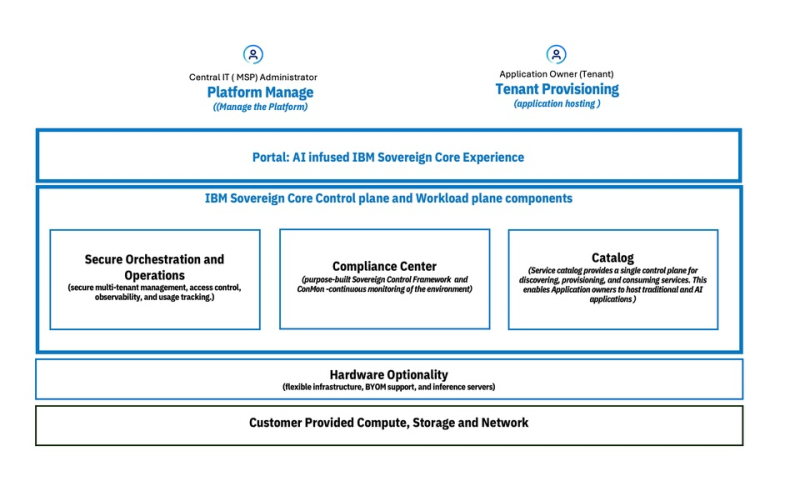

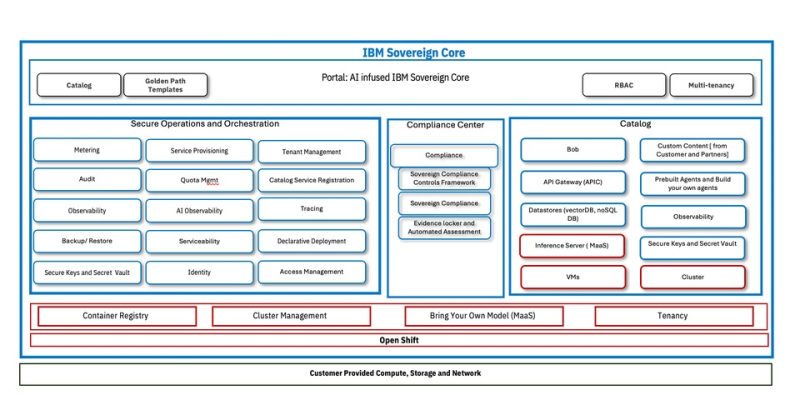

IBM представила облачную платформу IBM Sovereign Core для обеспечения непрерывного и проверяемого цифрового суверенитетаКомпания IBM представила программную платформу IBM Sovereign Core, разработанную для обеспечения более полного контроля обработки ИИ-приложений и облачных рабочих нагрузок на фоне дальнейшего ужесточения требований регулирующих органов к обеспечению цифрового суверенитета. IBM отметила, что цифровой суверенитет касается не только места размещения данных. Он также включает управление и контроль над технологической средой, контроль доступа и управление данными, управление исполнением рабочих нагрузок и юрисдикцию работы ИИ-моделей. Компания заявила, что организации при разработке инноваций испытывают всё большее давление в плане необходимости соответствия требованиям регуляторов, контроля операционной среды и хранения конфиденциальных данных в пределах национальных или региональных границ. IBM привела данные прогноза Gartner, согласно которому к 2030 году у более 75 % всех предприятий будет стратегия обеспечения цифрового суверенитета. IBM Sovereign Core — первое, по словам компании, в отрасли ПО с поддержкой суверенитета, предназначенное для создания, развёртывания и управления облачными и ИИ-нагрузками под собственным контролем организации в выбранных юрисдикциях. Оно базируется на открытых решениях Red Hat и, в отличие от предложений других провайдеров, предлагающих суверенные сервисы в виде наложения на существующие архитектуры политик или управляемых ими механизмов, предлагает суверенитет как встроенную функцию. Сачин Прасад (Sachin Prasad), программный директор по управлению продуктами в области ИИ и данных в IBM подчеркнул в интервью SiliconANGLE, что ИИ не относится к второстепенным элементам, он должен быть встроен в структуру. IBM сообщила, что при разработке IBM Sovereign Core основывалась на трёх фундаментальных принципах, которые формируют ПО от начала до конца. Во-первых, суверенитет — это возможность платформы, и он должен быть доказуемым. В IBM Sovereign Core суверенитет обеспечивается архитектурно, а не договорно. Управление основано не на наложении политик на существующие решения вендора, а на автоматизированных постоянно действующем контроле управления, принадлежащем пользователю. Платформа базируется на технологиях Red Hat OpenShift с изоляцией ПО, работающим как SaaS, но полностью находящимся под контролем компании и местных властей. Идентификация, ключи шифрования, журналы, телеметрия и аудиторские данные остаются полностью в пределах суверенных границ. Возможности постоянного соответствия требованиям встроены непосредственно в платформу, позволяя организациям по запросу получать готовые к проверке регуляторами доказательства суверенности. Во-вторых, платформа обеспечивает и суверенитет ИИ. В пределах суверенных границ организации могут развёртывать кластеры на базе CPU/GPU, использовать утверждённые открытые или проприетарные модели и управлять доступом к моделям, инструментам и источникам знаний через контролируемые шлюзы. Инференс и агенты работают локально, без экспорта данных или телеметрии внешним поставщикам. Что не менее важно, IBM Sovereign Core обеспечивает суверенитет во время выполнения, а не только во время конфигурации. Идентификация, доступ, использование моделей и активность постоянно отслеживаются и записываются, создавая чёткий аудиторский след для ИИ-систем, работающих в регулируемых областях. И в-третьих, суверенитет реализован не в ущерб производительности и масштабируемости. IBM Sovereign Core можно быстро развернуть и управлять тысячами ядер и сотнями узлов с различными требованиями и средствами контроля суверенности из единого центра. Автоматическая настройка идентификации, безопасности и соответствия требованиям заложена с самого начала, а самообслуживание для предоставления ресурсов CPU, GPU, ВМ и сред ИИ-инференса обеспечивает повторяемое развёртывание в корпоративных и многопользовательских моделях без ущерба для контроля — локально, в облаке или в партнёрских средах поставщиков услуг, где требуется лишь поддержка Kubernetes. Эта гибкость, по словам IBM, позволяет клиентам перемещать рабочие нагрузки не только между регионами, но и между различными инфраструктурами, что в сочетании с возможностью устанавливать уникальные параметры управления, позволит адаптироваться по мере изменения нормативных требований с развитием ИИ-технологий. Благодаря проверяемому аудиторскому следу, документирующему непрерывное соответствие требованиям, компания сможет в любой момент продемонстрировать соответствие нормам в области суверенитета и, таким образом, сократить расходы, связанные с аудитом. «Соответствие требованиям и аудит обходятся дорого с точки зрения времени и ресурсов, и ситуация только ухудшается», — сообщил главный аналитик Moor Insights and Strategy Джейсон Андерсен (Jason Andersen). «Всё, что упростит и оптимизирует этот процесс, принесёт большую пользу IT-специалистам и поставщикам управляемых услуг», — добавил он. Андерсен также отметил, что хотя на рынке предлагаются облачные решения для обеспечения суверенитета от AWS, Google и Microsoft, он «ещё не увидел ничего, созданного для гибридных сред, подобного тому, что предлагает IBM». По словам Прасада, при развёртывании новой платформы IBM первоначально сотрудничает с европейскими поставщиками услуг, прежде чем расширить сотрудничество на более широкий круг партнёров. Такой подход призван получить обратную связь, но не ограничит распространение. Он добавил, что IBM рассчитывает продавать пакет напрямую: «Он будет продаваться так же, как и любой другой продукт». Компания сообщила, что начиная с февраля, IBM Sovereign Core будет доступна в режиме предварительного тестирования, а выход полной общедоступной версии запланирован на середину 2026 года.

14.01.2026 [01:29], Владимир Мироненко

Безоблачно: США запретили Китаю удалённый доступ к передовым ИИ-ускорителямПалата представителей США приняла подавляющим большинством «Закон о безопасности удалённого доступа» (Remote Access Security Act). Как сообщается на сайте Специального комитета Палаты Представителей США по стратегическому соперничеству между Соединёнными Штатами и Компартией Китая (CCP), этот закон расширяет действие «Закона о реформе экспортного контроля», позволяя федеральным властям «ограничивать возможности иностранных противников получать удалённый доступ к технологиям, включая ИИ-чипы, через облачные вычислительные сервисы». Проще говоря, теперь китайским компаниям запрещён доступ к передовым ускорителям в ЦОД и облаках за пределами КНР. Хотя экспорт ускорителей NVIDIA H200 теперь разрешён, поставка в Китай более мощных чипы на базе архитектуры Blackwell по-прежнему запрещена, как и ускорителей с новой архитектурой Vera Rubin. Новый закон призван перекрыть пробелы в законодательстве США, которыми с успехом пользуются китайские компании, получая доступ к находящимся под санкциями ИИ-ускорителям, покупая или арендуя их для использования на территории США. О таких обходных путях стало известно в 2024 году, когда выяснилось, что ByteDance, китайский владелец TikTok, арендовал передовые чипы NVIDIA у Oracle, пишет Data Center Dynamics. Как передаёт The Register, китайские компании обходят экспортные ограничения на высокопроизводительные ускорители NVIDIA и другие чипы, получая к ним доступ через такие платформы, как AWS и Azure, по крайней мере, с 2023 года. The Register также ранее сообщал, что китайские облачные провайдеры, такие как Alibaba и Tencent, могут предоставлять доступ к находящимся под экспортными ограничениями GPU клиентам в Китае, арендуя облачное оборудование, размещённое за пределами страны. В свою очередь, Microsoft и AWS предлагают в Китае через местных партнёров облачные услуги, в целом аналогичные тем, что доступны в других странах. «Амбиции КПК в области ИИ подпитываются доступом к американским чипам, размещённым в ЦОД за пределами Китая, — заявил председатель Специального комитета по Китаю, один из соавторов законопроекта. — Этот законопроект переводит наши законы в цифровую эпоху и ясно даёт понять, что облачные вычисления подпадают под действие американского законодательства об экспортном контроле, так же как и физические чипы. Устранение этих лазеек укрепит национальную безопасность США и защитит американские инновации». Новый закон теоретически может целиком перекрыть бизнес некоторых азиатских компаний. После появления сообщения о том, что NVIDIA потребует от китайских клиентов, приобретающих ускорители H200, полной предоплаты, чипмейкер выступил с опровержением, заявив агентству Reuters, которое первым сообщило об этом что «никогда не будет требовать от клиентов оплаты за продукцию, которую они не получают». В начале декабря администрация Трампа разрешила NVIDIA продавать H200 «одобренным клиентам» в Китае и других странах при условии выплаты 25-% пошлины. В свою очередь, китайское правительство попросило технологические компании страны приостановить оформление заказов на ускорители, пока регулирующие органы не определятся с соотношением приобретаемых чипов H200 и отечественных чипов «в нагрузку» к ним.

11.01.2026 [15:06], Руслан Авдеев

ИИ-облако Lambda пытается привлечь $350 млн перед выходом на IPOСтартап Lambda Inc., предлагающий облачную ИИ-платформу, как сообщается, намерен привлечь $350 млн на развитие бизнеса и ведёт переговоры с Mubadala Capital, которая должна возглавить новый раунд инвестиций. При этом менее двух месяцев назад прошёл раунд финансирования серии E, возглавленный TWG Global, в ходе которого удалось привлечь $1,5 млрд, сообщает Silicon Angle со ссылкой на The Information. Lambda выступает оператором дюжины дата-центров в США. Флагманским предложением является сервис Superclusters, который позволяет арендовать кластеры, имеющие до 165 тыс. ИИ-ускорителей NVIDIA. Lambda предлагает несколько поколений чипов NVIDIA, в том числе суперускорители GB300 NVL72. В скором времени обещана и доступность новейших Vera Rubin NVL72. Системы Lambda работают на кастомном пакете ПО Lambda Stack, состоящем из открытых ИИ-инструментов, которые компания оптимизировала для своего оборудования. Новый раунд финансирования, возможно, будет последним перед выходом компании на IPO во II полугодии 2026 года. В ноябре Lambda заключила многомиллиардный контракт с Microsoft. Согласно его условиям, Lambda предоставит гиганту из Редмонда доступ к десяткам тысяч ИИ-ускорителей. Также подписано соглашение на $1,5 млрд с NVIDIA, которая будет арендовать у Lambda свои же чипы.

03.01.2026 [15:08], Руслан Авдеев

Brookfield готова побороться с гиперскейлерами, запустив облако Radiant с «бюджетной» ИИ-инфраструктуройОдин из крупнейших управляющих инвестициями в альтернативные активы — компания Brookfield Asset Management может стать неожиданным соперником гиперскейлерам. Она намерена предложить собственные, недорогие облачные сервисы, сообщает Silicon Angle. Как свидетельствует доклад в The Information, компания планирует запустить облачный бизнес, который будет сдавать в аренду ИИ-чипы напрямую клиентам. Компания предложит бизнес-модель, которая позволит снизить стоимость строительства и эксплуатации ИИ ЦОД. Новый бизнес будет управляться подразделением Brookfield Radiant в связке с новой инфраструктурной программой стоимостью $100 млрд, анонсированной в ноябре 2025 года. Brookfield Artificial Intelligence Infrastructure Fund уже выделил на инициативу $10 млрд, половина из которых поступит от отраслевых партнёров, включая NVIDIA и Kuwait Investment Authority (KIA). Ранее Brookfield и Qatar Investment Authority (QIA) объявили о создании совместного предприятия на $20 млрд для инвестиций в ИИ-инфраструктуру в Катаре и на других международных рынках.

Источник изображения: Adeolu Eletu/unsplash.com Фонд поддерживает новые проекты ЦОД во Франции, Катаре и Швеции, а Radiant, как ожидается, первой получит право получить эти мощности. Если мощности не будут освоены, Brookfield планирует сдавать их в аренду сторонним операторам в рамках более традиционных схем. Если планы Brookfield действительно будут реализованы, Radiant теоретически сможет конкурировать с AWS и Microsoft Azure. Правда, основное преимущество Radiant перед остальными гиперскейлерами связано с многомиллиардными инвестициям Brookfield в энергетический сектор. В компании заявили, что такие актив смогли бы помочь контролировать ключевые элементы цепочки создания стоимости в сфере ИИ, что недоступно обычным облачным соперникам. Поскольку AWS, Microsoft и другим гиперскейлерам необходимо продемонстрировать отдачу от своих инвестиций в ИИ, запуск сервисов Radiant, вероятно, заставит их оптимизировать свою энергетическую логистику для своих дата-центров — для того, чтобы оставаться конкурентоспособными.

25.12.2025 [02:15], Игорь Осколков

NVIDIA купит за $20 млрд активы разработчика ИИ-ускорителей Groq — это самая дорогая покупка в истории компанииNVIDIA приобретёт активы Groq, своего конкурента в области ИИ-ускорителей, за $20 млрд, передаёт CNBC. Сама Groq заявила, что «заключила неисключительное лицензионное соглашение с NVIDIA на технологии инференса» и что основатель и генеральный директор Groq Джонатан Росс (Jonathan Ross), а также президент компании Санни Мадра (Sunny Madra) и другие высокопоставленные сотрудники «присоединятся к NVIDIA, чтобы помочь продвижению и масштабированию лицензированной технологии». При этом Groq продолжит свою деятельность как независимая компания под руководством Саймона Эдвардса (Simon Edwards). Финансовый директор Nvidia Колетт Кресс (Colette Kress) отказалась комментировать сделку. По-видимому, речь фактически идёт о поглощении Groq, а столь необычная форма сделки выбрана, по примеру других, в попытке снизить внимание к ней регулирующих органов. Стоимость сделки официально не называется, однако Алекс Дэвис (Alex Davis), глава Disruptive, которая инвестировала в Groq более $500 млн, называет сумму в $20 млрд, причём «живыми» деньгами. Дэвис сообщил CNBC, что NVIDIA получит все активы Groq, за исключением её облачного бизнеса. Groq заявила, что «GroqCloud продолжит работать без перебоев». В электронном письме сотрудникам, полученном CNBC, глава NVIDIA Дженсен Хуанг (Jensen Huang) заявил, что сделка расширит возможности NVIDIA: «Мы планируем интегрировать ускорители Groq в архитектуру NVIDIA AI Factory, расширив платформу для обслуживания ещё более широкого спектра задач инференса и рабочих нагрузок в реальном времени». Хуанг добавил: «Хотя мы пополняем наши ряды талантливыми сотрудниками и лицензируем интеллектуальную собственность Groq, мы не приобретаем Groq как компанию». Эта сделка является крупнейшей покупкой NVIDIA за всю историю. До этого самой крупной сделкой была покупка Mellanox почти за $7 млрд в 2019 году. В конце октября у NVIDIA было $60,6 млрд наличных средств и краткосрочных инвестиций, что на $13,3 млрд больше, чем в начале 2023 года. По схожей с Groq схеме была организована и сделка c Enfabrica, в рамках которой NVIDIA заплатила $900 млн деньгами и акциями за лицензирование технологий и переход главы Enfabrica Рочана Санкара (Rochan Sankar) и других ключевых в NVIDIA. Всего три месяца назад Groq, основанная в 2016 году разработчиками ИИ-ускорителей Google TPU, привлекла $750 млн при оценке примерно в $6,9 млрд. Раунд возглавила Disruptive, к которой присоединились Blackrock, Neuberger Berman, Deutsche Telekom Capital Partners, Samsung, Cisco, D1, Altimeter, 1789 Capital и Infinitum. Повлияло ли на решение NVIDIA слухи о намерении Intel купить разработчика ИИ-ускорителей для инференса SambaNova, который наряду с Cerebras является одним из немногих стартапов, способных составить хоть какую-то серьёзную конкуренцию NVIDIA, не уточняется. Сама Groq планировала достичь выручки в $500 млн в этом году. По словам Дэвиса, компания не планировала продажу, когда к ней обратилась NVIDIA. В сентябре NVIDIA объявила о намерении вложить $5 млрд в Intel, а также инвестировать до $100 млрд в OpenAI. Впрочем, последняя сделка носит циклический характер и пока далеко не продвинулась. |

|